本次分享題目為 ChatGPT 技術、國產化嘗試和開源模型。分享包含三大部分的內容,第一部分整體介紹ChatGPT 相關的技術:ChatGPT 技術的演進、目前存在什麼樣的問題、ChatGPT 技術學習的三個階段、資料組織和效果評估;第二部分分享我們在ChatGPT技術國產化方面進行的嘗試,包含實驗過程中我們遇到的問題、進行的思考以及模型的效果和應用;第三部分介紹我們已經發布的中文開源大模型,使用自有數據訓練出本地模型如何進行操作,在實驗過程中可能遇到的問題,和開源的先進模型相比存在的差距以及如何進一步提升模型的效果。

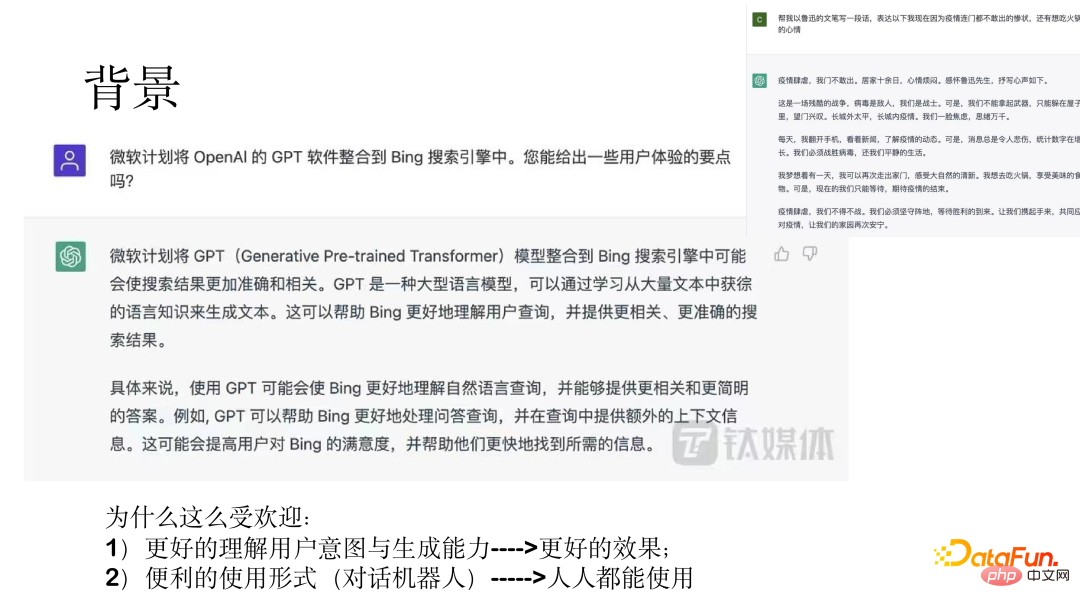

ChatGPT 是一個通用功能型助理。 2022 年 12 月 5 日,OpenAI 執行長 Sam Altman 在社群媒體上發文稱,ChatGPT 推出五天,突破 100 萬用戶。 AI 聊天機器人 ChatGPT 爆火出圈,已成為一個標誌性事件。微軟正洽談 100 億美元增持股份,並很快將其整合到微軟雲端。

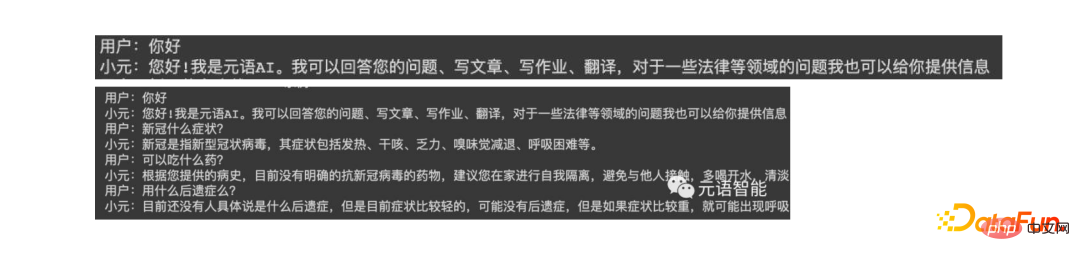

#上圖中展示了兩個例子,展現出了驚人的效果。

ChatGPT 之所以這麼受歡迎,一方面是由於其理解用戶意圖的能力和生成的效果比較好;另一方面,透過對話機器人的形式,使得人人都能使用。

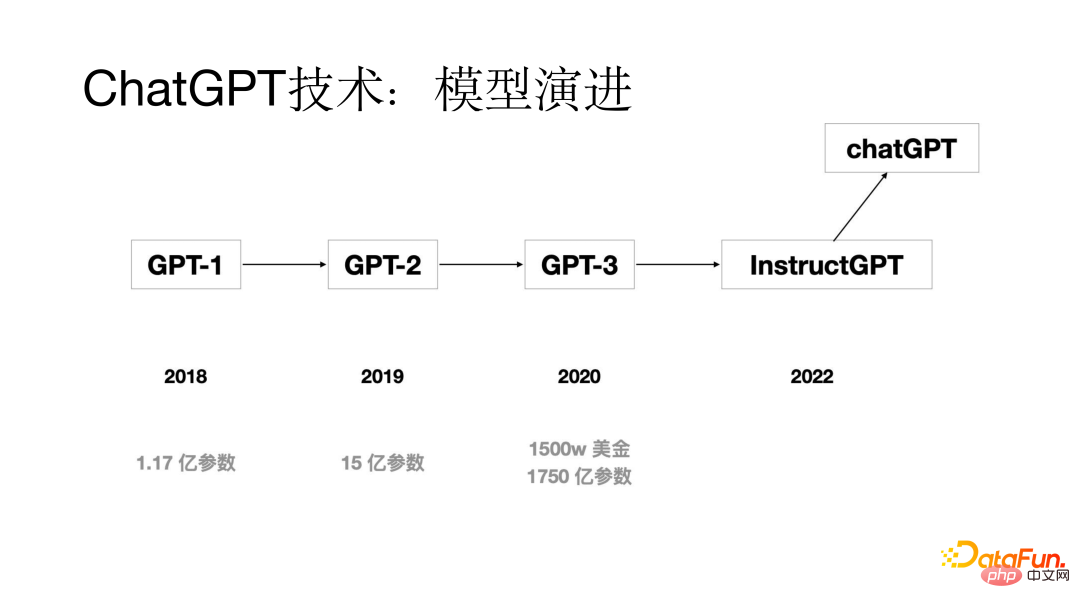

以下將從模型演進、最初模型存在的問題、ChatGPT 模型學習的三個階段、訓練ChatGPT 模型的資料組織和效果幾個方面進行介紹。

#ChatGPT 技術也經過了幾代模型的演進,最初的GPT 模型是在2018 年提出的,模型參數只有1.17 億;2019 年的時候GPT-2 模型參數是15 億;到了2020 年GPT-3 模型參數達到了1750 億;透過幾代的模型更新迭代,到2022 年出現了ChatGPT 模型。

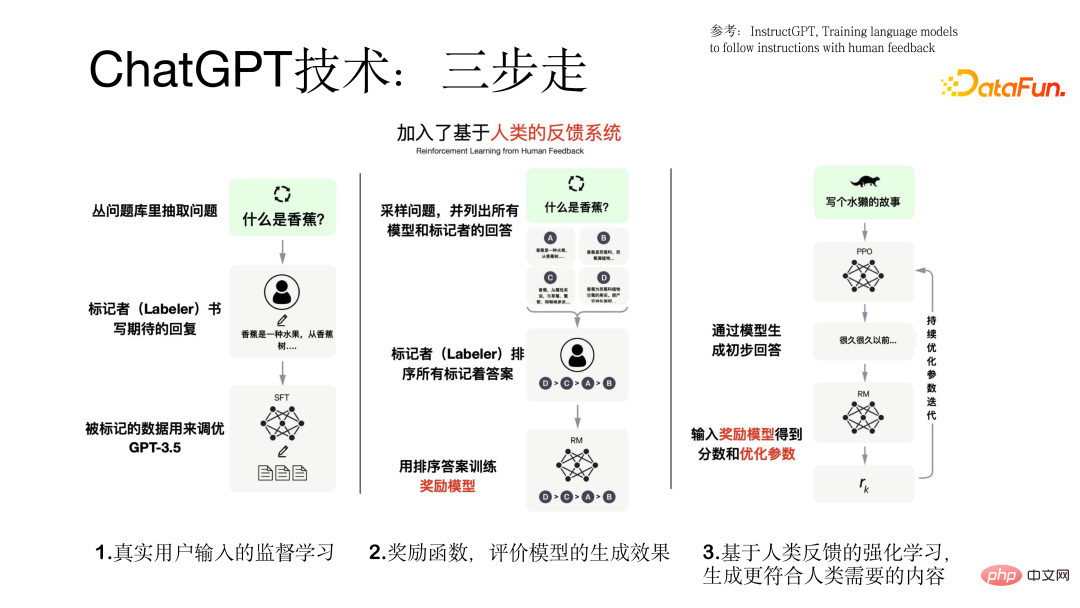

在ChatGPT 模型出來之前的模型有什麼樣的問題呢?透過分析發現存在的一個比較顯著的問題是對齊問題,雖然大模型的生成能力比較強,但是生成的答案有時不符合使用者意圖。透過研究發現造成對齊問題出現的主要原因是語言模型訓練的訓練目標是預測下一個詞,而不是按照使用者意圖來產生。為了解決對齊問題,在訓練 ChatGPT 模型過程中加入了基於人類回饋的強化學習(Reinforcement Learning from Human Feedback,RLHF)流程。

#ChatGPT 模型的訓練過程是按照三步驟走的形式進行的。

第一步是#在GPT 模型基礎上使用真實使用者的輸入進行監督學習,在這個過程中數據來自真實用戶,數據品質比較高也比較寶貴。

第二步是#訓練一個獎勵模型,對於一個query 透過不同模型會產生不同的輸出結果,標記者對所有模型的輸出結果進行一個排序,用這些排序後的資料訓練獎勵模型。

#第三步是把模型產生的初步答案輸入到獎勵模型當中,獎勵模型會對這個答案進行一個評價,如果產生的答案符合使用者的意圖就給一個正向的回饋,否則就給一個負向的回饋,從而把模型調教的越來越好,這就是引入強化學習的目的,使得生成的結果更符合人類的需要。訓練 ChatGPT 模型過程中三步驟的流程如下圖所示。

#在訓練模型之前我們需要準備好所使用的資料集,在這個過程中就會遇到資料冷啟動的問題,可以透過以下三個面向來解決:

(1)蒐集舊系統使用者所使用的資料集

##(2)讓標註人員根據先前真實使用者輸入的問題標註一些相似的prompt 和輸出

#(3)資料標註人員從問答、寫故事、生成等自己想的一些prompt。

訓練ChatGPT 模型的資料包含三部分資料集(77k 真實資料):(1)基於真實使用者prompt 的監督學習數據,用戶prompt,模型response,數據量有13k。

(2)用於訓練獎勵模型的資料集,這部分資料對於一個 prompt 對應多個response 的排序,資料量有 33k。

(3)基於獎勵模型使用強化學習技術進行模型訓練的資料集,只需要使用者prompt,資料量有31k,對品質要求較高。

完成ChatGPT 模型訓練後,對於模型的評估也是比較充分的,主要從以下幾個面向來評估:(1 )模型產生的結果是否符合使用者的意圖

(2)產生的結果能不能滿足使用者提到的限制

#(3)模型在客服領域能否有好的效果

#透過和GPT 基礎模型進行比較的詳細實驗結果如下圖所示。

#以下將從背景與問題、解決想法、效果與實踐三個面向介紹我們進行ChatGPT 技術國產化的內容。

#為什麼要進行國產化,主要考慮了以下幾個面向:

(1)ChatGPT 技術本身是比較先進的,在許多任務上效果比較好,但是不對中國大陸提供服務。

(2)可能無法滿足國內企業級客戶的需求,無法提供在地化技術支援和服務。

(3)價格是以歐美為主要市場的美元進行計價的,價格比較昂貴,國內多數用戶可能承受不起。透過測試發現每個資料約需要花費 0.5 元人民幣,對於擁有大量資料的客戶無法進行商業化。 #

因為以上三個問題,我們嘗試了 ChatGPT 技術國產化。

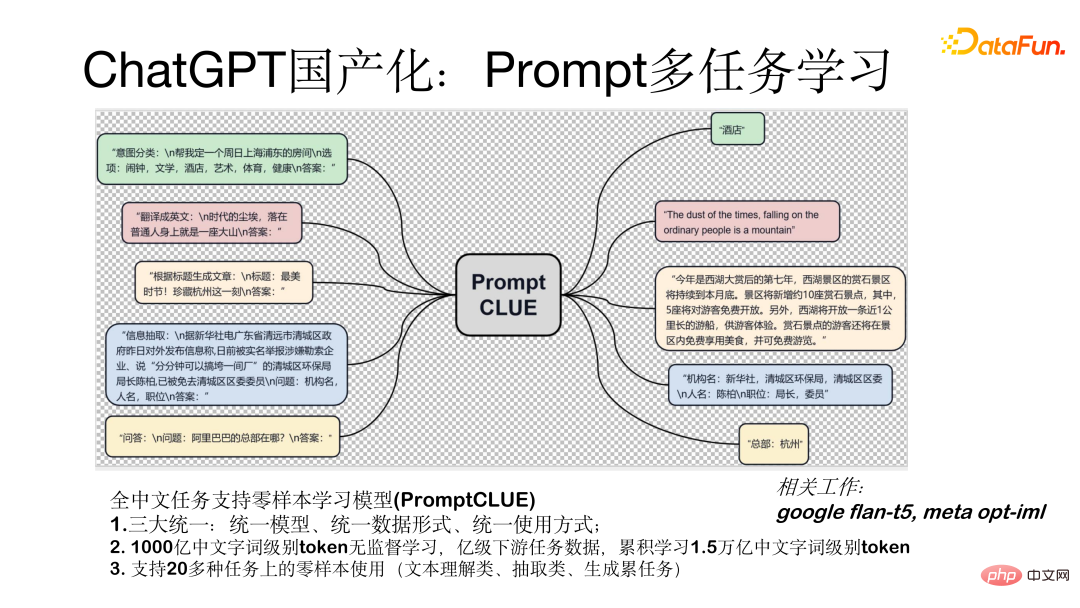

#我們在進行ChatGPT 技術國產化過程中,採用了分佈走的策略。

首先訓練了一個具有百億參數的中文預訓練模型;其次在億級任務資料上使用Prompt 的形式進行任務監督學習;然後把模型對話化,即以對話或人機互動的形式和人進行互動;最後我們引入獎勵模型和使用者回饋的強化學習RLHF 技術。

Prompt 多任務學習模型(PromptCLUE)是一個支援全中文任務零樣本學習的模型。此模型實現了三大統一:統一模型、統一資料形式(所有任務轉化為 prompt 形式)、統一使用方式(零樣本的形式進行使用)。該模型是基於 1000 億中文字詞級別 token 進行無監督學習,在億級下游任務數據上進行訓練,累積學習了 1.5 兆中文字詞級別 token。支援 20 多種任務上的零樣本使用(文字理解類別、抽取類別、生成類別任務)。

如何把模型進行對話化,也就是轉換為人機互動形式的模型,我們主要做瞭如下幾方面的工作:

首先為了讓模型具有比較好的生成效果,我們移除了文字理解類別和抽取類別的任務,這樣就加強了問答、對話和生成類別任務的學習;其次,轉變成對話模型後,生成結果會受到上下文的干擾,針對這個問題,我們加入了抗干擾數據,使得模型可以在必要時忽略無關的上下文;最後,我們基於真實用戶的反饋數據加入了學習過程,使得模型更能理解使用者的意圖。下圖是和模型進行單輪和多輪測試的形式。

以下是針對模型進行測試的效果,透過比較目前與ChatGPT 模型相比還有1~2 年的差距,不過這種差距是可以逐步彌補的,目前我們進行了一些有益的嘗試,也有了一定的效果,目前可以進行一些對話、問答、寫作等互動。下圖展示了測試結果。

我們最近剛發布的元語功能型對話大模型(ChatYuan)參數量有7.7 億,線上的版本是具有100 億參數量的模型,已經上線了多個平台,包括Huggingface、ModelScope、Github 、paddlepaddle 都可以使用。模型可以下載到本機,根據自己的使用者資料集進行微調。它是基於 PromptCLUE-large 結合數億個功能對話多輪對話資料進一步訓練得到。

#上以Huggingface 平台為例,展示了模型本機使用方法。在平台搜尋ChatYuan,載入模型,進行簡單的包裝。使用中有一些比較重要的參數,例如是否採樣 sample,如果需要產生的比較多樣就需要採樣。

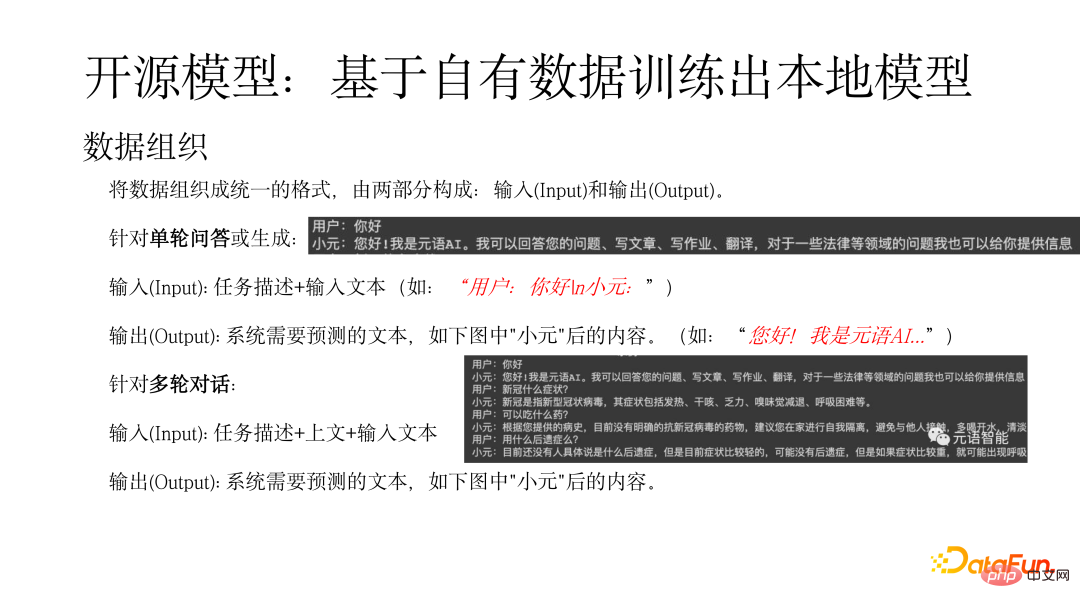

#首先需要將資料組織成統一的形式,由兩部分構成:輸入(Input)和輸出(Output)。對於單輪問答或產生輸入(Input):任務描述輸入文字(如:“用戶:你好n小元:”),輸出(Output)是指系統需要預測的文字(如:“您好!我是元語AI...”)。對於多輪對話輸入(Input):任務描述 上文 輸入文本,輸出是指系統需要預測的文本,如下圖中"小元"後的內容。

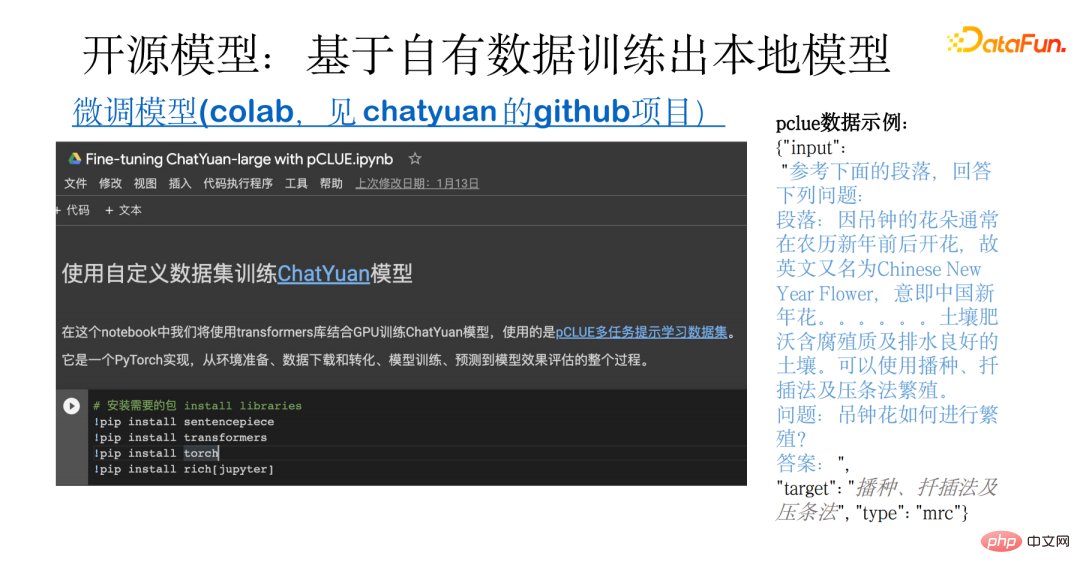

下圖展示了基於自有資料進行訓練本地模型的範例。這個範例涵蓋了整個過程,從資料的準備,到開源資料的下載、轉化,還包括模型的訓練、預測和評估。其基礎使用的是 pCLUE 多工資料集。使用者可以使用自己的資料進行訓練,也可以使用 pCLUE 進行初步的訓練,來測試效果。

ChatYuan 和ChatGPT 都是通用型功能型對話大模型,都能夠在閒聊或法律、醫療等專業領域進行問答、互動和產生。透過和ChatGPT 模型比較,目前還有一定的差距,主要體現在是以下幾個方面:

在使用模型過程中可能會遇到產生效果和文字長度方面的問題,取決於資料格式是否正確,在生成過程中是否採樣sample,輸出結果的長度控制max_length 等。

要進一步提升模型效果,可以從以下幾個面向入手:

(1)結合產業資料進行進一步訓練,包括無監督預訓,以及使用大量高品質的資料進行有監督學習。

(2)使用真實使用者回饋資料的學習可以彌補分佈差異。

(3)引入強化學習,對齊使用者意圖。

(4)選用較大的模型,一般來說模型越大,模型能力越強。

ChatGPT 帶來的新技術和使用場景,讓人們看到了 AI 的巨大潛力。更多應用都將升級,也為一些新應用創造了可能。

元語智能,作為大模型 Model-as-a-Service 服務商,在這一領域也在不斷探索中。歡迎有興趣的夥伴關注我們的網站和公眾號。

今天的分享就到這裡,謝謝大家。以上是ChatGPT技術國產化嘗試的詳細內容。更多資訊請關注PHP中文網其他相關文章!