還在為玩不了ChatGPT苦惱?這十幾個開源平替也能體驗智慧對話

距離 ChatGPT 的最初發布,過去差不多四個月的時間了。在這段期間,ChatGPT 的驚艷表現,讓人直呼 AIGC 是不是要提前實現了。

不過眾所周知的一個秘密是,ChatGPT 不大可能開源,加上巨大的算力投入以及海量的訓練資料等,都為研究界複製其實現過程設下重重關卡。

面對 ChatGPT 的來勢洶洶,開源平替是一個不錯的選擇,它們在實現相似功能的同時,還能讓你透過替代品了解 ChatGPT 的運行機理。

隨著技術的進步,現在已經出現了許多其他類似 ChatGPT 的新 AI 模型。本文我們將為大家盤點 ChatGPT 的開源平替專案。內容將分為兩部分,一部分為類別 ChatGPT 開源專案匯總,另一部分是對該專案匯總的補充。

專案總結

專案作者 nichtdax 整理了 9 個開源的 ChatGPT 平替專案。接下來會一一介紹。

#專案網址:https://github.com/nichtdax/awesome -totally-open-chatgpt

PaLM-rlhf-pytorch

第一個專案是「PaLM-rlhf-pytorch」,計畫作者為Phil Wang。該專案是在 PaLM 架構之上實現 RLHF(人類回饋的強化學習),它基本上是使用 PaLM 的 ChatGPT。

該專案已在 GitHub 上獲得了 5.8k 的 Stars。

#專案位址:https://github.com/lucidrains/PaLM-rlhf- pytorch

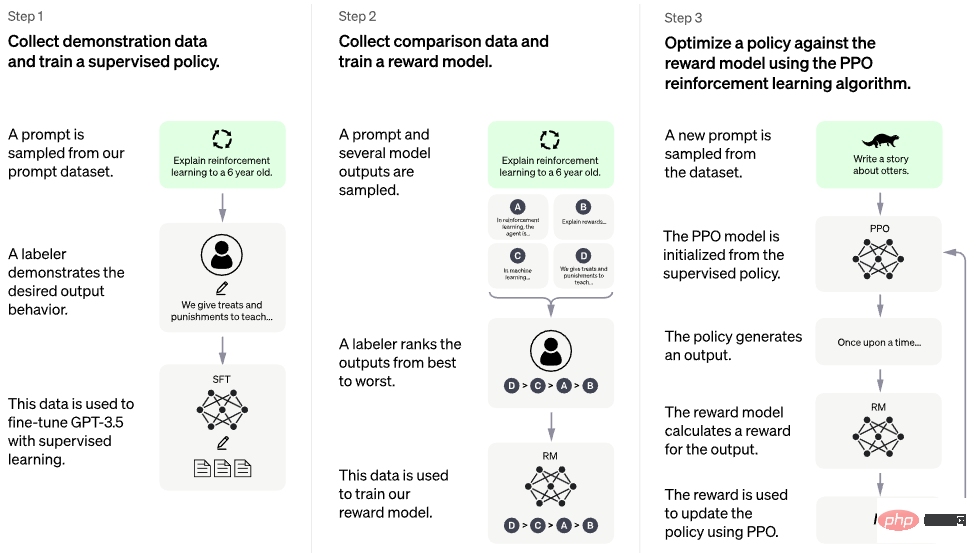

下圖為訓練流程。

OpenChatKit

第二個項目是「OpenChatKit」,它提供了一個強大的開源基礎,為各種應用程式創建專用和通用的聊天機器人。該 kit 包含了一個經過指令調優的 200 億參數語言模型、一個 60 億參數調節模型和一個涵蓋自訂儲存庫最新回應的可擴展檢索系統。

OpenChatKit 是在 OIG-43M 訓練資料集上訓練的,該資料集是 Together、LAION 和 Ontocord.ai 三者的聯合。專案作者表示,這不僅是一個模型的發布,也是一個開源專案的開始。他們正在發布一套工具和流程,並透過社群貢獻持續改進。

該專案已在 GitHub 上獲得了 5.7k 的 Stars。

#專案網址:https://github.com/togethercomputer/OpenChatKit

#text-generation-webui

第三個項目是“text-generation-webui”,它是一個用於運行GPT-J 6B、OPT、GALACTICA、LLaMA 和Pygmalion 等大語言模型的gradio web UI。該專案旨在成為文本生成領域的 AUTOMATIC1111/stable-diffusion-webui。

功能包括使用下拉式選單在不同模型之間切換、提供類似OpenAI playground 的筆電模式、用於對話和角色扮演的聊天模式、為GPT-4chan 產生漂亮的HTML 輸出等等。

該專案已在 GitHub 上獲得了 3.4k 。

#專案位址:https://github.com/oobabooga/text-generation- webui

KoboldAI-Client

第四個專案是「KoboldAI-Client」,它是一個基於瀏覽器的前端,透過多個本地和遠端AI 模型實現AI 輔助寫作。

KoboldAI-Client 提供了一系列標準的工具,包括記憶體、作者註解、世界資訊、儲存& 載入、可調節的AI 設定、格式化選項以及匯入現有文字冒險遊戲《AI Dungeon》的能力。你可以開啟 Adventure 模式,也可以玩 AI Dungeon Unleashed 之類的遊戲。

該專案已在 GitHub 上獲得了 1.4k。

#專案位址:https://github.com/KoboldAI/KoboldAI-Client

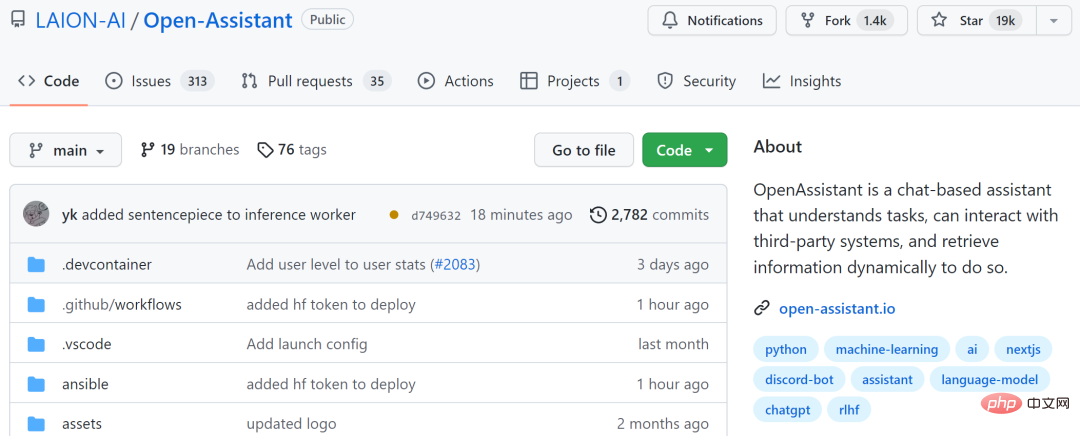

Open-Assistant

第五個項目是“Open-Assistant”,它旨在讓每個人都可以存取基於聊天的大語言模型。計畫作者希望藉此在語言創新方面掀起一場革命,就像 stable diffusion 幫助世界以新的方式創造藝術和圖像一樣。

專案作者計畫收集高品質人工產生指令執行樣本(指示 回應),目標大於 50k。對於收集到的每個指示,他們將採樣多個補全結果。接下來進入基於指示和獎勵模型的 RLHF 訓練階段。

該專案已在 GitHub 上獲得了 19k 的 Stars。

#專案網址:https://github.com/LAION-AI/Open- Assistant

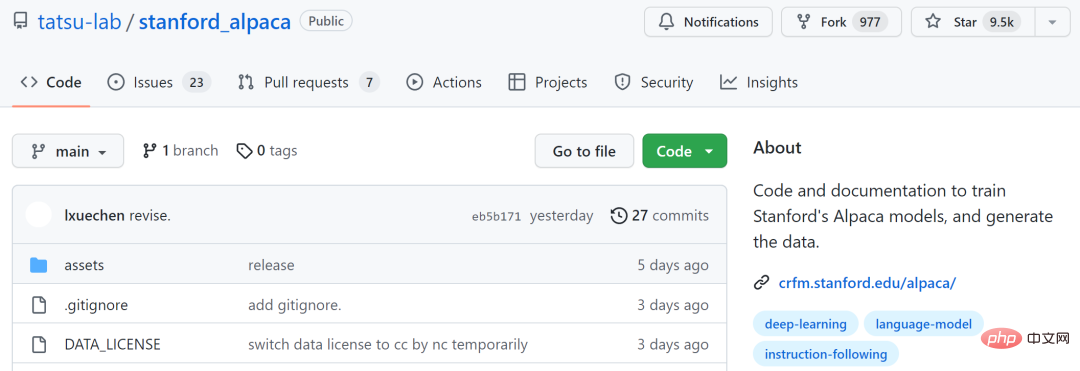

stanford_alpaca

第六個項目是“stanford_alpaca”,它旨在建立和共享一個指令遵循的LLaMA 模型。該 repo 包含了用於微調模型的 52k 資料、用於生成資料的程式碼以及用於微調模型的程式碼。

該專案已在 GitHub 上獲得了 9.5k 的 Stars。

#專案網址:https://github.com/tatsu-lab/stanford_alpaca

ChatRWKV

第七個專案是“ChatRWKV”,它類似於ChatGPT,但由RWKV(100% RNN)模型支持,並且是開源的。專案作者表示,RWKV 是目前唯一能在品質和擴展方面媲美 transformers 的 RNN 模型,同時速度更快、節省 VRAM。

該專案已在 GitHub 上獲得了 3.5k 的 Stars。

#專案位址:https://github.com/BlinkDL/ChatRWKV

#ChatGLM-6B

第八個項目是由清華技術成果轉化的公司智譜AI 開源、支援中英雙語的對話語言模型“ChatGLM-6B”,基於General Language Model (GLM) 架構,具有62 億參數。結合模型量化技術,使用者可以在消費級的顯示卡上進行本地部署(INT4 量化等級下最低只需 6GB 記憶體)。

ChatGLM-6B 使用了和 ChatGPT 相似的技術,針對中文問答和對話進行最佳化。經過約 1T 標識符的中英雙語訓練,輔以監督微調、反饋自助、人類反饋強化學習等技術的加持,62 億參數的 ChatGLM-6B 已經能產生相當符合人類偏好的答案。

不過由於ChatGLM-6B 的規模較小,目前已知其具有相當多的局限性,如事實性/ 數學邏輯錯誤、可能生成有害/ 有偏見內容、較弱的脈絡能力、自我認知混亂、以及對英文指示生成與中文指示完全矛盾的內容。

該專案已在 GitHub 上獲得了 6k 的 Stars。

#專案位址:https://github.com/THUDM/ChatGLM-6B

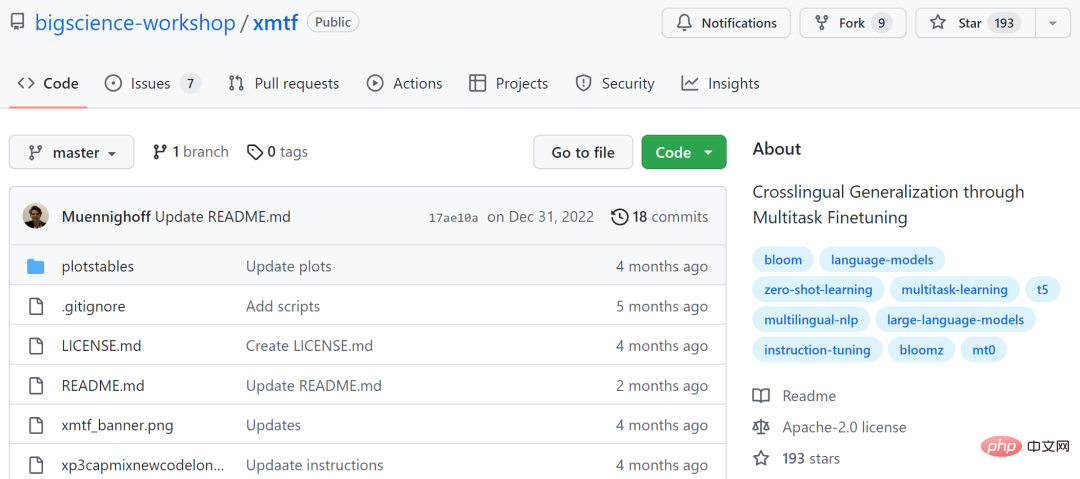

xmtf

第九個專案是「xmtf」,包含了創建論文《Crosslingual Generalization through Multitask Finetuning》中介紹的BLOOMZ、mT0 和xP3 的所有元件。

其中BLOOMZ 是一個1760 億參數且可開放獲取的多語言模型;mT0(這裡特指谷歌的T5X);xP3 是46 種語言的有監督資料集,帶有英文和機器翻譯的prompts。

#專案位址:https://github.com/bigscience-workshop/xmtf

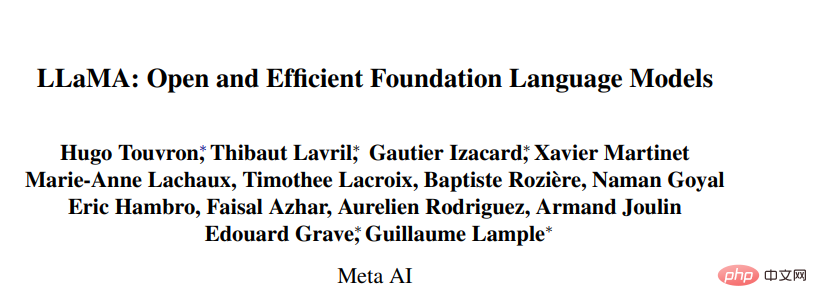

除了上述提到的模型,ChatGPT 平替專案還包括基於Meta 開源的大模型系列 LLaMA(Large Language Model Meta AI)的一些研究,這個系列模型的參數量從70 億到650 億不等。具有130 億參數的LLaMA 模型「在大多數基準上」可以勝過GPT-3( 參數量達1750 億),而且可以在單塊V100 GPU 上運行;而最大的650 億參數的LLaMA 模型可以媲美谷歌的Chinchilla-70B 和PaLM-540B。

- 論文連結:https://research.facebook.com/publications/llama-open-and-efficient-foundation-language -models/

- GitHub 連結:https://github.com/facebookresearch/llama

基於此研究,開發者也提出了幾個開源專案。

llama.cpp 無需GPU,就能運行LLaMA

llama.cpp 專案實現了在MacBook 上運行LLaMA,還有開發者成功的在4GB RAM 的樹莓派上運行了LLaMA 7B。總結而言,即使開發者沒有 GPU ,也能運行 LLaMA 模型。

#專案網址:https://github.com/ggerganov/llama.cpp

ChatLLaMA

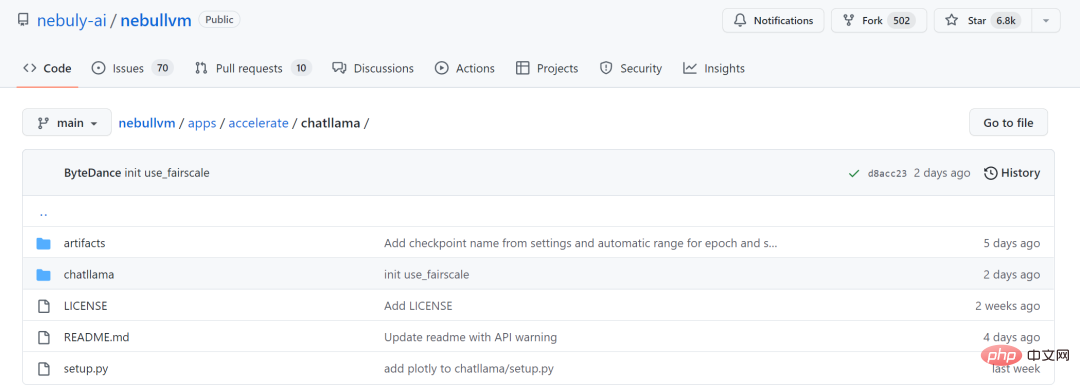

#由於 LLaMA 大模型系列沒有使用 RLHF 方法,因此新創公司 Nebuly AI 開源了 RLHF 版 LLaMA(ChatLLaMA)的訓練方法。它的訓練過程類似 ChatGPT,該計畫允許基於預訓練的 LLaMA 模型建立 ChatGPT 形式的服務。與ChatGPT 相比,LLaMA 架構更小,但訓練過程和單GPU 推理速度更快,成本更低;該庫還支援所有的LLaMA 模型架構(7B、13B、33B、65B),因此用戶可以根據訓練時間和推理性能偏好對模型進行微調。

#專案位址:https://github.com/nebuly-ai/nebullvm/ tree/main/apps/accelerate/chatllama

期待後續更多開源專案加入。

以上是還在為玩不了ChatGPT苦惱?這十幾個開源平替也能體驗智慧對話的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

文字標註工作是將標籤或標記與文字中特定內容相對應的工作。其主要目的是為文本提供額外的信息,以便進行更深入的分析和處理,尤其是在人工智慧領域。文字標註對於人工智慧應用中的監督機器學習任務至關重要。用於訓練AI模型,有助於更準確地理解自然語言文本訊息,並提高文本分類、情緒分析和語言翻譯等任務的表現。透過文本標註,我們可以教導AI模型識別文本中的實體、理解上下文,並在出現新的類似數據時做出準確的預測。本文主要推薦一些較好的開源文字標註工具。 1.LabelStudiohttps://github.com/Hu

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

圖像標註是將標籤或描述性資訊與圖像相關聯的過程,以賦予圖像內容更深層的含義和解釋。這個過程對於機器學習至關重要,它有助於訓練視覺模型以更準確地識別圖像中的各個元素。透過為圖像添加標註,使得電腦能夠理解圖像背後的語義和上下文,從而提高對圖像內容的理解和分析能力。影像標註的應用範圍廣泛,涵蓋了許多領域,如電腦視覺、自然語言處理和圖視覺模型具有廣泛的應用領域,例如,輔助車輛識別道路上的障礙物,幫助疾病的檢測和診斷透過醫學影像識別。本文主要推薦一些較好的開源免費的圖片標註工具。 1.Makesens

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

人臉偵測辨識技術已經是一個比較成熟且應用廣泛的技術。而目前最廣泛的網路應用語言非JS莫屬,在Web前端實現人臉偵測辨識相比後端的人臉辨識有優勢也有弱勢。優點包括減少網路互動、即時識別,大大縮短了使用者等待時間,提高了使用者體驗;弱勢是:受到模型大小限制,其中準確率也有限。如何在web端使用js實現人臉偵測呢?為了實現Web端人臉識別,需要熟悉相關的程式語言和技術,如JavaScript、HTML、CSS、WebRTC等。同時也需要掌握相關的電腦視覺和人工智慧技術。值得注意的是,由於Web端的計

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

安裝步驟:1、在ChatGTP官網或手機商店下載ChatGTP軟體;2、開啟後在設定介面中,選擇語言為中文;3、在對局介面中,選擇人機對局並設定中文相譜;4 、開始後在聊天視窗中輸入指令,即可與軟體互動。

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

向大家介紹一個最新的AIGC開源專案-AnimagineXL3.1。這個專案是動漫主題文字到圖像模型的最新迭代,旨在為用戶提供更優化和強大的動漫圖像生成體驗。在AnimagineXL3.1中,開發團隊專注於優化了幾個關鍵方面,以確保模型在效能和功能上達到新的高度。首先,他們擴展了訓練數據,不僅包括了先前版本中的遊戲角色數據,還加入許多其他知名動漫系列的數據納入訓練集中。這項舉措豐富了模型的知識庫,使其能夠更全面地理解各種動漫風格和角色。 AnimagineXL3.1引入了一組新的特殊標籤和美學標

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名