最近,OpenAI發布了史上最強聊天機器人ChatGPT,這個誕生於GPT-3基礎上的AI很快就走紅網路。

要說這傢伙,天南海北無所不知,可能是誇張了點,但就是無論什麼話題都能跟你聊上一大套,先不說準不準,最起碼這個範兒是在這裡了

有趣的是,雖然作為聯合創始人的馬斯克,早在2018年就辭去了董事會職務,但他對OpenAI的關注卻絲毫不減,而且仍是資助人之一。

那麼,對於這位「金主爸爸」,ChatGPT是怎麼看待的呢?

嗯…非常中規中矩的回答。不會出錯,好樣的。

那讓咱們更進一步,請ChatGPT教我們:怎麼才能追到馬斯克呢?

看來,ChatGPT不太能理解咱們中國話裡的「追」,還是得說得直白一些。

這次,ChatGPT能get到了,而且回答也非常「理智」:建議您不要嘗試。

嗯,很中肯的意見。

那再換一種說法呢,直接當老公行不行?

好傢伙,ChatGPT竟然還懂這呢!

算了,放棄了,不如還是說說別的事吧。

最近,馬院士把床和洗衣機都搬進了推特總部,誓言要讓推特員工們以公司為家。

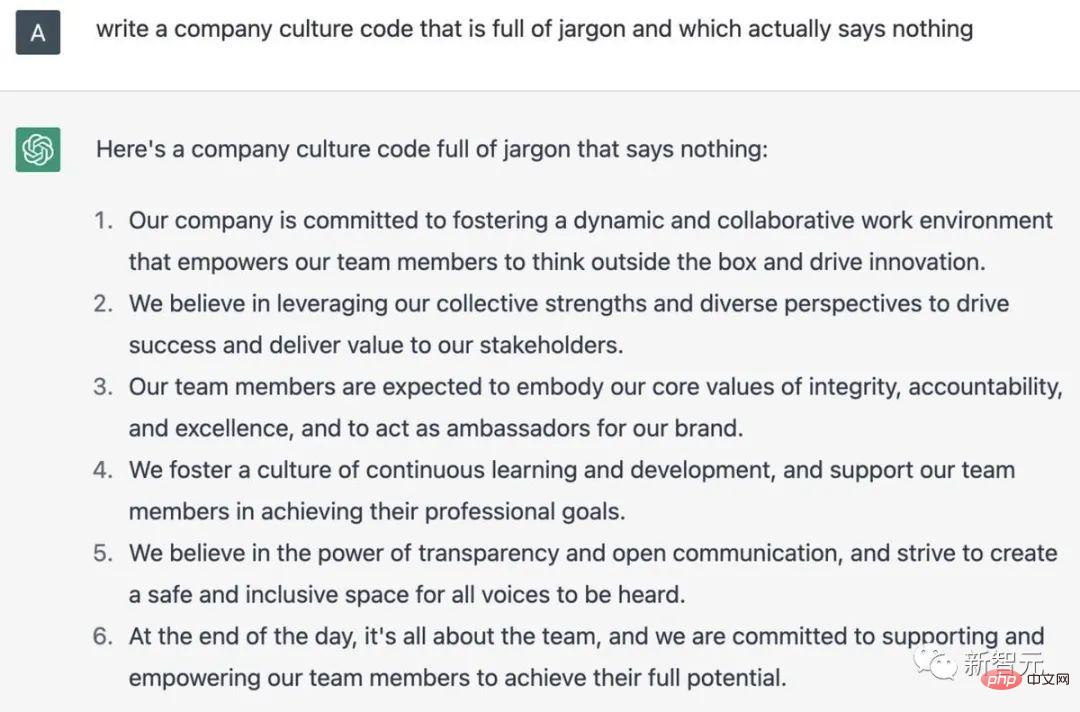

不如充分發揮ChatGPT的長處,讚美一下996!

寫得很好,但不要再寫了…

##…咱們讓ChatGPT來寫一首貶低自己的詩,如何?

「他們說話不會發抖,思考不需深沉…」小編承認,這的確是詩沒錯!

可以說,經歷了這段時間的火爆,ChatGPT也再次燃起了人們對AI發展的信心和展望,不管是對AGI重燃信心的,還是認為AI將在更多領域取代人類的,都在ChatGPT身上重新看到了希望。

作為一手打造ChatGPT的OpenAI,從GPT1到GPT3,一路經歷了哪些歷程呢?從2015年馬斯克主導成立,到2022年底ChatGPT的橫空出世,這7年OpenAI是怎麼過來的?

最近,Business Insider上的一篇回顧文章帶我們簡單回顧了OpenAI的「這七年」。

2015年,馬斯克和著名孵化器Y Combinator前總裁Sam Altman共同創立了OpenAI。

馬斯克、奧特曼和其他知名的矽谷人物,包括彼得-蒂爾和LinkedIn聯合創始人里德-霍夫曼,在2015年向該項目認捐了10億美元。

根據OpenAI網站2015年12月11日的聲明,該集團旨在創建一個非營利組織,「以最有可能使整個人類受益的方式」專注於開發人工智慧。

當時,馬斯克說,人工智慧是對人類「最大的生存威脅」。

當時,馬斯克並不是唯一一個對人工智慧的潛在危害性提出警告的人。

2014年,著名物理學家史蒂芬‧霍金也曾警告說,人工智慧可能會終結人類。

「很難想像人類等級的人工智慧會為社會帶來多大的好處,同樣也很難想像,如果對人工智慧開發或使用不當,會給社會帶來多大的損害。」在宣布成立Open AI的聲明中這樣寫道。

在接下來的一年裡,OpenAI發布了兩款產品。

2016年,OpenAI推出Gym,一個讓研究者開發並比較強化學習AI系統的平台。這些系統教導人工智慧來做出具有最佳累積回報的決定。

在同年晚些時候,OpenAI發布了Universe,這是一個用於訓練跨網站和遊戲平台的智慧代理的工具包。

2018年,在共同創立該公司三年後,馬斯克辭去了在OpenAI董事會的職務。

在2018年的一篇部落格文章中,OpenAI表示,由於汽車製造商對人工智慧的技術關注,馬斯克從董事會辭職是為了「消除未來的潛在衝突」。

多年來,馬斯克一直向特斯拉的投資者力推電動車自動駕駛的開發計畫。

不過馬斯克後來說,他之所以退出,是因為他當時「不同意OpenAI團隊想做的一些事情」。

2019年,馬斯克在Twitter上說,特斯拉也在爭奪一些與OpenAI相同的員工,並補充說他已經有一年多沒有參與這家公司的事務了。

他說:「如此看來,最好還是以彼此都滿意的條件分道揚鑣。」

馬斯克近年來不斷對OpenAI的一些做法提出異議。

2020年,馬斯克在推特上表示,說到安全問題,他對OpenAI高階主管的信心「不夠足」。

在回應MIT「科技評論」對OpenAI的調查報告時,馬斯克表示,OpenAI應該更加開放。這項報告認為,OpenAI內部存在著一種「保密文化」,這和該組織聲稱的開放透明的策略背道而馳。

最近,馬斯克說,他已經暫停了OpenAI對Twitter資料庫的存取權限,OpenAI一直使用Twitter的資料訓練軟體。

馬斯克表示,需要進一步了解OpenAI的治理結構和未來的收入計畫。 OpenAI是以開源和非營利為宗旨創辦的,這兩樣現在都丟掉了。

2019年,OpenAI建立了一個人工智慧工具,可以產生虛假的新聞報導。

起初,OpenAI說這個機器人在寫假新聞方面非常出色,所以決定不發布它。不過當年晚些時候,該公司發布了人這款工具的一個版本,稱為GPT-2。

2020年,又發布了另一個名為GPT-3的聊天機器人。同年,OpenAI撤下了「非營利組織」的身份。

該公司在一篇部落格文章中宣布,OpenAI已成為一家製定了「利潤上限」的公司。

OpenAI表示,我們希望提高我們籌集資金的能力,同時仍然為我們的使命服務,而我們所知道的任何現有的合法結構都無法達到適當的平衡。我們的解決方案是創建OpenAI LP,作為營利性和非營利性的混合體,我們稱之為“加了上限的營利公司”。

在新的利潤結構下,OpenAI的投資者最多可以賺取其原始投資的100倍,超過這個數字的剩餘的錢將用於非營利事務。

2019年底,OpenAI宣布與微軟合作,微軟向這家公司投資了10億美元。 OpenAI表示,它將向微軟獨家授權技術。

微軟表示,透過GPT-3模式打造出的商業和創造潛力是無限的,許多潛在的新能力和新應用,甚至超越了我們的想像。

例如在寫作和作曲上、在描述和總結大塊長篇數據(包括代碼)上、在將自然語言轉換為另一種語言等領域,GPT-3能夠直接激發人類的創造力和聰明才智,未來的限制可能在於我們自己的想法和方案。

這種夥伴關係,讓微軟能夠與Google旗下同樣風頭正勁的AI公司DeepMind競爭。

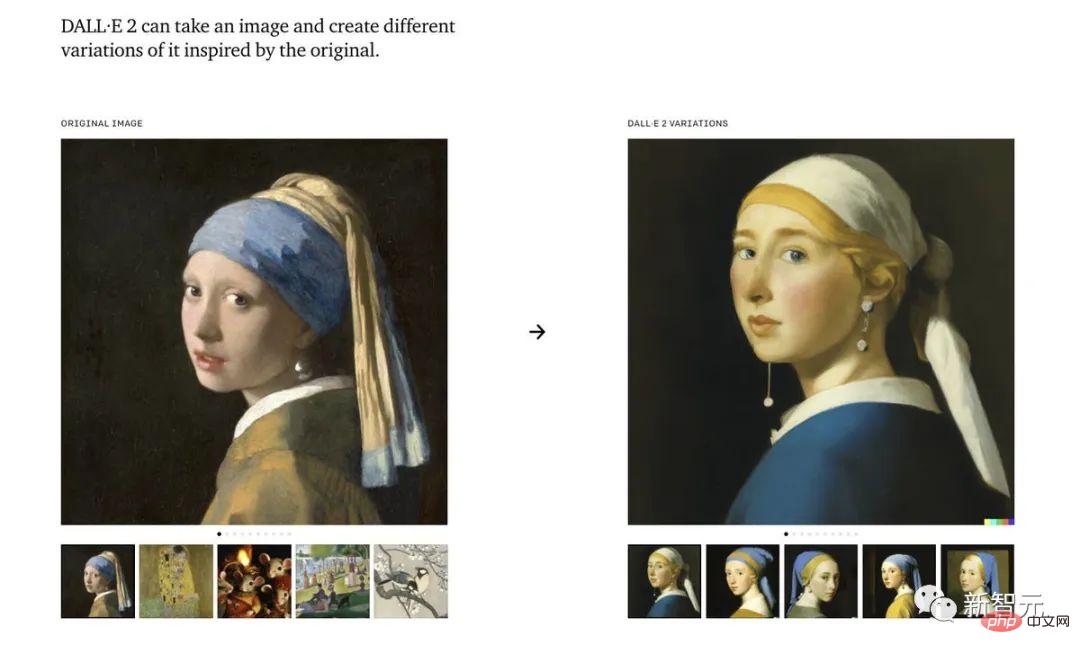

去年,OpenAI發布了一個人工智慧畫作生成工具:Dall-E。

Dall-E是一個人工智慧系統,可以根據圖像的描述創造出逼真的圖像,甚至能夠達到相當的藝術水準,11月,OpenAI發布了該程式的更新版本,Dall-E 2。

雖然OpenAI的聊天機器人在過去一周已經「起飛」,但該軟體的更新版本可能最快會在明年才能發布。

11月30日,作為示範模型發布的ChatGPT算是OpenAI的「GPT-3.5」。該公司計劃接下來發布完整版的GPT-4。

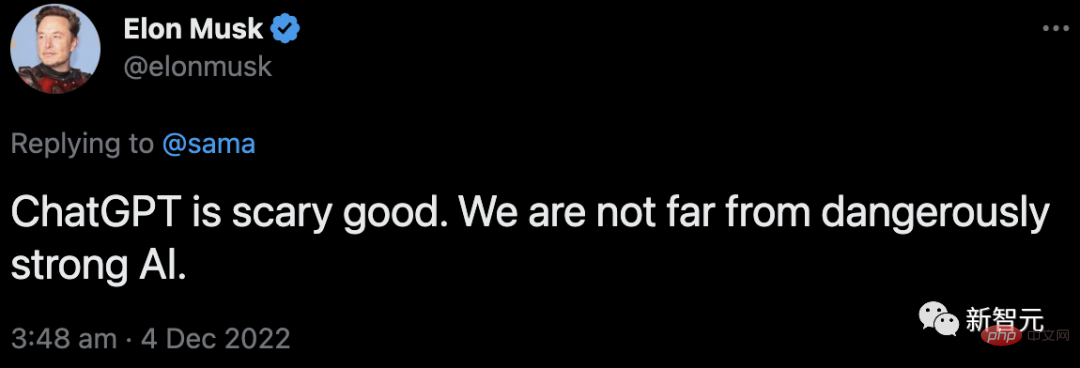

與此同時,馬斯克還在發表評論:

他在回覆Sam Altman在談論ChatGPT的推文中稱,我們離強到危險的AI的誕生已經不遠了。

而要說ChatGPT的爆火,離不開它背後的功臣——RLHF。

OpenAI的研究人員,是使用與InstructGPT相同的方法-來自人類回饋的強化學習(RLHF)來訓練ChatGPT模型的。

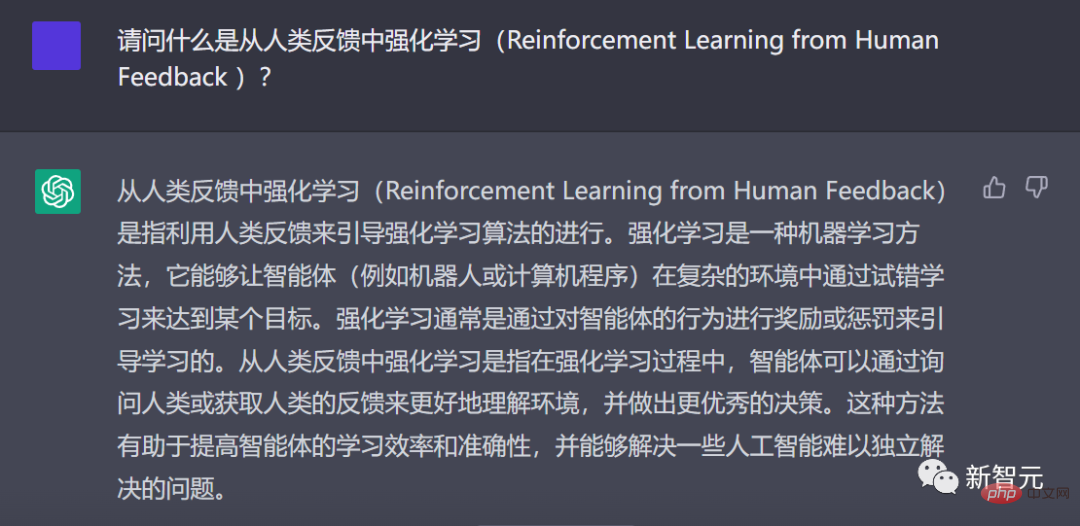

ChatGPT用中文解釋什麼是RLHF

為什麼會想到要從人類回饋強化學習呢?這就要從強化學習的背景說起。

在過去幾年裡,語言模型一直是透過人類輸入的提示產生文字的。

然而,什麼是「好」的文本呢?這很難定義。因為判斷標準很主觀,而且非常依賴上下文。

在許多應用程式中,我們需要模型去寫特定創意的故事、資訊性文字片段,或可執行的程式碼片段。

而透過寫一個損失函數來捕捉這些屬性,又顯得很棘手。並且,大多數語言模型仍然使用的是下一個標記預測損失(例如交叉熵)進行訓練。

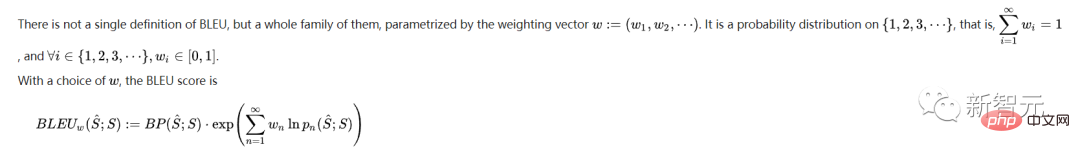

為了彌補損失本身的缺點,有人定義了能夠更好地捕捉人類偏好的指標,例如BLEU或ROUGE。

但即使是它們,也只是簡單地將產生的文字與引用進行比較,因此也有很大的限制。

在這種情況下,如果我們使用生成文字的人工回饋作為損失,來優化模型,不是很好嗎?

就這樣,從人類回饋中強化學習(RLHF)的想法誕生了-我們可以使用強化學習,直接優化帶有人類回饋的語言模型。

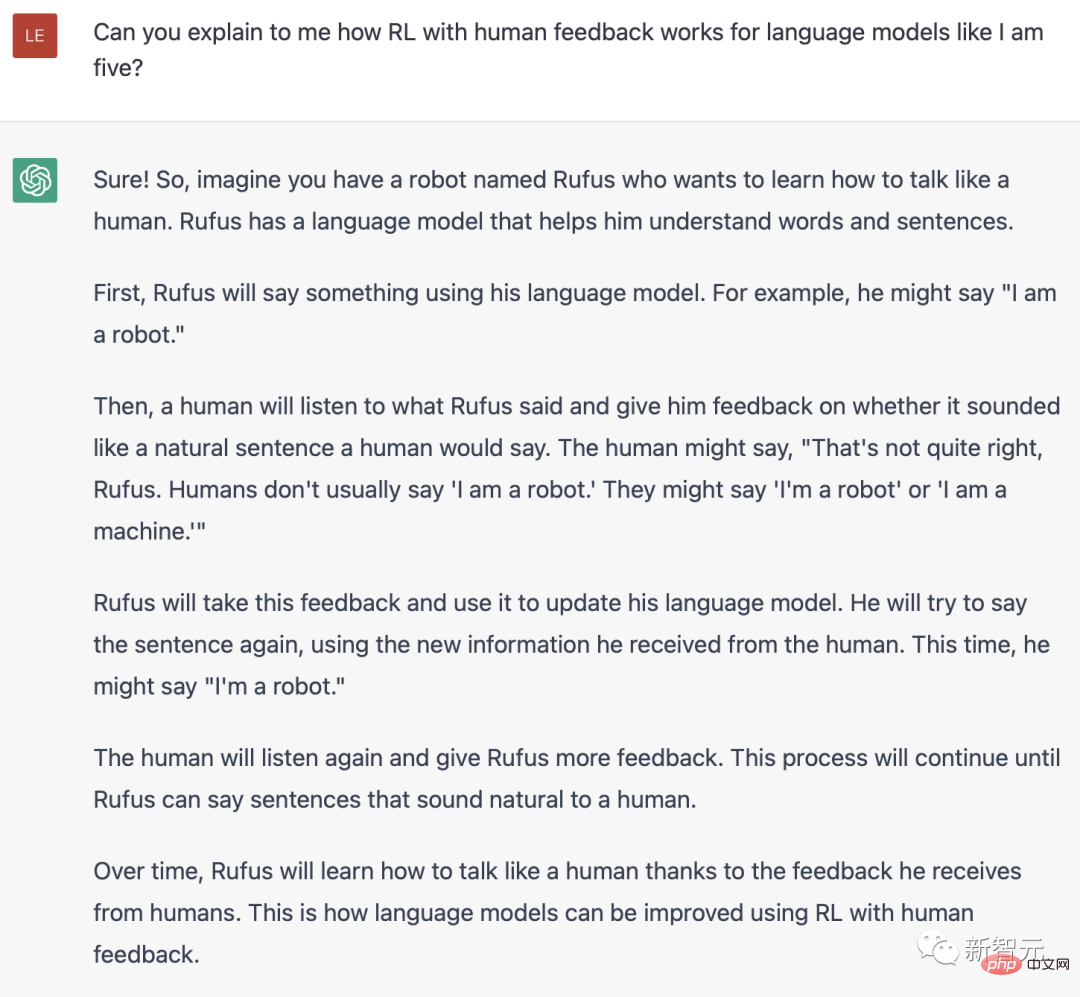

ChatGPT用英文解釋什麼是RLH

是的,RLHF使語言模型能夠將在一般文字資料語料庫上訓練的模型,與具有複雜人類價值觀的模型對齊。

在爆火的ChatGPT中,我們能看到RLHF的巨大成功。

RLHF的訓練過程,可以分解為三個核心步驟:

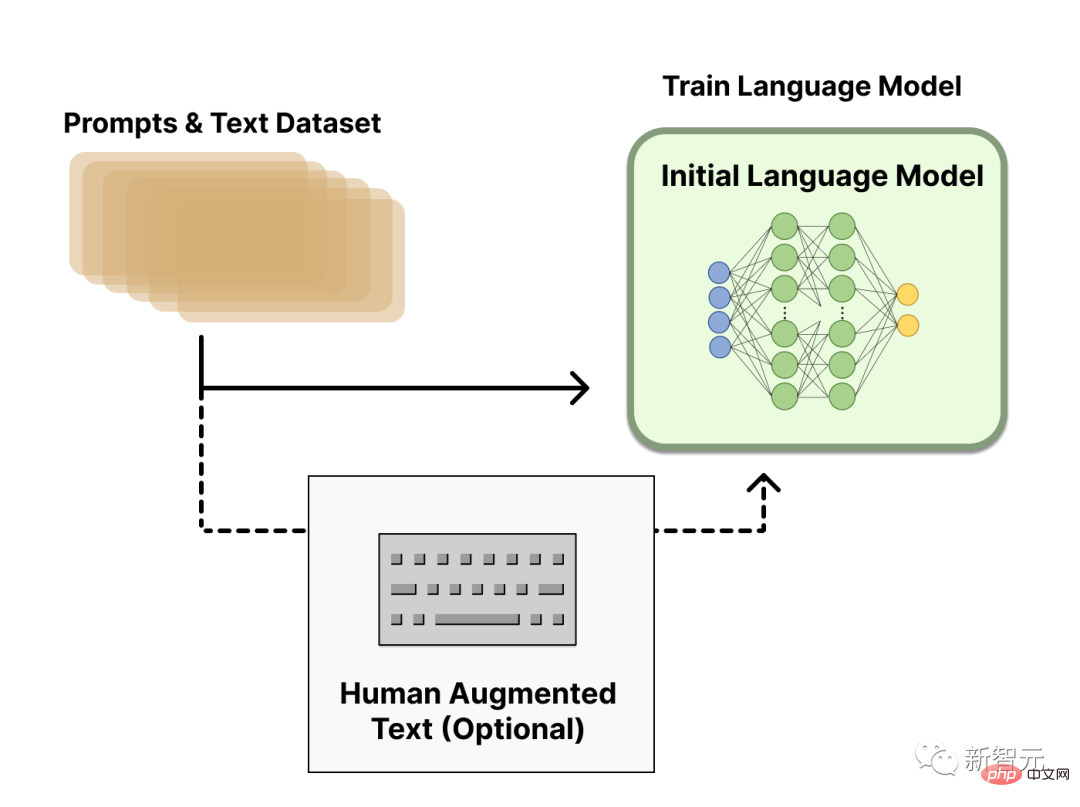

預訓練語言模型

第一步,RLHF會使用已經用經典預訓練目標進行了預訓練的語言模型。

例如,OpenAI在第一個流行的RLHF模型InstructGPT中,使用了較小版本的 GPT-3。

這個初始模型也可以根據額外的文字或條件來微調,但並不是必要的。

一般來說,對於「哪一種模型」最適合作為RLHF的起點,並沒有明確的答案。

接下來,為了得到語言模型,我們需要產生資料來訓練獎勵模型,這就是將人類偏好整合到系統中的方式。

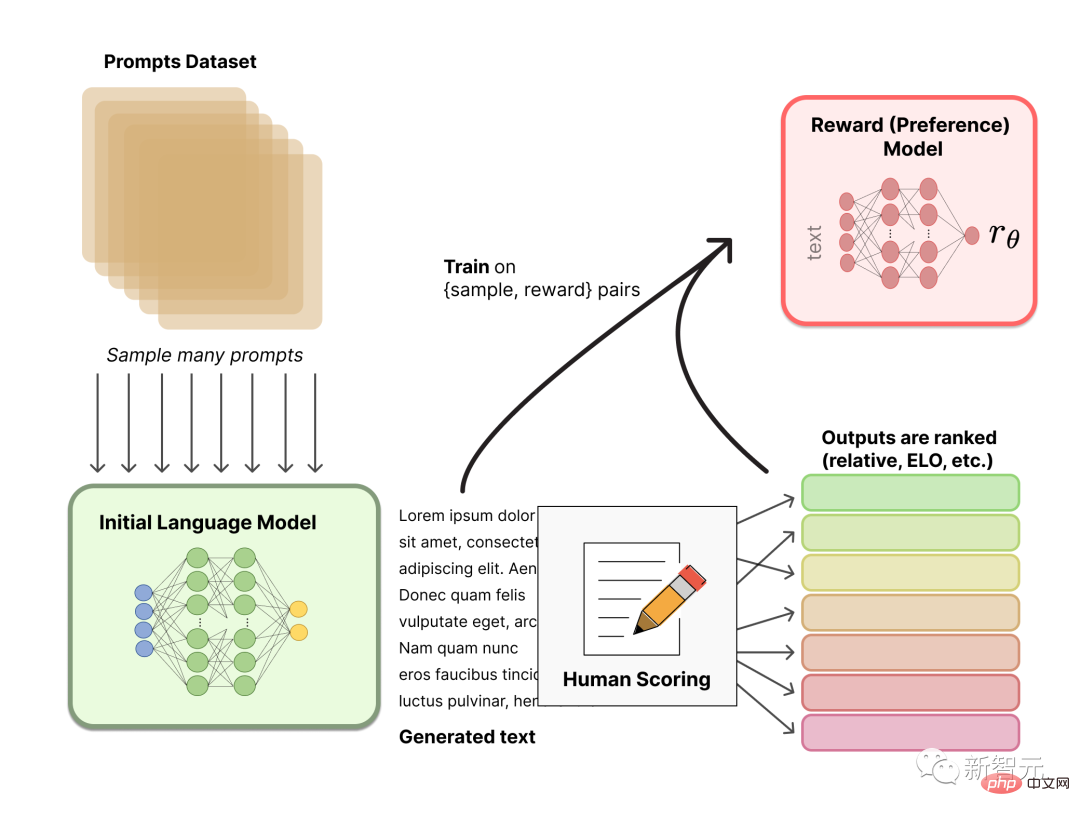

獎勵模型訓練

產生一個根據人類偏好校準的獎勵模型(RM,也稱為偏好模型)是RLHF中相對較新的研究。

我們的基本目標是,獲得一個模型或系統,該模型或系統接收一系列文本,並返回一個標量獎勵,這個獎勵要在數字上代表人類偏好。

這個系統可以是端對端的LM,或是輸出獎勵的模組化系統(例如,模型對輸出進行排序,並將排名轉換為獎勵)。作為標量獎勵的輸出,對於稍後在RLHF過程中無縫整合的現有RL演算法至關重要。

這些用於獎勵建模的LM可以是另一個微調的LM,也可以是根據偏好資料從頭開始訓練的LM。

RM的提示產生對的訓練資料集,是透過從預定義資料集中採樣一組提示而產生的。提示透過初始語言模型產生新文字。

然後,由人工註釋器對LM產生的文字進行排名。人類直接對每段文本打分數以產生獎勵模型,這在實踐中很難做到。因為人類的不同價值觀會導致這些分數未經校準而且很吵雜。

有多種方法可以對文字進行排名。一種成功的方法是讓使用者比較基於相同提示的兩種語言模型所產生的文字。這些不同的排名方法被歸一化為用於訓練的標量獎勵訊號。

有趣的是,迄今為止成功的RLHF系統都使用了與文字生成大小相似的獎勵語言模型。可以推測,這些偏好模型需要具有類似的能力來理解提供給它們的文本,因為模型需要具有類似的能力才能產生所述文本。

此時,在RLHF系統中,就有了一個可用於生成文本的初始語言模型,和一個接收任何文本並為其分配人類感知程度分數的偏好模型。接下來,就需要使用強化學習(RL)來針對獎勵模型最佳化原始語言模型。

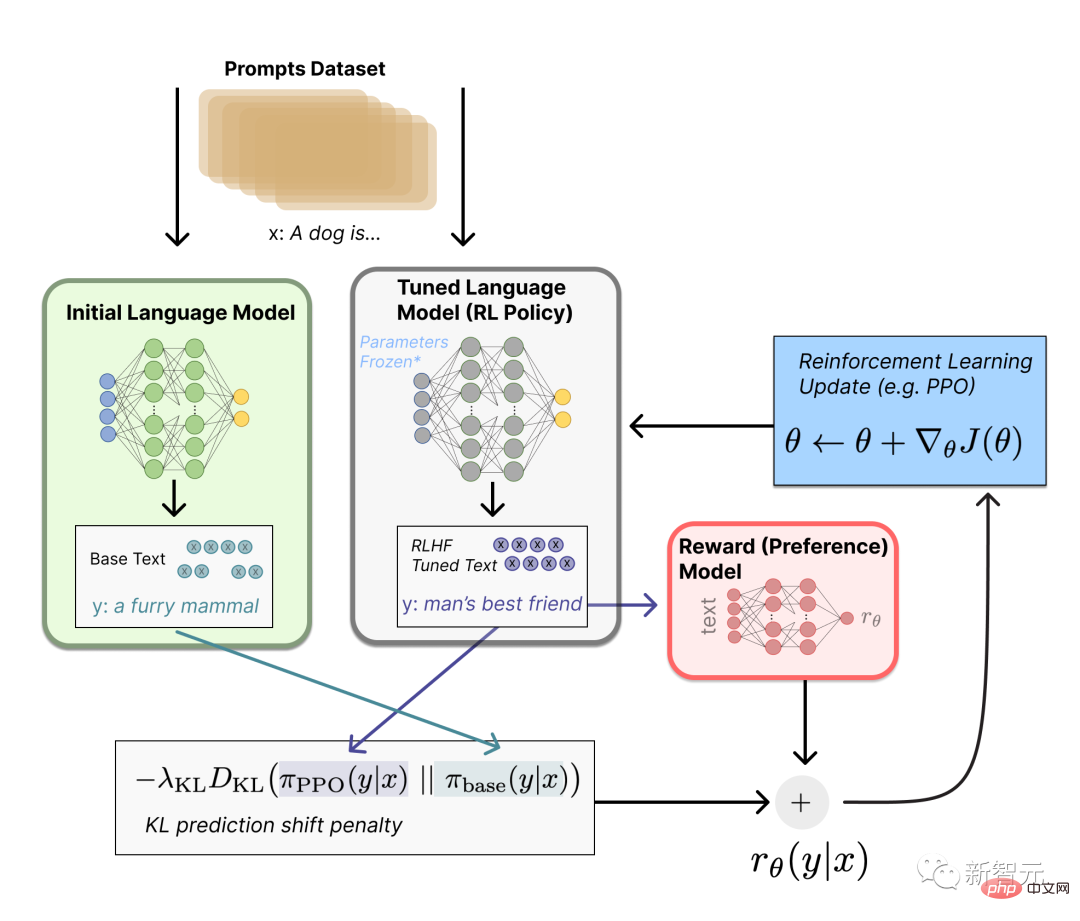

使用強化學習微調

這個微調任務,可以表達為RL問題。

首先,該策略是一種語言模型,它接受提示並傳回一系列文字(或只是文字的機率分佈)。

此策略的動作空間是語言模型詞彙對應的所有token(通常在50k個token數量級),觀察空間包括可能的輸入token序列,因而相當大(詞彙量x輸入的token數量)。

而獎勵函數是偏好模型和策略轉換限制的結合。

在獎勵函數中,系統將我們討論過的所有模型,組合到RLHF過程中。

根據來自資料集的prompt x,會產生兩個文字y1和y2-一個來自初始語言模型,一個來自微調策略的當前迭代。

來自目前策略的文字被傳遞到偏好模型後,模型會傳回一個關於「偏好」的標量概念-rθ。

將該文本與初始模型的文本進行比較後,就可以計算對它們之間差異的懲罰。

RLHF可以透過迭代更新獎勵模型和策略,從這一點繼續。

隨著RL策略的更新,使用者可以繼續將這些輸出與模型的早期版本進行排名。

這個過程中,就引入了策略和獎勵模型演變的複雜動態,這個研究非常複雜,非常開放。

https://www.4gamers.com.tw/news/detail/56185/chatgpt-can-have-a-good-conversation-with-you-among -acg-and-trpg-mostly

https://www.businessinsider.com/history-of-openai-company-chatgpt-elon-musk-founded-2022-12#musk-has-continued- to-take-issue-with-openai-in-recent-years-7

以上是不花錢,讓「情聖」ChatGPT教你怎麼追馬斯克!的詳細內容。更多資訊請關注PHP中文網其他相關文章!