星海爭霸II協作對抗基準超越SOTA,新型Transformer架構解決多智能體強化學習問題

多智能體強化學習(MARL) 是一個具有挑戰性的問題,它不僅需要識別每個智能體的策略改進方向,而且還需要將單一智能體的策略更新聯合起來,以提高整體性能。最近,這個問題已得到初步解決,有研究人員引入了集中訓練分散執行 (CTDE) 的方法,使智能體在訓練階段可以存取全局資訊。然而,這些方法無法涵蓋多智能體互動的全部複雜性。

事實上,其中一些方法也被證明是失敗的。為了解決這個問題,有人提出多智能體優勢分解定理。在此基礎上,HATRPO 和 HAPPO 演算法被推導出來。然而,這些方法也存在局限性,這些方法仍然依賴精心設計的最大化目標。

近年來,序列模型(SM)在自然語言處理(NLP)領域取得了實質進展。如 GPT 系列、BERT 在廣泛的下游任務上表現出色,並且在小樣本泛化任務上取得了較強的性能。

由於序列模型與語言的序列特性自然契合,因此可用於語言任務,但是序列方法不僅限於 NLP 任務,而是廣泛適用的通用基礎模型。例如,在電腦視覺 (CV) 中,可以將影像分割成子圖並將它們按序列排列,就好像它們是 NLP 任務中的 token 一樣 。近期比較有名的模型 Flamingo、DALL-E 、 GATO 等都有序列方法的影子。

隨著 Transformer 等網路架構的出現,序列建模技術也引起了 RL 社群的極大關注,這促進了一系列基於 Transformer 架構的離線 RL 開發。這些方法在解決一些最基本的 RL 訓練問題方面顯示出了巨大的潛力。

儘管這些方法取得了顯著的成功,但沒有一種方法被設計用來建模多智能體系統中最困難(也是MARL 獨有的) 的方面——智能體之間的互動。事實上,如果簡單地賦予所有智能體一個 Transformer 策略,並對其進行單獨訓練,這仍然不能保證能提高 MARL 聯合性能。因此,雖然有大量強大的序列模型可用,但 MARL 並沒有真正利用序列模型效能優勢。

如何用序列模型解決 MARL 問題?來自上海交通大學、Digital Brain Lab、牛津大學等的研究者提出一種新型多智能體Transformer(MAT,Multi-Agent Transformer)架構,該架構可以有效地將協作MARL 問題轉化為序列模型問題,其任務是將智能體的觀測序列映射到智能體的最優動作序列。

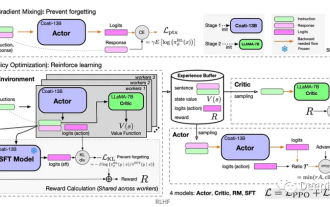

本文的目標是在 MARL 和 SM 之間建立橋樑,以便為 MARL 釋放現代序列模型的建模能力。 MAT 的核心是編碼器- 解碼器架構,它利用多智能體優勢分解定理,將聯合策略搜尋問題轉化為序列決策過程,這樣多智能體問題就會表現出線性時間複雜度,最重要的是,這樣做可以確保MAT 單調效能提升。與 Decision Transformer 等先前技術需要預先收集的離線資料不同,MAT 以線上策略方式透過來自環境的線上試驗和錯誤進行訓練。

- #論文網址:https://arxiv.org/pdf/2205.14953 .pdf

- 專案首頁:https://sites.google.com/view/multi-agent-transformer

為了驗證MAT,研究者在StarCraftII、Multi-Agent MuJoCo、Dexterous Hands Manipulation 和Google Research Football 基準上進行了廣泛的實驗。結果表明,與 MAPPO 和 HAPPO 等強基線相比,MAT 具有更好的效能和資料效率。此外,研究也證明了無論智能體的數量如何變化,MAT 在沒見過的任務上表現較好,可是說是個優秀的小樣本學習者。

背景知識

在本節中,研究者首先介紹了協作 MARL 問題公式和多智能體優勢分解定理,這是本文的基石。然後,他們回顧了現有的與 MAT 相關的 MARL 方法,最後引出了 Transformer。

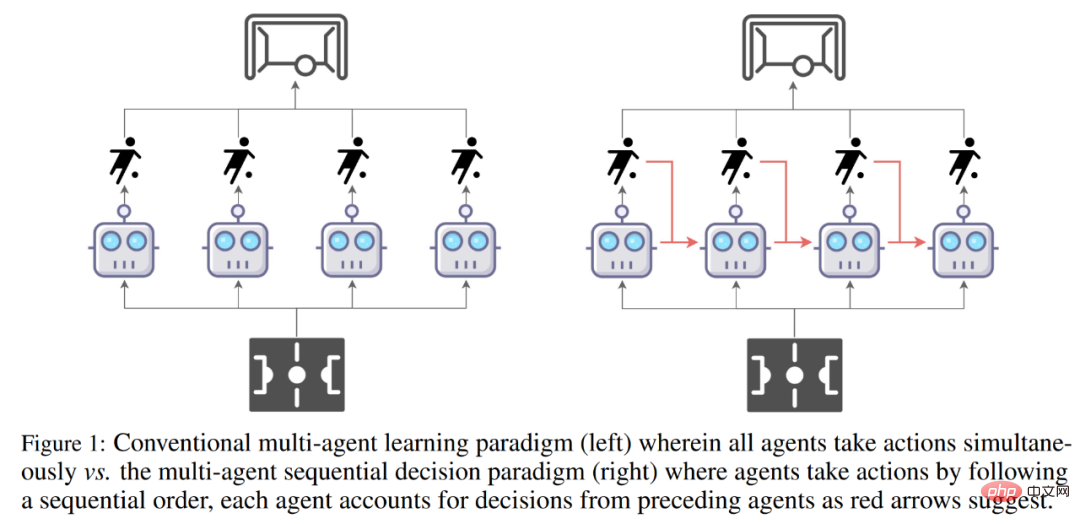

傳統多智能體學習範式(左)與多智能體序列決策範式(右)的比較。

問題公式

協作MARL 問題通常由離散的部分可觀察馬可夫決策過程(Dec-POMDPs) #來建模。

#來建模。

多智能體優勢分解定理

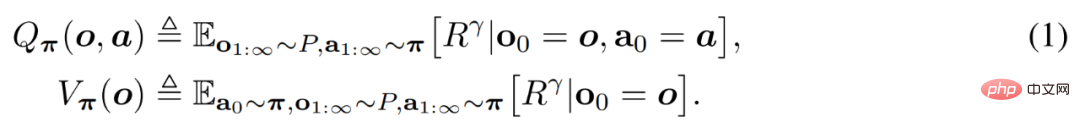

智能體透過 Q_π(o, a)和 V_π(o)來評估行動和觀察的值,定義如下。

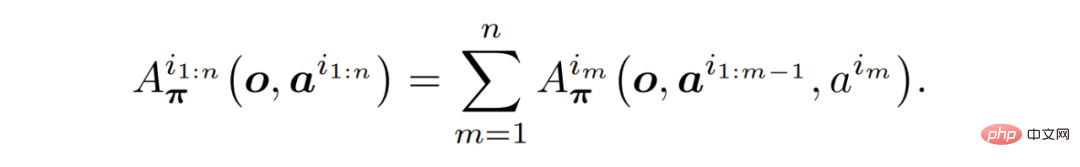

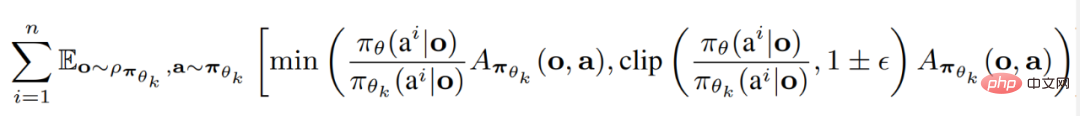

定理 1(多智能體優勢分解):設 i_1:n 為智能體的排列。如下公式始終成立,無需進一步假設。

重要的是,定理 1 提供了一種用來引導如何選擇漸進式改進行動的直覺。

現有MARL 方法

研究者總結了目前兩種SOTA MARL 演算法,它們都建構在近端策略優化(Proximal Policy Optimization, PPO)之上。 PPO 是一種以簡潔性和性能穩定性聞名的 RL 方法。

多智能體近端策略最佳化(MAPPO)是第一個將 PPO 應用於 MARL 中的最直接方法。

異構智能體近端策略最佳化(HAPPO)是目前的SOTA 演算法之一,它可以充分利用定理(1) 以實現具有單調提升保證的多智能體信任域學習。

Transformer 模型

#基於定理(1) 中所述的序列屬性以及HAPPO 背後的原理,現在可以直觀地考慮使用Transformer 模型來實現多智能體信任域學習。透過將一個智能體團隊視為一個序列,Transformer 架構允許建模具有可變數量和類型的智能體團隊,同時可以避免 MAPPO/HAPPO 的缺點。

多智能體 Transformer

為了實現 MARL 的序列建模範式,研究者提供的解決方案是多智能體 Transformer(MAT)。應用Transformer 架構的思路源自於這樣一個事實,即智能體觀察序列(o^i_1,...,o^i_n) 輸入與動作序列(a^ i_1 , . . . , a^i_n)輸出之間的映射是類似機器翻譯的序列建模任務。如同定理 (1) 所迴避的,動作 a^i_m 依賴先前所有智能體的決策 a ^i_1:m−1。

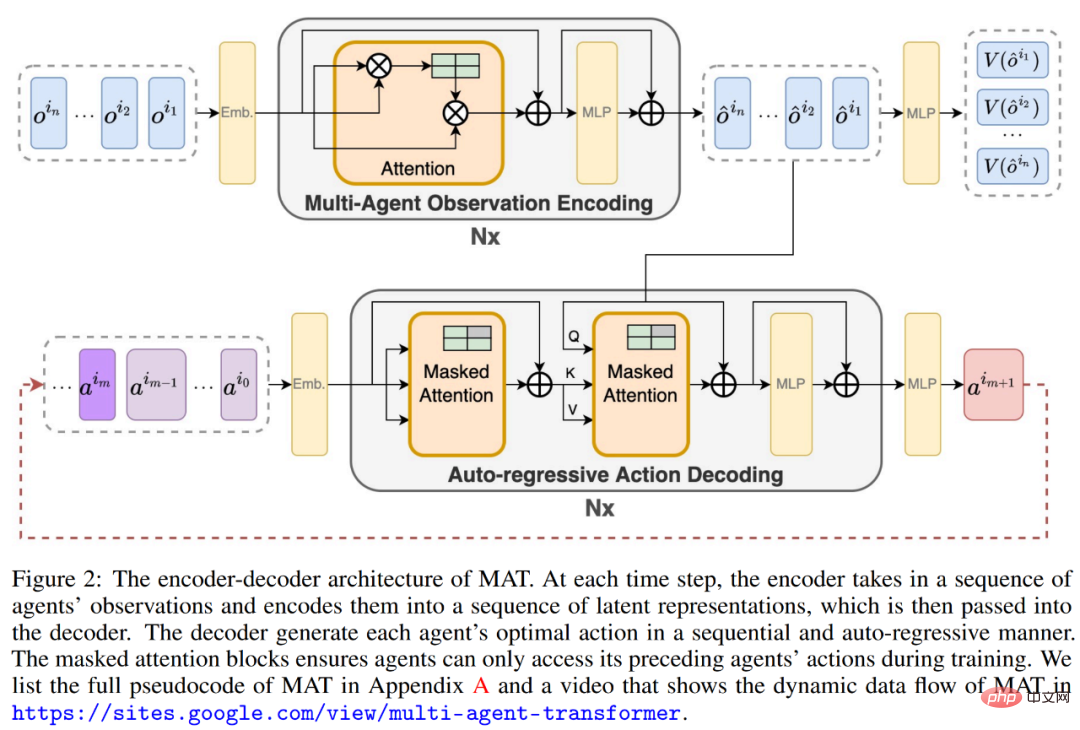

因此,如下圖(2)所示,MAT 中包含了一個用於學習聯合觀察表示的編碼器和一個以自回歸方式為每個智能體輸出動作的解碼器。

編碼器的參數以φ 表示,它以任意順序取得觀察序列(o^i_1 , . . . , o^i_n),並將它們傳遞通過幾個計算塊。每個區塊都由一個自註意力機制、一個多層感知機(MLP)和殘差連接組成,以防止隨深度增加而出現梯度消失和網路退化。

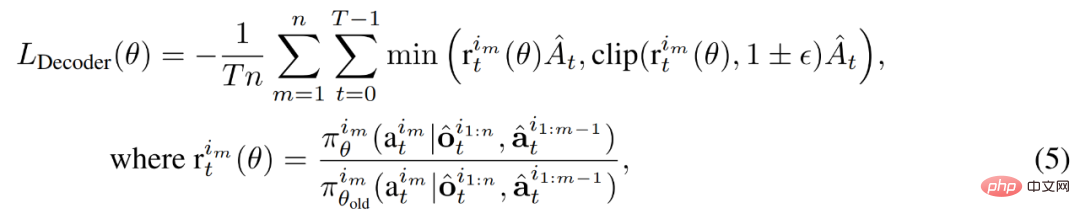

解碼器的參數以θ表示,它將嵌入的聯合動作a^i_0:m−1 , m = {1, . . . n}(其中a^i_0 是指示解碼開始的任意符號)傳遞到解碼塊序列。至關重要的是,每個解碼區塊都有一個遮罩的自註意力機制。為了訓練解碼器,研究者將如下裁剪 PPO 目標最小化。

MAT 中的詳細資料流如下動圖所示。

實驗結果

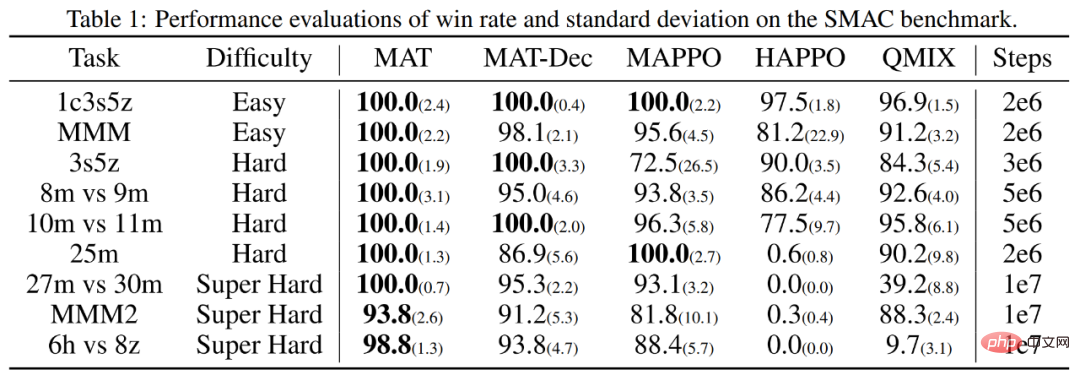

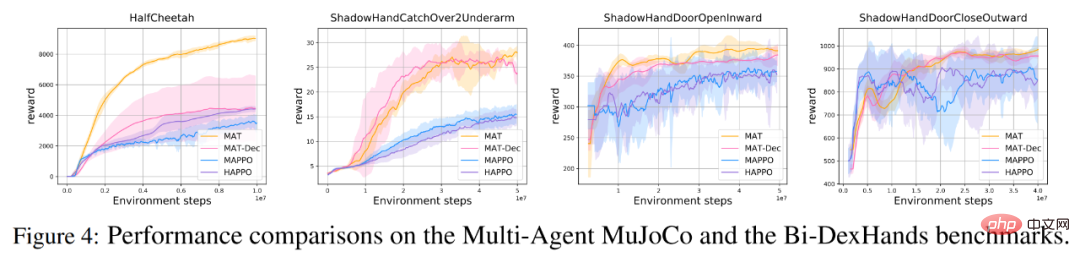

為了評估MAT 是否符合預期,研究者在星海爭霸II 多智能體挑戰(SMAC)基準(MAPPO 在之上具有優越性能)和多智能體MuJoCo 基準上(HAPPO 在之上具有SOTA 性能)對MAT 進行了測試。

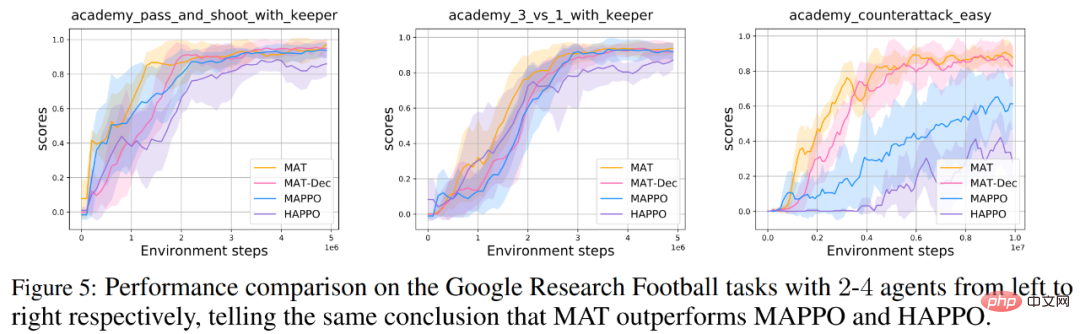

此外,研究者還在 Bimanual Dxterous Hand Manipulation (Bi-DexHands)和 Google Research Football 基準上了對 MAT 進行了擴展測試。前者提供了一系列具有挑戰性的雙手操作任務,後者提供了一系列足球遊戲中的合作場景。

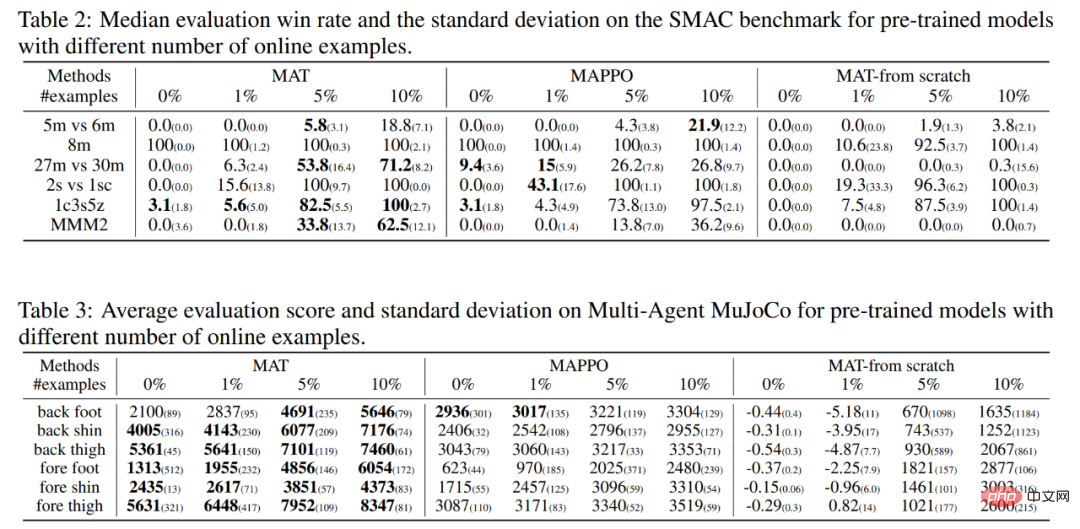

最後,由於Transformer 模型通常在小樣本任務上表現出強大的泛化性能,因此研究者相信MAT 在未見過的MARL 任務上也能具有類似強大的泛化能力。因此,他們在 SMAC 和多智能體 MuJoCo 任務上設計了零樣本和小樣本實驗。

協作MARL 基準上的效能

如下表1 與圖4 所示,對於SMAC、多智能體MuJoCo 和Bi-DexHands 基準來說,MAT 在幾乎所有任務上都顯著優於MAPPO 和HAPPO,顯示它在同構和異構智能體任務上強大的建構能力。此外,MAT 還得到了優於 MAT-Dec 的性能,顯示了 MAT 設計中解碼器架構的重要性。

#同樣地,研究者在Google Research Football 基準上也得到了類似的性能結果,如下圖5 所示。

MAT 用於小樣本學習

表2 和表3 中總結了每個演算法的零樣本和小樣本結果,其中粗體數字表示最佳性能。

研究者也提供了資料相同情況下 MAT 的效能,其與對照組一樣從頭開始訓練。如下表所示,MAT 獲得了大多數最佳成績,這證明了 MAT 小樣本學習的強大泛化表現。

以上是星海爭霸II協作對抗基準超越SOTA,新型Transformer架構解決多智能體強化學習問題的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

五官亂飛,張嘴、瞪眼、挑眉,AI都能模仿到位,影片詐騙要防不住了

Dec 14, 2023 pm 11:30 PM

五官亂飛,張嘴、瞪眼、挑眉,AI都能模仿到位,影片詐騙要防不住了

Dec 14, 2023 pm 11:30 PM

好強大的AI模仿能力,真的防不住,完全防不住。現在AI的發展已經達到這種程度了嗎?你前腳讓自己的五官亂飛,後腳,一模一樣的表情就被復現出來,瞪眼、挑眉、噘嘴,不管多麼誇張的表情,都模仿的非常到位。加大難度,讓眉毛挑的再高些,眼睛睜的再大些,甚至連嘴型都是歪的,虛擬人物頭像也能完美復現表情。當你在左邊調整參數時,右邊的虛擬頭像也會相應地改變動作給嘴巴、眼睛一個特寫,模仿的不能說完全相同,只能說表情一模一樣(最右邊)。這項研究來自慕尼黑工業大學等機構,他們提出了GaussianAvatars,這種

強化學習中的獎勵函數設計問題

Oct 09, 2023 am 11:58 AM

強化學習中的獎勵函數設計問題

Oct 09, 2023 am 11:58 AM

強化學習中的獎勵函數設計問題引言強化學習是一種透過智能體與環境的互動來學習最優策略的方法。在強化學習中,獎勵函數的設計對於智能體的學習效果至關重要。本文將探討強化學習中的獎勵函數設計問題,並提供具體程式碼範例。獎勵函數的作用及目標獎勵函數是強化學習中的重要組成部分,用來評估智能體在某一狀態下所獲得的獎勵值。它的設計有助於引導智能體透過選擇最優行動來最大化長期累

使用Panda-Gym的機器臂模擬實現Deep Q-learning強化學習

Oct 31, 2023 pm 05:57 PM

使用Panda-Gym的機器臂模擬實現Deep Q-learning強化學習

Oct 31, 2023 pm 05:57 PM

強化學習(RL)是一種機器學習方法,它允許代理透過試誤來學習如何在環境中表現。行為主體會因為採取行動導致預期結果而獲得獎勵或懲罰。隨著時間的推移,代理人會學會採取行動,以使得其預期回報最大化RL代理通常使用馬可夫決策過程(MDP)進行訓練,MDP是為順序決策問題建模的數學框架。 MDP由四個部分組成:狀態:環境的可能狀態的集合。動作:代理人可以採取的一組動作。轉換函數:在給定當前狀態和動作的情況下,預測轉換到新狀態的機率的函數。獎勵函數:為每次轉換分配獎勵給代理的函數。代理的目標是學習策略函數,

Spring Data JPA 的架構和工作原理是什麼?

Apr 17, 2024 pm 02:48 PM

Spring Data JPA 的架構和工作原理是什麼?

Apr 17, 2024 pm 02:48 PM

SpringDataJPA基於JPA架構,透過映射、ORM和事務管理與資料庫互動。其儲存庫提供CRUD操作,派生查詢簡化了資料庫存取。此外,它使用延遲加載,僅在必要時檢索數據,從而提高了效能。

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显著的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效

MotionLM:多智能體運動預測的語言建模技術

Oct 13, 2023 pm 12:09 PM

MotionLM:多智能體運動預測的語言建模技術

Oct 13, 2023 pm 12:09 PM

本文經自動駕駛之心公眾號授權轉載,轉載請洽出處。原標題:MotionLM:Multi-AgentMotionForecastingasLanguageModeling論文連結:https://arxiv.org/pdf/2309.16534.pdf作者單位:Waymo會議:ICCV2023論文想法:對於自動駕駛車輛安全規劃來說,可靠地預測道路代理未來行為是至關重要的。本研究將連續軌跡表示為離散運動令牌序列,並將多智能體運動預測視為語言建模任務。我們提出的模型MotionLM有以下幾個優點:首

golang框架架構的學習曲線有多陡峭?

Jun 05, 2024 pm 06:59 PM

golang框架架構的學習曲線有多陡峭?

Jun 05, 2024 pm 06:59 PM

Go框架架構的學習曲線取決於對Go語言和後端開發的熟悉程度以及所選框架的複雜性:對Go語言的基礎知識有較好的理解。具有後端開發經驗會有所幫助。複雜度不同的框架導致學習曲線差異。

你知道程式設計師再過幾年會沒落?

Nov 08, 2023 am 11:17 AM

你知道程式設計師再過幾年會沒落?

Nov 08, 2023 am 11:17 AM

《ComputerWorld》雜誌曾經寫過一篇文章,說“編程到1960年就會消失”,因為IBM開發了一種新語言FORTRAN,這種新語言可以讓工程師寫出他們所需的數學公式,然後提交給電腦運行,所以程式設計就會終結。圖片又過了幾年,我們聽到了一種新說法:任何業務人員都可以使用業務術語來描述自己的問題,告訴電腦要做什麼,使用這種叫做COBOL的程式語言,公司不再需要程式設計師了。後來,據說IBM開發了一門名為RPG的新程式語言,可以讓員工填寫表格並產生報告,因此大部分企業的程式設計需求都可以透過它來完成圖