無線「心靈交流」!崔鐵軍院士領銜研發新型腦機超表面,靈活、非侵入性

近年來,可程式超表面(coding metasurfaces)已經實現了對電磁功能的即時和可程式控制,而以往的電磁功能要么是靜態的,要么是在傳統的被動設備中非常有限。但是,這類超表面依然需要人工操作。

為了直接偵測和區分人的意願,科學家隨後提出了腦機介面(brain-computer interface,BCI)的概念,試圖透過腦機介面來建立腦與設備之間的通信,為可編程超表面的控制提供了新的視角。透過從「特殊的帽子」收集大腦訊號,腦機介面可以解碼操作員的意願,並向被控制對象發送命令,而不需要操作員進行一些複雜的肌肉活動。

如今,東南大學毫米波國家重點實驗室崔鐵軍院士團隊聯合華南理工大學、新加坡國立大學等科研機構更進一步,開發出了一種電磁腦機超表面(electromagnetic brain-computer- metasurface,EBCM)。

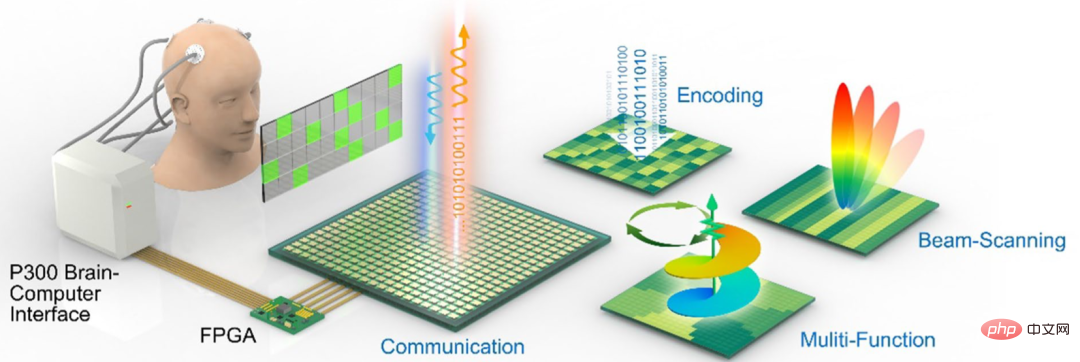

據介紹,這種超表面能夠靈活、非侵入性地控制資訊合成和無線傳輸,將操作者的大腦資訊轉化為腦電圖(EEG)訊號,進而轉化為各種電磁(EM)指令,從而實現兩個操作者之間的無線「心靈交流」。

如下圖,操作人員面前放置顯示相關指令的顯示器。只需要接收簡單的指令,EBCM 就能理解操作人員的意圖,就可以實現視束掃描(visual-beam scanning)、波浪調製(wave modulations)、模式編碼(pattern encoding)等電磁功能。

相關研究論文以「Directly wireless communication of human minds via non-invasive brain-computer-metasurface platform」為題,發表在科學期刊eLight 上。

研究人員表示,這項研究將電磁波空間與腦機介面結合,為超表面、人腦智慧與人工智慧的深度融合的探索開闢了新的方向,有助於建構出新一代生物智慧超表面系統。

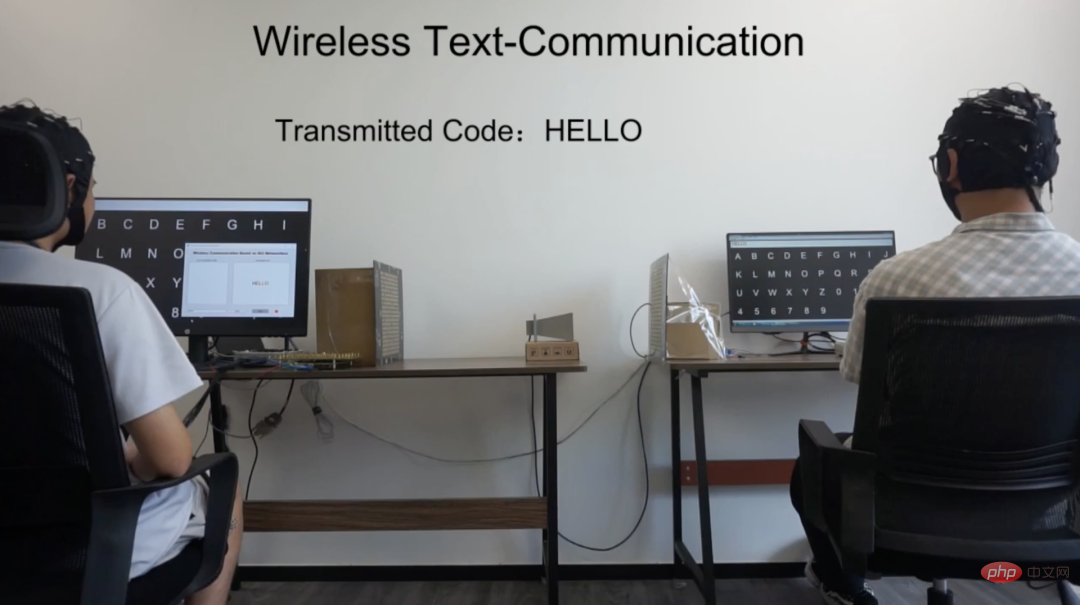

用意念輸出「HELLO」

#在本研究中,研究團隊設計並實驗示範了基於EBCM 的無線文字通訊。

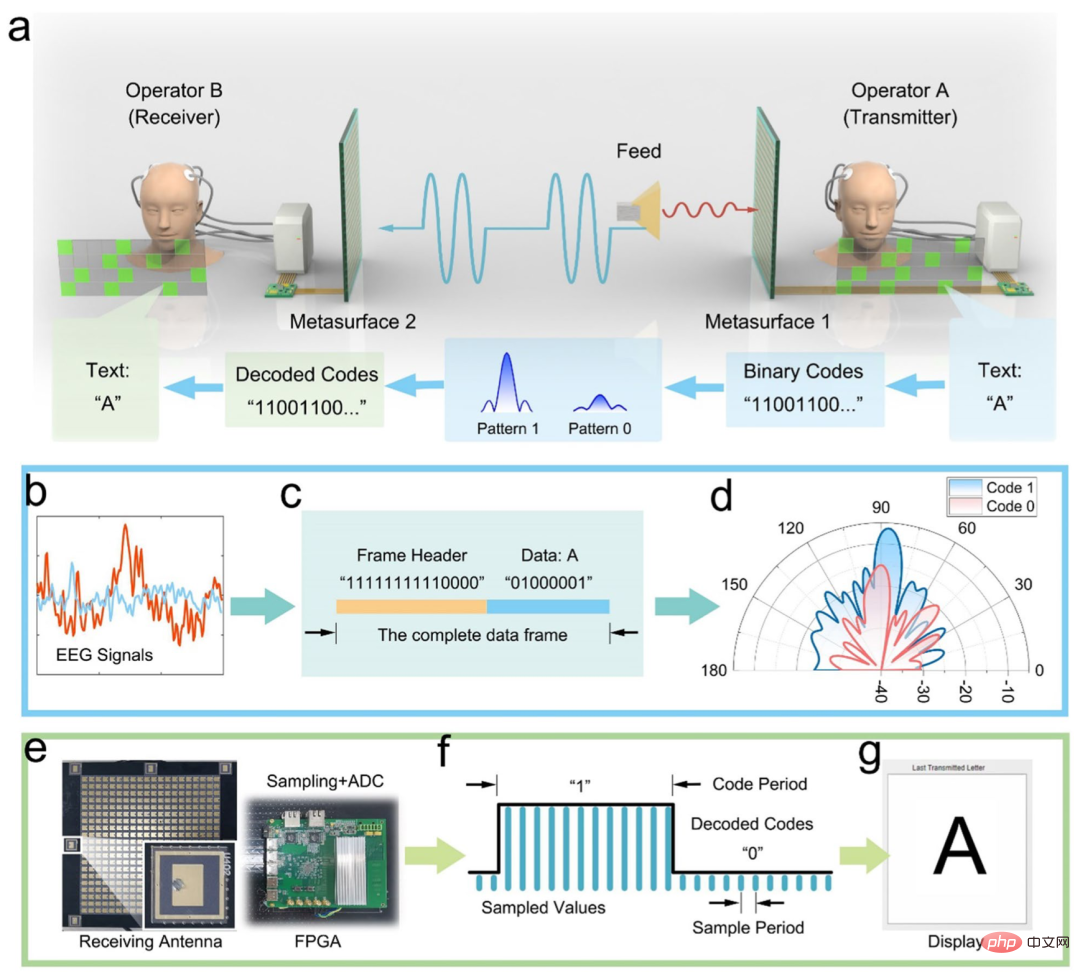

研究團隊為腦機介面操作者提供了文字圖形使用者介面(GUI),使得視覺按鈕可以直接被編碼為由「0」和「1」組成的特定編碼序列。

在實驗中,採用高增益的單波束模式和低增益的隨機散射模式區分超表面反射的振幅,分別對應於用於無線資訊傳輸的編碼“1”(高振幅)和“ 0”(低振幅)。

作為原型的演示,研究人員演示了文字在 EBCM 通訊系統中從一個操作員到另一個操作員的無線傳輸。

操作員 A 作為文字發送者,透過視覺地查看 EBCM GUI 上的字元按鈕發送字母。當從腦電圖訊號解碼目標字母時,在 FPGA 上實現一個基於 ASCII 的編碼序列,以切換時變模式,操縱超表面將訊息發送到空間,由操作員 B 的 EBCM 接收、解調和呈現。

如下圖,研究團隊展示了5 個字母「HELLO」的無線傳輸過程,操作員B 的螢幕上成功顯示出了「HELLO」的字樣。

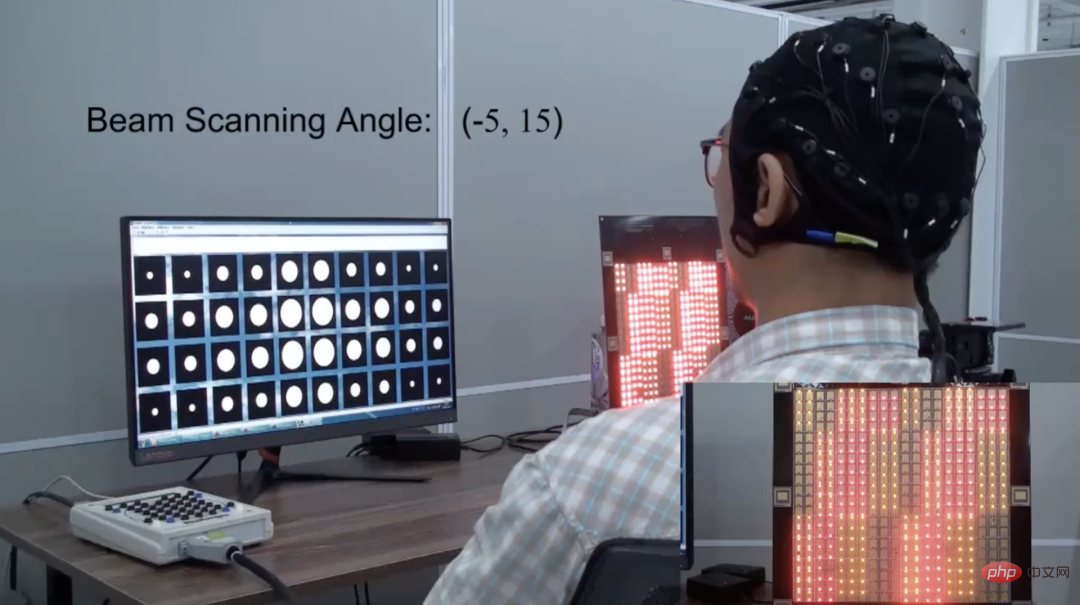

在視覺光束掃描實驗中,操作人員透過目視注視特定方向,直接實現了所需的波束掃描方向。在偵測到操作者的腦電圖後,EBCM 可以顯示出相關波束掃描方向的執行編碼模式。

另外,研究團隊也示範了 EBCM 的模式編碼過程。操作人員透過按下特定的按鈕輸入所需的代碼。 EBCM 偵測到的輸入代碼以黃色方塊顯示在螢幕上。最後一個代碼「C4」是終止編碼過程的停止指令,並命令 FPGA 計算最終的編碼模式。之後,EBCM 執行所計算的編碼模式,並在超表面顯示。

以上實驗表明,操作者不再需要任何涉及肌肉的動作,而只需要盯著特定的視覺按鈕進行相關的連續刺激,EBCM 可以識別這些刺激並轉換成對應的EM 訊號進行通訊。

什麼是智慧超表面?

超表面,指厚度小於波長的人工層狀材料。根據面內的結構形式,超表面可分為兩種:一種具有橫向亞波長的微細結構,一種為均勻膜層。超表面可實現對電磁波相位、極化方式、傳播模式等特性的靈活有效調控。

智慧超表面是資訊超材料在行動通訊領域的重要應用,其基本原理是透過數位程式設計的方式控制超材料的電磁特性,改變普通牆面對空間電磁波的漫反射,實現對空間電磁波的智慧調控與波束賦形,並且具有低功耗、低成本等特點,可望成為未來行動通訊網路的重要基礎設施。

早在 2014 年,崔鐵軍院士團隊就率先實現了智慧超表面的硬體系統,為推動資訊超材料的應用開創了先河。

今年2 月,崔鐵軍院士團隊及其合作者使用多層透射式數位編碼超表面構建了可即時調節的全衍射式神經網路(可編程人工智慧機,PAIM),成功實現了網路參數的即時編程和光速計算特性,並展示了多種應用案例,包括圖像識別、強化學習和通信多通道編解碼等,在國際上首次實現和展示了微波空間全衍射式可調神經網絡。

當然,超表面的應用場景不限於此。

超表面豐富獨特的物理特性及其對電磁波的靈活調控能力,可以使得其在隱身技術、天線技術、微波和太赫茲裝置、光電子裝置等諸多領域都具有重要的應用前景。

以上是無線「心靈交流」!崔鐵軍院士領銜研發新型腦機超表面,靈活、非侵入性的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

深入探討模型、資料與架構:一份詳盡的54頁高效能大語言模型綜述

Jan 14, 2024 pm 07:48 PM

深入探討模型、資料與架構:一份詳盡的54頁高效能大語言模型綜述

Jan 14, 2024 pm 07:48 PM

大規模語言模型(LLMs)在許多重要任務中展現了引人注目的能力,包括自然語言理解、語言生成和複雜推理,並對社會產生了深遠的影響。然而,這些出色的能力卻需要大量的訓練資源(如左圖)和較長的推理時間(如右圖)。因此,研究人員需要開發有效的技術手段來解決它們的效率問題。此外,從圖的右邊還可以看出,一些高效率的LLMs(LanguageModels)如Mistral-7B,已經成功應用於LLMs的設計和部署中。這些高效的LLMs在保持與LLaMA1-33B相近的準確性的同時,能夠大大減少推理內存

擴散+超解析度模型強強聯合,Google影像生成器Imagen背後的技術

Apr 10, 2023 am 10:21 AM

擴散+超解析度模型強強聯合,Google影像生成器Imagen背後的技術

Apr 10, 2023 am 10:21 AM

近年來,多模態學習受到重視,特別是文字 - 圖像合成和圖像 - 文字對比學習兩個方向。一些 AI 模型因在創意圖像生成、編輯方面的應用引起了公眾的廣泛關注,例如 OpenAI 先後推出的文本圖像模型 DALL・E 和 DALL-E 2,以及英偉達的 GauGAN 和 GauGAN2。谷歌也不甘落後,在 5 月底發布了自己的文字到圖像模型 Imagen,看起來進一步拓展了字幕條件(caption-conditional)圖像生成的邊界。僅僅給出一個場景的描述,Imagen 就能產生高品質、高解析度

碾壓H100,英偉達下一代GPU曝光!首個3nm多晶片模組設計,2024年亮相

Sep 30, 2023 pm 12:49 PM

碾壓H100,英偉達下一代GPU曝光!首個3nm多晶片模組設計,2024年亮相

Sep 30, 2023 pm 12:49 PM

3奈米製程,性能超越H100!最近,根據外媒DigiTimes爆料,英偉達正在開發下一代GPU,代號為「Blackwell」的B100據稱,作為面向人工智慧(AI)和高性能計算(HPC)應用的產品,B100將採用台積電的3nm工藝過程,以及更為複雜的多晶片模組(MCM)設計,並將於2024年第四季現身。對於壟斷了人工智慧GPU市場80%以上份額的英偉達來說,則可以藉著B100趁熱打鐵,在這波AI部署的熱潮中進一步狙擊AMD、英特爾等挑戰者。根據英偉達的估計,到2027年,該領域的產值預計將達到約

多模態大模型最全綜述來了! 7位微軟研究員大力合作,5大主題,成文119頁

Sep 25, 2023 pm 04:49 PM

多模態大模型最全綜述來了! 7位微軟研究員大力合作,5大主題,成文119頁

Sep 25, 2023 pm 04:49 PM

多模態大模型最全綜述來了!由微軟7位華人研究員撰寫,足足119頁——它從目前已經完善的和還處於最前沿的兩類多模態大模型研究方向出發,全面總結了五個具體研究主題:視覺理解視覺生成統一視覺模型LLM加持的多模態大模型多模態agent並專注於一個現象:多模態基礎模型已經從專用走向通用。 Ps.這也是為什麼論文開頭作者就直接畫了一個哆啦A夢的形象。誰適合閱讀這份綜述(報告)?用微軟的原話來說:只要你有興趣學習多模態基礎模型的基礎知識和最新進展,無論你是專業研究員還是在校學生,這個內容都非常適合你一起來

SD社群的I2V-Adapter:無需配置,即插即用,完美相容於圖生視訊插件

Jan 15, 2024 pm 07:48 PM

SD社群的I2V-Adapter:無需配置,即插即用,完美相容於圖生視訊插件

Jan 15, 2024 pm 07:48 PM

影像到影片生成(I2V)任務是電腦視覺領域的一項挑戰,旨在將靜態影像轉化為動態影片。這個任務的困難在於從單張影像中提取並產生時間維度的動態訊息,同時保持影像內容的真實性和視覺上的連貫性。現有的I2V方法通常需要複雜的模型架構和大量的訓練資料來實現這一目標。近期,快手主導的一項新研究成果《I2V-Adapter:AGeneralImage-to-VideoAdapterforVideoDiffusionModels》發布。該研究引入了一種創新的圖像到視頻轉換方法,提出了一種輕量級適配器模組,即I

揭曉2022年玻爾茲曼獎:Hopfield網路創辦人榮獲獎項

Aug 13, 2023 pm 08:49 PM

揭曉2022年玻爾茲曼獎:Hopfield網路創辦人榮獲獎項

Aug 13, 2023 pm 08:49 PM

兩位獲得2022年玻爾茲曼獎的科學家已經公佈,這個獎項由IUPAP統計物理委員會(C3)設立,旨在表彰在統計物理學領域取得傑出成就的研究者。獲獎者必須是之前沒有獲得玻爾茲曼獎或諾貝爾獎的科學家。這個獎項始於1975年,每三年頒發一次,以紀念統計物理學的奠基人路德維希·玻爾茲曼DeepakDharistheoriginalstatement.獲獎理由:表彰DeepakDharistheoriginalstatement.對統計物理學領域作出的開創性貢獻,包括自組織臨界模型的精確解、界面生長、無序

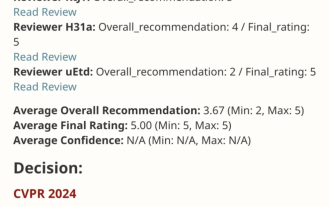

VPR 2024 滿分論文! Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

VPR 2024 滿分論文! Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

EfficientSAM這篇工作以5/5/5滿分收錄於CVPR2024!作者在某社群媒體上分享了這個結果,如下圖所示:LeCun圖靈獎得主也強烈推薦了這份工作!在近期的研究中,Meta研究者提出了一種新的改進方法,即使用SAM的遮罩影像預訓練(SAMI)。此方法結合了MAE預訓練技術和SAM模型,旨在實現高品質的預訓練ViT編碼器。透過SAMI,研究者試圖提高模型的表現和效率,為視覺任務提供更好的解決方案。這項方法的提出為進一步探索和發展電腦視覺和深度學習領域帶來了新的思路和機會。透過結合不同的

GoogleAI新星轉投Pika:影片生成Lumiere一作,擔任創始科學家

Feb 26, 2024 am 09:37 AM

GoogleAI新星轉投Pika:影片生成Lumiere一作,擔任創始科學家

Feb 26, 2024 am 09:37 AM

影片產生進展如火如荼,Pika迎來一位大將-Google研究員OmerBar-Tal,擔任Pika創始科學家。一個月前,還在Google以共同一作的身份發布影片生成模型Lumiere,效果十分驚艷。當時網友表示:Google加入影片生成戰局,又有好戲可看了。 StabilityAICEO、谷歌前同事等在內一些業內人士送上了祝福。 Lumiere一作,剛碩士畢業OmerBar-Tal,2021年本科畢業於特拉維夫大學的數學與計算機系,隨後前往魏茨曼科學研究所攻讀計算機碩士,主要聚焦於圖像和視頻合成領域的研究。其論文成果多次