真的有這麼絲滑:3D頭髮建模新方法NeuralHDHair,浙大、ETH Zurich、CityU聯合出品

近年来,虚拟数字人行业爆火,各行各业都在推出自己的数字人形象。毫无疑问,高保真度的 3D 头发模型可以显著提升虚拟数字人的真实感。与人体的其他部分不同,由于交织在一起的头发结构极其复杂,因此描述和提取头发结构更具挑战性,这使得仅从单一视图重建高保真的 3D 头发模型极其困难。一般来说,现有的方法都是通过两个步骤来解决这个问题:首先根据从输入图像中提取的 2D 方向图估计一个 3D 方向场,然后根据 3D 方向场合成头发丝。但这种机制在实践中仍在存在一些问题。

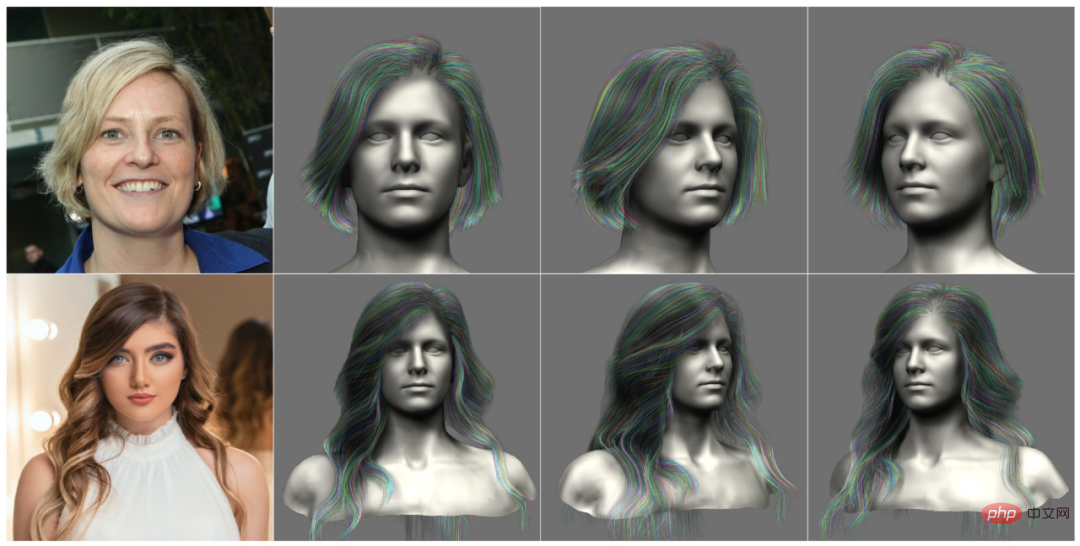

基于实践中的观察,研究者们正在寻求一个完全自动化和高效的头发模型建模方法,可以从具备细粒度特征的单一图像重建一个 3D 头发模型(如图 1),同时显示出高度的灵活性,比如重建头发模型只需要网络的一个前向传递。

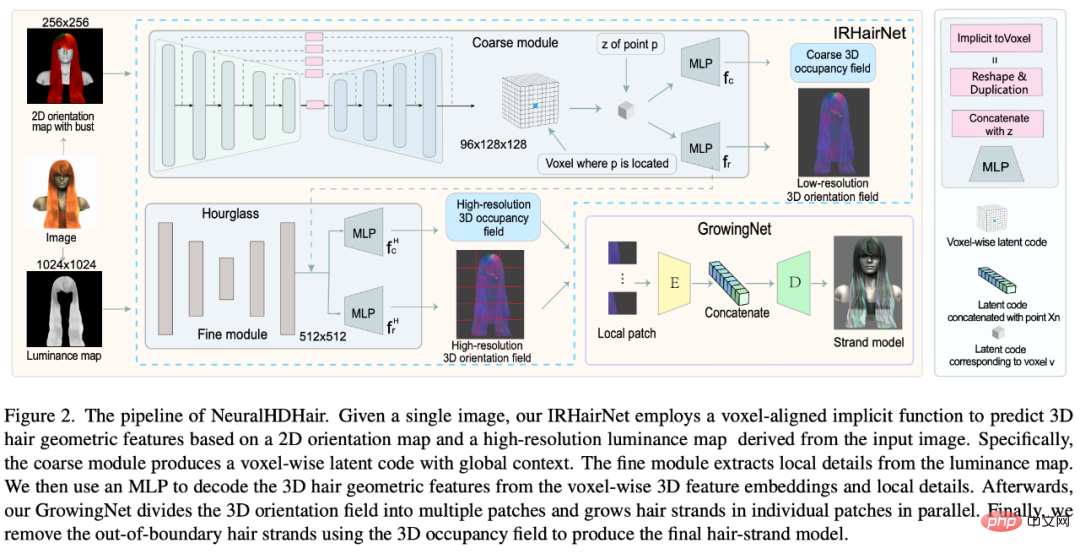

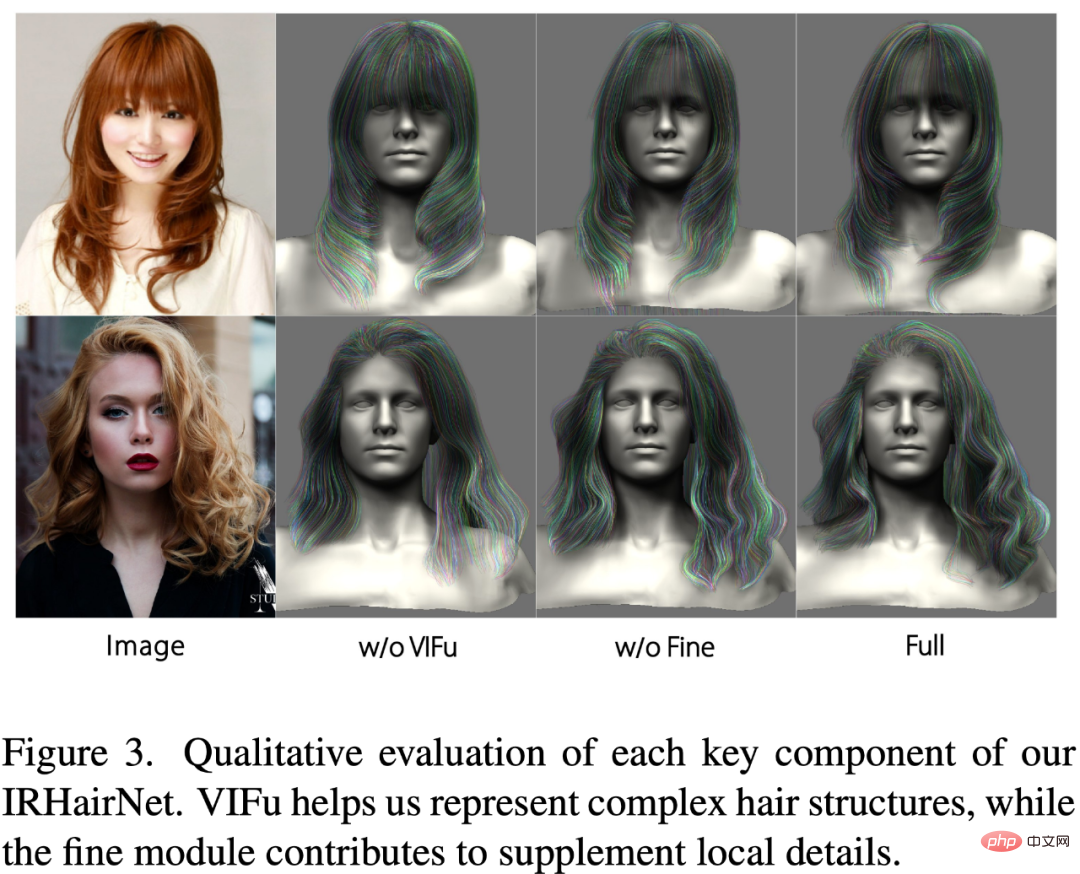

为了解决这些问题,来自浙江大学、瑞士苏黎世联邦理工学院和香港城市大学的研究者提出了 IRHairNet,实施一个由粗到精的策略来生成高保真度的 3D 方向场。具体来说,他们引入了一种新颖的 voxel-aligned 的隐函数(VIFu)来从粗糙模块的 2D 方向图中提取信息。同时,为了弥补 2D 方向图中丢失的局部细节,研究者利用高分辨率亮度图提取局部特征,并结合精细模块中的全局特征进行高保真头发造型。

为了有效地从 3D 方向场合成头发丝模型,研究者引入了 GrowingNet,一种基于深度学习利用局部隐式网格表征的头发生长方法。这基于一个关键的观察:尽管头发的几何形状和生长方向在全局范围内有所不同,但它们在特定的局部范围内具有相似的特征。因此,可以为每个局部 3D 方向 patch 提取一个高级的潜在代码,然后训练一个神经隐函数 (一个解码器) 基于这个潜在代码在其中生长头发丝。在每一个生长步骤之后,以头发丝的末端为中心的新的局部 patch 将被用于继续生长。经过训练后,它可适用于任意分辨率的 3D 定向场。

论文:https://arxiv.org/pdf/2205.04175.pdf

IRHairNet 和 GrowingNet 组成了 NeuralHDHair 的核心。具体来说,这项研究的主要贡献包括:

- 介绍了一种新颖的全自动单目毛发建模框架,其性能明显优于现有的 SOTA 方法;

- 介绍了一个从粗到细的毛发建模神经网络(IRHairNet) ,使用一个新颖的 voxel-aligned 隐函数和一个亮度映射来丰富高质量毛发建模的局部细节;

- 提出了一种基于局部隐函数的新型头发生长络(GrowingNet) ,可以高效地生成任意分辨率的头发丝模型,这种网络比以前的方法的速度实现了一定数量级的提升。

方法

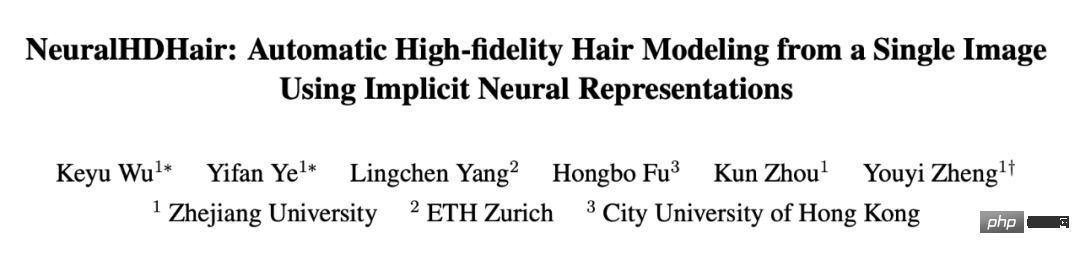

图 2 展示了 NeuralHDHair 的 pipeline。对于人像图像,首先计算其 2D 方向图,并提取其亮度图。此外,自动将它们对齐到相同的半身参考模型,以获得半身像深度图。然后,这三个图随后被反馈到 IRHairNet。

- IRHairNet 设计用于从单个图像生成高分辨率 3D 头发几何特征。这个网络的输入包括一个 2D 定向图、一个亮度图和一个拟合的半身深度图,这些都是从输入的人像图中得到的。输出是一个 3D 方向字段,其中每个体素内包含一个局部生长方向,以及一个 3D 占用字段,其中每个体素表示发丝通过 (1) 或不通过(0)。

- GrowingNet 设计用于从 IRHairNet 估计的 3D 定向场和 3D 占用字段高效生成一个完整的头发丝模型 ,其中 3D 占用字段是用来限制头发的生长区域。

更多方法细节可参考原论文内容。

实验

在这一部分,研究者通过消融研究评估了每个算法组件的有效性和必要性 (第 4.1 节),然后将本文方法与当前的 SOTA(第 4.2 节) 进行比较。实施细节和更多的实验结果可以在补充材料中找到。

消融實驗

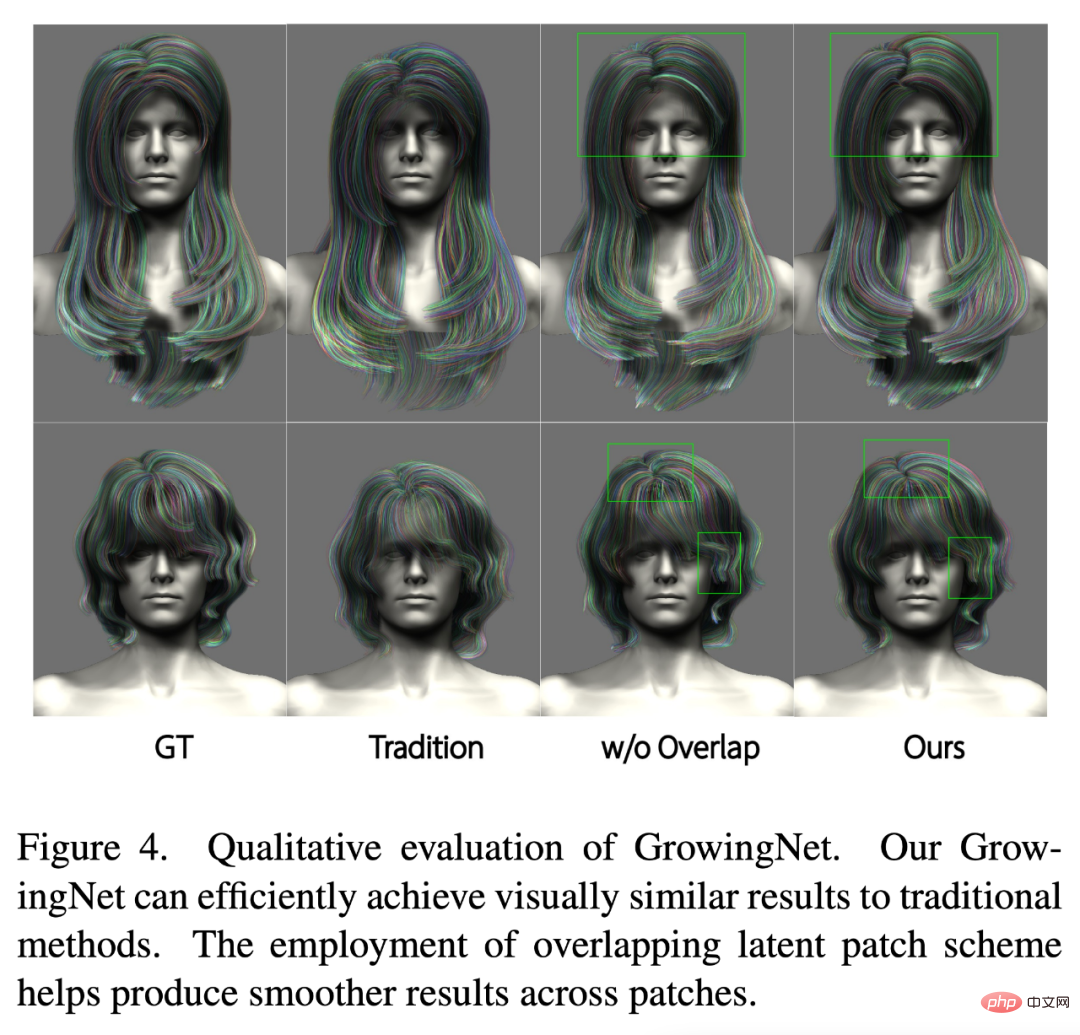

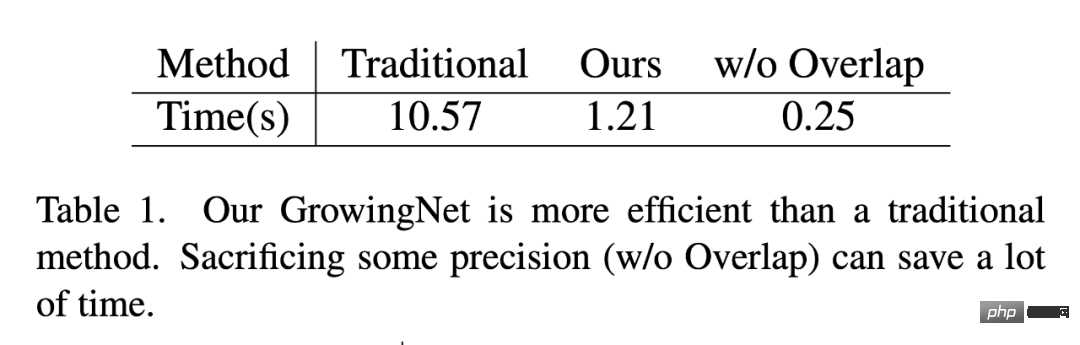

研究者從定性和定量的角度評估了 GrowingNet 的保真度和效率。首先對合成資料進行三組實驗:1)傳統的頭髮生長演算法,2)沒有重疊潛在 patch 方案的 GrowingNet,3)本文的完整模型。

如圖 4 和表 1 所示,與傳統的頭髮生長演算法相比,本文的 GrowingNet 在時間消耗上具有明顯的優勢,同時在視覺品質上保持了相同的生長性能。此外,透過比較圖4 的第三列和第四列,可以看到,如果沒有重疊潛在patch 方案,patch 邊界處的髮絲可能是不連續的,當髮絲的生長方向急劇變化時,這個問題就更加嚴重。不過值得注意的是,這種方案以略微降低精度為代價,大大提高了效率,提高效率對於其方便、高效地應用於人體數位化是具有重要意義的。

與SOTA 方法比較

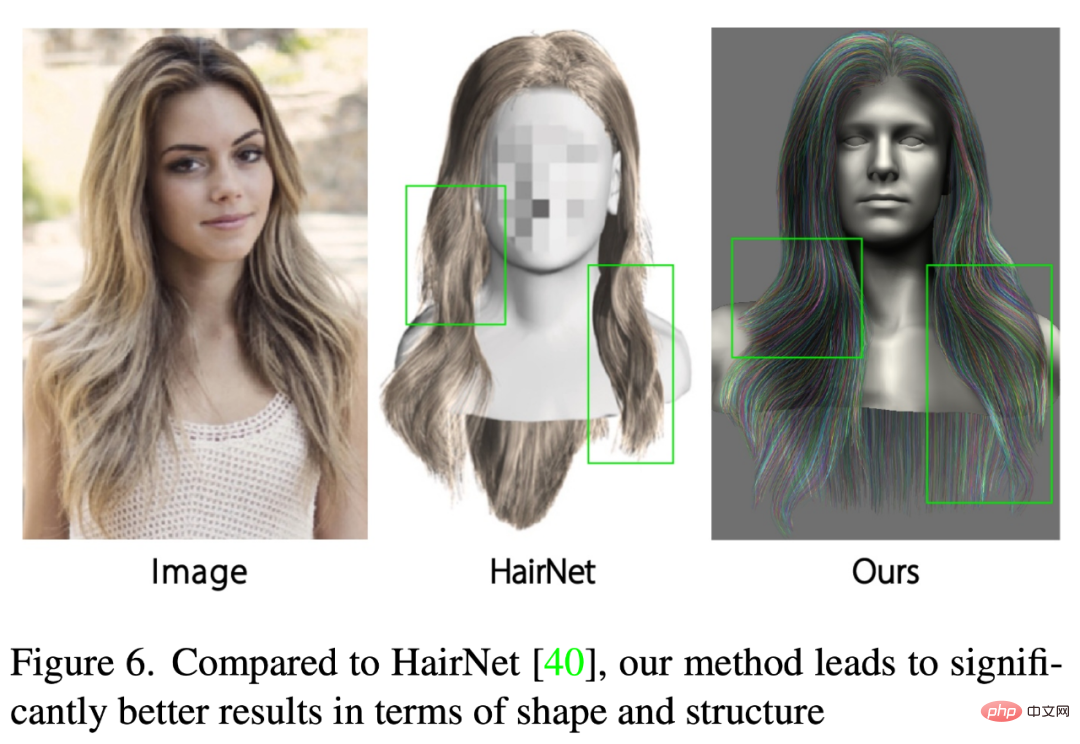

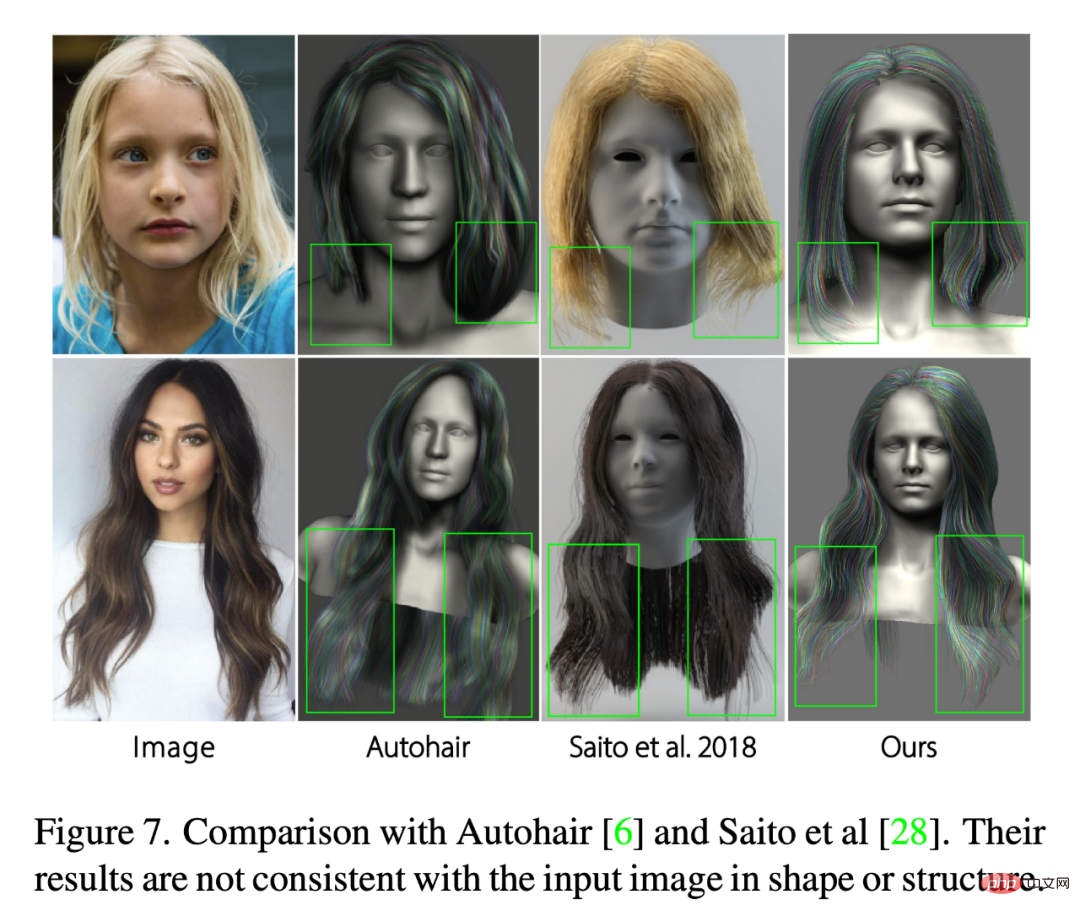

為了評估NeuralHDHair 的性能,研究者將其與一些SOTA 方法[6,28,30,36,40] 進行了比較。其中 Autohair 是基於數據驅動的方法進行頭髮合成,而 HairNet [40]忽略頭髮生長過程來實現端到端的頭髮建模。相較之下,[28,36]執行一個兩步驟策略,首先估計一個 3D 方向場,然後從中合成髮絲。 PIFuHD [30]是一種基於粗到細策略的單眼高解析度 3D 建模方法,可用於 3D 頭髮建模。

如圖 6 所示,HairNet 的結果看起來差強人意,但局部的細節,甚至整體的形狀與輸入影像中的頭髮不一致。這是因為該方法用一種簡單而粗糙的方式來合成頭髮,直接從單一的圖像中恢復無序的髮絲。

這裡也將重建結果與 Autohair[6]和 Saito[28]進行了比較。如圖 7 所示,雖然 Autohair 可以合成真實的結果,但結構上無法很好地匹配輸入影像,因為資料庫包含的髮型有限。另一方面,Saito 的結果缺乏局部細節,形狀與輸入影像不一致。相較之下,本文方法的結果更保持了頭髮的全局結構和局部細節,同時確保了頭髮形狀的一致性。

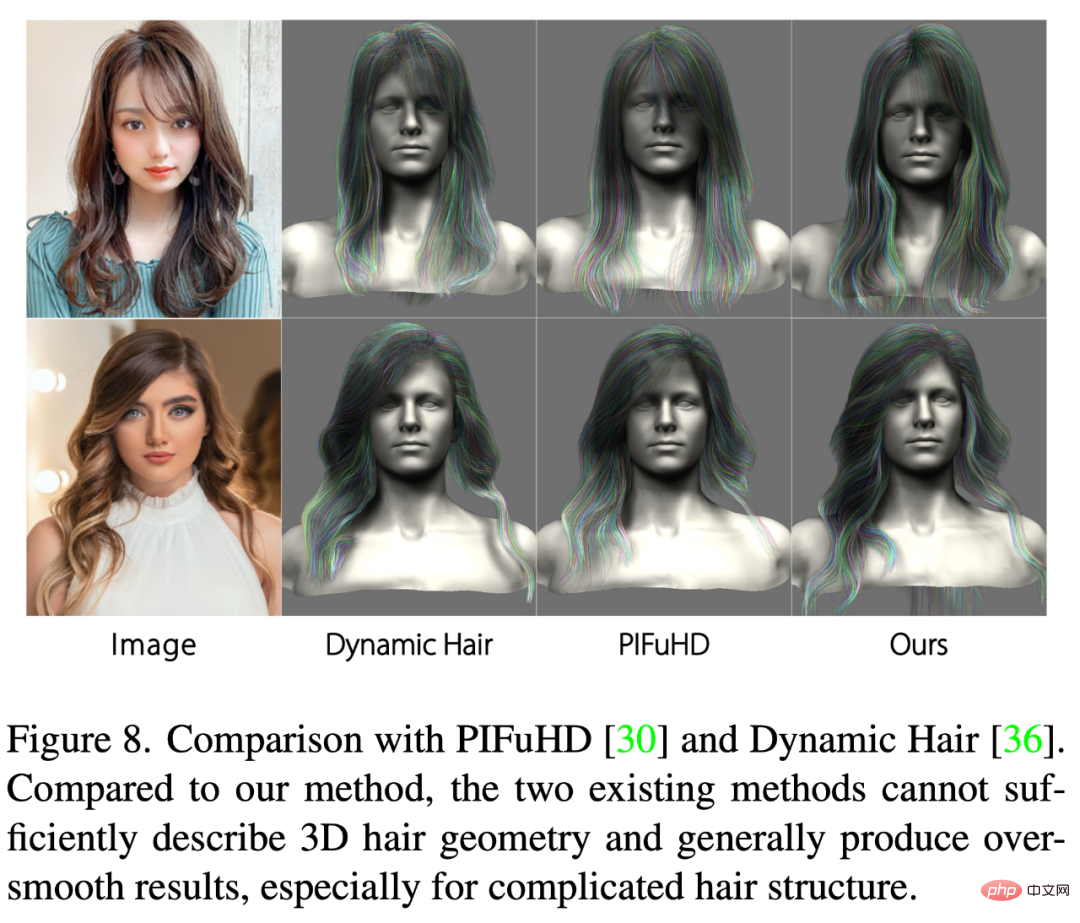

PIFuHD [30]和Dynamic Hair [36]則致力於估計高保真度的3D 頭髮幾何特徵,以產生真實的髮絲模型。圖 8 展示了兩個代表性的比較結果。可以看出,PIFuHD 中採用的像素級隱函數無法充分描繪複雜的頭髮,導致結果過於光滑,沒有局部細節,甚至沒有合理的全局結構。 Dynamic Hair 可以用較少的細節產生更合理的結果,而且其結果中的頭髮生長趨勢可以很好地匹配輸入圖像,但許多局部結構細節 (例如層次結構) 無法捕獲,特別是對於複雜的髮型。相較之下,本文的方法可以適應不同的髮型,甚至是極端複雜的結構,並充分利用全局特徵和局部細節,產生高保真度、高解析度的具有更多細節的 3D 頭髮模型。

以上是真的有這麼絲滑:3D頭髮建模新方法NeuralHDHair,浙大、ETH Zurich、CityU聯合出品的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI,的確正在改變數學。最近,一直十分關注這個議題的陶哲軒,轉發了最近一期的《美國數學學會通報》(BulletinoftheAmericanMathematicalSociety)。圍繞著「機器會改變數學嗎?」這個話題,許多數學家發表了自己的觀點,全程火花四射,內容硬核,精彩紛呈。作者陣容強大,包括菲爾茲獎得主AkshayVenkatesh、華裔數學家鄭樂雋、紐大電腦科學家ErnestDavis等多位業界知名學者。 AI的世界已經發生了天翻地覆的變化,要知道,其中許多文章是在一年前提交的,而在這一

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

目標偵測在自動駕駛系統當中是一個比較成熟的問題,其中行人偵測是最早得以部署演算法之一。在多數論文當中已經進行了非常全面的研究。然而,利用魚眼相機進行環視的距離感知相對來說研究較少。由於徑向畸變大,標準的邊界框表示在魚眼相機當中很難實施。為了緩解上述描述,我們探索了擴展邊界框、橢圓、通用多邊形設計為極座標/角度表示,並定義一個實例分割mIOU度量來分析這些表示。所提出的具有多邊形形狀的模型fisheyeDetNet優於其他模型,並同時在用於自動駕駛的Valeo魚眼相機資料集上實現了49.5%的mAP

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名