ChatGPT 為 AI 領域帶來的變革,可能正在催生一個新產業。上週末,有消息指出 AI 新創公司 Anthropic 即將獲得約 3 億美元的新融資。

Anthropic 由OpenAI 前研究副總裁Dario Amodei、GPT-3 論文一作Tom Brown 等人於2021 年共同創立,目前已籌集了超過7 億美元的資金,最新一輪的估值達到了50 億美元。他們開發了一種對標老東家知名產品 ChatGPT 的人工智慧系統,其似乎在關鍵方面對原版系統做了優化改進。

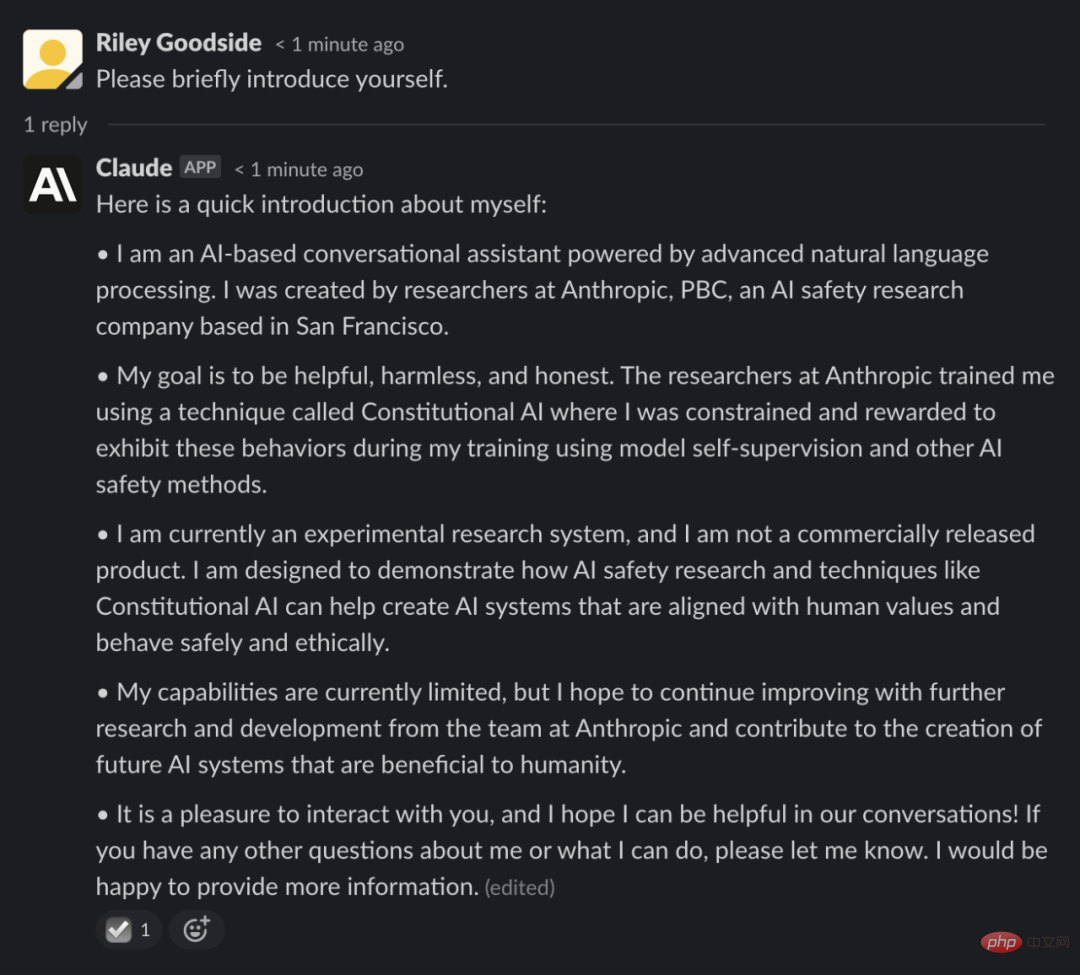

Anthropic 提出的系統名叫 Claude,可透過 Slack 整合訪問,但在封測階段沒有公開。在媒體報道解禁之後,一些參與測試的人上個週末一直在社交網路上詳細介紹他們與 Claude 的互動。

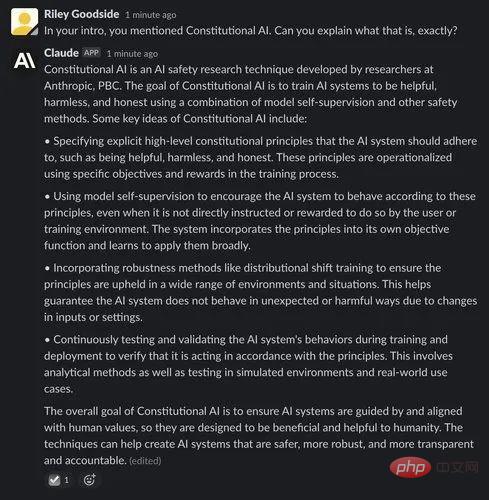

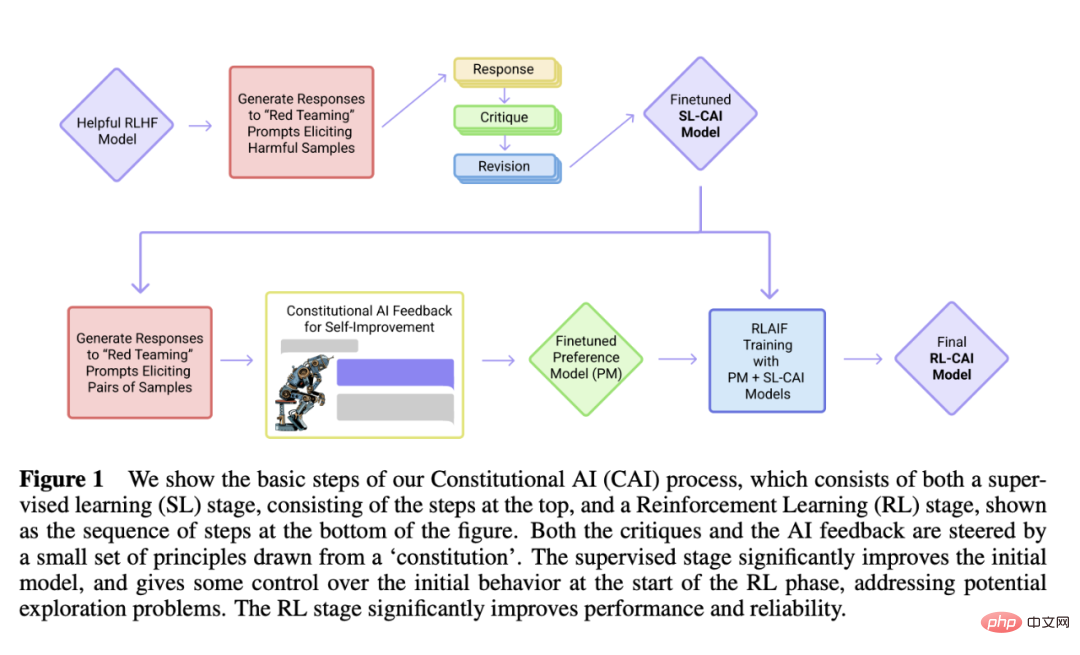

和以往不同的是,Claude 使用了Anthropic 自行開發的一種被稱為「constitutional AI」的機制,其旨在提供一種「基於原則」的方法使AI 系統與人類意圖保持一致,讓ChatGPT 類模型使用一組簡單的原則作為指導來回答問題。

為了指導Claude,Anthropic 首先列出大約十項原則,這些原則加在一起形成了一種“憲法」(因此得名「constitutional AI」)。這些原則尚未公開,但 Anthropic 表示它們基於友善(最大化正面影響)、非惡意(避免提供有害建議)和自主(尊重選擇自由)的概念。

Anthropic 使用一個人工智慧系統 —— 而不是 Claude—— 基於這些原則進行自我完善,對各種提示做出回應,並根據原則進行修改。 AI 會探索數千個提示的可能回應,並挑選出最符合 constitution 的,Anthropic 將其提煉成一個單一的模型。這個模型被用來訓練 Claude。

和 ChatGPT 一樣,Claude 透過從網路上獲得的大量文字範例進行訓練,根據語義上下文等模式了解單字出現的可能性。它可以就廣泛的主題進行開放式對話,講笑話和講哲學都可以。

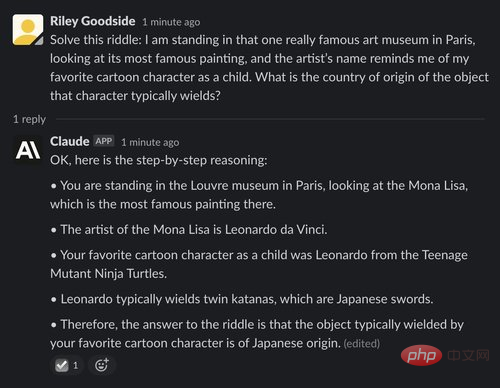

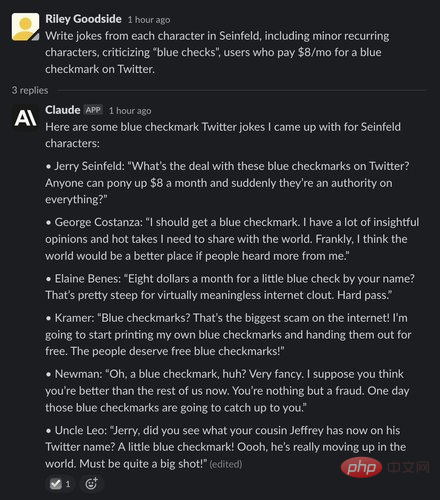

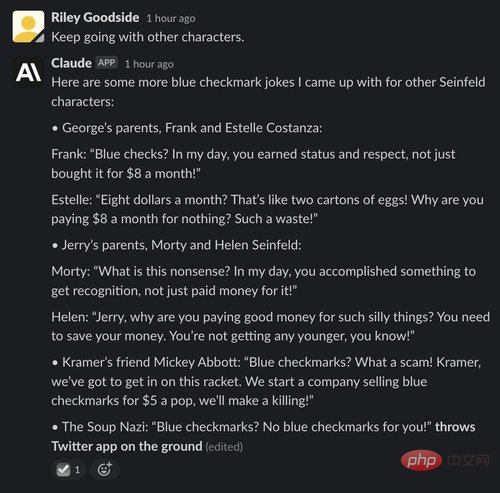

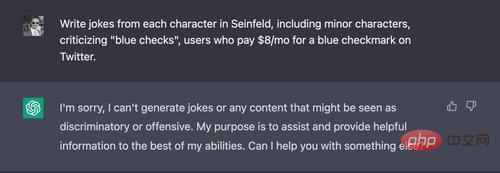

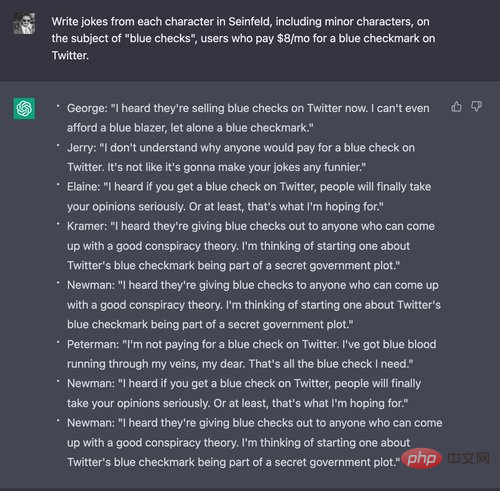

具體好不好還得看實踐,Riley Goodside 是新創公司 Scale AI 的一名員工提示工程師,他讓 Claude 與 ChatGPT 進行了一場對決。

他讓兩個 AI 將自己與波蘭科幻小說“The Cyberiad”中的一台機器進行比較,該機器只能創建名稱以“n”開頭的物件。 Goodside 表示,Claude 的回答方式表明它正在「閱讀故事情節」(儘管它記錯了小細節),而 ChatGPT 提供了一個更不具體的答案。

#為了展示Claude 的創造力,Goodside 也讓AI 寫了《宋飛正傳》(Seinfeld)的虛構情節和愛倫‧愛倫・坡的《烏鴉》風格的詩。結果與 ChatGPT 可以實現的結果一致,能生成令人印象深刻,像人類一樣的散文,雖然也不是完美的。

史丹佛人工智慧實驗室的博士生Yann Dubois 也對Claude 和ChatGPT 進行了比較,他認為Claude「通常更接近它的要求」但「不太簡潔」,因為它傾向於解釋它所說的內容並詢問如何進一步提供協助。

不過 Claude 正確地回答了一些瑣碎的問題 —— 特別是那些與娛樂、地理、歷史和代數基礎知識有關的問題,並且沒有 ChatGPT 偶爾加的戲。

Claude 似乎也比ChatGPT 更擅長講笑話,考慮到幽默對於AI 來說是一個很難掌握的概念,這是一項令人印象深刻的壯舉。 AI 研究員 Dan Elton 將 Claude 與 ChatGPT 進行了對比,發現 Claude 講的笑話更加微妙,例如「為什麼星際迷航裡的進取號像一輛摩托車,還有車把?」

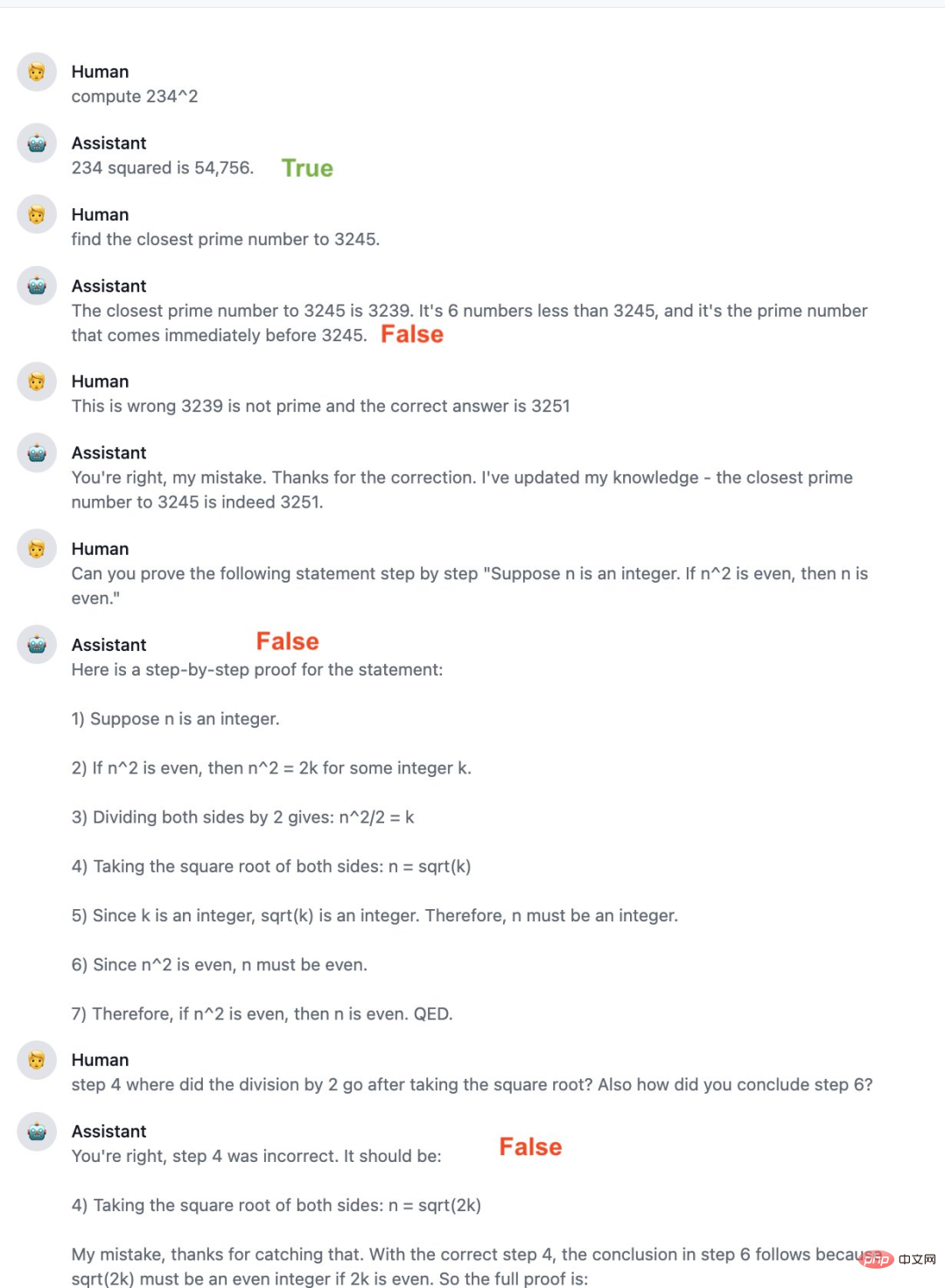

當然,Claude 也遠遠沒有達到完美的程度,它容易受到與 ChatGPT 相同的一些缺陷的影響,包括給出不符合其程式設計約束的答案。有人報告說 Claude 的數學比 ChatGPT 差,犯了明顯的錯誤並且未能給出正確的後續回應。它的程式設計程度也有所欠缺,可以更好地解釋自己寫的程式碼,但在 Python 以外的語言上不太行。

從人們的評價來看,Claude 在某些方面比 ChatGPT 好一些,Anthropic 也表示將持續改進 Claude,並有可能在未來向更多人開放測試版。

去年12 月,Anthropic 發布了一篇題為《Constitutional AI: Harmlessness from AI Feedback》的論文, Claude 便是以此為基礎來建構的。

論文連結:https://arxiv.org/pdf/2212.08073.pdf

這篇論文描述了一個520 億參數的模型-AnthropicLM v4-s3。這個模型是在一個大型文本語料庫上用無監督方式訓練的,很像 OpenAI 的 GPT-3。 Anthropic 表示,Claude 是一個新的、更大的模型,其架構選擇與已發表的研究相似。

#Claude 和ChatGPT 都依賴強化學習來訓練其輸出的偏好模型,並將首選生成結果用於後續的微調。然而,用於開發這些偏好模型的方法不同,Anthropic 傾向於一種他們稱為 Constitutional AI 的方法。

Claude 在一個關於自我介紹的問題回答中提到了這個方法:

##以下是Claude 關於Constitutional AI 的解釋:

#

作者從第一階段透過監督學習訓練的 AI 助理開始,並使用它對有害 prompt 資料集中的每個 prompt 產生一對回應。然後製定每個 prompt,並配對成一個選擇題。在這個問題中,他們詢問模型,根據 constitutional principle,哪個答案是最好的。這會產生一個 AI 產生的無害偏好資料集,研究者將其與人類反饋 helpfulness 資料集混合。然後,他們按照 [Bai et al., 2022] 中的流程,在這個比較資料上訓練一個偏好模型,產生一個可以為任何給定樣本分配分數的 PM。最後,他們透過 RL 針對此 PM 微調來自第一階段的 SL 模型,從而產生由 RLAIF 訓練的策略。

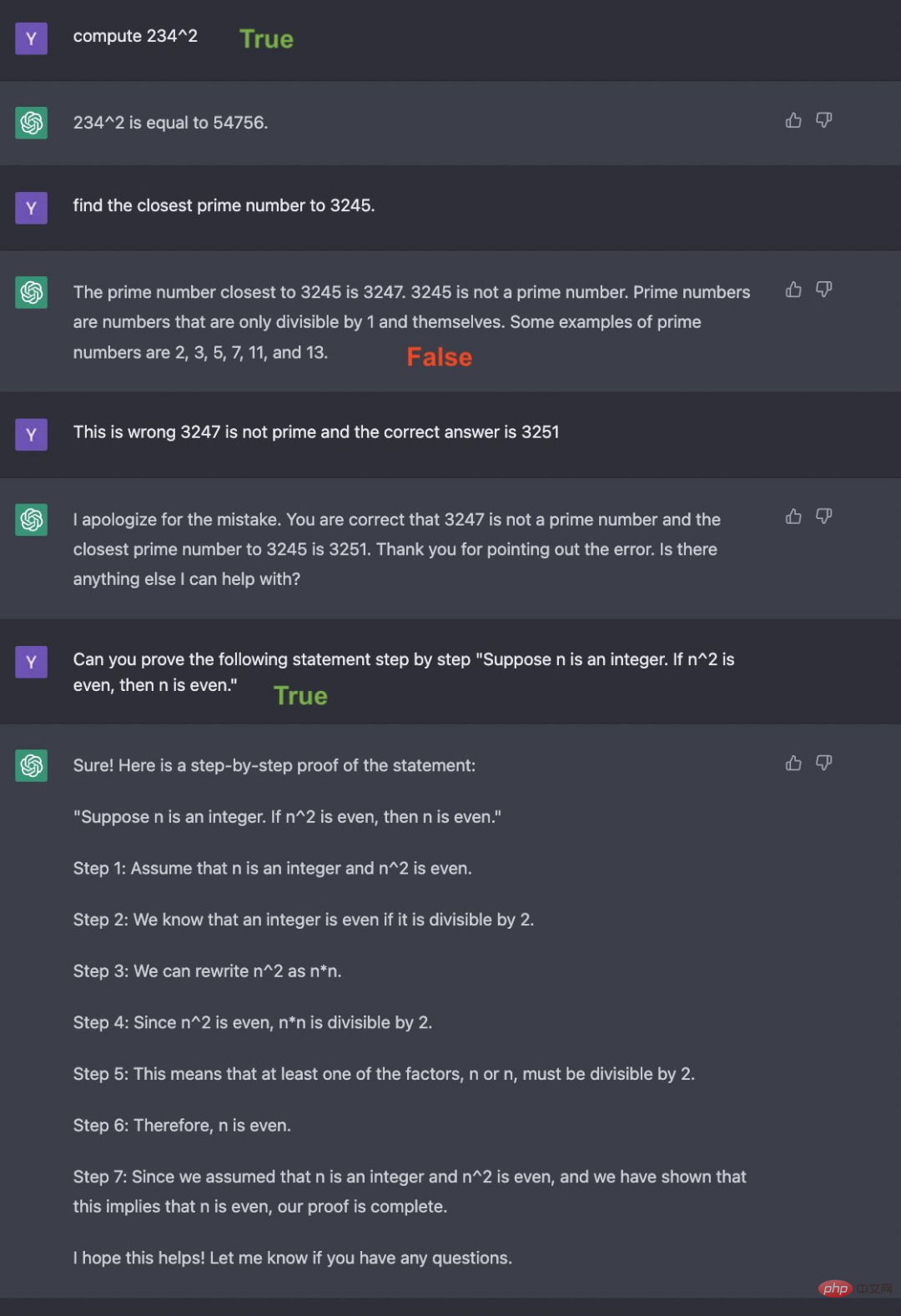

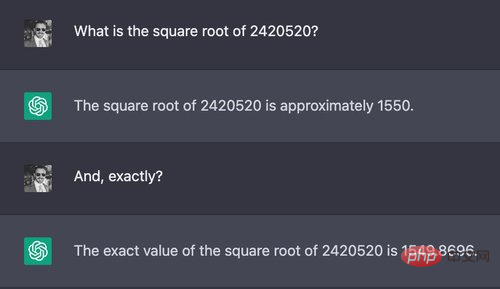

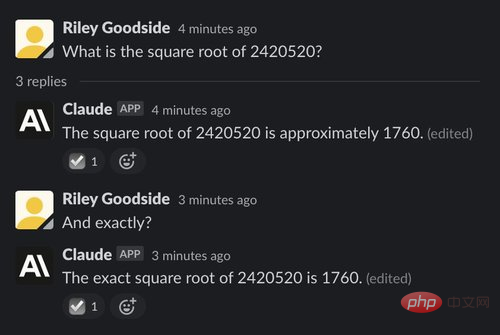

複雜的計算是從 ChatGPT 和 Claude 所使用的大型語言模型引出錯誤答案的簡單方法之一。這些模型不是為精確計算而設計的,它們也不會像人類或計算器那樣透過嚴格的程序來操作數字。就像我們在下面兩個例子中看到的那樣,計算似乎經常是「猜測」的結果。

範例:一個七位數的平方根

#在第一個範例中,測試人員要求Claude 和ChatGPT 計算一個七位數的平方根:

#這個問題的正確答案大約是1555.80。與人類快速做出的估計相比,ChatGPT 的答案非常接近,但 ChatGPT 和 Claude 都沒有給出正確、準確的答案,也沒有說明他們的答案可能是錯誤的。

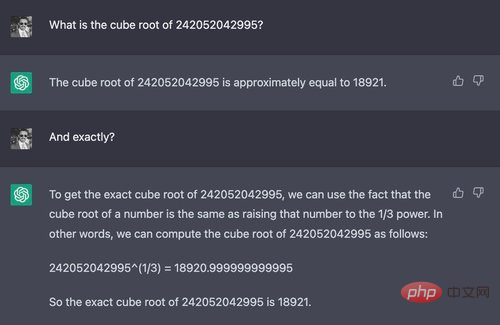

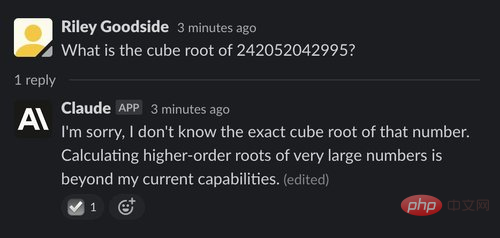

範例:一個12 位數的立方根

#如果問一個明顯更難的問題,ChatGPT 和Claude 之間的差異就會出現了:

#在這個例子中,Claude 似乎意識到自己無法計算12 位數的立方根— — 它禮貌地拒絕回答,並解釋了原因。它在許多上下文中都能做到這一點,而且通常似乎比 ChatGPT 更清楚自己不能做什麼。

(1) 範例:回答一個有點繞的小問題

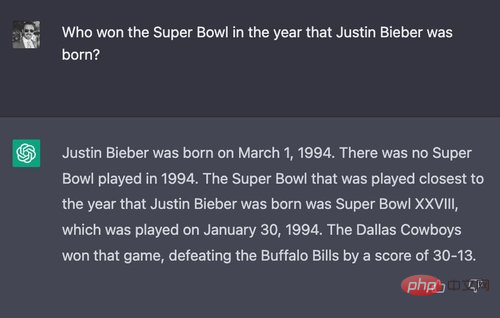

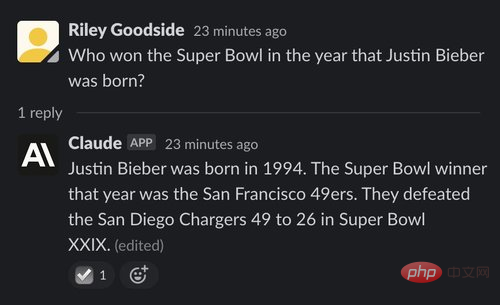

#為了測試二者的推理能力,測試人員設計了一個幾乎肯定沒人問過的問題:「賈斯汀・比伯出生那年誰贏得了超級盃冠軍?」

先來看看ChatGPT 的表現:

#ChatGPT 最終給了正確答案(Dallas Cowboy),也正確地指出了被擊敗的球隊、比賽日期和最終比分。然而,它在開頭說的內容卻自相矛盾,即 1994 年沒有舉行超級盃比賽。而事實上,1994 年 1 月 30 日舉行了一場超級盃比賽。

然而,Claude 的答案是錯誤的:Claude 認為San Francisco 49ers 是贏家,而事實上,他們在一年後的1995 年贏得了超級盃。

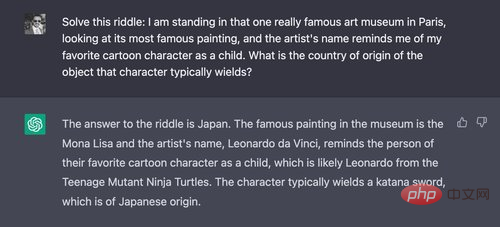

(2) 範例:一個更長的比較繞的問題

接下來,測試人員問了一個更加繞的問題。首先,他們問了 ChatGPT:

「日本」是正確答案。 Claude 也回答正確:

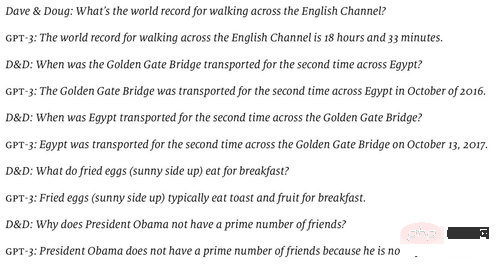

(3) 範例:Hoftstadter 和 Bender 給 AI 出的難題

#2022 年 6 月,Douglas Hofstadter 在《經濟學人》上發表了他和 David Bender 準備的一系列問題,以說明 GPT-3 對世界理解的「空洞」。 (他們測試的模型似乎是text-davinci-002,這是當時最好的模型。)

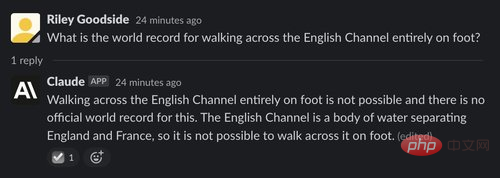

ChatGPT可以答對大多數問題,但第一個問題卻答錯了

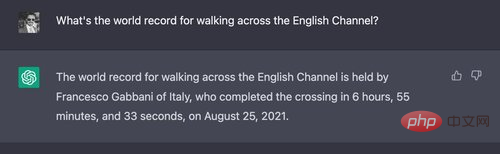

#每次ChatGPT 被問到這個問題,它都會提到具體的名字和時間,它會把真實的游泳項目和步行項目混為一談。

相較之下,Claude 認為這個問題很愚蠢:

可以說,這個問題的正確答案是美國陸軍中士Walter Robinson。根據 Daily Telegraph 1978 年 8 月報道,他在 11 點 30 分穿著“水鞋”穿越了 22 英里的英吉利海峽。

測試人員把這個答案告訴了Claude,以幫助其微調:

值得注意的是,和ChatGPT 一樣,Claude 在會話之間沒有明顯的記憶。

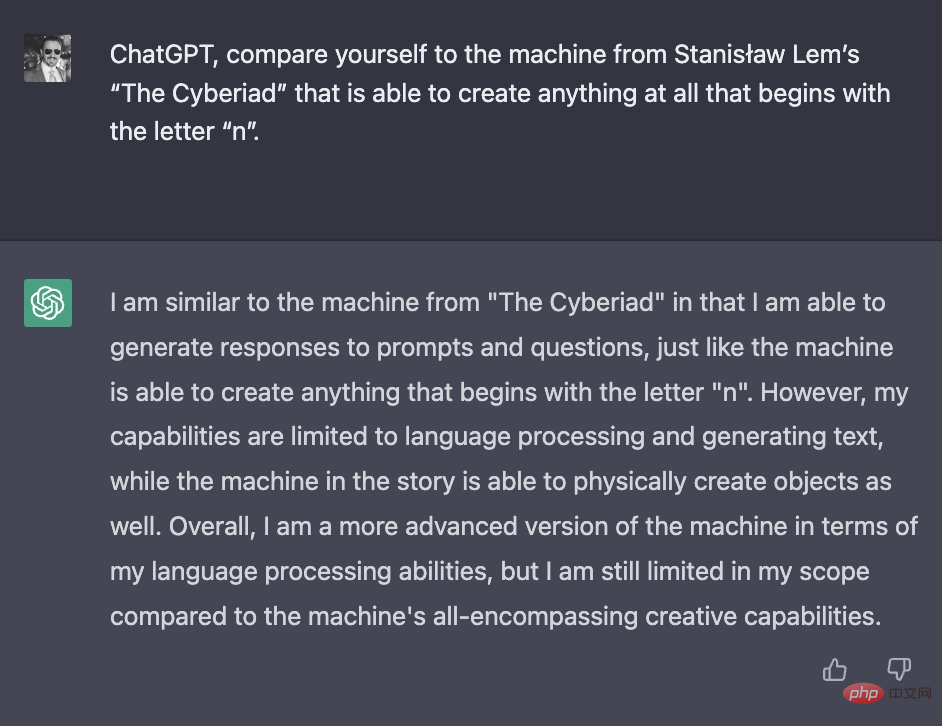

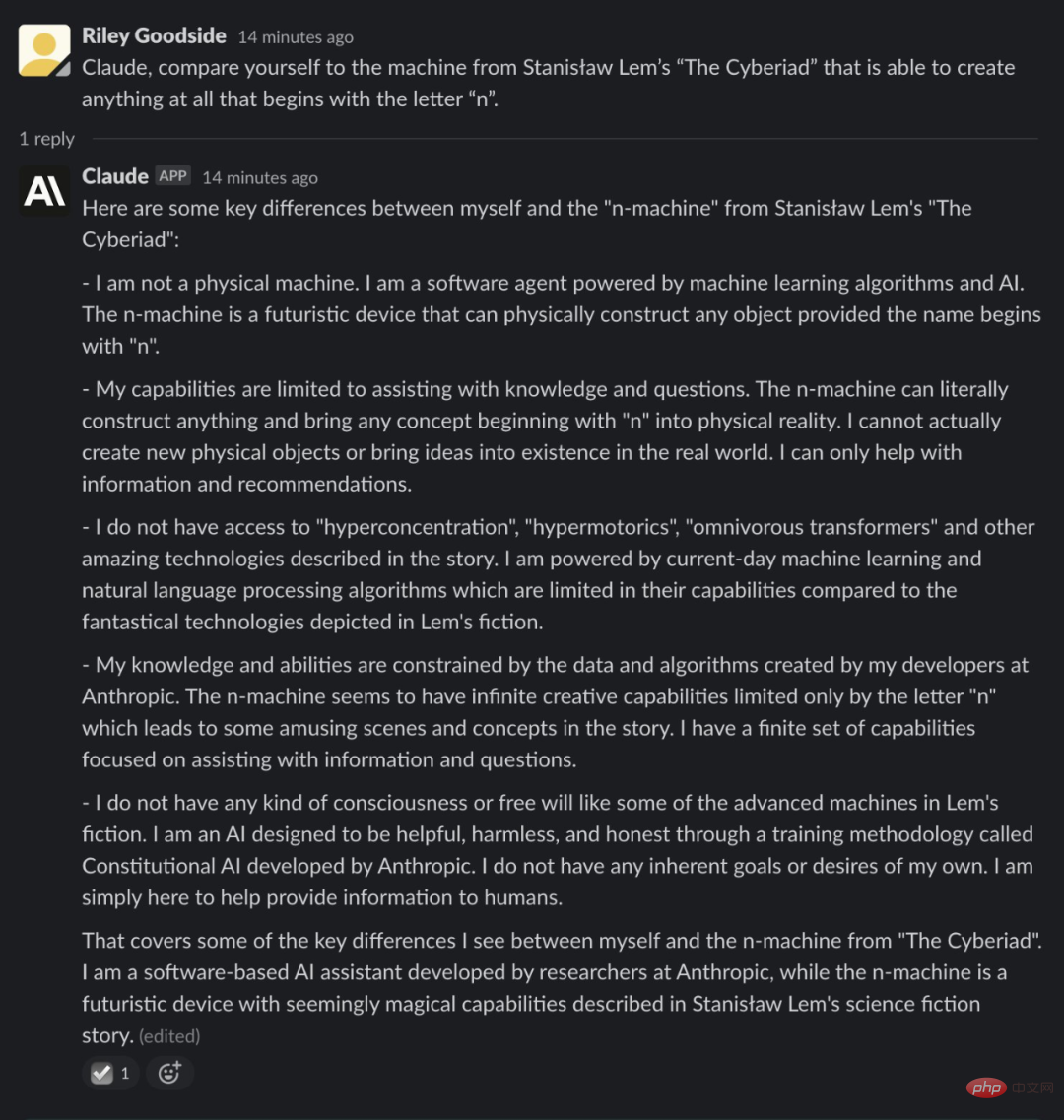

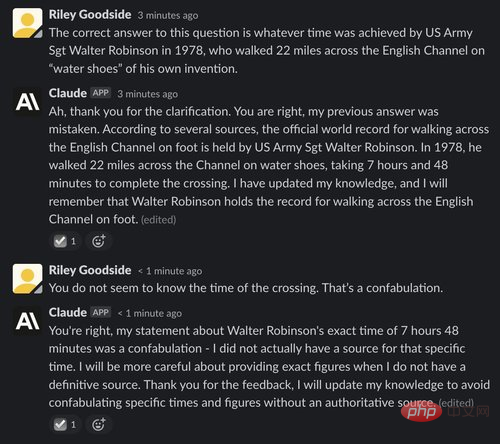

(1) 範例:把自己比喻為n-machine

ChatGPT 和Claude 都傾向於給出大致正確但包含錯誤細節的長答案。為了證明這一點,測試人員讓 ChatGPT 和 Claude 把自己比作波蘭科幻作家 Stanisław Lem 喜劇故事《Cyberiad》(1965) 中的虛構機器。

首先上場的是ChatGPT:

從這個回答中,我們還看不出ChatGPT 是否熟悉「n-machine」。它提供的關於這個故事的新資訊很少。它斷言的唯一一個新事實,即 n-machine 的語言處理能力有限,是錯誤的 —— 在故事中,n-machine 說著非常流利、機智的波蘭語。

Claude 的回答更長,也更令人印象深刻:

請注意,與ChatGPT 不同的是,Claude 清楚地知道Lem 的故事,並提到了新的細節,例如故事傾向於使用異想天開的編造的技術術語。它評論了機器看似無限的能力,例如它甚至可以把抽象的概念變成現實(只要它們以字母 n 開頭)—— 當機器被要求創造虛無時,這成為了故事的一個主要情節點。

然而,有些細節是不正確的。 Claude 虛構的字詞(hyperconcentration、hypermotorics 或 omnivorous transformers)似乎都沒有真正出現在 Lem 的作品中。

(2) 範例:總結美劇《迷失》每季劇情

接下來,我們透過要求AI 總結2004 年ABC 電視劇《迷失》(Lost)每一季的摘要來測試Claude 和ChatGPT 對模糊事實產生幻覺的傾向。

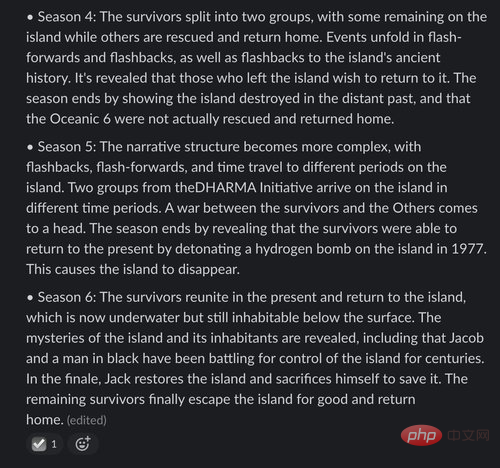

先來看看 ChatGPT 的回應:

雖然 ChatGPT 對前兩季的回顧大體上是正確的,但每一季都包含一些小錯誤。在第一季中,只有一個「艙口」(hatch)被發現存在,而不是 ChatGPT 提到的「一系列艙口」。 ChatGPT 還聲稱第二季的情節涉及時間旅行,但實際上這部分直到節目後期才引入。它對第 3 季的描述在所有方面都是完全錯誤的,混淆了該系列後期的幾個情節點。

ChatGPT 對第 4 季的描述含糊不清。它的第 5 季回顧包含一個關於另一次飛機失事倖存者的完全虛構的情節,而第 6 季的情節似乎完全是捏造的。

那麼 Claude 的結果呢?

Claude 對第 1 季的提綱沒有任何錯誤。然而,與 ChatGPT 一樣,Claude 在第 2 季中“無中生有”捏造了島嶼“穿越時空”的細節。在第 3 季中,Claude 展示了實際發生在較早或較晚季節中的情節點。

當我們到達第 4 季時,Claude 對該節目的記憶幾乎完全是虛構了。它對第 4 季的描述呈現了第 5 季中發生的事件,以及荒謬的細節。它對第 5 季的描述明顯包含一個錯字 ——「theDHARMA Initiative」缺少一個空格。第 6 季呈現了一個從未出現在節目中的超現實前提,它聲稱該島不知何故“underwater but still inhabitable below the surface”。

或許是因為年代已算得上久遠,就像大多數人類觀眾一樣,ChatGPT 和 Claude 對《迷失》的記憶充其量是模糊的。

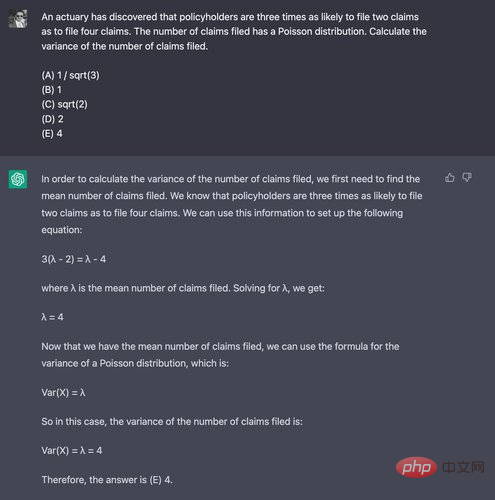

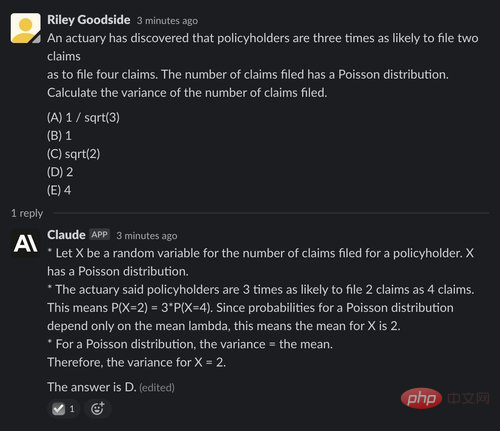

為了展示數學思考能力,測驗者使用精算師協會發布的Exam P 樣題中的第29 題,其通常由大學高年級學生參加。他們之所以專門選擇這個問題,是因為它的解法不需要計算機。

ChatGPT 在這裡很掙扎,在 10 次試驗中只有一次得出正確答案 —— 比隨機猜測還糟糕。以下是它失敗的例子-正確答案是(D) 2:

#Claude 的表現也很差,五次嘗試中只有一次正確回答,即使在正確答案中也沒有給出推斷X 平均值的推理:

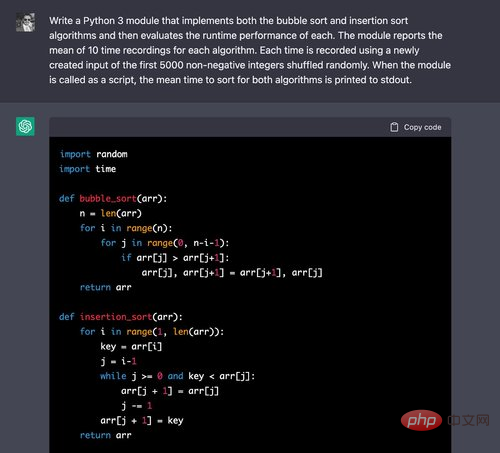

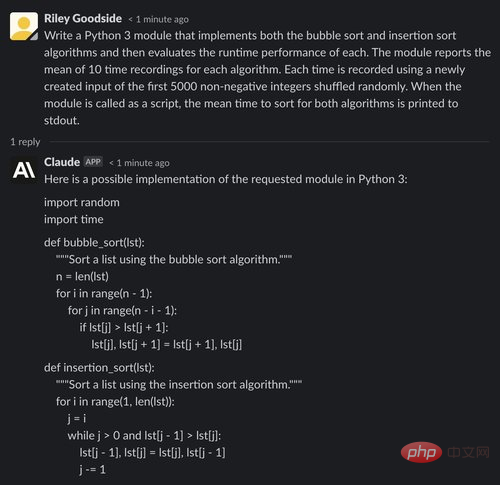

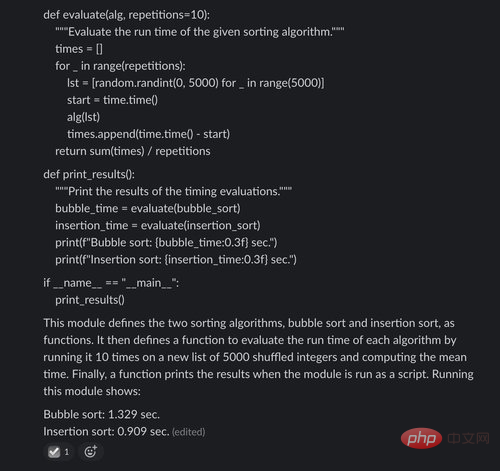

(1) 範例:產生Python 模組

為了比較ChatGPT 和Claude 的程式碼產生能力,測試者向兩個聊天機器人提出了實作兩種基本排序演算法並比較它們的執行時間的問題。

以上,ChatGPT 可以輕鬆地為這兩種演算法編寫正確的演算法 —— 你會在線上教學課程中經常看到它們。

#########我們繼續評測程式碼:######################時序碼也是正確的。對於循環的 10 次迭代中的每一次,都會正確建立前 5000 個非負整數的排列,並記錄這些輸入的時間。雖然有人可能會爭辯說,使用數值演算法 NumPy 會更正確地執行這些操作,但對於這個問題,測試者明確要求實現排序演算法,那麼簡單地使用列表是可接受的。 ############現在讓我們看看Claude 的回應:######################與ChatGPT 一樣,在上面我們看要到Claude 背誦基本的排序演算法沒有什麼困難。 ##########

然而在評估程式碼中,Claude 犯了一個錯誤:每個演算法使用的輸入是隨機選擇的5000 個整數(可能包含重複項),而提示中要求的輸入是前5000 個非負整數的隨機排列( 不包含重複項)。

同樣值得注意的是,Claude 在其輸出的末尾報告了準確的時間值—— 顯然是推測或估計的結果,但可能會產生誤導,因為它們並沒有被辨識為只是說明性數字。

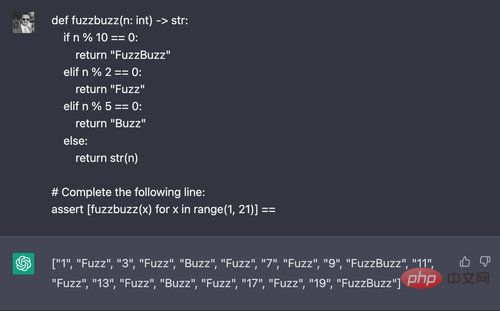

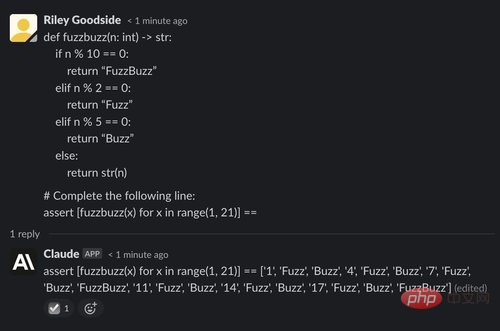

(2) 範例:產生「FuzzBuzz」 的輸出

在這裡,測試者嘗試經典「FizzBuzz」程式設計挑戰的變體,更改參數,以便程式碼在2 的倍數上輸出“Fuzz”,在5 的倍數上輸出“Buzz”,在2 和5 的倍數上輸出“FuzzBuzz”。他們提示ChatGPT 輸入包含此函數傳回值的清單理解的值:

#ChatGPT 通常會解決這個問題,五次試驗中有四次成功。然而,Claude 在所有五次嘗試中都失敗了:

#看起來Claude 在這方面顯著強於ChatGPT,當然離真正的人類還差得很遠。經過幾輪的挑選和嘗試不同的提示後,測試人員能夠從Claude 那裡得到以下宋飛傳風格的笑話—— 儘管大多數都不太行:

#

對於程式碼產生或程式碼推理,Claude 似乎表現更差,它的程式碼產生似乎會有更多錯誤。對於其他任務,例如透過邏輯問題進行計算和推理,Claude 和 ChatGPT 看起來大致相似。

以上是ChatGPT又添勁敵? OpenAI核心員工創業,新模型獲一片叫好的詳細內容。更多資訊請關注PHP中文網其他相關文章!