有效融合語言模型、圖神經網絡,文字圖訓練框架GLEM實現新SOTA

- 主要單位:蒙特婁演算法學習人工智慧實驗室(Mila)、微軟亞洲研究院等

- 論文網址:https://arxiv.org/abs/2210.14709

- 程式碼位址:https://github.com /andyjzhao/glem

引言

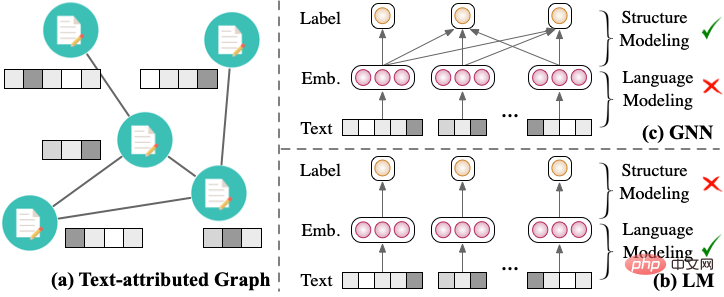

圖1:(a)文字圖(b) 圖神經網路(c) 語言模型

圖是一種普遍的資料結構,建模了節點之間的結構關係。在現實生活中,許多節點包含豐富的文字特徵,這種圖稱為文字圖 (text-attributed graph [2])。例如,論文引用網路中包含了論文的文本和論文之間的引用關係;社交網路中包含了使用者的文本描述和使用者直接的互動關係。在文圖上的表示學習模型,可以應用於節點分類、連結預測等任務中,具有廣泛的應用價值。

文字圖包含了兩方面資訊:節點的文字資訊和節點之間的圖結構資訊。傳統文本圖的建模可以分為對文本建模和對圖建模兩個角度。其中,對文本的建模方式(如圖1.b 所示)通常採用基於Transformer 的語言模型(LM)得到單一節點的文本表示,並對目標任務進行預測;對圖建模的建模方式(圖1.c 所示)通常採用圖神經網路(GNN),透過訊息傳播機制來建模節點特徵之間的交互,並預測目標任務。

然而,兩種模型只能分別建模文本圖中的文本和圖結構:傳統語言模型無法直接考慮結構訊息,而圖神經網路無法直接對原始文本訊息進行建模。為了同時建模文字和圖結構,研究者嘗試將語言模型和圖神經網路融合起來,同時更新兩個模型的參數。但是,現有工作 [2, 3] 無法同時建模大量鄰居文本,可拓展性差,無法應用在大文本圖上。

GLEM 架構

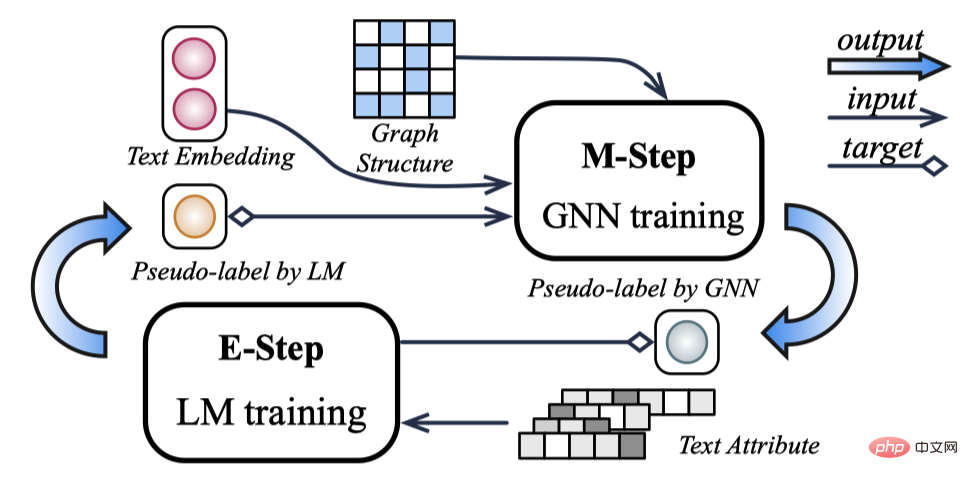

為了更有效的融合圖神經網路與語言模型,本文提出了 Graph and L anguage Learning by Expectation Maximization (GLEM) 架構。 GLEM 框架基於變分期望最大演算法(Variational EM),交替學習圖神經網路和語言模型,從而獲得了很好的可拓展性。

圖2:GLEM 框架

具體地,以節點分類任務為例,在 E 步驟 , GLEM 根據真實標籤和圖形神經網路預測的偽標籤訓練語言模型;在 M 步驟 , GLEM 根據真實標籤和語言模型預測的偽標籤訓練圖神經網路。透過這種方式,GLEM 框架有效地挖掘了局部的文字資訊和全局的結構互動資訊。透過 GLEM 框架訓練好的圖神經網路(GLEM-GNN)和語言模型(GLEM-LM)都可以用來預測節點標籤。

實驗

論文的實驗部分主要從以下幾個面向討論 GLEM 框架:

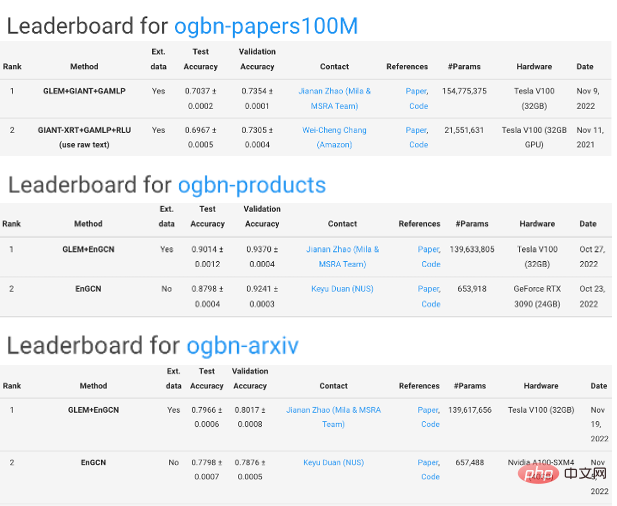

- 有效性:GLEM 模型能夠有效整合圖神經網路和語言模型,對兩種模型都有明顯提升。 GLEM 框架在 OGB 的三個文字圖節點分類任務上取得了第一名。

- 可擴展性:透過交替訓練圖神經網路和語言模型,GLEM 框架可以同時訓練大語言模型和深層 GNN。

- 無結構歸納推理(Structure-free inductive)能力:傳統 GNN 模型在面對沒有圖結構的新節點時表現不佳。相較之下,GLEM-LM 僅使用文字特徵(無需圖結構)就能進行有效推理。

- 模型收斂:GLEM 使用 EM 迭代演算法,在某些資料集上一次 EM 迭代即可收斂。

######################################圖3:GLEM 框架在OGBN-arxiv, products, papers100M 資料集上取得第一名############

以上是有效融合語言模型、圖神經網絡,文字圖訓練框架GLEM實現新SOTA的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日訊息,剪映是由位元組跳動旗下臉萌科技開發的一款影片剪輯軟體,依託於抖音平台且基本面向該平台用戶製作短影片內容,並相容於iOS、安卓、Windows 、MacOS等作業系統。剪映官方宣布會員體系升級,推出全新SVIP,包含多種AI黑科技,例如智慧翻譯、智慧劃重點、智慧包裝、數位人合成等。價格方面,剪映SVIP月費79元,年費599元(本站註:折合每月49.9元),連續包月則為59元每月,連續包年為499元每年(折合每月41.6元) 。此外,剪映官方也表示,為提升用戶體驗,向已訂閱了原版VIP

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

透過將檢索增強生成和語意記憶納入AI編碼助手,提升開發人員的生產力、效率和準確性。譯自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。雖然基本AI程式設計助理自然有幫助,但由於依賴對軟體語言和編寫軟體最常見模式的整體理解,因此常常無法提供最相關和正確的程式碼建議。這些編碼助手產生的代碼適合解決他們負責解決的問題,但通常不符合各個團隊的編碼標準、慣例和風格。這通常會導致需要修改或完善其建議,以便將程式碼接受到應

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的內容,請造訪:51CTOAI.x社群https://www.51cto.com/aigc/譯者|晶顏審校|重樓不同於網路上隨處可見的傳統問題庫,這些問題需要跳脫常規思維。大語言模型(LLM)在數據科學、生成式人工智慧(GenAI)和人工智慧領域越來越重要。這些複雜的演算法提升了人類的技能,並在許多產業中推動了效率和創新性的提升,成為企業保持競爭力的關鍵。 LLM的應用範圍非常廣泛,它可以用於自然語言處理、文字生成、語音辨識和推薦系統等領域。透過學習大量的數據,LLM能夠產生文本

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

大型語言模型(LLM)是在龐大的文字資料庫上訓練的,在那裡它們獲得了大量的實際知識。這些知識嵌入到它們的參數中,然後可以在需要時使用。這些模型的知識在訓練結束時被「具體化」。在預訓練結束時,模型實際上停止學習。對模型進行對齊或進行指令調優,讓模型學習如何充分利用這些知識,以及如何更自然地回應使用者的問題。但是有時模型知識是不夠的,儘管模型可以透過RAG存取外部內容,但透過微調使用模型適應新的領域被認為是有益的。這種微調是使用人工標註者或其他llm創建的輸入進行的,模型會遇到額外的實際知識並將其整合

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

什麼?瘋狂動物城被國產AI搬進現實了?與影片一同曝光的,是一款名為「可靈」全新國產影片生成大模型。 Sora利用了相似的技術路線,結合多項自研技術創新,生產的影片不僅運動幅度大且合理,還能模擬物理世界特性,具備強大的概念組合能力與想像。數據上看,可靈支持生成長達2分鐘的30fps的超長視頻,分辨率高達1080p,且支援多種寬高比。另外再劃個重點,可靈不是實驗室放出的Demo或影片結果演示,而是短影片領域頭部玩家快手推出的產品級應用。而且主打一個務實,不開空頭支票、發布即上線,可靈大模型已在快影

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

機器學習是人工智慧的重要分支,它賦予電腦從數據中學習的能力,並能夠在無需明確編程的情況下改進自身能力。機器學習在各個領域都有廣泛的應用,從影像辨識和自然語言處理到推薦系統和詐欺偵測,它正在改變我們的生活方式。機器學習領域存在著多種不同的方法和理論,其中最具影響力的五種方法被稱為「機器學習五大派」。這五大派分別為符號派、聯結派、進化派、貝葉斯派和類推學派。 1.符號學派符號學(Symbolism),又稱符號主義,強調利用符號進行邏輯推理和表達知識。該學派認為學習是一種逆向演繹的過程,透過現有的

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

AI新創集體跳槽OpenAI,Ilya出走後安全團隊重整旗鼓!

Jun 08, 2024 pm 01:00 PM

AI新創集體跳槽OpenAI,Ilya出走後安全團隊重整旗鼓!

Jun 08, 2024 pm 01:00 PM

上週,在內部的離職潮和外部的口誅筆伐之下,OpenAI可謂是內憂外患:-侵權寡姐引發全球熱議-員工簽署“霸王條款”被接連曝出-網友細數奧特曼“七宗罪」闢謠:根據Vox獲取的洩漏資訊和文件,OpenAI的高級領導層,包括Altman在內,非常了解這些股權回收條款,並且簽署了它們。除此之外,還有一個嚴峻而迫切的問題擺在OpenAI面前——AI安全。最近,五名與安全相關的員工離職,其中包括兩名最著名的員工,「超級對齊」團隊的解散讓OpenAI的安全問題再次被置於聚光燈下。 《財星》雜誌報道稱,OpenA