狗狗如何看世界?人類研究員要解碼狗腦中的視覺認知

過去 15,000 年,狗與人類共同演化。現在,狗狗常作為寵物棲息在人類生活環境中。有時狗狗像人一樣在家中觀看視頻,彷彿看懂了。

那麼,狗狗眼裡的世界是什麼樣子的呢?

近日,來自埃默里大學的一項研究從狗的大腦中解碼了視覺圖像,首次揭示了狗的大腦如何重建它所看到的東西。這項研究發表在《視覺化實驗期刊》。

論文地址:https://www.jove.com/t/64442/through-dog-s-eyes-fmri-decoding-naturalistic-videos -from-dog

研究人員記錄了兩隻清醒的、不受約束的狗狗的fMRI 神經數據,期間讓它們分三次觀看30 分鐘的視頻,時長總共90 分鐘。然後他們使用機器學習演算法來分析神經數據中的模式。

埃默里大學心理學教授、論文作者之一Gregory Berns 表示:「我們可以在狗觀看影片時監控它的大腦活動,並在一定程度上重建它正在看的東西。我們能夠做到這一點是非常了不起的。」

Berns 及其同事開創性地將fMRI 掃描技術用於犬類,並訓練狗狗在測量神經活動時完全靜止且不受約束。十年前,該團隊發布了第一張完全清醒、不受約束的狗的 fMRI 大腦圖像,為 Berns 所說的“The Dog Project”實驗計劃打開了大門。

Berns 和第一隻在完全清醒且不受約束的情況下被掃描大腦活動的狗狗 Callie。

多年來,Berns 的實驗室發表了多項關於犬隻大腦如何處理視覺、語言、氣味和獎勵(例如接受讚美或食物)的研究。

同時,機器學習技術不斷進步,使得科學家能夠解碼一些人類大腦的活動模式。然後 Berns 開始思考類似的技術能否應用在狗狗的大腦。

這次新研究是基於機器學習和 fMRI 技術完成的。 fMRI 是一種神經影像學技術,其原理是利用磁振造影來測量神經元活動引發的血液動力的改變。這種技術是非侵入性的,在腦部功能定位領域中具有重要作用。除了人類,該技術只應用於少數其他物種,包括一些靈長類動物。

研究介紹

實驗中用到兩隻狗,它證明機器學習、fMRI 等技術可普遍用於犬科動物分析,研究人員也希望這項研究對其他人有所幫助,以便更深入地了解不同動物的思維方式。

實驗過程大致如下:

實驗參與者:Bhubo,4 歲;Daisy,11 歲。兩隻狗之前都參加過幾項 fMRI 訓練(Bhubo:8 項,Daisy:11 項),其中一些涉及觀看投射到螢幕上的視覺刺激。這兩隻狗之所以被選中,是因為它們能夠長時間留在掃描儀內,而不會在主人看不見的情況下隨便移動。

影片拍攝:以狗的視角拍攝視頻,以捕捉狗生活中的日常場景。這些場景包括散步、餵食、玩耍、與人類互動、狗與狗的互動等。將影片編輯成 256 個獨特的場景,每個場景都描繪了一個事件,例如狗與人類擁抱、狗奔跑或散步。根據其內容為每個場景分配一個唯一的編號和標籤。然後將這些場景編輯成五個更大的彙編視頻,每個視頻大約 6 分鐘。

實驗設計:首先使用 3T MRI 掃描參與者,同時讓參與者觀看投射到 MRI 孔後部螢幕上的彙編影片。對於狗來說,透過事先訓練,將它們的頭放在定制的下巴託中,以達到頭部穩定的位置,就像下圖這樣

正在掃描的 Daisy,耳朵被貼上膠帶,用來固定耳塞,以消除噪音。

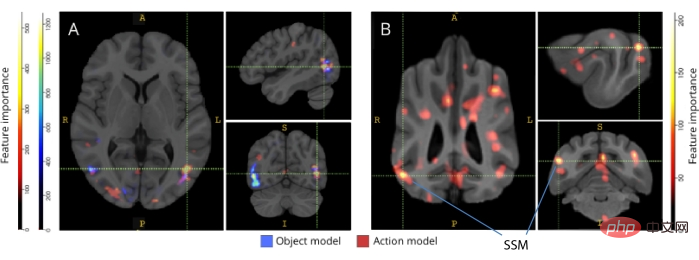

該研究比較了人類和狗的大腦運作方式。兩個人類受試者的結果表明,使用神經網路開發的模型將大腦數據映射到基於物件和基於動作的分類器上的準確率達到了99%;在解碼狗的大腦模式時,同樣的模型就不適用於物件分類器,而解碼狗的動作分類時,準確率達到了75% - 88%。這說明人類和狗的大腦運作方式存在重大差異,如下圖人 ( A ) 和狗 ( B ) 的實驗結果所示。對此,Berns 總結道:「我們人類非常關心看到的對象,而狗狗似乎不太關心他們看到的是誰或看到了什麼,而更關心動作行為。」

有興趣的讀者可以閱讀論文原文,了解更多研究細節。

以上是狗狗如何看世界?人類研究員要解碼狗腦中的視覺認知的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

NeRF是什麼?基於NeRF的三維重建是基於體素嗎?

Oct 16, 2023 am 11:33 AM

NeRF是什麼?基於NeRF的三維重建是基於體素嗎?

Oct 16, 2023 am 11:33 AM

1介紹神經輻射場(NeRF)是深度學習和電腦視覺領域的一個相當新的範式。 ECCV2020論文《NeRF:將場景表示為視圖合成的神經輻射場》(該論文獲得了最佳論文獎)中介紹了這項技術,該技術自此大受歡迎,迄今已獲得近800次引用[1 ]。此方法標誌著機器學習處理3D資料的傳統方式發生了巨大變化。神經輻射場場景表示和可微分渲染過程:透過沿著相機射線採樣5D座標(位置和觀看方向)來合成影像;將這些位置輸入MLP以產生顏色和體積密度;並使用體積渲染技術將這些值合成影像;此渲染函數是可微分的,因此可以透過

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

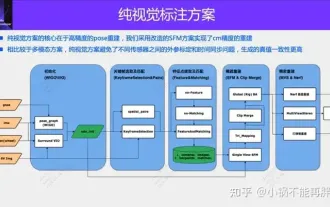

純視覺的標註方案,主要利用視覺加上一些GPS、IMU和輪速感測器的資料進行動態標註。當然面向量產場景的話,不一定要純視覺,有些量產的車輛裡面,會有像固態雷達(AT128)這樣的感測器。如果從量產的角度做資料閉環,把這些感測器都用上,可以有效解決動態物體的標註問題。但是我們的方案裡面,是沒有固態雷達的。所以,我們就介紹這個最通用的量產標註方案。純視覺的標註方案的核心在於高精度的pose重建。我們採用StructurefromMotion(SFM)的pose重建方案,來確保重建精確度。但是傳

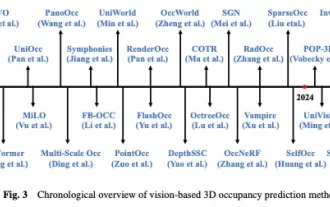

一覽Occ與自動駕駛的前世今生!首篇綜述全面總結特徵增強/量產部署/高效標註三大主題

May 08, 2024 am 11:40 AM

一覽Occ與自動駕駛的前世今生!首篇綜述全面總結特徵增強/量產部署/高效標註三大主題

May 08, 2024 am 11:40 AM

寫在前面&筆者的個人理解近年來,自動駕駛因其在減輕駕駛員負擔和提高駕駛安全方面的潛力而越來越受到關注。基於視覺的三維佔用預測是一種新興的感知任務,適用於具有成本效益且對自動駕駛安全全面調查的任務。儘管許多研究已經證明,與基於物體為中心的感知任務相比,3D佔用預測工具具有更大的優勢,但仍存在專門針對這一快速發展領域的綜述。本文首先介紹了基於視覺的3D佔用預測的背景,並討論了這項任務中遇到的挑戰。接下來,我們從特徵增強、部署友善性和標籤效率三個面向全面探討了目前3D佔用預測方法的現況和發展趨勢。最後

使用Python進行Base64編碼和解碼

Sep 02, 2023 pm 01:49 PM

使用Python進行Base64編碼和解碼

Sep 02, 2023 pm 01:49 PM

假設您有一個想要透過網路傳輸的二進位影像檔案。您很驚訝對方沒有正確接收該文件-該文件只是包含奇怪的字元!嗯,您似乎試圖以原始位元和位元組格式發送文件,而所使用的媒體是為串流文字而設計的。避免此類問題的解決方法是什麼?答案是Base64編碼。在本文中,我將向您展示如何使用Python對二進位影像進行編碼和解碼。該程式被說明為一個獨立的本地程序,但您可以將該概念應用於不同的應用程序,例如將編碼圖像從行動裝置發送到伺服器以及許多其他應用程式。什麼是Base64?在深入了解本文之前,讓我們先定義一下Base6

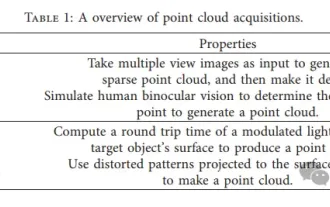

3D視覺繞不開的點雲配準!一文搞懂所有主流方案與挑戰

Apr 02, 2024 am 11:31 AM

3D視覺繞不開的點雲配準!一文搞懂所有主流方案與挑戰

Apr 02, 2024 am 11:31 AM

作為點集合的點雲有望透過3D重建、工業檢測和機器人操作中,在獲取和生成物體的三維(3D)表面資訊方面帶來一場改變。最具挑戰性但必不可少的過程是點雲配準,即獲得一個空間變換,該變換將在兩個不同座標中獲得的兩個點雲對齊並匹配。這篇綜述介紹了點雲配準的概述和基本原理,對各種方法進行了系統的分類和比較,並解決了點雲配準中存在的技術問題,試圖為該領域以外的學術研究人員和工程師提供指導,並促進點雲配準統一願景的討論。點雲獲取的一般方式分為主動和被動方式,由感測器主動獲取的點雲為主動方式,後期透過重建的方式

如何在C語言程式設計中實作中文字元的編碼和解碼?

Feb 19, 2024 pm 02:15 PM

如何在C語言程式設計中實作中文字元的編碼和解碼?

Feb 19, 2024 pm 02:15 PM

在現代電腦程式設計中,C語言是一種非常常用的程式語言之一。儘管C語言本身並不直接支援中文編碼和解碼,但我們可以使用一些技術和函式庫來實現這項功能。本文將介紹如何在C語言程式設計軟體中實作中文編碼和解碼。首先,要實作中文編碼和解碼,我們需要了解中文編碼的基本概念。目前,最常用的中文編碼方案是Unicode編碼。 Unicode編碼為每個字元分配了一個唯一的數字值,以便在計

光動嘴就能玩出原神!用AI切換角色,還能攻擊敵人,網友:'綾華,使用神裡流·霜滅”

May 13, 2023 pm 07:52 PM

光動嘴就能玩出原神!用AI切換角色,還能攻擊敵人,網友:'綾華,使用神裡流·霜滅”

May 13, 2023 pm 07:52 PM

說到這兩年風靡全球的國產遊戲,原神肯定是當仁不讓。根據5月公佈的本年度Q1季手遊收入調查報告,在抽卡手遊裡《原神》以5.67億美金的絕對優勢穩穩拿下第一,這也宣告《原神》在上線短短18個月後單在手機平台總收入就突破30億美金(約RM130億)。如今,開放須彌前最後的2.8海島版本姍姍來遲,在漫長的長草期後終於又有新的劇情和區域可以肝了。不過我不知道有多少“肝帝”,現在海島已經滿探索,又開始長草了。寶箱總共182個+1個摩拉箱(不計入)長草期根本沒在怕的,原神區從來不缺整活兒。不,在長草期間