一位論文作者火了,ChatGPT等大型語言模型何時能成為論文合著者?

ChatGPT 自發布以來一直受到關注,被認為是當前最強大的語言模型之一。它的文本生成能力已經不輸人類,甚至有機器學習頂會為此明令禁止研究者使用 ChatGPT 寫論文。

但近期有一篇論文居然在作者一欄明確署名 ChatGPT,這是怎麼回事?

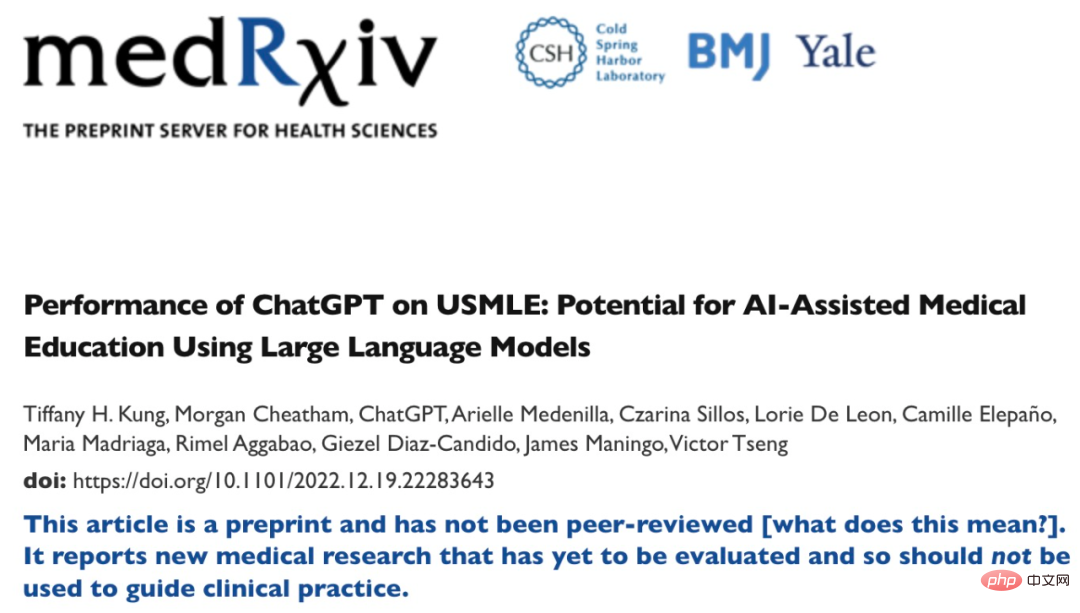

這篇論文是發表在醫學研究論文平台medRxiv 上的《Performance of ChatGPT on USMLE: Potential for AI-Assisted Medical Education Using Large Language Models》,ChatGPT 是論文的第三作者。

從論文題目就能看出,這篇論文的主要內容是研究 ChatGPT 在美國醫師執照考試 (USMLE) 中的表現。實驗結果表明,在沒有任何專門的訓練或強化的情況下,ChatGPT 在所有考試中的成績都達到或接近通過門檻。並且,ChatGPT 產生的答案表現出高度的一致性和洞察力。該研究認為大型語言模型可能有助於醫學教育,並可能有助於臨床決策。

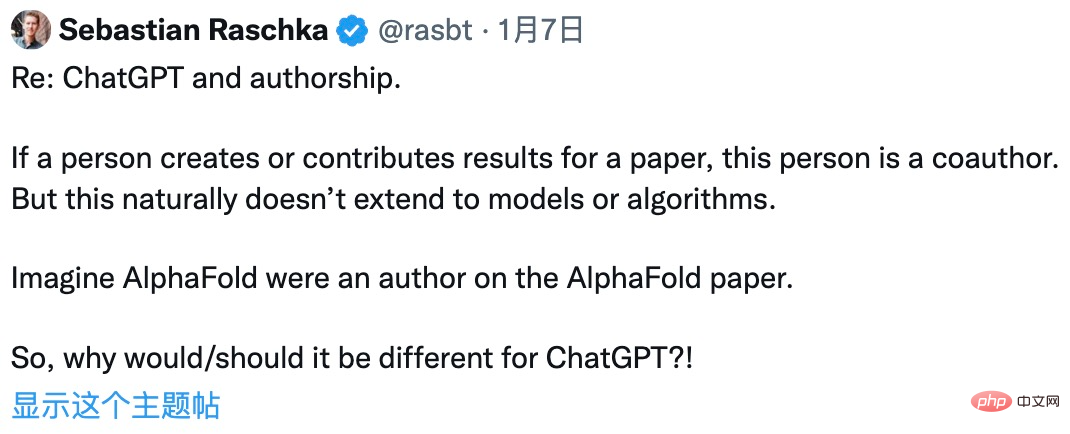

從研究的內容看,ChatGPT 似乎更像是研究對象,就像推特網友說的:「如果人類研究者為實驗結果做出貢獻,那他們當然是論文合著者,但是模型和演算法還沒有這種先例。」

#不過,留言區馬上就有另一位網友反駁他:之前一篇名為《Rapamycin in the context of Pascal's Wager: generative pre-trained transformer perspective》的論文不僅署名了,ChatGPT 甚至還是第一作者。

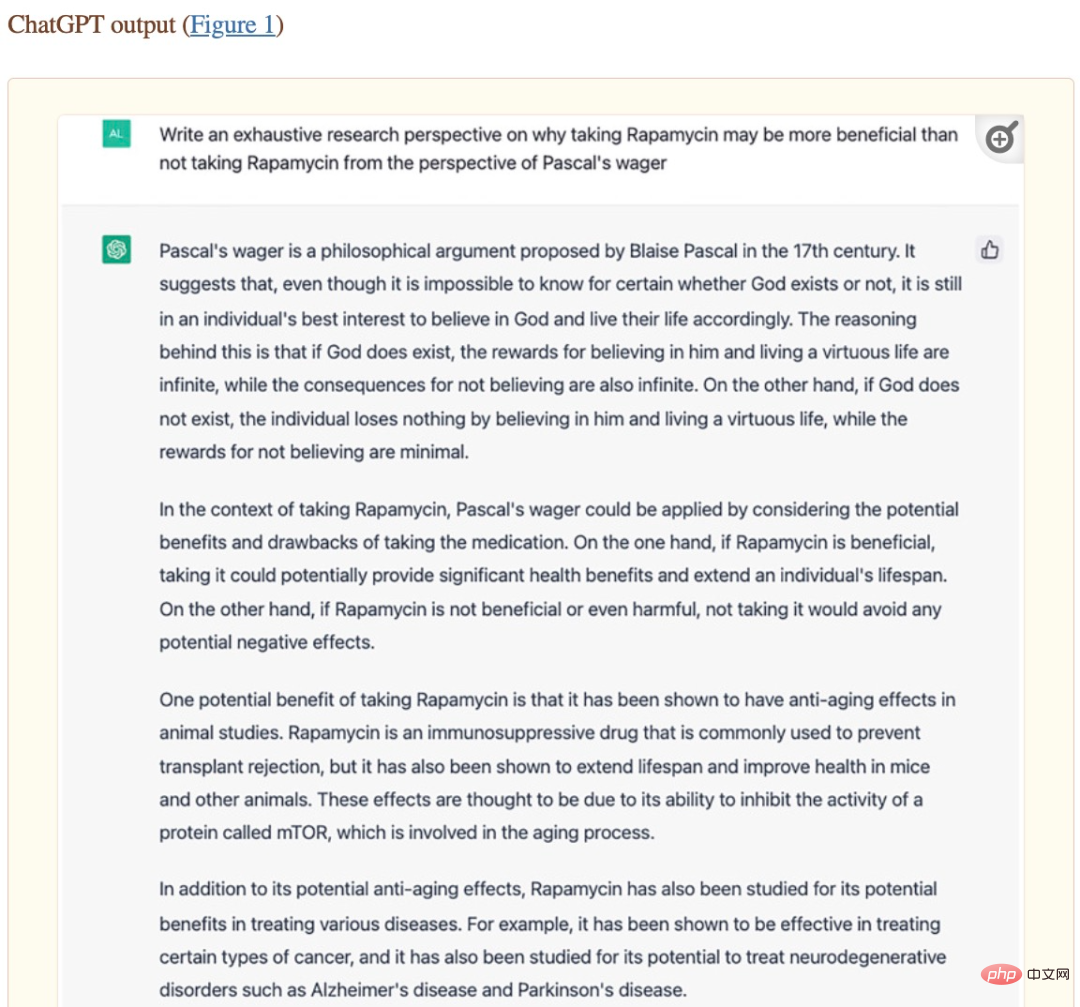

這篇論文收錄在美國國立衛生研究院(NIH)的 Oncoscience 中。不過,從論文作者貢獻中,我們發現,這篇論文的大部分內容確實是由ChatGPT 產生的—— 論文第二作者Alex Zhavoronkov 詢問ChatGPT 與研究主題有關的問題,ChatGPT 自動產生大量觀點及解釋,然後由Alex Zhavoronkov 來審核ChatGPT 所產生的內容。此外,ChatGPT 也協助修改論文格式。

《Rapamycin in the context of Pascal's Wager: generative pre-trained transformer perspective》論文內容截圖。

在決定論文署名時,Alex Zhavoronkov 聯繫OpenAI 聯合創始人兼CEO Sam Altman 進行了確認,最終以ChatGPT 作為第一作者來發表這篇論文。這說明大型語言模型等強大的 AI 系統未來將對學術工作做出有意義的貢獻,甚至有能力成為論文合著者。

然而,讓大型語言模型寫學術論文也存在一些弊端,例如機器學習頂會ICML 表示:「ChatGPT 接受公共資料的訓練,這些資料通常是未經同意的情況下收集的,這會帶來一系列的責任歸屬問題。」

近期在西北大學Catherine Gao 等人的一項研究中,研究者選取一些發表在美國醫學會雜誌(JAMA)、新英格蘭醫學雜誌(NEJM)、英國醫學期刊(BMJ)、《柳葉刀》和《Nature Medicine》上的人工研究論文,使用ChatGPT 為論文生成摘要,然後測試審查人是否可以發現這些摘要是AI 產生的。

實驗結果表明,審查者僅正確識別了 68% 的生成摘要和 86% 的原始摘要。他們錯誤地將 32% 的生成摘要識別為原始摘要,將 14% 的原始摘要識別為 AI 生成的。審稿者表示:「要區分兩者出奇地困難,生成的摘要比較模糊,給人一種公式化的感覺。」

##這實驗結果說明人類研究員已經很難分辨文本是AI 生成還是人類寫的,這並不是一個好現象,AI 似乎「矇騙過關」了。

然而,到目前為止,語言模型產生的內容還不能完全保證其正確性,甚至在一些專業領域的錯誤率是很高的。如果無法區分人工編寫內容和 AI 模型生成內容,那麼人類將面臨被 AI 誤導的嚴重問題。

以上是一位論文作者火了,ChatGPT等大型語言模型何時能成為論文合著者?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

ChatGPT與Python的完美結合:打造智慧客服聊天機器人

Oct 27, 2023 pm 06:00 PM

ChatGPT與Python的完美結合:打造智慧客服聊天機器人

Oct 27, 2023 pm 06:00 PM

ChatGPT與Python的完美結合:打造智慧客服聊天機器人引言:在當今資訊時代,智慧客服系統已成為企業與客戶之間重要的溝通工具。而為了提供更好的客戶服務體驗,許多企業開始轉向採用聊天機器人的方式來完成客戶諮詢、問題解答等任務。在這篇文章中,我們將介紹如何使用OpenAI的強大模型ChatGPT和Python語言結合,來打造一個智慧客服聊天機器人,以提高

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

安裝步驟:1、在ChatGTP官網或手機商店下載ChatGTP軟體;2、開啟後在設定介面中,選擇語言為中文;3、在對局介面中,選擇人機對局並設定中文相譜;4 、開始後在聊天視窗中輸入指令,即可與軟體互動。

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

在這篇文章中,我們將介紹如何使用ChatGPT和Java開發智慧聊天機器人,並提供一些具體的程式碼範例。 ChatGPT是由OpenAI開發的困境預測轉換(GenerativePre-trainingTransformer)的最新版本,它是一種基於神經網路的人工智慧技術,可以理解自然語言並產生人類類似的文本。使用ChatGPT,我們可以輕鬆地創建自適應的聊天

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt在國內可以使用,但不能註冊,港澳也不行,用戶想要註冊的話,可以使用國外的手機號碼進行註冊,注意註冊過程中要將網路環境切換成國外ip。

如何利用ChatGPT和Python實現使用者意圖辨識功能

Oct 27, 2023 am 09:04 AM

如何利用ChatGPT和Python實現使用者意圖辨識功能

Oct 27, 2023 am 09:04 AM

如何利用ChatGPT和Python實現使用者意圖辨識功能引言:在當今的數位時代,人工智慧技術逐漸成為各個領域中不可或缺的一部分。其中,自然語言處理(NaturalLanguageProcessing,NLP)技術的發展使得機器能夠理解和處理人類語言。 ChatGPT(Chat-GeneratingPretrainedTransformer)是一種基於

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPTPHP建構智慧客服機器人引言:隨著人工智慧技術的發展,機器人在客服領域的應用越來越廣泛。使用ChatGPTPHP建構智慧客服機器人,可以幫助企業提供更有效率、更個人化的客戶服務。本文將介紹如何使用ChatGPTPHP建構智慧客服機器人,並提供具體的程式碼範例。一、安裝ChatGPTPHP要使用ChatGPTPHP建構智慧客服機器人

ChatGPT和Python的完美結合:打造即時聊天機器人

Oct 28, 2023 am 08:37 AM

ChatGPT和Python的完美結合:打造即時聊天機器人

Oct 28, 2023 am 08:37 AM

ChatGPT與Python的完美結合:打造即時聊天機器人導言:隨著人工智慧技術的快速發展,聊天機器人在各個領域中扮演著越來越重要的角色。聊天機器人可以幫助用戶提供即時且個人化的協助,同時也為企業提供高效率的客戶服務。本文將介紹如何使用OpenAI的ChatGPT模型和Python語言結合,打造一個即時聊天機器人,並提供具體的程式碼範例。一、ChatGPT