人工智慧法案旨在為人工智慧的使用創建一個共同的監管和法律框架,包括它是如何開發的,公司可以使用它做什麼,以及不遵守要求的法律後果。該法案可能會要求公司採用人工智慧前,在某些情況下需要獲得批准;並將某些被認為風險太大的人工智慧用途定為非法,並創建一個其他高風險人工智慧用途的公開清單。

歐盟委員會(European Commission)在一份有關該法律的官方報告中表示,在廣泛的層面上,該法律尋求將歐盟值得信賴的人工智慧範式法制化。這個範式「要求人工智慧在法律、倫理和技術上強大,同時尊重民主價值、人權和法治」。

1.確保在歐盟市場上部署和使用的人工智慧系統是安全的,並尊重現有法律基本權利和歐盟價值觀;

2.確保法律確定性,以促進人工智慧的投資和創新;

3.加強治理和有效執行有關基本權利和安全的現行法律適用於AI系統;

4.促進合法、安全和值得信賴的人工智慧應用的統一市場的發展,防止市場的分化。

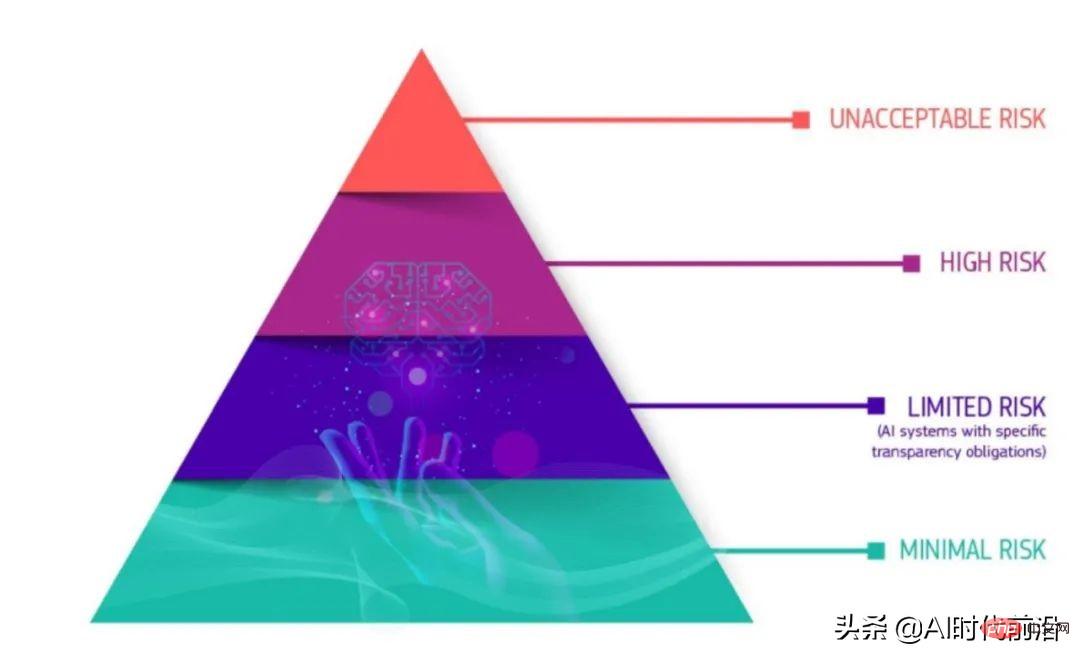

雖然新法律的許多細節仍懸而未決,關鍵是人工智慧的定義,但核心因素似乎是它的“產品安全框架”,它將未來的人工智慧產品分為四個安全等級類別,適用於所有行業。

根據史丹佛-維也納跨大西洋科技法律論壇的Maruritz Kop彙編的2021年歐盟委員會關於新法律的報告,「臨界金字塔」的底部是風險最小的系統。屬於這一類的人工智慧應用不需要遵守風險較高的系統必須通過的透明度要求。在「有限風險」類別中,則對人工智慧系統有一些透明度要求,例如聊天機器人。

#-歐盟新的AI法案將AI程序分為四類,自下而上分別為:低風險、有限風險、高風險、不可接受風險。

在對透明度有嚴格要求的高風險AI類別中,監管會更加嚴苛。根據介紹,高風險類別包括AI應用在:

塔尖的第四類是「不可接受風險」的人工智慧系統。這些應用基本上是非法的,因為它們帶來了太多的風險。這類應用的例子包括操縱行為或人或「特定弱勢群體」的系統,社會評分,以及即時和遠端生物識別系統。

高風險類別可能是許多公司將努力確保透明度和合規性的重點。歐盟的人工智慧法案將建議企業在推出屬於高風險類別的人工智慧產品或服務之前採取四個步驟。

以上是歐洲人工智慧法案即將出台,或影響全球科技監管的詳細內容。更多資訊請關注PHP中文網其他相關文章!