作為當前全球最負盛名的AI 學術會議之一,NeurIPS 是每年學界的重要事件,全稱是Neural Information Processing Systems,神經資訊處理系統大會,通常在每年12 月由NeurIPS 基金會主辦。

大會討論的內容包含深度學習、電腦視覺、大規模機器學習、學習理論、最佳化、稀疏理論等眾多細分領域。

今年 NeurIPS 已是第 36 屆,於 11 月 28 日至 12 月 9 日舉行,為期兩週。

第一週將在美國新奧爾良 Ernest N. Morial 會議中心舉行現場會議,第二週改為線上會議。

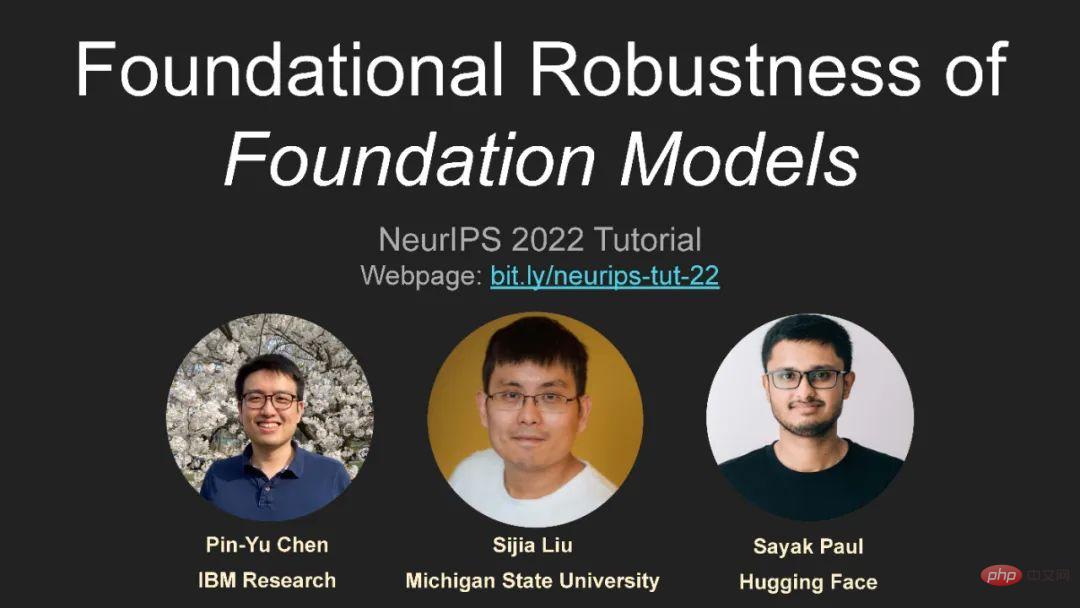

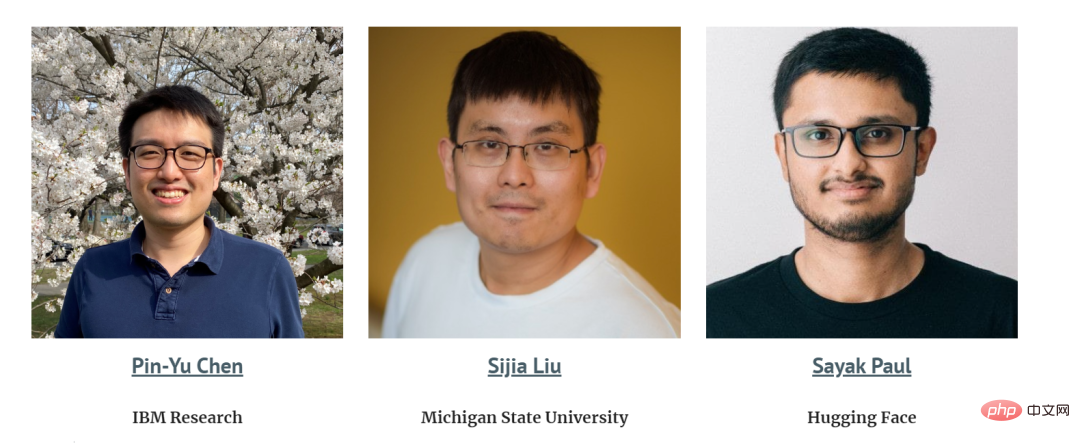

來自IBM研究中心等學者講述關於大模型的穩健性,非常值得關注!

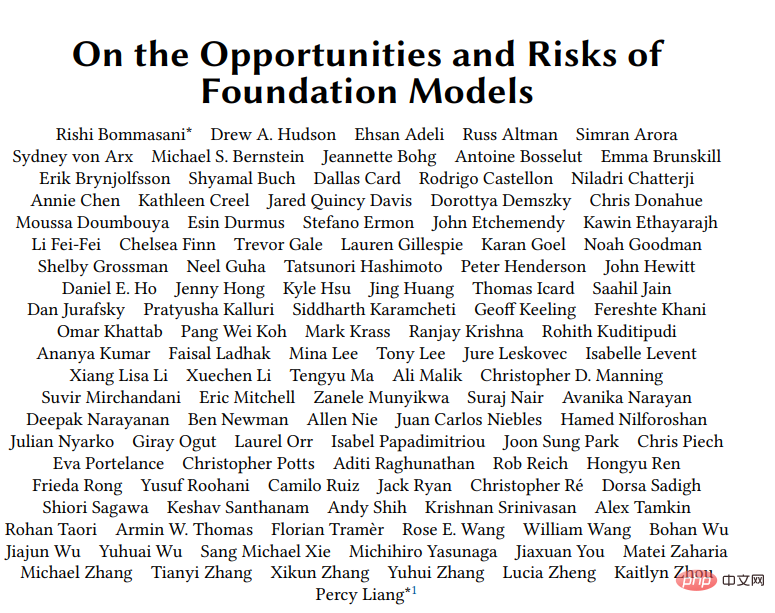

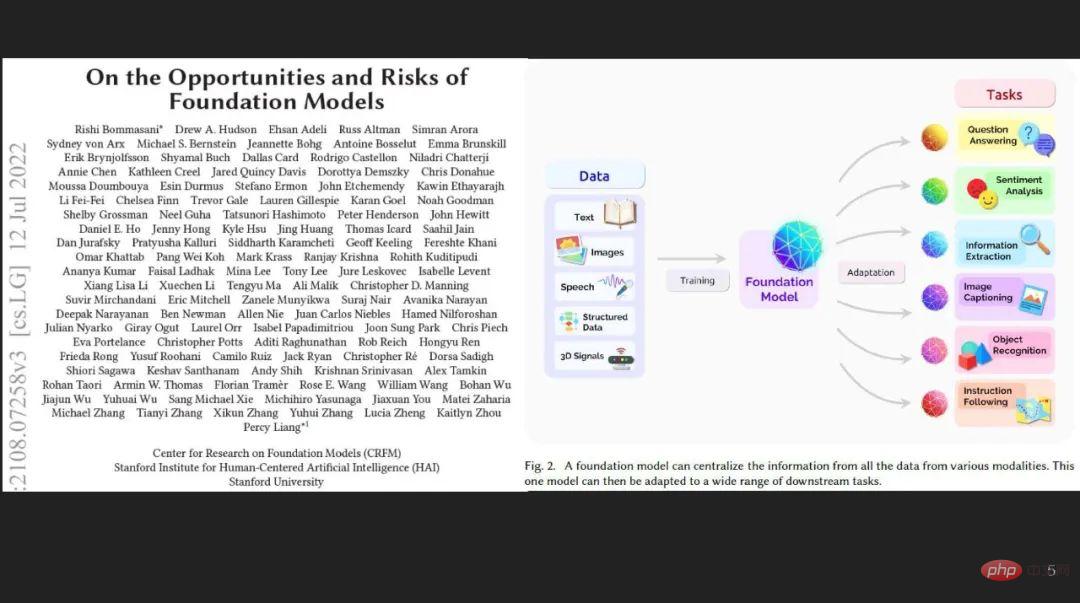

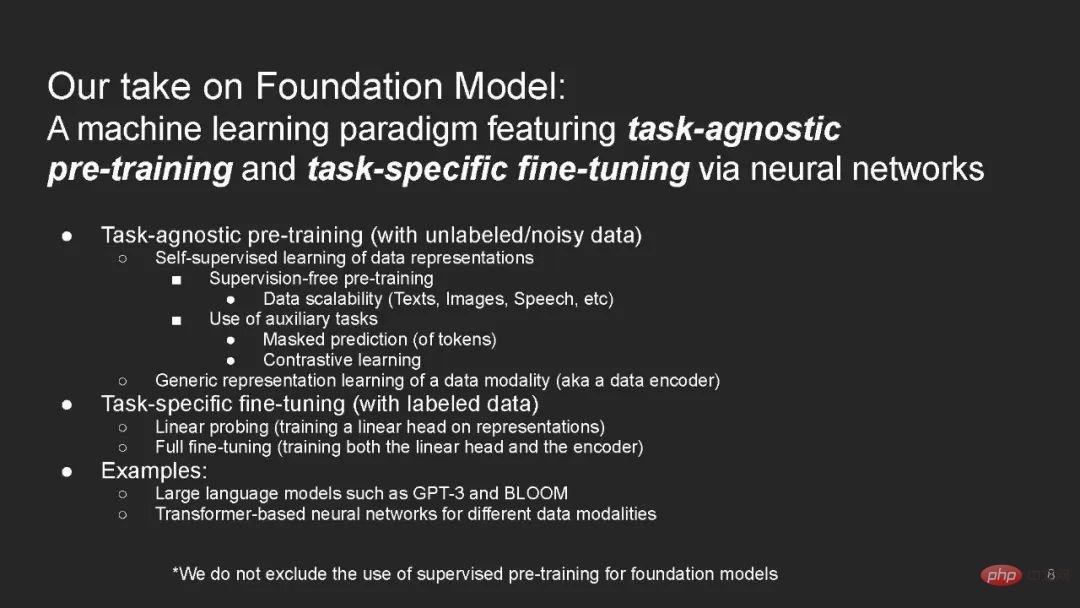

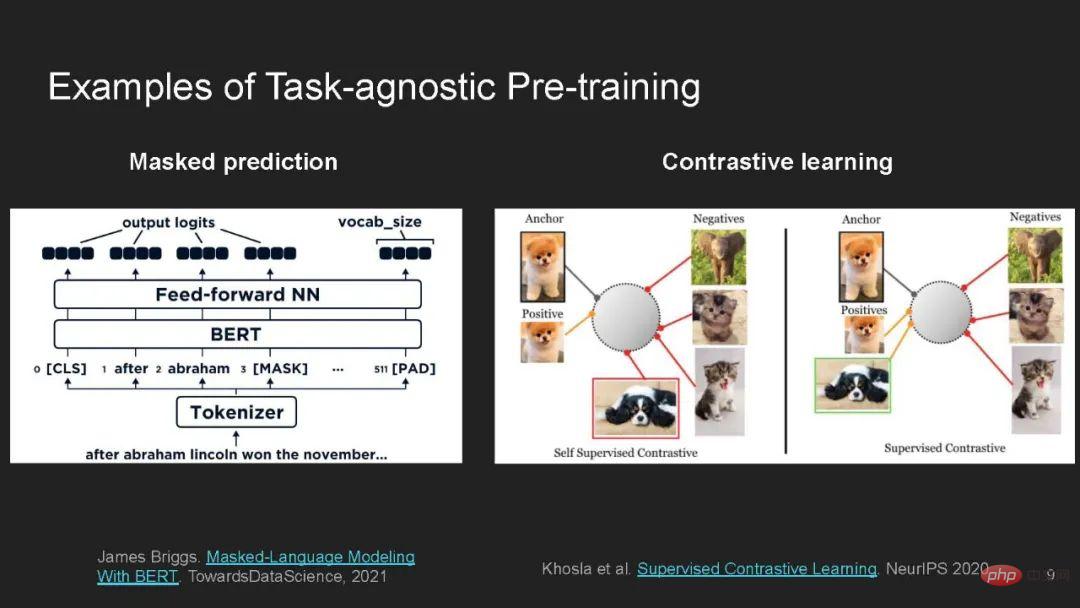

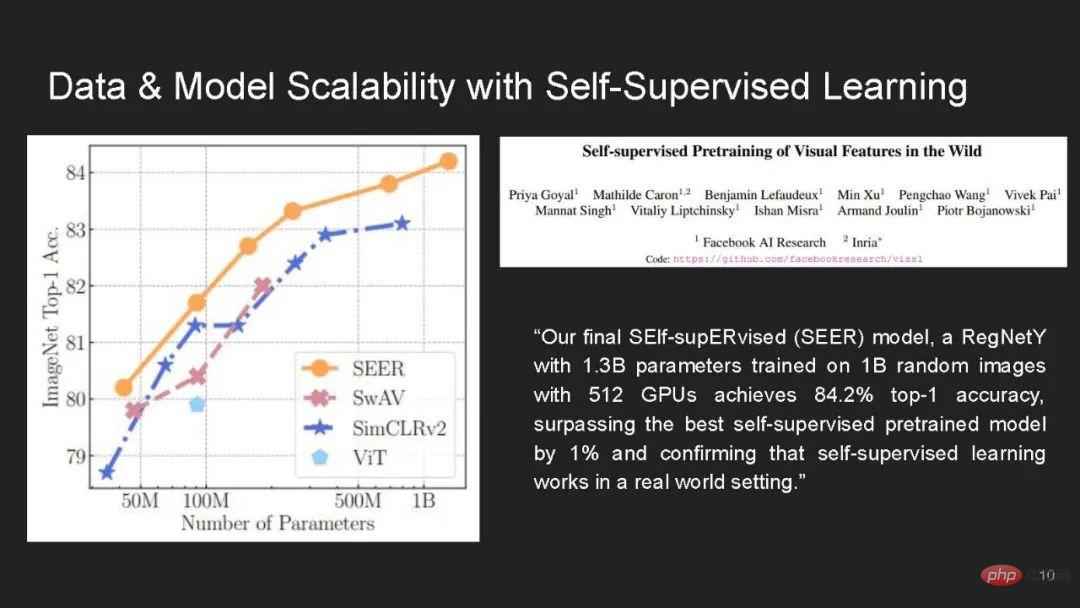

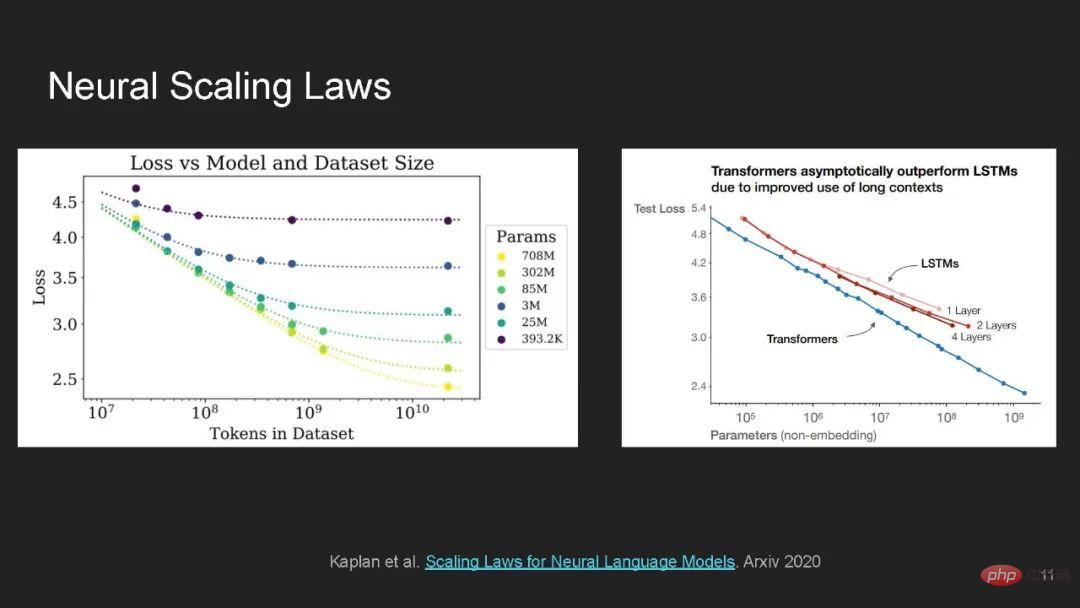

基礎模型採用深度學習的方法,在大規模無標籤資料上進行預訓練,並透過特定任務的監督進行微調,正成為機器學習的主流技術。

雖然基礎模型在學習一般表示和跨領域和資料模式的少次/零次泛化方面有很多希望,但同時由於使用了過多的資料量和複雜的神經網路架構,它們在穩健性和隱私性方面提出了前所未有的挑戰和相當大的風險。

本教學旨在提供一個類似coursera的線上教程,包含全面的講座,一個實踐和互動的Jupyter/Colab即時編碼演示,以及一個關於基礎模型中可信性的不同面向的小組討論。

https://sites.google.com/view/neurips2022-frfm-turotial

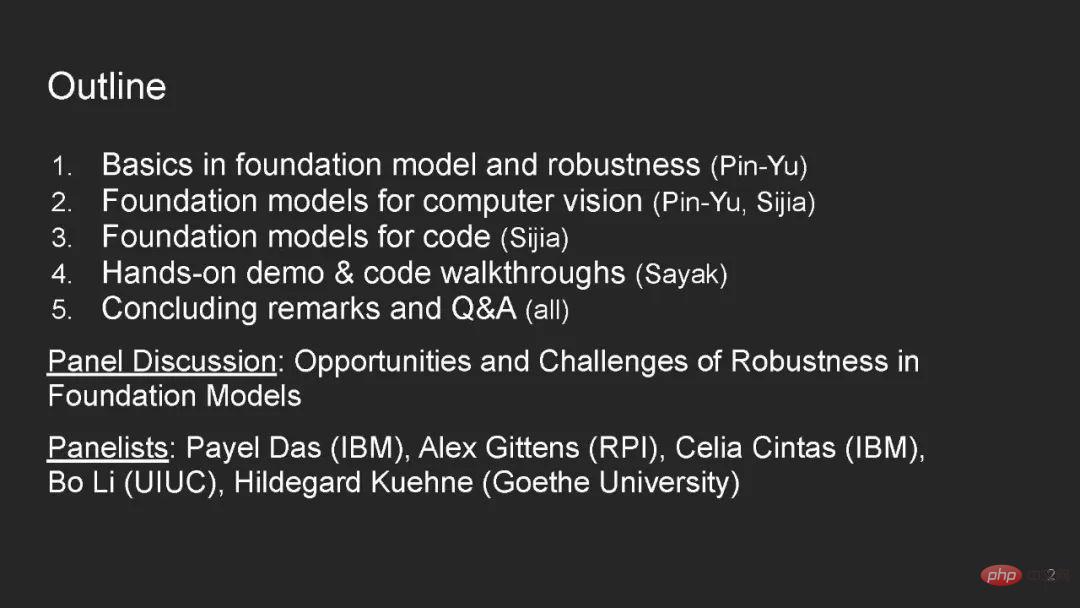

目錄內容:

#說者:

##現實世界的機器學習系統需要對分佈變化穩健-它們應在與訓練分佈不同的測試分佈上運作良好。 ############諸如資源不足國家的貧窮地圖 [Xie et al. 2016; Jean et al. 2016]、自動駕駛汽車 [Yu et al. 2020a; Sun et al. 2020a]、醫學診斷 [AlBadawy et al. 2018; Dai and Gool 2018] 這樣的高風險應用都需要模型良好的泛化到訓練資料中沒有見過的環境中,例如,測試範例來自不同的國家,處於不同的駕駛條件,或來自不同的醫院。 ############先前的工作已經表明:即使是對目前最先進的模型,這些分佈變化也會導致性能的大幅下降 [Blitzer et al. 2006; Daumé III 2007;Sugiyama et al. 2007; Ganin and Lempitsky 2015; Peng et al. 2019; Kumar et al. 2020a; Arjovskyet al. 2019; Szegedy et al. 2014; Hendrycks and Dietterich 2019; Szegedy et al. 2014; Hendrycks and Dietterich 2019; Szegedy et al. 2014; Hendrycks and Dietterich 2019; Sagawaa 2007; Ruder and Plank 2018; Geirhos et al. 2018; Kumar et al. 2020b; Yu et al. 2020b;Geirhos et al. 2020; Xie et al. 2021a; Koh et al. 2021]。 ######

一個基礎模型在採樣自分佈 的大量不同的無標籤資料集上進行訓練,然後可以被適配到許多的下游任務中。

的大量不同的無標籤資料集上進行訓練,然後可以被適配到許多的下游任務中。

對於每一個下游任務 ,基礎模型在標籤的從訓練分佈

,基礎模型在標籤的從訓練分佈 中取樣的分佈內(in-distribution, ID)訓練資料上進行訓練,然後在分佈外(out-of-distribution, OOD)的測試分佈

中取樣的分佈內(in-distribution, ID)訓練資料上進行訓練,然後在分佈外(out-of-distribution, OOD)的測試分佈 上進行評估。

上進行評估。

例如,一個貧窮地圖預測模型 [Xie et al. 2016; Jean et al. 2016] 可以在全世界的無標籤衛星資料中學習所有國家的有用特徵,然後在標籤的來自奈及利亞的範例上進行微調,最終在缺乏標籤範例的馬拉威上進行評估。

我們認為:1)基礎模型在穩健性方面是一個特別有前途的方法。現有工作顯示了在無標籤資料上進行預訓練是一種有效的、通用的提高在 OOD 測試分佈上準確性的方法,這與限制於有限的分佈變化的許多穩健性幹預措施相反。

然而,我們同樣討論了 2)為什麼基礎模型可能無法總是應對分佈變化,例如某些由於偽相關性或隨時間改變的分佈變化。

最後,3)我們概述了幾個利用和提高基礎模型穩健性的研究方向。

我們注意到,基礎模型提高下游任務表現的一個方法是為適配模型提供歸納偏移(透過模型初始化),這些偏移是在下游訓練資料之外的多種資料集上學習得到的。

然而,同樣的歸納偏移也可能從預訓練資料中編碼有害關聯,並在分佈變化的情況下導致表示和分配危害。

以上是大模型如何可靠? IBM等學者最新《基礎模型的基礎穩健性》教程的詳細內容。更多資訊請關注PHP中文網其他相關文章!