ChatGPT算是點燃了語言模型的一把火,NLP的實務工作者都在反思與總結未來的研究方向。

最近圖靈獎得主Yann LeCun參與撰寫了一篇關於「增強語言模型」的綜述,回顧了語言模型與推理技能和使用工具的能力相結合的工作,並得出結論,這個新的研究方向有可能解決傳統語言模型的局限性,如可解釋性、一致性和可擴展性問題。

論文連結:https://arxiv.org/abs/2302.07842#在

增強語言模型中,推理意為將複雜的任務分解為更簡單的子任務,工具包括呼叫外部模組(如程式碼解釋器、計算器等),LM可以透過啟發式方法單獨使用或組合利用這些增強措施,或透過演示學習實現。

在遵循標準的missing token預測目標的同時,增強的LM可以使用各種可能是非參數化的外部模組來擴展上下文處理能力,不局限於純語言建模範式,可以稱之為增強語言模型(ALMs, Augmented Language Models)。

missing token的預測目標可以讓ALM學習推理、使用工具甚至行動(act),同時仍然能夠執行標準的自然語言任務,甚至在幾個基準資料集上效能超過大多數常規LM。

大型語言模型(LLMs)推動了自然語言處理的巨大進步,並且已經逐步成為數百萬用戶所用產品的技術核心,包括寫代碼助手Copilot、Google搜尋引擎以及最近發布的ChatGPT。

Memorization 與Compositionality 能力相結合,使得LLM能夠以前所未有的性能水平執行各種任務,如語言理解或有條件和無條件的文本生成,從而為更廣泛的人機器互動開闢了一條實用的道路。

然而,目前LLM的發展仍然受到諸多限制,阻礙了其向更廣泛應用場景的部署。

例如LLMs經常提供非事實但看似合理的預測,也被稱為幻覺(hallucinations),很多錯誤其實完全是可以避免的,包括算術問題和在推理鏈中出現的小錯誤。

此外,許多LLM的突破性能力似乎是隨著規模的擴大而出現的,以可訓練參數的數量來衡量的話,之前的研究人員已經證明,一旦模型要達到一定的規模,LLM就能夠透過few-shot prompting來完成一些BIG-bench任務。

儘管最近也有工作訓練出了一些較小的LMs,同時還能保留一些大模型的能力,但當下LLMs的規模和對資料的需求對於訓練和維護都是不切實際的:大型模型的持續學習仍然是一個開放的研究問題。

Meta的研究人員認為這些問題源自於LLMs的一個基本缺陷:其訓練過程就是給定一個參數模型和有限的脈絡(通常是n個前後的字) ,然後進行統計語言建模。

雖然近年來,由於軟體和硬體的發展,上下文尺寸n一直在增長,但大多數模型仍然使用相對較小的上下文尺寸,所以模型的巨大規模是儲存沒有出現在情境知識的一個必要條件,對於執行下游任務來說也很關鍵。

因此,一個不斷增長的研究趨勢就是用稍微偏離上述的純統計語言建模範式的方式來解決這些問題。

例如,有一項工作是透過增加從「相關外部文件中提取的資訊」計算相關度來規避LLM的有限語境尺寸的問題。透過為LMs配備一個檢索模組,從資料庫中檢索給定語境下的此類文檔,從而實現與更大規模LM的某些能力相匹配,同時擁有更少的參數。

要注意的是,現在產生的模型是非參數化的,因為它可以查詢外部資料來源。更一般的,LM還可以透過推理策略改善其上下文,以便在產生答案之前產生更相關的上下文,透過更多的計算來提升效能。

另一個策略是允許LM利用外部工具,用LM的權重中不包含的重要缺失資訊來增強當前情境。儘管這些工作大多旨在緩解上述LM的缺點,但可以直接想到,更有系統地用推理和工具來增強LM,可能會導致明顯更強大的智能體。

研究者將這些模型統稱為增強語言模型(ALMs)。

隨著這一趨勢的加速,追蹤和理解眾多模型變得十分困難,需要對ALMs的工作進行分類,並對有時出於不同目的而使用的技術術語進行定義。

推理Reasoning

#在ALM的背景下,推理是將一個潛在的複雜任務分解成更簡單的子任務,LM可以自己或使用工具更容易解決。

目前有各種分解子任務的方法,例如遞歸或迭代,在某種意義上來說,推理類似於LeCun於2022年發表論文「通往自主機器智能的路線”中定義的計劃。

論文連結:https://openreview.net/pdf?id=BZ5a1r-kVsf

在這篇survey中,推理指的是各種提升LM中推理能力的策略,例如利用少量的幾個例子進行step-by-step推理。雖然目前還沒有完全理解LM是否真的在推理,或者只是產生了一個更大的背景,增加了正確預測missing tokens的可能性。

鑑於目前的技術水平,推理可能是一個被濫用的說法,但這個術語已經在社區內廣泛使用了。在ALM的脈絡中,推理的一個更務實的定義是在得出prompt的答案之前給模型更多的計算步驟。

工具Tool

#對ALM來說,工具是外部模組,通常使用一個規則或一個特殊的token來調用,其輸出包含在ALM的上下文中。

工具可以用來收集外部信息,或對虛擬或物理世界產生影響(一般由ALM感知):比如說文件檢索器可以用來作為獲取外部信息的工具,或用機器臂對外在影響進行感知。

工具可以在訓練時或推理時被調用,更一般地說,模型需要學習與工具的互動,包括學習調用其API

行為Act

對ALM來說,呼叫一個對虛擬或物理世界有影響的工具並觀察其結果,通常是將其納入ALM的當前上下文。

這篇survey中介紹的一些工作討論了在網路中搜尋(seraching the web),或透過LMs進行機械手臂操縱。在略微濫用術語的情況下,有時會把ALM對一個工具的呼叫表示為一個行動(action),即使沒有對外在世界產生影響。

為什麼要同時討論推理和工具?

LM中推理和工具的結合應該允許在沒有啟發式的情況下解決廣泛的複雜任務,即具有更好的泛化能力。

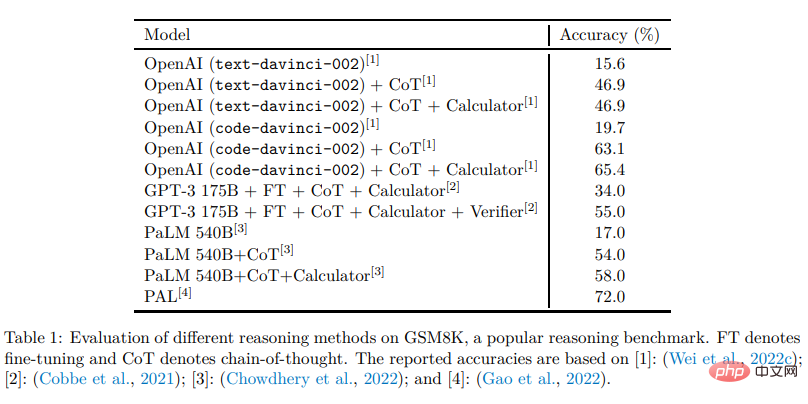

通常情況下,推理會促進LM將一個給定的問題分解成可能更簡單的子任務,而工具則有助於正確地完成每個步驟,例如從數學運算中獲得結果。

換句話說,推理是LM結合不同工具來解決複雜任務的一種方式,而工具則是避免推理失敗和有效分解的一種方式。

兩者都應該受益於對方,並且推理和工具可以放在同一個模組裡,因為二者都是透過增強LM的上下文來更好地預測missing tokens,儘管是以不同的方式。

為什麼要同時討論工具和行動?

收集額外資訊的工具和對虛擬或物理世界產生影響的工具可以被LM以同樣的方式呼叫。例如,輸出python程式碼解決數學運算的LM和輸出python程式碼操縱機械手臂的LM之間似乎沒有什麼區別。這篇綜述中討論的一些工作已經在使用對虛擬或物理世界產生影響的LM,在這種觀點下,我們可以說LM有行動的潛力,並期望在LM作為自主智能體的方向上取得重要進展。 分類方法

研究者將綜述中介紹的工作分解上述三個維度,並分別介紹,最後也討論了其他維度的相關工作。對讀者來說,應該記得,其中許多技術最初是在LM之外的背景下引入的,如果需要的話,盡可能查看提到的論文的介紹和相關工作。最後,儘管綜述專注於LLM,但並非所有的相關工作都採用了大模型,而是以LM的正確性為宗旨。

以上是ChatGPT之後何去何從? LeCun新作:全面綜述下一代「增強語言模式」的詳細內容。更多資訊請關注PHP中文網其他相關文章!