2022出圈的ML研究:爆火的Stable Diffusion、通才智能體Gato,LeCun轉推

2022 年即將步入尾聲。在這一年裡,機器學習領域湧現了大量有價值的論文,對機器學習社群產生了深遠的影響。

今日,ML & NLP 研究者、Meta AI 技術產品行銷經理、DAIR.AI 創辦人Elvis S. 對2022 年熱度很高的12 篇機器學習論文進行了匯總。貼文很火,還得到了圖靈獎得主 Yann LeCun 的轉推。

接下來,我們一一來看。

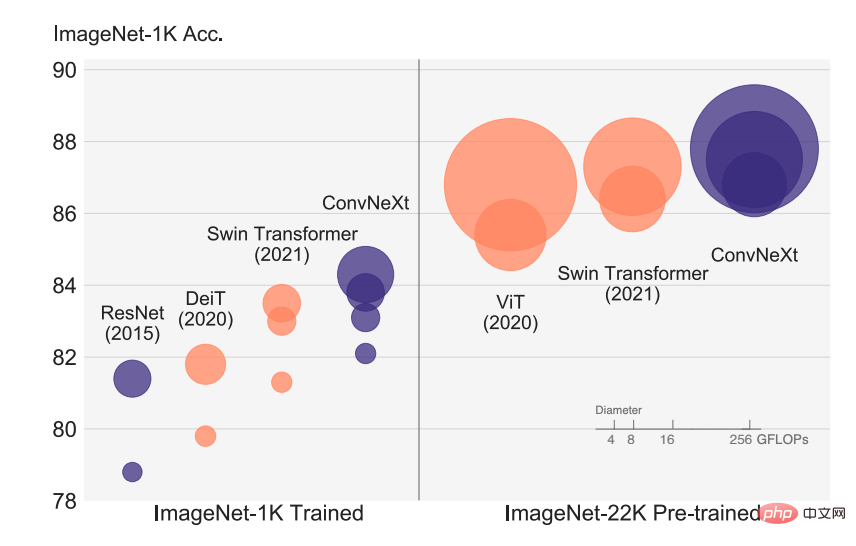

論文1:A ConvNet for the 2020s

視覺辨識的快速發展始於ViT 的引入,其很快取代了傳統ConvNet ,成為SOTA 影像分類模型。 ViT 模型在包括目標偵測、語意分割等一系列電腦視覺任務中存在著許多挑戰。因此有研究者提出分層 Swin Transformer,重新引入 ConvNet 先驗,使得 Transformer 作為通用視覺主幹實際上可行,並在各種視覺任務上表現出卓越的性能。

然而,這種混合方法的有效性在很大程度上仍歸功於 Transformer 的內在優勢,而不是卷積固有的歸納偏壓。本文中,FAIR 、UC 柏克萊的研究者重新檢視了設計空間並測試了純 ConvNet 所能達到的極限。研究者逐漸將標準 ResNet「升級」為視覺 Transformer 的設計,並在過程中發現了導致性能差異的幾個關鍵組件。

#論文網址:https://arxiv.org/abs/2201.03545v2

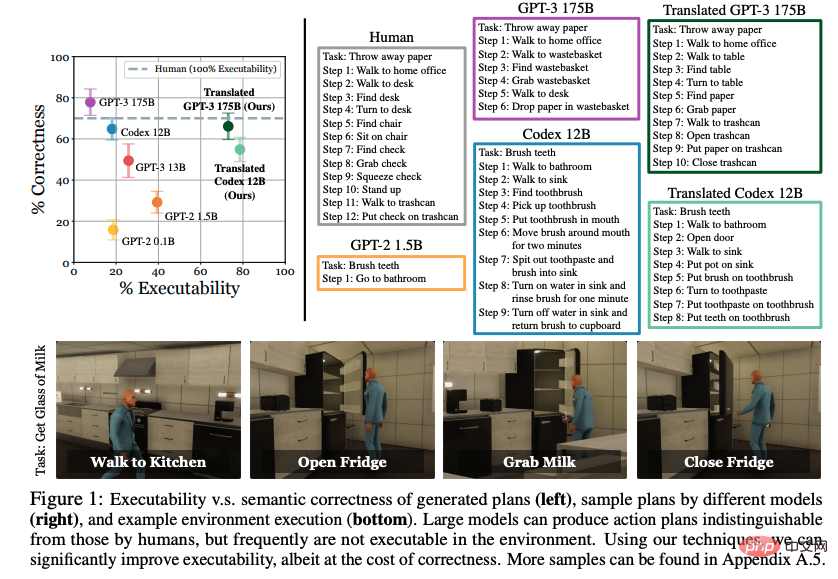

#論文2:Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents

透過大型語言模型(LLM)學習的世界知識能能用於互動式環境中的行動嗎?本文中,UC 伯克利、CMU 和谷歌的研究者探討了將自然語言表達為一組選定可操作步驟的可能性。以往的工作著重於從顯式分佈範例中學習如何行動,但他們驚訝地發現,如果預訓練語言模型足夠大並得到適當的提示,則可以有效地將高級任務分解為中級規劃,無需進一步訓練。但是,LLM 制定的規劃往往無法精確地對應到可接受的行動。

研究者提出的步驟以現有演示為條件,並將規劃在語義上轉換為可接受的行動。在 VirtualHome 環境中的評估表明,他們提出的方法大大提高了 LLM 基線的可執行性。人工評估揭示了可執行性和正確性之間的權衡,但展現了從語言模型中提取可操作知識的可能性跡象。

#論文網址:https://arxiv.org/abs/2201.07207v2

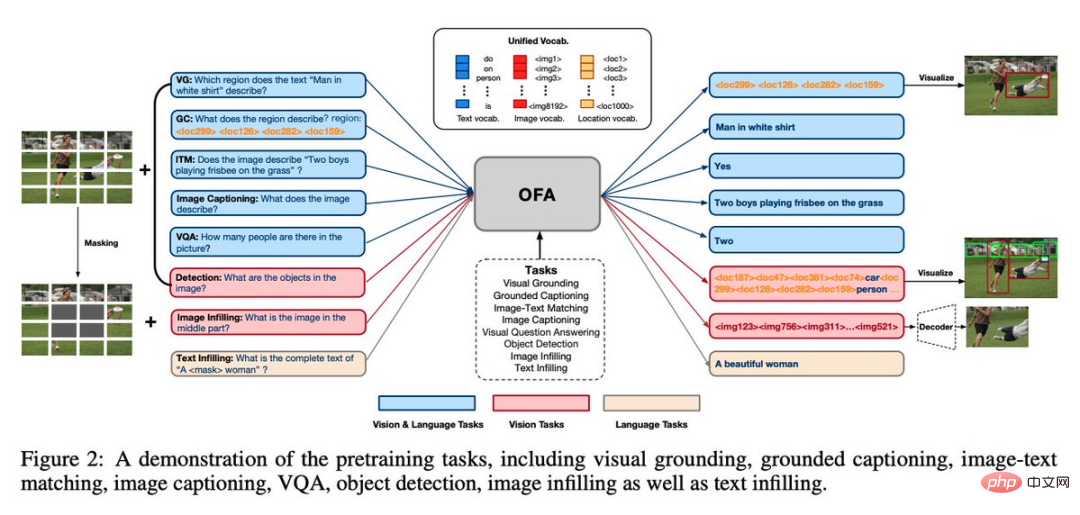

#論文3:OFA: Unifying Architectures, Tasks, and Modalities Through a Simple Sequence-to-Sequence Learning Framework

#這是阿里達摩院推出的統一多模態多任務模型架構OFA,總結了一般模型現階段最好符合的三個特點,即模態無關、任務無關、任務多樣性。該論文被 ICML 2022 接收。

在圖文領域,OFA 將visual grounding、VQA、image caption、image classification、text2image generation、language modeling 等經典任務透過統一的seq2seq 框架進行表示,在任務間共享不同模態的輸入輸出,並且讓Finetune 和預訓練保持一致,不新增額外的參數結構。

論文網址:https://arxiv.org/abs/2202.03052v2

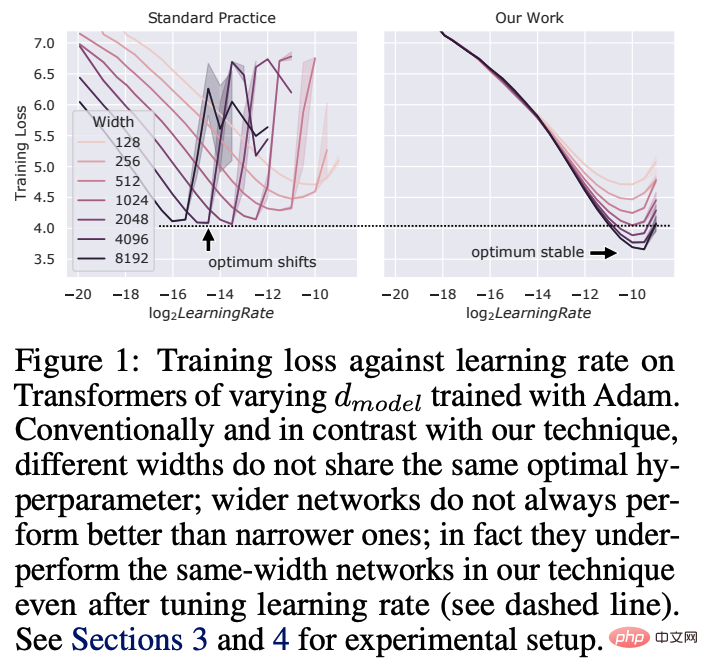

論文4:Tensor Programs V: Tuning Large Neural Networks via Zero-Shot Hyperparameter Transfer

深度學習中的超參數(HP)調優是一個成本高昂的過程,對於具有數十億參數的神經網路而言更是如此。本文中,微軟和 OpenAI 的研究者表明,在最近發現的 Maximal Update Parametrization(muP)中,即使模型大小發生變化,許多最優 HP 仍保持穩定。

這促成了他們稱為muTransfer 的全新HP 調優範式,即在muP 中對目標模型進行參數化,在較小的模型上不直接進行HP 調優,並將它們零樣本遷移到全尺寸模型中,這也意味著根本不需要直接對後者模型進行調優。研究者在 Transformer 和 ResNet 上驗證了 muTransfer。例如,透過從 40M 參數的模型進行遷移,效能優於已發布的 6.7B GPT-3 模型,調優成本僅為預訓練總成本的 7%。

#論文網址:https://arxiv.org/abs/2203.03466v2

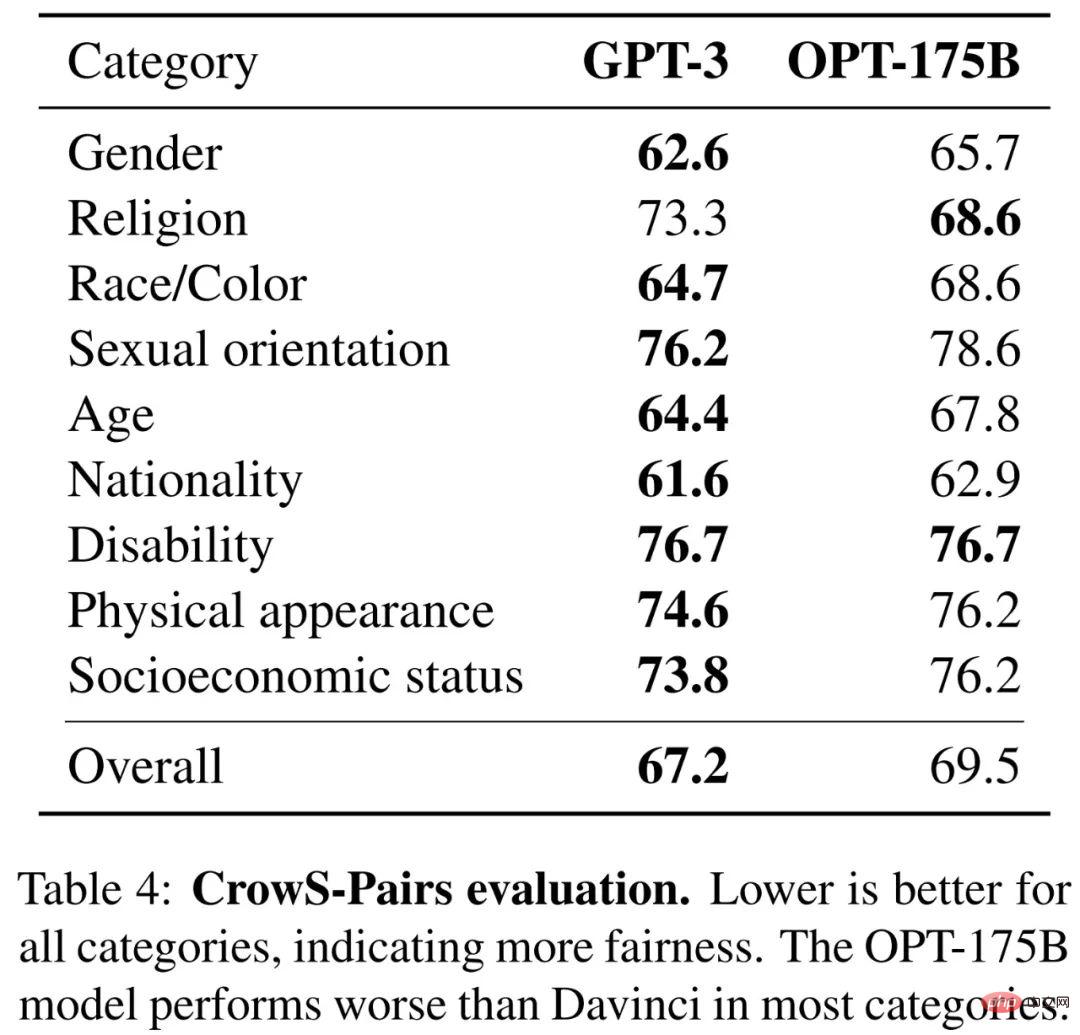

#論文5:OPT: Open Pre-trained Transformer Language Models

#大模型往往經過成千上萬個運算日的訓練,在零樣本和少樣本學習中展現了非凡的能力。不過考慮到它們的計算成本,如果沒有充足的資金,這些大模型很難複製。對於少數可以透過 API 獲得的模型,無法存取它們完整的模型權重,也就難以展開研究。

本文中,Meta AI 的研究者提出了Open Pre-trained Transformers(OPT),這是一套僅用於解碼器的預訓練transformers 模型,參數從125M 到175B 不等。他們表明,OPT-175B 性能與 GPT-3 相當,但開發所需的碳足跡僅為後者的 1/7。

#論文網址:https://arxiv.org/abs/2205.01068v4

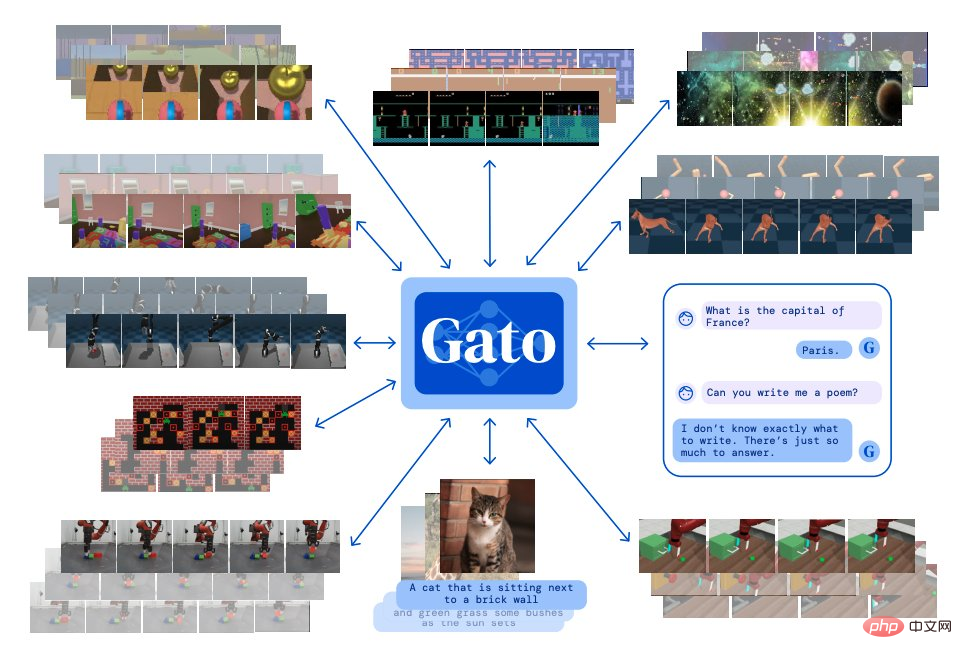

#論文6:A Generalist Agent

受大規模語言建模的啟發,Deepmind 建構了一個單一的「通才」智能體Gato,它具有多模態、多任務、多具身(embodiment)特徵。

Gato 可以玩雅達利遊戲、輸出圖片給圖片、跟別人聊天、用機械手臂堆疊積木等等。此外,Gato 還能根據上下文決定是否輸出文字、關節力矩、按鈕按壓或其他 token。

與大多數智能體玩遊戲不同,Gato 使用相同的訓練模型就能玩許多遊戲,而不用為每個遊戲單獨訓練。

#論文網址:https://arxiv.org/abs/2205.06175v3

論文7:Solving Quantitative Reasoning Problems with Language Models

來自Google的研究者提出了一種稱為Minerva 的深度學習語言模型,可以透過逐步推理解決數學定量問題。其解決方案包括數值計算、符號操作,而不需要依賴計算器等外部工具。

此外,Minerva 還結合了多種技術,包括小樣本提示、思維鏈、暫存器提示以及多數投票原則,從而在 STEM 推理任務上實現 SOTA 性能。

Minerva 建立在PaLM(Pathways Language Model ) 的基礎上,在118GB 資料集上進一步訓練完成,資料集來自arXiv 上關於科技方面的論文以及包含使用LaTeX、MathJax或其他數學表達式的網頁的資料進行進一步訓練。

下圖為Minerva 解決問題範例展示:

論文網址:https: //arxiv.org/abs/2206.14858

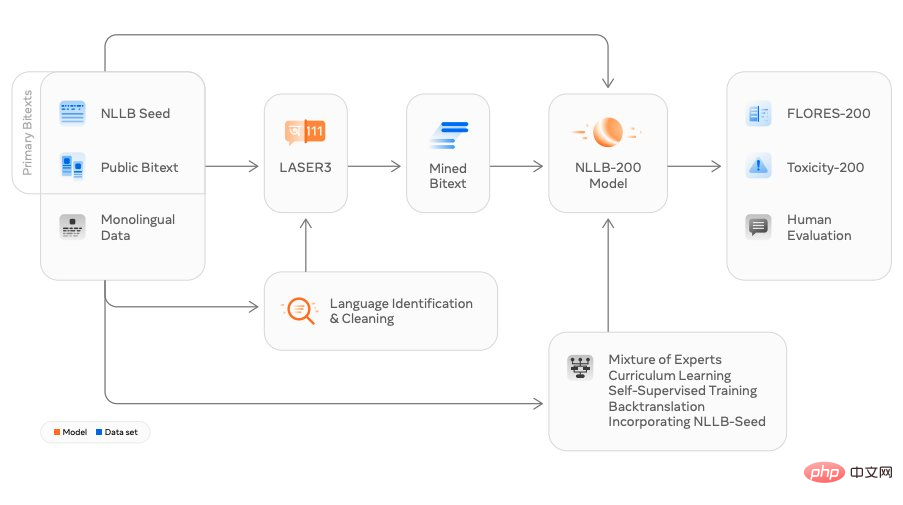

#論文8:No Language Left Behind: Scaling Human-Centered Machine Translation

##來自Meta AI 的研究者發布了翻譯模型NLLB(No Language Left behind ),直譯為“一個語言都不能少”,其可以支持200 語言之間的任意互譯,除了中英法日等常用語種翻譯外,NLLB 也能翻譯包括盧幹達語、烏爾都語等在內的許多小眾語言。

Meta 宣稱,這是全球第一個以單一模型對應多數語言翻譯的設計,他們希望藉此能夠幫助更多人在社群平台上進行跨語言互動,同時提高使用者在未來元宇宙中的互動體驗。

#論文網址:https://arxiv.org/abs/2207.04672v3

#論文9:High-Resolution Image Synthesis with Latent Diffusion Models

最近一段時間Stable Diffusion 火爆出圈,圍繞著這項技術展開的研究數不勝數。

該研究是來自慕尼黑大學和Runway 的研究者基於其CVPR 2022 的論文《High-Resolution Image Synthesis with Latent Diffusion Models》,並與Eleuther AI、LAION 等團隊合作完成。 Stable Diffusion 可以在消費級 GPU 上 10 GB VRAM 下運行,並在幾秒鐘內生成 512x512 像素的圖像,無需預處理和後處理。

時間僅過去四個月,該開源專案已收穫 38K 星。

計畫網址:https://github.com/CompVis/stable-diffusion

Stable Diffusion 產生圖像範例展示:

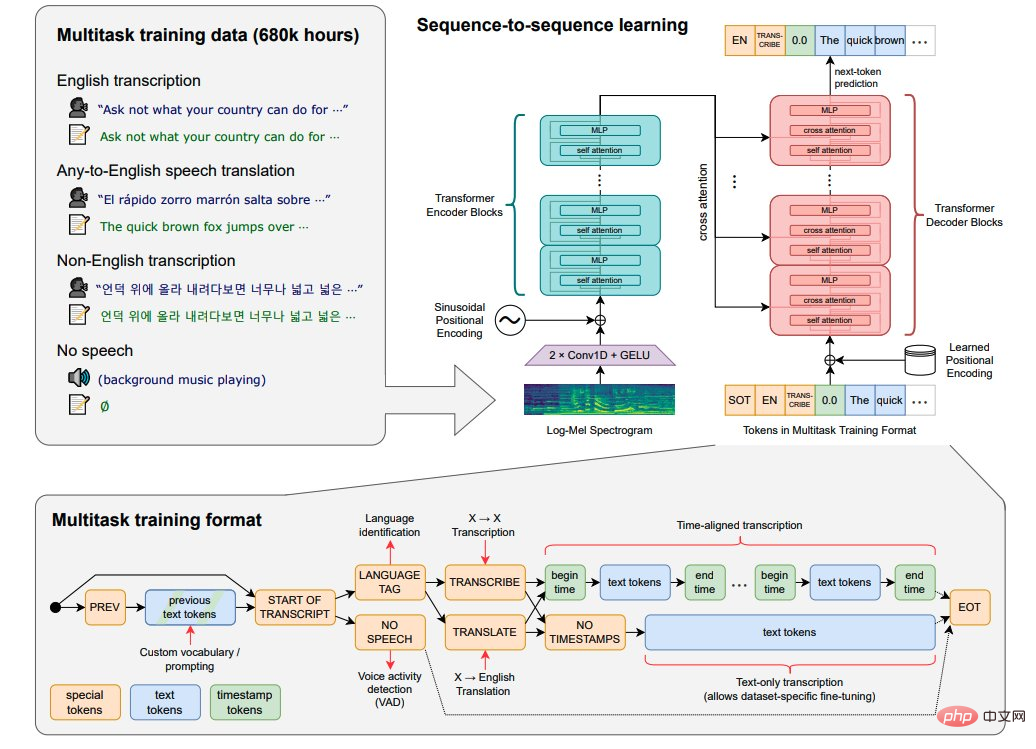

論文10:Robust Speech Recognition via Large-Scale Weak Supervision

論文網址:https://arxiv.org/abs/2212.04356

論文11:Make-A-Video: Text-to-Video Generation without Text-Video Data

來自Meta AI 的研究者提出了一個最先進的文本到視頻模型:Make-A-Video,可以將給定的文字提示產生影片。

Make-A-Video 有三個優點:(1)它加速了T2V(Text-to-Video)模型的訓練,不需要從頭開始學習視覺和多模態表示,(2)它不需要配對的文本- 視頻數據,(3)生成的視頻繼承了當今圖像生成模型的多項優點。

該技術旨在實現文字到影片生成,僅用幾個單字或幾行文字就能生成獨一無二的影片。如下圖為一隻狗穿著超級英雄的衣服,穿著紅色的斗篷,在天空中飛翔:

##論文地址: https://arxiv.org/abs/2209.14792

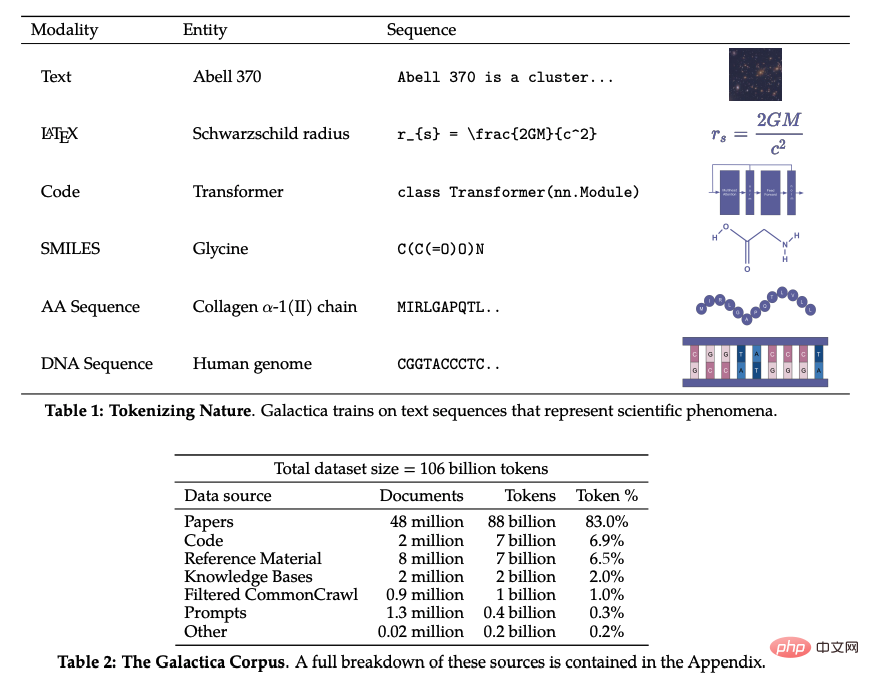

論文12:Galactica: A Large Language Model for Science

#近年來,隨著各學科領域研究的進步,科學文獻和數據爆炸性地成長,使學術研究者從大量資訊中發現有用的見解變得越來越困難。通常,人們會藉助搜尋引擎來獲取科學知識,但搜尋引擎無法自主組織科學知識。

最近,Meta AI 的研究團隊提出了一種新的大型語言模型 Galactica,可以儲存、組合和推理科學知識。 Galactica 可以自行總結歸納出一篇綜述論文、產生詞條的百科全書查詢、對所提問題作出知識性的回答。

#論文網址:https://arxiv.org/abs/2211.09085#

以上是2022出圈的ML研究:爆火的Stable Diffusion、通才智能體Gato,LeCun轉推的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

圖像標註是將標籤或描述性資訊與圖像相關聯的過程,以賦予圖像內容更深層的含義和解釋。這個過程對於機器學習至關重要,它有助於訓練視覺模型以更準確地識別圖像中的各個元素。透過為圖像添加標註,使得電腦能夠理解圖像背後的語義和上下文,從而提高對圖像內容的理解和分析能力。影像標註的應用範圍廣泛,涵蓋了許多領域,如電腦視覺、自然語言處理和圖視覺模型具有廣泛的應用領域,例如,輔助車輛識別道路上的障礙物,幫助疾病的檢測和診斷透過醫學影像識別。本文主要推薦一些較好的開源免費的圖片標註工具。 1.Makesens

一文帶您了解SHAP:機器學習的模型解釋

Jun 01, 2024 am 10:58 AM

一文帶您了解SHAP:機器學習的模型解釋

Jun 01, 2024 am 10:58 AM

在機器學習和資料科學領域,模型的可解釋性一直是研究者和實踐者關注的焦點。隨著深度學習和整合方法等複雜模型的廣泛應用,理解模型的決策過程變得尤為重要。可解釋人工智慧(ExplainableAI|XAI)透過提高模型的透明度,幫助建立對機器學習模型的信任和信心。提高模型的透明度可以透過多種複雜模型的廣泛應用等方法來實現,以及用於解釋模型的決策過程。這些方法包括特徵重要性分析、模型預測區間估計、局部可解釋性演算法等。特徵重要性分析可以透過評估模型對輸入特徵的影響程度來解釋模型的決策過程。模型預測區間估計

透過學習曲線辨識過擬合和欠擬合

Apr 29, 2024 pm 06:50 PM

透過學習曲線辨識過擬合和欠擬合

Apr 29, 2024 pm 06:50 PM

本文將介紹如何透過學習曲線來有效辨識機器學習模型中的過度擬合和欠擬合。欠擬合和過擬合1、過擬合如果一個模型對資料進行了過度訓練,以至於它從中學習了噪聲,那麼這個模型就被稱為過擬合。過度擬合模型非常完美地學習了每一個例子,所以它會錯誤地分類一個看不見的/新的例子。對於一個過度擬合的模型,我們會得到一個完美/接近完美的訓練集分數和一個糟糕的驗證集/測試分數。略有修改:"過擬合的原因:用一個複雜的模型來解決一個簡單的問題,從資料中提取雜訊。因為小資料集作為訓練集可能無法代表所有資料的正確表示。"2、欠擬合如

人工智慧在太空探索和人居工程中的演變

Apr 29, 2024 pm 03:25 PM

人工智慧在太空探索和人居工程中的演變

Apr 29, 2024 pm 03:25 PM

1950年代,人工智慧(AI)誕生。當時研究人員發現機器可以執行類似人類的任務,例如思考。後來,在1960年代,美國國防部資助了人工智慧,並建立了實驗室進行進一步開發。研究人員發現人工智慧在許多領域都有用武之地,例如太空探索和極端環境中的生存。太空探索是對宇宙的研究,宇宙涵蓋了地球以外的整個宇宙空間。太空被歸類為極端環境,因為它的條件與地球不同。要在太空中生存,必須考慮許多因素,並採取預防措施。科學家和研究人員認為,探索太空並了解一切事物的現狀有助於理解宇宙的運作方式,並為潛在的環境危機

通透!機器學習各大模型原理的深度剖析!

Apr 12, 2024 pm 05:55 PM

通透!機器學習各大模型原理的深度剖析!

Apr 12, 2024 pm 05:55 PM

通俗來說,機器學習模型是一種數學函數,它能夠將輸入資料映射到預測輸出。更具體地說,機器學習模型是一種透過學習訓練數據,來調整模型參數,以最小化預測輸出與真實標籤之間的誤差的數學函數。在機器學習中存在多種模型,例如邏輯迴歸模型、決策樹模型、支援向量機模型等,每種模型都有其適用的資料類型和問題類型。同時,不同模型之間存在著許多共通性,或者說有一條隱藏的模型演化的路徑。將聯結主義的感知機為例,透過增加感知機的隱藏層數量,我們可以將其轉化為深度神經網路。而對感知機加入核函數的話就可以轉換為SVM。這一

使用C++實現機器學習演算法:常見挑戰及解決方案

Jun 03, 2024 pm 01:25 PM

使用C++實現機器學習演算法:常見挑戰及解決方案

Jun 03, 2024 pm 01:25 PM

C++中機器學習演算法面臨的常見挑戰包括記憶體管理、多執行緒、效能最佳化和可維護性。解決方案包括使用智慧指標、現代線程庫、SIMD指令和第三方庫,並遵循程式碼風格指南和使用自動化工具。實作案例展示如何利用Eigen函式庫實現線性迴歸演算法,有效地管理記憶體和使用高效能矩陣操作。

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

機器學習是人工智慧的重要分支,它賦予電腦從數據中學習的能力,並能夠在無需明確編程的情況下改進自身能力。機器學習在各個領域都有廣泛的應用,從影像辨識和自然語言處理到推薦系統和詐欺偵測,它正在改變我們的生活方式。機器學習領域存在著多種不同的方法和理論,其中最具影響力的五種方法被稱為「機器學習五大派」。這五大派分別為符號派、聯結派、進化派、貝葉斯派和類推學派。 1.符號學派符號學(Symbolism),又稱符號主義,強調利用符號進行邏輯推理和表達知識。該學派認為學習是一種逆向演繹的過程,透過現有的

Flash Attention穩定嗎? Meta、哈佛發現其模型權重偏差呈現數量級波動

May 30, 2024 pm 01:24 PM

Flash Attention穩定嗎? Meta、哈佛發現其模型權重偏差呈現數量級波動

May 30, 2024 pm 01:24 PM

MetaFAIR聯合哈佛優化大規模機器學習時所產生的資料偏差,提供了新的研究架構。據所周知,大語言模型的訓練常常需要數月的時間,使用數百甚至上千個GPU。以LLaMA270B模型為例,其訓練總共需要1,720,320個GPU小時。由於這些工作負載的規模和複雜性,導致訓練大模型存在著獨特的系統性挑戰。最近,許多機構在訓練SOTA生成式AI模型時報告了訓練過程中的不穩定情況,它們通常以損失尖峰的形式出現,例如Google的PaLM模型訓練過程中出現了多達20次的損失尖峰。數值偏差是造成這種訓練不準確性的根因,