近年來自然語言處理的進展很大程度上都來自於大規模語言模型,每次發布的新模型都將參數量、訓練資料量推向新高,同時也會對現有基準排行進行一次屠榜!

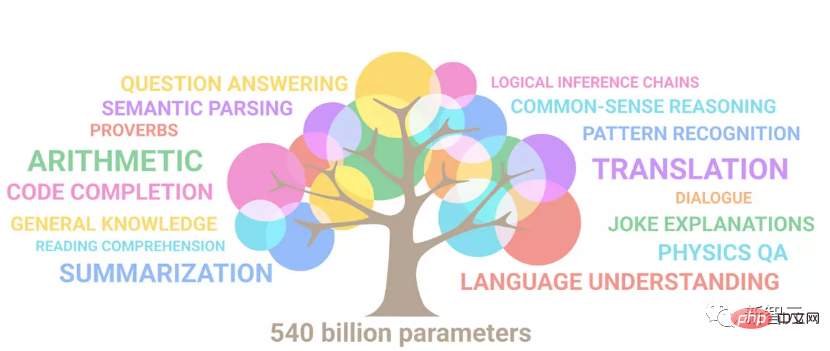

例如今年4月,Google發布5400億參數的語言模型PaLM(Pathways Language Model)在語言和推理類別的一系列評估中成功超越人類,尤其是在few-shot小樣本學習場景下的優異性能,也讓PaLM被認為是下一代語言模型的發展方向。

同理,視覺語言模型其實也是大力出奇蹟 ,可以透過提升模型的規模來提升效能。

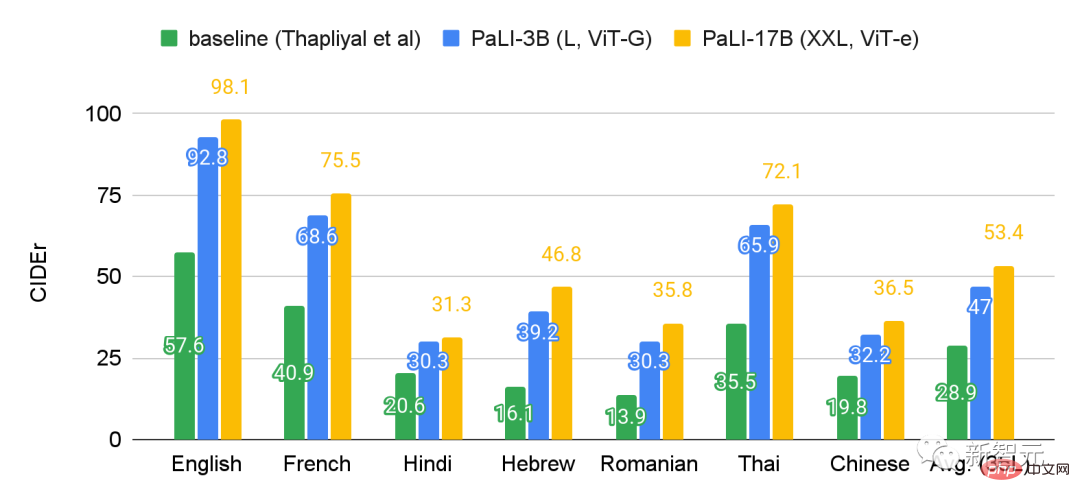

當然了,如果只是多任務的視覺語言模型,顯然還不是很通用,還得支援多種語言的輸入輸出才行。

最近Google就將PaLM擴展升級成PALI(Pathways Language and Image model),兼具多語言和圖像理解的能力,同時支援100 種語言來執行各種橫跨視覺、語言和多模態影像和語言應用,如視覺問題回答、影像說明(image caption)、物件偵測、影像分類、OCR、文本推理等。

論文連結:https://arxiv.org/abs/2209.06794

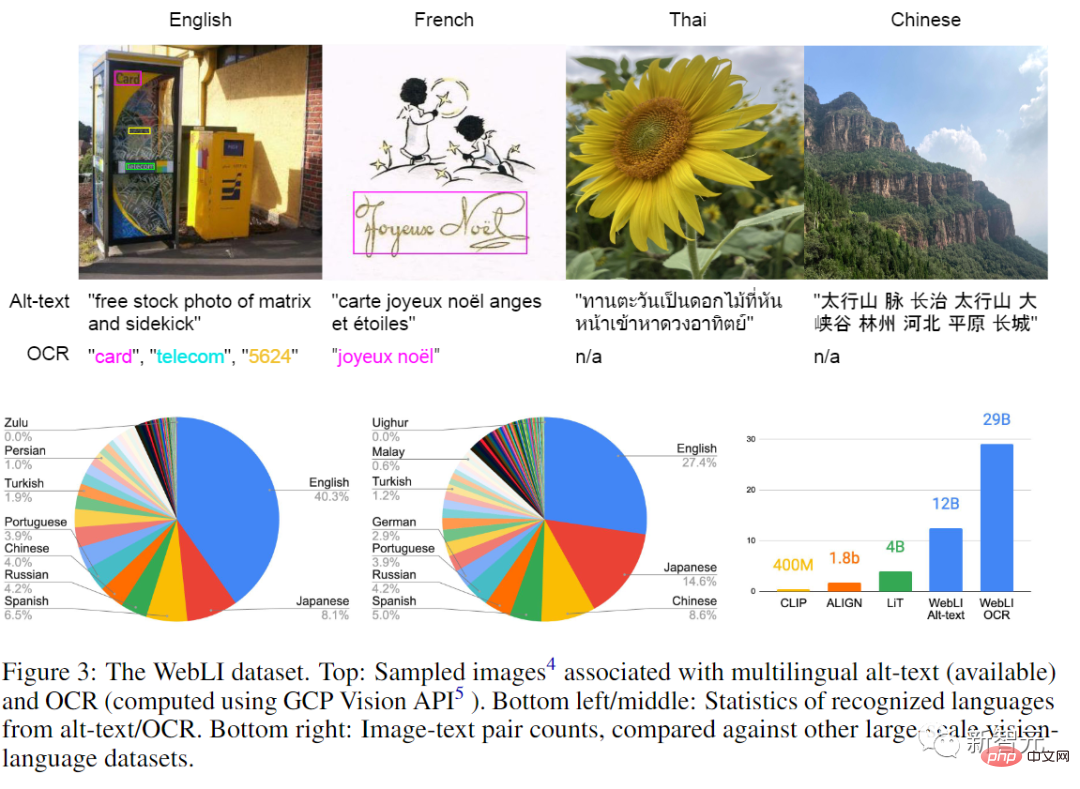

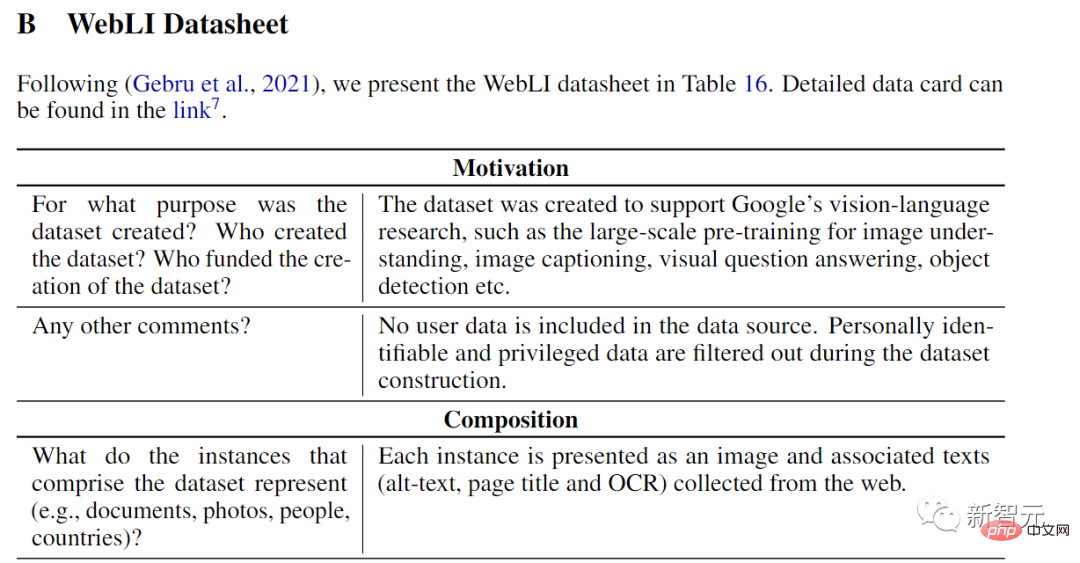

#模型的訓練使用的是一個公開的圖像集合,其中包括自動爬取的109種語言的標註,文中也稱之為WebLI資料集。

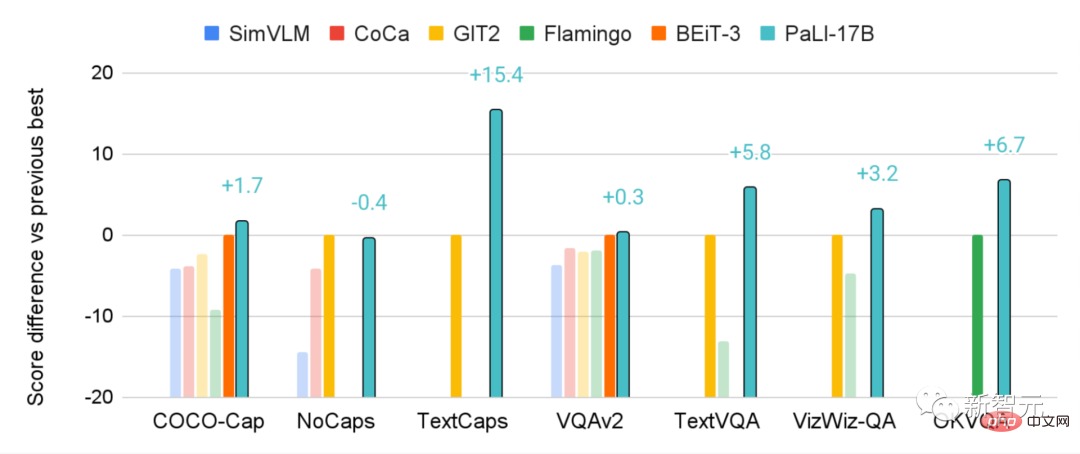

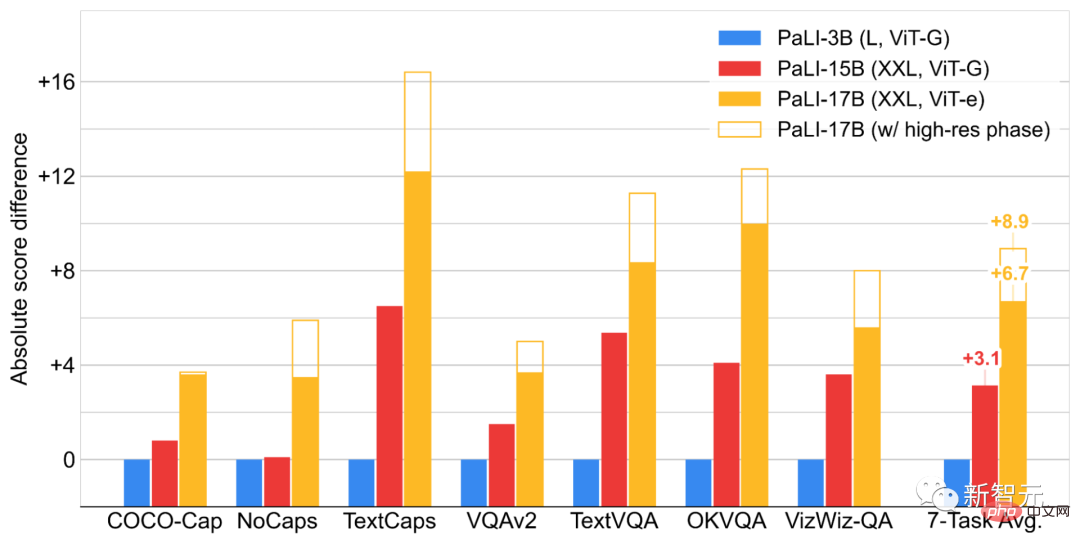

在WebLI上預先訓練的PaLI模型在多個影像和語言基準上取得了最先進的效能,如COCO-Captions、TextCaps、VQAv2、OK-VQA、TextVQA等等,也超越了先前模型的多語言視覺描述(multilingual visual captioning)和視覺問答的基準。

PALI的目標之一是研究語言和視覺模型在效能和規模上的聯繫是否相同,特別是語言-圖像模型的可擴展性(scalability)。

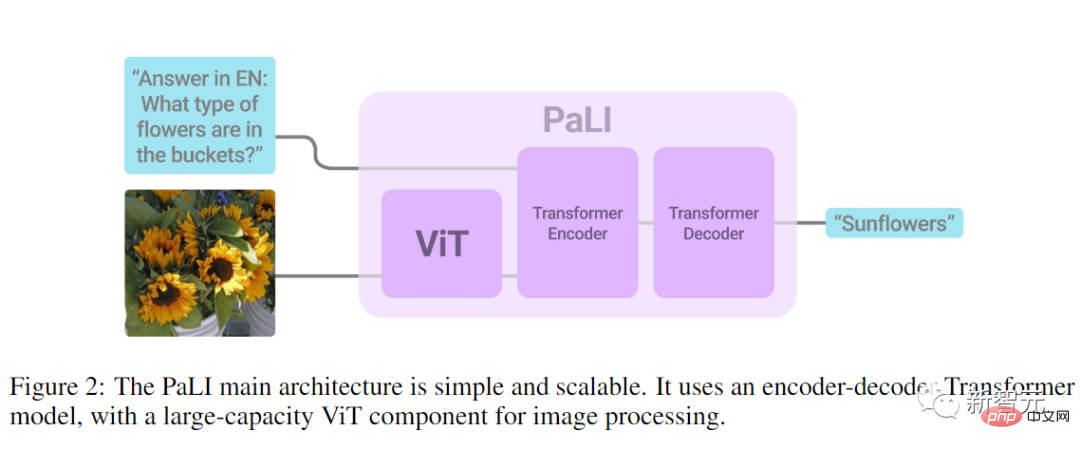

所以模型的架構設計上就很簡單,主要是為了實驗方便,尤其是可重複使用且可擴充。

模型由一個處理輸入文字的Transformer編碼器和一個產生輸出文字的自回歸Transformer解碼器組成。

在處理影像時,Transformer編碼器的輸入還包括代表由ViT處理的影像的視覺字詞(visual words)。

PaLI模型的一個關鍵設計是重用,研究人員用先前訓練過的單模態視覺和語言模型(如mT5-XXL和大型ViTs)的權重作為模型的種子,這種重用不僅使單模態訓練的能力遷移,還能節省計算成本。

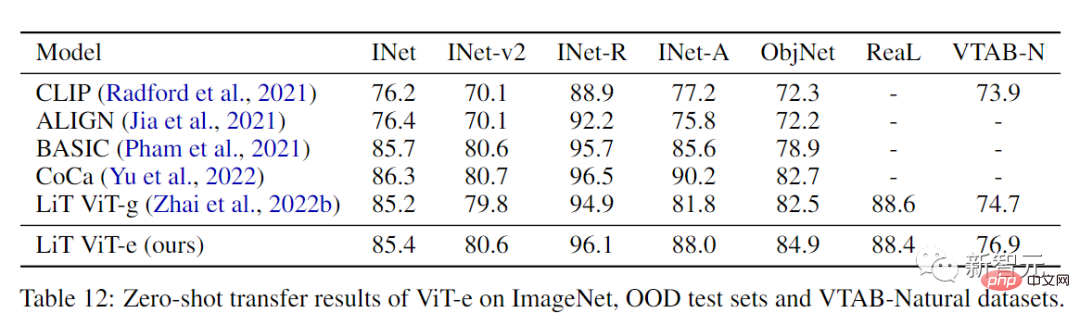

模型的視覺組件使用的是迄今為止最大的ViT架構ViT-e,它與18億參數的ViT-G模型具有相同的結構,並使用相同的訓練參數,差異就是擴充為了40億參數。

雖然在視覺領域和語言領域都對縮放規律進行了研究,但在視覺和語言的組合模型中對縮放行為的探討較少,擴大視覺骨幹模型的規模可能會導致在分類任務中的收益飽和。

研究人員也進一步證實了這一點,可以觀察到 ViT-e在ImageNet上只比ViT-G好一點,但ViT-e在PaLI的視覺語言任務上有很大的改進。例如,ViT-e在COCO字幕任務上比ViT-G多出近3個CIDEr點。任務上比ViT-G多出3分。這也暗示了未來在視覺語言任務中使用更大的ViT骨架模型的空間。

研究人員採用mT5骨幹作為語言建模元件,使用預訓練的mT5-Large(10億參數)和mT5-XXL (130億參數)來初始化PaLI的語言編碼器-解碼器,然後在許多語言任務中進行繼續混合訓練,包括純語言理解任務,這也有助於避免災難性的遺忘mT5的語言理解和生成能力。

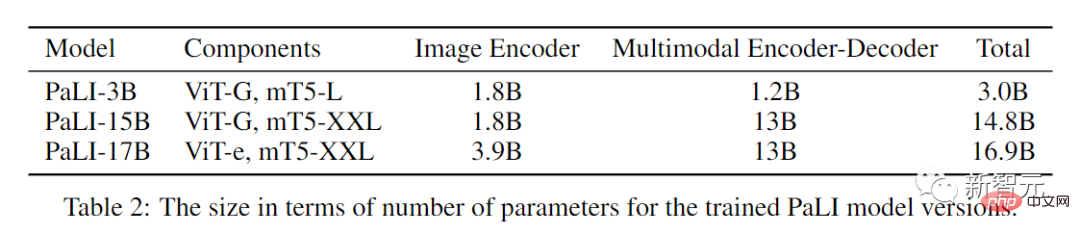

最後得到了三個不同尺寸的PALI模型。

#深度學習相關的擴展研究表明,模型越大,所需的訓練數據集也越大。

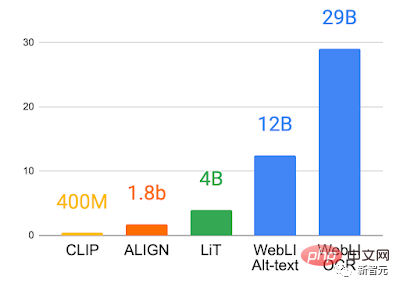

所以為了全面研究和釋放語言-圖像預訓練模型的潛力,研究人員從互聯網上爬取了大量的圖像和文本數據,構建了一個全新的數據集WebLI ,其中包括109種語言的120億alt-texts和100億張圖片。

除了以網路文字標註外,研究人員也應用雲端視覺API對影像進行OCR識別,進而得到290億個影像-OCR的數據對。

使用near-duplication對68個常見的視覺和視覺語言資料集的訓練、驗證和測試部分的圖像進行了去重處理,以避免下游評估任務的資料外洩。

為了進一步提高資料質量,研究人員也會根據「影像和alt-text」的跨模態相似度進行評分,並調整閾值,最後只保留10%的圖像,總共有10億張圖像用於訓練PaLI

由於視覺-語言任務是多模態,所以需要模型具有多種語意處理能力,而且會有不同的目標。例如有些任務需要對物體進行局部定位以準確解決任務,而其他一些任務可能需要更多的全域語意資訊。

同樣地,有的語言任務可能需要長的答案,而有些則需要緊湊的答案。

為了解決所有這些不一致的目標,研究人員利用WebLI預訓練資料的豐富性,引入預訓練任務的混合(Pretraining Task Mixture),為各種下游應用準備模型。

為了讓模型更通用以解決多種任務,作者將所有的任務歸入單一的通用API(輸入:圖像文字;輸出:文字),使多個圖像和語言任務之間能夠進行知識共享,這也是與預訓練設定的共享。

用於預訓練的目標作為加權的混合被投影到同一個API中,目的是既保持重複使用的模型組件的能力,又能訓練模型執行新的任務。

模型使用開源的T5X和Flaxformer框架在JAX中用Flax進行訓練,視覺部分的ViT-e使用開源的BigVision框架,將語言部分的詞向量與視覺部分生成的patch向量級聯起來,共同作為多模態編碼器-解碼器的輸入,編碼器使用mT5-XXL預訓練初始化。在PaLI的訓練過程中,視覺組件的權重被凍結,只更新多模態編碼器-解碼器的權重。

在實驗部分,研究人員在常見的視覺語言基準上對PaLI進行了比較,且PaLI模型在這些任務上取得了最先進的結果,甚至超過了以往文獻中提出的超大型的模型。

例如170億參數的PALI在某些VQA和圖像標題任務上的表現優於800億參數的Flamingo模型。

並且PALI在單語言或單一視覺的任務上也保持了良好的表現,雖然這並非是PALI主要的訓練目標。

文中也研究了圖像和語言模型組件在模型擴展方面是如何相互作用的,以及模型在哪裡產生最大的收益。

最後得出的結論是,對這兩個組件進行聯合擴展(縮放)會產生最好的性能,具體來說,對需要相對較少參數的視覺組件進行縮放是最關鍵的,同時縮放對於提高多語言任務的效能也很重要。

在35種語言的基準Crossmodal-3600上評估了PaLI後可以發現多語言起標題任務從PaLI模型的擴展中受益更多。

為了避免在大型語言和圖像模型中產生或加強不公平的偏見,需要對所使用的數據和模型如何使用這些數據保持透明,以及測試模型的公平性並進行負責任的資料分析,所以文中同時提供了一個Data Card和Model Card

以上是順手訓了一個史上超大ViT? Google升級視覺語言模型PaLI:支援100+種語言的詳細內容。更多資訊請關注PHP中文網其他相關文章!