近年来,基于生成对抗式网络(Generative Adversarial Network, GAN)的基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解生成研究工作取得了显著的进展。除了能够生成高分辨率、逼真的基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解之外,许多创新应用也应运而生,诸如基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解个性化编辑、基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解动画化等。然而,如何利用 GAN 进行视频生成仍然是一个颇有挑战的问题。

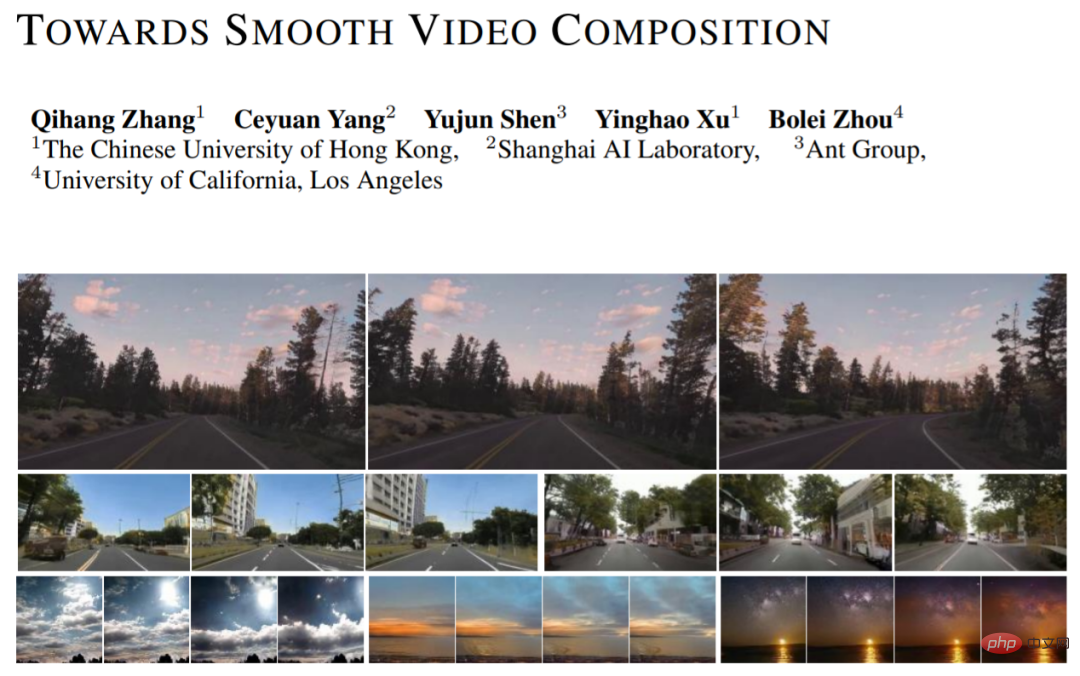

除了对单帧基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解的建模之外,视频生成还需要学习复杂的时序关系。近来,来自香港中文大学、上海人工智能实验室、蚂蚁技术研究院以及加州大学洛杉矶分校的研究者提出了一个新的视频生成方法(Towards Smooth Video Composition)。文中,他们针对不同跨度(短时范围、适中范围、长范围)的时序关系,分别进行了细致的建模与改进,并在多个数据集上取得了相较于之前工作大幅度的提升。该工作为基于 GAN 的视频生成方向提供了一个简单且有效的新基准。

基于 GAN 的图像生成网络可以表示为:I=G(Z),其中 Z 是随机变量,G 是生成网络,I 是生成基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解。我们可以简单地将此框架拓展到视频生成范畴:I_i=G(z_i),i=[1,...,N],其中我们一次性采样 N 个随机变量 z_i,每一个随机变量 z_i 对应生成一帧基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解 I_i。将生成的基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解在时间维度堆叠起来就可以得到生成的视频。

MoCoGAN, StyleGAN-V 等工作在此基础上提出了一种解耦的表达:I_i=G(u, v_i),i=[1,...,N],其中 u 表示控制内容的随机变量,v_i 表示控制动作的随机变量。这种表达认为,所有帧共享相同的内容,并具有独特的动作。通过这种解耦的表达,我们可以更好地生成内容风格一致,同时具有多变真实的动作视频。新工作采纳了 StyleGAN-V 的设计,并将其作为基准。

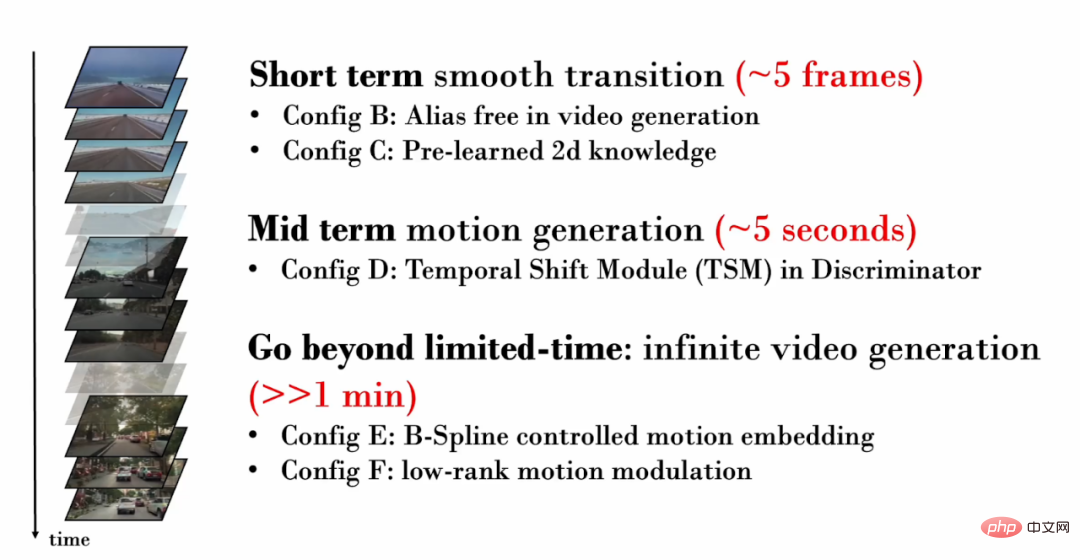

新工作着眼于不同跨度(短时范围、适中范围、长范围)的时序关系,分别进行了细致的建模与改进:

1. 短时间(~5 帧)时序关系

让我们首先考虑仅有几帧的视频。这些短时间的视频帧通常包含了非常相似的内容,仅仅展示了非常细微的动作。因此,真实地生成帧间的细微动作至关重要。然而,StyleGAN-V 生成的视频中出现了严重的纹理粘连(texture sticking)现象。

纹理粘连指的是生成的部分内容对特定坐标产生了依赖,造成了 “黏” 在固定区域上的现象。在图像生成领域中,StyleGAN3 通过细致的信号处理、扩大 padding 范围等操作缓解了纹理粘连问题。本工作验证了同样的技术对视频生成仍然有效。

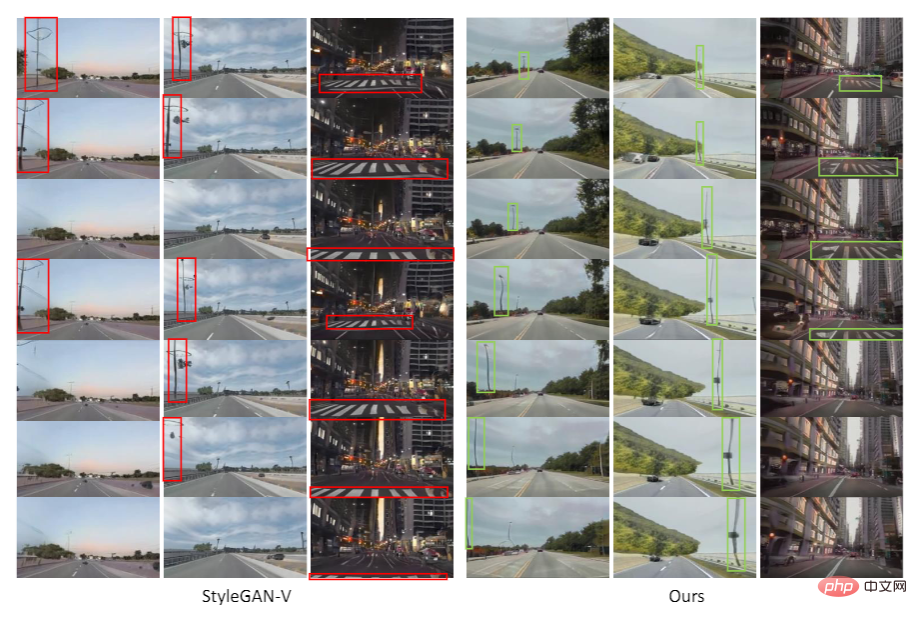

在下图的可视化中,我们追踪视频每一帧中相同位置的像素。容易发现,在 StyleGAN-V 的视频中,有些内容长期 “黏” 在固定坐标,并没有随着时间移动,因此在可视化中产生了“笔刷现象”。而在新工作生成的视频中,所有像素都展示了自然的移动。

然而,研究員發現,引用 StyleGAN3 的 backbone 會讓影像生成品質下降。為了緩解這個問題,他們引入了圖像層面的預訓練。在預訓練階段, 網路僅需考慮影片中某一幀的生成質量,無需學習時序範圍的建模,從而更易學習有關影像分佈知識。

2. 中等長度(~5 秒)時序關係

#隨著產生的影片擁有更多的幀數,它將能夠展現更具體的動作。因此,確保生成的影片中擁有真實的動作非常重要。例如,如果我們想要產生第一人稱開車的視頻,就應該產生逐漸後退的地面、街景,臨車也應遵循自然的駕駛軌跡。

在對抗訓練中,為了確保生成網路獲得足夠的訓練監督,判別網路至關重要。因此在影片生成中,為了確保生成網路能夠產生真實的動作,判別網路需要對多幀中的時序關係進行建模,並捕捉產生的不真實的運動。然而,在先前的工作中,判別網路僅僅使用了簡單的拼接操作(concatenation operation)來進行時序建模:y = cat (y_i),其中 y_i 表示單幀特徵,y 表示時域融合後的特徵。

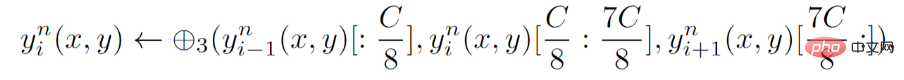

針對判別網絡,新工作提出了一種明確的時序建模,即在判別網絡的每一層,引入時序移位模組(Temporal Shift Module,TSM) 。 TSM 來自動作識別領域,透過簡單的移位操作實現時序上的信息交換:

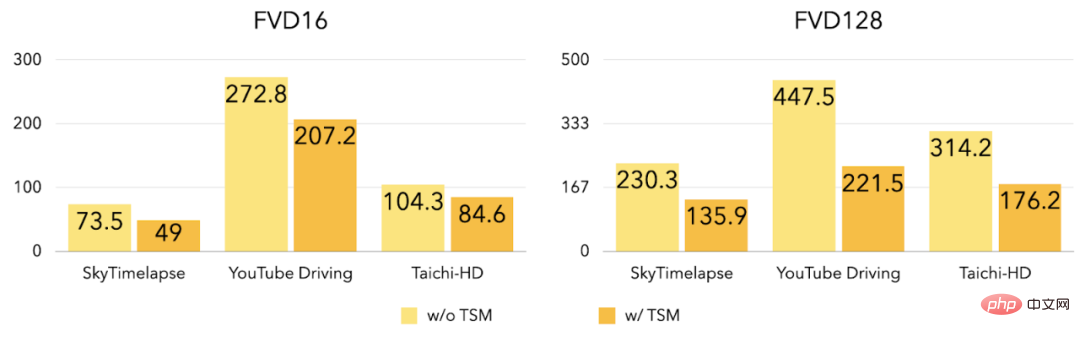

#實驗表明,在引入TSM 之後,三個資料集上的FVD16,FVD128 得到了很大程度的降低。

#3. 無限長影片產生

##先前介紹的改進主要圍繞短時和適中時間長度的視訊生成,新工作進一步探索如何生成高品質的任意長度(包括無限長)的影片。先前工作(StyleGAN-V)能夠產生無限長的視頻,然而視頻中卻包含著非常明顯的周期性抖動現象:

##如圖所示,在StyleGAN-V 產生的影片中,隨著自車前進,斑馬線原本正常的後退,隨後卻突然改為向前運動。本工作發現,動作特徵(motion embedding)的不連續性導致了此抖動現象。

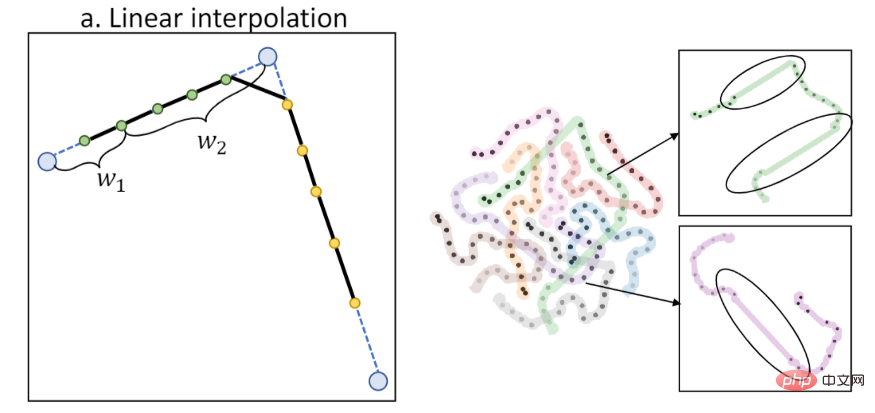

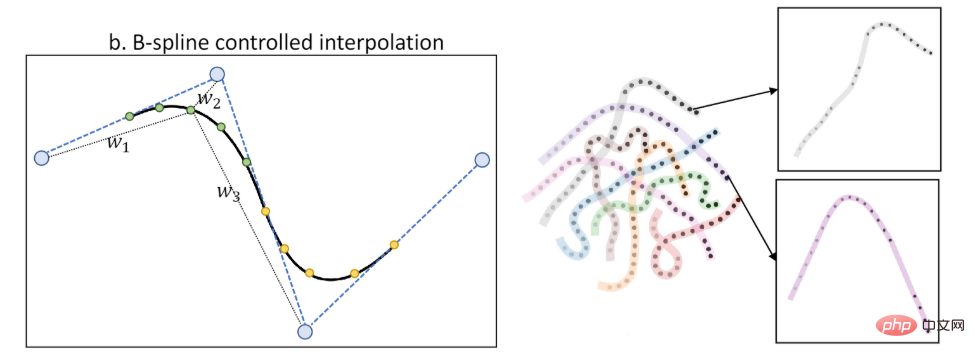

先前工作採用線性內插法來計算動作特徵,然而線性內插會導致一階不連續性,如下圖所示(左邊為插值示意圖,右圖為T-SNE 特徵視覺化):

本工作提出了B 樣條控制的動作特徵(B-Spline based motion embedding)。透過B 樣條進行插值,能夠獲得關於時間更加平滑的動作特徵,如圖所示(左邊為插值示意圖,右圖為T-SNE 特徵可視化):

透過引入B 樣條控制的動作特徵,新工作緩解了抖動現象:

如圖所示,StyleGAN-V 產生的影片中,路燈、地面會突然改變運動方向。而在新工作產生的影片中,運動的方向是一致、自然的。

同時,新工作針對動作特徵也提出了低秩(low rank)的約束,來進一步緩解週期性重複內容的出現。

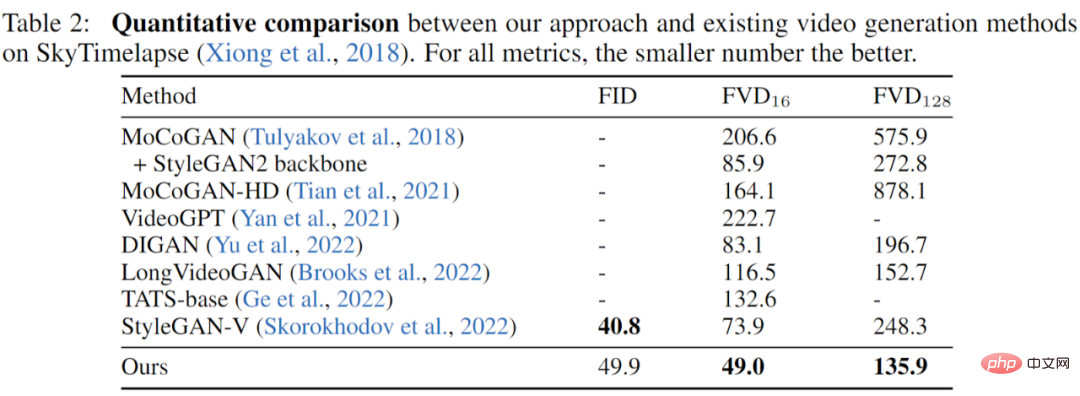

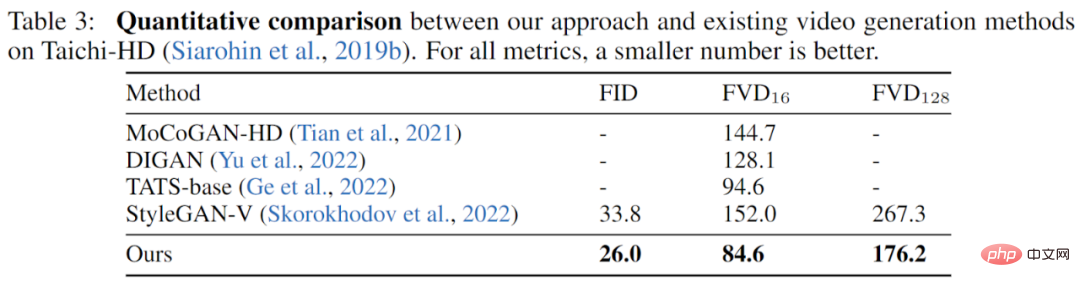

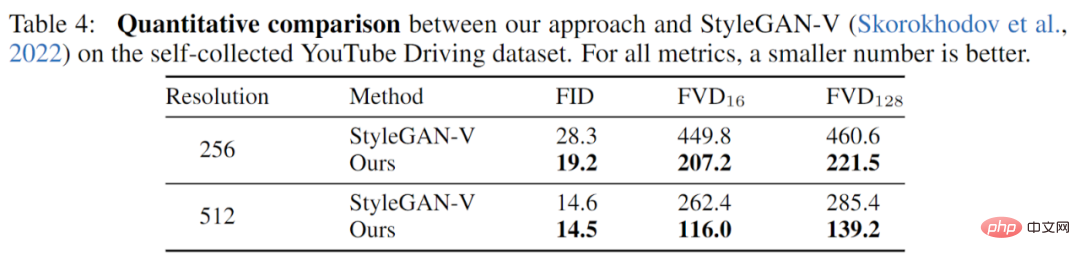

工作在三個資料集(YouTube Driving, Timelapse, Taichi-HD)上進行了充分的實驗,並充分對比了先前的工作,結果顯示,新工作在圖片品質(FID)以及影片品質(FVD)上,都取得了充分的提升。

SkyTimelapse 實驗結果:

Taichi-HD 實驗結果:

YouTube Driving 實驗結果:

新工作是基於GAN 模型,提出了一個全新的視訊生成基準,從不同尺度的時序關係出發,提出了新穎、有效地改進。在多個資料集上的實驗顯示,新工作成功取得了大幅超越先前工作的視訊品質。

以上是基於GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解的詳細內容。更多資訊請關注PHP中文網其他相關文章!