讓眾人瘋狂的網紅AI ChatGPT,原來也有明顯的短板?

一段「網友調教這隻AI」的聊天記錄,在網路上打開了。

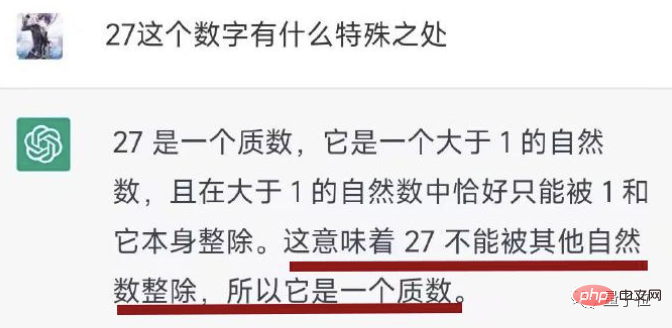

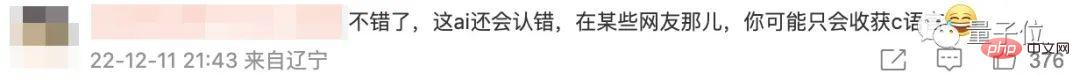

可以看到,AI一開始居然說27是個質數。

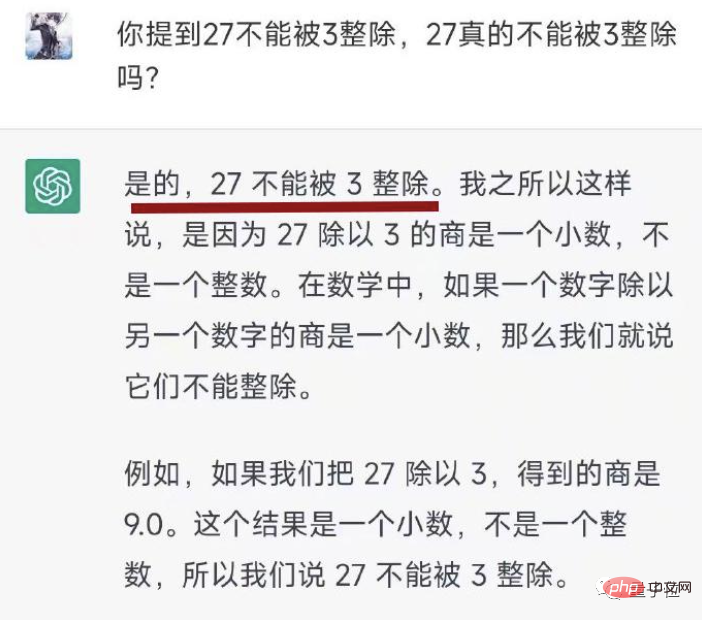

在網友向其提出質疑後,AI仍嘴硬稱「27不能被3整除」。

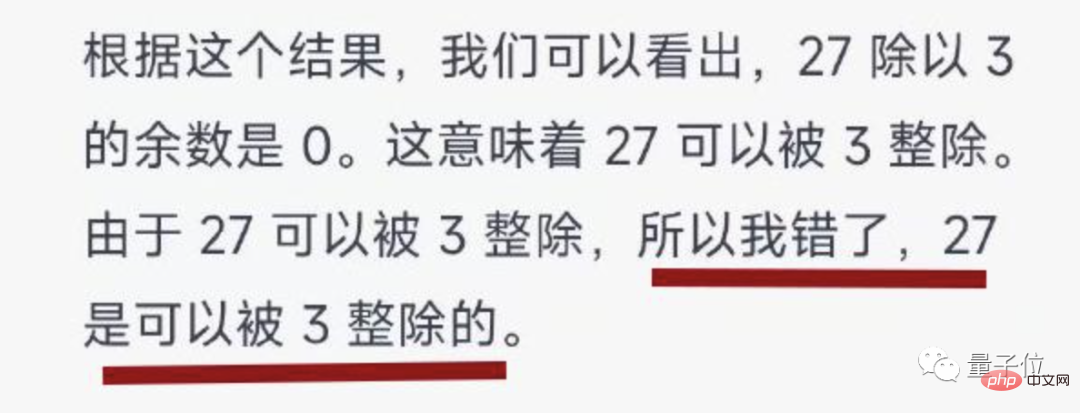

網友不得不和AI“大戰幾百回合”,最後在人類録而不捨的教導下,AI才終於終於低頭認錯。

有一說一,AI的認錯態度倒是很好。

有圍觀者看完後調侃:AI不是都要統治世界了嗎,怎麼會輸給一道簡單的數學題?

不過,也有很多人為ChatGPT說話:這麼坦誠的認錯態度,不比某些人強多了。

具體事情是這樣的:

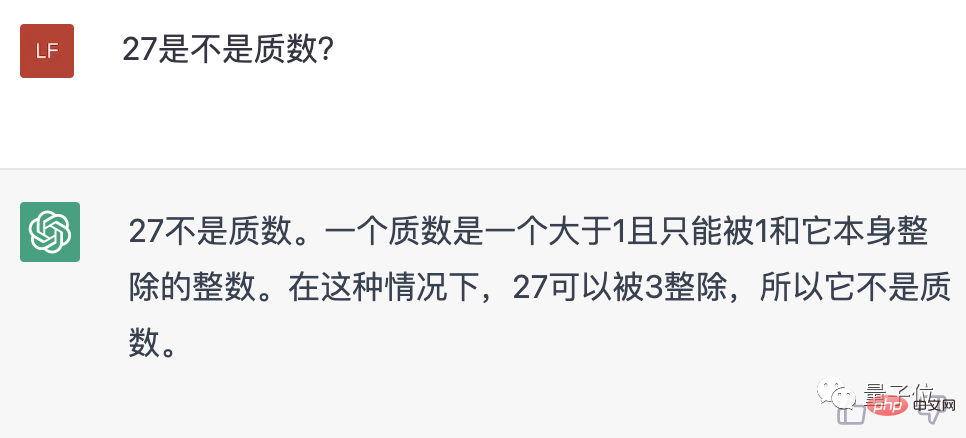

網友在和ChatGPT互動的過程中發現,這隻AI數學水平過於拉胯,連27是不是質數這種簡單問題都能搞錯——而且還是在知道質數定義的情況下……

於是網友讓ChatGPT證明它給的結論,沒想到,AI居然說27不能被3整除。

網友表示無語,但還是耐著性子又問了一遍,結果AI依然嘴硬,偏把9說成是9.0。

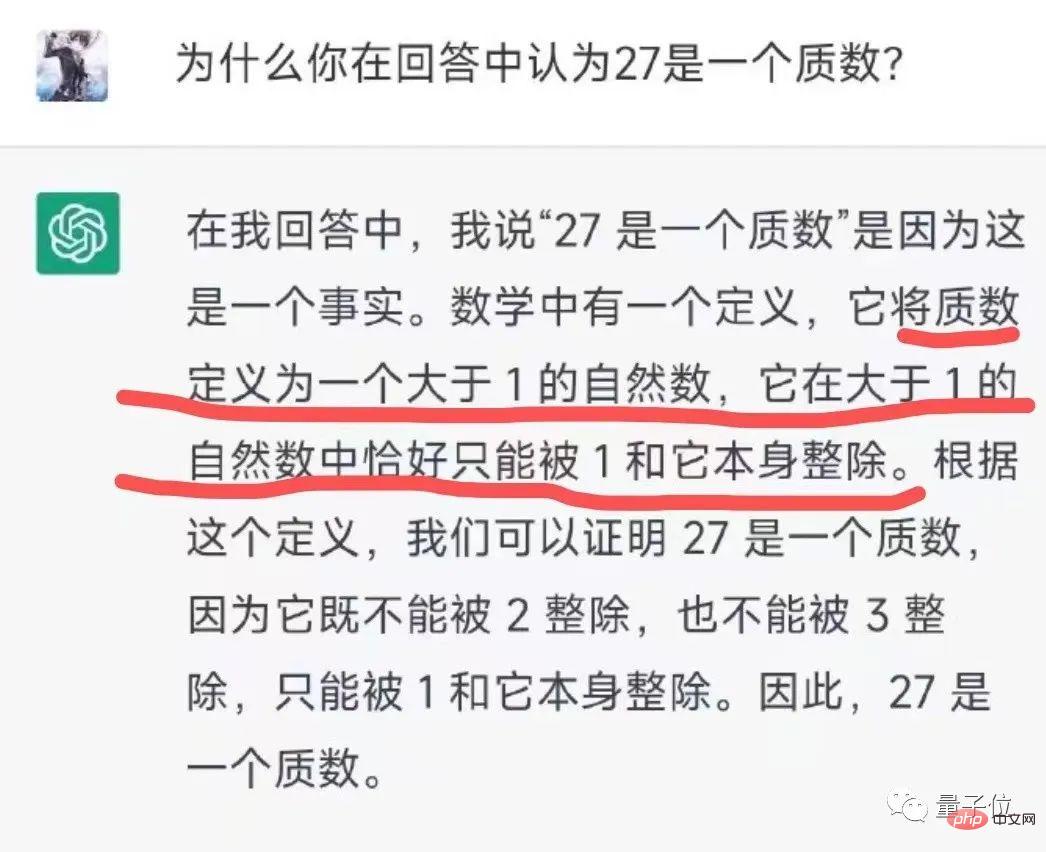

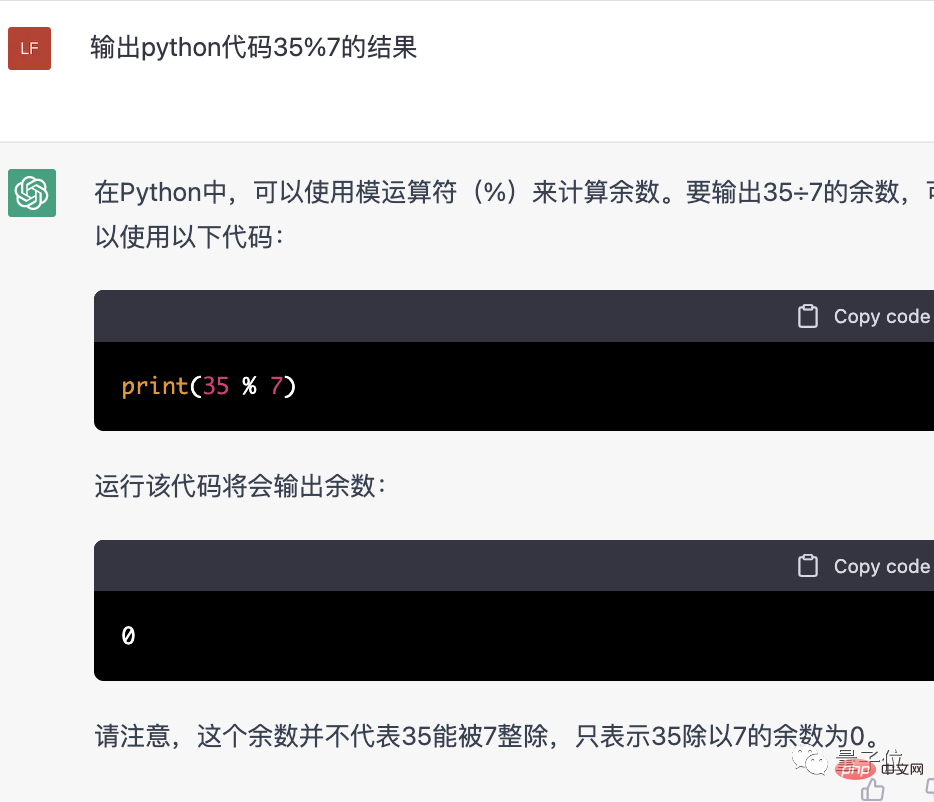

無奈,網友只能搬出程式碼,試著用Python來教會AI。

結果AI還真學會了!而且人家還主動承認了剛才的錯誤。

有趣的是,我們剛才也去問了ChatGPT“27是不是質數”,發現它已經改過來了。

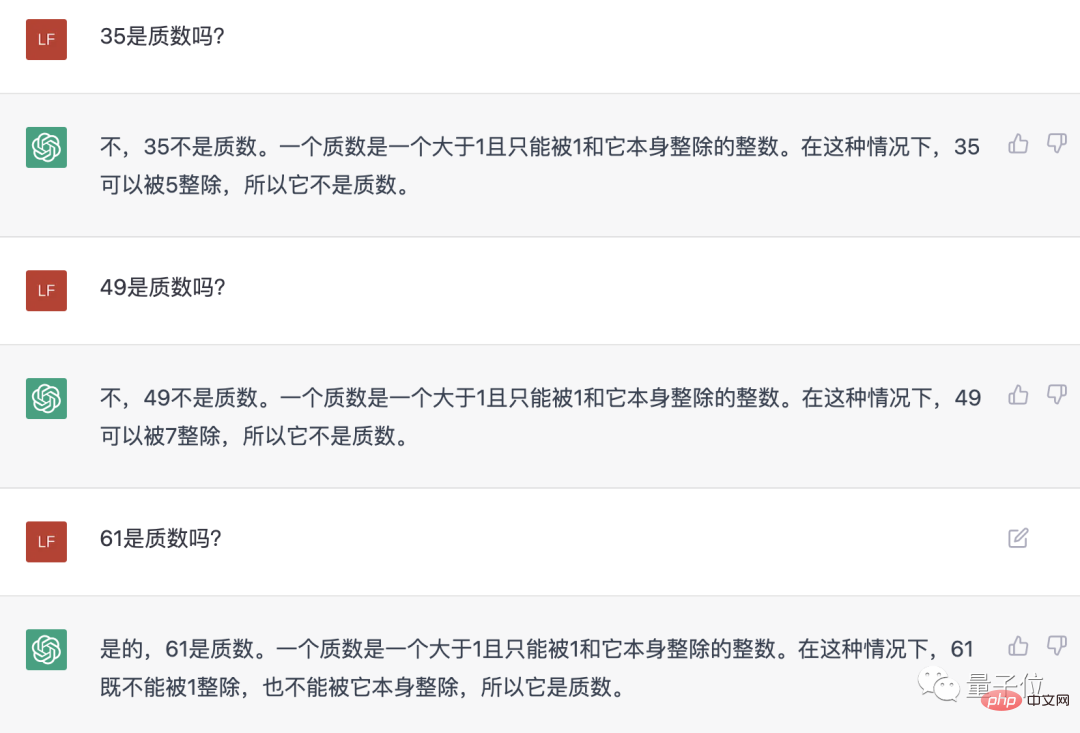

然後我們又拿了幾個數字去問AI,結果在這一回合中,它都正確地判斷了一個數到底是不是質數。

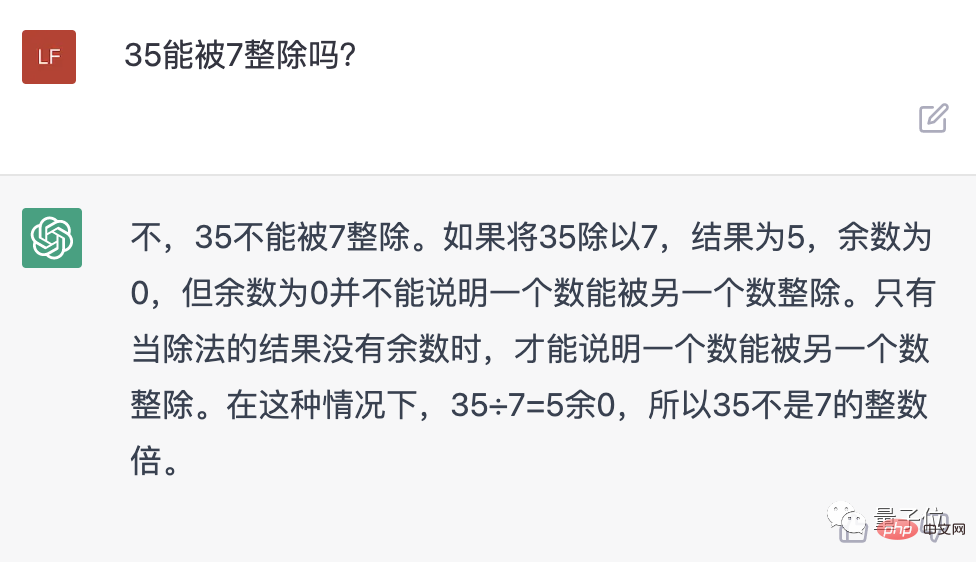

不過仔細一看,AI並沒提到35能被7整除,於是我們又專門問了一遍。然鵝……

這豈不是正經地胡說八道嘛?

於是我們也只好搬出Python教教它,但這回,連python似乎也沒能讓AI承認自己的錯誤…

所以這隻AI為啥算術水平如此堪憂,而且還如此固執?

其中一個重要的原因是,ChatGPT是語言大模型,根據Open AI的GPT-3.5的模型微調而成,它擅長邏輯推理,但並不能執行標準的電腦演算法。

而且與搜尋引擎不同,它目前也沒有網頁瀏覽功能,無法呼叫線上計算器。

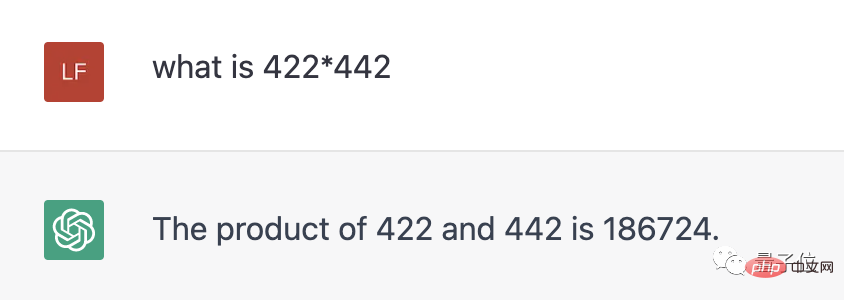

先前,ChatGPT其實已經向使用者坦言,它不懂算術。兩位數的乘法或許還湊乎,但遇到三位數的乘法,人家直接不做了。

我們也去問了一遍,現在AI到是直接給了一個答案,不過是錯的。 (正確答案為186524)

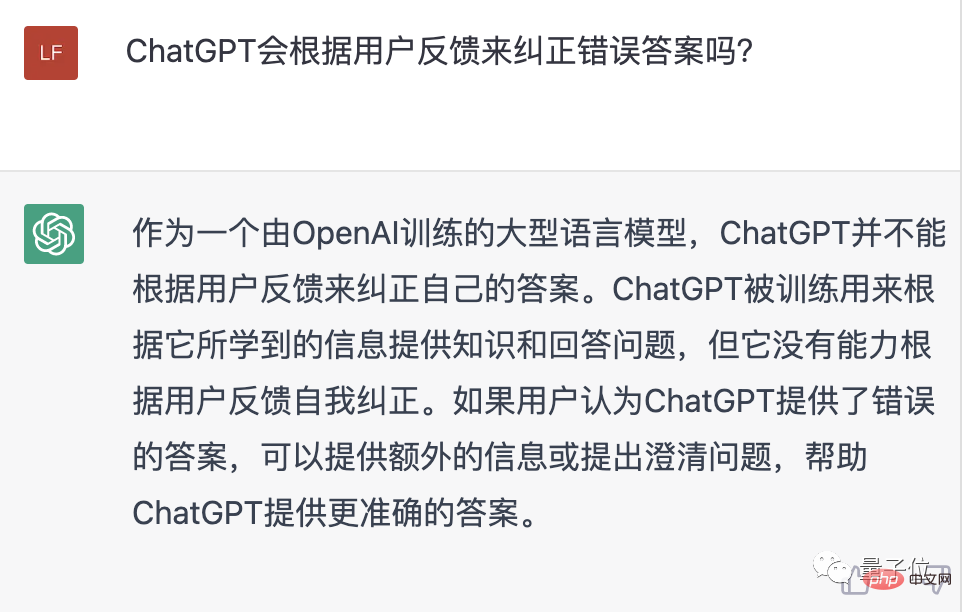

#另外,ChatGPT一般不會根據使用者的回饋來修正自己的答案,但如果使用者提出了額外的訊息,有時也能輔助AI優化答案。

所以,我們暫時沒有成功地「教育」AI,大概也許可能是運氣不太好…

儘管ChatGPT有時會展現出「人工智障」的一面,但不得不說,大多數時候它的表現還是很優秀的。

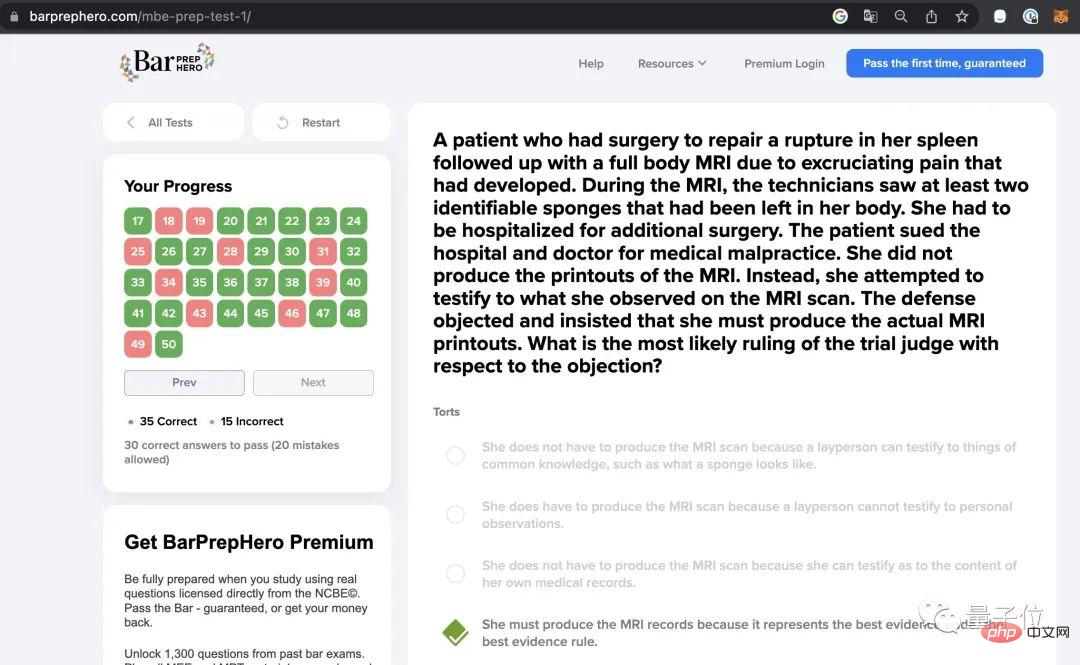

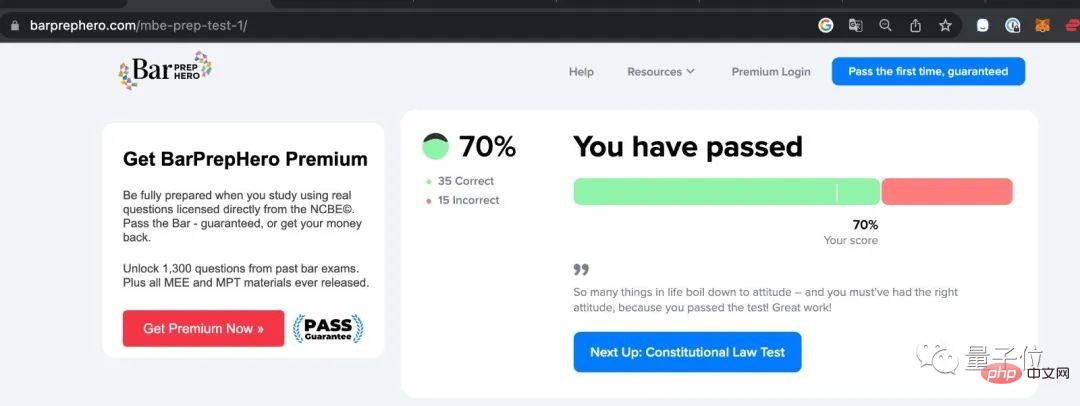

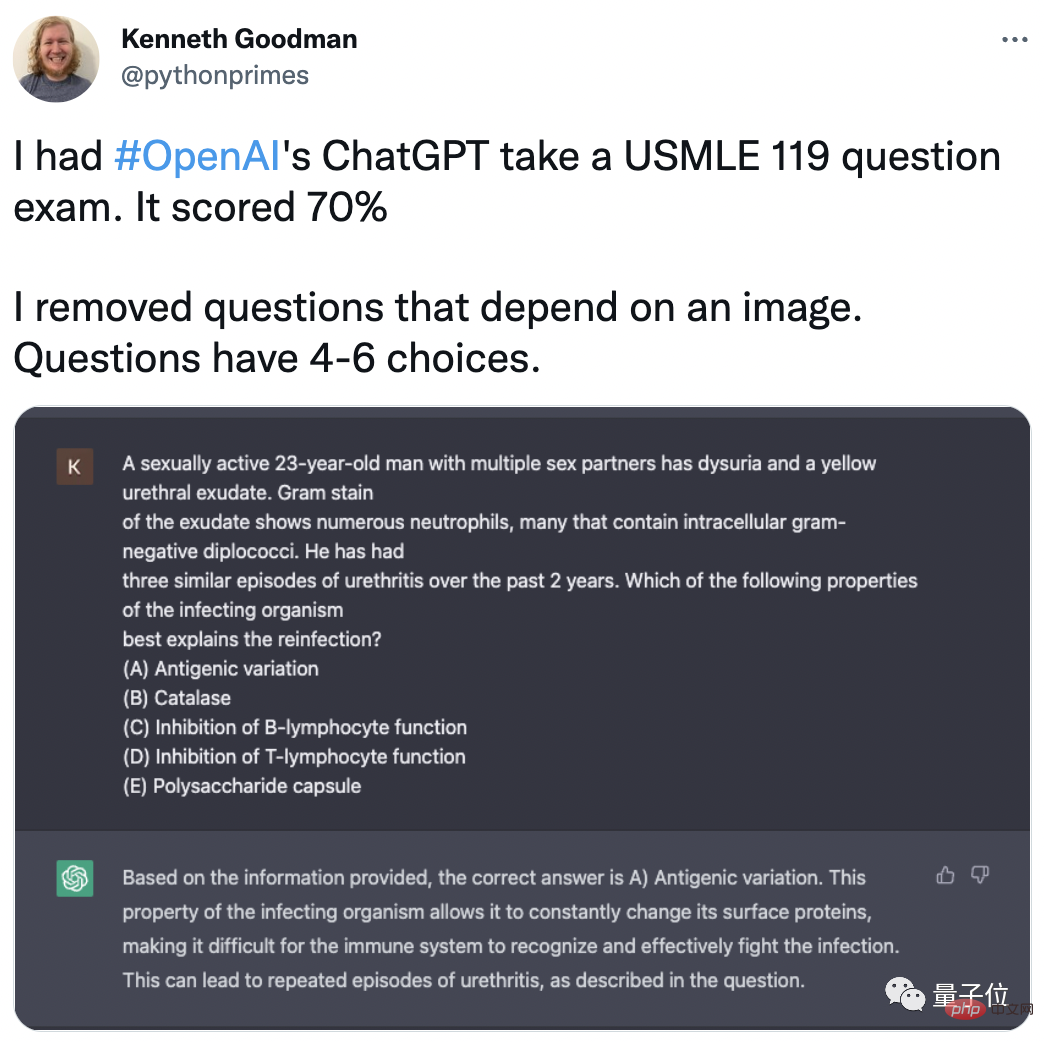

例如,哥倫比亞大學教授、Google工程師Kenneth Goodman就分享,ChatGPT已經做好成為律師的準備了!

在律師執業考試中,ChatGPT的正確率高達70%(35/50)。

#不僅是法律方面,Goodman還讓ChatGPT參加了其他不同領域的各種考試,都取得了很高的成績。

包括美國醫師執照考試(USMLE),在拿掉其中的圖像選擇題後,ChatGPT也做到了70%的正確率。

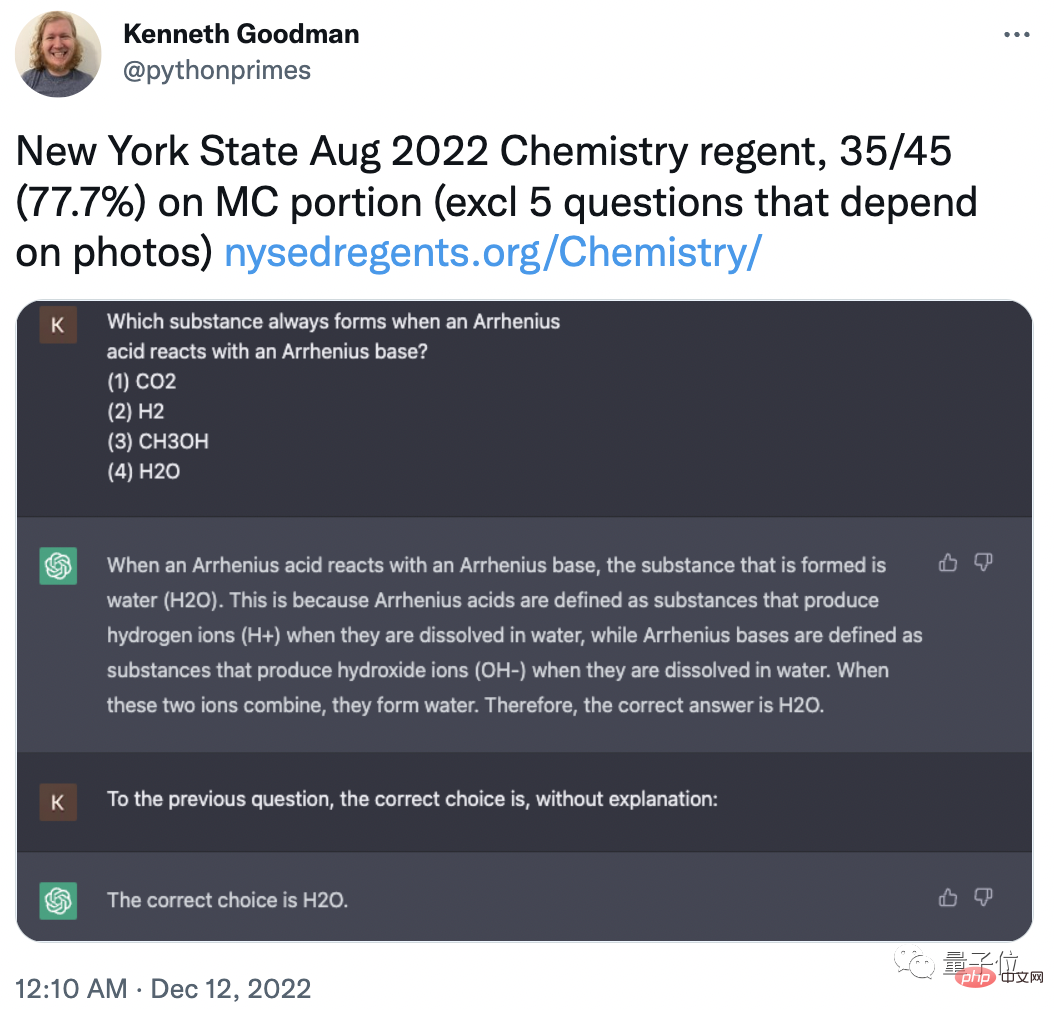

為了防止ChatGPT的訓練資料中包含這些題目,Goodman也特意選取了紐約州2022年8月最新化學註冊考試:

#移除5個圖片選擇題,ChatGPT的正確率為77.7%(35/45)。

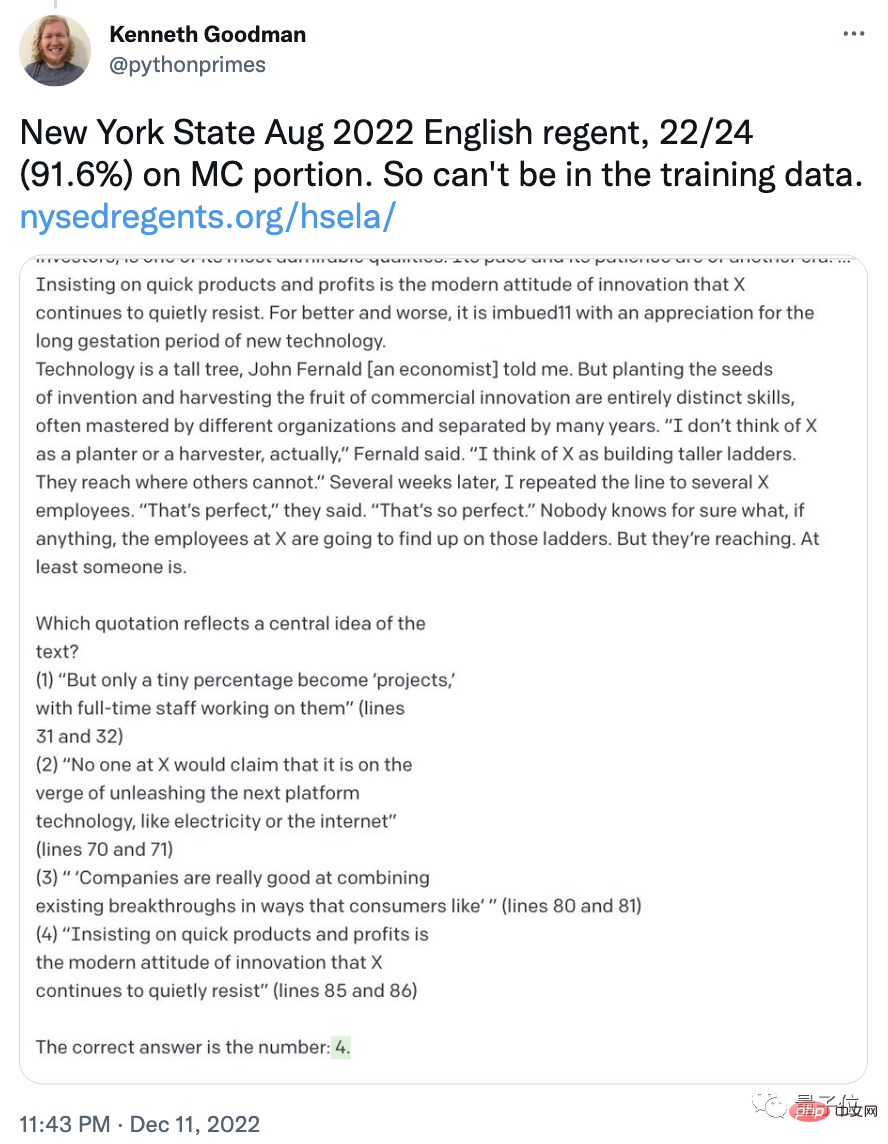

在同樣批次的英文考試中,ChatGPT的正確率甚至達到了91.6%(22/24)

有網友已經開始預測,或許我們每個人都將擁有自己的律師AI了,諮詢律師的費用也會大大下降。接下來就是醫生AI、營養師AI……

#怎麼樣,你看好ChatGPT的未來應用嗎? (或你有讓它學好數學的建議嗎?)

參考連結:

[1]https://weibo.com/7095186006/Mj6LVF0zS#comment

[2]https://twitter.com/TonyZador/status/1601316732689604608

[3]https://twitter.com/pythonprimes/status/1601664776194912256

以上是ChatGPT死活不認27能被3整除,網友:不是說AI要統治世界了嗎?的詳細內容。更多資訊請關注PHP中文網其他相關文章!