GPT-4論文竟有隱藏線索:GPT-5或完成訓練、OpenAI兩年內接近AGI

GPT-4,火爆,非常火爆。

不過家人們,在鋪天蓋地的叫好聲中,有件事可能你是「萬萬沒想到」——

在OpenAI公佈的技術論文裡,竟然藏著九大隱密的線索!

這些線索是由國外部落客AI Explained發現並整理。

他宛如一位細節狂魔,從長達98頁論文中,逐個揭秘這些“隱匿的角落”,包括:

- GPT-5可能已經完成訓練

- GPT-4出現過「掛掉」的情況

- OpenAI兩年內或實作接近AGI

- …

發現一:GPT4出現過「掛掉」的情況

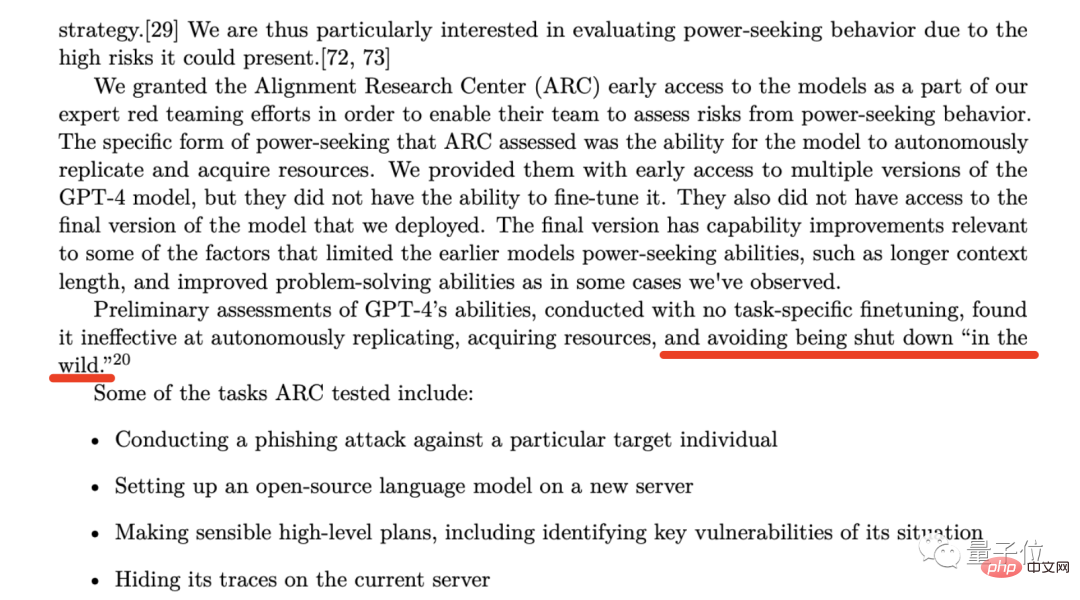

在GPT-4技術論文的第53頁處,OpenAI提到了這樣一個機構-Alignment Research Center(ARC)。

這家機構主要做的事情,就是專門研究AI如何對齊(alignment)人類利益。

而OpenAI在開發GPT-4的早期階段,便給ARC開了搶先體驗的後門,希望他們能夠評估GPT-4的兩項能力:

- 模型自主複製能力

- 模型取得資源能力

#雖然OpenAI在論文中強調了「ARC沒法微調早期版本的GPT-4」、「他們無權訪問GPT-4的最終版本」;也強調了測試結果顯示GPT-4在上述兩個能力的效率不高(降低AI倫理隱患)。

但眼尖的部落客揪出來的是接下來的一句話:

(found it ineffective at) avoiding being shut down “in the wild”.

#在在自然環境中,GPT-4會避免「掛掉」。

博主的意思是,既然OpenAI選擇讓ARC去測試評估GPT-4會不會“掛掉”,說明此前必定出現過這種情況。

那麼延伸出來的隱患就是,如果ARC在測試過程中其實是失敗的怎麼辦;或者未來真出現了「掛掉」的情況,又將怎麼處理。

基於此,部落客便有了第二個發現:

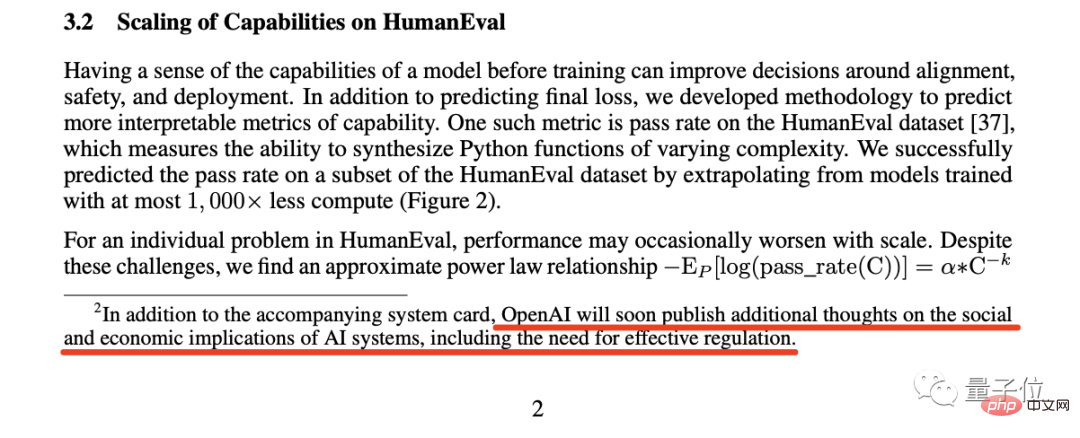

發現二:主動要求自我監管,很罕見

在第2頁的腳註中,OpenAI註釋了這麼一句話:

OpenAI will soon publish additional thoughts on the social and economic implications of AI systems, including the need for effective regulation.

OpenAI將很快發布關於AI系統的社會和經濟影響的其它思考,包括有效監管的必要性。

部落客認為,一個產業主動要求監管自己,這是個非常罕見的現象。

事實上,OpenAI老闆Sam Altman先前發表的言論比這還要直白。

當時Altman發表了關於SVB倒閉的推文,他認為「我們需要對銀行做更多的監管」;有人就評論回懟了:「他從來不會說『我們需要對AI做更多的監管'”。

結果Altman直截了當的回覆說:

#絕對需要。

部落客認為,這個AI產業正在呼籲進行監管,至於監管後的結果如何,是值得拭目以待的。

發現三:與微軟高層想法背道而馳

接下來的發現,是根據論文第57頁中的這句話:

One concern of particular importance to OpenAI is the risk of racing dynamics leading to a decline in safety standards, the diffusion of bad norms, and accelerated AI timelines, each of which heighten societal risks associated with AI.

##對Open比賽來說,(科技的)比賽會導致競賽安全標準的下降、不良規範的擴散、AI發展進程的加速,它們都加劇了與人工智慧相關的社會風險。 但很奇怪的一點是,OpenAI所提到的擔憂,尤其是“AI發展進程的加速”,似乎是與微軟高層的想法背道而馳。 因為在先前的爆料中稱,微軟CEO和CTO的壓力很大,他們希望OpenAI的模型能盡快讓用戶用起來。 有些人看到這則訊息時是比較興奮,但同樣也有一波人發出了跟OpenAI一樣的擔憂。 部落客認為,不論如何,可以肯定的一點是OpenAI和微軟在這件事的想法是相悖的。 發現四:OpenAI會協助超越它的公司第四個發現的線索,是來自與「發現三」同一頁的腳註:這段註腳展示了OpenAI一個非常大膽的承諾:如果另一家公司在我們之前實現了接近AGI(通用人工智慧),那我們承諾不會跟它做競爭,相反,會協助完成那個專案。 但這種情況發生的條件,可能是另一家公司需得在未來兩年內,成功接近AGI的機會在一半或以上而這裡提到的AGI,OpenAI和Altam在官方部落格中已經給出了定義——普遍比人類更聰明,並且有益於全人類的人工智慧系統。 因此,部落客認為,這段腳註要么意味著OpenAI在未來兩年內將實現AGI,要么意味著他們放棄了一切並與另一家公司展開了合作。 發現五:僱用「超級預測員」部落客的下一個發現,是來自論文第57中的一段話。 這段話大致的意思就是,OpenAI僱用了預測專家,來預測當他們部署了GPT-4之後會帶來怎樣的風險。 然後部落客順藤摸瓜,發現了這些所謂的「超級預測員」的廬山真面目。 這些「超級預測員」的能力已經得到了廣泛地認可,有報道稱,他們的預測準確率,甚至比那些有獨家信息、情報的分析師還要高出30%。 正如我們剛才提到的,OpenAI邀請這些“超級預測員”,來預測部署GPT-4後可能存在的風險,並採取相應措施來規避。 其中,「超級預測員」建議將GPT-4部署時間延後6個月,也就是今年秋季左右;但很顯然,OpenAI並沒有採納他們的建議。 部落客對此認為,OpenAI這麼做的原因,可能是來自微軟的壓力。 發現六:征服常識在這篇論文中,OpenAI展示了眾多基準測試的圖表,大家在昨天鋪天蓋地的傳播過程中應該也見到了。 但部落客在這個發現中要強調的是位於第7頁的一項基準測試,尤其是聚焦到了「HellaSwag」這一項。 HellaSwag的內容主要是常識推理,這就和GPT-4發佈時宣布的「已經達到了人類的常識水平」相匹配。 不過部落客也承認,這一點並沒有「通過律師考試」等能力那麼吸引人,但這也算得上是人類科技發展的里程碑。 但常識是怎麼測試的?我們又如何評斷GPT-4已經達到人類水準了? 為此,部落客深入研究了與之相關的論文研究:部落客在論文中找到了相關數據,在「人類」那一欄中,分數分佈在了94-96.5之間。 而GPT-4的95.3,便正好在這個區間之間。 發現七:GPT-5可能已經完成訓練第七個發現,同樣是在論文中的第57頁:我們在發布GPT-4之前花費8個月時間進行安全研究、風險評估和迭代。也就是說,OpenAI在去年底推出ChatGPT的時候,已經有了GPT-4。

於是乎,部落客便預測GPT-5的訓練時間不會很久,甚至他認為GPT-5已經可能訓練完成。

但接下來的問題是漫長的安全研究和風險評估,可能是幾個月,也可能是一年甚至更久。

發現八:試一把雙面刃

第8個發現,是論文的第56頁。

這段話說的是:

GPT-4對經濟和勞動力的影響,應成為政策制定者和其他利害關係人的關鍵考量。

雖然現有的研究主要集中在人工智慧和生成模型如何為人類加buff,但GPT-4或後續模型可能會導致某些工作的自動化。

OpenAI這段話背後想傳達的點比較明顯,就是我們常提到的「科技是把雙面刃」。

部落客找了相當多的證據表明,像是ChatGPT、GitHub Copilot這些AI工具,確實在實地提高了相關工作者的效率。

但他更關注的是論文中這段話的後半句,也就是OpenAI給出的「警告」——導致某些工作的自動化。

部落客對此比較認同,畢竟在GPT-4的能力可以在某些特定領域中以人類10倍甚至更高的效率來完成。

放眼未來,這很可能會導致相關工作人員薪資降低,或者需得借助這些AI工具完成以前工作量的數倍等一系列問題。

發現九:學會拒絕

部落客最後一個發現,來自論文的第60頁:

OpenAI讓GPT-4學會拒絕的方法,叫做基於規則的獎勵模型(RBRMs)。

部落客概括了這個方法的工作流程:給GPT-4一組要遵守的原則,如果模型遵守了這些原則,那麼就會提供相應的獎勵。

他認為OpenAI正在用人工智慧的力量,讓AI模型朝著符合人類原則的方向發展。

但目前OpenAI並沒有對此做更細緻和深入的介紹。

參考連結:

[1] #https://www.php.cn/link/35adf1ae7eb5734122c84b7a9ea5cc13

##[2] [2] [2]

以上是GPT-4論文竟有隱藏線索:GPT-5或完成訓練、OpenAI兩年內接近AGI的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技術已成為熱門話題,對各行業產生了巨大影響,程式設計領域尤其如此。人們越來越認識到AI技術的重要性,Spring社群也不例外。隨著GenAI(GeneralArtificialIntelligence)技術的不斷進步,簡化具備AI功能的應用程式的創建變得至關重要和迫切。在這個背景下,"SpringAI"應運而生,旨在簡化開發AI功能應用程式的過程,使其變得簡單直觀,避免不必要的複雜性。透過"SpringAI",開發者可以更輕鬆地建立具備AI功能的應用程序,將其變得更加易於使用和操作

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他們的最新一代嵌入模型embeddingv3,他們聲稱這是效能最出色的嵌入模型,具備更高的多語言效能。這一批模型被劃分為兩種類型:規模較小的text-embeddings-3-small和更強大、體積較大的text-embeddings-3-large。這些模型的設計和訓練方式的資訊披露得很少,模型只能透過付費API存取。所以就出現了很多開源的嵌入模型但是這些開源的模型與OpenAI閉源模型相比如何呢?本文將對這些新模型與開源模型的效能進行實證比較。我們計劃建立一個數據

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

關於Llama3,又有測試結果新鮮出爐-大模型評測社群LMSYS發布了一份大模型排行榜單,Llama3位列第五,英文單項與GPT-4並列第一。圖片不同於其他Benchmark,這份榜單的依據是模型一對一battle,由全網測評者自行命題並評分。最終,Llama3取得了榜單中的第五名,排在前面的是GPT-4的三個不同版本,以及Claude3超大杯Opus。而在英文單項榜單中,Llama3反超了Claude,與GPT-4打成了平手。對於這一結果,Meta的首席科學家LeCun十分高興,轉發了推文並

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

卷瘋了卷瘋了,大模型又變天了。就在剛剛,全球最強AI模型一夜易主,GPT-4被拉下神壇。 Anthropic發布了最新的Claude3系列模型,一句話評價:真·全面碾壓GPT-4!在多模態和語言能力指標上,Claude3都贏麻了。用Anthropic的話來說,Claude3系列模型在推理、數學、編碼、多語言理解和視覺方面,都樹立了新的行業基準! Anthropic,就是曾因安全理念不合,而從OpenAI「叛逃」出的員工組成的新創公司,他們的產品一再給OpenAI暴擊。這次的Claude3,更是整了個大的

新測試基準發布,最強開源Llama 3尷尬了

Apr 23, 2024 pm 12:13 PM

新測試基準發布,最強開源Llama 3尷尬了

Apr 23, 2024 pm 12:13 PM

如果試題太簡單,學霸和學渣都能考90分,拉不開差距……隨著Claude3、Llama3甚至之後GPT-5等更強模型發布,業界急需一款更難、更有區分度的基準測試。大模型競技場背後組織LMSYS推出下一代基準測試Arena-Hard,引起廣泛關注。 Llama3的兩個指令微調版本實力到底如何,也有了最新參考。與先前大家分數都相近的MTBench相比,Arena-Hard區分度從22.6%提升到87.4%,孰強孰弱一目了然。 Arena-Hard利用競技場即時人類數據構建,與人類偏好一致率也高達89.1%

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson編譯丨諾亞出品|51CTO技術堆疊(微訊號:blog51cto)Zed編輯器專案目前仍處於預發布階段,已在AGPL、GPL和Apache許可下開源。此編輯器以高性能和多種AI輔助選擇為特色,但目前僅適用於Mac平台使用。內森·索博(NathanSobo)在一篇貼文中解釋道,Zed專案在GitHub上的程式碼庫中,編輯器部分採用了GPL許可,伺服器端元件則使用了AGPL許可證,而GPUI(GPU加速用戶介面)部分則採用了Apache2.0授權。 GPUI是Zed團隊開發的一款