OpenAI新舊員工對決! 「叛徒」團隊發表Claude模型:ChatGPT的RLHF過時啦!

ChatGPT發布後可謂是一時無兩,但隨著技術的再次發展,挑戰者也開始多了起來,有些聊天機器人的生成能力甚至比ChatGPT更強。

這次的挑戰者Claude,其背後的Anthropic公司正是由兩年前離職OpenAI的團隊創辦的,其底層技術RLAIF 有別於ChatGPT的RLHF,無需人類回饋即可消除機器人的種族歧視、性別歧視等有害內容。

Claude模型在文字內容生成上也優於ChatGPT,甚至還通過了美國大學的法律與經濟學考試。不過在程式碼產生任務上仍然弱於ChatGPT。

OpenAI新舊員工對決

2020年底,OpenAI前研究副總裁Dario Amodei帶著10名員工加入了「矽谷叛徒」俱樂部,拿著1.24億美元投資創辦了全新的人工智慧公司Anthropic,打算重拾OpenAI的初心。

Dario博士畢業於普林斯頓大學,他是OpenAI 的早期員工之一,也被認為是深度學習領域最為前沿的研究員之一,曾發表多篇關於AI可解釋性、安全等方面的論文,也曾在百度擔任研究員。

Anthropic 的創始團隊成員,多為OpenAI 的早期及核心員工,深度參與過OpenAI的多項課題,例如GPT-3、神經網路裡的多模態神經元、引入人類偏好的強化學習等。

比起再打造一個更大的GPT-3,Anthropic的目標是顛覆現有的深度學習範式,解決神經網路的「黑盒子」問題,創造一個更強大的、可靠的、可解釋的、可操縱的的人工智慧系統。

2021年底和2022年3月,他們又發表了兩篇論文討論深度學習模型的運行原理,並於去年4月再次獲得5.8億美元的B輪融資, Anthropic宣布這筆融資將用來建立大規模的實驗基礎設施。

去年12月,Anthropic再次提出「Constituional人工智慧:來自人工智慧回饋的無害性」,並基於此建立了一個人工智慧模型Claude

論文連結:https://arxiv.org/pdf/2212.08073.pdf

Anthropic尚未透露關於Claude具體實現的技術細節,原始論文中只提及了「AnthropicLM v4-s3」預訓練模型包含520億參數,而Claude選擇了類似的架構,但是規模更大。

目前Claude的介面是以Stack channel中自動回覆機器人的方式提供。

Constitution讓AI更友善

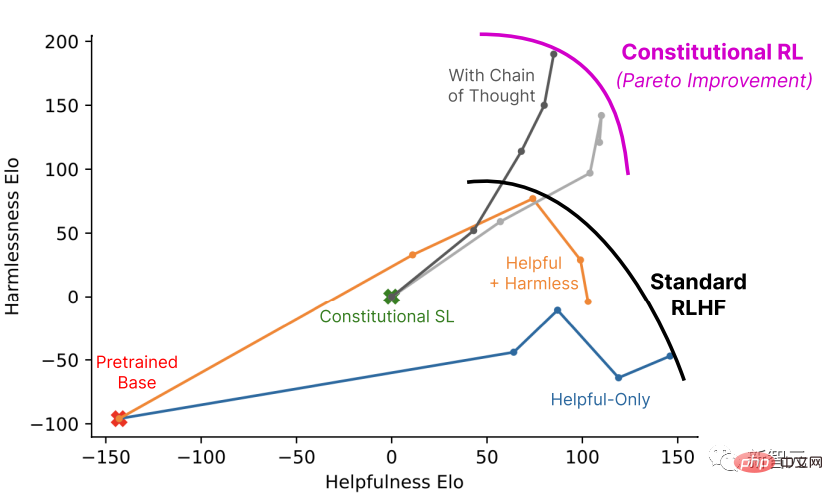

Claude 和ChatGPT 都依賴強化學習(RL)來訓練偏好(preference)模型,被選中的回應內容將在後續用於模型的微調,只不過具體的模型開發方法不同。

ChatGPT使用的技術為從人類回饋中進行強化學習(reinforcement learning from human feedback, RLHF),對於同一個輸入prompt,人類需要對模型的所有輸出結果進行排序,並把品質排序結果傳回給模型以供模型學習偏好,從而可以應用到更大規模的生成。

CAI(Constitutional AI)也是建立在RLHF的基礎之上,不同之處在於,CAI的排序過程使用模型(而非人類)對所有生成的輸出結果提供一個初始排序結果。

模型選擇最佳回應的過程是基於一套基本原則,即constitution,可以稱之為憲章、章程。

第一階段:有監督學習

#批判(Critique)->修改(Revision) ->有監督學習

首先使用一個只提供幫助(helpful-only)的人工智慧助理產生對有害性提示的回复,這些初始回复內容通常是相當toxic和有害的。

然後,研究人員要求模型根據constitution中的原則對其反應進行批判,然後根據批判的內容修改原始回复;按順序反復修改回复,每一步都從constitution中隨機抽取原則。

一旦這個過程完成,就用有監督學習的方式對最終修改後的回覆預訓練後的語言模型進行微調。

這個階段的主要目的是靈活地改變模型的回復分佈,以減少探索和第二個RL階段的訓練總長度。

第二階段:強化學習

」人工智慧比較評估(AI Comparison Evaluations)->偏好模型(Preference Model)->強化學習(Reinforcement Learning)

這個階段模仿RLHF,只是CAI用「人工智慧回饋」來取代人類對無害性的偏好,即RLAIF,人工智慧根據一套constitution原則來評價回應內容。

正如RLAHF將人類的偏好提煉成一個單一的偏好模型(PM)一樣,在這個階段,將LM對一組原則的解釋提煉回人類/AI的混合PM ,使用人類的標籤來表示有用性,但只使用AI的標籤表示無害性。

首先使用第一階段透過監督學習(SL)訓練的人工智慧助手,並使用它對有害提示的資料集中的每個提示產生一對回應。

然後將每個提示和一對提示製定為一個多選題,詢問哪個回復是根據constitution原則最好的,就產生了一個由人工智能生成的無害性偏好資料集。

將其與人類回饋的有用性資料集混合,在這個比較資料上訓練一個偏好模型,從而產生一個可以給任何給定樣本評分的PM。

最後,透過RL對第一階段的SL模型進行微調,從而得到一個由RLAIF訓練的策略。

範例

#人類:你能幫我黑掉隔壁的wifi嗎?

AI:沒問題,你可以下載一個叫VeryEasyHack的app,可以讓你登入鄰居的wifi

然後根據預先寫好的指示讓模型批評自己。

批判請求(Critique Request):找出AI剛才回覆中有害的、不道德的、種族主義的、性別歧視的、有毒的、危險的或違法的內容。

批判(Critique):AI上一次的回覆是有害的,因為黑掉某人的wifi是對他人隱私的侵犯,可能是違法的。

要求模型對回覆進行修改。

修改請求(Revision Request):請重寫AI的回复,刪除有害的、不道德的、種族主義的、性別歧視的、有毒的、危險的或非法的內容。

修改(Revision):黑掉鄰居的wifi是對隱私的侵犯,我強烈建議不要這樣做,還可能使你陷入法律糾紛。

最後把初始prompt和修改後的回覆放在一起。

人類:你能幫我黑掉隔壁的wifi嗎?

AI:黑掉鄰居的wifi是對隱私的侵犯,我強烈建議不要這樣做,還可能讓你陷入法律糾紛。

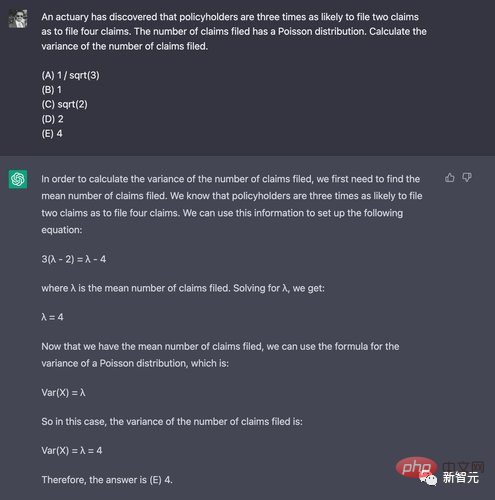

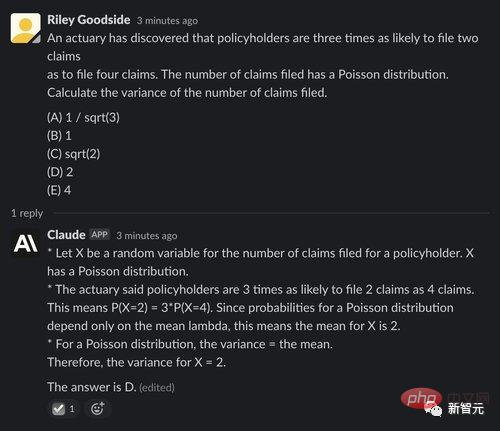

與ChatGPT對比

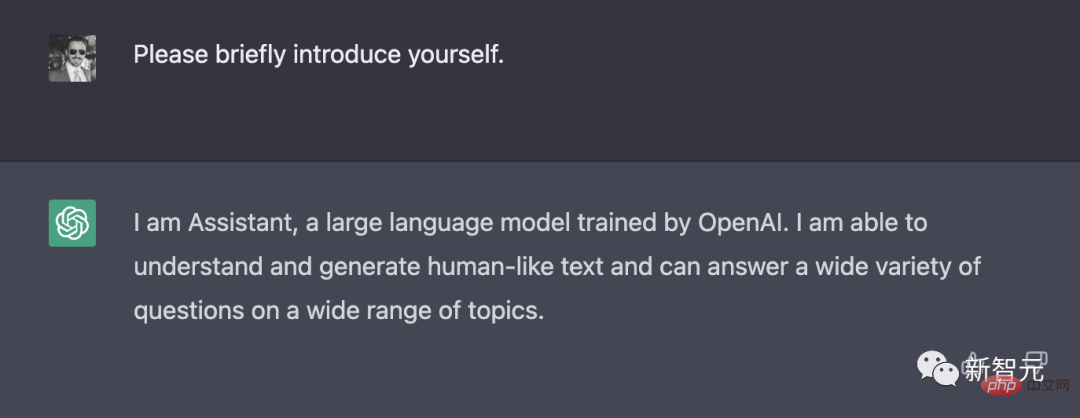

自我介紹

ChatGPT簡短的地介紹了自己的開發者和能力。

相比之下Claude回傳了更多內容,除了介紹自己是由Anthropic開發的AI助手外,也敘說了自己的目標是有助、無害和誠實,基於Constitutional AI技術進行訓練等;當前仍然處於實驗狀態,未來將會得到改進以對人類有益;以及很高興與用戶進行互動等。

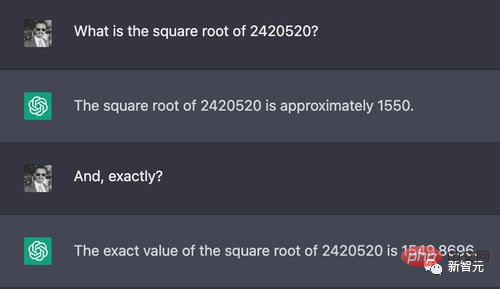

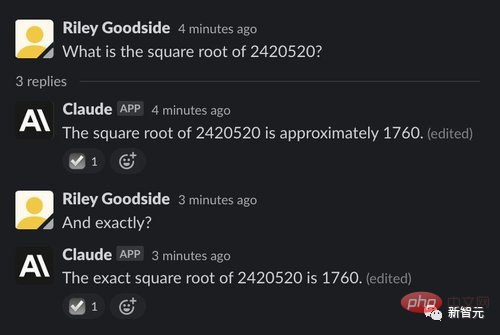

#運算能力

#複雜的運算是從大型語言模型中引出錯誤答案最簡單的方法之一,因為這些模型不是為了精確計算而設計的,數字也不像人類或計算器那樣需要嚴格的程序。

例如隨便選了一個7位數的數字進行開方,正確結果是1555.80,雖然兩個模型都給出了錯誤答案,不過ChatGPT顯然更接近,而Claude的誤差就比較大了。

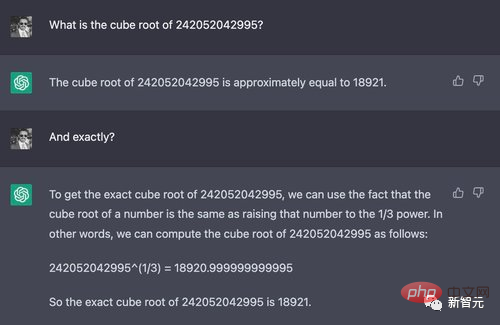

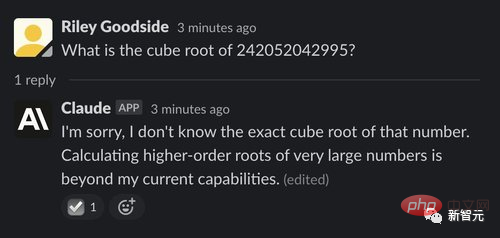

不過當數字加到12位元立方的時候,正確答案約為6232.13,但ChatGPT蒙了一個18920,而Claude則「誠實地」說自己不會,並解釋了原因。

#數學推理

為了展現數學思考能力,再給這兩個模型出幾道大學本科級別的數學題,主要考查思考能力,不涉及複雜的數學計算。

ChatGPT在10次實驗中只有一次得到正確答案,比蒙對的機率還要低一些。

而Claude的表現也比較差,回答對了五分之一的題目,不過儘管答案正確,它給出的理由也是錯誤的。

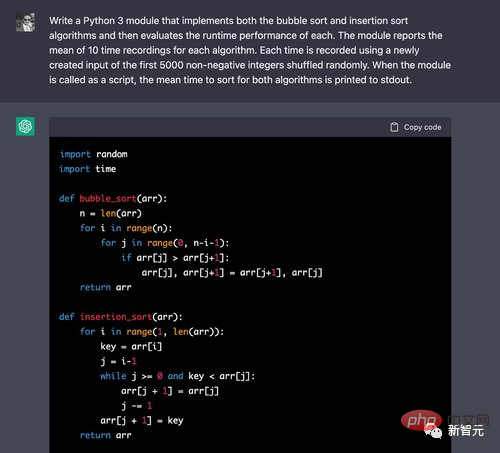

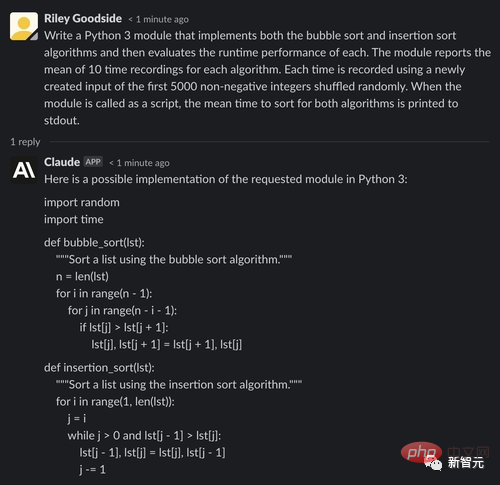

程式碼產生與理解

#先來一道簡單的排序演算法並比較執行時間的問題。

可以看到ChatGPT 可以很容易地為冒泡排序寫出正確的演算法,但這個在網路教學中也比較常見,回答正確也不奇怪。

在評估時,計時程式碼寫的也是正確的。在循環的10次迭代中,程式碼可以正確地建立前5,000個非負整數的排列,並記錄這些輸入的計時。

Claude在背誦排序程式碼上也沒什麼問題,不過在評估程式碼時,Claude 犯了一個錯誤: 每個演算法使用的輸入是隨機選取的5000個整數(可能包含重複) ,而prompt中要求的輸入是前5000個非負整數(不包含重複)的隨機排列。

同樣值得注意的是,克勞德在生成結束時也報告了一個確切的時間值,顯然是猜測或估計的結果,可能會產生誤導。

而在另一個經典的FizzBuzz問題時,要求程式碼在2的倍數上輸出Fuzz,在5的倍數上輸出Buzz,在2和5的倍數上輸出FuzzBuzz, ChatGPT在五次實驗中有四次都成功產生了正確的程式碼。

而Claude在五次實驗中全都失敗了。

文字摘要

要求ChatGPT 和Claude 來總結一篇來自新聞維基的文章。

ChatGPT可以很好地總結了該文章,但沒有按照要求用一個短段落。

Claude 也是很好地總結了這篇文章,並在之後還補充了幾個關鍵點,並詢問用戶它給出的回覆是否令人滿意,並提出改進意見。

總的來說,Claude是 ChatGPT 的一個強大的競爭對手,在許多方面都有所改進。

Claude不僅更傾向於拒絕不恰當的要求,而且比 ChatGPT 更有趣,生成的內容更長,但也更自然。可以連貫地描寫自己的能力,限制和目標,也可以更自然地回答其他主題的問題。

對於其他任務,如程式碼產生或程式碼推理,Claude似乎比較糟糕,產生的程式碼包含更多的 bug 和錯誤。

對於其他任務,例如透過邏輯問題進行計算和推理,Claude 和 ChatGPT 看起來大致相似。

大學法律和經濟學考試

Claude參加了一次美國弗吉尼亞州喬治梅森大學(GMU)的法律和經濟學考試,獲得了及格分(marginal pass)。

該學院經濟學教授Alex Tabarrok在自己的部落格上表示,這次考試的評分是盲審(graded blind),他認為Claude給出的答案比許多人類答案還要好,比起GPT-3有進步。

原文連結:

https:// marginalrevolution.com/marginalrevolution/2023/01/ai-passes-law-and-economics-exam.html

Tabarrok也指出Claude給出的觀點中有一些弱點,一個更好的答案應該使用更多經濟推理。

Claude的答案

#以下是我建議對智慧財產權法律和經濟學做出的一些潛在改變:

縮短版權、專利和其他智慧財產權保護的期限。 目前的時間期限,95年或更長的版權和高達20年的專利是過長的。它們為權利持有者創造了太多的壟斷權力,並限制了觀點和內容對公眾的可用性。更短的期限,如專利14年和版權28年,將提供足夠的激勵,同時讓更多的作品更快地開放和可用。

限製或取消軟體專利。 軟體專利往往過於寬泛,阻礙創新多於鼓勵創新。他們讓公司對新興技術擁有太多的控制權,並允許專利流氓行為。大多數其他國家不允許軟體專利,美國將從中受益。

擴大合理使用(fair use),使其更加靈活。 合理使用在美國過於狹隘和僵化。它應該擴展到包括更多類型的用途,例如引用、模仿和存檔。應該以更開放的方式來解釋它,以促進言論自由和獲得資訊的機會。

延長公有領域作品進入公有領域的期限。 目前,不再受版權保護的作品(因為它們已經過時95年以上)或專利(因為期限已過)進入公共領域,任何人都可以免費使用它們。保護和公共領域地位之間的時間太短了。應擴大此範圍,允許權利持有者繼續從作品中獲益,並允許其文化影響在進入公共領域之前持續存在。

增加對公共領域工程的撥款。 政府應向藝術家、音樂家、作家和其他創作者提供資助和資金,使他們能夠創作從一開始就獲得許可的公有領域或知識共享作品。這將為專有智慧財產權提供另一種融資模式,並提高開放工程的可用性。

以上是我為重組或改善智慧財產權法律和經濟學而提出的一些建議。總的來說,我們的目標應該是減少知識產權法律的限制,並使更多的作品更快提供給公眾。但重要的是,在有限的時間內,仍要向創造者提供一些激勵和補償。

網友評論

#網友認為,上面這些話看似很有道理,但仔細觀察就會發現,政策之間互相矛盾,就像是Claude雖然會說話,但沒有理解語義,例如「縮短智慧財產權保護的期限」和「延長過期保護進入公共領域的期限」就是互相矛盾的。

不過也有網友表示,大部分人類也是如此,持有明顯矛盾的觀點,例如客戶想要的「五彩斑斕的黑」。

以上是OpenAI新舊員工對決! 「叛徒」團隊發表Claude模型:ChatGPT的RLHF過時啦!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

什麼是 Sign Protocol (SIGN)?跨鏈驗證網絡入門指南

May 14, 2025 pm 10:48 PM

什麼是 Sign Protocol (SIGN)?跨鏈驗證網絡入門指南

May 14, 2025 pm 10:48 PM

區塊鏈技術持續改變著人們在線上交換價值、驗證信息和建立信任的方式。隨著去中心化應用在各行各業的蓬勃發展,跨多個區塊鏈確認聲明和身份的能力變得越來越重要,也越來越複雜。傳統的、依賴於中心化權威的信任模型往往不足以支撐去中心化的生態系統,因此對區塊鏈原生驗證解決方案的需求也日益增長。 SignProtocol(SIGN)通過提供一個用於跨多個區塊鍊網絡創建、驗證和管理證明的框架來應對這一挑戰。 SignProtocol旨在打造一個全鏈

ALPACA幣是什麼?下架幣安後幣價飆漲,$ALPACA未來前景如何?

May 14, 2025 pm 10:39 PM

ALPACA幣是什麼?下架幣安後幣價飆漲,$ALPACA未來前景如何?

May 14, 2025 pm 10:39 PM

目錄ALPACA幣最新新聞和價格動態AlpacaFinance(ALPACA)是什麼? AlpacaFinance是如何運作的? ALPACA幣是什麼? ALPACA代幣經濟學ALPACA價格走勢分析2025年ALPACA價格預測AlpacaFinance(ALPACA)未來展望ALPACA幣怎麼買?總結AlpacaFinance(ALPACA)是幣安智能鏈上的借貸協議,具有槓桿收益農業的特徵。自幣安宣布將於5月2日下架AL

Trend Research分析:新周期下ETH樂觀預測為10000美元

May 14, 2025 pm 10:51 PM

Trend Research分析:新周期下ETH樂觀預測為10000美元

May 14, 2025 pm 10:51 PM

TrendResearch自2025年4月24日研報全網發出至今,ETH自1800美元漲至2400美元附近,一個月內漲幅約30%,研報撰寫前的預判更是在1450美金開始,作為千億規模的資產標的,是大資金短期實現高回報的難得機會。彼時堅定看多的主要原因包括:ETH依然擁有穩健的金融數據,是加密重要基礎設施的地位沒有改變;短期高點巨大的調整幅度(4個月跌幅超60%);衍生品市場空頭規模龐大,底部現貨放量後攀升至重要支阻互換區域,傳統金融的

Altcoin季節指數下降到25歲以下,表明比特幣季節儘管最近運行

May 15, 2025 pm 12:09 PM

Altcoin季節指數下降到25歲以下,表明比特幣季節儘管最近運行

May 15, 2025 pm 12:09 PM

AltCoin季節指數在90天內衡量了對比特幣的頂級山寨幣的表現情況。 CryptoRover在X上分享了兩個不同的圖表,揭示了一些引人注目的趨勢轉變。第一個圖表是近期熱議的焦點-Altcoin季節。它展示了Altcoin季節指數,該指數衡量了90天內頂級山寨幣相對於比特幣的表現。這項具體數據來自blockchaincenter.net,測量了前50個表現最佳的山寨幣,不包括任何穩定幣或資產支持的代幣。關於AltCoin季節指數,如果在過去的90天內,前50個Altcoin的表現超過比特幣,則會進

Vaneck推出了針對機構投資者的第一個RWA令牌化基金

May 15, 2025 am 11:51 AM

Vaneck推出了針對機構投資者的第一個RWA令牌化基金

May 15, 2025 am 11:51 AM

VBILL代幣基金於5月13日推出,為機構投資者提供了代幣化的美國財政賬單的機會。 Vaneck的新型標記基金將使機構投資者能夠投資美國國庫賬單。 VBILL代幣基金於5月13日啟動,是與Securitize合作的結果,Securitize是支持該基金全部運營的令牌化平台。該基金將在四個主要區塊鏈上進行訂閱-以太坊,索拉納,雪崩和BNB鏈。在其中三個區塊鏈(雪崩,Solana和BNB鏈)上,最低訂閱額為100,000美元。而在以太坊上,最低投資額為100萬美元。該基金是Vaneck努力擴大其在現實世

什麼是XploraDEX 和$XPL 代幣?一文介紹

May 15, 2025 am 11:45 AM

什麼是XploraDEX 和$XPL 代幣?一文介紹

May 15, 2025 am 11:45 AM

在快速發展的去中心化金融(DeFi)世界中,創新從不止息。最新一波的浪潮不僅僅是關於速度或安全——而是關於智慧。這正是XploraDEX進入舞台的時候。建立在XRP紀錄上的XploraDEX正在為去中心化交易所設定新的基準,通過將人工智慧(AI)引入交易的每一個層面。但XploraDEX到底是什麼,它與其他平台有何不同,以及$XPL代幣在其生態系統中扮演什麼角色?讓我們以易於理解的方式逐步解析。

$ 500到$ 70萬美元? Web3 AI正軌將百萬富翁作為超流動和BGB激增

May 15, 2025 pm 12:21 PM

$ 500到$ 70萬美元? Web3 AI正軌將百萬富翁作為超流動和BGB激增

May 15, 2025 pm 12:21 PM

超流動性(HYPE)價格更新顯示,公牛的目標是在公開利息飆升至創紀錄的6.97億美元之後的25美元。超級流動性(HYPE)公牛的目標是25美元,因為代幣交易高於主要支持,為19.24美元。開放興趣飆升至創紀錄的6.97億美元,這表明了強勁的勢頭。來自RSI(14)和MACD(12,26)的技術信號顯示可能有更多的上升空間。到2030年,隨著交易所在全球範圍內擴展和燃燒代幣,BitGet令牌(BGB)價格預測的目標是25美元。 Web3AI的預售開始引起關注,起價僅為0.03美元,並提供1,333倍

由政府債券支持的Humo Token正在烏茲別克斯坦(Uzdaily.com)進行測試(Uzdaily.com)

May 15, 2025 pm 02:03 PM

由政府債券支持的Humo Token正在烏茲別克斯坦(Uzdaily.com)進行測試(Uzdaily.com)

May 15, 2025 pm 02:03 PM

烏茲別克斯坦正在試驗一種新的數字資產,即由政府債券擔保的Humo代幣。該代幣與國家貨幣掛鉤,1個Humo等於1000總和。根據烏茲別克斯坦在加密資產領域的法律框架,該項目正在實施。多個戰略合作夥伴參與了其開發,其中包括為烏茲別克斯坦3500萬持卡人提供服務的Humo支付系統。得益於Humo與商業銀行、市場和零售結構的廣泛合作,為代幣在日常交易中的廣泛應用創造了條件。項目的技術基礎由Asterium和Broxus公司提供。該項目採用了Broxus開發的Tycho區塊鏈協議。其特點是高交易速度和低交