理論計算機科學家 Boaz Barak:深度學習並非'簡單的統計”,二者距離已越來越遠

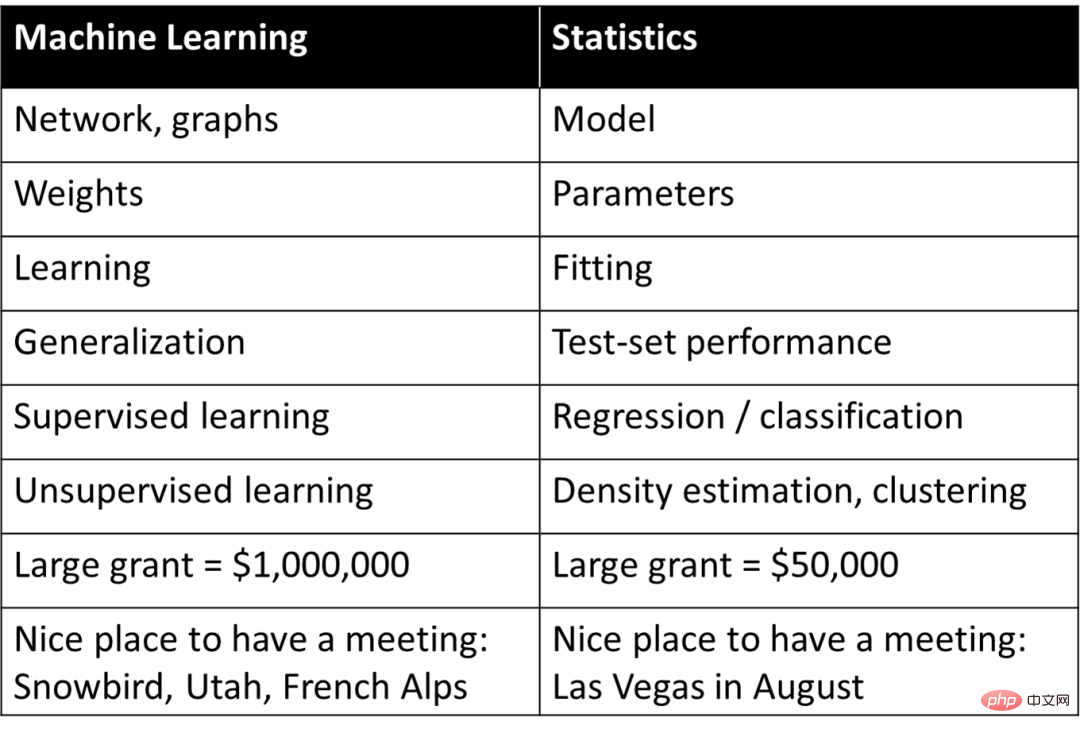

上世紀九十年代,史丹佛大學的知名生物資訊學教授Rob Tibshirani 曾擬了一個詞彙表,將機器學習與統計學中的不同概念作了簡單而粗暴的對應關係:

一方面,這個表格為理解機器學習提供了基礎的認識,但同時,其簡單地將深度學習或機器學習中的概念歸納為統計學中的詞義,也引起了大多數人對深度學習本質的認知偏差:即深度學習是「簡單的統計」。

然而,在深入探討中,這樣的認知在某種程度上阻礙了研究者理解深度學習成功的本質原因。在今年六月的一篇文章「The uneasy relationship between deep learning and (classical) statistics」中,哈佛大學知名教授、理論計算機科學家Boaz Barak 就將深度學習與統計學進行了對比區分,指出深度學習的根本構成因素就與統計學有許多不同。

Boaz Barak 提出一個重要的觀察:從模型的用途來看,如果是專注於預測與觀察,那麼具備黑盒子特性的深度學習模型可能是最好的選擇;但如果是希望獲取對事物的因果關係理解、提高可解釋性,那麼「簡單」的模型可能表現更佳。這與馬毅、曹穎、沈向洋三位科學家在上個月提出的構成智能兩大原理之一的「簡約性」見解不謀而合。

同時,Boaz Barak 透過展示擬合統計模型和學習數學這兩個不同的場景案例,探討其與深度學習的匹配性;他認為,雖然深度學習的數學和程式碼與擬合統計模型幾乎相同,但在更深層次上,深度學習中的極大部分都可在「向學生傳授技能」場景中被捕捉。

統計學習在深度學習中扮演著重要的角色,這是毋庸置疑的。但可以肯定的是,統計角度無法為理解深度學習提供完整的畫面,要理解深度學習的不同面向,仍需要人們從不同的角度出發來實現。

以下是Boaz Barak 的論述:

#1 模型擬合中的預測與解釋

############### ##幾千年來,科學家一直在為觀測結果擬合模型。例如在科學哲學書皮中所提到的,埃及天文學家托勒密提出了一個巧妙的行星運動模型。托勒密的模型是地心的(即行星圍繞地球旋轉),但有一系列“旋鈕”(knobs,具體來說就是“本輪”),使其具有出色的預測準確性。相較之下,哥白尼最初的日心說模型則是假設行星繞太陽的圓形軌道。它比托勒密的模型更簡單(「可調節旋鈕」更少)、且整體上更正確,但在預測觀察方面卻不太準確###。 ###(哥白尼在後來也添加了他自己的本輪,從而與托勒密的表現可以相媲美。)############托勒密和哥白尼的模型是無與倫比的。當你需要一個「黑盒子」來進行預測時,那托勒密的地心模型更勝一籌。而如果你想要一個可以「窺視內部」的簡單模型,並作為解釋星星運動的理論起點,那哥白尼的模型就更好。 ############事實上,克卜勒最終將哥白尼的模型改進為橢圓軌道,並提出了他的行星運動三定律,這使得牛頓能夠使用地球上適用的相同引力定律來解釋它們。為此,至關重要的是,日心模型並不僅是一個提供預測的“黑匣子”,而是由幾乎沒有“活動部件”的簡單數學方程式給出的。多年來,天文學一直是發展統計技術的靈感來源。高斯和勒讓德(獨立地)在 1800 年左右發明了最小二乘回歸,用於預測小行星和其他天體的軌道;柯西在1847年發明的梯度下降,也是受到了天文預測的推動。 ######

在物理學中,(至少有時)你可以「擁有一切」——找到能夠實現最佳預測準確性和數據最佳解釋的「正確」理論,這被諸如奧卡姆剃刀原理之類的觀點所捕捉,假設簡單性、預測能力和解釋性洞察力都是相互一致的。然而在許多其他領域,解釋(或一般情況下稱,洞察力)和預測的雙重目標之間存在張力。 如果只是想預測觀察結果,「黑盒子」可能是最好的選擇。但如果你提取因果模型、一般原理或重要特徵,那麼一個容易理解和解釋的簡單模型可能會更好。

模型的正確選擇取決於其用途。例如,考慮一個包含許多個體的基因表現和表型(例如某種疾病)的資料集,如果其目標是預測個人生病的幾率,往往會希望為該任務使用最佳模型,不管它有多複雜或它依賴多少基因。相較之下,如果你的目標是在濕實驗室中識別一些基因來進一步研究,那麼複雜的黑盒子的用途將是有限的,即使它非常準確。

2001年, Leo Breiman 在統計建模兩種文化的著名文章「Statistical Modeling: The Two Cultures」中,就有力地闡述了這一點。 「資料建模文化」著重於解釋資料的簡單生成模型,而「演算法建模文化 」對資料是如何產生的並不了解,而是專注於尋找能夠預測資料的模型。 Breiman 認為,統計數據太受第一文化的支配,而這種關注「導致了不相關的理論和有問題的科學結論」 和「阻止統計學家研究令人興奮的新問題。」

但是,Breiman 的論文充滿爭議。雖然Brad Efron 對部分觀點表示贊同,但「看第一遍,Leo Breiman 那篇令人振奮的論文看起來像是反對簡約和科學洞察力,支持很多旋鈕可操縱的黑盒子。而看第二遍,還是那個樣子」 。但在近期一篇文章(「Prediction, Estimation, and Attribution」)中,Efron 大方承認「事實證明,Breiman 比我更有先見之明:純粹的預測演算法在21 世紀佔據了統計的風頭,其發展方向與Leo 先前提到的差不多。”

2 經典和現代預測模型

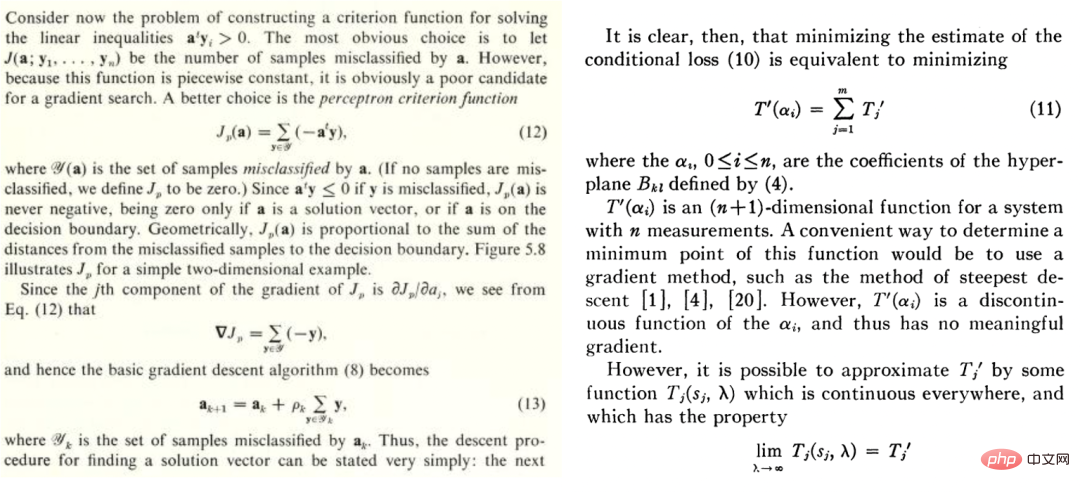

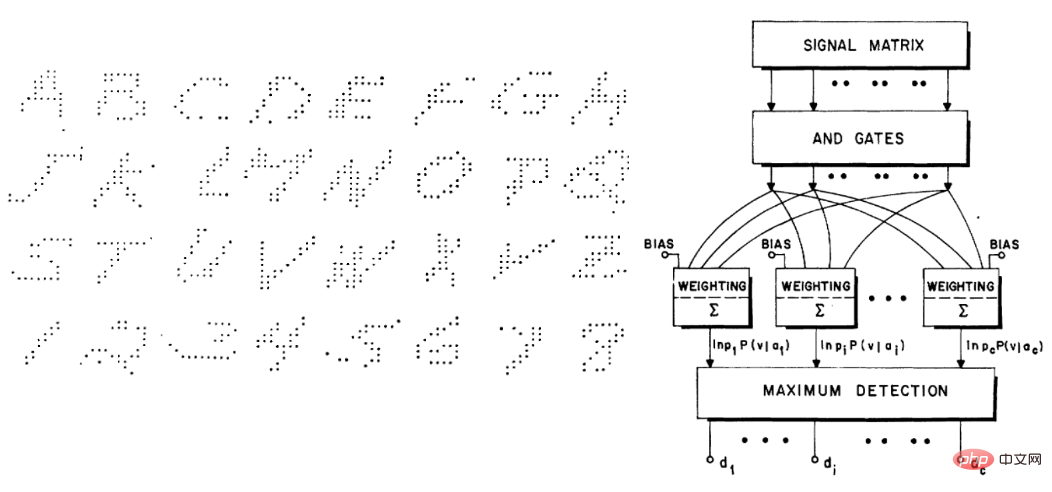

##無論機器學習是否“深度” ,它都屬於Breiman 所說的第二種文化,即專注於預測,這種文化已流傳很長一段時間。例如Duda 和Hart 1973 年的教科書《Deconstructing Distributions: A Pointwise Framework of Learning》、以及Highleyman 1962 年《The Design and Analysis of Pattern Recognition Experiments》的論文片段,對於今天的深度學習從業者來說,其辨識度非常高:

同樣地,Highleyman 的手寫字元資料集和用來與資料集擬合的架構Chow(準確率約為58%)也引起了現代讀者的共鳴。

3 為什麼深度學習不同?

1992 年,Stuart Geman、Elie Bienenstock 和Rene Doursat 共同寫了一篇題為「Neural Networks and the Bias/Varian Dilemma」的論文,其中談到一些悲觀的看法,例如, 「目前的前饋神經網絡,在很大程度上不足以解決機器感知和機器學習中的難題」;具體來說,他們認為通用神經網路無法成功解決困難的任務,神經網路成功的唯一途徑是透過手工設計特徵。用他們的話來說,即是:「重要的特徵必須是內建的或『硬連線的』(hard-wired)…而不是透過統計的方法來學習。

」事後看來,他們的觀點完全錯了。而且,現代神經網路的架構如 Transformer 甚至比當時的捲積網路更通用。但理解他們犯錯的背後原因是很有趣的。

我認為,他們犯錯的原因是深度學習確實與其他學習方法不同。 一個先驗的現像是:深度學習似乎只是多了一個預測模型,像是最近的鄰居或隨機森林。它可能有更多的“旋鈕”(knobs),但這似乎是數量上而不是質量上的差異。用 PW Andreson 的話來說,就是「more is different」(多的就是不同的)。

在物理學中,一旦規模發生了幾個數量級的變化,我們往往只需要一個完全不同的理論就可以解釋,深度學習也是如此。事實上,深度學習與經典模型(參數或非參數)的運行過程是完全不同的,即使從更高的角度看,方程式(和 Python 程式碼)看起來相同。

為了解釋這一點,我們來看兩個非常不同例子的學習過程: 擬合統計模型,與教導學生學習數學。

場景A:擬合統計模型

通常來說,將統計模型與資料進行擬合的步驟如下:

1、我們觀察一些資料x 與y。可將x 視為一個n x p 的矩陣,y 視為一個n 維向量;資料來自一個結構與雜訊模型:每個座標 的得到形式是

的得到形式是 ,其中

,其中 是對應的噪聲,為簡單起見使用了加性噪聲,而

是對應的噪聲,為簡單起見使用了加性噪聲,而 是正確的真實標籤。 )

是正確的真實標籤。 )

2、透過執行某種最佳化演算法,我們可以將模型 擬合到資料中,使

擬合到資料中,使 #的經驗風險最小。也就是說,我們使用最佳化演算法來找到

#的經驗風險最小。也就是說,我們使用最佳化演算法來找到 的最小化數量

的最小化數量

#是一個損失項(捕捉

#是一個損失項(捕捉 距離y 多近),

距離y 多近), 是一個可選的規範化項(試圖使得

是一個可選的規範化項(試圖使得 偏向更簡單的模型)。

偏向更簡單的模型)。

3、我們希望,我們的模型能有良好的整體損失,因為泛化誤差/損失 很小(這個預測是基於實驗數據所在的總體數據來獲得的)。

很小(這個預測是基於實驗數據所在的總體數據來獲得的)。

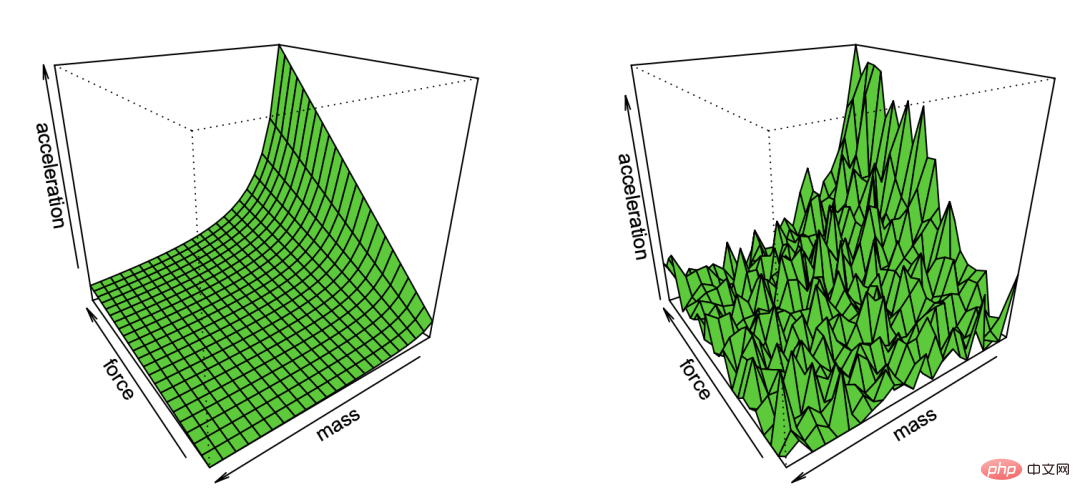

圖註:Bradley Efron經過對噪音的觀察所復現的牛頓第一定律漫畫

這個非常通用的範式包含了許多設置,包括最小平方法線性迴歸、最近鄰、神經網路訓練等等。在經典的統計設定中,我們期望觀察到以下情況:

偏差/變異數權衡:將 F 作為最佳化的模型集。 (當我們處於非凸設定和/或有一個正則器項,我們可以讓F作為這種模型的集合,考慮到演算法選擇和正則器的影響,這些模型可以由演算法以不可忽略的機率實現。)

F 的偏差是對正確標籤的最佳近似,可以透過元素 來實現。 F 的類別越大,偏差越小,當

來實現。 F 的類別越大,偏差越小,當 ,偏差甚至可以是零。然而,當 F 類越大, 則需要越多樣本來縮小其成員範圍,從而演算法輸出模型中的變異數就越大。總體泛化誤差是偏差項和變異數貢獻的總和。

,偏差甚至可以是零。然而,當 F 類越大, 則需要越多樣本來縮小其成員範圍,從而演算法輸出模型中的變異數就越大。總體泛化誤差是偏差項和變異數貢獻的總和。

因此,統計學習通常會顯示偏差/方差權衡,並透過正確模型複雜性的「金髮女孩選擇」來最小化整體誤差。事實上,Geman 等人也是這麼做的,透過說「偏差-方差困境導致的基本限制適用於包括神經網路在內的所有非參數推理模型」來證明他們對神經網路的悲觀情緒是合理的。

更多並非總是最好的。 在統計學習中,獲得更多的特徵或數據並不一定能提高效能。 例如,從包含許多不相關特徵的資料中學習更具挑戰性。類似地,從混合模型中學習,其中資料來自兩個分佈之一(例如 和

和 ),比獨立學習單一更難。

),比獨立學習單一更難。

收益遞減。 在許多情況下,將預測雜訊降低到某個參數 ,其所需的資料點數量在某些參數k 下以

,其所需的資料點數量在某些參數k 下以 ##的形式拓展。在這種情況下,需要大約k 個樣本來“起飛”,而一旦這樣做,則會面臨收益遞減的製度,即假設花耗n 個點來達到(比如)90%的準確度,那麼想要將準確度提高到95%,則大約需要另外3n 個點。一般來說,隨著資源增加(無論是數據、模型的複雜性,還是計算),我們希望捕捉更多更細的區別,而不是解鎖新的品質上的能力。

##的形式拓展。在這種情況下,需要大約k 個樣本來“起飛”,而一旦這樣做,則會面臨收益遞減的製度,即假設花耗n 個點來達到(比如)90%的準確度,那麼想要將準確度提高到95%,則大約需要另外3n 個點。一般來說,隨著資源增加(無論是數據、模型的複雜性,還是計算),我們希望捕捉更多更細的區別,而不是解鎖新的品質上的能力。

對損失、資料的強烈依賴。 在將模型擬合到高維度資料時,一個很小的細節就有可能造成結果的很大差異。統計學家知道,諸如 L1 或 L2 正則化器之類的選擇很重要,更不用說使用完全不同的資料集,不同數量的高維優化器將具有極大的差異性。

資料點沒有自然的「難度」(至少在某些情況下)。 傳統上認為,資料點是獨立於某個分佈進行取樣的。儘管靠近決策邊界的點可能更難分類,但考慮到高維度的測量集中現象,可預期大多數點的距離將存在相似的情況。因此,至少在經典數據分佈中,並不期望點在其難度水平上有很大差異。然而,混合模型可以顯示這種差異的不同難度級別,所以與上述其他問題不同,這種差異在統計設定中不會非常令人驚訝。

場景B:學習數學

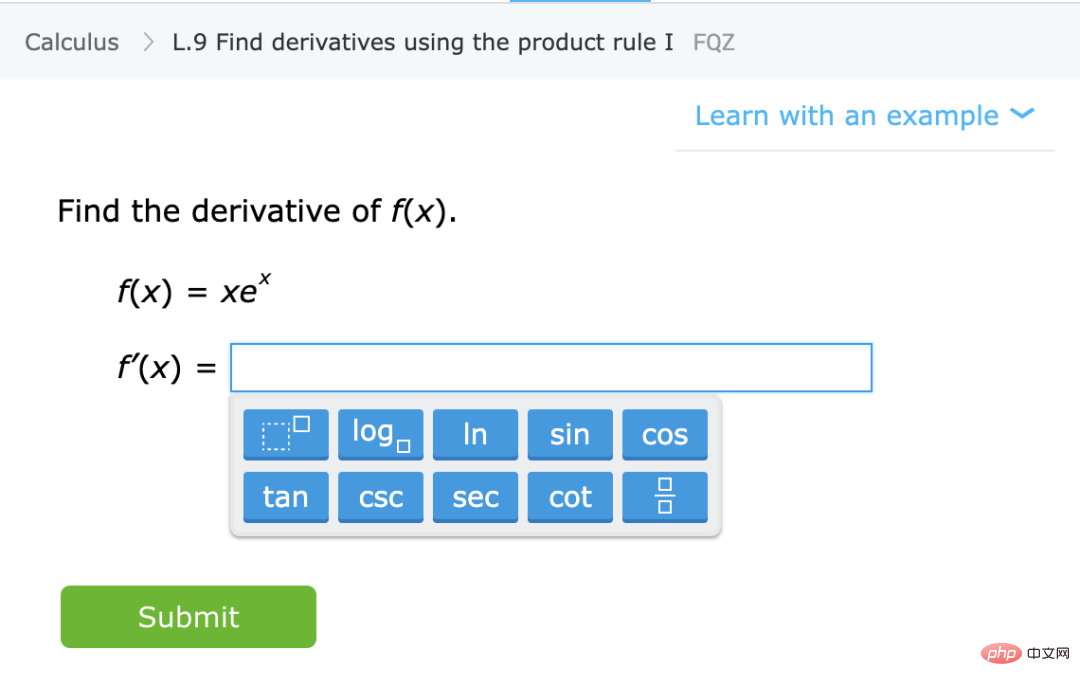

與上述相反,我們來談談教學生一些特定的數學題目(如計算導數),給予他們常規指導及要做的練習。這不是一個正式定義的設置,但可以考慮它的一些定性特徵:

圖註:從IXL 網站學習特定數學技能的練習

學習一項技能,而不是近似分佈。 在這種情況下,學生是學習一種技能,而不是某個數量的估計器/預測器。 雖然定義「技能」不是一項微不足道的任務,但卻是一個性質不同的目標。特別是,即使函數映射練習不能用作解決某些相關任務 X 的“黑盒子”,但我們相信,學生在解決這些問題時所形成的內部表徵,仍是對 X 有用的。

越多越好。 一般來說,學生練習更多問題和不同類型問題,會取得更好的成績。但事實上,「混合模型」——做一些微積分問題和代數問題——不會影響學生在微積分上的表現,反而會幫助他們學習。

「探索」或解鎖功能,轉向自動表示。 雖然在某些時候解決問題也會出現收益遞減,但學生似乎確實經歷了幾個階段,有的階段做一些問題有助於概念「點擊」並解鎖新功能。另外,當學生重複某一特定類型的問題時,他們似乎將自己的能力和對這些問題的表述轉移至較低的水平,使他們能夠對這些問題產生某些以前所沒有的自動性。

效能部分獨立於損失和資料。 教授數學概念的方法不只一種,即使學生使用不同書籍、教育方法或評分系統學習,但最終仍可學習到相同的材料和相似的內部表示。

有些問題更難。 在數學練習中,我們經常可以看到不同學生在解決同一個問題時所採取的方法有強烈的相關性。一個問題的難度似乎是固定的,解決難題的順序也是固定的,這使得學習的過程能夠最佳化。這事實上也是IXL等平台正在做的事情。

4 深度學習比較像統計估計還是學生學習技巧?

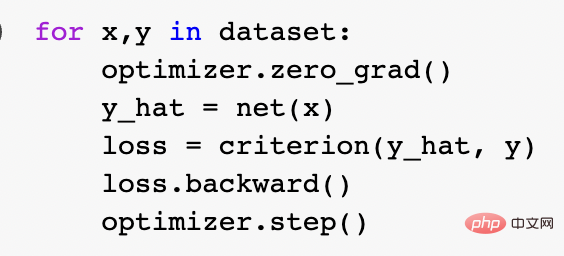

那麼,上述兩個比喻中,哪一個比較恰當地描述了現代深度學習,特別是它如此成功的原因呢?統計模型擬合似乎更符合數學和程式碼。實際上,規範的Pytorch 訓練循環,就是透過如上所述的經驗風險最小化來訓練深度網路的:

## 然而,在更深層次上,這兩種設定之間的關係就沒那麼清楚。具體而言,可以透過修復一個特定的學習任務來展開,使用「自我監督學習 線性探頭(linear probe)」的方法訓練分類演算法,其演算法訓練如下:#

1、假设数据是一个序列 ,其中

,其中 是某个数据点(例如具体的图像)、

是某个数据点(例如具体的图像)、 是一个标签。

是一个标签。

2、首先找到一个深度神经网络来表示函数 ,这个函数的训练只使用数据点

,这个函数的训练只使用数据点 而不使用标签,通过最小化某种类型的自监督损失函数。这种损失函数的例子是重建或画中画(从另一个输入 x 的某些部分恢复)或对比学习(找到

而不使用标签,通过最小化某种类型的自监督损失函数。这种损失函数的例子是重建或画中画(从另一个输入 x 的某些部分恢复)或对比学习(找到 使

使 显著更小,当

显著更小,当 是同一个数据点的增量时,并列关系比两个随机点的并列关系要小得多)。

是同一个数据点的增量时,并列关系比两个随机点的并列关系要小得多)。

3、然后我们使用完整的标记数据 来拟合线性分类器

来拟合线性分类器 (其中 C 是类的数量),使交叉熵损失最小。最终的分类器得出了

(其中 C 是类的数量),使交叉熵损失最小。最终的分类器得出了 的映射。第 3 步仅适合线性分类器,因此“魔法”发生在第 2 步(深度网络的自监督学习)。在自监督学习中,可以看到的一些属性包括:

的映射。第 3 步仅适合线性分类器,因此“魔法”发生在第 2 步(深度网络的自监督学习)。在自监督学习中,可以看到的一些属性包括:

学习一项技能,而不是逼近一个函数。自监督学习不是逼近一个函数,而是学习可用于各种下游任务的表示。假设这是自然语言处理中的主导范式,那么下游任务是通过线性探测、微调还是提示获得,都是次要的。

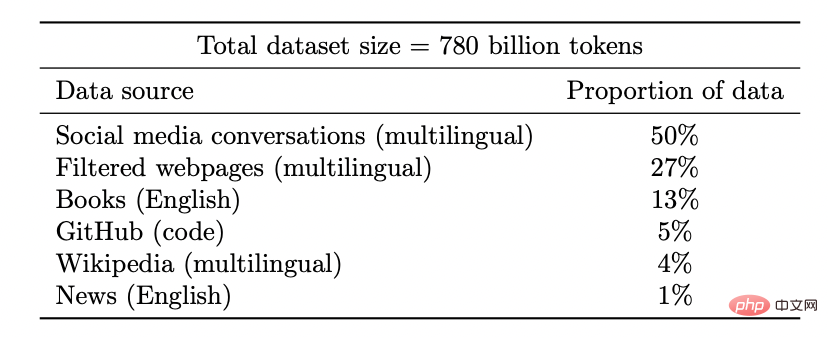

越多越好。在自监督学习中,表征的质量随着数据量的增加而提高。而且,数据越多样越好。

图注:谷歌 PaLM 模型的数据集

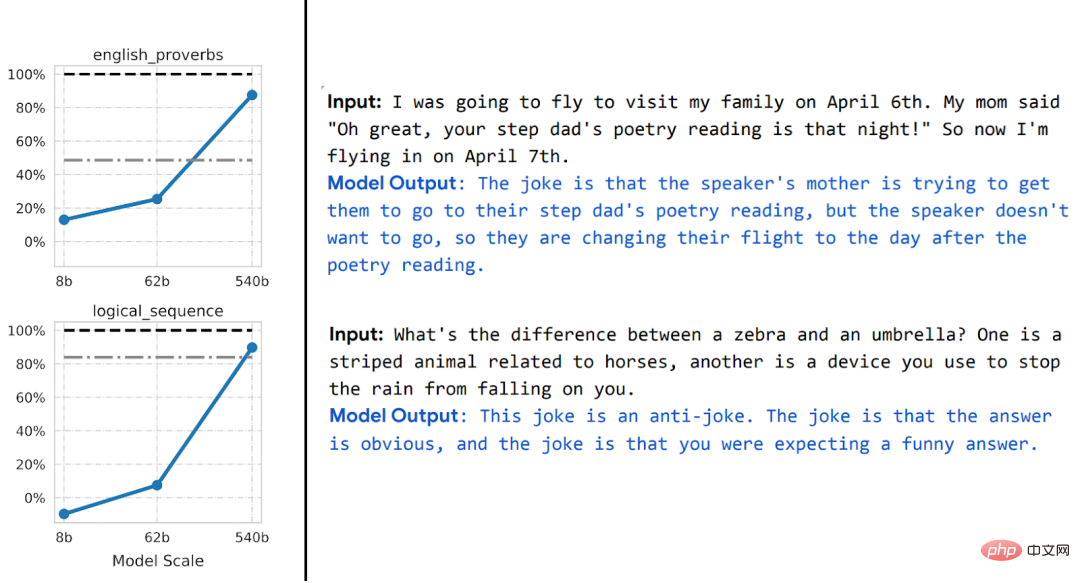

解锁能力。随着资源(数据、计算、模型大小)的拓展,深度学习模型的不连续改进一次又一次地被看到,这在一些合成环境中也得到了证明。

圖註:隨著模型大小的增加,PaLM 模型在一些基準測試中顯示出一些不連續的改進(上述圖中只有三個大小的警告),並解鎖了一些令人驚訝的功能,例如解釋笑話。

效能在很大程度上與損失或資料無關。 不只一種自監督損失,有幾種對比性和重建性損失被用於影像。語言模型有時會採用單面重建(預測下一個標記),有時則是使用遮蔽模型,其目標是預測來自左右標記的遮蔽輸入。

也可以使用稍微不同的資料集,這可能會影響效率,但只要做出「合理」的選擇,常規情況下,原始資源比使用的特定損失或資料集更能預測效能。

有些實例比其他實例更難。 這一點不限於自監督學習,數據點或存在一些固有的「難度等級」。

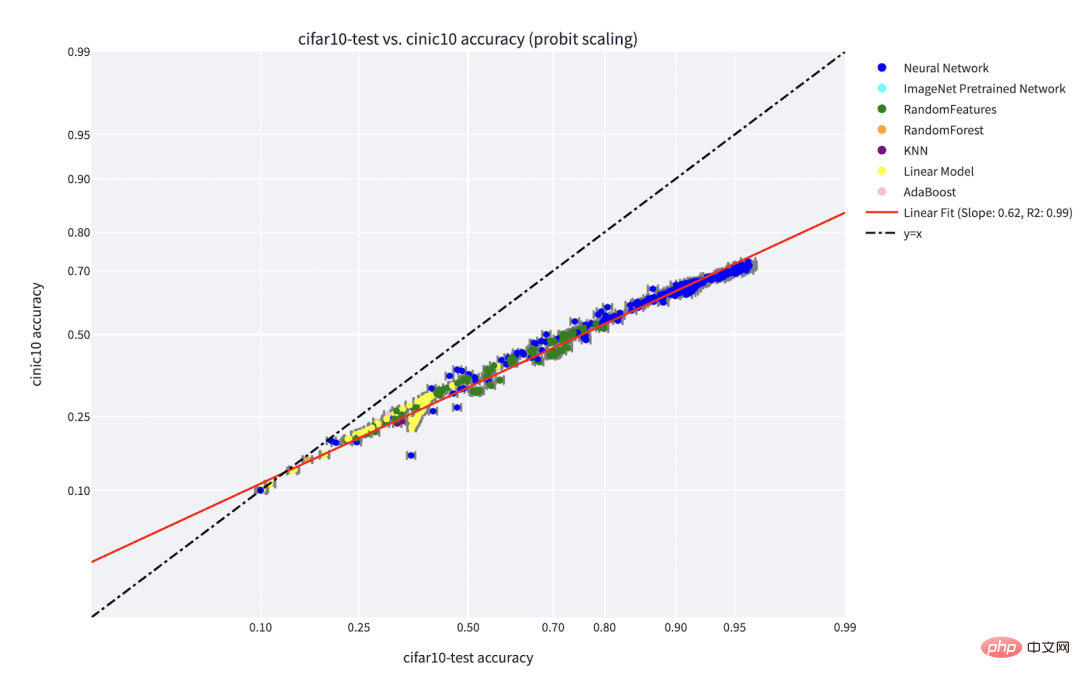

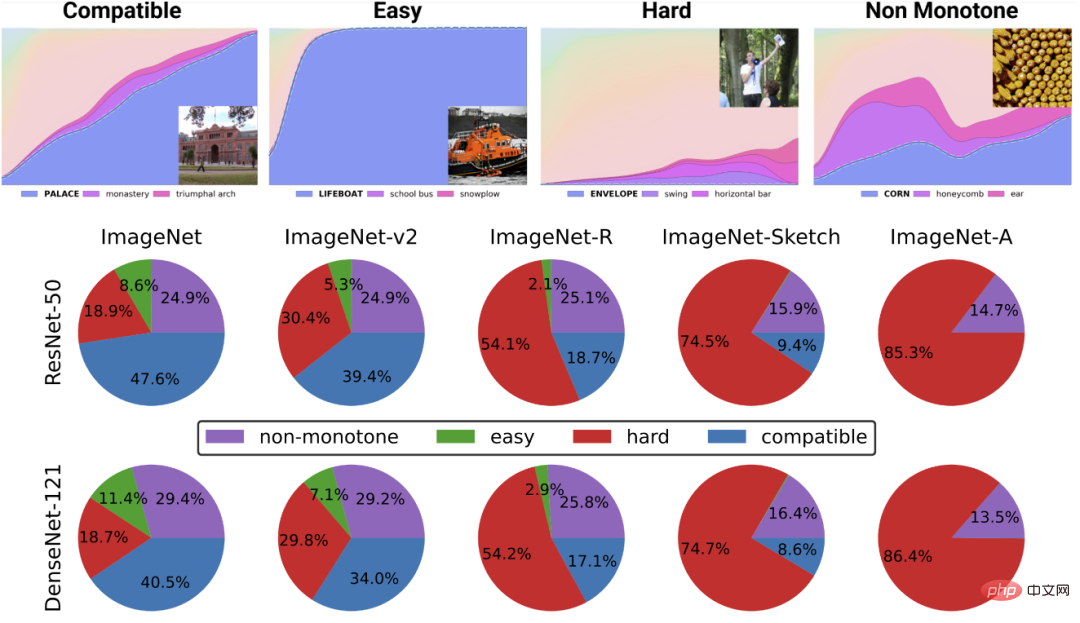

事實上,有幾個實際證據表明,不同的學習演算法有不同的“技能水平”,不同的點有不同的“難度水平” (分類器f 對x 進行正確分類的機率,隨著f 的技能單向遞增,隨x 的難度單向遞減)。 「技能與難度」典範是對Recht 和 Miller 等人所發現的「線上準確度」現象最清楚的解釋,在我同Kaplun、Ghosh、Garg 和Nakkiran 的合著論文中,也展示了資料集中的不同輸入如何具有固有的“難度特徵”,常規情況下,該特徵似乎對不同的模型來說是穩健的。

圖註:Miller 等人的圖表顯示了在CIFAR-10 上訓練並在CINIC-10 上測試的分類器的線現象準確性

圖註:將資料集解構為來自Kaplun 和Ghosh 等人在論文「Deconstructing Distributions: A Pointwise Framework of Learning」中的不同「難度概況」點,以獲得越來越多的資源分類器。頂部圖表描述了最可能類別的不同 softmax 機率,作為由訓練時間索引的某個類別分類器的全局精度的函數;底部餅圖展示了將不同資料集分解為不同類型的點。值得注意的是,這種分解對於不同的神經架構是相似的。

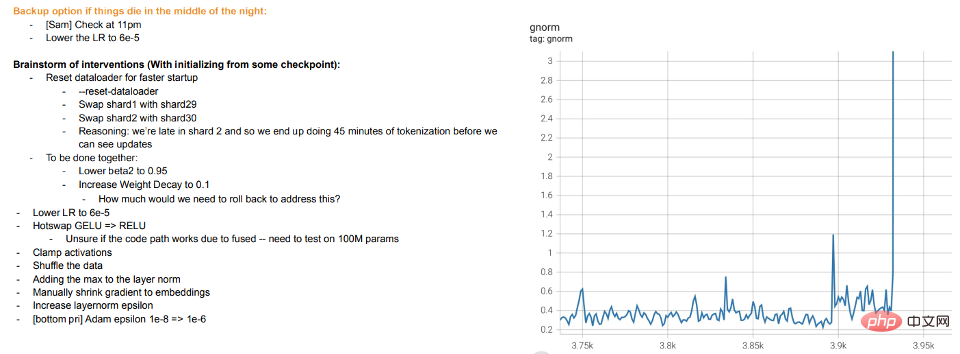

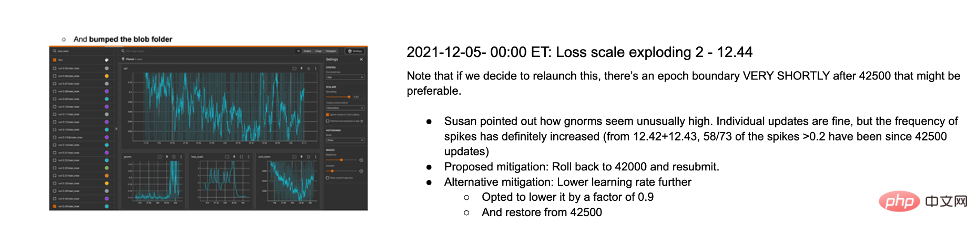

訓練即教學。 現代對大模型的訓練似乎更像是在教學生,而不是讓模型適應數據,在學生不理解或看起來疲勞(訓練偏離)時採取「休息」或嘗試其他方式。 Meta 大模型的訓練日誌很有啟發性——除了硬體問題外,還可以看到一些幹預措施,例如在訓練過程中切換不同的最佳化演算法,甚至考慮「熱交換」激活函數(GELU 到 RELU)。如果將模型訓練視為擬合資料而不是學習表示,則後者沒有多大意義。

圖註:Meta 的訓練日誌片段以下探討兩種情況:

情況1:監督學習

到目前為止,我們只討論了自監督學習,但深度學習的典型例子仍然是監督學習,畢竟深度學習的「ImageNet時刻」是來自ImageNet。那麼,我們上面所探討的內容是否適用於監督式學習呢?

首先,有監督的大規模深度學習的出現,在某種程度上是一個歷史性的意外,這得益於大型高品質標記資料集(即 ImageNet)的可用性。 可以想像另一種歷史:深度學習首先透過無監督學習在自然語言處理方面取得突破性進展,然後才轉移到視覺和監督學習中。

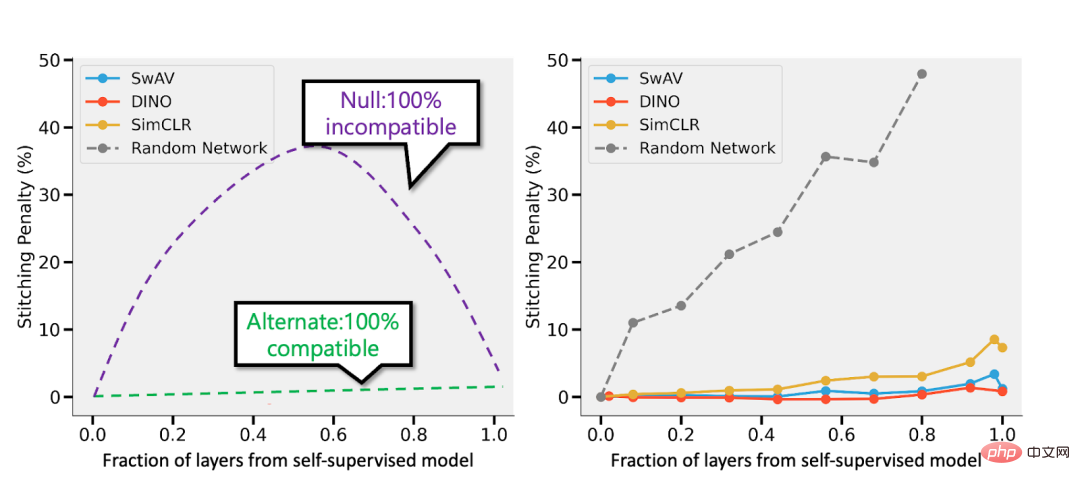

其次,有一些證據表明,即使監督學習與自監督學習使用完全不同的損失函數,它們在「幕後」的行為也相似。兩者通常都能達到相同的性能。 在「Revisiting Model Stitching to Compare Neural Representations」這篇論文中也發現,它們學習了相似的內部表示。具體來說,對於每一個 ,都可以將透過自監督訓練的深度d 模型的首k 層數與監督模型的最後d-k 層數「縫合」起來,並且使性能幾乎保持原有水平。

,都可以將透過自監督訓練的深度d 模型的首k 層數與監督模型的最後d-k 層數「縫合」起來,並且使性能幾乎保持原有水平。

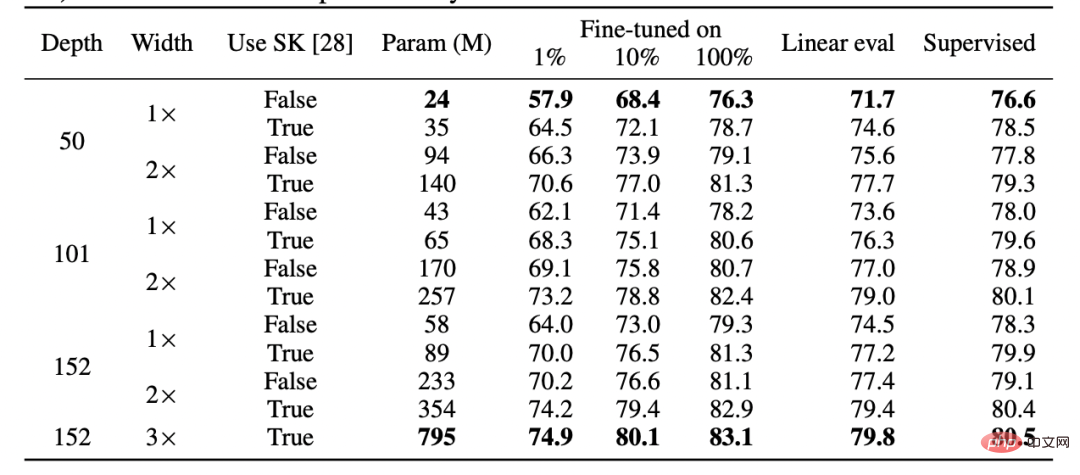

圖註:來自 Hinton 團隊論文「Big Self-Supervised Models are Strong Semi-Supervised Learners」的表格。請注意監督學習、微調(100%) 自監督和自監督線性探測在性能上的普遍相似性

# #圖註:摘自論文「Revisiting Model Stitching to Compare Neural Representations」的自監督與監督模型。左圖-如果自監督模型的準確度比監督模型低3%,那麼,完全相容的表示將造成 p·3% 的拼接懲罰(p層來自自監督模型時)。如果模型完全不相容,那麼隨著更多模型的縫合,預計準確度會急劇下降。右圖-拼接不同自監督模型的實際結果。

自監督簡單模型的優點在於,它們可以將特徵學習或「深度學習魔法」(深度表示函數的結果)與統計模型擬合(由線性或其他“簡單”分類器完成,分離出來在此表示之上)

。 最後,雖然推測,但「元學習」似乎通常等同於學習表示這一事實(詳情看論文「Rapid Learning or Feature Reuse? Towards Understanding the Effectiveness of MAML」),可以視為另一個支持本文觀點的證據,不管模型表面上最佳化的目標是什麼。

情況2:過度參數化

情況2:過度參數化

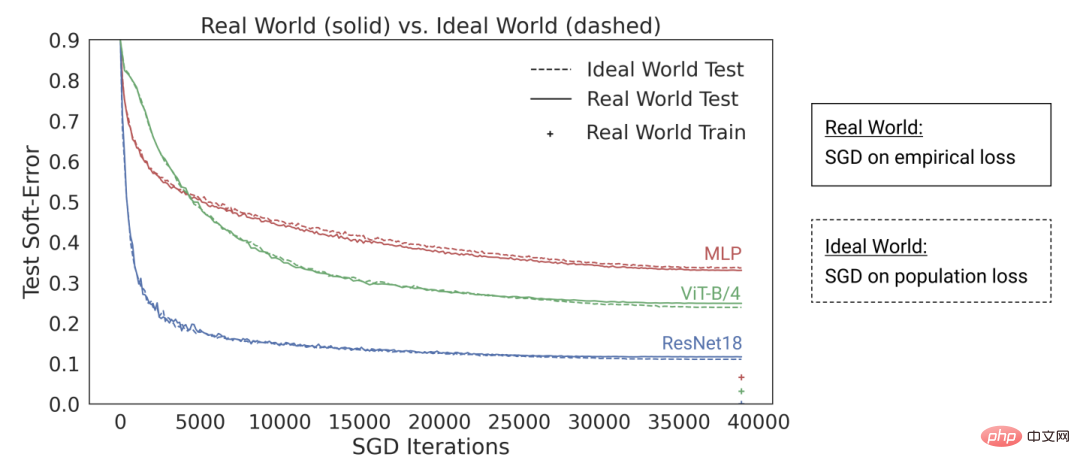

圖註:在「The Deep Bootstrap Framework: Good Online Learners are Good Offline Generalizers」這篇論文中,研究者的發現表明,如今的深度學習架構在「過度參數化」與「欠採樣」狀態下表現相似(其中,模型在有限資料上訓練多代,直到過度擬合:也就是上圖所示的「真實世界」),在「參數化不足」與「線上」情況下也如此(其中,模型只訓練一代,每個樣本只看到一次:也就是上圖中的「理想世界」)

5 總結

毫無疑問,統計學習在深度學習中扮演著重要的角色。但是,如果僅僅將深度學習視為比經典模型擬合更多旋鈕(knobs)的模型,則會忽略其成功背後的許多因素。所謂的「人類學生」隱喻更是不恰當表述。

深度學習與生物演化相似,雖然對同一規則(即經驗損失的梯度下降)有許多重複的應用,但會產生高度複雜的結果。在不同的時間內,神經網路的不同組成部分似乎會學習不同的內容,包括表示學習、預測擬合、隱式正則化和純噪音等。目前我們仍在尋找正確的視角來提出有關深度學習的問題,更別說回答這些問題了。

任重道遠,與君共勉。

以上是理論計算機科學家 Boaz Barak:深度學習並非'簡單的統計”,二者距離已越來越遠的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

Python中使用BERT進行情感分析的方法及步驟

Jan 22, 2024 pm 04:24 PM

Python中使用BERT進行情感分析的方法及步驟

Jan 22, 2024 pm 04:24 PM

BERT是由Google在2018年提出的一種預先訓練的深度學習語言模式。全稱為BidirectionalEncoderRepresentationsfromTransformers,它基於Transformer架構,具有雙向編碼的特性。相較於傳統的單向編碼模型,BERT在處理文字時能夠同時考慮上下文的訊息,因此在自然語言處理任務中表現出色。它的雙向性使得BERT能夠更好地理解句子中的語義關係,從而提高了模型的表達能力。透過預訓練和微調的方法,BERT可以用於各種自然語言處理任務,如情緒分析、命名

YOLO不死! YOLOv9出爐:性能速度SOTA~

Feb 26, 2024 am 11:31 AM

YOLO不死! YOLOv9出爐:性能速度SOTA~

Feb 26, 2024 am 11:31 AM

如今的深度學習方法專注於設計最適合的目標函數,以使模型的預測結果與實際情況最接近。同時,必須設計一個合適的架構,以便為預測取得足夠的資訊。現有方法忽略了一個事實,當輸入資料經過逐層特徵提取和空間變換時,大量資訊將會遺失。本文將深入探討資料透過深度網路傳輸時的重要問題,即資訊瓶頸和可逆函數。基於此提出了可編程梯度資訊(PGI)的概念,以應對深度網路實現多目標所需的各種變化。 PGI可以為目標任務提供完整的輸入訊息,以計算目標函數,從而獲得可靠的梯度資訊以更新網路權重。此外設計了一種新的輕量級網路架

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

潛藏空間嵌入:解釋與示範

Jan 22, 2024 pm 05:30 PM

潛藏空間嵌入:解釋與示範

Jan 22, 2024 pm 05:30 PM

潛在空間嵌入(LatentSpaceEmbedding)是將高維度資料對應到低維度空間的過程。在機器學習和深度學習領域中,潛在空間嵌入通常是透過神經網路模型將高維輸入資料映射為一組低維向量表示,這組向量通常被稱為「潛在向量」或「潛在編碼」。潛在空間嵌入的目的是捕捉資料中的重要特徵,並將其表示為更簡潔和可理解的形式。透過潛在空間嵌入,我們可以在低維空間中對資料進行視覺化、分類、聚類等操作,從而更好地理解和利用資料。潛在空間嵌入在許多領域中都有廣泛的應用,如影像生成、特徵提取、降維等。潛在空間嵌入的主要

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

在當今科技日新月異的浪潮中,人工智慧(ArtificialIntelligence,AI)、機器學習(MachineLearning,ML)與深度學習(DeepLearning,DL)如同璀璨星辰,引領著資訊科技的新浪潮。這三個詞彙經常出現在各種前沿討論和實際應用中,但對於許多初涉此領域的探索者來說,它們的具體含義及相互之間的內在聯繫可能仍籠罩著一層神秘面紗。那讓我們先來看看這張圖。可以看出,深度學習、機器學習和人工智慧之間存在著緊密的關聯和遞進關係。深度學習是機器學習的一個特定領域,而機器學習

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

自2006年深度學習概念被提出以來,20年快過去了,深度學習作為人工智慧領域的一場革命,已經催生了許多具有影響力的演算法。那麼,你所認為深度學習的top10演算法有哪些呢?以下是我心目中深度學習的頂尖演算法,它們在創新、應用價值和影響力方面都佔有重要地位。 1.深度神經網路(DNN)背景:深度神經網路(DNN)也叫多層感知機,是最普遍的深度學習演算法,發明之初由於算力瓶頸而飽受質疑,直到近些年算力、數據的爆發才迎來突破。 DNN是一種神經網路模型,它包含多個隱藏層。在該模型中,每一層將輸入傳遞給下一層,並

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显著的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效

使用CNN和Transformer混合模型以提升效能的方法

Jan 24, 2024 am 10:33 AM

使用CNN和Transformer混合模型以提升效能的方法

Jan 24, 2024 am 10:33 AM

卷積神經網路(CNN)和Transformer是兩種不同的深度學習模型,它們在不同的任務上都展現了出色的表現。 CNN主要用於電腦視覺任務,如影像分類、目標偵測和影像分割等。它透過卷積操作在影像上提取局部特徵,並透過池化操作進行特徵降維和空間不變性。相較之下,Transformer主要用於自然語言處理(NLP)任務,如機器翻譯、文字分類和語音辨識等。它使用自註意力機制來建模序列中的依賴關係,避免了傳統的循環神經網路中的順序計算。儘管這兩種模型用於不同的任務,但它們在序列建模方面有相似之處,因此