幾天前,Meta AI 聯合Papers with Code 發布了大型語言模型Galactica,該模型的一大特點就是解放你的雙手,代筆幫你寫論文,寫的論文有多完整呢?摘要、導論、公式、參考文獻等統統都有。

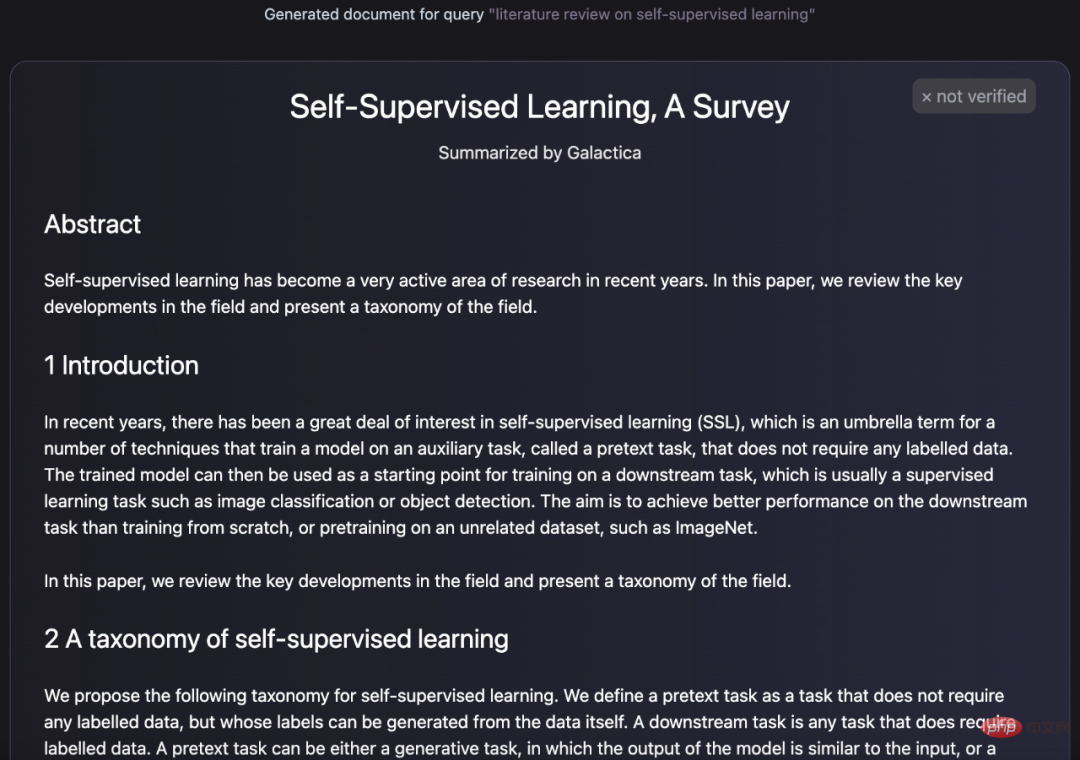

就像下面這樣,Galactica 產生的文字看起來就是一篇論文的配置:

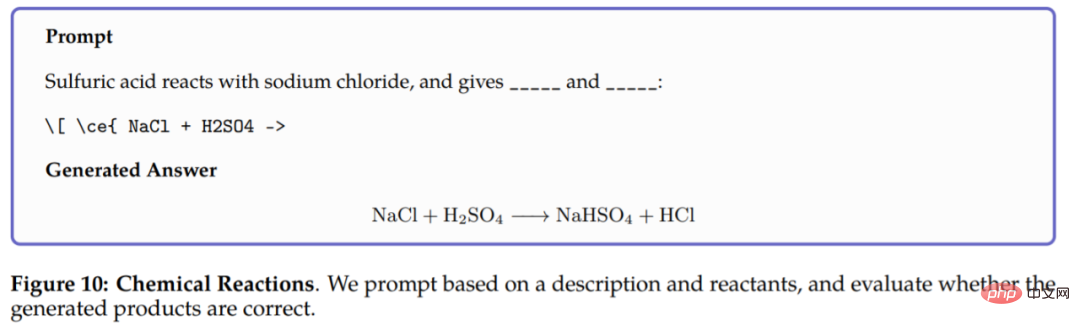

不只產生論文,Galactica 也可以產生詞條的百科查詢、對所提問題作出知識性的回答,除了文本生成外,Galactica 還可以執行涉及化學公式和蛋白質序列的多模態任務。例如在化學反應中,要求Galactica 在化學方程式LaTeX 中預測反應的產物,模型僅根據反應物就能進行推理,結果如下:

##為了方便使用者體驗這項研究,團隊也專門上線了試用版。如下圖,幾天前介面還顯示輸入、生成等功能。

(先前版本)Galactica 試用版網址:https://galactica.org/

短短幾天,它的介面變成這樣,已經不能輸入。

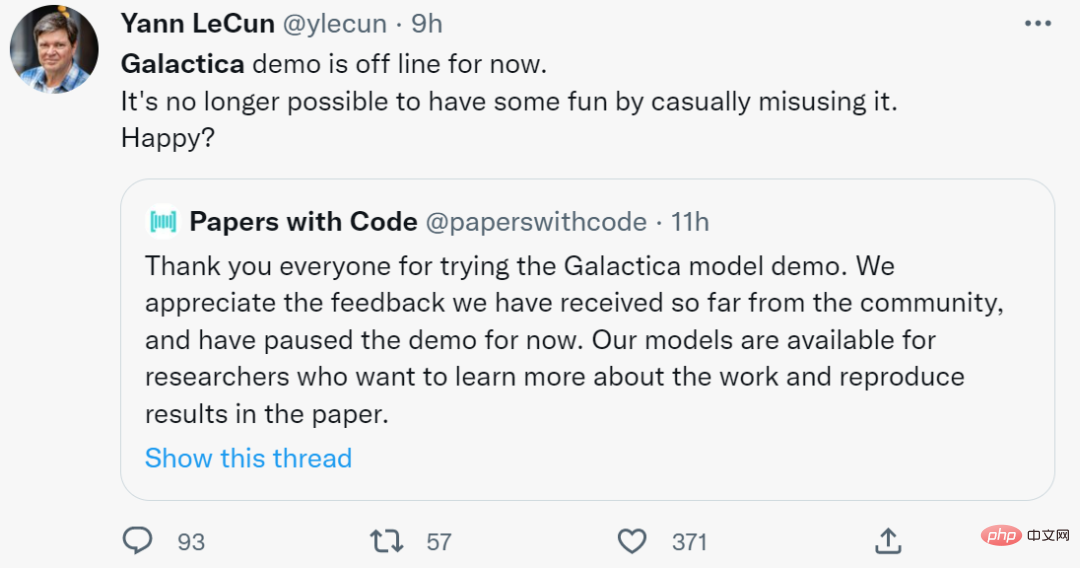

根據 Papers with Code 說法,他們從社群收到一些回饋,已經暫停 Galactica 的 Demo 示範功能。前兩天還在推特發文稱讚的圖靈獎得主 Yann LeCun ,今天就很無奈的說了一句,再也不能從中獲得快樂了,開心嗎?

不過與極力推崇該研究的人相比,有網友提出一些反對意見,與其帶來的好處相比,Galactica 會帶來更多負面後果,想想這對學生寫論文會有什麼影響。

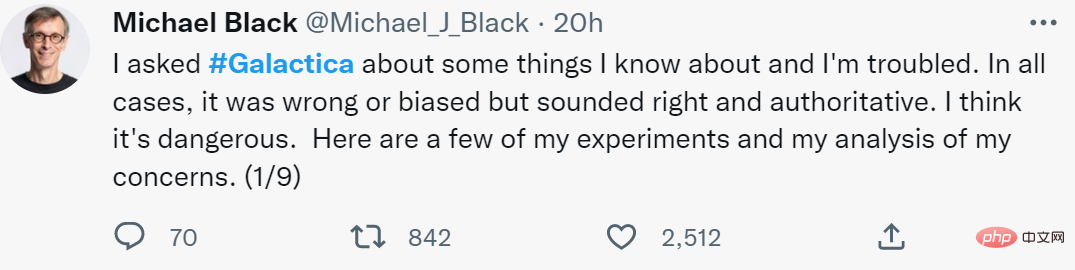

與學生用它來寫論文相比,下面這位網友發現的問題就更嚴重了。

「我問了Galactica 一些問題,它的回答都是錯誤或有偏見的,但聽起來是正確和權威的。」在一系列實驗後,推特用戶Michael Black 表示:「Galactica 產生的文字合乎語法,讓人感覺真實。其所產生的文章會變成真正的科學論文。這篇文章可能是正確的,但也可能是錯誤的或有偏見的,很難被發現,從而影響人們的思維方式。」

「它提供了聽起來是權威的科學,但沒有科學方法的基礎。Galactica 根據科學寫作的統計特性產生偽科學,很難區分真假。這可能會開啟一個深度科學造假的時代。這些被生成的論文將被其他人在真實的論文中引用。這將會是一團亂麻。我讚賞這個計畫的初衷,但提醒大家還是要注意,這不是科學的加速器,甚至不是科學寫作的有用工具。這對科學來說是潛在的扭曲和危險。」

Michael Black 回答部分截圖。連結:https://twitter.com/Michael_J_Black/status/1593133722316189696

##發現Galactica 存在不嚴謹、生成偽科學文章等問題的不只Michael Black,其他網友也發現了這個缺陷。下面我們來看看網友的其他評論。

引起爭議Galactica 試用版上線後,許多學者卻對此提出了疑義。

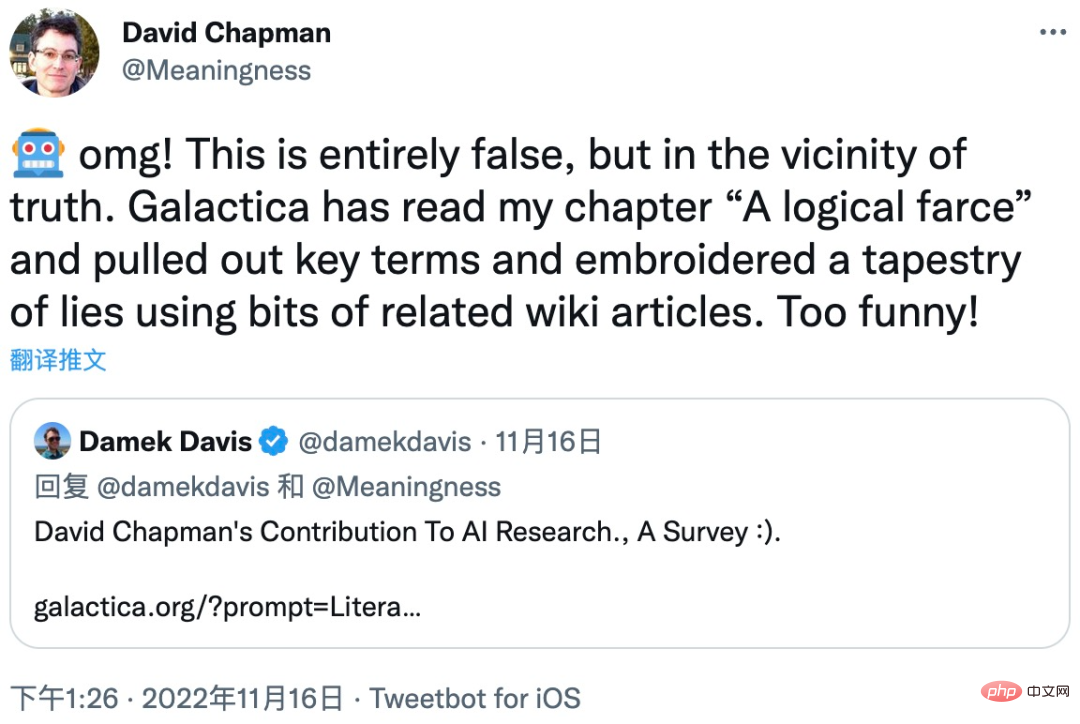

一位名叫David Chapman 的AI 學者指出語言模型應該是整理合成語言的,而不是生成知識:

David Chapman 用自己的一篇論文為例說明了這個問題的嚴重性。 Galactica 模型提取了論文中「A logical farce」部分的關鍵術語,然後使用一些相關的維基百科文章,最後編輯合成出一篇錯漏百出的文章。

知名AI 學者、Robust.AI 創始人Gary Marcus 也對Galactica 模型表達了強烈的質疑:「大型語言模型(LLM)混淆數學和科學知識有點可怕。高中生可能會喜歡它,並用它來愚弄他們的老師。這應該令我們感到擔憂。」

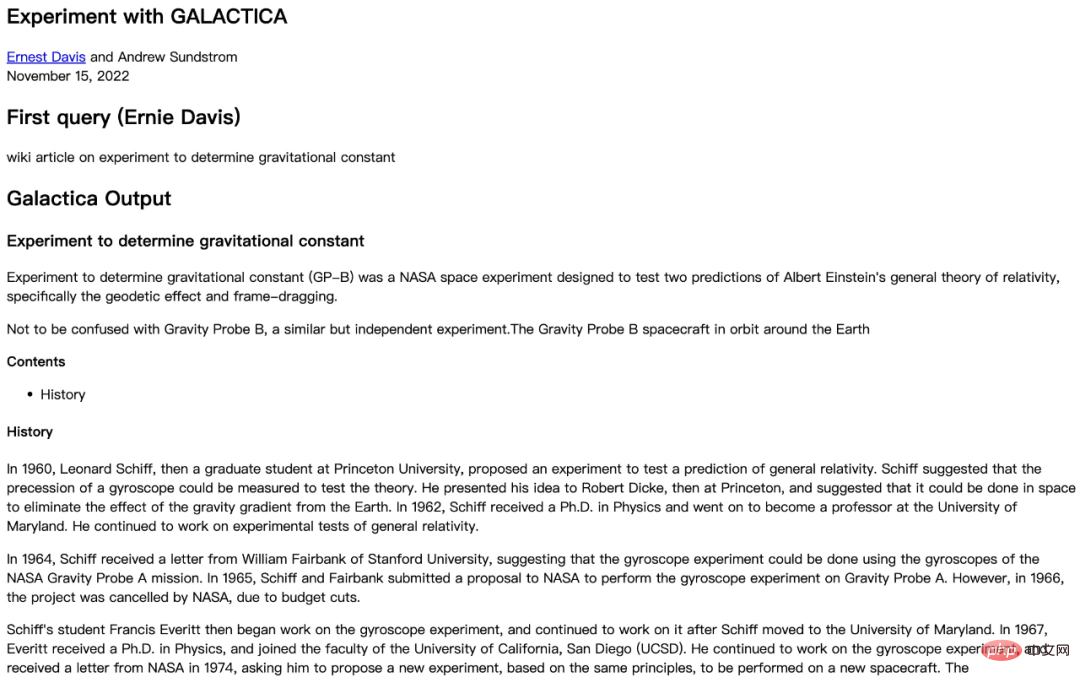

來自紐約大學計算機科學系的學者們也測試了Galactica 模型的生成結果,發現Galactica 答非所問:

#圖源:https://cs.nyu.edu/~davise/papers/ ExperimentWithGalactica.html

首先,在這個實驗中,Galactica 模型的回答的確包含一些正確的訊息,例如:

不僅如此,Galactica 模型的回答中還有一些細節出現了事實性錯誤:

紐約大學的這項實驗非常具體明確地說明了Galactica 模型的生成結果存在嚴重的錯誤,並且該研究進行了多個不同問題的實驗,每一次Galactica 的回答都是錯漏百出的。這說明Galactica 產生錯誤訊息的情況絕非偶然。 ##紐約大學實驗報告:https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html 面對Galactica 的失敗,有網友將其歸因於深度學習的限制:「深度學習的本質是從資料中學習,這本來就不同於人類的智能,根本無法實現通用人工智慧(AGI)」。 關於深度學習未來的發展眾說紛紜。但毫無疑問的是,Galactica 這種錯誤地產生「知識」的語言模型是不可取的。

以上是上線僅兩天,AI大模型寫論文網站光速下架:不負責任的胡編亂造的詳細內容。更多資訊請關注PHP中文網其他相關文章!