谷歌搶先手發布影片生成類AIGC,網友:可以客製化電影了

我們知道,生成模型和多模態視覺語言模型的進展已經為具備前所未有生成真實性和多樣性的大型文本到圖像模型鋪平了道路。這些模型提供了新的創作過程,但僅限於合成新圖像而不是編輯現有圖像。為了彌合這一差距,基於文字的直觀編輯方法可以對生成和真實圖像進行基於文字的編輯,並保留這些圖像的一些原始屬性。與圖像類似,近來文本到視頻模型也提出了很多,但使用這些模型進行視頻編輯的方法卻很少。

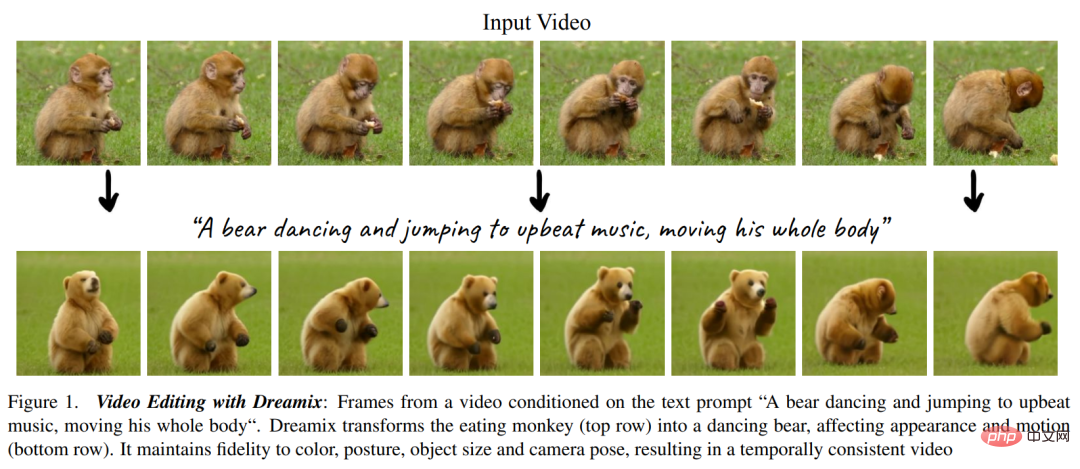

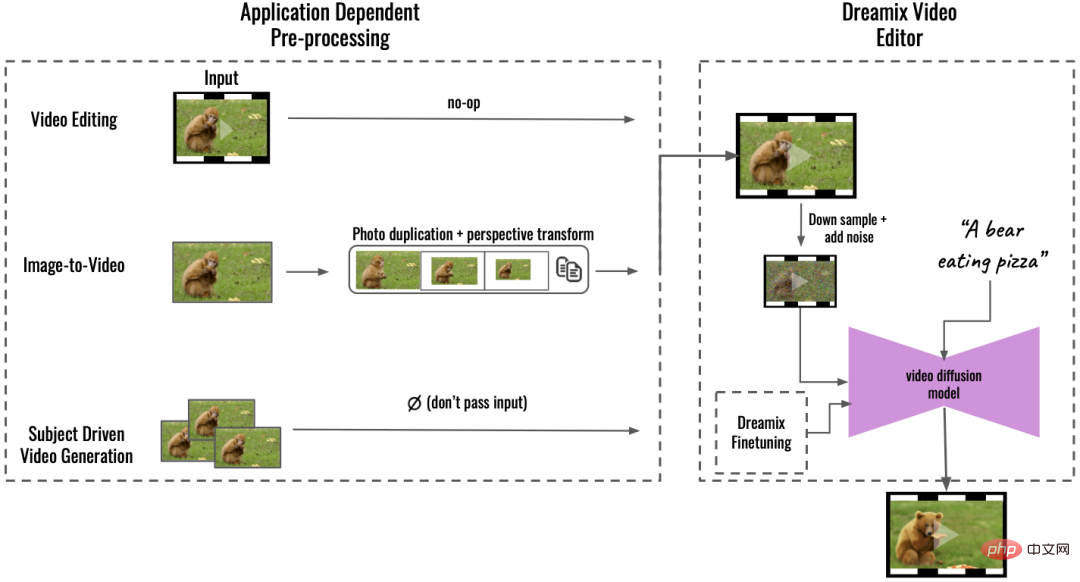

在文字指導的影片編輯中,使用者提供輸入影片以及描述產生影片預期屬性的文字 prompt,如下圖 1 所示。目標有以下三個方面,1)對齊,編輯後的視頻應符合輸入文本prompt;2)保真度,編輯後的視頻應保留原始視頻的內容,3)質量,編輯後的視頻應具備高質量。

可以看到,影片編輯比影像編輯更具挑戰性,它需要合成新的動作,而不僅僅是修改視覺外觀。另外還需要保持時間上的一致性。因此,將 SDEdit、Prompt-to-Prompt 等影像層級的編輯方法應用於視訊幀上不足以實現良好的效果。

#在近日谷歌研究院等發表在arXiv 的一篇論文中,研究者提出了一種新方法Dreamix,它受到了UniTune 的啟發,將文字條件視訊擴散模型(video diffusion model, VDM)應用於影片編輯。

- #論文網址:https://arxiv.org/ pdf/2302.01329.pdf

- #專案首頁:https://dreamix-video-editing.github.io/

#文中方法的核心是透過以下兩個主要想法來讓文字條件VDM 保持對輸入影片的高保真度。其一不使用純噪聲作為模型初始化,而是使用原始視頻的降級版本,通過縮小尺寸和添加噪聲僅保留低時空信息;其二通過微調原始視頻上的生成模型來進一步提升對原始視頻的保真度。

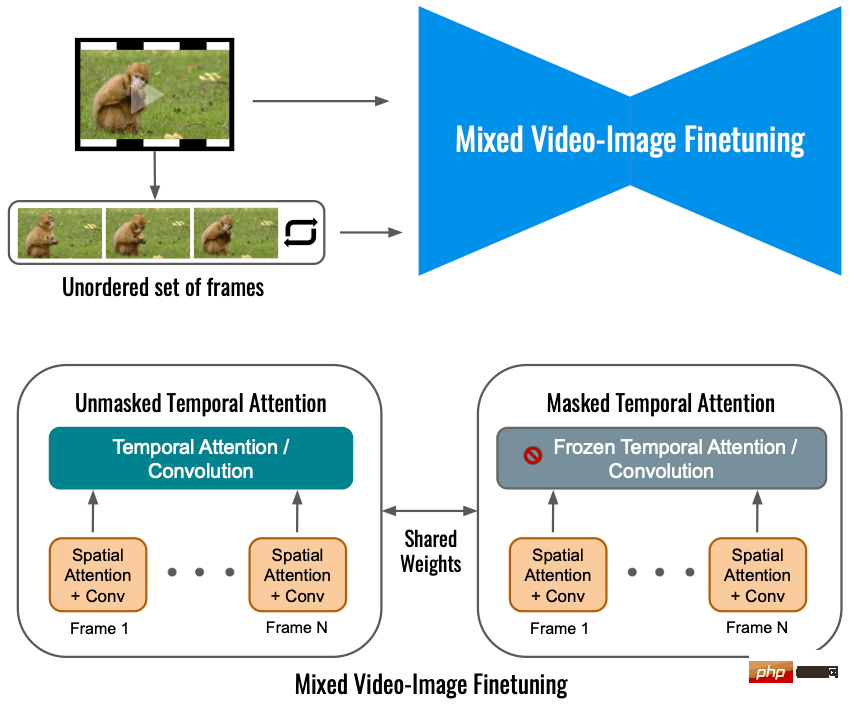

微調確保模型了解原始影片的高解析度屬性。輸入影片的簡單微調會促成相對較低的運動可編輯性,這是因為模型學會了更傾向於原始運動而不是遵循文字 prompt。研究者提出了一種新穎的混合微調方法,其中 VDM 也在輸入視訊各個幀的集合上進行微調,並丟棄了它們的時序。混合微調顯著提升了運動編輯的品質。

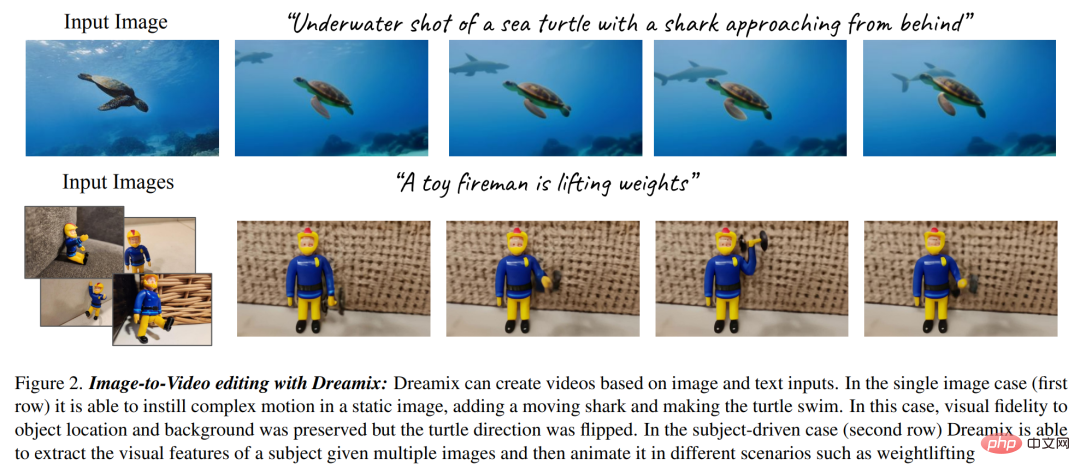

研究者進一步利用其影片編輯模型提出了一個新的圖像動畫框架,如下圖 2 所示。該框架包含了幾個步驟,例如為圖像中的物件和背景設定動畫、創建動態相機運動等。他們透過幀複製或幾何圖像變換等簡單的圖像處理操作來實現,從而創建粗糙的視訊。接著使用 Dreamix 影片編輯器對影片進行編輯。此外研究者也使用其微調方法進行目標驅動的影片生成,也即 Dreambooth 的影片版本。

#在實驗展示部分,研究者進行了廣泛的質性研究和人工評估,展現了他們方法的強大能力,具體可參考如下動圖。

#對於Google這項研究,有人表示,3D 運動和編輯工具可能是下一波論文的熱門主題。

還有人表示:大家可以很快在預算內製作自己的電影了,你所需要的只是一個綠幕以及這項技術:

#方法概覽

#本文提出了一種新的方法用於影片編輯,具體而言:

透過逆向被破壞影片進行文字引導影片編輯

#他們採用級聯VDM(Video Diffusion Models ),先透過下取樣對輸入視訊就行一定的破壞,然後再加入雜訊。接下來是級聯擴散模型用於採樣過程,並以時間 t 為條件,將視訊升級到最終的時間 - 空間解析度。

在對輸入視訊進行破壞處理的這一過程中,首先需要進行下採樣操作,以得到基礎模型(16 幀24 × 40),然後加入方差為 高斯噪聲,從而進一步破壞輸入視訊。

高斯噪聲,從而進一步破壞輸入視訊。

對於上述處理好的視頻,接下來的操作是使用級聯VDM 將損壞的低解析度視頻映射到與文字對齊的高分辨率視頻。這裡的核心思想是,給定一個嘈雜的、時間空間分辨率非常低的視頻,有許多完全可行的、高分辨率的視頻與之對應。本文中基礎模型從損壞的影片開始,它與時間 s 的擴散過程具有相同的雜訊。然後研究用 VDM 來逆向擴散過程直到時間 0。最後透過超解析度模型對影片進行升級。

混合視訊影像微調

#僅利用輸入視訊進行視訊擴散模型的微調會限制物體運動變化,相反,該研究使用了一種混合目標,即除了原始目標(左下角)之外,本文還對無序的幀集進行了微調,這是透過「masked temporal attention」來完成的,以防止時間注意力和卷積被微調(右下)。這種操作允許向靜態影片中添加運動。

推理

##推理

######實驗結果#########影片編輯:下圖中Dreamix 將動作改為舞蹈,外觀由猴子變成熊,但影片中主體的基本屬性沒有改變:#######

圖片到影片:當輸入是圖片時,Dreamix 可以使用其影片先驗新增新的移動對象,如下圖中添加了在有霧的森林中出現一頭獨角獸,並放大。

已出現企鵝在小屋旁邊:

目標驅動影片產生:Dreamix 還可以取得顯示相同主題的圖片集合,並以此主題為運動物件產生新的影片。如下圖是一條在葉子上蠕動的毛毛蟲:

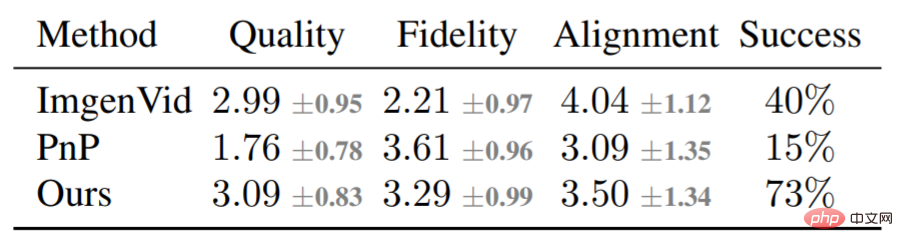

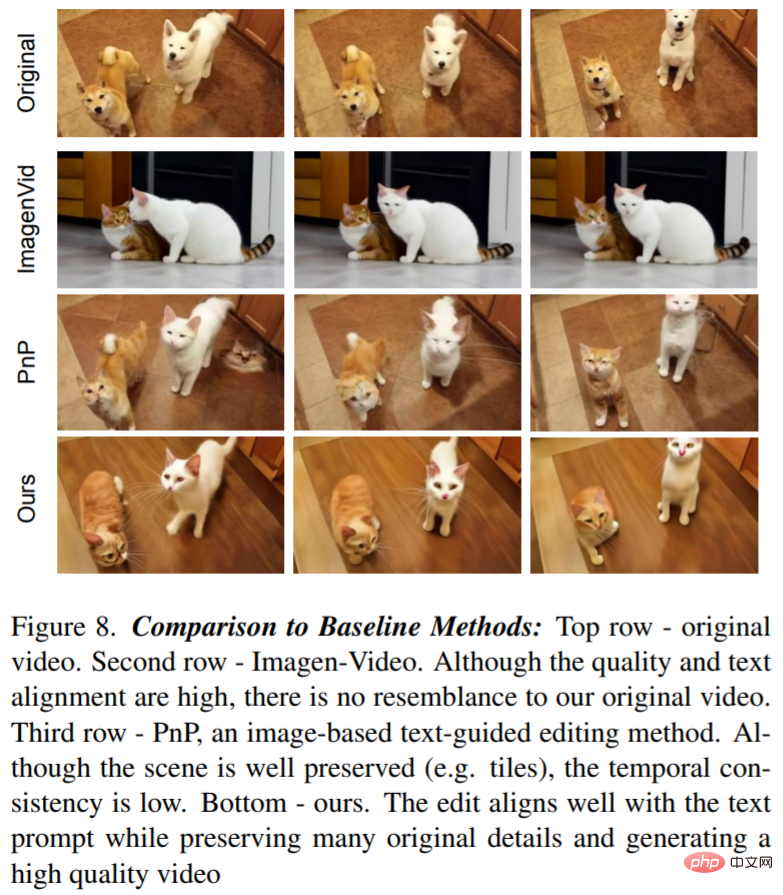

除了定性分析外,該研究還進行了基線比較,主要是將Dreamix與Imagen-Video、 Plug-and-Play (PnP) 兩種基線方法進行比較。下表為評分結果:

#圖8 展示了Dreamix 編輯的影片和兩個基準範例:文字到視訊模型實現了低保真度的編輯,因為它不以原始影片為條件。 PnP 保留了場景,但不同影格之間缺乏一致性;Dreamix 在這三個目標上都表現良好。

# 更多技術細節請參閱原始論文。

以上是谷歌搶先手發布影片生成類AIGC,網友:可以客製化電影了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

視訊檔案儲存在瀏覽器快取中的位置在哪裡?

Feb 19, 2024 pm 05:09 PM

視訊檔案儲存在瀏覽器快取中的位置在哪裡?

Feb 19, 2024 pm 05:09 PM

瀏覽器快取影片在哪個資料夾在日常使用網路瀏覽器時,我們經常會觀看各種線上視頻,例如在YouTube上看音樂影片或在Netflix上觀看電影等。而這些影片在載入過程中會被瀏覽器快取下來,以便日後再次播放時能夠快速載入。那麼問題來了,這些快取的影片實際上儲存在哪個資料夾中呢?不同瀏覽器的快取視訊資料夾保存位置是不同的。以下我們將分別介紹幾種常見的瀏覽器以及它們

抖音發布他人影片侵權嗎?它怎麼剪輯影片不算侵權?

Mar 21, 2024 pm 05:57 PM

抖音發布他人影片侵權嗎?它怎麼剪輯影片不算侵權?

Mar 21, 2024 pm 05:57 PM

隨著短影片平台的興起,抖音成為了大家日常生活中不可或缺的一部分。在抖音上,我們可以看到來自世界各地的有趣影片。有些人喜歡發布他人的視頻,這就引發了一個問題:抖音發布他人視頻侵權嗎?本文將圍繞這個問題展開討論,告訴大家怎樣剪輯影片不算侵權,以及如何避免侵權問題。一、抖音發布他人影片侵權嗎?根據我國《著作權法》的規定,未經著作權人許可,擅自使用其作品,屬於侵權行為。因此,在抖音上發布他人視頻,如果未經原作者或著作權人許可,就屬於侵權行為。二、怎樣剪輯影片不算侵權? 1.使用公共領域或授權的內容:公共

Wink如何去影片浮水印

Feb 23, 2024 pm 07:22 PM

Wink如何去影片浮水印

Feb 23, 2024 pm 07:22 PM

Wink如何去視訊浮水印?winkAPP中是有去除掉視訊浮水印的工具,但是多數的小伙伴不知道wink中如何去除掉視頻中的水印,接下來就是小編為玩家帶來的Wink視頻去水印方法圖文教程,有興趣的用戶快來一起看看吧! Wink如何去視訊浮水印1、先開啟winkAPP,在首頁面專區中選擇【去浮水印】功能;2、然後在相簿中選擇你需要去除水印的影片;3、接著選擇影片之後,剪輯影片之後點擊右上角【√】;4、最後點選如下圖的【一鍵去印】之後點選【處理】即可。

如何發布小紅書影片作品?發影片要注意什麼?

Mar 23, 2024 pm 08:50 PM

如何發布小紅書影片作品?發影片要注意什麼?

Mar 23, 2024 pm 08:50 PM

隨著短影片平台的興起,小紅書成為了許多人分享生活、表達自我、獲取流量的平台。在這個平台上,發布影片作品是一種非常受歡迎的互動方式。那麼,如何發布小紅書影片作品呢?一、如何發布小紅書影片作品?首先,確保準備好一段適合分享的影片內容。你可以利用手機或其他攝影設備拍攝,需要注意畫質和聲音的清晰度。 2.剪輯影片:為了讓作品更具吸引力,可以剪輯影片。可使用專業的影片剪輯軟體,如抖音、快手等,加入濾鏡、音樂、字幕等元素。 3.選擇封面:封面是吸引用戶點擊的關鍵,選擇一張清晰、有趣的圖片作為封面,讓

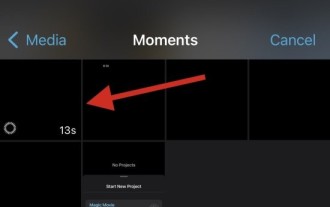

從 iPhone 上的影片中刪除慢動作的 2 種方法

Mar 04, 2024 am 10:46 AM

從 iPhone 上的影片中刪除慢動作的 2 種方法

Mar 04, 2024 am 10:46 AM

在iOS設備上,「相機」應用程式可讓您拍攝慢動作視頻,如果您使用的是最新的iPhone,甚至可以以每秒240幀的速度錄製視頻。此功能讓您能夠捕捉到豐富細節的高速動作。但有時候,您可能希望將慢動作影片以正常速度播放,這樣可以更好地欣賞影片中的細節和動作。在這篇文章中,我們將解釋從iPhone上的現有影片中刪除慢動作的所有方法。如何從iPhone上的影片中刪除慢動作[2種方法]您可以使用「照片」App或iMovie剪輯App從裝置上的影片中刪除慢動作。方法1:使用「照片」應用程式在iPhone上開啟

微博發影片怎麼不壓縮畫質_微博發影片不壓縮畫質方法

Mar 30, 2024 pm 12:26 PM

微博發影片怎麼不壓縮畫質_微博發影片不壓縮畫質方法

Mar 30, 2024 pm 12:26 PM

1.先打開手機微博,點選右下角【我】(如圖所示)。 2、接著點選右上角【齒輪】打開設定(如圖所示)。 3.然後找到並開啟【通用設定】(如圖所示)。 4.隨後進入【影片隨著】選項(如圖所示)。 5.再開啟【影片上傳清晰度】設定(如圖)。 6.最後選擇【原畫質】就能不壓縮了(如圖)。

抖音發布影片如何賺收益?新手小白怎麼在抖音上賺錢啊?

Mar 21, 2024 pm 08:17 PM

抖音發布影片如何賺收益?新手小白怎麼在抖音上賺錢啊?

Mar 21, 2024 pm 08:17 PM

抖音,這個全民短視頻平台,不僅讓我們在閒暇時間享受到各種有趣、新奇的短視頻,同時也給了我們一個展示自我、實現價值的舞台。那麼,如何在抖音發布影片中賺取收益呢?本文將詳細解答這個問題,幫助你在抖音上賺取更多的收益。一、抖音發布影片如何賺收益?發布影片在抖音上獲得一定的播放量後,可以有機會參與廣告分成計畫。這項收益方式是抖音用戶最熟悉的之一,也是許多創作者主要的收入來源。抖音根據帳號權重、影片內容以及觀眾回饋等多種因素來決定是否提供廣告分成的機會。抖音平台允許觀眾透過發送禮物來支持自己喜歡的創作者,

uc瀏覽器下載的視頻怎麼變成本地視頻

Feb 29, 2024 pm 10:19 PM

uc瀏覽器下載的視頻怎麼變成本地視頻

Feb 29, 2024 pm 10:19 PM

uc瀏覽器下載的影片怎麼變成本機影片?許多手機用戶都喜歡使用UC瀏覽器,不僅可用它進行網頁瀏覽,還可在線上觀看各種影片和電視節目,並將喜愛的影片下載至手機。實際上,我們可以將下載的視頻轉換為本地視頻,但很多人不清楚如何操作。因此,小編特地為大家帶來了將uc瀏覽器快取的影片轉為本地影片方法,希望可以幫助到各位。將uc瀏覽器快取的影片轉為本機影片方法1、開啟uc瀏覽器,點選「選單」選項。 2、點選「下載/影片」。 3、點選「已快取影片」。 4.長按任意一個視頻,彈出選項後,點選「開啟目錄」。 5.勾選要下載的