當每個人都在苦苦等待 GPT-4 發佈時,OpenAI 卻一直遲遲沒有消息,仍在修復其前身。這家總部位於舊金山的公司於昨日發布了一個名為 ChatGPT 的新模型,它是 GPT-3 的衍生產品,它以對話的方式進行互動。

這種對話允許 ChatGPT 回答後續問題,承認錯誤,挑戰不正確的前提,並拒絕不適當的請求。有別的語言模型胡編亂造,例如 Meta 的語言模型 Galactica 因為不負責任的胡編亂造,上線幾天就下架了。 ChatGPT 的不同之處在於,當它不知道自己在說什麼時,它承認不知道。此外,ChatGPT 拒絕回答它沒有受過訓練的問題,例如,它不會試圖回答有關 2022 年之後發生的事件的問題。它也不會回答關於個人的問題。

這個模型到底有多聰明?以前調試程式碼的腦力活都得程式設計師親自動手,現在 ChatGPT 可以攬下這個苦差事。

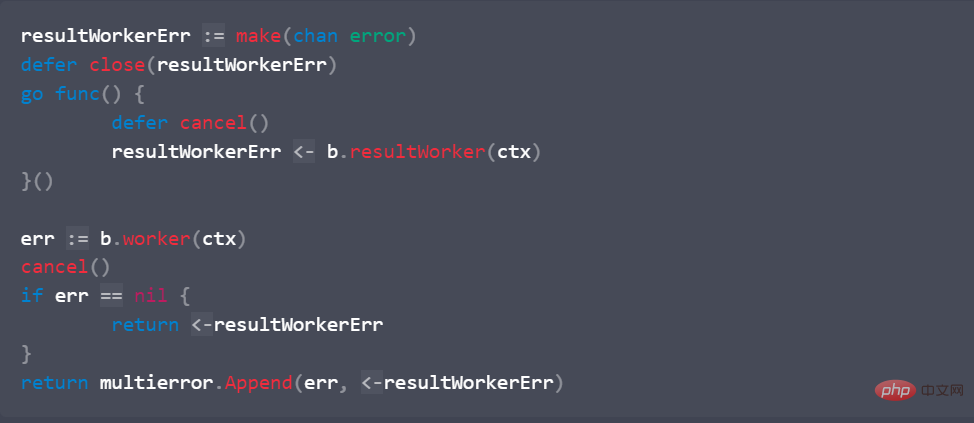

使用者表示:這段程式碼沒有像我期望的那樣運行,我該如何修改?

ChatGPT:你給的上下文資訊太少了,很難說出程式碼的問題。你能否提供更多關於程式碼的信息,例如程式碼用來幹什麼的,這是整個程式碼還是其中的一部分?

用戶:這是程式碼的一部分。我認為 channel 出現了問題。

ChatGPT:如果沒有更多資訊來說明程式碼應該做什麼、執行時發生了什麼,這個問題就很難說了。從你提供的資訊可以看出,程式碼的一個潛在問題是 resultWorkerErr channel 從未關閉,這意味著如果從未寫入 resultWorkerErr channel,程式碼可能會掛起。如果 b.resultWorker 沒有回傳錯誤或它在有機會回傳錯誤之前被取消,就會發生這種情況。

要解決此問題,你可以在寫入 resultWorkerErr channel 後將其關閉。例如,你可以在向channel 發送錯誤的行之後添加以下程式碼行:

這將確保resultWorkerErr channel 總是關閉的,即使b.c retworker 從未回傳錯誤。同樣,如果沒有更多關於你所看到的問題的信息,很難判斷這是否是你正在經歷的問題。你能提供更多關於運行程式碼時發生的細節嗎?

以上就是 ChatGPT 修改 Bug 的一個過程,可以說是刨根問底了。

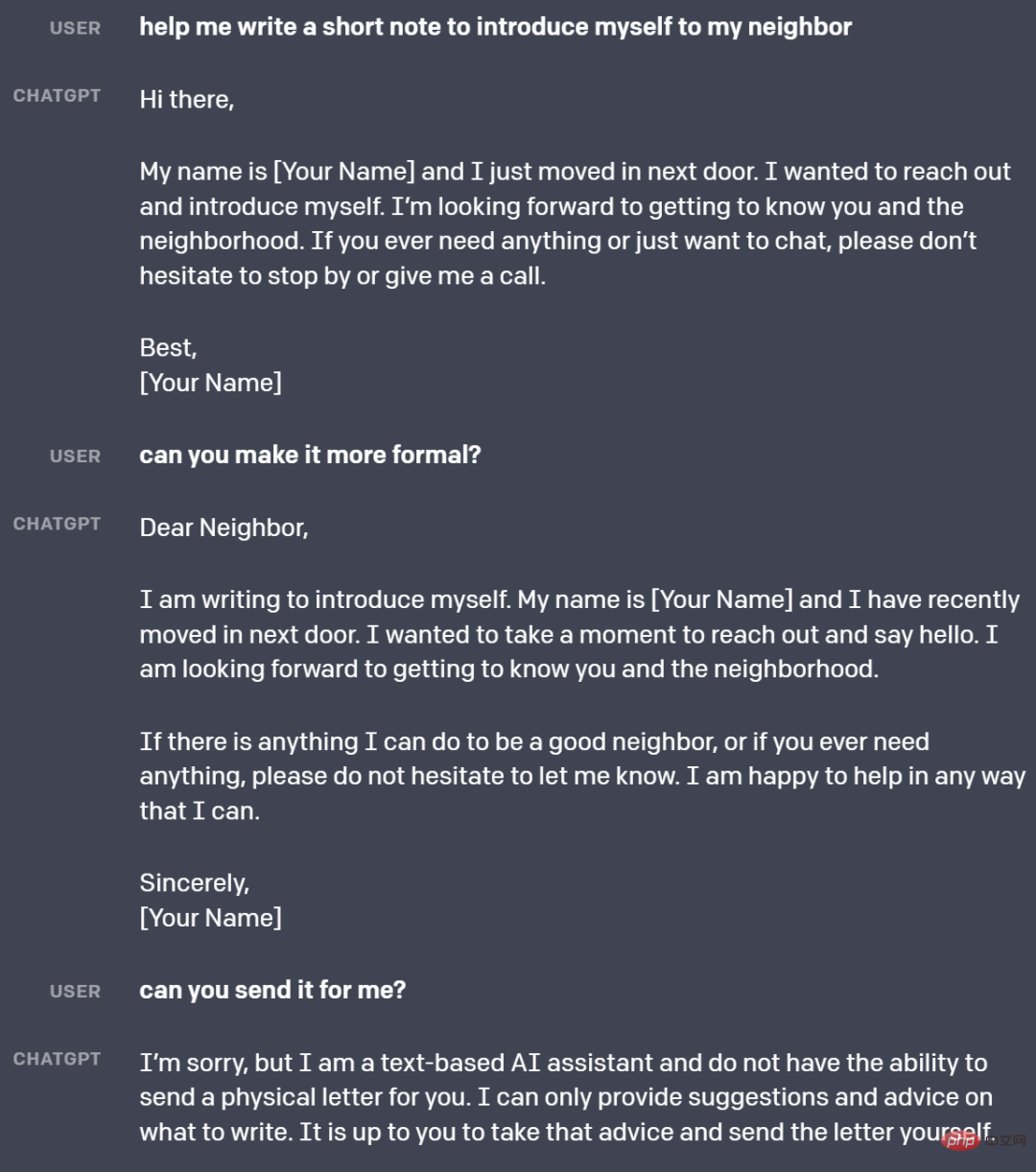

在下面的範例中,ChatGPT 提供了對後續指令的回應。下圖大概意思是說,用戶要求ChatGPT 幫自己寫個簡短的介紹,好與鄰居認識一下;ChatGPT 給了一篇簡短文字介紹,但用戶嫌棄不夠正式,好脾氣的ChatGPT 又來了一版正式一點的;之後用戶又提了一個要求,讓ChatGPT 幫忙寄出去。最後ChatGPT 回答:「很抱歉,我是一個基於文字的AI 助手,沒有能力為你發送一封實體信件。我只能提供關於寫什麼的建議。你可以接受該建議並自己發送這封信。」

看到這,你是不是也想嘗試一番。不錯,這個模型一經發布,讓很多人沉迷而無法自拔,就連馬斯克都來了一句:「很多人陷入了該死瘋狂的ChatGPT 循環中。」

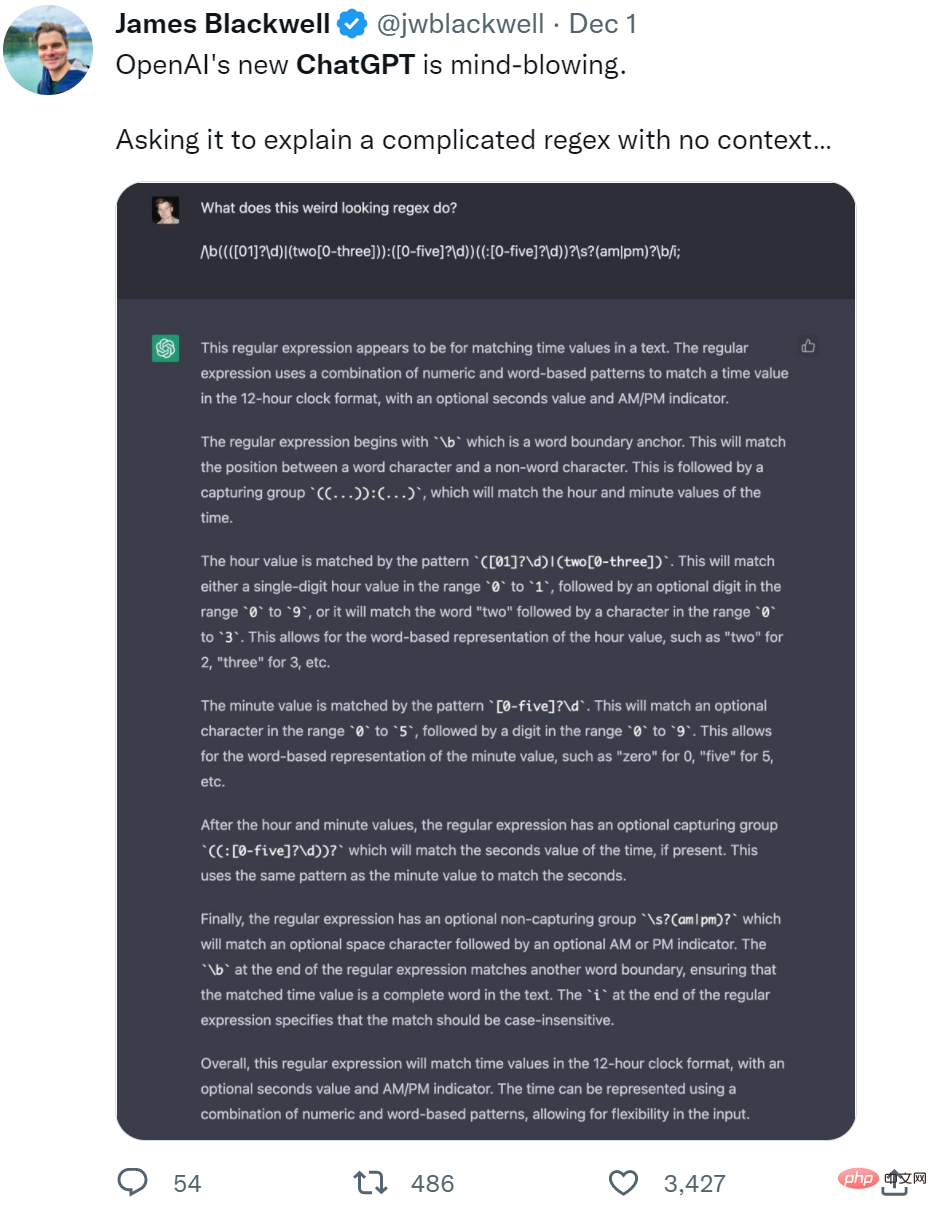

一時間,大家彷彿找到了一個新的樂子,紛紛和ChatGPT 打開了對話模式。 「要求它解釋一個沒有上下文的複雜的正規表示式……」這個問題真是夠難為人的,但是難不倒 ChatGPT。看這解釋的篇幅,應該是解釋清楚了。

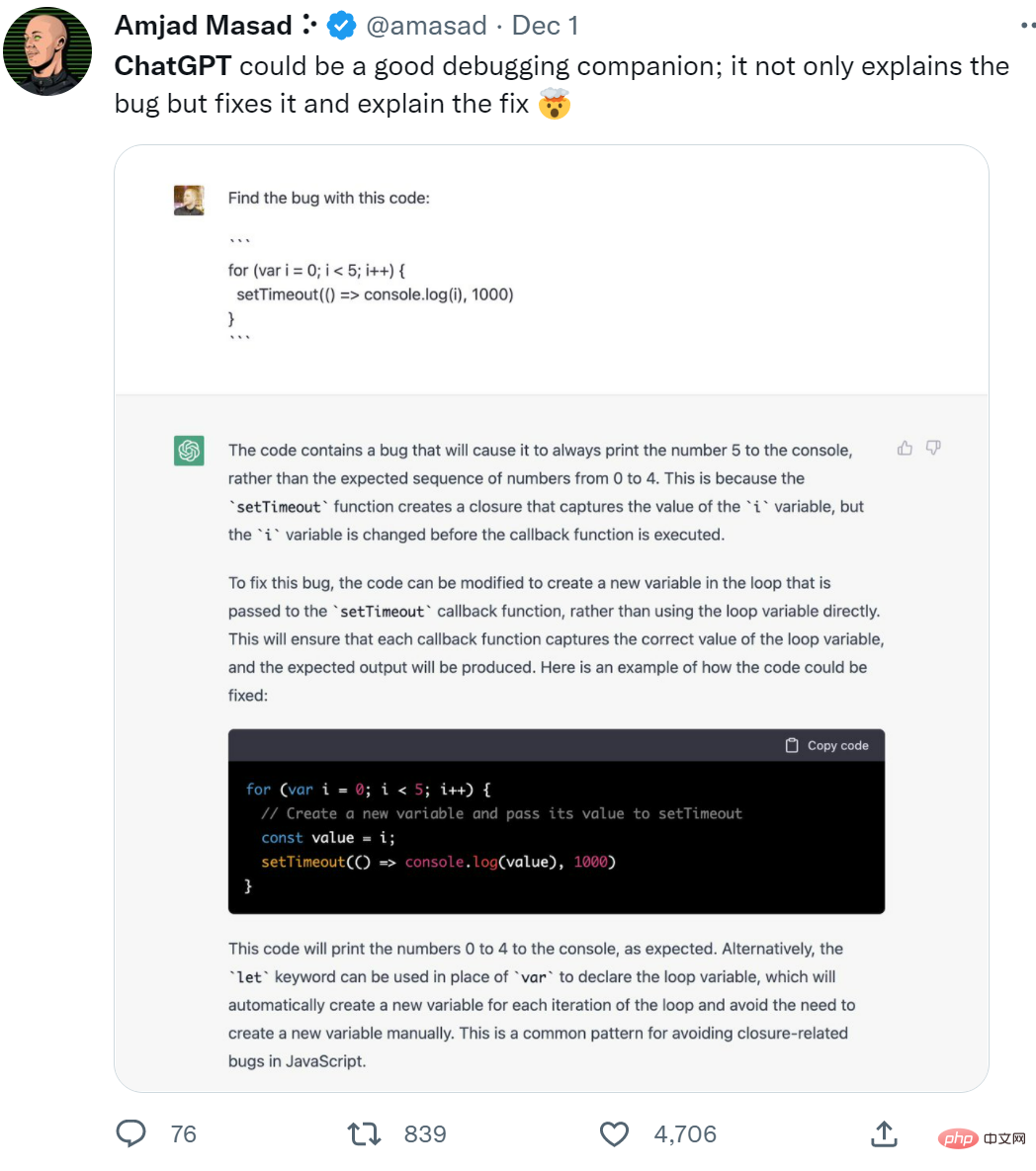

「ChatGPT 是一個很好的 debugging 夥伴,它不僅能解釋 bug,還能修復 bug 並解釋修復 bug 的方法。」網友表示。

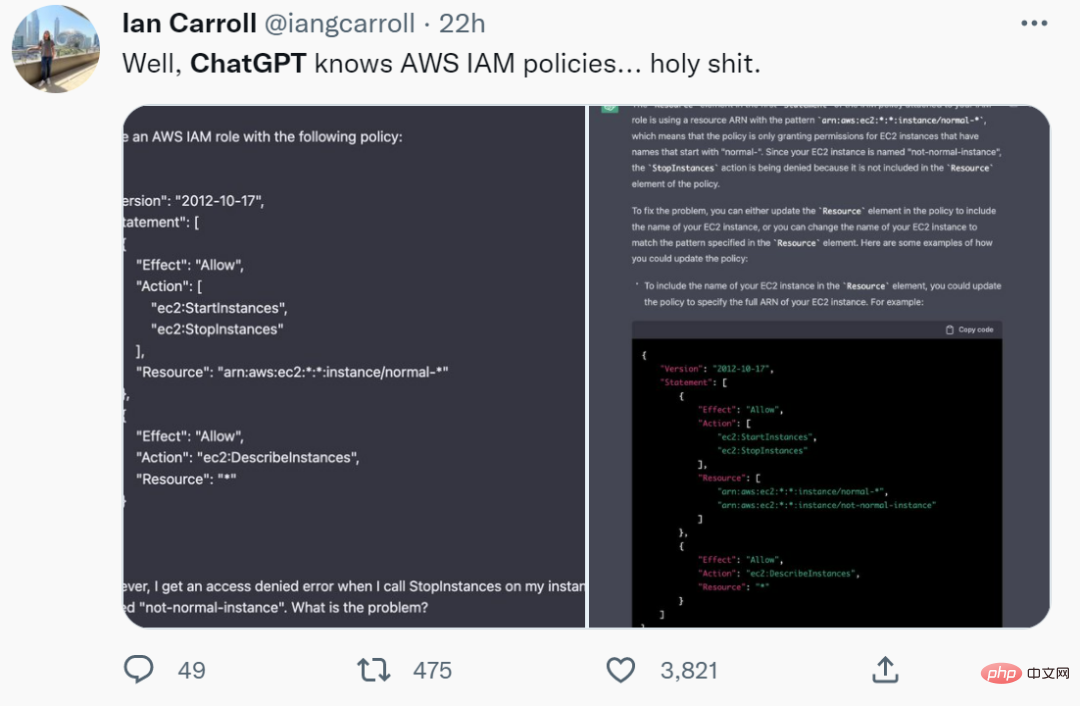

更有網友不可思議道:「天啊,ChatGPT 竟然知道AWS IAM 策略。」

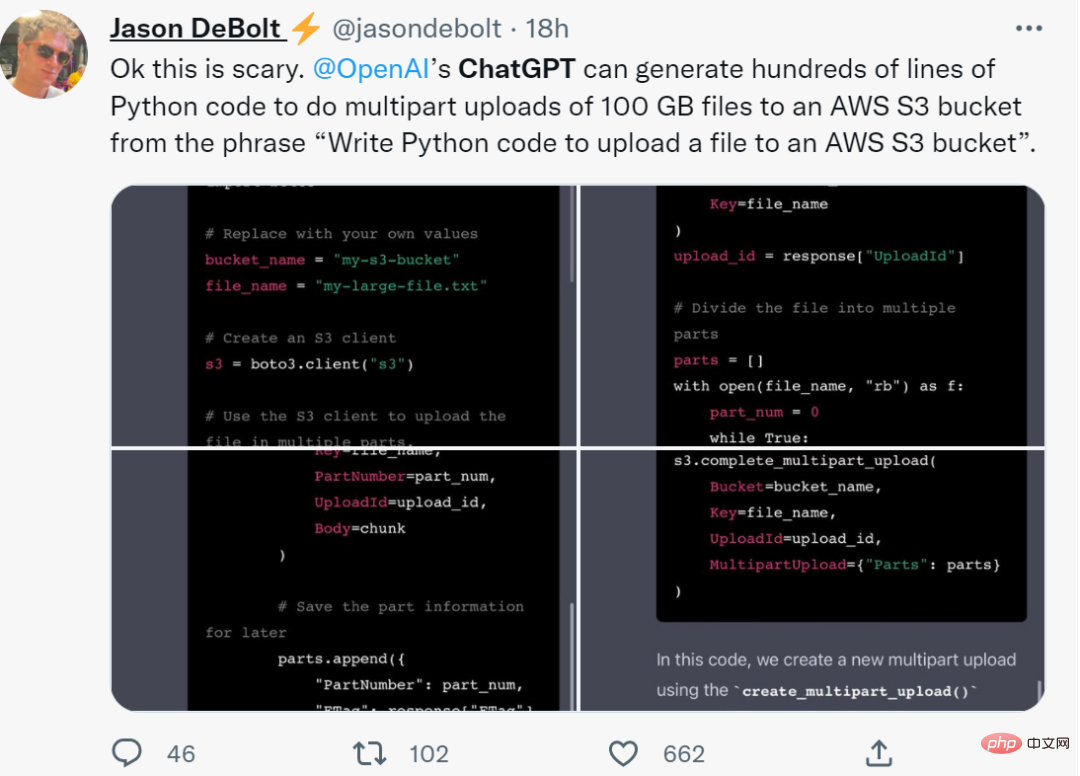

#「ChatGPT 可以產生數百行Python 程式碼,將100 GB 的檔案上傳到AWS S3 bucket 中,只要寫這樣一句話即可「Write Python code to upload a file to an AWS S3 bucket(寫Python 程式碼,上傳檔案到AWS S3 bucket )。」

由於大家太過熱情,試用網站已經崩了:「我們的需求異常旺盛。請稍等,我們正在擴充我們的系統。」

##試用地址:chat. openai.com

方法#########ChatGPT 使用與InstructGPT 相同的方法-以人類回饋強化學習(RLHF) 訓練模型,但資料收集設定略有不同。 ChatGPT 使用監督微調訓練了一個初始模型:人類 AI 訓練員提供對話,他們在對話中扮演雙方——用戶和 AI 助手,AI 訓練員可以訪問模型編寫的對話回复,以幫助 AI 調整回复內容。 ############為了創建強化學習的獎勵模型,研究需要收集比較數據,其中包含兩個或多個按品質排序的模型回應。該研究收集了 AI 訓練員與聊天機器人的對話,並隨機選擇一條模型編寫的消息,抽取幾個備選回复,讓 AI 訓練員對這些回復進行排名。此外,該研究還使用近端策略優化演算法(PPO)微調模型,並對整個過程進行了幾次迭代。 ############ChatGPT 對 GPT-3.5 系列中的某個模型進行了微調,該模型於 2022 年初完成訓練。 ChatGPT 和 GPT 3.5 在 Azure AI 超級運算基礎架構上進行了訓練。 #########限制#########1. ChatGPT 有時會寫出看似合理但不正確或荒謬的答案。解決這個問題非常具有挑戰性,因為:######

相比於GPT-3 和Codex,ChatGPT 作為OpenAI 最新發布的模型,已經在安全性和可用性方面做出了諸多改進,汲取了先前模型的經驗教訓,並透過使用人類回饋強化學習(RLHF) 大幅減少了模型的有害和不真實輸出。

以上是OpenAI新上線GPT太強了,伺服器瞬間擠爆,馬斯克:你們太沉迷了的詳細內容。更多資訊請關注PHP中文網其他相關文章!