誰在發表最具影響力的 AI 研究?在現今「百花齊放」的時代,這個問題極具挖掘空間。

你可能會猜到一些結論:例如Google、微軟、OpenAI、DeepMind 這些頂級機構,類似這樣的結論只猜對了一半,還有另外一些信息,向我們揭露了原本不為人知的結論。

隨著 AI 創新的快速發展,盡快獲得一些「情報」是至關重要的。畢竟幾乎沒人有時間去閱讀所有的東西,但可以肯定的是,本文整理的這些論文具備改變人工智慧技術發展方向的潛力。

對研發團隊影響力的真正考驗當然是科技如何落地在產品中,OpenAI 在2022 年11 月底發布了ChatGPT,震撼了整個領域,這是繼他們2022 年3 月的論文「利用人類回饋訓練遵循指令的語言模型」(Training language models to follow instructions with human feedback)之後的另一個突破。

如此迅速的產品落地是罕見的。所以,為了洞察到更多信息,近日,Zeta Alpha 的統計採用了一個經典的學術指標:引用次數。

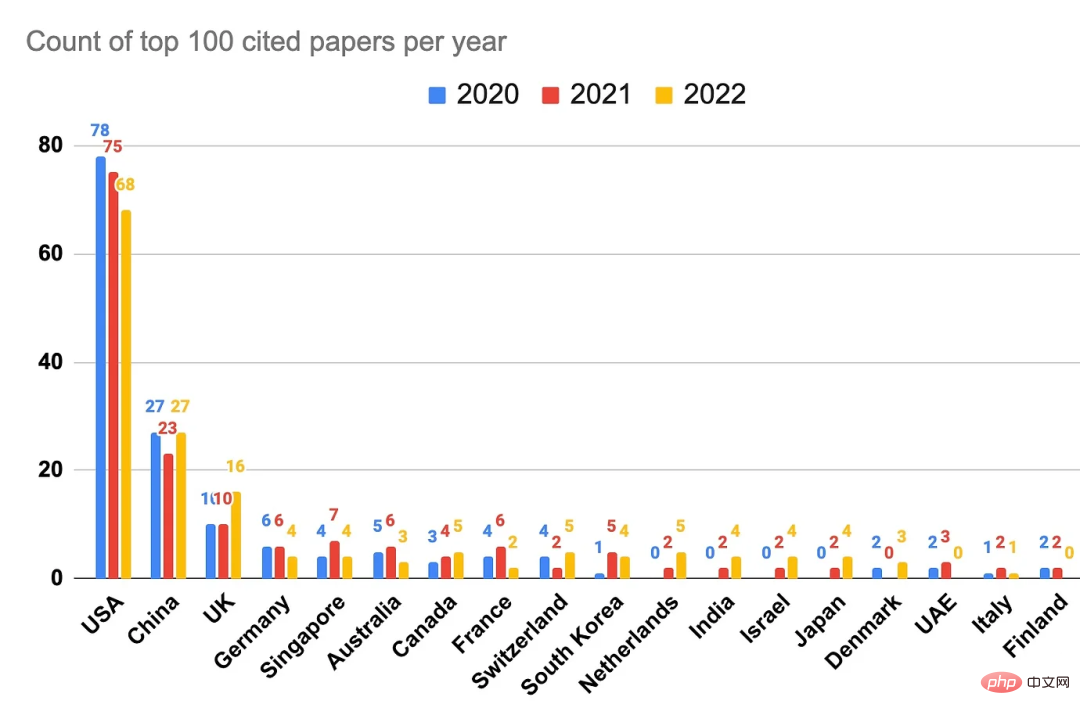

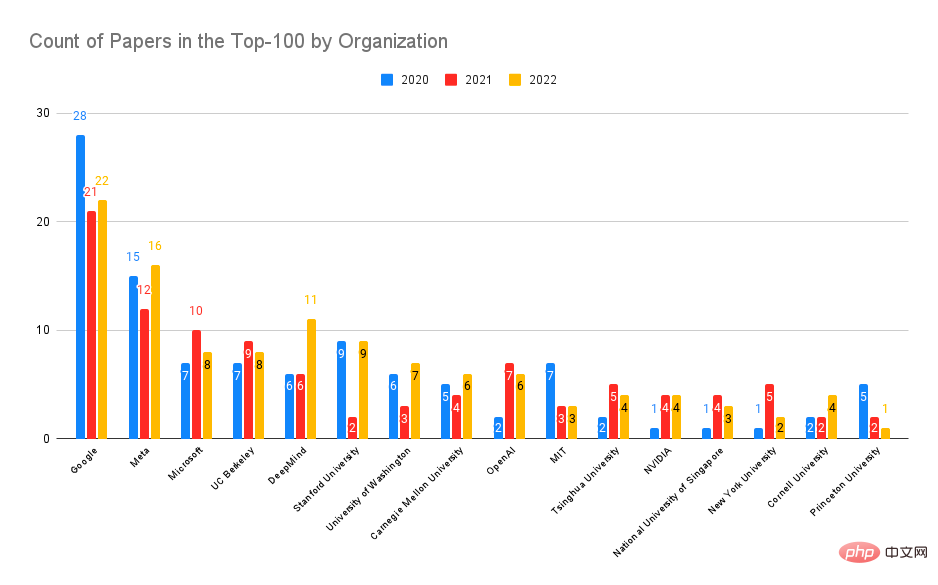

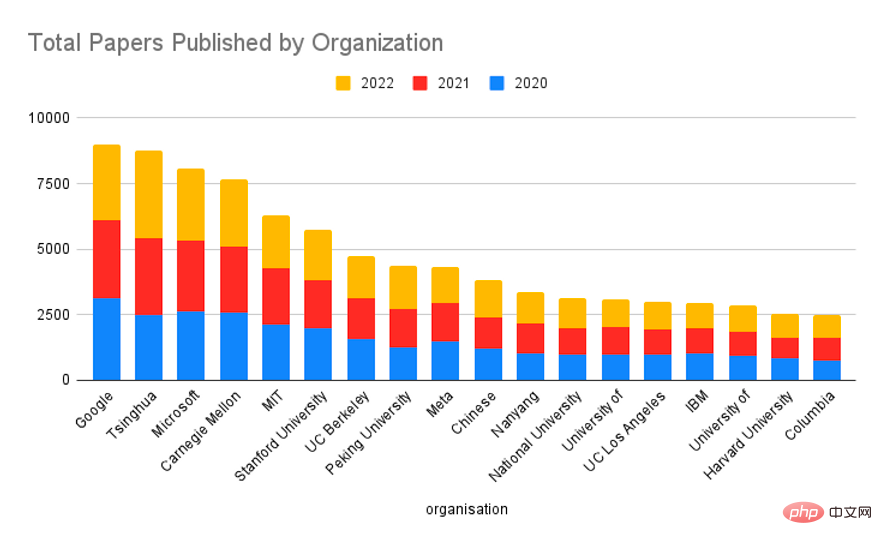

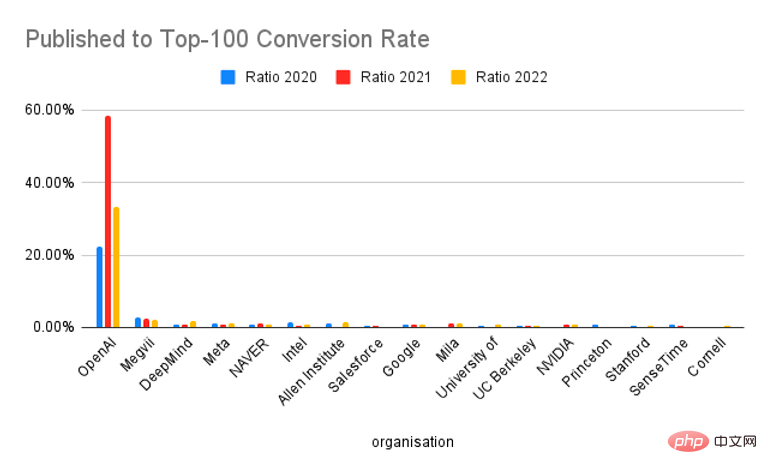

對2022 年、2021 年和2020 年每年被引用次數最多的100 篇論文的詳細分析,可以深入了解目前發表最具影響力的AI 研究的機構和國家/ 地區。一些初步結論是:美國和谷歌仍然占主導地位,DeepMind 在這一年也取得了輝煌的成就,但考慮到產出量,OpenAI 在產品影響和研究方面確實處於前列,並能快速和廣泛地被引用。

資料來源:Zeta Alpha。

如上圖所示,另外一個重要結論是:中國在研究引用量上的影響力排行第二,但與美國相比仍存在差距,並不像許多報道中所描述的「追平甚至超越」。

利用來自Zeta Alpha 平台的數據,然後結合人工策劃,本文收集了2022 年、2021 年和2020 年人工智慧領域被引用次數最多的論文,並分析了作者的所屬機構和國家/ 地區。這使得能夠按照研發影響而不是純粹的出版數據對這些論文進行排名。

為了創建分析結果,本文首先在Zeta Alpha 平台上收集了每年被引用次數最多的論文,然後手動檢查首次發表日期(通常是arXiv 預印本),以便將論文放在正確的年份。然後透過在 Semantic Scholar 上挖掘高引用率的人工智慧論文來補充這個名單,因為 Semantic Scholar 的覆蓋範圍更廣,而且能夠按引用次數排序。這主要是發現了來自高影響力的出版商(如 Nature、Elsevier、Springer 和其他期刊)以外的論文。然後,將每篇論文在Google學術上的引用次數作為代表指標,並按這個數字對論文進行排序,得出一年中的前 100 名。對於這些論文,本文使用了 GPT-3 來提取作者、隸屬機構和國家 / 地區,並手動檢查這些結果(如果國家 / 地區在出版物中不明顯,就採用該組織總部所在的國家 / 地區)。如果一篇論文有來自多個機構的作者,每個機構算一次。

看了這份排行榜之後,大佬Yann LeCun 表示很欣慰:「在Meta AI,我們傾向於出版品質而不是數量。這就是為什麼在2022 年被引用在最多的100 篇人工智慧論文中,Meta AI 撰寫(或共同撰寫)了16 篇,僅次於谷歌的22 篇,排名第二。我們的研究正在對社會產生巨大的影響。(此外,紐約大學的排名也很讚)。」

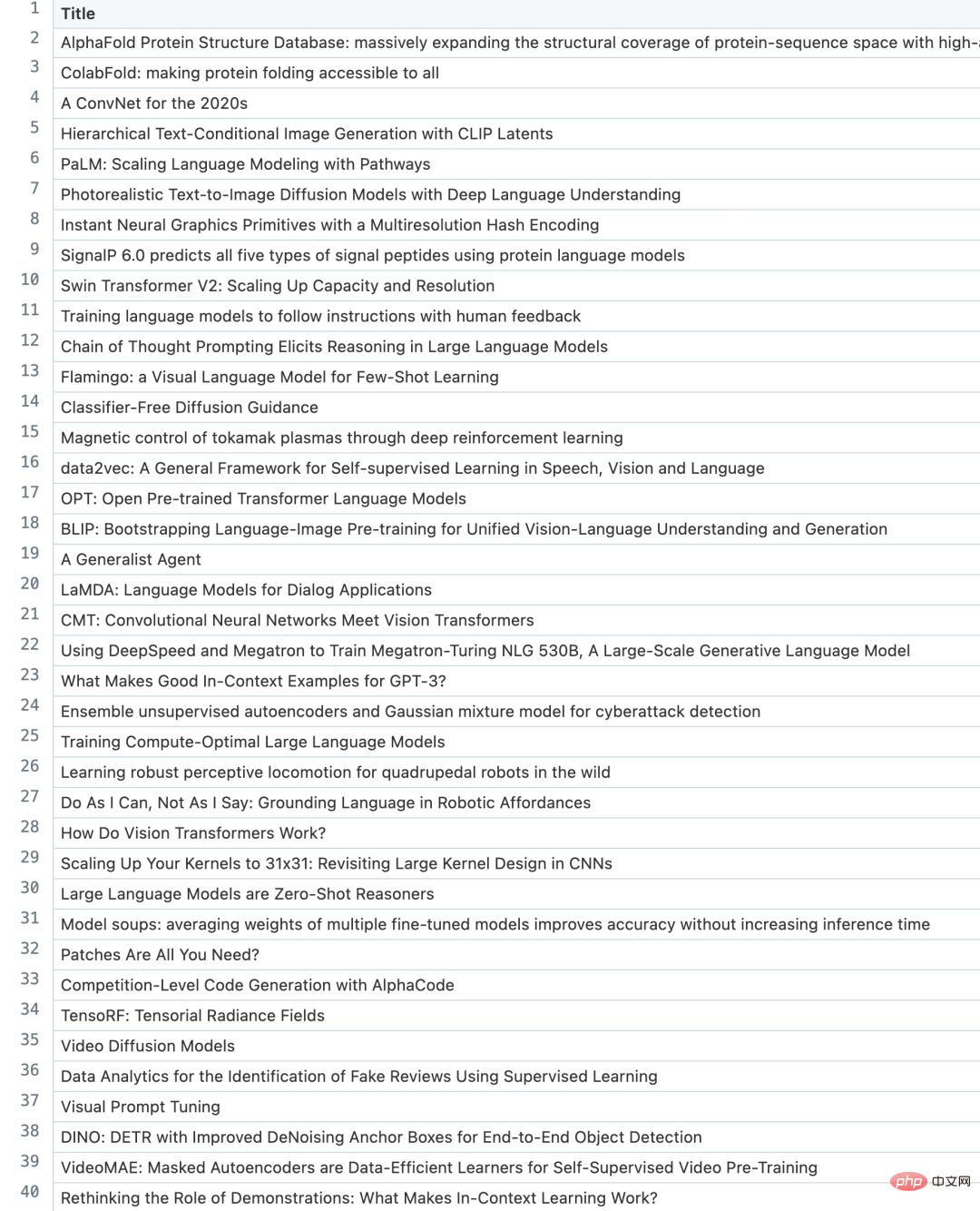

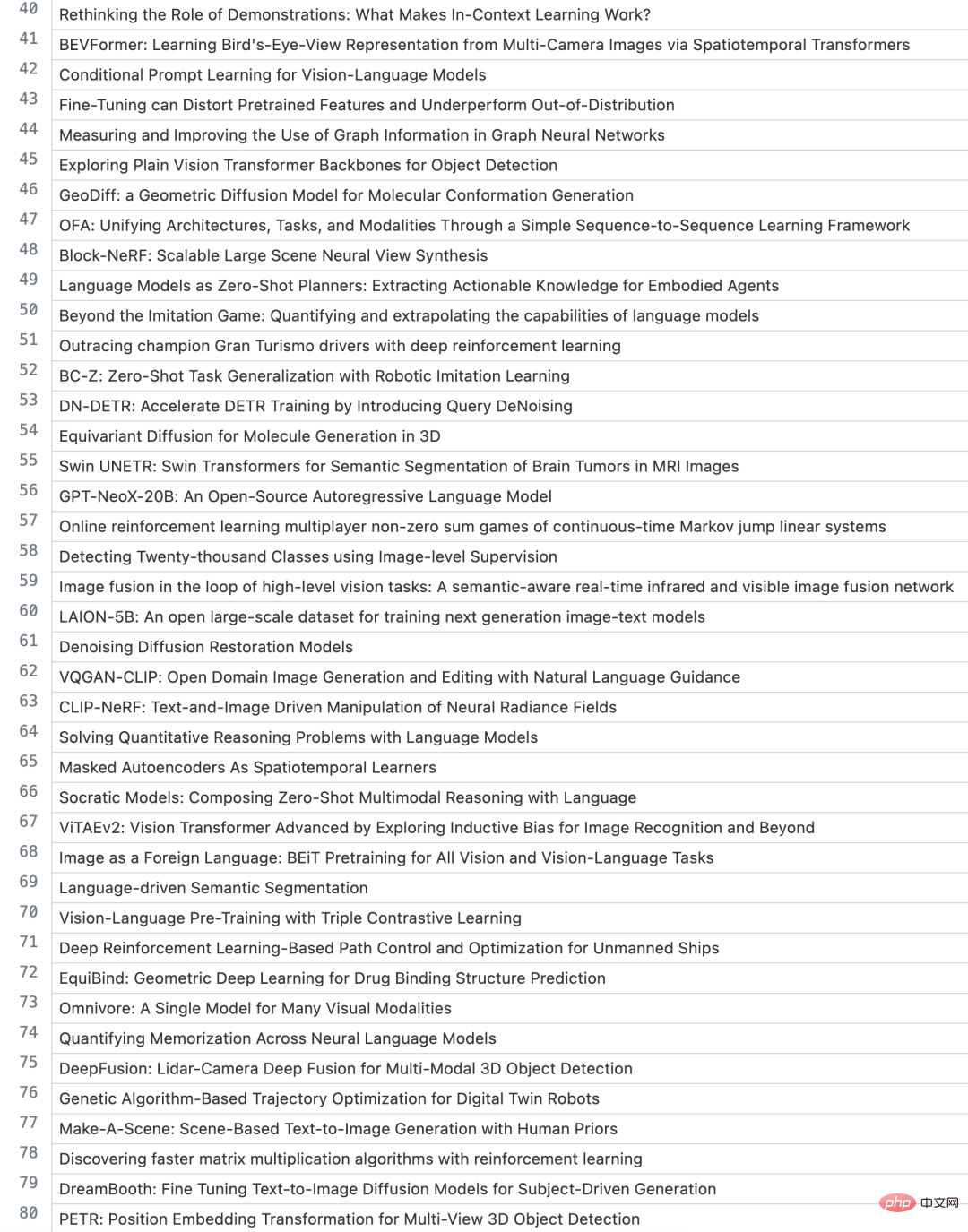

所以,剛才談論的這些Top 論文有哪些?

在深入了解這些數字之前,讓我們先了解一下過去三年的熱門論文。相信你會認出其中的幾篇。

1、AlphaFold Protein Structure Database: massively expanding the structural coverage of protein-sequence space with high-accuracy models

#2、ColabFold: making protein folding accessible to all

3、Hierarchical Text-Conditional Image Generation with CLIP Latents

4、A ConvNet for the 2020s

#5、PaLM: Scaling Language Modeling with Pathways

1、《Highly accurate protein structure prediction with AlphaFold》

2、《Swin Transformer: Hierarchical Vision Transformer using Shifted Windows》

論文連結:https://arxiv.org/abs/2103.00020

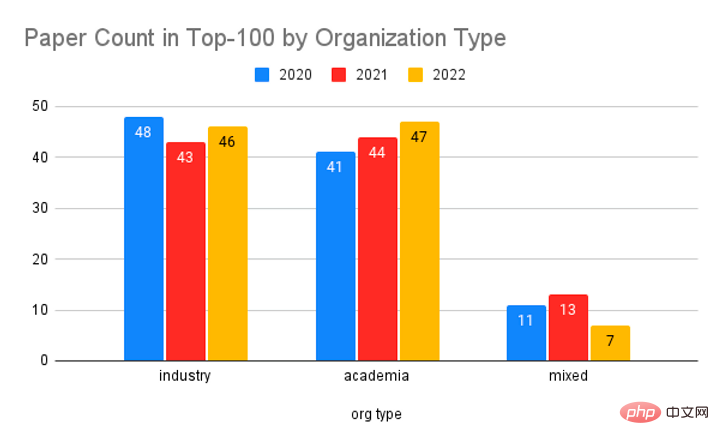

# 5、《Emerging Properties in Self-Supervised Vision Transformers》 1、《An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale》 ##2、《Language Models are Few-Shot Learners》 #3、《YOLOv4: Optimal Speed and Accuracy of Object Detection》 4、《Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer》 ##5、《Bootstrap your own latent: A new approach to self-supervised Learning》 ##讓我們來看看一些領先的機構在前100名的論文數量上是如何排行的: #Google一直是最強大的參與者,其次是Meta 、微軟、加州大學柏克萊分校、DeepMind 和史丹佛。雖然如今的工業界在人工智慧研究中「呼風喚雨」,單一的學術機構不會產生那麼大的影響,但這些機構的尾巴要長得多,所以當我們按組織類型進行匯總時,就會達到平衡。 在研究總量方面,過去三年谷歌居首位,清華大學、卡內基美隆大學、麻省理工學院、史丹佛大學等高校排名靠前,而微軟則位居第三位元.整體來看,學術機構的研究數量是多於業界科技企業的,而Google、微軟這兩大科技巨頭近三年發表的研究數也是居於高位。

2020 年熱門論文

論文連結:https://arxiv.org/abs/2005.14165

#論文連結:https://arxiv.org/abs /2004.10934

#論文連結:https://arxiv.org/abs/1910.10683

領先機構排行

實際上,Google的科研實力一直都很強。 2017 年,Google發表論文《Attention Is All You Need》,標誌著 transformer 的問世。直到今天,transformer 仍然是包括 ChatGPT 在內的大部分 NLP 和 CV 模型的架構基礎。

上個月,在Bard 發布之際,GoogleCEO Sundar Pichai 也在一份公開信中表示:「Google AI 和DeepMind 推動了最先進技術的發展。我們的Transformer研究計畫和我們2017 年的領域論文,以及我們在擴散模型方面的重要進展,是當前許多生成式AI 應用程式的基礎。」

當然,作為新晉頂流ChatGPT 背後的公司,OpenAI 近三年的研究成果轉換率(Conversion Rate)是具有絕對優勢的。最近幾年,OpenAI 的大多數研究成果都引起了極大的關注,特別是在大規模語言模型方面。

2020 年,OpenAI 發布了GPT-3,這個1750 億參數的大規模語言模型在某種程度上顛覆了語言模型領域的遊戲規則,因為它解決了許多大規模語言模型中的難題。 GPT-3 掀起了一場大規模語言模式的狂潮。幾年來,語言模型的參數規模不斷被打破,人們一直在探索大規模語言模型的更多潛力。

2022 年底,ChatGPT 橫空出世,它引起了人們對文本生成和 AI 對話系統的高度關注。特別地,ChatGPT 在生成知識型內容和生成代碼方面已經表現出非常高的能力。在Google、微軟陸續宣布將類似 ChatGPT 的功能整合到下一代搜尋引擎後,ChatGPT 被認為將引領一場 AIGC 和智慧工具的新變革。

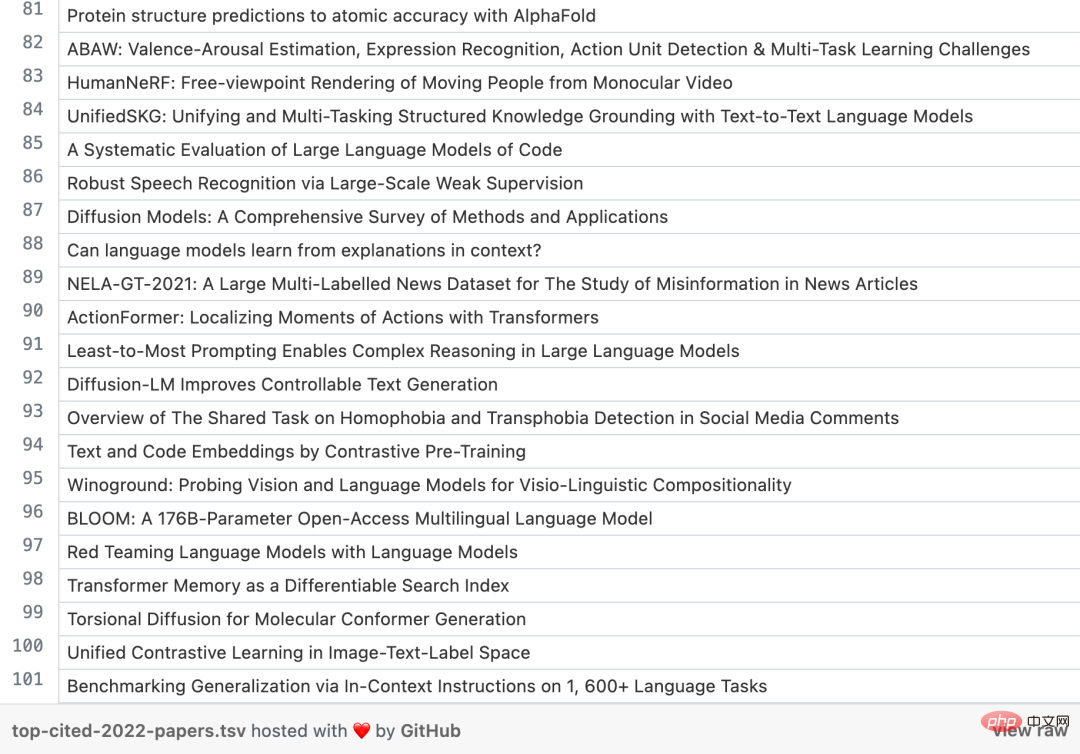

最後,我們來看看2022 年被引用次數最多的100 篇論文具體有哪些:

這裡也增加了推特提及次數,這有時被視為早期影響指標。但到目前為止,相關性似乎很弱。還需要進一步的工作。

以上是誰發表了最具影響力的AI研究? Google遙遙領先,OpenAI成果轉換率完勝DeepMind的詳細內容。更多資訊請關注PHP中文網其他相關文章!