Diffusion+目標偵測=可控制影像生成!華人團隊提出GLIGEN,完美控制物件的空間位置

隨著Stable Diffusion的開源,用自然語言進行圖像生成也逐漸普及,許多AIGC的問題也暴露了出來,例如AI不會畫手、無法理解動作關係、很難控制物體的位置等。

其主要原因還是在於「輸入介面」只有自然語言,無法做到對畫面的精細控制。

最近來自威斯康辛大學麥迪遜分校、哥倫比亞大學和微軟的研究熱源提出了一個全新的方法GLIGEN,以grounding輸入為條件,對現有「預訓練文本到圖像擴散模型”的功能進行擴展。

論文連結:https://arxiv.org/pdf/2301.07093.pdf

#專案首頁:https://gligen.github.io/

##體驗連結:https: //huggingface.co/spaces/gligen/demo

為了保留預訓練模型的大量概念知識,研究人員沒有選擇對模型進行微調,而是透過門控機制將輸入的不同grounding條件注入新的可訓練層中,以實現對開放世界圖像生成的控制。

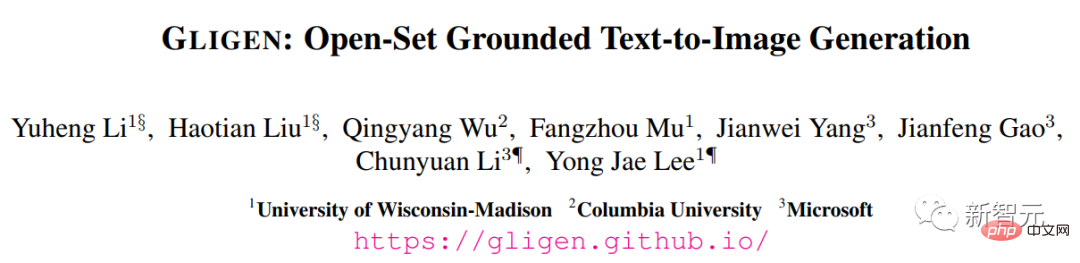

目前GLIGEN支援四種輸入。

(左上)文字實體box (右上)圖片實體box

#(左上)文字實體box (右上)圖片實體box

(左下)圖像風格文字box (右下)文字實體關鍵點

實驗結果也顯示,GLIGEN 在COCO 和LVIS上的zero-shot性能大大優於目前有監督layout-to-image基線。

可控影像生成在擴散模型之前,生成對抗網路(GANs)一直是影像生成領域的一哥,其潛空間和條件輸入在“可控操作”和“生成”方面得到了充分的研究。

文字條件自回歸和擴散模型表現出驚人的影像品質和概念覆蓋率,得益於其更穩定的學習目標和對網路影像-文字配對資料的大規模訓練,並迅速出圈,成為輔助藝術設計和創作的工具。

但現有的大規模文字-圖像生成模型不能以「文字以外」的其他輸入模式為條件,缺乏精確定位概念或使用參考圖像來控制生成過程的能力,限制了訊息的表達。

比如說,使用文字很難描述一個物體的精確位置,而邊界框(bounding

boxes)或關鍵點(keypoints )則可以很容易實現。

boxes)或關鍵點(keypoints )則可以很容易實現。

現有的一些工具如inpainting, layout2img產生等可以利用文字以外的模態輸入,但卻很少將這些輸入結合起來用於可控的text2img生成。

此外,先前的生成模型通常是在特定任務的資料集上獨立訓練的,而在影像辨識領域,長期以來的範式是透過從「大規模影像資料」或「圖像-文字對」上預先訓練的基礎模型開始建立特定任務的模型。

擴散模型已經在數十億的圖像-文字對上進行了訓練,一個很自然的問題是:我們能否在現有的預訓練的擴散模型的基礎上,賦予它們新的條件輸入模式?

由於預訓練模型所具有的大量概念知識,可能能夠在其他生成任務上取得更好的性能,同時獲得比現有文本-圖像生成模型更多的可控性。

GLIGEN#########基於上述目的和想法,研究人員提出的GLIGEN模型仍然保留文字標題作為輸入,但也啟用了其他輸入模態,如grounding概念的邊界框、grounding參考影像和grounding部分的關鍵點。 ######這裡面的關鍵難題是在學習注入新的grounding資訊的同時,也保留預訓練模型中原有的大量概念知識。

為了防止知識遺忘,研究人員提出凍結原來的模型權重,並增加新的可訓練的門控Transformer層以吸收新的grouding輸入,下面以邊界框為例。

指令輸入

#每個grouding文字實體都被表示為一個邊界框,包含左上角和右下角的座標值。 要注意的是,現有的layout2img相關工作通常需要一個概念字典,在評估階段只能處理close-set的實體(如COCO類別),研究人員發現使用編碼圖像描述的文字編碼器即可將訓練集中的定位資訊泛化到其他概念上。

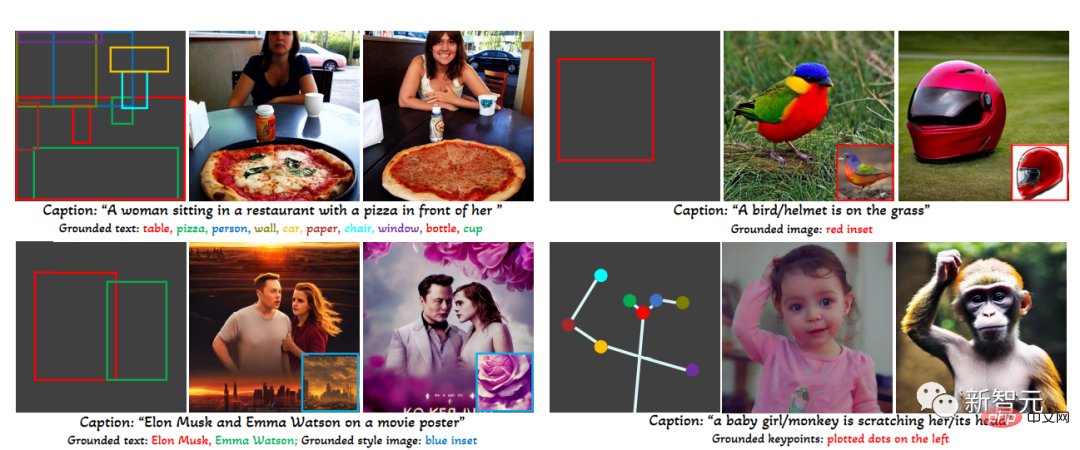

訓練資料

用於產生grounding影像的訓練資料需要文字c和grounding實體e作為條件,在實踐中可以透過考慮更靈活的輸入來放鬆對資料的要求。

主要有三種類型的資料

1. grounding資料

每張圖片都與描述整張圖片的標題相關聯;名詞實體從標題中提取,並標上邊界框。

由於名詞實體直接取自自然語言的標題,它們可以涵蓋更豐富的詞彙,有利於開放世界詞彙的grounding生成。

2. 偵測資料Detection data

#名詞實體是預先定義的close-set類別(例如COCO中的80個物件類別),選擇使用classifier-free引導中的空標題token作為標題。

偵測資料的數量(百萬級)大於基礎資料(千級),因此可以大幅增加整體訓練資料。

3. 偵測與標題資料Detection and Caption data

名詞實體與偵測資料中的名詞實體相同,而圖像是單獨用文字標題描述的,可能存在名詞實體與標題中的實體不完全一致的情況。 例如標題只給了客廳的高層次描述,沒有提到場景中的物體,而偵測標註則提供了更精細的物體層次的細節。

門控注意力機制

#大型擴散模型已經在網路規模的圖像文字上進行了預訓練,以獲得基於多樣化和複雜的語言指令合成現實圖像所需的知識,由於預訓練的成本很高,性能也很好,在擴展新能力的同時,在模型權重中保留這些知識是很重要的,可以通過調整新的模組來逐步適應新能力。

###############在訓練過程中,使用門控機制逐漸將新的grounding資訊整合到預訓練的模型中,這種設計使生成過程中的取樣過程具有靈活性,以提高品質和可控性。 ############實驗中也證明了,在採樣步驟的前半部分使用完整的模型(所有層),在後半部分只使用原始層(沒有門控Transformer層),生成的結果能夠更準確反映grounding條件,同時具有較高的影像品質。 ######

實驗部分

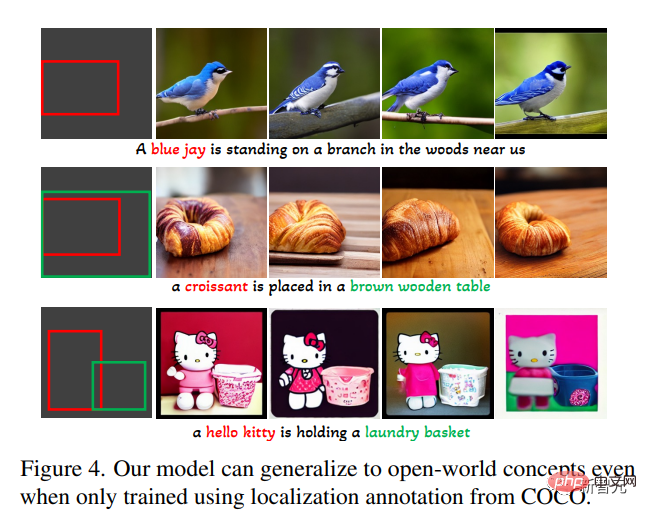

在開放集合grounded文字到影像產生任務中,首先只用COCO(COCO2014CD)的基礎標註進行訓練,並評估GLIGEN是否能產生COCO類別以外的基礎實體。

可以看到,GLIGEN可以學會新的概念如「藍鴉」、「羊角麵包」,或新的物件屬性如“棕色木桌”,而這些資訊並沒有出現在訓練類別中。

研究人員認為這是因為GLIGEN的門控自註意力學會了為接下來的交叉注意力層重新定位與標題中的接地實體相對應的視覺特徵,並且由於這兩層中的共享文字空間而獲得了泛化能力。

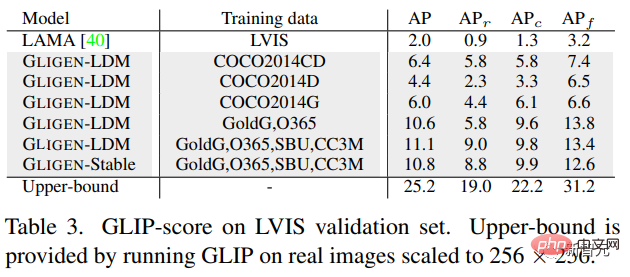

實驗中也定量評估了該模型在LVIS上的zero-shot產生效能,該模型包含1203個長尾物件類別。使用GLIP從生成的圖像中預測邊界框併計算AP,並將其命名為GLIP得分;將其與為layout2img任務設計的最先進的模型進行比較,

可以發現,儘管GLIGEN模型只在COCO標註上進行了訓練,但它比有監督的基線要好得多,可能因為從頭開始訓練的基線很難從有限的標註中學習,而GLIGEN模型可以利用預訓練模型的大量概念知識。

總的來說,這篇論文:

##1.提出了一種新的text2img生成方法,賦予了現有text2img擴散模型新的grounding可控性;

2. 透過保留預訓練的權重和學習逐漸整合新的定位層,該模型實現了開放世界的grounded text2img生成與邊界框輸入,即綜合了訓練中未觀察到的新的定位概念;

3. 此模型在layout2img任務上的zero-shot性能明顯優於先前的最先進水平,證明了大型預訓練生成模型可以提高下游任務的性能

以上是Diffusion+目標偵測=可控制影像生成!華人團隊提出GLIGEN,完美控制物件的空間位置的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

如何在 Windows 11 中清除桌面背景最近的影像歷史記錄

Apr 14, 2023 pm 01:37 PM

如何在 Windows 11 中清除桌面背景最近的影像歷史記錄

Apr 14, 2023 pm 01:37 PM

<p>Windows 11 改進了系統中的個人化功能,這使用戶可以查看先前所做的桌面背景變更的近期歷史記錄。當您進入windows系統設定應用程式中的個人化部分時,您可以看到各種選項,而更改背景桌布也是其中之一。但是現在可以看到您系統上設置的背景壁紙的最新歷史。如果您不喜歡看到此內容並想清除或刪除此最近的歷史記錄,請繼續閱讀這篇文章,它將幫助您詳細了解如何使用註冊表編輯器進行操作。 </p><h2>如何使用登錄編輯

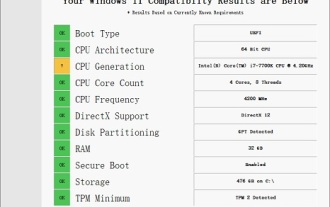

i7-7700無法升級至Windows 11的解決方案

Dec 26, 2023 pm 06:52 PM

i7-7700無法升級至Windows 11的解決方案

Dec 26, 2023 pm 06:52 PM

i77700的效能運行win11完全足夠,但是用戶卻發現自己的i77700不能升級win11,這主要是受到了微軟硬性條件的限制,所以只要跳過該限制就能安裝了。 i77700不能升級win11:1、因為微軟限制了cpu的版本。 2.intel只有第八代以上版本可以直升win11。3、而i77700作為7代,無法滿足win11的升級需求。 4.但是i77700在性能上是完全能流暢使用win11的。 5.所以大家可以使用本站的win11直裝系統。 6.下載完成後,右鍵「裝載」該檔案。 7.再雙擊運行其中的「一鍵

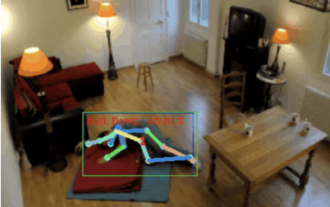

摔倒偵測,基於骨骼點人體動作識別,部分代碼用 Chatgpt 完成

Apr 12, 2023 am 08:19 AM

摔倒偵測,基於骨骼點人體動作識別,部分代碼用 Chatgpt 完成

Apr 12, 2023 am 08:19 AM

哈嘍,大家好。今天就跟大家分享一個摔倒偵測項目,確切地說是基於骨骼點的人體動作辨識。大概分為三個步驟辨識人體辨識人體骨骼點動作分類項目源碼已經打包好了,取得方式見文末。 0. chatgpt首先,我們需要取得監控的視訊串流。這段程式碼比較固定,我們可以直接讓chatgpt完成chatgpt寫的這段程式碼是沒有問題的,可以直接使用。但後面涉及業務型任務,例如:用mediapipe識別人體骨骼點,chatgpt給的代碼是不對的。我覺得chatgpt可以當作一個工具箱,能獨立於業務邏輯,都可以試著交給c

如何在電腦上下載 Windows 聚光燈桌布影像

Aug 23, 2023 pm 02:06 PM

如何在電腦上下載 Windows 聚光燈桌布影像

Aug 23, 2023 pm 02:06 PM

窗戶從來不是一個忽視美學的人。從XP的田園綠場到Windows11的藍色漩渦設計,預設桌面桌布多年來一直是用戶愉悅的來源。借助WindowsSpotlight,您現在每天都可以直接存取鎖定螢幕和桌面桌布的美麗、令人敬畏的圖像。不幸的是,這些圖像並沒有閒逛。如果您愛上了Windows聚光燈圖像之一,那麼您將想知道如何下載它們,以便將它們作為背景保留一段時間。以下是您需要了解的所有資訊。什麼是WindowsSpotlight?窗口聚光燈是一個自動壁紙更新程序,可以從“設定”應用中的“個性化>

如何在Python中使用影像語意分割技術?

Jun 06, 2023 am 08:03 AM

如何在Python中使用影像語意分割技術?

Jun 06, 2023 am 08:03 AM

隨著人工智慧技術的不斷發展,影像語意分割技術已成為影像分析領域的熱門研究方向。在影像語意分割中,我們將一張影像中的不同區域進行分割,並對每個區域進行分類,從而達到對這張影像的全面理解。 Python是一種著名的程式語言,其強大的資料分析和資料視覺化能力使其成為了人工智慧技術研究領域的首選。本文將介紹如何在Python中使用影像語意分割技術。一、前置知識在深入

MIT最新力作:以GPT-3.5解決時間序列異常檢測問題

Jun 08, 2024 pm 06:09 PM

MIT最新力作:以GPT-3.5解決時間序列異常檢測問題

Jun 08, 2024 pm 06:09 PM

今天要為大家介紹一篇MIT上週發表的文章,使用GPT-3.5-turbo解決時間序列異常檢測問題,初步驗證了LLM在時間序列異常檢測的有效性。整個過程沒有進行finetune,直接使用GPT-3.5-turbo進行異常檢測,文中的核心是如何將時間序列轉換成GPT-3.5-turbo可辨識的輸入,以及如何設計prompt或pipeline讓LLM解決異常檢測任務。下面跟大家詳細介紹一下這篇工作。圖片論文標題:Largelanguagemodelscanbezero-shotanomalydete

iOS 17:如何在照片中使用一鍵裁剪

Sep 20, 2023 pm 08:45 PM

iOS 17:如何在照片中使用一鍵裁剪

Sep 20, 2023 pm 08:45 PM

透過iOS17照片應用,Apple可以更輕鬆地根據您的規格裁剪照片。繼續閱讀以了解如何操作。以前在iOS16中,在「照片」應用程式中裁剪圖像涉及幾個步驟:點擊編輯介面,選擇裁剪工具,然後透過捏合縮放手勢或拖曳裁剪工具的角落來調整裁剪。在iOS17中,值得慶幸的是,蘋果簡化了這個過程,這樣當你放大照片庫中任何選定的照片時,一個新的「裁剪」按鈕會自動出現在螢幕的右上角。點擊它會彈出完整的裁剪介面,其中包含您選擇的縮放級別,因此您可以裁剪到您喜歡的圖像部分,旋轉圖像,反轉圖像,或應用螢幕比例,或使用標記

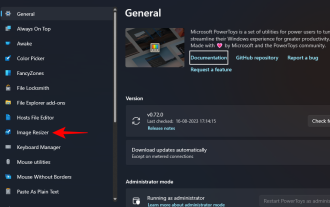

如何在Windows上使用PowerToys批次調整影像大小

Aug 23, 2023 pm 07:49 PM

如何在Windows上使用PowerToys批次調整影像大小

Aug 23, 2023 pm 07:49 PM

那些必須每天處理圖像檔案的人經常不得不調整它們的大小以適應他們的專案和工作的需求。但是,如果要處理的圖像太多,則單獨調整它們的大小會消耗大量時間和精力。在這種情況下,像PowerToys這樣的工具可以派上用場,除此之外,可以使用其影像調整大小器實用程式批次調整影像檔案的大小。以下是設定影像調整器設定並開始使用PowerToys批次調整影像大小的方法。如何使用PowerToys批次調整影像大小PowerToys是一個多合一的程序,具有各種實用程式和功能,可協助您加快日常任務。它的實用程式之一是圖像