教ChatGPT學會看圖的方法來了

2022年流行「文生圖」模型,那2023年流行什麼?

機器學習工程師Daniel Bourke的答案是:反過來!

這不,一個最新發布的「圖生文」模型在網路上爆火,其優秀的效果引發眾多網友紛紛轉發、點讚。

不僅是基礎的「看圖說話」功能,寫情詩、講解劇情、給圖片中物件設計對話等等,這個AI都拿捏得穩穩的!

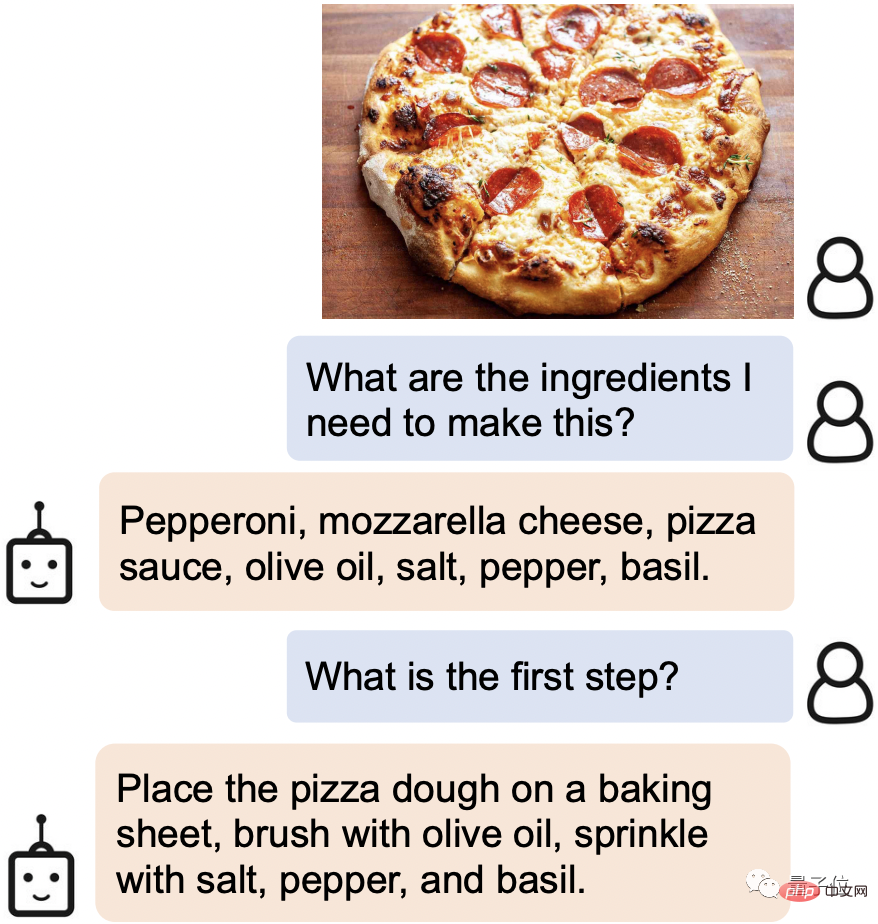

例如,當你在網路上刷到誘人的美食時,只需把圖片發給它,它就會立刻識別出需要的食材和做菜步驟:

#甚至圖片中的一些列文虎克的細節也能「看」得清清楚楚。

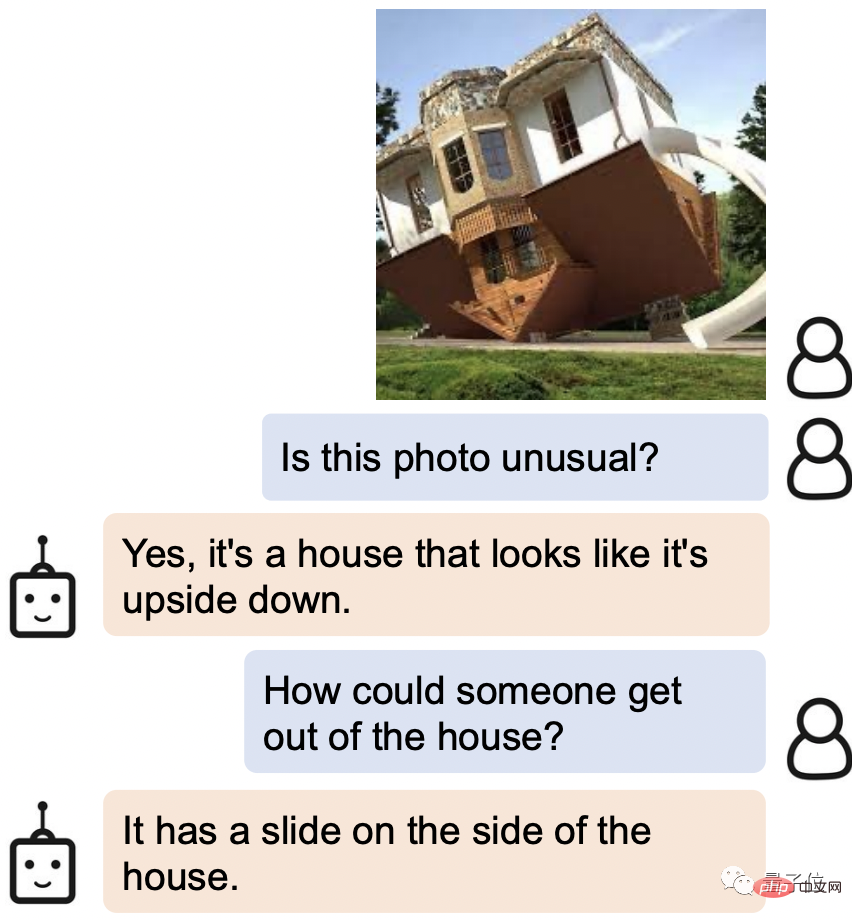

當被問到如何從圖片中倒著的房子裡離開,AI的回答是:側面不是有滑梯嘛!

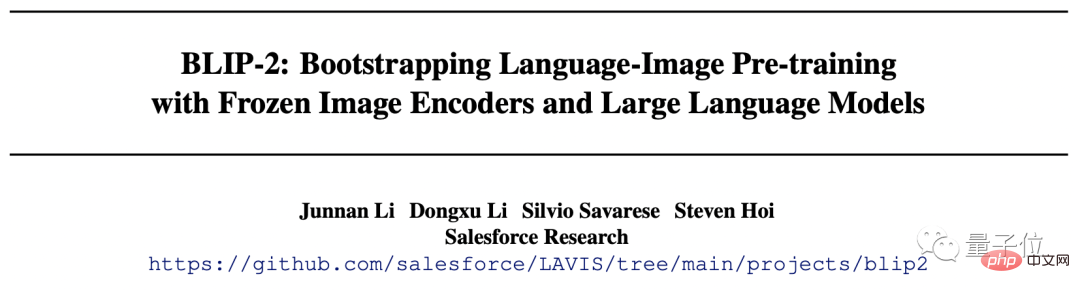

這只新AI名為BLIP-2 (Bootstrapping Language-Image Pre-training 2),目前程式碼已開源。

最重要的是,和先前的研究不同,BLIP-2使用的是一種通用的預訓練框架,因此可以任意對接自己的語言模型。

有網友已經在暢想把介面換成ChatGPT後的強強組合了。

作者之一Steven Hoi更是放話:BLIP-2未來就是「多模態版ChatGPT」。

那麼,BLIP-2神奇的地方還有哪些?一起往下看。

理解能力一流

BLIP-2的玩法可以說非常多樣化了。

只需提供一張圖片,你就可以與它對話,讓它看圖講故事、推理、生成個人化文本等各種要求都能滿足。

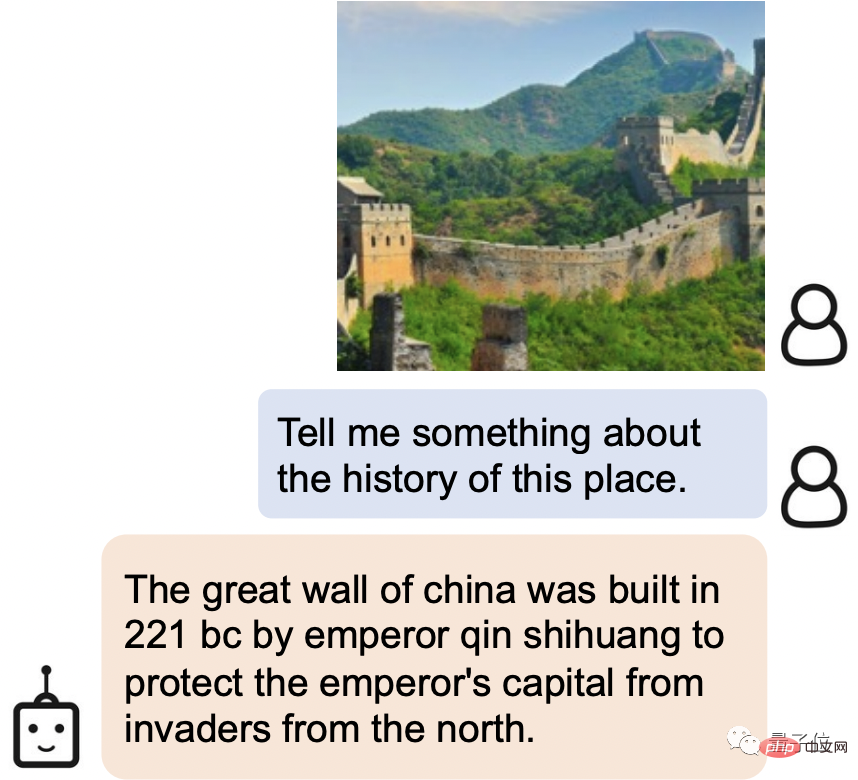

舉個例子,BLIP-2不僅能輕易辨識圖片中的景點是長城,還能介紹出長城的歷史:

中國的長城是西元前221年秦始皇為了保護帝都不受北方侵略而建造的。

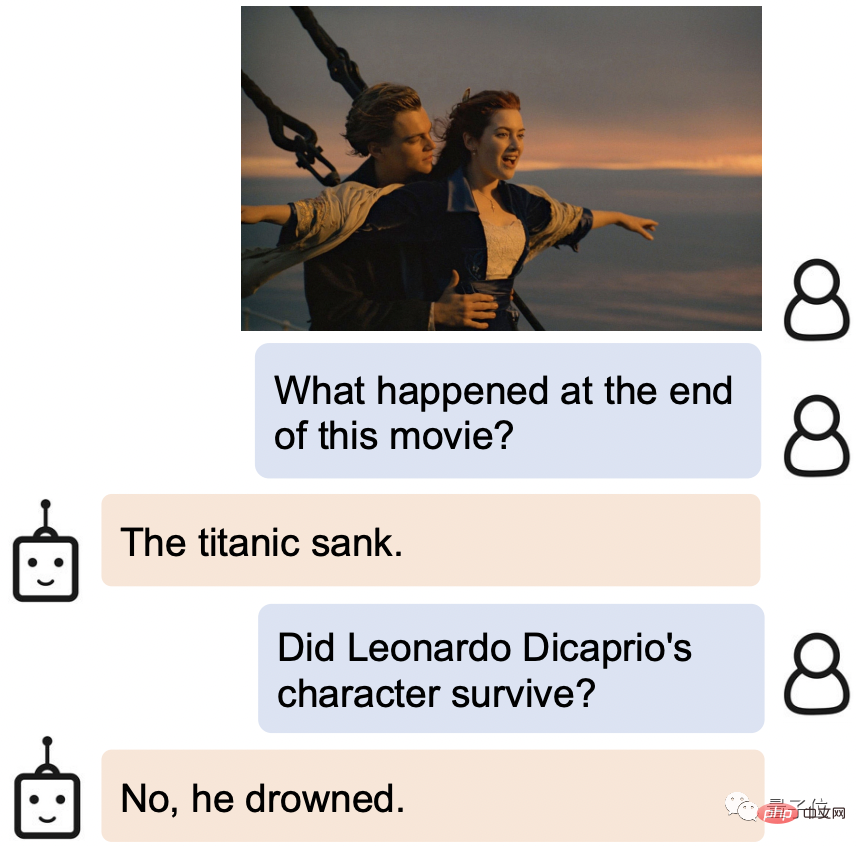

給它一張電影劇照,BLIP-2不光知道出自哪,還知道故事的結局是be:泰坦尼克號沉沒,男主淹死。

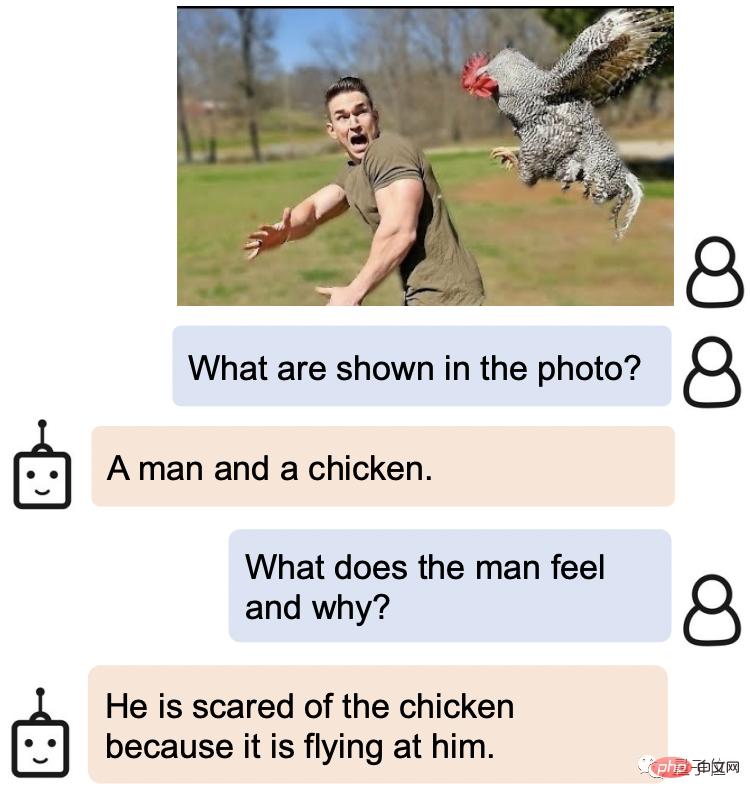

在對人類神態的拿捏上,BLIP-2同樣掌握得非常準確。

被問到這張圖片中的男人是什麼表情,他為什麼這樣時,BLIP-2的回答是:他害怕那隻雞,因為它正朝他飛來。

更神奇的是,在許多開放性問題上,BLIP-2的表現也很出色。

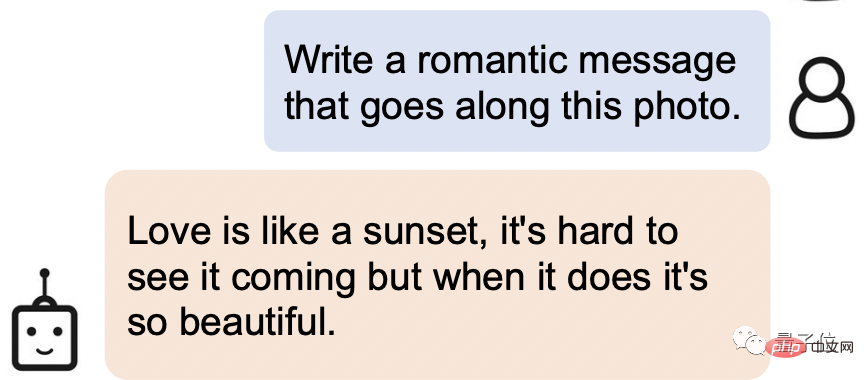

讓它根據下面的圖片寫一句浪漫的話:

#它的回答是這樣的:愛就像日落,很難預見它的到來,但當它發生時,它是如此的美麗。

這不光理解能力滿分,文學造詣也相當強啊!

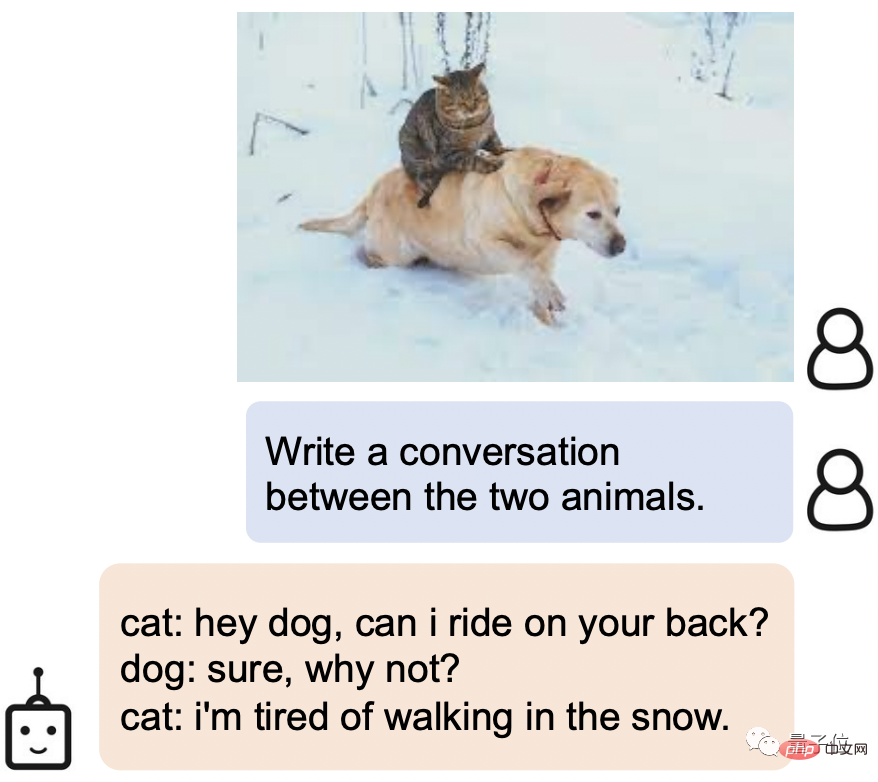

讓它給圖片中的兩隻動物生成一段對話,BLIP-2也能輕鬆拿捏傲嬌貓貓x萌蠢狗狗的設定:

貓: 嘿,狗狗,我可以騎在你背上嗎?

狗: 當然,為什麼不呢?

貓: 我已經厭倦了在雪地裡行走。

那麼,如此強大的理解能力背後,BLIP-2究竟是怎麼做到的?

多項視覺語言任務上實現新SOTA

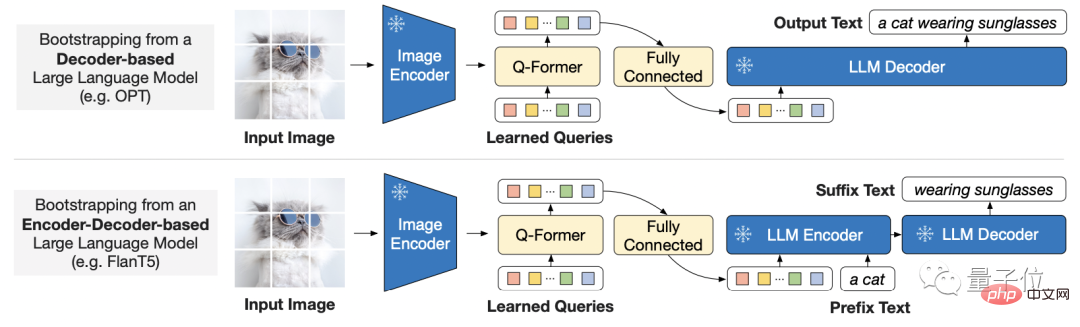

考慮到大規模模型的端到端訓練成本越來越高,BLIP-2使用的是一種通用且高效的預訓練策略:

從現成的凍結預訓練影像編碼器和凍結的大型語言模型中引導視覺語言預訓練。

這也意味著,每個人都可以選擇自己想使用的模型存取使用。

而為了彌補了模態之間的差距,研究者提出了一個輕量級的查詢Transformer。

此Transformer分兩個階段進行預先訓練:

第一階段從凍結影像編碼器引導視覺語言表示學習,第二階段將視覺從凍結的語言模型引導到語言生成學習。

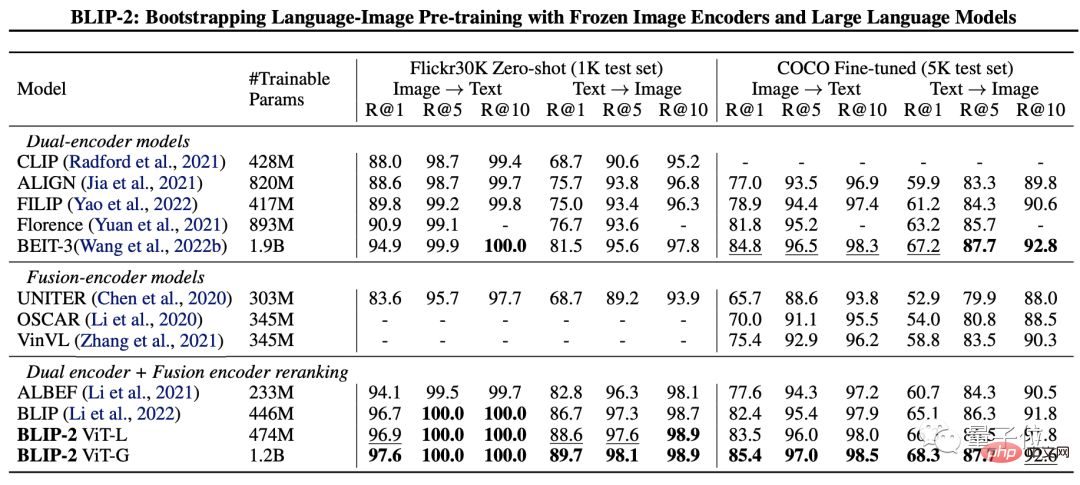

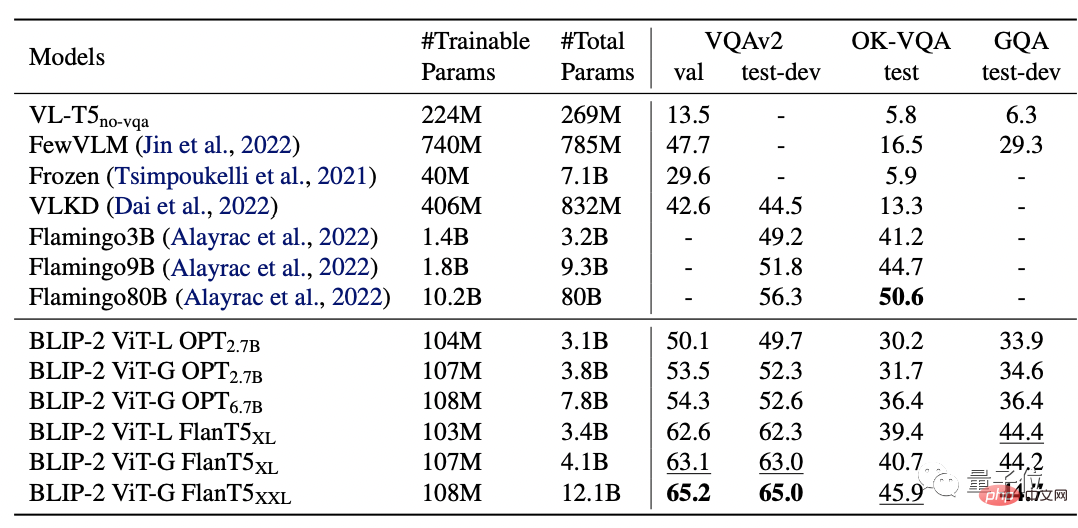

為了測試BLIP-2的效能,研究者分別從零樣本圖像-文字產生、視覺問答、圖像-文字檢索、圖像字幕任務上對其進行了評估。

最終結果顯示,BLIP-2在多項視覺語言任務上都實現了SOTA。

其中,BLIP-2在zero-shot VQAv2上比Flamingo 80B高8.7%,且訓練參數也減少了54倍。

而且顯而易見的是,更強的圖像編碼器或更強的語言模型都會產生更好的效能。

值得一提的是,研究者在論文最後也提到,BLIP-2還有一個不足,那就是缺乏上下文學習能力:

每個樣本只包含一個圖像-文字對,目前還無法學習單一序列中多個圖像-文字對之間的相關性。

研究團隊

BLIP-2的研究團隊來自Salesforce Research。

第一作者為Junnan Li,他也是一年前推出的BLIP的一作。

目前是Salesforce亞洲研究院資深研究科學家。本科畢業於香港大學,博士畢業於新加坡國立大學。

研究領域很廣泛,包括自我監督學習、半監督學習、弱監督學習、視覺-語言。

以下是BLIP-2的論文連結和GitHub鏈接,有興趣的夥伴們可以自取~

論文連結:https://arxiv.org/pdf/2301.12597. pdf

GitHub連結:https://github.com/salesforce/LAVIS/tree/main/projects/blip2

參考連結:[1]https://twitter.com/mrdbourke /status/1620353263651688448

[2]https://twitter.com/LiJunnan0409/status/1620259379223343107

以上是教ChatGPT學會看圖的方法來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

怎麼在番茄免費小說app中寫小說 分享番茄小說寫小說方法教程

Mar 28, 2024 pm 12:50 PM

怎麼在番茄免費小說app中寫小說 分享番茄小說寫小說方法教程

Mar 28, 2024 pm 12:50 PM

番茄小說是一款非常熱門的小說閱讀軟體,我們在番茄小說中經常會有新的小說和漫畫可以去閱讀,每一本小說和漫畫都很有意思,很多小伙伴也想著要去寫小說來賺取賺取零用錢,在把自己想要寫的小說內容編輯成文字,那麼我們要怎麼樣在這裡面去寫小說呢?小伙伴們都不知道,那就讓我們一起到本站本站中花點時間來看寫小說的方法介紹。分享番茄小說寫小說方法教學 1、先在手機上打開番茄免費小說app,點擊個人中心——作家中心 2、跳到番茄作家助手頁面——點擊創建新書在小說的結

七彩虹主機板怎麼進入bios?教你兩種方法

Mar 13, 2024 pm 06:01 PM

七彩虹主機板怎麼進入bios?教你兩種方法

Mar 13, 2024 pm 06:01 PM

七彩虹主機板在中國國內市場享有較高的知名度和市場佔有率,但是有些七彩虹主機板的用戶還不清楚怎麼進入bios進行設定呢?針對這一情況,小編專門為大家帶來了兩種進入七彩虹主機板bios的方法,快來試試吧!方法一:使用u盤啟動快捷鍵直接進入u盤裝系統七彩虹主機板一鍵啟動u盤的快捷鍵是ESC或F11,首先使用黑鯊裝機大師製作一個黑鯊U盤啟動盤,然後開啟電腦,當看到開機畫面的時候,連續按下鍵盤上的ESC或F11鍵以後將會進入到一個啟動項順序選擇的窗口,將遊標移到顯示“USB”的地方,然

微信刪除的人如何找回(簡單教學告訴你如何恢復被刪除的聯絡人)

May 01, 2024 pm 12:01 PM

微信刪除的人如何找回(簡單教學告訴你如何恢復被刪除的聯絡人)

May 01, 2024 pm 12:01 PM

而後悔莫及、人們常常會因為一些原因不小心刪除某些聯絡人、微信作為一款廣泛使用的社群軟體。幫助用戶解決這個問題,本文將介紹如何透過簡單的方法找回被刪除的聯絡人。 1.了解微信聯絡人刪除機制這為我們找回被刪除的聯絡人提供了可能性、微信中的聯絡人刪除機制是將其從通訊錄中移除,但並未完全刪除。 2.使用微信內建「通訊錄恢復」功能微信提供了「通訊錄恢復」節省時間和精力,使用者可以透過此功能快速找回先前刪除的聯絡人,功能。 3.進入微信設定頁面點選右下角,開啟微信應用程式「我」再點選右上角設定圖示、進入設定頁面,,

手機字體大小設定方法(輕鬆調整手機字體大小)

May 07, 2024 pm 03:34 PM

手機字體大小設定方法(輕鬆調整手機字體大小)

May 07, 2024 pm 03:34 PM

字體大小的設定成為了重要的個人化需求,隨著手機成為人們日常生活的重要工具。以滿足不同使用者的需求、本文將介紹如何透過簡單的操作,提升手機使用體驗,調整手機字體大小。為什麼需要調整手機字體大小-調整字體大小可以使文字更清晰易讀-適合不同年齡段用戶的閱讀需求-方便視力不佳的用戶使用手機系統自帶字體大小設置功能-如何進入系統設置界面-在在設定介面中找到並進入"顯示"選項-找到"字體大小"選項並進行調整第三方應用調整字體大小-下載並安裝支援字體大小調整的應用程式-開啟應用程式並進入相關設定介面-根據個人

手機版龍蛋孵化方法大揭密(一步一步教你如何成功孵化手機版龍蛋)

May 04, 2024 pm 06:01 PM

手機版龍蛋孵化方法大揭密(一步一步教你如何成功孵化手機版龍蛋)

May 04, 2024 pm 06:01 PM

手機遊戲成為了人們生活中不可或缺的一部分,隨著科技的發展。它以其可愛的龍蛋形象和有趣的孵化過程吸引了眾多玩家的關注,而其中一款備受矚目的遊戲就是手機版龍蛋。幫助玩家們在遊戲中更好地培養和成長自己的小龍,本文將向大家介紹手機版龍蛋的孵化方法。 1.選擇合適的龍蛋種類玩家需要仔細選擇自己喜歡並且適合自己的龍蛋種類,根據遊戲中提供的不同種類的龍蛋屬性和能力。 2.提升孵化機的等級玩家需要透過完成任務和收集道具來提升孵化機的等級,孵化機的等級決定了孵化速度和孵化成功率。 3.收集孵化所需的資源玩家需要在遊戲中

快速掌握:華為手機開啟兩個微信帳號方法大揭密!

Mar 23, 2024 am 10:42 AM

快速掌握:華為手機開啟兩個微信帳號方法大揭密!

Mar 23, 2024 am 10:42 AM

在現今社會,手機已經成為我們生活中不可或缺的一部分。而微信作為我們日常溝通、工作、生活的重要工具,更是經常被使用。然而,在處理不同事務時可能需要分開兩個微信帳號,這就要求手機能夠支援同時登入兩個微信帳號。華為手機作為國內知名品牌,很多人使用,那麼華為手機開啟兩個微信帳號的方法是怎麼樣的呢?下面就來揭秘一下這個方法。首先,要在華為手機上同時使用兩個微信帳號,最簡

Go語言方法與函數的差異及應用場景解析

Apr 04, 2024 am 09:24 AM

Go語言方法與函數的差異及應用場景解析

Apr 04, 2024 am 09:24 AM

Go語言方法與函數的差異在於與結構體的關聯性:方法與結構體關聯,用於操作結構體資料或方法;函數獨立於類型,用於執行通用操作。