一塊GPU,每秒20個模型!英偉達新玩具用GET3D造元宇宙

Abracadabra!

在2D生成3D模型上,英偉達亮出了自稱「世界級」研究:GET3D。

經過2D影像訓練後,此模型可產生具有高保真紋理和複雜幾何細節的3D形狀。

究竟有多厲害?

形狀、紋理、材質自訂

GET3D之所以得名,是因為它能夠產生顯式紋理3D網格(Generate Explicit Textured 3D meshes )。

論文網址:https://arxiv.org/pdf/2209.11163.pdf

#也就是說,它創建的形狀是三角形網格的形式,就像紙模型一樣,上面覆蓋著紋理材質。

關鍵是,這個模型可以產生多種多樣,且高品質的模型。

例如,椅子腿上的各種輪子;汽車的車輪,燈和車窗;動物的耳朵、角;摩托車的後視鏡,車輪胎上的紋理;高跟鞋,人類衣服...

街道兩旁的獨特建築,不同的車輛呼嘯而過,還有不同的人群穿梭而過...

若想透過手動建模做出同樣的3D虛擬世界非常耗時。

儘管先前的3D生成AI模型雖然比手動建模更快,但它們在產生更多豐富細節模型的能力還是欠缺。

即便是,最新的反向渲染方法也只能基於從各個角度拍攝的2D影像生成3D對象,開發人員一次只能建構一個3D物件。

GET3D可就不一樣了。

開發者可以輕鬆地將生成模型匯入到遊戲引擎、3D建模器和影片渲染器中,對它們進行編輯。

當創建者將GET3D產生的模型匯出到圖形應用程序,他們就可以在模型所在的場景中移動或旋轉時應用逼真的照明效果。

如圖:

另外,GET3D還可以做到文字引導形狀生成。

透過使用英偉達的另一個AI工具StyleGAN-NADA,開發人員可以使用文字提示為圖像添加特定的風格。

#例如,可以將渲染後的汽車變成一輛燒毀的汽車或出租車

#將一個普通的房子改造成磚房、著火的房子,甚至是鬼屋。

或將老虎紋、熊貓紋的特色應用在任何動物身上...

#簡直就是辛普森家庭的「動物森友會」...

#英偉達介紹,在單一英偉達GPU上訓練,GET3D每秒可以產生約20個物件。

在此,它所學習的訓練資料集越大、越多樣化,輸出的多樣性和詳細程度就越高。

英偉達稱,研究團隊僅用2天時間,就使用A100 GPU在大約100萬張圖像上訓練了模型。

研究方法與過程

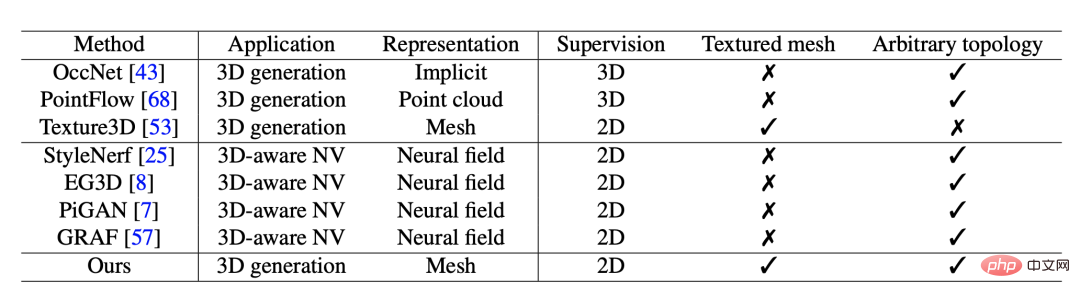

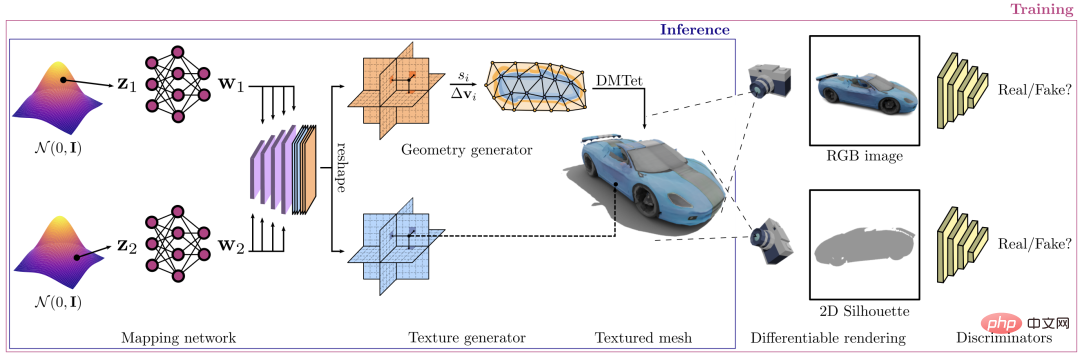

GET3D框架,主要作用是合成有紋理的三維形狀。

生成過程分為兩個部分:第一部分是幾何分支,可以輸出任意拓樸結構的表面網格。另一部分則是紋理分支,它會產生一個紋理場,由此可以在表麵點上進行查詢。

#在訓練過程中,一個可微分光柵化器被用來高效渲染所產生的紋理網格,並渲染成二維的高解析度影像。整個過程是可分的,允許透過傳播二維判別器的梯度,從影像中進行對抗性訓練。

之後,梯度從二維判別器傳播到兩個產生器分支。

研究人員又進行了廣泛的實驗來評估模型。他們首先將GET3D產生的三維紋理網格的品質與現有的使用ShapeNet和Turbosquid資料集產生的做比較。

接下來,研究人員根據對比結果在之後的研究中對模型進行了最佳化,並做了更多實驗。

GET3D模型在幾何形狀和紋理能夠實現相分離。

如圖,在每一行中展示了由相同的幾何隱藏程式碼產生的形狀,同時更改了紋理程式碼。

在每一列中展示了由相同的紋理隱藏程式碼產生的形狀,同時更改了幾何程式碼。

另外,研究人員在每一行中相同的紋理隱藏程式碼產生的形狀,從左到右插入幾何隱藏程式碼。

並由相同的幾何隱藏程式碼產生的形狀,同時從上到下插入紋理程式碼。結果顯示,每個插值對生成模型都是有意義的。

#

在每個模型的子圖中,GET3D能夠在所有類別的不同形狀之間的生成實現平滑過渡。

在每一行中,透過加入一個小雜訊來局部擾亂隱藏程式碼。透過這種方式,GET3D能夠在局部產生外觀相似但略有差異的形狀。

研究人員指出,未來版本的GET3D可以使用攝影機姿態估計技術,讓開發人員訓練模型的現實世界的數據,而不是合成數據集。

未來,透過改進,開發人員可以在各種3D形狀上一次訓練GET3D,而不需要一次在一個物件類別上訓練它。

英偉達人工智慧研究副總裁Sanja Fidler表示,

GET3D讓我們離人工智慧驅動的3D內容創作大眾化又更近了一步。它即時產生帶有紋理3D形狀的能力可能會改變開發人員的遊戲規則,幫助他們用各種有趣的物件快速填充虛擬世界。

作者介紹

論文一作Jun Gao是多倫多大學機器學習小組的博士生,指導教授是Sanja Fidler。

除了學歷優異以外,他也是英偉達多倫多人工智慧實驗室的研究科學家。

他的研究主要集中在深度學習(DL),目標直指結構化幾何表示學習。同時,他的研究也從人類對2D和3D影像、視訊的感知中獲得見解。

這麼優秀的高材生,來自北京大學。他於2018年本科畢業,並獲得學士學位。在北大期間,他和王立威教授一同工作。

畢業後他也曾在史丹佛大學、MSRA和英偉達進行實習。

Jun Gao的導師同樣是業界翹楚。

Fidler是多倫多大學的副教授,Vector研究所的教師,同時,她也是該研究所的共同創始成員之一。

教學之外,她也是英偉達公司的人工智慧研究副總裁,領導著多倫多的一個研究實驗室。

在來到多倫多之前,她是芝加哥豐田技術研究所的研究助理教授。該研究所位於芝加哥大學校園內,算是學術機構。

Fidler的研究領域集中在電腦視覺(CV)和機器學習(ML),聚焦於CV和圖形學的交叉領域、三維視覺,以及三維重建與合成,還有影像註解的互動方法等等。

#以上是一塊GPU,每秒20個模型!英偉達新玩具用GET3D造元宇宙的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

Beelink EX顯示卡擴充座承諾GPU效能零損失

Aug 11, 2024 pm 09:55 PM

Beelink EX顯示卡擴充座承諾GPU效能零損失

Aug 11, 2024 pm 09:55 PM

最近推出的 Beelink GTi 14 的突出特點之一是迷你 PC 下方有一個隱藏的 PCIe x8 插槽。該公司在發佈時表示,這將使外部顯示卡更容易連接到系統。 Beelink有n

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

開放LLM社群正是百花齊放、競相爭鳴的時代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1等許多表現優良的模型。但是,相較於以GPT-4-Turbo為代表的專有大模型,開放模型在許多領域仍有明顯差距。在通用模型之外,也有一些專精關鍵領域的開放模型已被開發出來,例如用於程式設計和數學的DeepSeek-Coder-V2、用於視覺-語言任務的InternVL

AMD FSR 3.1 推出:幀產生功能也適用於 Nvidia GeForce RTX 和 Intel Arc GPU

Jun 29, 2024 am 06:57 AM

AMD FSR 3.1 推出:幀產生功能也適用於 Nvidia GeForce RTX 和 Intel Arc GPU

Jun 29, 2024 am 06:57 AM

AMD 兌現了 24 年 3 月的最初承諾,將於今年第二季推出 FSR 3.1。 3.1 版本的真正與眾不同之處在於幀生成方面與升級方面的解耦。這使得 Nvidia 和 Intel GPU 擁有者可以應用 FSR 3。

「AI 工廠」將推動軟體全端重塑,英偉達提供 Llama3 NIM 容器供用戶部署

Jun 08, 2024 pm 07:25 PM

「AI 工廠」將推動軟體全端重塑,英偉達提供 Llama3 NIM 容器供用戶部署

Jun 08, 2024 pm 07:25 PM

本站6月2日消息,在目前正在進行的黃仁勳2024台北電腦展主題演講上,黃仁勳介紹生成式人工智慧將推動軟體全端重塑,展示其NIM(NvidiaInferenceMicroservices)雲端原生微服務。英偉達認為「AI工廠」將掀起一場新產業革命:以微軟開創的軟體產業為例,黃仁勳認為生成式人工智慧將推動其全端重塑。為方便各種規模的企業部署AI服務,英偉達今年3月推出了NIM(NvidiaInferenceMicroservices)雲端原生微服務。 NIM+是一套經過優化的雲端原生微服務,旨在縮短上市時間

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

為了將大型語言模型(LLM)與人類的價值和意圖對齊,學習人類回饋至關重要,這能確保它們是有用的、誠實的和無害的。在對齊LLM方面,一種有效的方法是根據人類回饋的強化學習(RLHF)。儘管RLHF方法的結果很出色,但其中涉及了一些優化難題。其中涉及訓練一個獎勵模型,然後優化一個策略模型來最大化該獎勵。近段時間已有一些研究者探索了更簡單的離線演算法,其中之一就是直接偏好優化(DPO)。 DPO是透過參數化RLHF中的獎勵函數來直接根據偏好資料學習策略模型,這樣就無需顯示式的獎勵模型了。此方法簡單穩定

無需OpenAI數據,躋身程式碼大模型榜單! UIUC發表StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

無需OpenAI數據,躋身程式碼大模型榜單! UIUC發表StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

在软件技术的前沿,UIUC张令明组携手BigCode组织的研究者,近日公布了StarCoder2-15B-Instruct代码大模型。这一创新成果在代码生成任务取得了显著突破,成功超越CodeLlama-70B-Instruct,登上代码生成性能榜单之巅。StarCoder2-15B-Instruct的独特之处在于其纯自对齐策略,整个训练流程公开透明,且完全自主可控。该模型通过StarCoder2-15B生成了数千个指令,响应对StarCoder-15B基座模型进行微调,无需依赖昂贵的人工标注数

LLM全搞定! OmniDrive:集3D感知、推理規劃於一體(英偉達最新)

May 09, 2024 pm 04:55 PM

LLM全搞定! OmniDrive:集3D感知、推理規劃於一體(英偉達最新)

May 09, 2024 pm 04:55 PM

寫在前面&筆者的個人理解這篇論文致力於解決當前多模態大語言模型(MLLMs)在自動駕駛應用中存在的關鍵挑戰,即將MLLMs從2D理解擴展到3D空間的問題。由於自動駕駛車輛(AVs)需要針對3D環境做出準確的決策,這項擴展顯得格外重要。 3D空間理解對於AV來說至關重要,因為它直接影響車輛做出明智決策、預測未來狀態以及與環境安全互動的能力。目前的多模態大語言模型(如LLaVA-1.5)通常只能處理較低解析度的影像輸入(例如),這是由於視覺編碼器的分辨率限制,LLM序列長度的限制。然而,自動駕駛應用需