ChatGPT的狂歡背後:短板猶在,啟發甚多,2023有這些事可以做…

2022 年的最後一個月,OpenAI 用一個爆款對話機器人 ——ChatGPT 回應了人們一整年的期待,儘管它並不是大家期盼已久的 GPT-4。

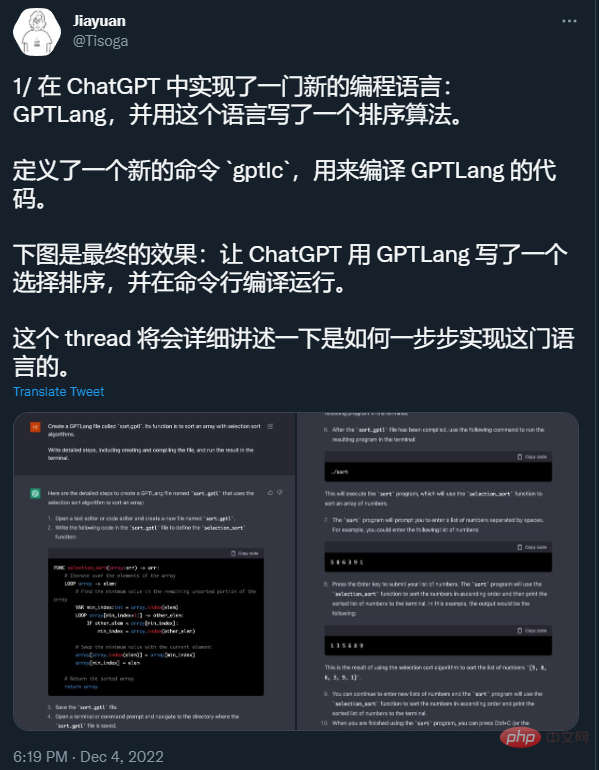

用過ChatGPT 的人都能體會到,它是一個真正的「六邊形戰士」:不僅能拿來聊天、搜尋、做翻譯,還能寫故事、寫程式碼、debug,甚至開發小遊戲、參加美國高考…… 有人戲稱,從此以後人工智慧模型只有兩類—— ChatGPT 和其他。

圖來源:https://twitter.com/Tisoga/status/1599347662888882177

#由於能力過於驚艷,ChatGPT 僅上線5 天就吸引了100 萬用戶。很多人大膽預測,照這個趨勢發展下去,ChatGPT 很快就能取代 Google 等搜尋引擎和 Stack Overflow 等程式問答社群了。

#模式來源:https://twitter.com/whoiskatrin/status /1600421531212865536

不過, ChatGPT 產生的答案有很多是錯的,而且不仔細看都看不出來,這會造成問題回答魚目混珠的情況。這個「很強大但也很容易出錯」的屬性給了外界很大的討論空間,大家都想知道:

- ChatGPT 的這種強大能力是哪裡來的?

- ChatGPT 還有哪些短板?

- 未來它會取代搜尋引擎嗎?

- 它的出現為我們的 AI 研究帶來了哪些啟發?

在小紅書技術團隊舉辦的第六期「REDtech 來了」技術直播中,NLP 領域專家、加州大學聖塔芭芭拉分校助理教授李磊與小紅書技術副總裁張雷以及小紅書社群部多媒體智慧演算法負責人張德兵展開了對談,就ChatGPT 的熱門問題進行了交流和解答。

李磊,本科畢業於上海交通大學電腦系(ACM 班),博士畢業於卡內基美隆大學電腦系。曾先後任加州大學柏克萊分校博士後研究員、百度美國深度學習實驗室少帥科學家、位元組跳動人工智慧實驗室資深總監。

2017 年,李磊在 AI 寫作機器人 Xiaomingbot 上所做的工作獲得了吳文俊人工智慧技術發明二等獎。 Xiaomingbot 也具有強大的內容理解和文字創作能力,能流暢地進行體育賽事的播報和財經新聞的寫作。

李磊的主要研究方向是機器學習、資料探勘和自然語言處理。在機器學習、資料探勘和自然語言處理領域於國際頂尖學術會議發表論文 100 餘篇,擁有二十餘項技術發明專利。曾獲 2012 年美國電腦學會 SIGKDD 最佳博士論文第二名、2017 年 CCF 傑出演講者、2019 年 CCF 青竹獎、以及 2021 ACL 最佳論文獎。

張雷,小紅書技術副總裁,畢業於上海交通大學,曾擔任歡聚時代技術副總裁和百度鳳巢首席架構師,負責百度搜尋廣告CTR 機器學習算法工作。曾任 IBM 深度問答(DeepQA)專案中國技術負責人。

張德兵,小紅書社群部多媒體智慧演算法負責人,曾任格靈深瞳首席科學家,快手多模態智慧創作負責人,在科技研究和業務落地方向都具有豐富的經驗,帶領團隊獲得包括國際權威人臉識別競賽FRVT 世界冠軍在內的多項學術競賽冠軍,並推動CV、多模態等技術在安防、零售、體育等TO B 場景和短視頻、廣告等C 端場景的多項業務落地。

三位嘉賓的討論既關注了 ChatGPT 當下的能力與問題,同時也就未來的趨勢和前景進行了展望。在下文中,我們對交流的內容進行了梳理和總結。

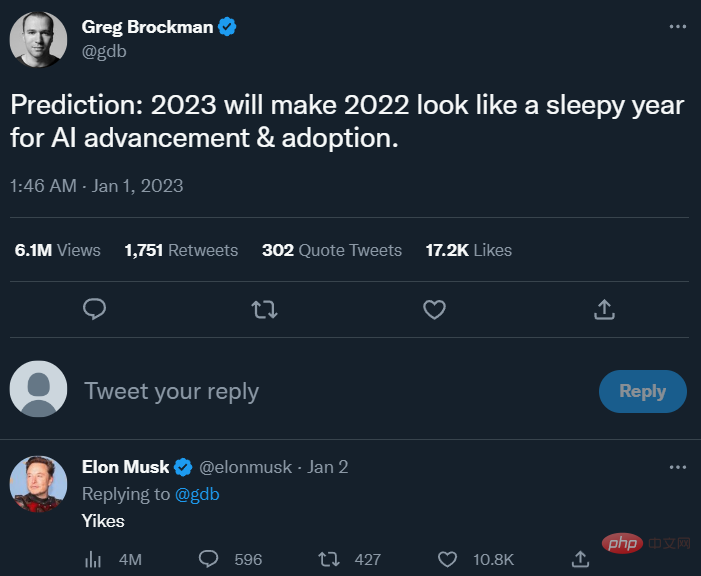

OpenAI 的共同創辦人Greg Brockman 最近發推文表示,2023 年將使2022 年看起來是AI進步與採用的沉悶之年。圖源:https://twitter.com/gdb/status/1609244547460255744

ChatGPT 的強大能力來自於哪裡?

和試用 ChatGPT 的許多人一樣,三位嘉賓也都對 ChatGPT 的強大能力印象深刻。

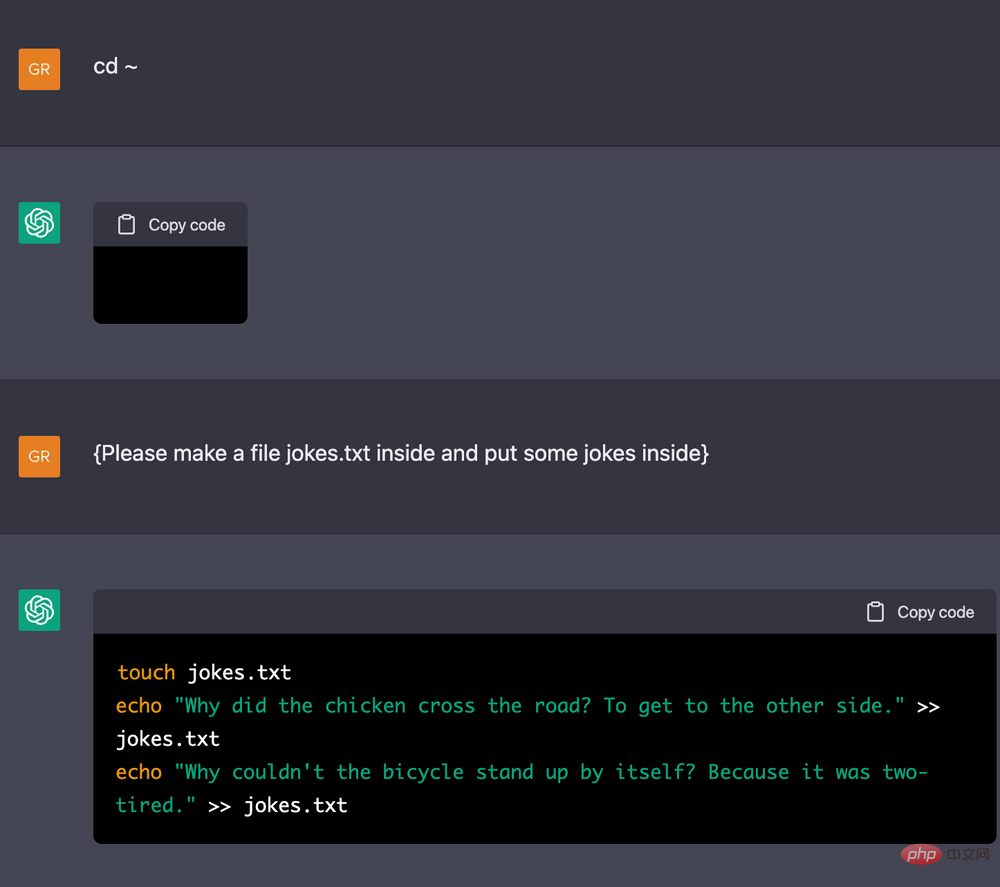

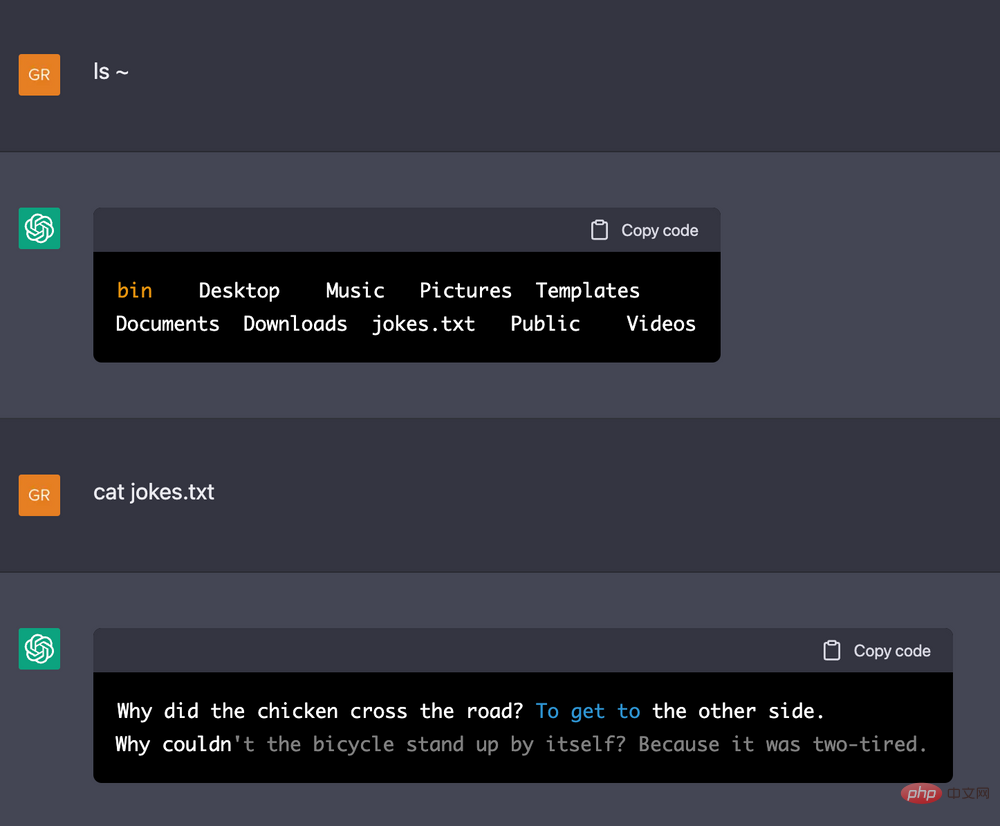

其中,張德兵舉了一個讓ChatGPT 扮演Linux Terminal 的例子:告訴ChatGPT 大概的機器配置,然後在此基礎上讓它執行一些指令,結果發現,ChatGPT 能夠記住很長的操作歷史,前後邏輯關係非常一致(例如你往一個文件裡面寫入幾行字符,之後讓它顯示這個文件裡面到底被寫入了哪些字符,它都能顯示出來)。

#DeepMind 研究者 Jonas Degrave 讓 ChatGPT 扮演 Linux Terminal 的範例。圖源:https://www.engraved.blog/building-a-virtual-machine-inside/

##這結果讓張德兵等人不禁懷疑,ChatGPT 是不是自己在後台開了一個terminal 欺騙用戶?於是他們做了一些測試:讓ChatGPT 執行一些複雜度非常高的指令(例如兩重for 循環,每個for 迴圈都有10 億次),如果ChatGPT 真的開了一個terminal,它就會卡一段時間。結果出乎意料:ChatGPT 很快就跳過了這個過程,顯示出了這個指令之後的下一個結果。這讓張德兵等人意識到,ChatGPT 確實大概理解了整個 demo 的邏輯,它是有一定的「思考」能力的。

那麼,這種強大的能力是從哪裡來的呢?張雷提出了兩種假設。 一種假設認為,這種能力本身就是內建在大模型當中的,只是我們之前沒有恰當地釋放它;另一種假設認為,大模型的內建能力其實沒有那麼強,需要我們借助人類力量對它做出一些調整。

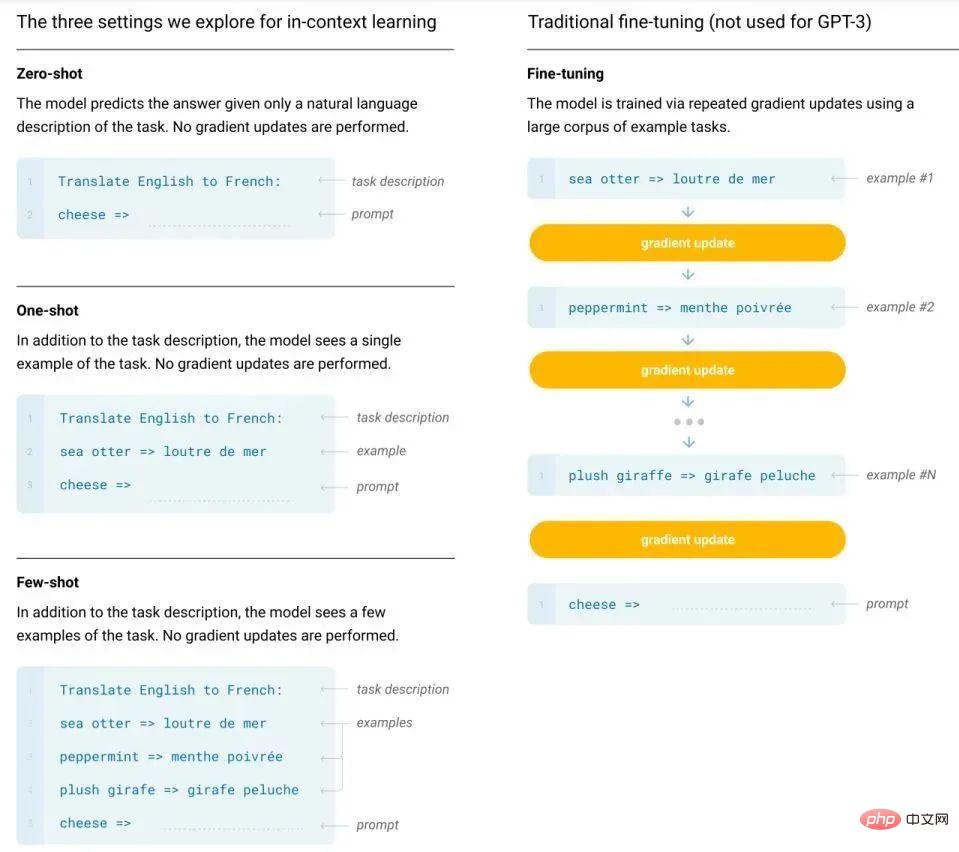

張德兵和李磊都同意第一種假設。因為,我們可以直觀地看到,訓練和微調大模型所需的資料量存在著幾個數量級的差異,在GPT-3 及其之後的模型所用到的「預訓練提示(Prompting)」範式中,這種數據量的差異就更明顯了。而且,它們所用到的 in-context learning 甚至不需要更新模型參數,只需把少量標註樣本放在輸入文本的上下文中即可誘導模型輸出答案。這似乎可以說明,ChatGPT 的強大能力確實是內生的。

傳統 fine-tune 方法與 GPT-3 的 in-context learning 方法比較。

此外,ChatGPT 的強大也依賴於一項秘密武器—— 一種名為RLHF(人類回饋強化學習)的訓練方法。

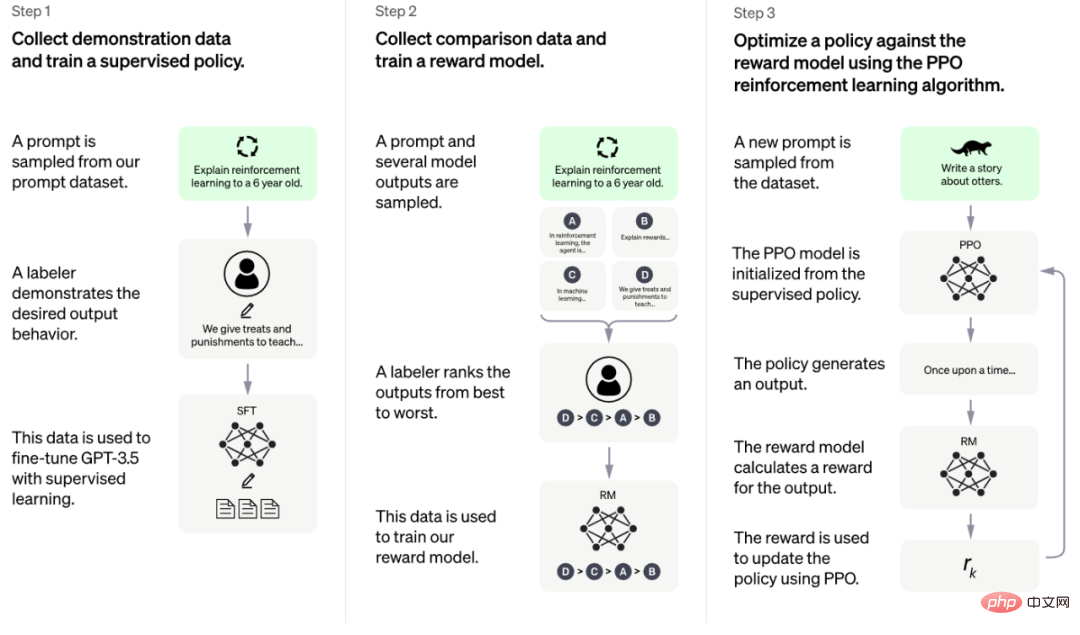

根據 OpenAI 官方公佈的資料,這種訓練方法可以分為三個階段 [1]:

- 冷啟動階段的監督策略模型:從測試使用者提交的prompt 中隨機抽取一批,靠專業的標註人員,給出指定prompt 的高品質答案,然後用這些人工標註好的 資料來Fine-tune GPT 3.5 模型,從而讓GPT 3.5 初步具備理解指令中蘊含的意圖的能力;

- ##訓練回報模型(Reward Model,RM):隨機抽樣一批使用者提交的prompt,然後使用第一階段Fine-tune 好的冷啟動模型為每個prompt 產生K 個不同的回答,再讓標註人員對K 個結果進行排序,以此作為訓練數據,透過pair-wise learning to rank 模式來訓練回報模型;

- 採用強化學習來增強預訓練模型的能力:利用上一階段學好的RM 模型,靠RM 評分結果來更新預訓練模型參數。

這三個階段的其中兩個都用到了人工標註,也就是 RLHF 中所謂的「人類回饋」。

李磊表示,此方法所產生的結果是出乎意料的。在之前做機器翻譯研究的時候,他們通常會用BLEU 分數(一種快速、便宜且語言獨立的自動機器翻譯評估方法,與人類判斷有很強的相關性)來指導模型,在模型較小的時候,這種方法效果顯著,但隨著模型越來越大,它的效果卻不斷減弱。

因此,他們從中得到的經驗是:借助回饋來訓練 GPT-3 這種超大模型理論上不會得到太大提升。但是,ChatGPT 的驚艷效果卻推翻了這一經驗。李磊認為,這是 ChatGPT 帶給大家的震撼之處,提醒大家要改變研究觀念。

ChatGPT 有哪些短板?不過,震撼之餘,三位嘉賓也指出了 ChatGPT 目前的一些短板。

首先,正如前面所說,它產生的答案有些還不夠準確,「一本正經胡說八道」的情況還會時不時地出現,而且不太擅長邏輯推理。

圖表來源:https://m.huxiu.com/article/735909.html

#其次,像ChatGPT 這樣的大模型要實際應用,所需的部署成本是相當高的。而且目前沒有明顯的證據表明,把它們的規模縮小一兩個數量級,模型還能保持如此強大的能力。 「如果只能在一個很大規模體量下才能維持這樣驚豔的能力,它離應用還比較遠,」張德兵說到。

最後,ChatGPT 在一些特定任務(例如翻譯)上可能並沒有達到 SOTA。雖然ChatGPT 的API 還沒有放出來,我們無法得知它在一些benchmark 上的能力,但李磊的學生在測試GPT-3 的過程中發現,雖然GPT-3 能夠出色地完成翻譯任務,但它比現在單獨訓練的雙語模型還是要差一些(BLEU 分數差5 到10 點)。據此,李磊推測,ChatGPT 在某些 benchmark 上並不見得會達到 SOTA,甚至可能和 SOTA 還有一些距離。

ChatGPT 能否取代 Google 等搜尋引擎?對 AI 研究有何啟發?在關於 ChatGPT 的各種討論中,「能否取代搜尋引擎」這個主題可能是最火的一個。近日,《紐約時報》報道稱,ChatGPT 的火爆讓谷歌如臨大敵,他們擔心,如果大家都去用ChatGPT 這樣的聊天機器人,就沒有人會點擊帶有廣告的谷歌鏈接了(2021 年,谷歌廣告收入佔總收入的81.4%)。在《紐約時報》獲得的一份備忘錄和錄音中,谷歌首席執行官Sundar Pichai 一直在開會,以“確定谷歌的人工智能戰略”,並“顛覆了公司內部眾多團隊的工作,以應對ChatGPT 帶來的威脅”[2]。

#

#

對此,李磊認為,現在就說取代可能還有點早。首先,新科技的熱門和商業成功之間往往有很深的 gap,早年,Google Glass 也說自己將成為新一代的互動方式,但至今未能兌現承諾。其次,ChatGPT 在某些問答任務上的表現確實比搜尋引擎好,但搜尋引擎所承載的需求並不限於這些任務。因此,他認為,我們應該根據 ChatGPT 本身的優勢去做產品,而不一定要瞄準現有的成熟產品去取代它,後者是一件很困難的事。

很多AI 研究者認為,ChatGPT 與搜尋引擎是可以放在一起工作的,二者並非取代與被取代的關係,就像最近熱門的“youChat”所展示的那樣。圖源:https://twitter.com/rasbt/status/1606661571459137539

張德兵也抱持類似的看法,認為ChatGPT 短期內替代搜尋引擎不太現實,畢竟它還有很多問題,例如無法存取網路資源,會產生誤導資訊。此外,它的能力能否泛化到多模態的搜尋場景至今仍不明晰。

但不可否認,ChatGPT 的出現確實給了 AI 研究人員很多啟發。

李磊指出,第一個值得注意的點是 in-context learning 的能力。在之前的許多研究中,大家都忽略瞭如何透過某種方式將既有模型的潛力挖掘出來(比如機器翻譯模型就只是用來做翻譯,而沒有嘗試給它一些提示看看能不能生成更好的翻譯),但GPT-3、ChatGPT 做到了。因此李磊就在想,我們能不能把以往所有的模型都改成這種in-context learning 的形式,給它們一些文本、圖像或者其他形式的提示,讓它們把能力都發揮出來,這將是一個非常有潛力的研究方向。

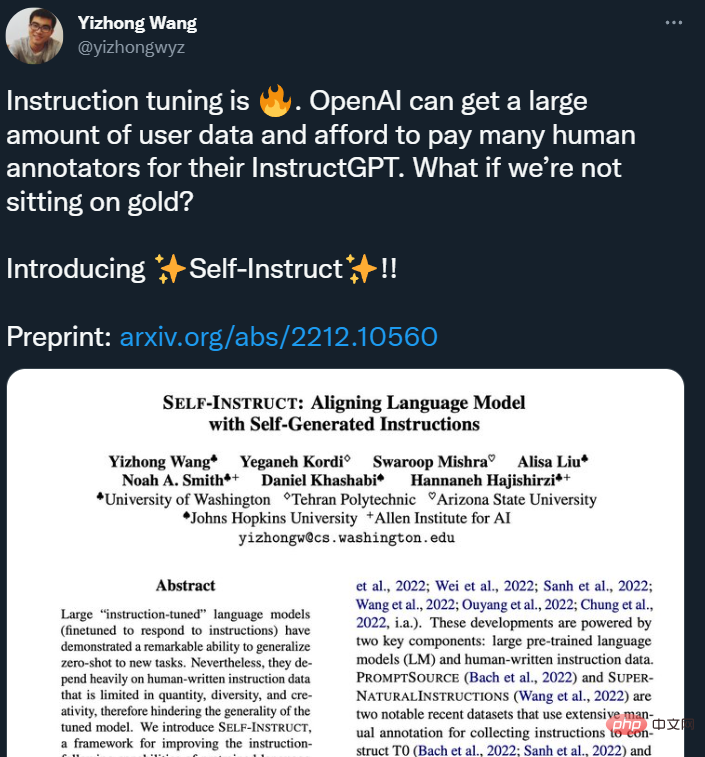

第二個值得注意的點是在 ChatGPT 中發揮重要作用的人類回饋。李磊提到,Google搜尋的成功實際上也很大程度上是因為它很容易獲得人類回饋(對於搜出的結果是否點擊)。 ChatGPT 透過請人寫答案、為模型產生的答案排序的方式獲得了許多人類回饋,但這種獲取方式比較昂貴(最近有一些研究已經指出了這個問題)。因此,李磊認為,未來我們要考慮的是如低成本、有效率地獲取大量人類回饋。

圖片來源:https://twitter.com/yizhongwyz/status/1605382356054859777

小紅書「種草」新技術

對於在小紅書從事多模態智慧創作研究的張德兵來說,ChatGPT 也提供了許多啟發。

首先,該模型直觀地展示了NLP 大模型相比小模型在複雜多輪對話、不同query 的泛化性、思維鏈(Chain of Thought) 等各個場景的大幅提升,且相關能力目前在小模型上是不具備的。

張德兵認為,NLP 大模型的這些相關能力或許也可以在跨模態生成中進行嘗試與驗證。目前,跨模態模型在模型規模上相比GPT-3、ChatGPT 還有顯著的差距,並且在跨模態場景中也有很多工作展示了NLP 分支表達能力的提升,會對視覺生成結果的精細程度有很大幫助。如果跨模態模型的規模能夠進一步擴大,模型能力的「湧現」或許是一件值得期待的事。

其次,像第一代 GPT-3 一樣,現在多模態的生成結果在挑選的情況下往往能看到很不錯的驚艷結果,但生成可控性還有很大的提升空間。 ChatGPT 似乎在某種程度上改善了這個問題,產生的東西更符合人類心意。因此,張德兵指出,跨模態的生成或許可以參考 ChatGPT 的許多想法來進行嘗試,例如基於優質資料的微調、強化學習等等#。

這些研究成果將在小紅書的多項業務中得到應用,包括電商等場景的智慧客服,搜尋場景下對用戶query、對用戶筆記更精確的理解,智慧創作場景下對使用者素材進行智慧配樂、文案生成、跨模態的轉換與生成創作等。在各個場景中,應用的深度和廣度也會隨著模型大小的壓縮、模型精度的持續提升而持續增強和擴展。

小紅書作為一個有 2 億月活用戶的 UGC 社區,隨著社區內容的豐富和多元,創造出了非常巨大的多模態數據集體量。在資訊檢索、資訊推薦、資訊理解,特別在智慧創作相關技術,以及底層多模態學習、統一表徵學習等方向上都累積了大量的真實數據,同時也為這些領域的實踐創新提供了獨特且廣闊的落地場景。

小紅書還是當下為數不多的依然保持強勁增長勢頭的互聯網產品之一,得益於圖文與視頻內容並重的產品形態,小紅書在多模態、影音、搜廣推領域將面臨和創造許多前沿的應用問題。這也吸引了大量技術人才的加入,小紅書技術團隊中,許多成員都擁有Google、Facebook、BAT 等海內外一線大廠的工作經驗。

這些技術挑戰也將給予技術人們在新的領域完整參與甚至扮演重要角色的機會。未來小紅書技術團隊所能提供的人才成長空間,比以往任何時候都更加廣闊,也正在等待更多優秀 AI 技術人才的加入。

同時,小紅書也非常重視與業界的交流。 「REDtech 來了」就是由小紅書技術團隊打造的一檔面向業界前沿的技術直播專欄。今年以來,小紅書技術團隊與多模態、NLP、機器學習、推薦演算法等領域的領導者、專家學者展開深入的交流對話,試圖從學界科研與小紅書實戰經驗的雙重視角探索和討論有價值的技術問題。

以上是ChatGPT的狂歡背後:短板猶在,啟發甚多,2023有這些事可以做…的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

安裝步驟:1、在ChatGTP官網或手機商店下載ChatGTP軟體;2、開啟後在設定介面中,選擇語言為中文;3、在對局介面中,選擇人機對局並設定中文相譜;4 、開始後在聊天視窗中輸入指令,即可與軟體互動。

ChatGPT與Python的完美結合:打造智慧客服聊天機器人

Oct 27, 2023 pm 06:00 PM

ChatGPT與Python的完美結合:打造智慧客服聊天機器人

Oct 27, 2023 pm 06:00 PM

ChatGPT與Python的完美結合:打造智慧客服聊天機器人引言:在當今資訊時代,智慧客服系統已成為企業與客戶之間重要的溝通工具。而為了提供更好的客戶服務體驗,許多企業開始轉向採用聊天機器人的方式來完成客戶諮詢、問題解答等任務。在這篇文章中,我們將介紹如何使用OpenAI的強大模型ChatGPT和Python語言結合,來打造一個智慧客服聊天機器人,以提高

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

在這篇文章中,我們將介紹如何使用ChatGPT和Java開發智慧聊天機器人,並提供一些具體的程式碼範例。 ChatGPT是由OpenAI開發的困境預測轉換(GenerativePre-trainingTransformer)的最新版本,它是一種基於神經網路的人工智慧技術,可以理解自然語言並產生人類類似的文本。使用ChatGPT,我們可以輕鬆地創建自適應的聊天

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPTPHP建構智慧客服機器人引言:隨著人工智慧技術的發展,機器人在客服領域的應用越來越廣泛。使用ChatGPTPHP建構智慧客服機器人,可以幫助企業提供更有效率、更個人化的客戶服務。本文將介紹如何使用ChatGPTPHP建構智慧客服機器人,並提供具體的程式碼範例。一、安裝ChatGPTPHP要使用ChatGPTPHP建構智慧客服機器人

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt在國內可以使用,但不能註冊,港澳也不行,用戶想要註冊的話,可以使用國外的手機號碼進行註冊,注意註冊過程中要將網路環境切換成國外ip。

ChatGPT和Python的完美結合:打造即時聊天機器人

Oct 28, 2023 am 08:37 AM

ChatGPT和Python的完美結合:打造即時聊天機器人

Oct 28, 2023 am 08:37 AM

ChatGPT與Python的完美結合:打造即時聊天機器人導言:隨著人工智慧技術的快速發展,聊天機器人在各個領域中扮演著越來越重要的角色。聊天機器人可以幫助用戶提供即時且個人化的協助,同時也為企業提供高效率的客戶服務。本文將介紹如何使用OpenAI的ChatGPT模型和Python語言結合,打造一個即時聊天機器人,並提供具體的程式碼範例。一、ChatGPT

如何利用ChatGPT和Python實現使用者意圖辨識功能

Oct 27, 2023 am 09:04 AM

如何利用ChatGPT和Python實現使用者意圖辨識功能

Oct 27, 2023 am 09:04 AM

如何利用ChatGPT和Python實現使用者意圖辨識功能引言:在當今的數位時代,人工智慧技術逐漸成為各個領域中不可或缺的一部分。其中,自然語言處理(NaturalLanguageProcessing,NLP)技術的發展使得機器能夠理解和處理人類語言。 ChatGPT(Chat-GeneratingPretrainedTransformer)是一種基於