相信很多人已經領會過生成式 AI 技術的魅力,特別是在經歷了 2022 年的 AIGC 爆發之後。以Stable Diffusion 為代表的文本到圖像生成技術一度風靡全球,無數用戶湧入,借助AI 之筆表達自己的藝術想像……

相比於圖像編輯,視頻編輯是一個更具有挑戰性的議題,它需要合成新的動作,而不僅僅是修改視覺外觀,此外還需要保持時間上的一致性。

在這條賽道上探索的公司也不少。前段時間,Google發布的 Dreamix 以將文字條件視訊擴散模型(video diffusion model, VDM)應用於影片編輯。

近日,曾參與創建Stable Diffusion 的Runway 公司推出了一個新的人工智慧模型“Gen-1”,該模型透過應用文字prompt 或參考圖像指定的任何風格,可將現有影片轉化為新影片。

論文連結:https://arxiv.org/pdf/2302.03011.pdf

#計畫首頁:https://research.runwayml.com/gen1

2021 年,Runway 與慕尼黑大學的研究人員合作,建立了Stable Diffusion 的第一個版本。隨後英國的一家新創公司 Stability AI 介入,資助了在更多數據上訓練模型所需的計算費用。 2022 年,Stability AI 將 Stable Diffusion 納入主流,從研究計畫轉變為全球現象。

Runway 表示,希望 Gen-1 能像 Stable Diffusion 在影像上所做的那樣為影片服務。

「我們已經看到圖像生成模型的大爆炸,」Runway 執行長兼聯合創始人 Cristóbal Valenzuela 說。 「我真的相信,2023 年將是影片之年。」

具體來說,Gen-1 支援幾種編輯模式:

#1、風格化。將任何影像或 prompt 的風格轉移到影片的每一幀。

2、分鏡。將模型變成完全風格化和動畫的渲染。

3、遮罩。分離影片中的主題並使用簡單的文字 prompt 對其進行修改。

4、渲染。透過應用輸入影像或 prompt,將無紋理渲染變成逼真的輸出。

5、客製化。透過自訂模型以獲得更高保真度的結果,釋放 Gen-1 的全部功能。

在該公司官方網站上發布的 demo 中,展示了 Gen-1 如何絲滑地更改影片風格,來看幾個範例。

例如將「街上的人」變成「黏土木偶」,只需要一行prompt:

或將「堆放在桌上的書」變成「夜晚的城市景觀」:

從「雪地上的奔跑」到「月球漫步」:

年輕女孩,竟然秒變成古代先哲:

視覺特效與影片編輯在當代媒體領域無所不在。隨著以影片為中心的平台的普及,對更直觀、性能更強的影片編輯工具的需求也在增加。然而,由於視訊資料的時間性,在這種格式下的編輯仍然是複雜且耗時的。最先進的機器學習模型在改善編輯過程方面顯示出了巨大的前景,但許多方法不得不在時間一致性和空間細節之間取得平衡。

由於引入了在大規模資料集上訓練的擴散模型,用於影像合成的生成方法最近在品質和受歡迎程度上經歷了一個快速增長階段。一些文字條件模型,如 DALL-E 2 和 Stable Diffusion,使新手只需輸入一個文字 prompt 就能產生詳細的圖像。潛在擴散模型提供了有效的方法,透過在感知壓縮的空間中進行合成來產生影像。

在本論文中,研究者提出了一個可控的結構和內容感知的視頻擴散模型,該模型是在未加字幕的視頻和配對的文本- 圖像數據的大規模資料集上訓練的。研究者選擇用單眼深度估計來表徵結構,並以預先訓練的神經網路預測的嵌入來表徵內容。

此方法在其生成過程中提供了幾種強大的控制模式:首先,與影像合成模型類似,研究者訓練模型使推斷出的影片內容,如其外觀或風格,與使用者提供的圖像或文字prompt 相符(圖1)。其次,受擴散過程的啟發,研究者對結構表徵應用了一個資訊掩蔽過程,以便能夠選擇模型對給定結構的支持程度。最後,研究者透過一個自訂的指導方法來調整推理過程,該方法受到無分類指導的啟發,以實現對生成片段的時間一致性的控制。

整體來說,本研究的亮點如下:

就研究目的而言,從內容和結構的角度來考慮一個影片將是有幫助的。對於結構,此處指的是描述其幾何和動態的特徵,例如主體的形狀和位置,以及它們的時間變化。對於內容,此處將其定義為描述影片的外觀和語義的特徵,例如物體的顏色和風格以及場景的照明。 Gen-1 模型的目標是編輯影片的內容,同時保留其結構。

為了實現這個目標,研究者學習了影片x 的生成模型p (x|s, c),其條件是結構表徵(以s 表示)和內容表徵(用c 表示)。他們從輸入影片推斷出形狀表徵 s,並根據描述編輯的文字 prompt c 對其進行修改。首先,描述了對生成模型的實現,作為一個條件潛在的視訊擴散模型,然後,描述了對形狀和內容表徵的選擇。最後,討論了模型的最佳化過程。

模型結構如圖 2 所示。

為了評估方法,研究者採用了 DAVIS 的影片和各種素材。為了自動建立編輯 prompt,研究者首先運行了一個字幕模型來獲得原始影片內容的描述,然後使用 GPT-3 來產生編輯 prompt。

定性研究

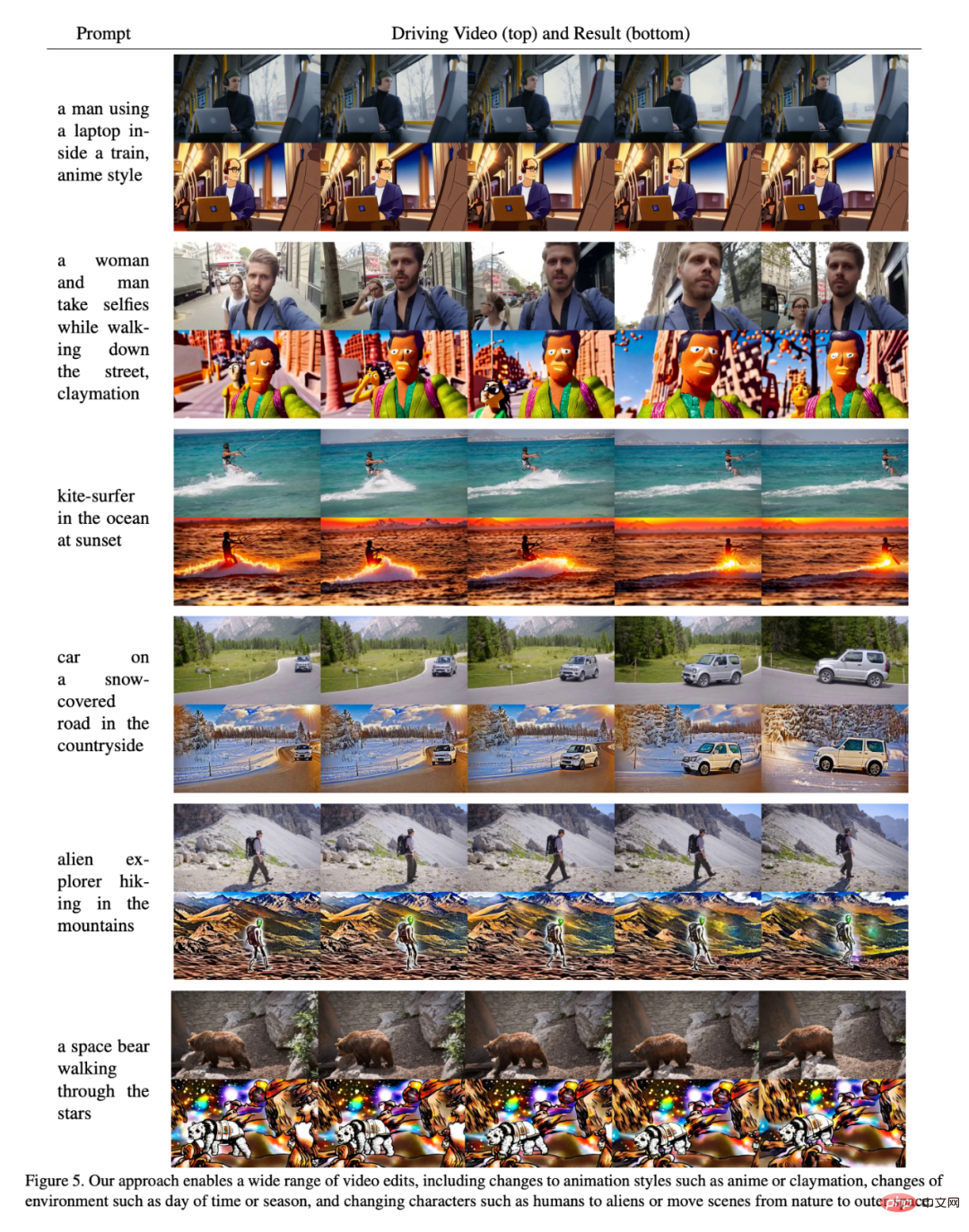

#如圖5 所示,結果證明,本文的方法在一些不同的輸入上表現良好。

使用者研究

研究者還使用Amazon Mechanical Turk(AMT)對35 個代表性的影片編輯prompt 的評估集進行了使用者研究。對於每個樣本,均要求5 個註解者在基線方法和本文方法之間對比對視頻編輯prompt 的忠實度(“哪個視頻更好地代表了所提供的編輯過的字幕?”),然後以隨機順序呈現,並使用多數票來決定最終結果。

結果如圖7 所示:

##定量評估

圖6 展示了每個模型使用本文框架一致性和prompt 一致性指標的結果。本文模型在這兩方面的表現都傾向於超越基線模型(即,在圖的右上角位置較高)。研究者還注意到,在基線模型中增加強度參數會有輕微的 tradeoff:更大的強度縮放意味著更高的 prompt 一致性,代價是更低的框架一致性。同時他們也觀察到,增加結構縮放會導致更高的 prompt 一致性,因為內容變得不再由輸入結構決定。

客製化

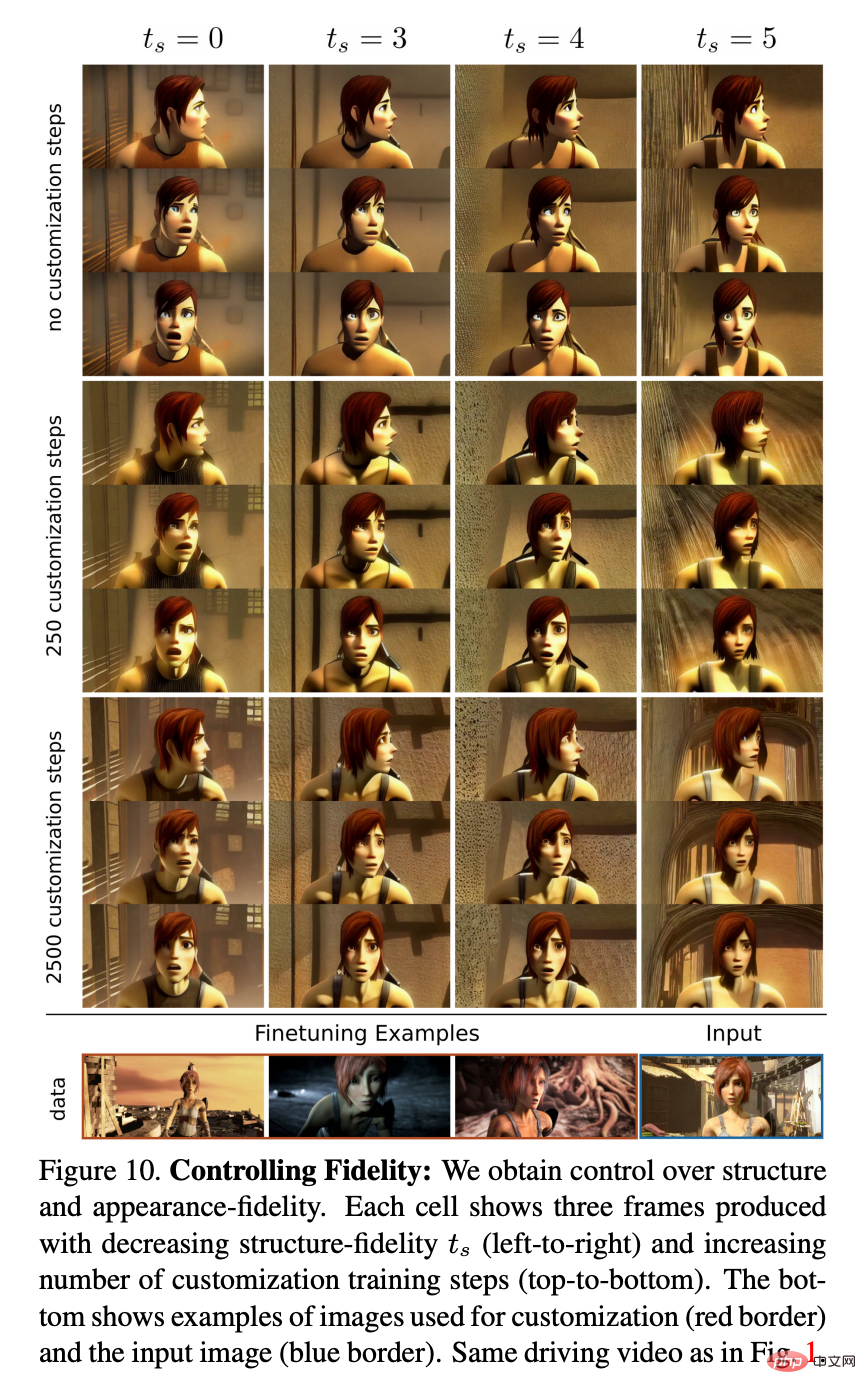

#圖10 展示了一個具有不同數量的客製化步驟和不同程度的結構依附性ts 的例子。研究者觀察到,客製化提高了對人物風格和外觀的保真度,因此,儘管使用具有不同特徵的人物的驅動視頻,但結合較高的 ts 值,還是可以實現精確的動畫效果。

以上是加特技只要一句話or一張圖,Stable Diffusion的公司把AIGC玩出了新花樣的詳細內容。更多資訊請關注PHP中文網其他相關文章!