人工智慧300年! LSTM之父萬字長文:詳解現代AI與深度學習發展史

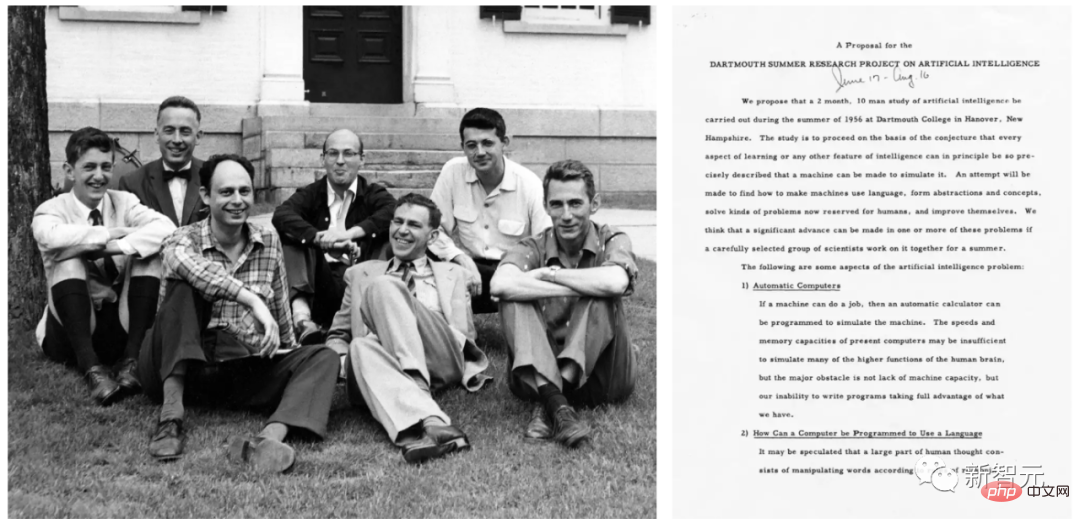

「人工智慧」一詞,首次在1956年達特茅斯會議上,由約翰麥卡錫等人正式提出。

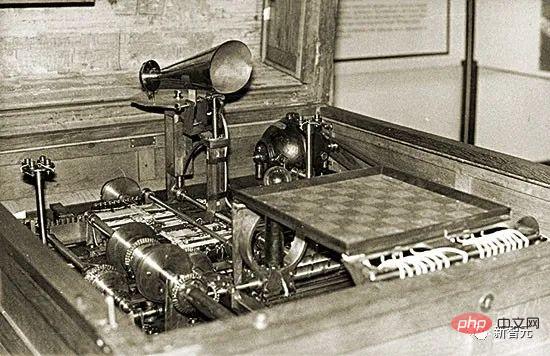

實用AI地提出,最早可以追溯到1914年。當時Leonardo Torres y Quevedo建構了第一個工作的西洋棋機器終端遊戲玩家。當時,國際象棋被認為是一種僅限於智慧生物領域的活動。

至於人工智慧理論,則可追溯至1931-34年。當時庫爾特·哥德爾(Kurt Gödel )確定了任何類型的基於計算的人工智慧的基本限制。

時間來到1980年代,此時的AI歷史會強調定理證明、邏輯程式設計、專家系統和啟發式搜尋等主題。

2000年代初期的AI歷史會更強調支援向量機和核心方法等主題。貝葉斯推理(Bayesian reasoning)和其他機率論和統計概念、決策樹、 整合方法、群體智慧和進化計算,此類技術推動了許多成功的AI應用。

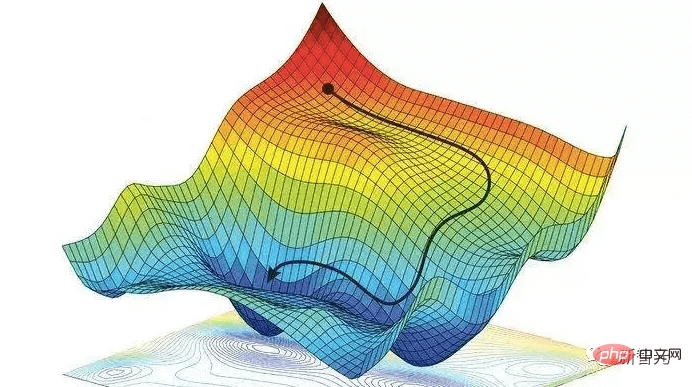

2020年代的AI研究反而更加「復古」,例如強調諸如鍊式法則和透過梯度下降(gradient descent)訓練的深度非線性人工神經網絡,特別是基於反饋的循環網路等概念。

Schmidhuber表示,這篇文章對先前具有誤導性的「深度學習歷史」進行修正。在他看來,先前的深度學習史忽略了文章中提到的大部分開創性工作。

此外,Schmidhuber還駁斥了一個常見的錯誤,即神經網路「作為幫助電腦識別模式和模擬人類智慧的工具是在1980年代引入的」。因為事實上,神經網路早在80年代前就已經出現。

一、1676年:反向信用分配的鍊式法則

1676年,戈特弗里德·威廉·萊布尼茨(Gottfried Wilhelm Leibniz )在回憶錄中發表了微積分的鍊式法則。如今,這條規則成為了深度神經網路中信用分配的核心,也是現代深度學習的基礎。

戈特弗里德·威廉·萊布尼茨

神經網路具有計算來自其他神經元的輸入的可微函數的節點或神經元,這些節點或神經元又計算來自其他神經元的輸入的可微函數。如果想要知道修改早期函數的參數或權值後,最終函數輸出的變化,就需要用到鍊式法則。

這個答案也被用來做梯度下降技術。為了教導神經網路將來自訓練集的輸入模式轉換為所需的輸出模式,所有神經網路權值都朝著最大局部改進的方向迭代改變一點,以創建稍微更好的神經網絡,依此類推,逐漸靠近權值和偏壓的最佳組合,從而最小化損失函數。

######值得注意的是,萊布尼茲也是第一個發現微積分的數學家。他和艾薩克·牛頓先後獨立發現了微積分,而且他所使用的微積分的數學符號被更廣泛的使用,萊布尼茨所發明的符號被普遍認為更綜合,適用範圍更加廣泛。 ############此外,萊布尼茲也是「世界上第一位電腦科學家」。他於1673年設計了第一台可以執行所有四種算術運算的機器,奠定了現代電腦科學的基礎。 ######二、19世紀初:神經網路、線性迴歸與淺層學習

1805 年,阿德利昂·瑪利·埃·勒讓德(Adrien-Marie Legendre)發表了現在通常稱為線性神經網路的內容。

#阿德利昂·瑪利·埃·勒讓德

後來,約翰·卡爾·弗里德里希·高斯(Johann Carl Friedrich Gauss)也因類似的研究而受到讚譽。 這個來自2個多世紀前的神經網路有兩層:一個具有多個輸入單元的輸入層和一個輸出層。每個輸入單元都可以保存一個實數值,並透過具有實數值權值的連接連接到輸出。

神經網路的輸出是輸入與其權值的乘積總和。給定輸入向量的訓練集和每個向量的期望目標值,調整 權值,使神經網路輸出與對應目標之間的平方誤差總和最小化。

當然,那時候這還不叫神經網路。它被稱為最小二乘法(least squares),也被廣泛稱為線性迴歸。但它在數學上與今天的線性神經網路相同:相同的基本演算法、相同的誤差函數、相同的自適應參數/權值。

約翰·卡爾·弗里德里希·高斯

這種簡單的神經網路執行「淺層學習」,與具有許多非線性層的「深度學習」相反。事實上,許多神經網路課程都是從介紹這種方法開始的,然後轉向更複雜、更深入的神經網路。

這種簡單的神經網路執行「淺層學習」,與具有許多非線性層的「深度學習」相反。事實上,許多神經網路課程都是從介紹這種方法開始的,然後轉向更複雜、更深入的神經網路。

當今,所有技術學科的學生都必須上數學課,尤其是分析、線性代數和統計學。在所有這些領域中,許多重要的結果和方法都要歸功於高斯:代數基本定理、高斯消去法、統計的高斯分佈等。

這位號稱「自古以來最偉大的數學家」的人也開創了微分幾何、數論(他最喜歡的科目)和非歐幾何。如果沒有他的成果,包括AI在內的現代工程將不可想像。

三、1920-1925年:第一個循環神經網路與人腦相似,循環神經網路(RNN)具有回饋連接,因此可以遵循從某些內部節點到其他節點的定向連接,並最終在起點結束。這對於在序列處理期間實現對過去事件的記憶至關重要。

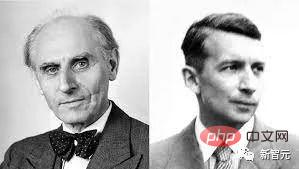

威廉楞次(左);恩斯特·伊辛(右)

#物理學家恩斯特·伊辛(Ernst Ising)和威廉·楞次(Wilhelm Lenz)在1920 年代引入並分析了第一個非學習RNN架構:伊辛模型(Ising model) 。它根據輸入條件進入平衡狀態,是第一個RNN學習模型的基礎。

#########1972 年,甘利俊一(Shun-Ichi Amari)使伊辛模型循環架構具有自適應性,可以透過改變其連結權值來學習將輸入模式與輸出模式相關聯。這是世界上第一個學習型RNN。 ########################甘利俊一###############目前,最受歡迎的RNN就是Schmidhuber提出的長短期記憶網絡LSTM。它已經成為20世紀被引用最多的神經網路。 ######四、1958年:多層前饋神經網路

1958年,弗蘭克·羅森布拉特(Frank Rosenblatt)結合了線性神經網路和閾值函數,設計出了更深層次的多層感知器(MLP)。

#法蘭克‧羅森布拉特

##多層感知器遵循人類神經系統原理,學習並進行資料預測。它首先學習,然後使用權值儲存數據,並使用演算法來調整權值並減少訓練過程中的偏差,即實際值和預測值之間的誤差。

由於多層前饋網路的訓練經常採用誤差反向傳播演算法,在模式識別的領域中算是標準監督學習演算法,並在計算神經學及平行分佈式處理領域中,持續成為被研究的課題。

五、1965年:第一個深度學習深度前饋網路架構的成功學習始於1965年的烏克蘭,當時Alexey Ivakhnenko和Valentin Lapa為具有任意多個隱藏層的深度MLP引入了第一個通用的工作學習演算法。

Alexey Ivakhnenko

給定一組具有對應目標輸出向量的輸入向量訓練集,層逐漸增長並通過回歸分析進行訓練,然後藉助單獨的驗證集進行修剪,其中正則化用於清除多餘的單元。層數和每層單元以問題相關的方式學習。

與後來的深度神經網路一樣,Ivakhnenko的網路學會了為傳入資料創建分層的、分散式的、內部表示。

他沒有稱它們為深度學習神經網絡,但它們就是這樣。事實上,「深度學習」這個術語最早是由Dechter於1986年引入機器學習的,而Aizenberg等人在2000則引入了「神經網路」的概念。

六、1967-68年:隨機梯度下降1967年,甘利俊一首次提出透過隨機梯度下降 (SGD)訓練神經網路。

甘利俊一與他的學生Saito在具有兩個可修改層的五層MLP中學習了內部表示,該層被訓練用於對非線性可分離模式類進行分類。

Rumelhart和Hinton等人在1986年做出了類似的工作,並將其命名為反向傳播演算法。

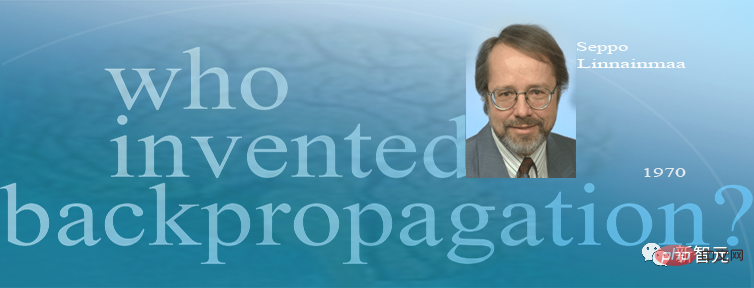

七、1970年:反向傳播演算法1970 年,Seppo Linnainmaa率先發表了反向傳播的演算法,這是一種著名的可微節點網路信用分配演算法,也稱為「自動微分的反向模式」。

Seppo Linnainmaa

Linnainmaa首次描述了在任意、離散的稀疏連接情況下的類神經網路的高效誤差反向傳播方式。它現在是廣泛使用的神經網路軟體包的基礎,例如PyTorch和Google的Tensorflow。

反向傳播本質上是為深度網路實施萊布尼茨鍊式法則的有效方式。柯西(Cauchy)提出的梯度下降在許多試驗過程中使用它逐漸削弱某些神經網路連接並加強其他連接。

1985年,計算成本已比1970年減少約1,000倍,當桌上型電腦剛在富裕的學術實驗室中普及時,David Rumelhart等人對已知方法進行實驗分析。

David Rumelhart

#透過實驗,魯姆哈特等人證明反向傳播可以在在神經網路的隱藏層中產生有用的內部表示。至少對於監督式學習,反向傳播通常比甘利俊一透過SGD方法進行的上述深度學習更有效。

2010年之前,許多人認為訓練多層神經網路需要無監督預訓練。 2010年,Schmidhuber的團隊與Dan Ciresan表明深度FNN可以透過簡單的反向傳播進行訓練,根本不需要對重要應用進行無監督預訓練。

八、1979年:首個卷積神經網路

#1979年,福島邦彥(Kunihiko Fukushima)在STRL開發了一種用於模式辨識的神經網路模型:Neocognitron。

福島邦彥

但這個Neocognitron用今天的話來說,叫做卷積神經網路(CNN),是深度神經網路基本結構的最偉大發明之一,也是目前人工智慧的核心技術。

福島博士引入的Neocognitron,是第一個使用卷積和下採樣的神經網絡,也是卷積神經網絡的雛形。

福島邦彥設計的具有學習能力的人工多層神經網絡,可以模仿大腦的視覺網絡,這種「洞察力」成為現代人工智慧技術的基礎。福島博士的工作帶來了一系列實際應用,從自動駕駛汽車到臉部識別,從癌症檢測到洪水預測,將會有越來越多的應用。

1987年,Alex Waibel將具有捲積的神經網路與權值共享和反向傳播結合,提出了延時神經網路(TDNN)的概念。

1989年以來,Yann LeCun的團隊為CNN的改進做出了貢獻,尤其是在圖像方面。

Yann LeCun

2011年末,Schmidhuber的團隊大大加快了深度CNN的訓練速度,使其在機器學習社群中變得更加流行。團隊推出基於GPU的CNN:DanNet,比早期的CNN更深入、運算更快。同年,DanNet成為第一個贏得電腦視覺競賽的純深度CNN。

由Microsoft Research的4位學者提出的殘差神經網路(ResNet),在2015年的ImageNet大規模視覺辨識競賽拔得頭籌。

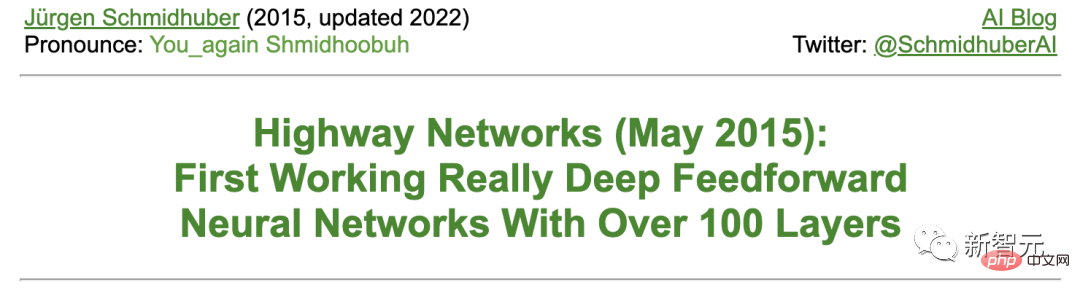

Schmidhuber 表示,ResNet是其團隊研發的高速神經網路(Highway Net)的早期版本。相較於以前的神經網路最多只有幾十層,這是第一個真正有效的、具有數百層的深度前饋神經網路。

九、1987-1990年代:圖神經網路與隨機Delta法則

可以操縱結構化資料(例如圖形)的深度學習架構於1987年由Pollack提出,並在20世紀90年代初期由Sperduti、Goller和Küchler進行擴展和改進。如今,圖神經網路被用於許多應用程式中。

Paul Werbos和R. J. Williams等人分析了在RNN中實現梯度下降的方法。 Teuvo Kohonen的自組映射(Self-Organizing Map)也流行起來。

Teuvo Kohonen

1990年,Stephen Hanson引入了隨機Delta法則,這是一種透過反向傳播訓練神經網路的隨機方法。幾十年後,這個方法在“dropout”的綽號下流行起來。

十、1990年2月:生成式對抗網路/好奇心

生成對抗網路(GAN)最早於1990年在以「人工智慧好奇心」為名發表。

兩個對抗的NN(一個機率產生器和一個預測器)試圖在一個最小極限遊戲中使對方的損失最大化。其中:

- 生成器(稱為控制器)產生機率輸出(使用隨機單元,如後來的StyleGAN)。

- 預測器(稱為世界模型)看到控制器的輸出並預測環境對它們的反應。使用梯度下降法,預測器NN將其誤差最小化,而生成器NN則試圖這個誤差最大化-一個網的損失就是另一個網路的收益。

在2014年關於GAN的論文之前4年,Schmidhuber就在著名的2010年調查中,將1990年的生成式對抗NN總結如下:「作為預測世界模型的神經網路被用來最大化控制器的內在獎勵,它與模型的預測誤差成正比」。

而之後發布的GAN,只是一個實例。其中,試驗非常短,環境只是根據控制器(或生成器)的輸出是否在一個給定的集合中而返回1或0。

1990年的原理被廣泛用於強化學習的探索和現實圖像的合成,儘管後者的領域最近被Rombach等人的Latent Diffusion接替。

1991年,Schmidhuber發表了另一個基於兩個對抗性NN的ML方法,稱為可預測性最小化,用於創建部分冗餘資料的分離表徵,1996年應用於影像。

十一、1990年4月:生成子目標/按指令工作

近幾個世紀以來,大多數NN都致力於簡單的模式識別,而不是高級推理。

然而,在1990年代初,首次出現了例外。這項工作將傳統的「符號」層次式人工智慧的概念注入到端到端的可區分的「次符號」(sub-symbolic)NN。

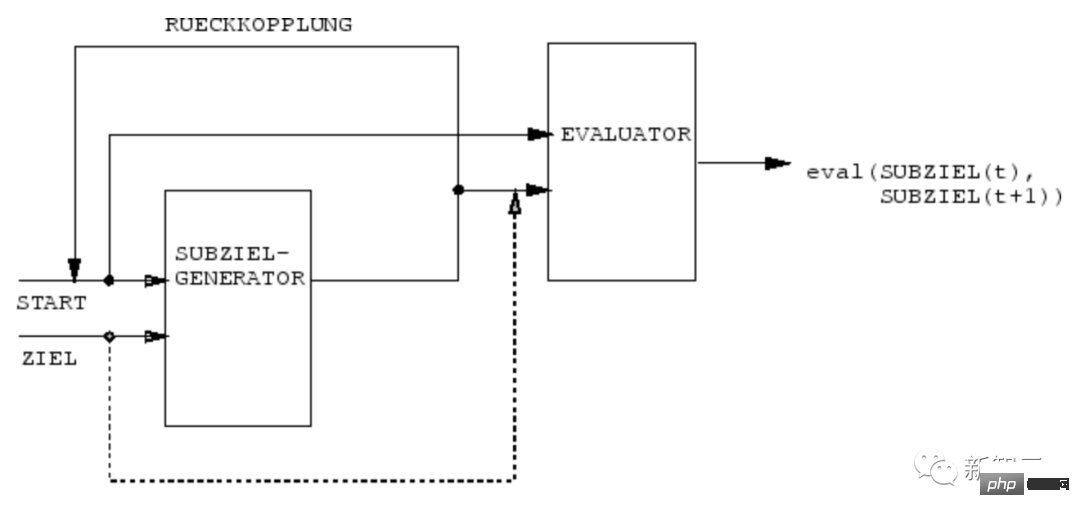

1990年,Schmidhuber團隊的NN學會了用端到端可微分NN的子目標產生器來產生層次化的行動計劃,用於層次化強化學習(HRL) 。

一個RL機器得到額外的指令輸入,其形式為(開始,目標)。一個評估器NN學習預測從開始到目標的當前獎勵/成本。一個基於(R)NN的子目標產生器也看到了(開始,目標),並使用評估器NN的(副本)透過梯度下降學習一連串成本最低的中間子目標。 RL機器試圖使用這種子目標序列來實現最終目標。

該系統在多個抽象層次和多個時間尺度上學習行動計劃,並在原則上解決了最近被稱為「開放性問題」的問題。

十二、1991年3月:具有線性自註意力的Transformer

具有「線性自註意力」的Transformer首次發表於1991年3月。

這些所謂的「快速權重程式設計師」(Fast Weight Programmers)或「快速權重控制器」(Fast Weight Controllers)就像傳統電腦一樣分離了儲存和控制,但以一種端到端差異化、自適應,以及神經網路的方式。

此外,今天的Transformer大量使用無監督預訓練,這是Schmidhuber在1990-1991年首次發表的一種深度學習方法。

十三、1991年4月:透過自監督的預訓練進行深度學習

今天最強大的NN往往是非常深的,也就是說,它們有很多層的神經元或很多後續的計算階段。

然而,在1990年代之前,基於梯度的訓練對深度NN並不奏效(只對淺層NN有效)。

與前饋NN(FNN)不同的是,RNN有回饋連結。這使得RNN成為強大的、通用的、平行序列的計算機,可以處理任意長度的輸入序列(例如語音或視訊)。

然而,在1990年代之前,RNN在實務上未能學習深層的問題。

為此,Schmidhuber建立了一個自監督的RNN層次結構,來嘗試實現「通用深度學習」。

1991年4月:將一個NN蒸餾成另一個NN

透過使用Schmidhuber在1991年提出的NN蒸餾程序,上述神經歷史壓縮機的分層內部表徵可以被壓縮成一個單一的遞歸NN(RNN)。

在這裡,教師NN的知識被「蒸餾」到學生NN中,方法是訓練學生NN模仿教師NN的行為(同時也重新訓練學生NN,從而保證之前學到的技能不會被忘記)。 NN蒸餾法也在許多年後重新發表,並在今天被廣泛使用。

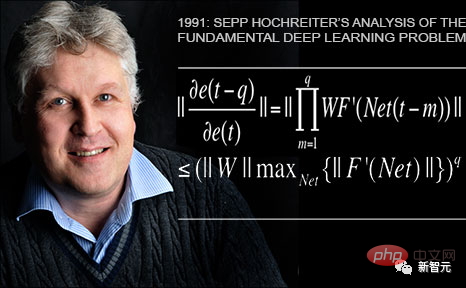

#十四、1991年6月:基本問題——梯度消失

Schmidhuber的第一個學生Sepp Hochreiter在1991年的畢業論文中發現並分析了基本的深度學習問題。

深度NN受到現在著名的梯度消失問題的困擾:在典型的深度或遞歸網路中,反向傳播的錯誤訊號要麼迅速縮小,要麼超出界限增長。在這兩種情況下,學習都會失敗。

十五、1991年6月:LSTM/Highway Net/ResNet的基礎

長短期記憶(LSTM)遞歸神經網路克服了Sepp Hochreiter在上述1991年的畢業論文中所指出的基本深度學習問題。

在1997年發表了經過同行評審的論文之後(現在是20世紀被引用最多的NN文章),Schmidhuber的學生Felix Gers和Alex Graves等人,進一步改進了LSTM及其訓練程序。

1999-2000年發表的LSTM變體——帶有遺忘門的“vanilla LSTM架構”,在如今谷歌的Tensorflow中依然還在應用。

2005年,Schmidhuber首次發表了LSTM在時間上完全反向傳播和雙向傳播的文章(同樣也被廣泛使用)。

2006年一個里程碑式的訓練方法是「連結主義時間分類」(CTC),用於同時對齊和識別序列。

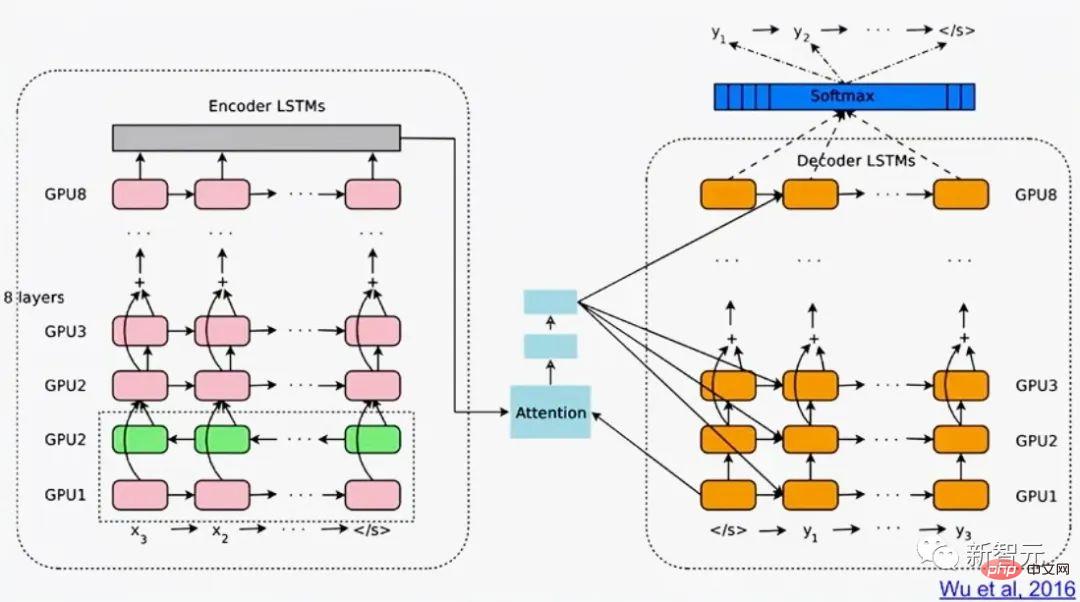

Schmidhuber的團隊在2007年成功地將CTC訓練的LSTM應用於語音(也有分層的LSTM堆疊),第一次實現了卓越的端到端神經語音識別效果。

2009年,透過Alex的努力,由CTC訓練的LSTM成為第一個贏得國際比賽的RNN,即三個ICDAR 2009手寫比賽(法語、波斯語、阿拉伯語)。這引起了業界的極大興趣。 LSTM很快就被用於所有涉及序列資料的場合,例如語音和視訊。

2015年,CTC-LSTM的組合大大改善了Google在安卓智慧型手機上的語音辨識效能。直到2019年,Google在行動端搭載的語音辨識仍然是基於LSTM。

1995年:神經機率語言模型

#1995年,Schmidhuber提出了一個優秀的神經機率文本模型,其基本概念在2003年被重新使用。

2001年,Schmidhuber顯示LSTM可以學習HMM等傳統模型無法學習的語言。

2016年的Google翻譯,則是基於兩個連接的LSTM(白皮書提到LSTM超過50次),一個用於傳入文本,一個用於傳出翻譯。

同年,Google資料中心用於推理的超強運算能力中,有超過四分之一用於LSTM(還有5%用於另一種流行的深度學習技術,即CNN)。

到了2017年,LSTM也為Facebook的機器翻譯(每週超過300億次翻譯)、蘋果在大約10億部iPhone上的Quicktype、亞馬遜的Alexa的語音、谷歌的圖像標題生成和自動電子郵件回答等提供支援。

當然,Schmidhuber的LSTM也被大量用於醫療保健和醫療診斷——簡單的谷歌學術搜尋就能找到無數標題中帶有「LSTM」的醫學文章。

2015年5月,Schmidhuber團隊基於LSTM原理提出了Highway Network,第一個具有數百層的非常深的FNN(以前的NN最多只有幾十層)。微軟的ResNet(贏得了ImageNet 2015比賽)就是它的一個版本。

早期Highway Net在ImageNet上的表現與ResNet大致相同。 Highway Net的變體也被用於某些演算法任務,在這些任務中,純殘差層的效果並不理想 。

LSTM/Highway Net原理是現代深度學習的核心

深度學習的核心是NN深度。

在20世紀90年代,LSTM為有監督的遞歸NN帶來了基本無限的深度;在2000年,受LSTM啟發的Highway Net為前饋NN帶來了深度。

現在,LSTM成為20世紀被引用最多的NN,而Highway Net的其中一個版本ResNet,則是21世紀被引用最多的NN。

十六、1980至今:在沒有老師的情況下學習行動的NNN

此外,NN也與強化學習(RL)有關。

雖然部分問題可以透過早在20世紀80年代之前發明的非神經技術來解決。例如,蒙特卡羅樹搜尋(MC)、動態規劃(DP)、人工進化、α-β-剪枝、控制理論和系統識別、隨機梯度下降,以及通用搜尋技術。但深度FNN和RNN可以為某些類型的RL任務帶來更好的效果。

一般來說,強化學習智能體必須學會如何在沒有老師的幫助下,與一個動態的、最初未知的、部分可觀察的環境互動,從而使預期的累積獎勵訊號最大化。在行動和可感知的結果之間可能存在任意的、先驗的未知延遲。

當環境有一個馬可夫接口,使RL智能體的輸入可以傳達確定下一個最佳行動所需的所有資訊時,基於動態規劃(DP)/時序差分(TD)/蒙地卡羅樹搜尋(MC)的RL會非常成功。

對於沒有馬可夫介面的更複雜的情況,智能體不僅要考慮現在的輸入,還要考慮以前輸入的歷史。對此,由RL演算法和LSTM形成的組合已經成為了一種標準方案,特別是透過策略梯度訓練的LSTM。

例如,在2018年,一個經過PG訓練的LSTM是OpenAI著名的Dactyl的核心,它在沒有老師的情況下學會了控制一隻靈巧的機器人手。

電玩遊戲也是如此。

2019年,DeepMind(由Schmidhuber實驗室的學生共同創立)在《星海爭霸》遊戲中擊敗了職業選手,其中用到的Alphastar,就是有一個由PG訓練的深度LSTM核心。

同時,RL LSTM(佔模型總參數數的84%)也是著名的OpenAI Five的核心,它在Dota 2中擊敗了專業的人類玩家。

RL的未來將是用複雜輸入流的緊湊時空抽象來學習/組合/規劃,也就是關於常識推理和學習思考。

Schmidhuber在1990-91年發表的論文中提出,自監督的神經歷史壓縮器,可以學習多層次的抽象和多時間尺度上的表徵概念;而基於端到端的可區分NN的子目標產生器,則可以透過梯度下降學習分層的行動計劃。

在隨後的1997年和2015-18年,更複雜的學習抽象思考的方法被發表。

十七、是硬體問題,呆子!

在過去的一千年裡,如果沒有不斷改進和加速升級的電腦硬件,深度學習演算法不可能迎來重大突破。

我們第一個已知的齒輪計算設備是2000多年前古希臘的安提基特拉機械(Antikythera mechanism)。這是當今所知的最古老的複雜科學計算機,同時也是世界上第一台模擬計算機。

安提基特拉機械

而世界上第一台實用的可程式機器,是古希臘機械學家海倫於西元1世紀發明的。

17世紀的機器變得更靈活,可以根據輸入資料計算答案。

第一台用於簡單算術的機械計算器由威廉·契克卡德(Wilhelm Schickard)於1623年發明製造。

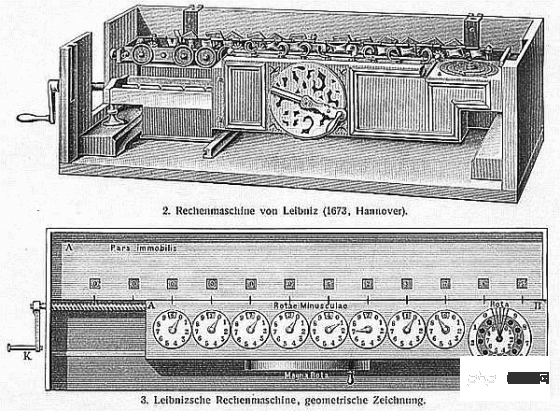

1673年,萊布尼茨設計了第一台可以執行所有四種算術運算,並帶有記憶體的機器。他還描述了由穿孔卡控制的二元電腦的原理並提出鍊式法則,構成了深度學習和現代人工智慧的重要組成部分。

萊布尼茲乘法器

1800年左右,約瑟夫·瑪麗·雅卡爾(Joseph Marie Jacquard) 等人在法國製造了第一台首台可設計織布機-雅卡爾織布機(Jacquard machine)。該發明對將來發展出其他可程式機器(例如電腦)起了重要作用。

雅卡爾織布機

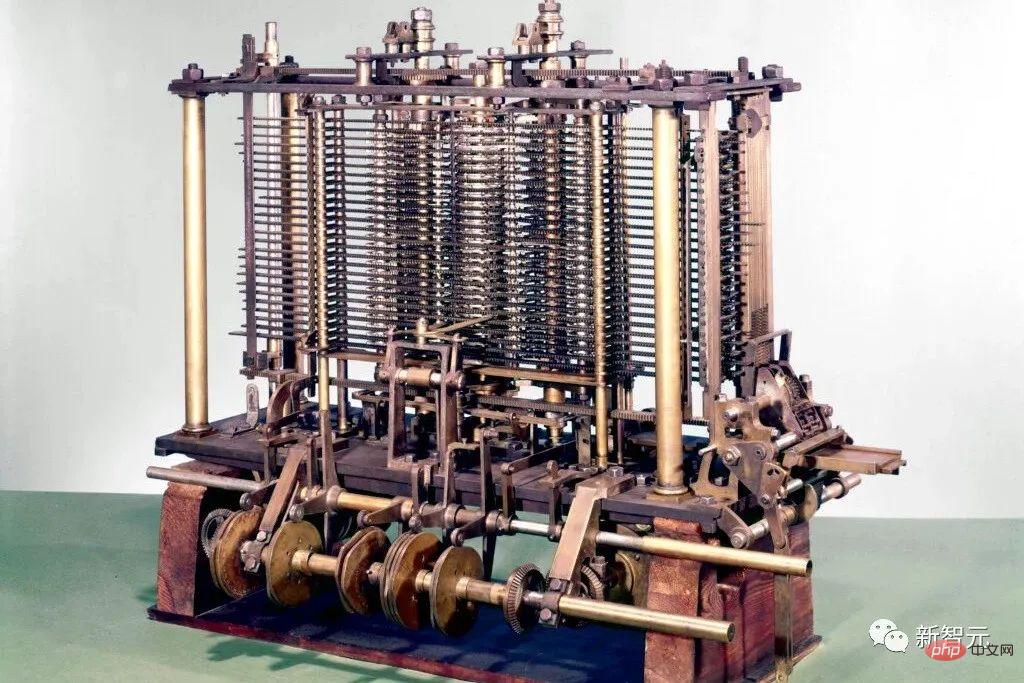

他們啟發了阿達洛芙萊斯(Ada Lovelace)和她的導師查爾斯·巴貝奇(Charles Babbage)發明了一台現代電子計算機的前身:巴貝奇差分機。

在隨後的1843年,洛芙萊斯公佈了世界上第一套電腦演算法。

巴貝奇差分機

1914年,西班牙人Leonardo Torres y Quevedo成為20世紀第一位人工智慧先驅,他創造了第一個國際象棋終端機器玩家。

1935年至1941年間,康拉德·楚澤(Konrad Zuse)發明了世界上第一台可運作的可程式通用電腦:Z3。

康拉德·楚澤

#與巴貝奇分析機不同,楚澤使用萊布尼茲的二進制計算原理,而不是傳統的十進制計算。這大大簡化了硬體的負載。

1944年,霍華德·艾肯(Howard Aiken)帶領團隊,發明世界上第一台大型自動數位電腦Mark Ⅰ(馬克一號)。

1948年,弗雷德里克威廉斯(Frederic Williams)、湯姆基爾伯恩(Tom Kilburn)和傑夫托蒂(Geoff Tootill)發明了世界第一台電子儲存程式計算機:小型實驗機(SSEM),又被稱為「曼徹斯特寶貝」(Manchester Baby)。

「曼徹斯特寶貝」複製品

從那時起,計算機的運算在積體電路(IC)的幫助下變得更快。 1949年,西門子的維爾納·雅各比(Werner Jacobi)申請了一項積體電路半導體專利,使一個公共基板可以有多個電晶體。

1958年,Jack Kilby展示了一個帶有外部導線的積體電路。 1959年,羅伯特·諾伊斯 (Robert Noyce) 提出了單晶片積體電路。自1970年代以來,圖形處理單元 (GPU) 已被用於透過平行處理來加速運算。現在,電腦的GPU包含數十億個電晶體。

物理極限在哪裡?

根據漢斯·約阿希姆·布雷默曼(Hans Joachim Bremermann)提出的布雷默曼極限,一台質量為1公斤、體積為1公升的計算機最多可以在最多10的32次方位上每秒執行最多10的51次方操作。

漢斯·約阿希姆·布雷默曼

然而,太陽系的質量只有2x10^30公斤,這一趨勢勢必會在幾個世紀內打破,因為光速會嚴重限制以其他太陽系的形式獲取額外質量。

因此,物理學的限制要求未來高效的計算硬體必須像大腦一樣,在三維空間中有許多緊湊放置的處理器以最小化總連接成本,其基本架構本質上是一種深度的、稀疏連接的三維RNN。

Schmidhuber推測,這類RNN的深度學習方法將變得更加重要。

十八、1931年以來的人工智慧理論

現代人工智慧和深度學習的核心主要是基於近幾個世紀的數學:微積分、線性代數和統計學。

######20世紀30年代初,哥德爾創立了現代理論電腦科學。他引入了一種以整數為基礎的通用編碼語言,允許以公理形式將任何數位計算機的操作正規化。 ############同時,哥德爾也建構了著名的形式化語句,透過給定一個計算性的定理檢驗器,從可列舉的公理集合中系統地列舉所有可能的定理。因此,他確定了演算法定理證明、計算以及任何類型的基於計算的人工智慧的基本限制。 ############此外,哥德爾在寫給約翰·馮·諾伊曼的著名信件中,確定了計算機科學中最著名的開放問題“P=NP?”。 ######1935年,Alonzo Church透過證明Hilbert和Ackermann的決策問題沒有一般的解決方案,得出了哥德爾結果的一個推論。為了做到這一點,他使用了他的另一種通用編碼語言,稱為Untyped Lambda Calculus,它構成了極具影響力的程式語言LISP的基礎。

1936年,阿蘭·圖靈引入了另一個通用模型:圖靈機,重新得出了上述結果。同年,Emil Post發表了另一個獨立的計算通用模型。

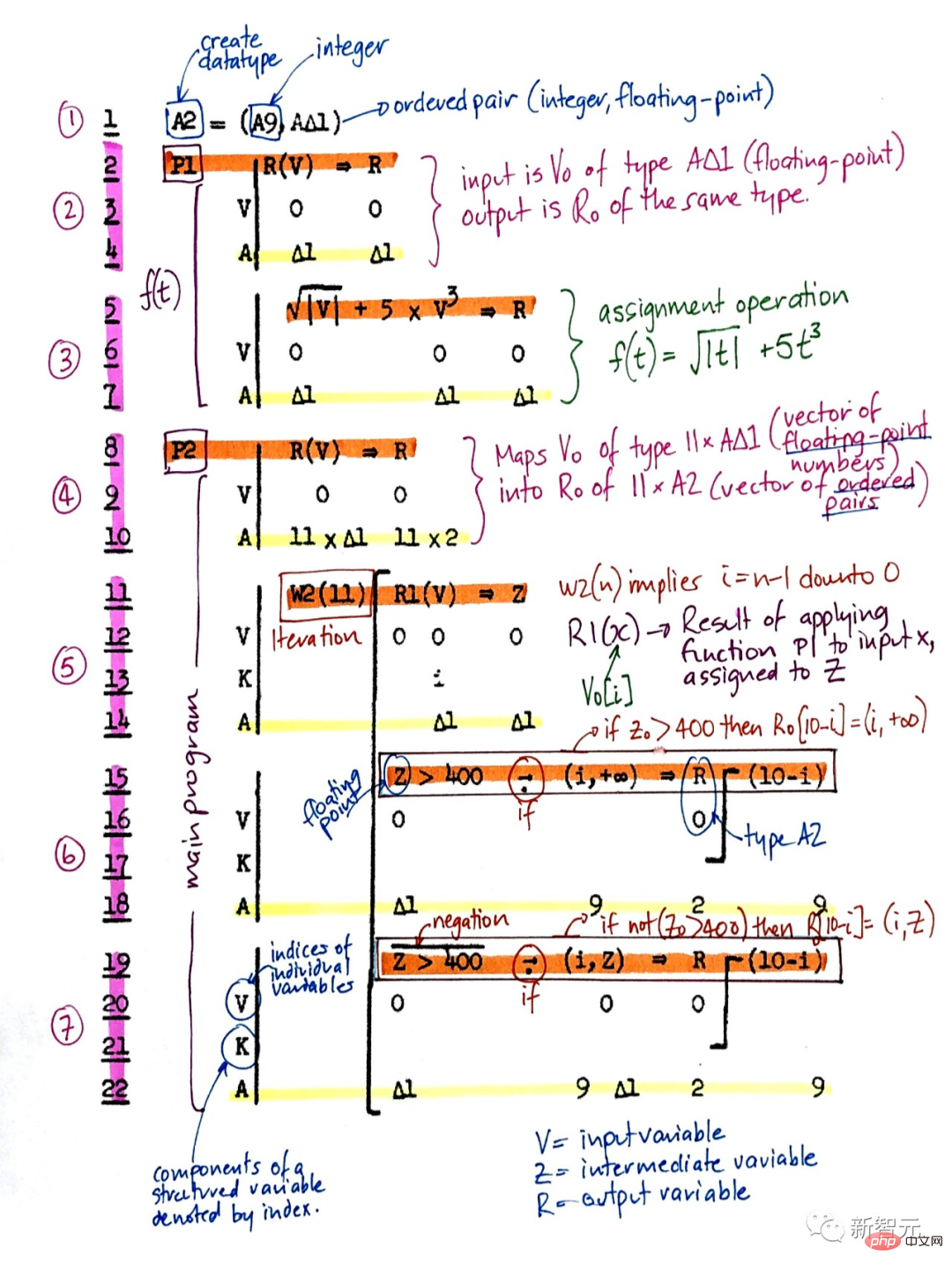

康拉德·楚澤不僅創造了世界上第一台可用的可程式通用計算機,還設計了第一種高級程式語言——Plankalkül。他在1945年將其應用於國際象棋,在1948年應用於定理證明。

Plankalkül

20世紀40-70年代的大部分早期人工智慧其實是關於定理證明和透過專家系統和邏輯程式進行哥德爾式的推導。

1964年,Ray Solomonoff將貝葉斯(實際上是拉普拉斯)機率推理和理論計算機科學結合起來,得出一種數學上最優(但計算上不可行)的學習方式,從過去的觀察預測未來數據。

他與Andrej Kolmogorov一起創立了柯氏複雜性或演算法資訊理論(AIT)的理論,透過計算數據的最短程序的概念,將奧卡姆剃刀的概念正式化,從而超越了傳統的資訊理論。

#柯氏複雜性

自指哥德爾機更通用的最優性並不限於漸進式最優。

儘管如此,由於各種原因,這種數學上的最優人工智慧在實踐上還不可行。相反,實用的現代人工智慧是基於次優的、有限的、但並不被極度理解的技術,如NN和深度學習則是重點。

但誰知道20年後的人工智慧歷史會是什麼樣的呢?

以上是人工智慧300年! LSTM之父萬字長文:詳解現代AI與深度學習發展史的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日訊息,剪映是由位元組跳動旗下臉萌科技開發的一款影片剪輯軟體,依託於抖音平台且基本面向該平台用戶製作短影片內容,並相容於iOS、安卓、Windows 、MacOS等作業系統。剪映官方宣布會員體系升級,推出全新SVIP,包含多種AI黑科技,例如智慧翻譯、智慧劃重點、智慧包裝、數位人合成等。價格方面,剪映SVIP月費79元,年費599元(本站註:折合每月49.9元),連續包月則為59元每月,連續包年為499元每年(折合每月41.6元) 。此外,剪映官方也表示,為提升用戶體驗,向已訂閱了原版VIP

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

透過將檢索增強生成和語意記憶納入AI編碼助手,提升開發人員的生產力、效率和準確性。譯自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。雖然基本AI程式設計助理自然有幫助,但由於依賴對軟體語言和編寫軟體最常見模式的整體理解,因此常常無法提供最相關和正確的程式碼建議。這些編碼助手產生的代碼適合解決他們負責解決的問題,但通常不符合各個團隊的編碼標準、慣例和風格。這通常會導致需要修改或完善其建議,以便將程式碼接受到應

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

大型語言模型(LLM)是在龐大的文字資料庫上訓練的,在那裡它們獲得了大量的實際知識。這些知識嵌入到它們的參數中,然後可以在需要時使用。這些模型的知識在訓練結束時被「具體化」。在預訓練結束時,模型實際上停止學習。對模型進行對齊或進行指令調優,讓模型學習如何充分利用這些知識,以及如何更自然地回應使用者的問題。但是有時模型知識是不夠的,儘管模型可以透過RAG存取外部內容,但透過微調使用模型適應新的領域被認為是有益的。這種微調是使用人工標註者或其他llm創建的輸入進行的,模型會遇到額外的實際知識並將其整合

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的內容,請造訪:51CTOAI.x社群https://www.51cto.com/aigc/譯者|晶顏審校|重樓不同於網路上隨處可見的傳統問題庫,這些問題需要跳脫常規思維。大語言模型(LLM)在數據科學、生成式人工智慧(GenAI)和人工智慧領域越來越重要。這些複雜的演算法提升了人類的技能,並在許多產業中推動了效率和創新性的提升,成為企業保持競爭力的關鍵。 LLM的應用範圍非常廣泛,它可以用於自然語言處理、文字生成、語音辨識和推薦系統等領域。透過學習大量的數據,LLM能夠產生文本

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

機器學習是人工智慧的重要分支,它賦予電腦從數據中學習的能力,並能夠在無需明確編程的情況下改進自身能力。機器學習在各個領域都有廣泛的應用,從影像辨識和自然語言處理到推薦系統和詐欺偵測,它正在改變我們的生活方式。機器學習領域存在著多種不同的方法和理論,其中最具影響力的五種方法被稱為「機器學習五大派」。這五大派分別為符號派、聯結派、進化派、貝葉斯派和類推學派。 1.符號學派符號學(Symbolism),又稱符號主義,強調利用符號進行邏輯推理和表達知識。該學派認為學習是一種逆向演繹的過程,透過現有的

SOTA性能,廈大多模態蛋白質-配體親和力預測AI方法,首次結合分子表面訊息

Jul 17, 2024 pm 06:37 PM

SOTA性能,廈大多模態蛋白質-配體親和力預測AI方法,首次結合分子表面訊息

Jul 17, 2024 pm 06:37 PM

編輯|KX在藥物研發領域,準確有效地預測蛋白質與配體的結合親和力對於藥物篩選和優化至關重要。然而,目前的研究並沒有考慮到分子表面訊息在蛋白質-配體相互作用中的重要作用。基於此,來自廈門大學的研究人員提出了一種新穎的多模態特徵提取(MFE)框架,該框架首次結合了蛋白質表面、3D結構和序列的信息,並使用交叉注意機制進行不同模態之間的特徵對齊。實驗結果表明,該方法在預測蛋白質-配體結合親和力方面取得了最先進的性能。此外,消融研究證明了該框架內蛋白質表面資訊和多模態特徵對齊的有效性和必要性。相關研究以「S

佈局 AI 等市場,格芯收購泰戈爾科技氮化鎵技術和相關團隊

Jul 15, 2024 pm 12:21 PM

佈局 AI 等市場,格芯收購泰戈爾科技氮化鎵技術和相關團隊

Jul 15, 2024 pm 12:21 PM

本站7月5日消息,格芯(GlobalFoundries)於今年7月1日發布新聞稿,宣布收購泰戈爾科技(TagoreTechnology)的功率氮化鎵(GaN)技術及智慧財產權組合,希望在汽車、物聯網和人工智慧資料中心應用領域探索更高的效率和更好的效能。隨著生成式人工智慧(GenerativeAI)等技術在數位世界的不斷發展,氮化鎵(GaN)已成為永續高效電源管理(尤其是在資料中心)的關鍵解決方案。本站引述官方公告內容,在本次收購過程中,泰戈爾科技公司工程師團隊將加入格芯,進一步開發氮化鎵技術。 G