一文淺談深度學習泛化能力

一、DNN泛化能力的問題

論文主要探討的是, 為什麼過參數的神經網路模型還能有不錯的泛化性?即不是簡單記憶訓練集,而是從訓練集中總結出一個通用的規律,從而可以適配於測試集(泛化能力)。

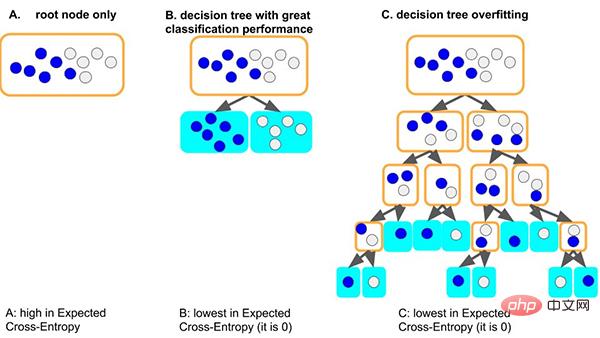

以經典的決策樹模型為例, 當樹模型學習資料集的通用規律時:一種好的情況,假如樹第一個分裂節點時,剛好就可以很好區分開不同標籤的樣本,深度很小,相應的各葉子上面的樣本數是夠的(即統計規律的數據量的依據也是比較多的),那這會得到的規律就更有可能泛化到其他數據。 (即:擬合良好, 有泛化能力)。

另外一種較差的情況,如果樹學習不好一些通用的規律,為了學習這個資料集,那樹就會越來越深,可能每個葉子節點分別對應著少數樣本(少數據帶來統計資料可能只是雜訊),最後,死記硬背地記住所有資料(即:過擬合無泛化能力)。我們可以看到過深(depth)的樹模型很容易過度擬合。

那麼過參數化的神經網路如何達到良好的泛化性呢?

二、 DNN泛化能力的原因

本文是從一個簡單通用的角度解釋-在神經網路的梯度下降優化過程上,探討泛化能力的原因:

我們總結了梯度相干理論:來自不同樣本的梯度產生相干性,是神經網路能有良好的泛化能力原因。當不同樣本的梯度在訓練過程中對齊良好,即當它們相干時,梯度下降是穩定的,可以很快收斂,並且由此產生的模型可以有良好的泛化性。否則,如果樣本太少或訓練時間過長,可能無法泛化。

基於這個理論,我們可以做出以下解釋。

2.1 寬度神經網路的泛化性

更寬的神經網路模型具有良好的泛化能力。這是因為,更寬的網絡都有更多的子網絡,對比小網絡更有產生梯度相干的可能,從而有更好的泛化性。換句話說,梯度下降是優先考慮泛化(相干性)梯度的特徵選擇器,更廣泛的網路可能僅僅因為它們有更多的特徵而具有更好的特徵。

- 論文原文:Generalization and width. Neyshabur et al. [2018b] found that wider networks generalize better. Can we now explain this? networks generalize better. Can we now explain this? veloping works, worksive works 及 so the sub-network with maximum coherence in a wider network may be more coherent than its counterpart in a thinner network, and hence generalize better. In other words, since—as cussed indient 10—grased as discussed indient 10— well-generalizing (coherent) features, wider networks are likely to have better features simply because they 順ave features simply because they 0have features simply because Lottery Ticket Hypothesis [Frankle and Carbin, 2018]

- 論文連結:https ://github.com/aialgorithm/Blog

但是個人覺得,這還是要區分下網路輸入層/隱藏層的寬度。特別是資料探勘任務的輸入層,由於輸入特徵是通常是人工設計的,需要考慮下做下特徵選擇(即減少輸入層寬度),不然直接輸入特徵噪音,對於梯度相干性影響不也是有乾擾的。

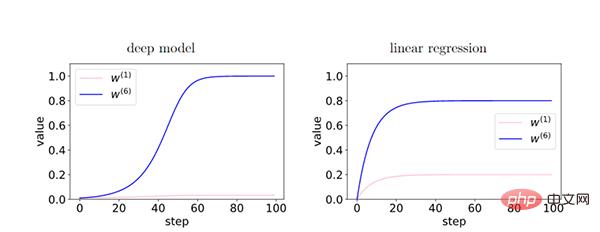

2.2 深度神經網路的泛化性

越深的網絡,梯度相干現像被放大,有更好的泛化能力。

在深度模型中,由於層之間的回饋加強了有相干性的梯度,因此存在相干性梯度的特徵(W6)和非相干梯度的特徵( W1)之間的相對差異在訓練過程中呈指數放大。從而使得更深的網路更偏好相干梯度,從而更好地泛化能力。

2.3 早停(early-stopping)

透過早停我們可以減少非相干梯度的過度影響,提高泛化性。

在訓練的時候,有些容易樣本比其他樣本(困難樣本)更早擬合。訓練前期,這些容易樣本的相干梯度做主導,並且很容易擬合。訓練後期,以困難樣本的非相干梯度主導了平均梯度g(wt),從而導致泛化能力變差,這個時候就需要早停。

- (註:簡單的樣本,是那些在資料集裡面有很多梯度共同點的樣本,正由於這個原因,大多數梯度對它有益,收斂也比較快。)

2.4 全梯度下降VS 學習率

我們發現全梯度下降也可以有很好的泛化能力。此外,仔細的實驗顯示隨機梯度下降並不一定有更優的泛化,但這並不排除隨機梯度更容易跳出局部最小值、起正則化等的可能性。

- Based on our theory, finite learning rate, and mini-batch stochasticity are not necessary for generalization

#我們認為較低的學習率可能無法降低泛化誤差,因為較低的學習率意味著更多的迭代次數(與早停相反)。

- Assuming a small enough learning rate, as training progresses, the generalization gap cannot 我 training: with 40 more steps, stability can only degrade. If this is violated in a practical setting, it would point to an interesting limitation of the theory

2.5 L2、L1正規化

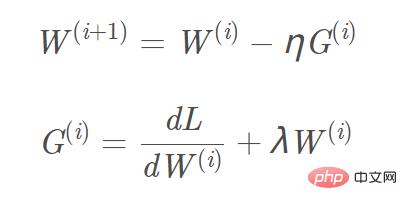

目標函數加入L2、L1正則化,對應的梯度計算, L1正規項需增加的梯度為sign(w) ,L2梯度為w。以L2正規為例,對應的梯度W(i 1)更新公式為:圖片

我們可以把「L2正則化(權重衰減)」看成是一種“背景力”,可將每個參數推近於資料無關的零值( L1容易得到稀疏解,L2容易得到趨近0的平滑解) ,來消除在弱梯度方向上影響。只有在相干梯度方向的情況下,參數才比較能脫離“背景力”,並基於數據完成梯度更新。

2.6 梯度下降演算法的進階

- #Momentum 、Adam等梯度下降演算法

Momentum 、Adam等梯度下降演算法,其參數W更新方向不僅由目前的梯度決定,也與先前累積的梯度方向有關(即,保留累積的相干梯度的作用)。這使得參數中那些梯度方向變化不大的維度可以加速更新,並減少梯度方向變化較大的維度上的更新幅度,由此產生了加速收斂和減小震盪的效果。

- 抑制弱梯度方向的梯度下降

我們可以透過最佳化批次梯度下降演算法,來抑制弱梯度方向的梯度更新,進一步提高了泛化能力。例如,我們可以使用梯度截斷(winsorized gradient descent),排除梯度異常值後的再取平均值。或取梯度的中位數代替平均值,以減少梯度異常值的影響。

小結

文末說兩句,對於深度學習的理論,有興趣可以看下論文提及的相關研究。

以上是一文淺談深度學習泛化能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Python中使用BERT進行情感分析的方法及步驟

Jan 22, 2024 pm 04:24 PM

Python中使用BERT進行情感分析的方法及步驟

Jan 22, 2024 pm 04:24 PM

BERT是由Google在2018年提出的一種預先訓練的深度學習語言模式。全稱為BidirectionalEncoderRepresentationsfromTransformers,它基於Transformer架構,具有雙向編碼的特性。相較於傳統的單向編碼模型,BERT在處理文字時能夠同時考慮上下文的訊息,因此在自然語言處理任務中表現出色。它的雙向性使得BERT能夠更好地理解句子中的語義關係,從而提高了模型的表達能力。透過預訓練和微調的方法,BERT可以用於各種自然語言處理任務,如情緒分析、命名

潛藏空間嵌入:解釋與示範

Jan 22, 2024 pm 05:30 PM

潛藏空間嵌入:解釋與示範

Jan 22, 2024 pm 05:30 PM

潛在空間嵌入(LatentSpaceEmbedding)是將高維度資料對應到低維度空間的過程。在機器學習和深度學習領域中,潛在空間嵌入通常是透過神經網路模型將高維輸入資料映射為一組低維向量表示,這組向量通常被稱為「潛在向量」或「潛在編碼」。潛在空間嵌入的目的是捕捉資料中的重要特徵,並將其表示為更簡潔和可理解的形式。透過潛在空間嵌入,我們可以在低維空間中對資料進行視覺化、分類、聚類等操作,從而更好地理解和利用資料。潛在空間嵌入在許多領域中都有廣泛的應用,如影像生成、特徵提取、降維等。潛在空間嵌入的主要

YOLO不死! YOLOv9出爐:性能速度SOTA~

Feb 26, 2024 am 11:31 AM

YOLO不死! YOLOv9出爐:性能速度SOTA~

Feb 26, 2024 am 11:31 AM

如今的深度學習方法專注於設計最適合的目標函數,以使模型的預測結果與實際情況最接近。同時,必須設計一個合適的架構,以便為預測取得足夠的資訊。現有方法忽略了一個事實,當輸入資料經過逐層特徵提取和空間變換時,大量資訊將會遺失。本文將深入探討資料透過深度網路傳輸時的重要問題,即資訊瓶頸和可逆函數。基於此提出了可編程梯度資訊(PGI)的概念,以應對深度網路實現多目標所需的各種變化。 PGI可以為目標任務提供完整的輸入訊息,以計算目標函數,從而獲得可靠的梯度資訊以更新網路權重。此外設計了一種新的輕量級網路架

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

自2006年深度學習概念被提出以來,20年快過去了,深度學習作為人工智慧領域的一場革命,已經催生了許多具有影響力的演算法。那麼,你所認為深度學習的top10演算法有哪些呢?以下是我心目中深度學習的頂尖演算法,它們在創新、應用價值和影響力方面都佔有重要地位。 1.深度神經網路(DNN)背景:深度神經網路(DNN)也叫多層感知機,是最普遍的深度學習演算法,發明之初由於算力瓶頸而飽受質疑,直到近些年算力、數據的爆發才迎來突破。 DNN是一種神經網路模型,它包含多個隱藏層。在該模型中,每一層將輸入傳遞給下一層,並

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

在當今科技日新月異的浪潮中,人工智慧(ArtificialIntelligence,AI)、機器學習(MachineLearning,ML)與深度學習(DeepLearning,DL)如同璀璨星辰,引領著資訊科技的新浪潮。這三個詞彙經常出現在各種前沿討論和實際應用中,但對於許多初涉此領域的探索者來說,它們的具體含義及相互之間的內在聯繫可能仍籠罩著一層神秘面紗。那讓我們先來看看這張圖。可以看出,深度學習、機器學習和人工智慧之間存在著緊密的關聯和遞進關係。深度學習是機器學習的一個特定領域,而機器學習

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显著的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效

AlphaFold 3 重磅問世,全面預測蛋白質與所有生命分子相互作用及結構,準確度遠超以往水平

Jul 16, 2024 am 12:08 AM

AlphaFold 3 重磅問世,全面預測蛋白質與所有生命分子相互作用及結構,準確度遠超以往水平

Jul 16, 2024 am 12:08 AM

编辑|萝卜皮自2021年发布强大的AlphaFold2以来,科学家们一直在使用蛋白质结构预测模型来绘制细胞内各种蛋白质结构的图谱、发现药物,并绘制每种已知蛋白质相互作用的「宇宙图」。就在刚刚,GoogleDeepMind发布了AlphaFold3模型,该模型能够对包括蛋白质、核酸、小分子、离子和修饰残基在内的复合物进行联合结构预测。AlphaFold3的准确性对比过去许多专用工具(蛋白质-配体相互作用、蛋白质-核酸相互作用、抗体-抗原预测)有显著提高。这表明,在单个统一的深度学习框架内,可以实现