利用多光照資訊的單視角NeRF演算法S^3-NeRF,可恢復場景幾何與材質訊息

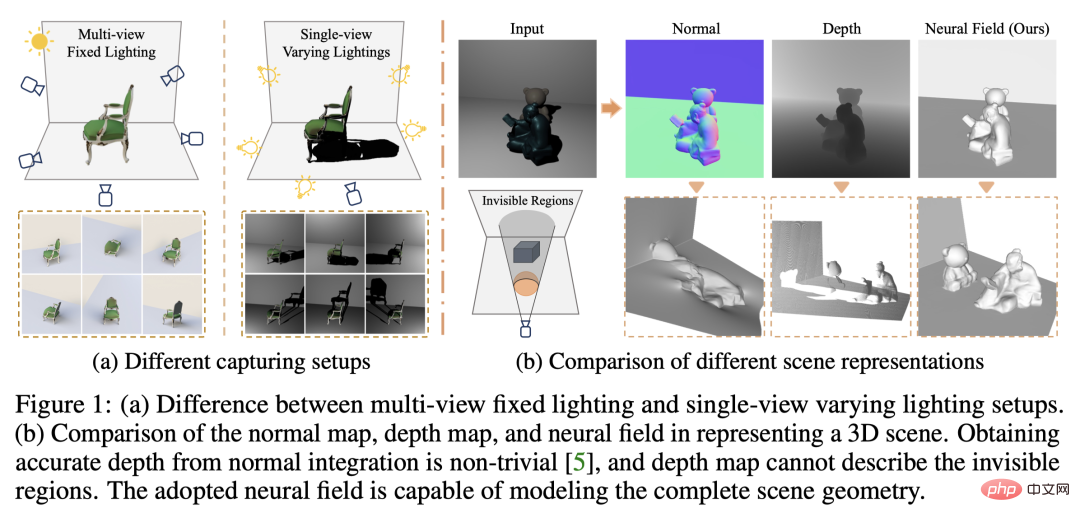

目前影像 3D 重建工作通常採用恆定自然光照條件下從多個視點(multi-view)捕捉目標場景的多視圖立體重建方法(Multi-view Stereo)。然而,這些方法通常假設朗伯表面,並且難以恢復高頻細節。

另一種場景重建方法是利用固定視點但在不同點光源下擷取的影像。例如光度立體 (Photometric Stereo) 方法就採用這種設定並利用其 shading 資訊來重建非朗伯物體的表面細節。然而,現有的單視圖方法通常採用法線貼圖(normal map)或深度圖(depth map)來表徵可見表面,這使得它們無法描述物體背面和被遮蔽的區域,只能重建 2.5D 場景幾何。此外,法線貼圖無法處理深度不連續的情況。

在最近的一項研究中,來自香港大學、香港中文大學(深圳)、南洋理工大學、MIT-IBM Waston AI Lab 的研究者提出了利用單視圖多光源(single-view,multi-lights)影像,重建完整3D 場景的工作。

- #論文連結:https://arxiv.org/abs/2210.08936

- 論文首頁:https://ywq.github.io/s3nerf/

- 程式碼連結:https://github.com/ywq/s3nerf

與現有基於法線貼圖或深度圖的單一視圖方法不同,S# 3-NeRF 基於神經場景表徵(neural scene representation),同時利用場景中的shading 和shadow 資訊重建整個3D 場景(包括可見/ 不可見區域)。神經場景表徵方法使用多層感知器 (MLP)對 連續 3D 空間進行建模,將 3D 點映射到如密度、顏色等的場景屬性。儘管神經場景表徵在多視圖重建和新視圖合成方面取得了重大進展,但其在單視圖場景建模中的探索較少。與現有依賴多視圖照片一致性的基於神經場景表徵的方法不同,S3-NeRF 主要透過利用單一視圖下的 shading 和 shadow 資訊來優化神經場。

我們發現簡單的在 NeRF 中直接引入光源位置資訊作為輸入無法重建場景的幾何和外觀。為了更好地利用捕捉的光度立體影像,我們使用反射場(reflectance field)對錶面幾何和BRDF 進行明確建模,並採用基於物理的渲染來計算場景3D 點的顏色,並透過立體渲染得到該光線(ray)對應的二維像素的顏色。同時,我們對場景的可見度(visibility)進行可微建模,透過追蹤 3D 點到光源之間的光線,計算該點的可見度。然而,考慮一條光線上所有採樣點的可見性計算成本較大,因此我們透過計算光線追蹤得到的表麵點的可見性來優化陰影建模。

基於神經反射場的場景表徵

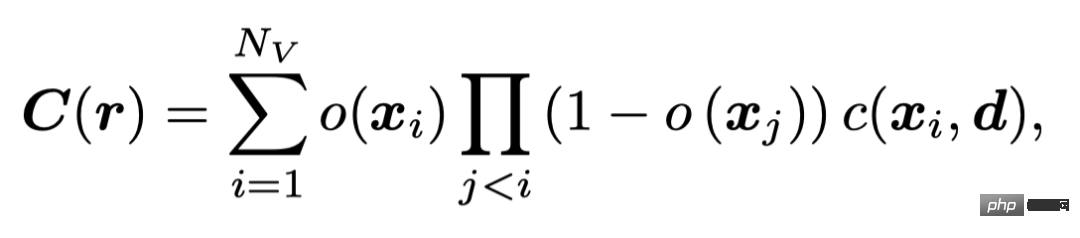

我們採用類似 UNISURF 的 occupancy field 來表徵場景幾何。 UNISURF 透過MLP 將3D 點座標及視線方向對應到該點的occupancy 值和顏色,並透過立體渲染得到像素的顏色,

Nv為每條射線上取樣點的數量。

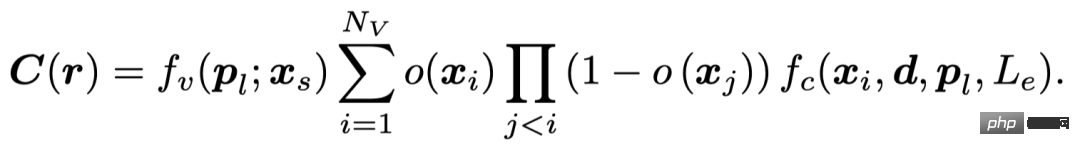

為了有效利用光度立體影像中的shading 訊息,S3-NeRF 明確地對場景的BRDF 進行了建模,並使用基於物理的渲染得到3D 點的顏色。同時我們對場景 3D 點的光可見性進行建模以利用影像中豐富的陰影線索,並透過下式得到最後的像素值。

基於物理的渲染模型

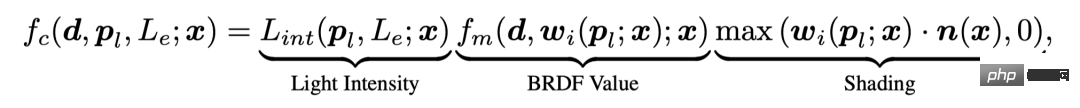

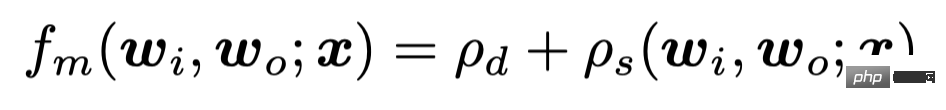

我們的方法考慮了非朗伯表面和空間變化的 BRDF。點x 在近場點光源(pl, Le)下從視線方向d 觀測得到的值可以表示為

其中,我們考慮到點光源的光線衰減問題,透過光源- 點之間的距離計算入射該點的光照強度。我們採用考慮漫反射和鏡面反射的BRDF 模型

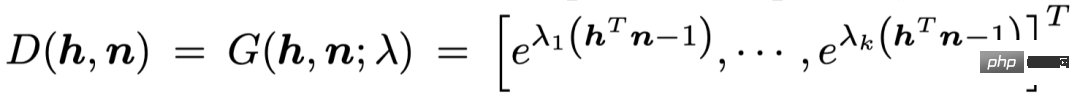

#透過球形高斯(Sphere Gaussian)基底的加權組合來表示鏡面反射率

陰影建模

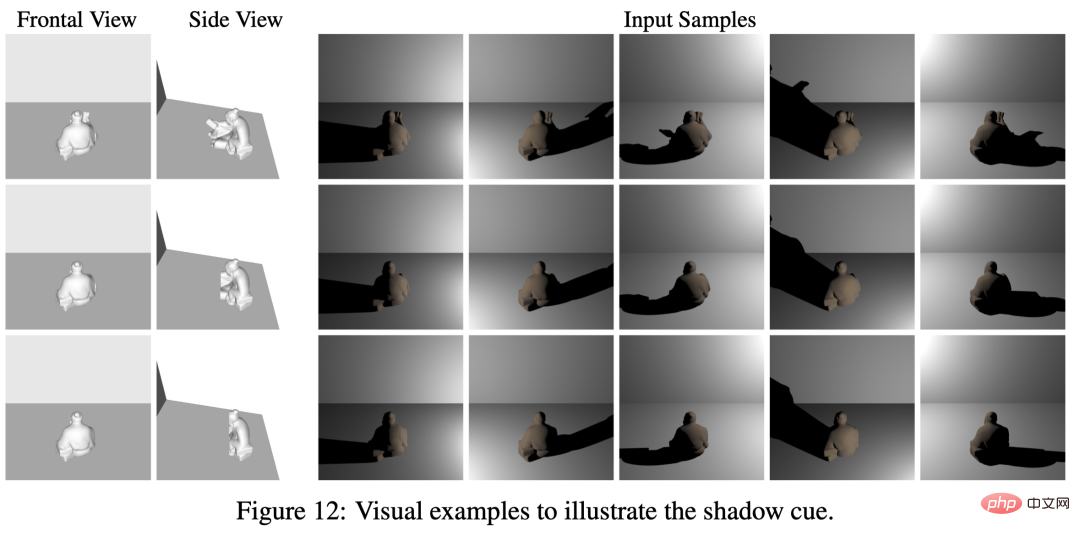

陰影在場景幾何重建中是至關重要的其中一個線索。圖中的三個物體在正視圖中具有相同的形狀和外觀,但其背面卻是形狀各異。透過不同光照下產生的陰影,我們可以觀察到其陰影的形狀各不相同,這些反應了正視圖中不可見區域的幾何資訊。光線透過映射在背景中的陰影對物體的背面輪廓產生了一定的約束。

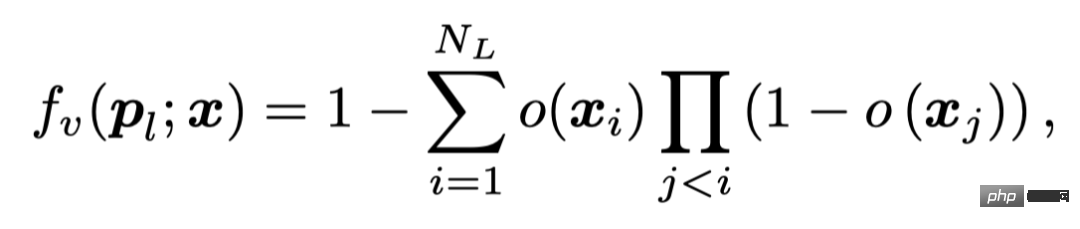

我們透過計算3D 點- 光源之間的occupancy 值來反映該點的光可見度

##其中,NL#是該點- 光源線段上取樣的點的數量。

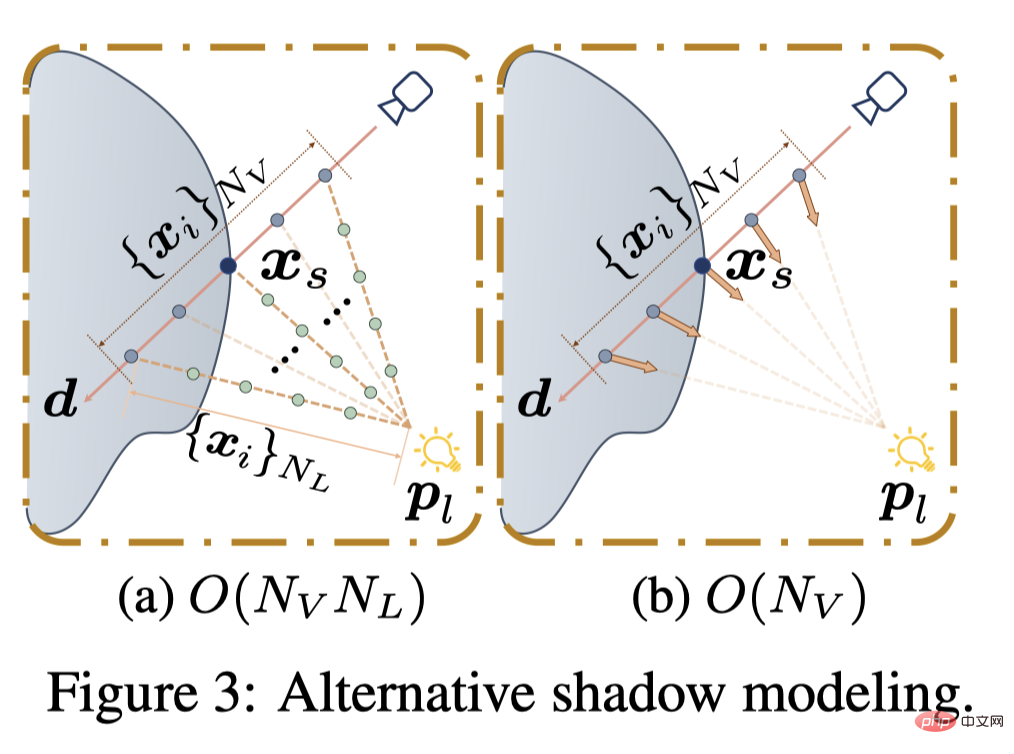

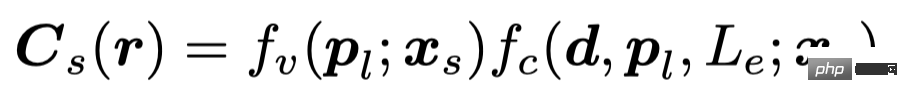

由於計算像素點沿光線取樣的所有 Nv 點的可見度計算成本較大(O (NvNL)),現有的方法有的採用MLP 直接迴歸點的可見度(O (Nv )),或是得到場景幾何後預先擷取表麵點(O (NL))。 S3-NeRF 則透過 root-finding 定位的表麵點以線上方式計算該像素的光可見度,並透過下式表示像素值。

我們的方法不需要對陰影進行監督,而是依靠影像的重建loss 來進行優化。考慮到單視角下沒有其他視角所帶來的額外約束,如果採用類似 UNISURF 逐漸縮小取樣範圍的取樣策略,將會導致模型在取樣間隔減少後開始退化。因此,我們採用聯合立體渲染和表面渲染的策略,利用 root-finding 定位得到的表面點渲染顏色併計算 L1 loss。

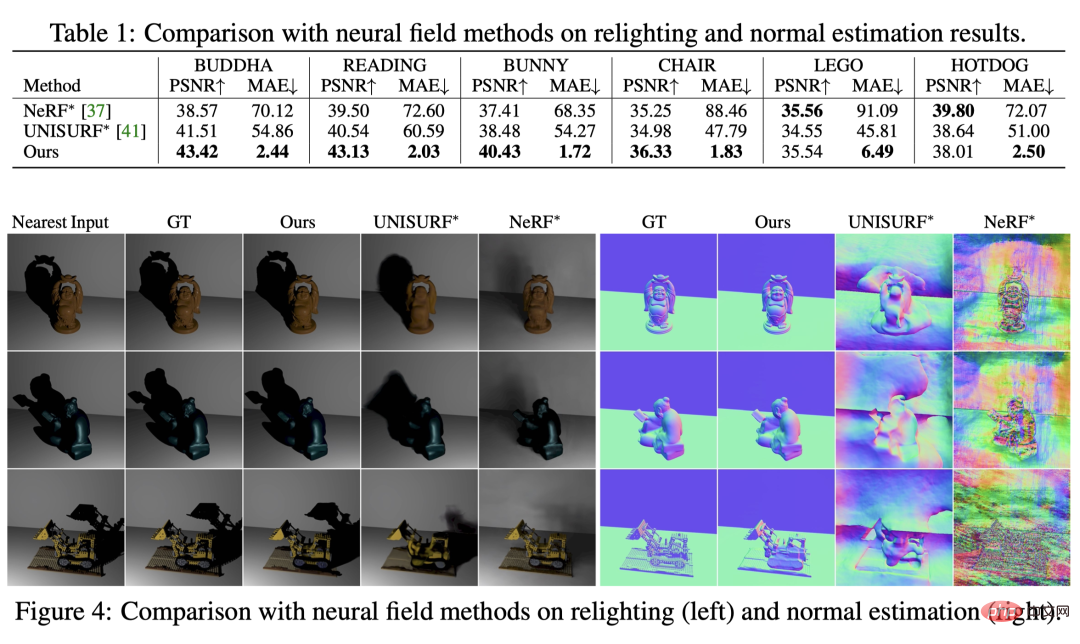

#與神經輻射場方法的比較

###########################################################我們首先與基於神經輻射場的兩個 baseline 方法進行比較(由於任務不同,我們在其顏色 MLP 中引入光源資訊)。可以看到它們無法重建場景幾何,也無法準確地產生新光照下的陰影。

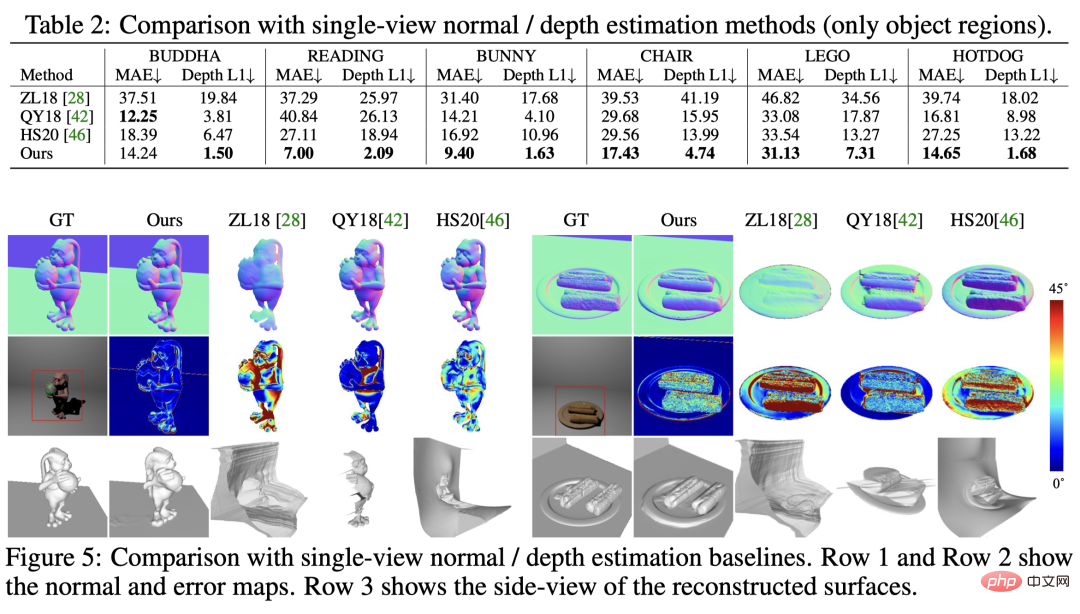

與單一視角形狀估計方法的比較

在與現有單視圖法線/ 深度估計的方法比較中可以看到,我們的方法在法線估計和深度估計上都取得了最好的結果,並且能夠同時重建場景中可見與不可見的區域。

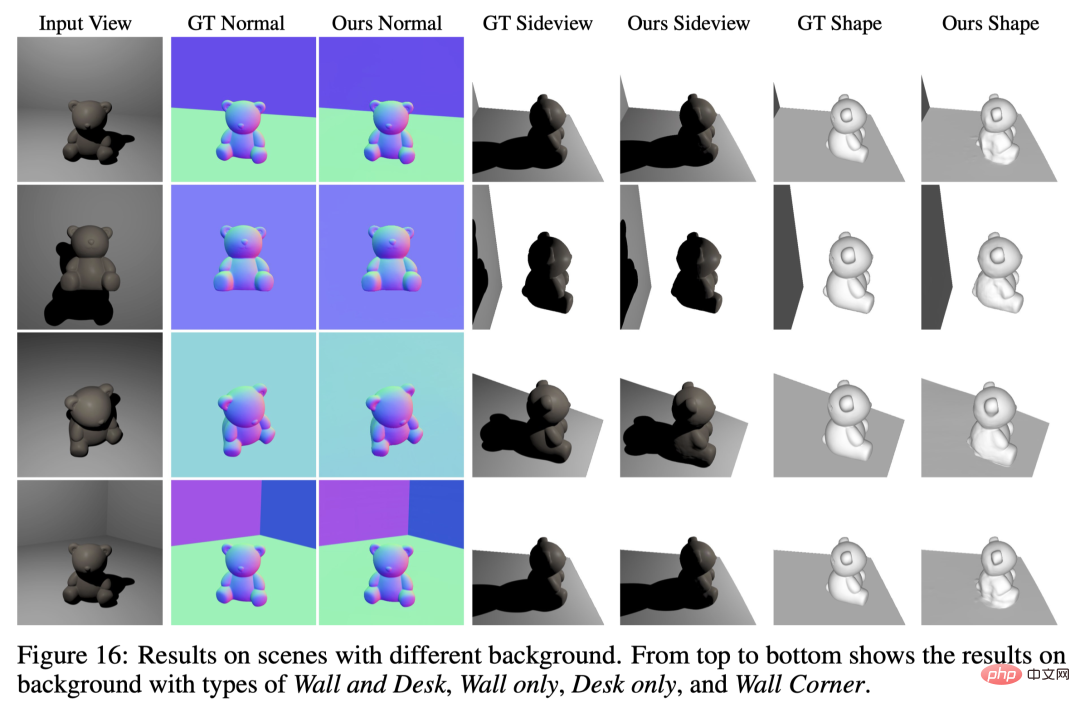

不同背景的場景重建

我們的方法適用於各種不同背景條件的場景。

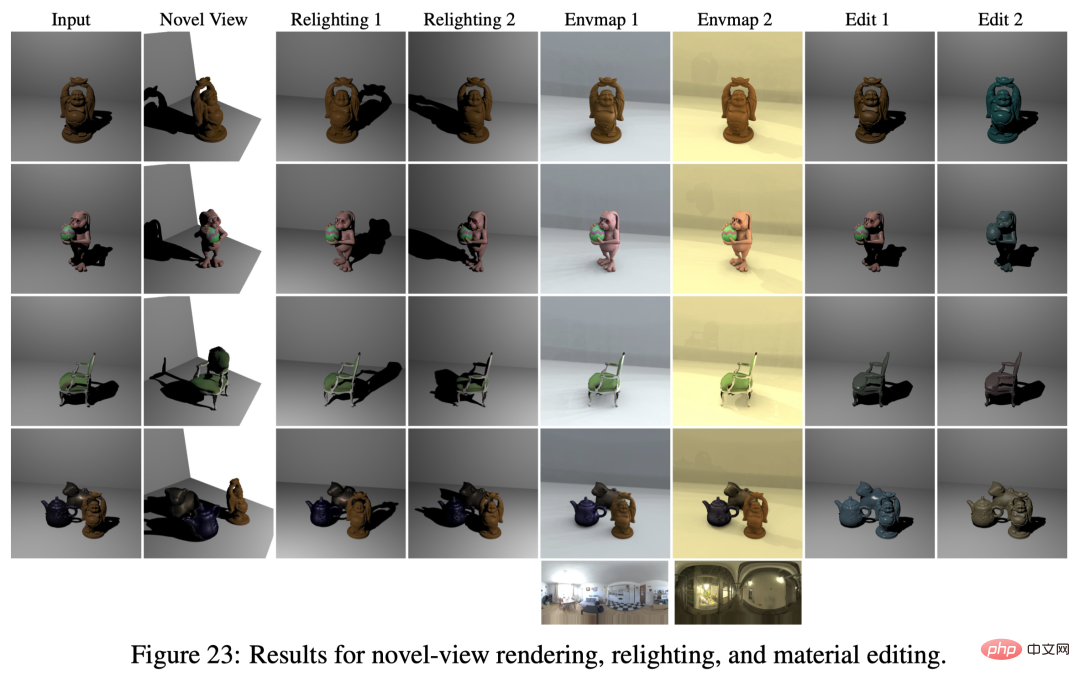

新視圖渲染、改變光照與材料編輯

基於神經反射場的場景建模,我們成功解耦了場景的幾何/ 材質/ 光照等,因而可以應用於新視圖渲染、改變場景光照、材料編輯等應用。

#真實拍攝場景的重建

我們拍攝了三個真實場景來探索其實用性。我們將相機位置固定,利用手機的手電筒作為點光源(環境光源關閉),手持手電筒隨機移動以捕捉不同光源下的影像。此設定無需光源校準,我們應用 SDPS‑Net 得到光源方向的粗略估計,並粗略估計相機 - 物體及光源 - 物體的相對距離來初始化光源位置。光源位置在訓練過程中隨場景的幾何和 BRDF 聯合優化。可以看到即便是較為隨意的資料捕捉設定(沒有光源的校準),我們的方法仍能較好的重建 3D 場景幾何。

總結

- S3-NeRF 透過利用單一視圖多個點光源下拍攝的影像來優化神經反射場以重建3D 場景幾何和材質資訊。

- 透過利用shading 和shadow 線索,S3-NeRF 能有效恢復場景中可見/ 不可見區域的幾何形狀,實現單眼視角下完整場景幾何/ BRDF 的重建。

- 各項實驗顯示我們的方法能夠重建各種複雜幾何 / 材質的場景,並能應付各種幾何 / 材質的背景以及不同的光照數量 / 光源分佈。

以上是利用多光照資訊的單視角NeRF演算法S^3-NeRF,可恢復場景幾何與材質訊息的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

為何在自動駕駛方面Gaussian Splatting如此受歡迎,開始放棄NeRF?

Jan 17, 2024 pm 02:57 PM

為何在自動駕駛方面Gaussian Splatting如此受歡迎,開始放棄NeRF?

Jan 17, 2024 pm 02:57 PM

寫在前面&筆者的個人理解三維Gaussiansplatting(3DGS)是近年來在顯式輻射場和電腦圖形學領域出現的一種變革性技術。這種創新方法的特點是使用了數百萬個3D高斯,這與神經輻射場(NeRF)方法有很大的不同,後者主要使用隱式的基於座標的模型將空間座標映射到像素值。 3DGS憑藉其明確的場景表示和可微分的渲染演算法,不僅保證了即時渲染能力,而且引入了前所未有的控制和場景編輯水平。這將3DGS定位為下一代3D重建和表示的潛在遊戲規則改變者。為此我們首次系統性地概述了3DGS領域的最新發展與關

如何在Microsoft Word中刪除作者和上次修改的訊息

Apr 15, 2023 am 11:43 AM

如何在Microsoft Word中刪除作者和上次修改的訊息

Apr 15, 2023 am 11:43 AM

Microsoft Word文件在儲存時包含一些元資料。這些詳細資訊用於在文件上識別,例如建立時間、作者是誰、修改日期等。它還具有其他信息,例如字元數,字數,段落數等等。如果您可能想要刪除作者或上次修改的資訊或任何其他訊息,以便其他人不知道這些值,那麼有一種方法。在本文中,讓我們看看如何刪除文件的作者和上次修改的資訊。刪除微軟Word文件中的作者和最後修改的資訊步驟 1 –前往

了解 Microsoft Teams 中的 3D Fluent 表情符號

Apr 24, 2023 pm 10:28 PM

了解 Microsoft Teams 中的 3D Fluent 表情符號

Apr 24, 2023 pm 10:28 PM

您一定記得,尤其是如果您是Teams用戶,Microsoft在其以工作為重點的視訊會議應用程式中添加了一批新的3DFluent表情符號。在微軟去年宣佈為Teams和Windows提供3D表情符號之後,該過程實際上已經為該平台更新了1800多個現有表情符號。這個宏偉的想法和為Teams推出的3DFluent表情符號更新首先是透過官方部落格文章進行宣傳的。最新的Teams更新為應用程式帶來了FluentEmojis微軟表示,更新後的1800表情符號將為我們每天

選擇相機還是光達?實現穩健的三維目標檢測的最新綜述

Jan 26, 2024 am 11:18 AM

選擇相機還是光達?實現穩健的三維目標檢測的最新綜述

Jan 26, 2024 am 11:18 AM

0.寫在前面&&個人理解自動駕駛系統依賴先進的感知、決策和控制技術,透過使用各種感測器(如相機、光達、雷達等)來感知周圍環境,並利用演算法和模型進行即時分析和決策。這使得車輛能夠識別道路標誌、檢測和追蹤其他車輛、預測行人行為等,從而安全地操作和適應複雜的交通環境。這項技術目前引起了廣泛的關注,並認為是未來交通領域的重要發展領域之一。但是,讓自動駕駛變得困難的是弄清楚如何讓汽車了解周圍發生的事情。這需要自動駕駛系統中的三維物體偵測演算法可以準確地感知和描述周圍環境中的物體,包括它們的位置、

單卡30秒跑出虛擬3D老婆! Text to 3D產生看清毛孔細節的高精度數字人,無縫銜接Maya、Unity等製作工具

May 23, 2023 pm 02:34 PM

單卡30秒跑出虛擬3D老婆! Text to 3D產生看清毛孔細節的高精度數字人,無縫銜接Maya、Unity等製作工具

May 23, 2023 pm 02:34 PM

ChatGPT為AI產業注入一劑雞血,一切曾經的不敢想,都成為現今的基操。正持續進擊的Text-to-3D,就被視為繼Diffusion(影像)和GPT(文字)後,AIGC領域的下一個前緣熱點,得到了前所未有的關注。這不,一款名為ChatAvatar的產品低調公測,火速收攬超70萬瀏覽與關注,並登上抱抱臉週熱門(Spacesoftheweek)。 △ChatAvatar也將支援從AI生成的單視角/多視角原畫生成3D風格化角色的Imageto3D技術,受到了廣泛關注現行beta版本生成的3D模型,

CLIP-BEVFormer:明確監督BEVFormer結構,提升長尾偵測性能

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer:明確監督BEVFormer結構,提升長尾偵測性能

Mar 26, 2024 pm 12:41 PM

寫在前面&筆者的個人理解目前,在整個自動駕駛系統當中,感知模組扮演了其中至關重要的角色,行駛在道路上的自動駕駛車輛只有通過感知模組獲得到準確的感知結果後,才能讓自動駕駛系統中的下游規控模組做出及時、正確的判斷和行為決策。目前,具備自動駕駛功能的汽車中通常會配備包括環視相機感測器、光達感測器以及毫米波雷達感測器在內的多種數據資訊感測器來收集不同模態的信息,用於實現準確的感知任務。基於純視覺的BEV感知演算法因其較低的硬體成本和易於部署的特點,以及其輸出結果能便捷地應用於各種下游任務,因此受到工業

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

寫在前面項目連結:https://nianticlabs.github.io/mickey/給定兩張圖片,可以透過建立圖片之間的對應關係來估計它們之間的相機姿態。通常,這些對應關係是二維到二維的,而我們估計的姿態在尺度上是不確定的。一些應用,例如隨時隨地實現即時增強現實,需要尺度度量的姿態估計,因此它們依賴外部的深度估計器來恢復尺度。本文提出了MicKey,這是一個關鍵點匹配流程,能夠夠預測三維相機空間中的度量對應關係。透過學習跨影像的三維座標匹配,我們能夠在沒有深度測試的情況下推斷度量相對

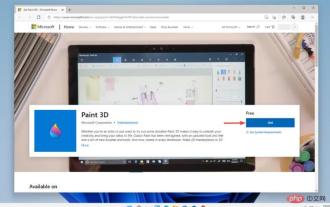

Windows 11中的Paint 3D:下載、安裝和使用指南

Apr 26, 2023 am 11:28 AM

Windows 11中的Paint 3D:下載、安裝和使用指南

Apr 26, 2023 am 11:28 AM

當八卦開始傳播新的Windows11正在開發中時,每個微軟用戶都對新作業系統的外觀以及它將帶來什麼感到好奇。經過猜測,Windows11就在這裡。作業系統帶有新的設計和功能變更。除了一些添加之外,它還附帶功能棄用和刪除。 Windows11中不存在的功能之一是Paint3D。雖然它仍然提供經典的Paint,它對抽屜,塗鴉者和塗鴉者有好處,但它放棄了Paint3D,它提供了額外的功能,非常適合3D創作者。如果您正在尋找一些額外的功能,我們建議AutodeskMaya作為最好的3D設計軟體。如