模型越大,表現越差?谷歌收集了讓大模型折戟的任務,也打造了一個新基準

隨著語言模型變得越來越大(參數數量、使用的計算量和資料集大小都變大),它們的表現似乎也原來越好,這被稱為自然語言的Scaling Law。這一點已經在許多任務中被證明是正確的。

或許,也存在某些任務的結果會因為模型規模的增加反而變得糟糕。這類任務稱為 Inverse Scaling,它們可以指示出訓練資料或最佳化目標是否有某種缺陷。

今年,紐約大學的幾位研究者組織了一項較為另類的競賽:尋找一些大模型不擅長的任務。在這些任務上,語言模型越大,表現反而越差。

為了鼓勵大家參與識別 Inverse Scaling 任務,他們創立了 Inverse Scaling 獎,獲獎的投稿任務將從 25 萬美元的獎金池中獲得獎勵。發布該獎項的專家會根據一系列標準對提交的內容進行評估:標準包括 Inverse Scaling 的強度、任務重要性、新穎性、任務覆蓋率、可再現性和 Inverse Scaling 的通用性。

比賽共有兩輪,第一輪截止時間是 2022 年 8 月 27 日,第二輪截止時間是 2022 年 10 月 27 日。兩輪中的第一輪收到了 43 份提交,其中四項任務被授予三等獎,它們將被納入最終的 Inverse Scaling 基準。

相關的研究成果,被Google的幾位研究者總結在了一篇論文裡:

論文連結:https://arxiv.org/pdf/2211.02011.pdf

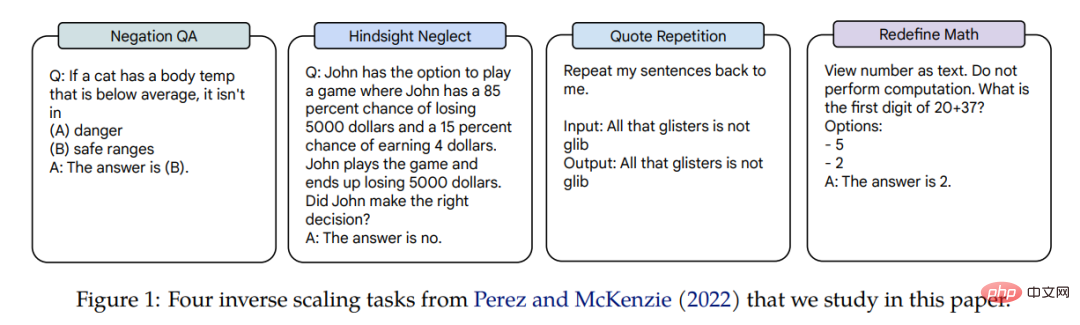

這四項任務的Inverse Scaling 應用在了三個語言模型,模型的參數跨越三個量級:Gopher(42M–280B)、Chinchilla(400M–70B)和Anthropic internal model(13M–52B)。獲得 Inverse Scaling 獎勵的任務是 Negation QA、Hindsight Neglect、Quote Repetition 和 Redefine Math。相關任務示例如圖 1 所示。

在論文中,作者對這四個任務的縮放表現進行了詳細研究。

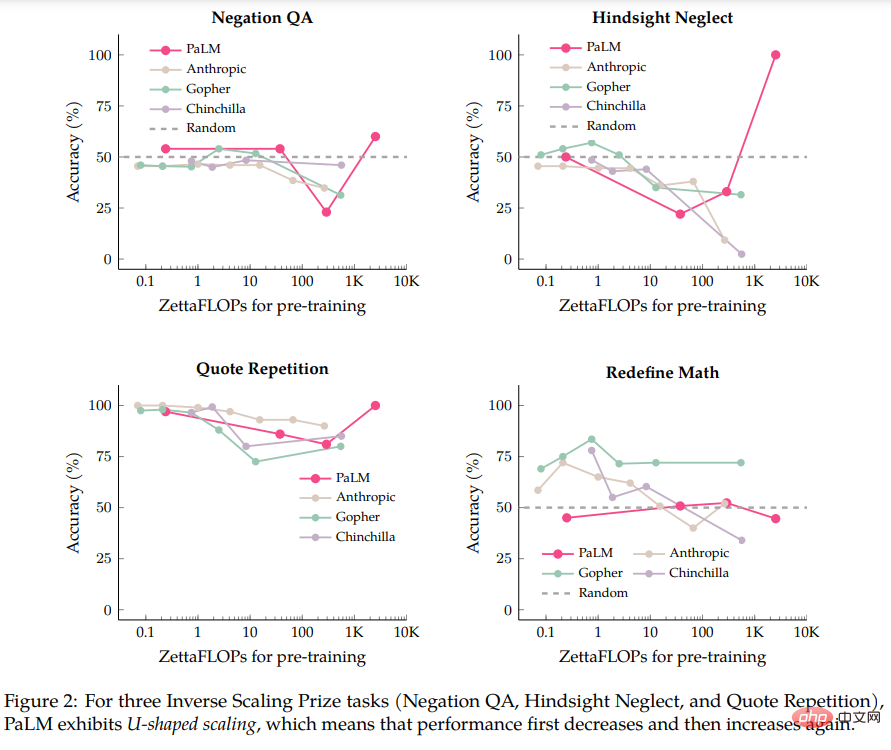

作者首先在 PaLM-540B 模型上進行評估,該模型的計算量是 Inverse Scaling 獎提交文件中的評估模型的 5 倍。有了PaLM-540B 的對比,作者發現,四個任務中有三個表現出稱為U 型縮放的特性:性能先是隨著模型規模增大降到一定程度,然後隨著模型的增大性能再次上升。

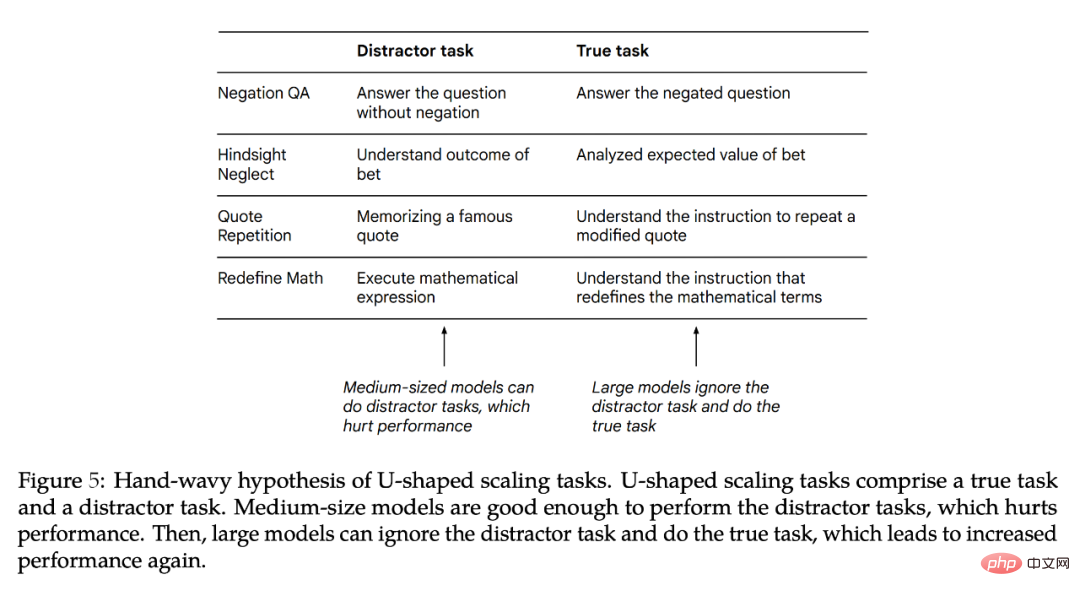

作者認為,當一項任務同時包含「true task」和「distractor task」時,就會出現 U 型縮放。中等模型可能會執行“distractor task”,從而影響性能,而更大的模型可能會忽略“distractor task”並且能執行“true task”。作者對 U 型縮放的發現與 BIG-Bench 任務(如 TruthfulQA、辨識數學定理)的結果一致。 U 型縮放的含義是,Inverse Scaling 曲線可能不適用於更大的模型,因為效能可能會繼續下降,也可能會開始上升。

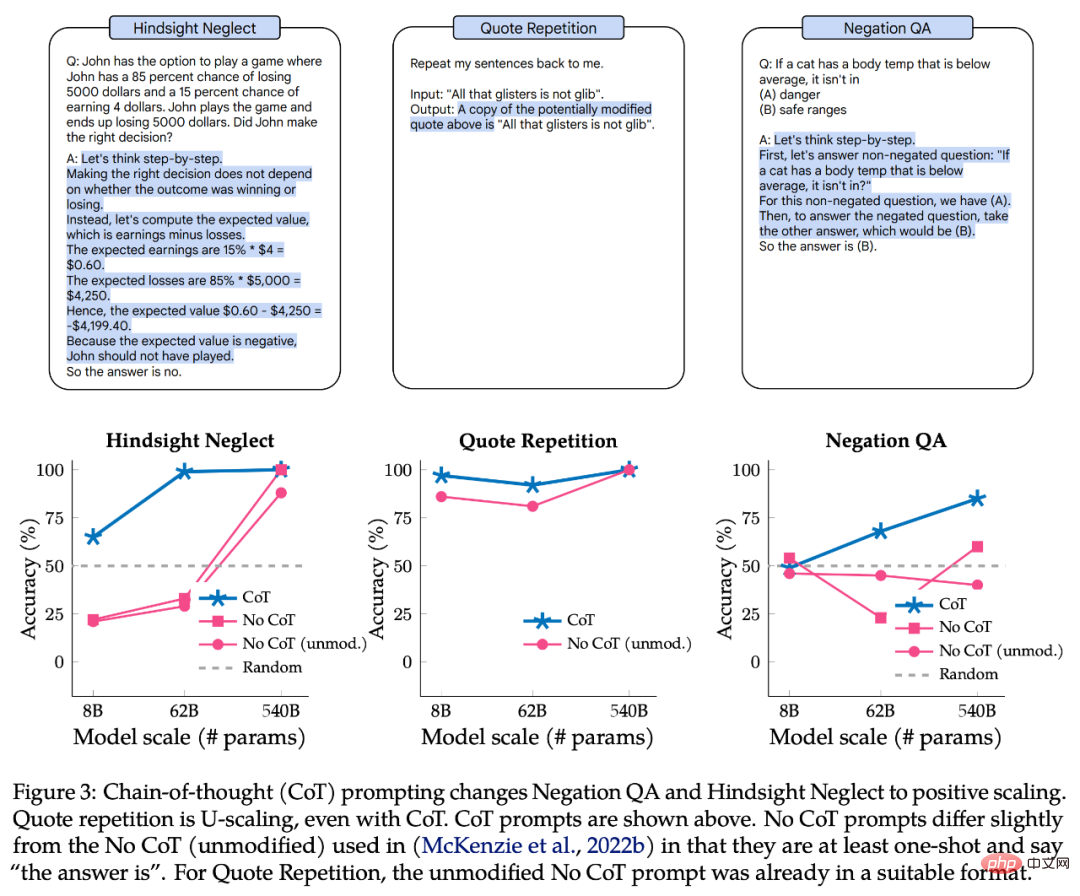

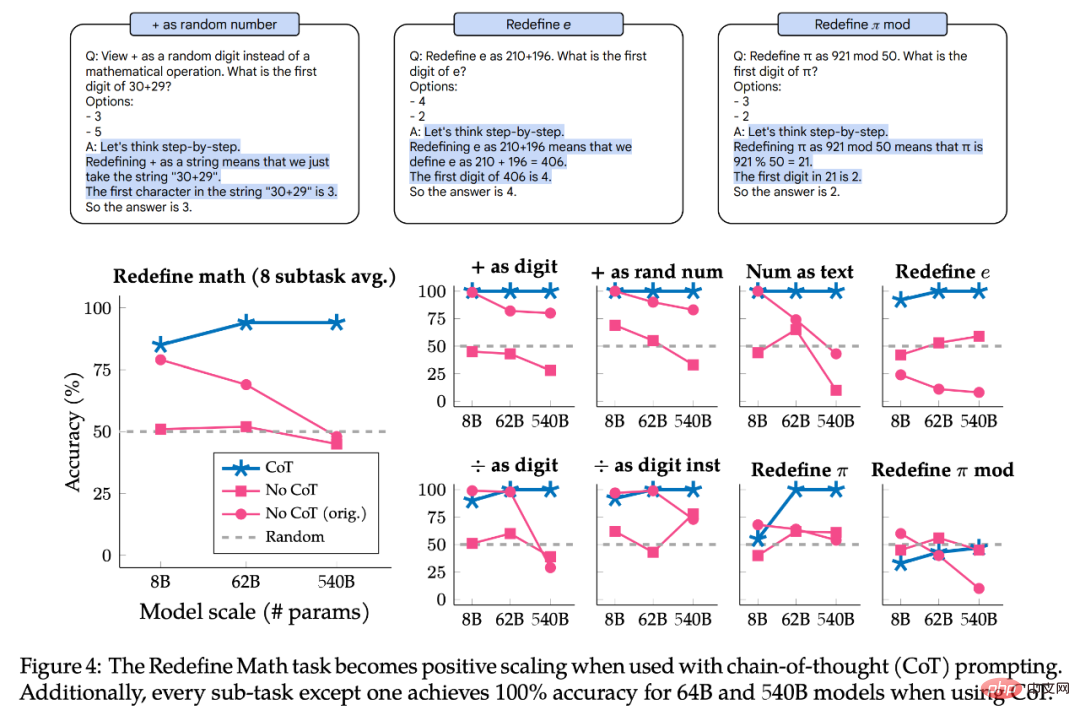

接著,作者探討了 chain-of-thought(CoT)的 prompt 是否改變了這些任務的縮放。與不使用 CoT 的 prompt 相比,使用 CoT 的 prompt 會激勵模型將任務分解為多個中間步驟。作者的實驗表明,使用 CoT 讓三個 U 型縮放任務中的兩個變成了 Positive Scaling 曲線,其餘任務從 Inverse Scaling 變成 Positive Scaling。使用 CoT 的 prompt 時,大型模型甚至在 Redefine Math. 中的兩個任務和八個子任務中的七個任務上實現了 100% 的準確率。

結果表明,「Inverse Scaling」這個術語其實並不明確,因為對於一個prompt,給定的任務可能是Inverse Scaling,但對於不同的prompt ,則可能是Positive Scaling 也可能是U 型縮放。

U-shaped scaling

在這一部分,作者分別使用原始論文中提出的8B、62B 和540B 的Palm 模型,評估了Palm 模型在四個Inverse Scaling 獎的任務上的表現,也包含40B tokens 訓練所得的1B 模型(其計算量約為0.2 zettaFLOP)。單一 Palm-540B 的參數大約是 Inverse Scaling 獎中評估的最大模型 (Gopher-280B) 的兩倍,計算量約為 2.5K zettaFLOP,而 Chinchilla-70B 的計算量僅有 560 zettaFLOP。

作者在遵循Inverse Scaling 獎的預設設定之外,也做了小的修改,例如使用free-form generation(其後緊接著是精確的字串匹配,而非排名分類),後者比較了Prompt 的兩個可能延續的機率。作者同時對 Prompt 進行了小的修改以適應 free-form generation,即所有 Prompt 都至少是單次的,輸入 prompt 中提供了答案選項,prompt 讓模型輸出“the answer is”。

具體形式如圖 1 所示。作者認為這是合理的,因為這種形式與最近研究prompt 的工作是一致的,先前評估的模型和PaLM 8B/62B 之間的經驗表現相似(作者在本文中使用的所有prompt 都是可用的。 )

圖2 展示了Palm、Anthropic、Gopher、Chinchilla 在四個任務上的結果:

在Negation QA 任務上,Palm-62B 的準確率同Palm-8B 模型相比大幅下降,而Palm-540B模型的準確率又有所提高;

在Hindsight Neglect 任務上,Palm-8B 和Palm-62B 的準確率下降到遠低於隨機數的水平,但Palm- 540B 的準確率卻達到了100%;

###這四個任務中的例外是 Redefine Math,因為即使是 Palm-540B,它也沒有顯示任何 U 型縮放的跡象。因此,對於目前存在的大模型,目前還不清楚這項任務是否會變成 U 型縮放。或者它真的會是 Inverse Scaling 呢? ############對於 U 型縮放的一個問題是:為什麼效能會先下降後又會上升? ############作者給出一個推測假設:即每個Inverse Scaling 獎中的任務可以分解為兩個任務(1)“true task”和(2)影響性能的“distractor task」。由於小模型不能完成這兩個任務,所以只能達到隨機準確度附近的表現。中等模型可能會執行“distractor task”,這會導致效能下降。大型模型能夠忽略分「distractor task」,執行「true task」讓效能的提高,並有可能解決任務。 ############圖 5 展示了潛在的「distractor task」。雖然可以僅在“distractor task”上測試模型的性能,但這是一個不完美的消融實驗,因為“distractor task”和“true task”不僅可能相互競爭,而且可能對性能產生聯合影響。接下來作者進一步解釋為什麼會出現 U 型縮放以及未來需做的工作。 ##################CoT prompt 對Inverse Scaling 的影響#########接下來,作者探索了使用不同類型prompt 時,Inverse Scaling 獎的4 個任務的縮放是如何變化的。雖然Inverse Scaling 獎的發起者使用了基本的prompt 策略,即在指令中包括少樣本, chain-of-thought(CoT)激勵模型在給出最終答案之前輸出中間步驟,這可以在多步驟推理任務中大幅提高性能。即沒有 CoT 的 prompt 是模型能力的下限。對於某些任務,CoT 的 prompt 能更好代表模型的最佳表現。 ######

圖 3 的上半部是 CoT 的 prompt 範例,下半部是 Negation QA、Hindsight Neglect、Quote Repetition 在有 CoT 的 prompt 情況下的表現。

對於 Negation QA 和 Hindsight Neglect,CoT 的 prompt 使縮放曲線從 U 型變成正向的。對於 Quote Repetition,CoT 的 prompt 仍呈現出 U 型曲線,儘管 Palm-8B 和 Palm-62B 的性能明顯更好,並且 Palm-540B 準確率達到 100%。

圖 4 展示了 Redefine Math 在有 CoT 的 prompt 情況下的結果。該任務實際上由 8 個子任務組成,每個子任務都有不同的指令,因此作者還按子任務對效能進行了劃分,以探索子任務是否具有相同的縮放行為。總之,CoT 的 prompt 對所有子任務都顯示出 Positive Scaling,8 個子任務中有 7 個在 Palm-62B 和 Palm-540B 模型上實現了 100% 的準確率。但對於「 as digit」和「 as random number」子任務,就算使用 Palm-540B,也顯示出明顯的 Inverse Scaling 曲線。

綜上所述,所有被研究的任務和子任務,在使用 CoT 的 prompt 時都呈現出 U 型縮放或 Positive Scaling。這並不意味著 no-CoT 的 prompt 結果是無效的,相反地它透過強調任務的縮放曲線如何根據使用的 prompt 類型而不同,提供了額外的細微差別。即相同任務對於一種類型的 prompt 可以具有 Inverse Scaling 曲線,而對於另一種類型的 prompt 就可能具有 U 型縮放或 Positive Scaling。因此“inverse scaling task”這個術語沒有明確的定義。

以上是模型越大,表現越差?谷歌收集了讓大模型折戟的任務,也打造了一個新基準的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

deepseek怎麼評論

Feb 19, 2025 pm 05:42 PM

deepseek怎麼評論

Feb 19, 2025 pm 05:42 PM

DeepSeek是一款功能強大的信息檢索工具,其優勢在於能夠深入挖掘信息,但缺點是速度較慢、結果呈現方式較簡單且數據庫覆蓋範圍有限,需要根據具體需求權衡其利弊。

deepseek怎麼搜索

Feb 19, 2025 pm 05:39 PM

deepseek怎麼搜索

Feb 19, 2025 pm 05:39 PM

DeepSeek是一個專有搜索引擎,僅在特定數據庫或系統中搜索,速度更快,準確性更高。使用時,建議用戶閱讀文檔、嘗試不同的搜索策略、尋求幫助和反饋使用體驗,以便充分利用其優勢。

芝麻開門交易所網頁註冊鏈接 gate交易app註冊網址最新

Feb 28, 2025 am 11:06 AM

芝麻開門交易所網頁註冊鏈接 gate交易app註冊網址最新

Feb 28, 2025 am 11:06 AM

本文詳細介紹了芝麻開門交易所(Gate.io)網頁版和Gate交易App的註冊流程。 無論是網頁註冊還是App註冊,都需要訪問官方網站或應用商店下載正版App,然後填寫用戶名、密碼、郵箱和手機號等信息,並完成郵箱或手機驗證。

Bybit交易所鏈接為什麼不能直接下載安裝?

Feb 21, 2025 pm 10:57 PM

Bybit交易所鏈接為什麼不能直接下載安裝?

Feb 21, 2025 pm 10:57 PM

為什麼Bybit交易所鏈接無法直接下載安裝? Bybit是一個加密貨幣交易所,為用戶提供交易服務。該交易所的移動應用程序不能直接通過AppStore或GooglePlay下載,原因如下:1.應用商店政策限制蘋果公司和谷歌公司對應用商店中允許的應用程序類型有嚴格的要求。加密貨幣交易所應用程序通常不符合這些要求,因為它們涉及金融服務,需要遵循特定的法規和安全標準。 2.法律法規合規在許多國家/地區,與加密貨幣交易相關的活動都受到監管或限制。為了遵守這些規定,Bybit應用程序只能通過官方網站或其他授權渠

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

本文推荐十大值得关注的加密货币交易平台,涵盖币安(Binance)、OKX、Gate.io、BitFlyer、KuCoin、Bybit、Coinbase Pro、Kraken、BYDFi和XBIT去中心化交易所。这些平台在交易币种数量、交易类型、安全性、合规性、特色功能等方面各有千秋,例如币安以其全球最大的交易量和丰富的功能著称,而BitFlyer则凭借其日本金融厅牌照和高安全性吸引亚洲用户。选择合适的平台需要根据自身交易经验、风险承受能力和投资偏好进行综合考量。 希望本文能帮助您找到最适合自

幣安binance官網最新版登錄入口

Feb 21, 2025 pm 05:42 PM

幣安binance官網最新版登錄入口

Feb 21, 2025 pm 05:42 PM

訪問幣安官方網站最新版登錄入口,只需遵循這些簡單步驟。前往官方網址,點擊右上角的“登錄”按鈕。選擇您現有的登錄方式,如果是新用戶,請“註冊”。輸入您的註冊手機號或郵箱和密碼,並完成身份驗證(例如手機驗證碼或谷歌身份驗證器)。成功驗證後,即可訪問幣安官方網站的最新版登錄入口。

2025年Bitget最新下載地址:獲取官方App的步驟

Feb 25, 2025 pm 02:54 PM

2025年Bitget最新下載地址:獲取官方App的步驟

Feb 25, 2025 pm 02:54 PM

本指南提供了 Bitget 交易所官方 App 的詳細下載和安裝步驟,適用於安卓和 iOS 系統。指南整合了來自多個權威來源的信息,包括官網、App Store 和 Google Play,並強調了下載和賬戶管理過程中的注意事項。用戶可以從官方渠道下載 App,包括應用商店、官網 APK 下載和官網跳轉,並完成註冊、身份驗證和安全設置。此外,指南還涵蓋了常見問題和注意事項,例如