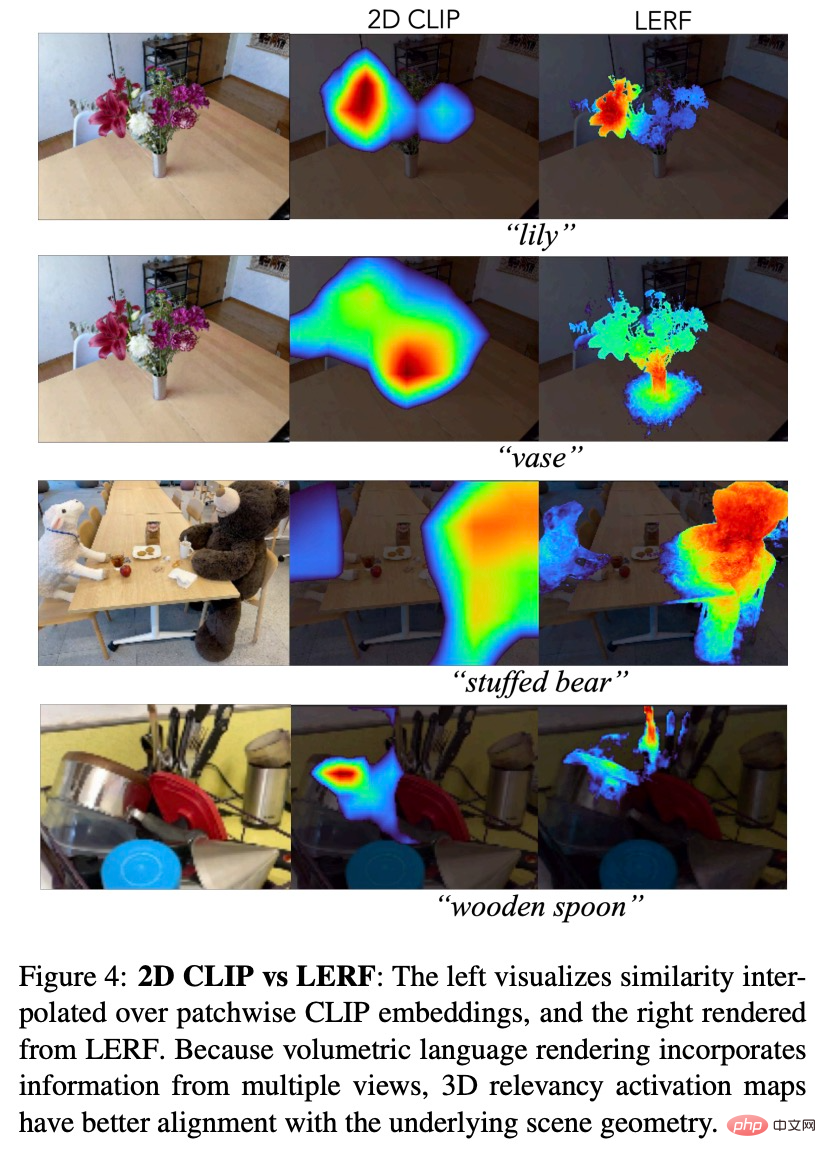

自然語言融入NeRF,給點文字就產生3D圖的LERF來了

NeRF(Neural Radiance Fields)又稱神經輻射場,自從被提出以來,火速成為最為熱門的研究領域之一,效果非常驚艷。然而,NeRF 的直接輸出只是一個彩色的密度場,對研究者來說可用資訊很少,缺乏上下文就是需要面對的問題之一,其效果是直接影響了與 3D 場景互動介面的建構。

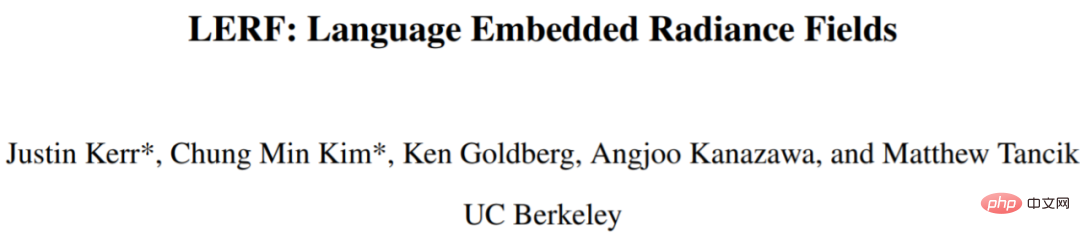

但自然語言不同,自然語言與 3D 場景互動非常直覺。我們可以用圖 1 中的廚房場景來解釋,透過詢問餐具在哪,或詢問用來攪拌的工具在哪,以這種方式就可以在廚房裡找到物體。不過完成這項任務不僅需要模型的查詢能力,還需要能夠在多個尺度上合併語意等。

本文中,來自UC 柏克萊的研究者提出了一種新穎的方法,並命名為LERF(Language Embedded Radiance Fields),該方法將CLIP(Contrastive Language-Image Pre -training)等模型中的語言嵌入到NeRF 中,使得這些類型的3D 開放式語言查詢成為可能。 LERF 直接使用 CLIP,無需透過 COCO 等資料集進行微調,也不需要依賴遮罩區域建議。 LERF 在多個尺度上保留了 CLIP 嵌入的完整性,也能夠處理各種語言查詢,包括視覺屬性(如黃色)、抽象概念(如電流)、文字等,如圖 1 所示。

論文網址:https://arxiv.org/pdf/2303.09553v1.pdf

專案首頁:https://www.lerf.io/

LERF 可以即時互動地為語言提示擷取3D 相關圖示。例如在一張有小羊和水杯的桌上,輸入提示小羊、或水杯,LERF 就可以給相關3D 圖:

對於複雜的花束,LERF 也可以精準定位:

# 廚房中的不同物體:

方法

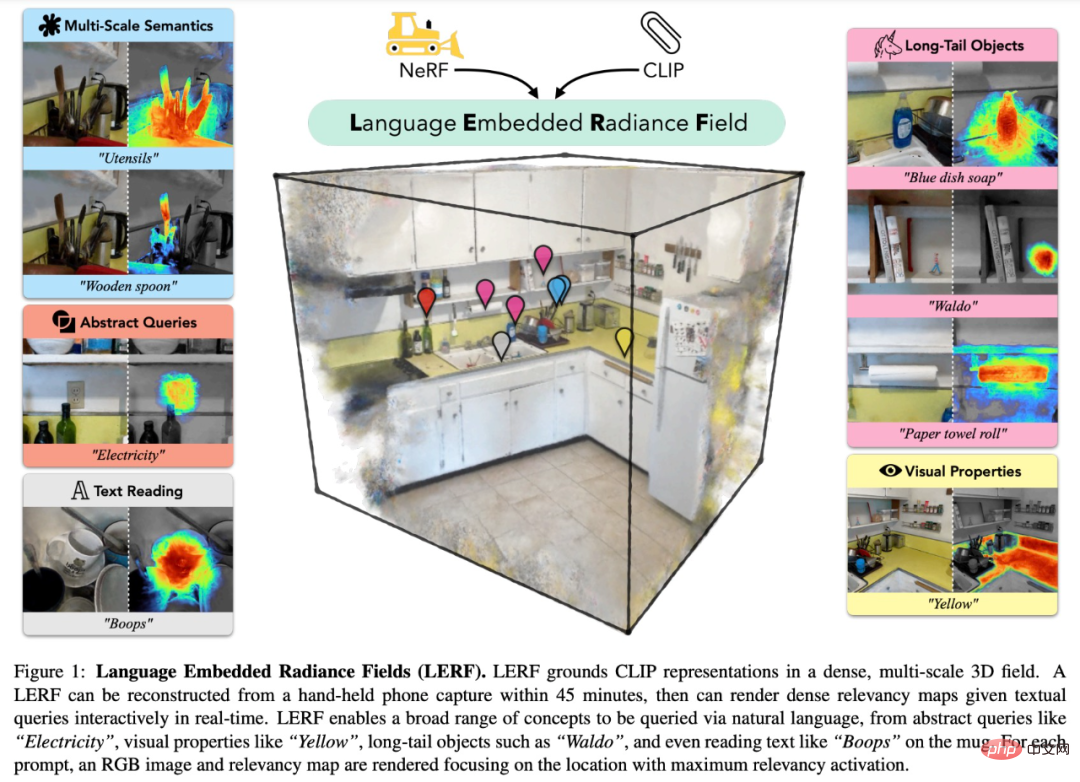

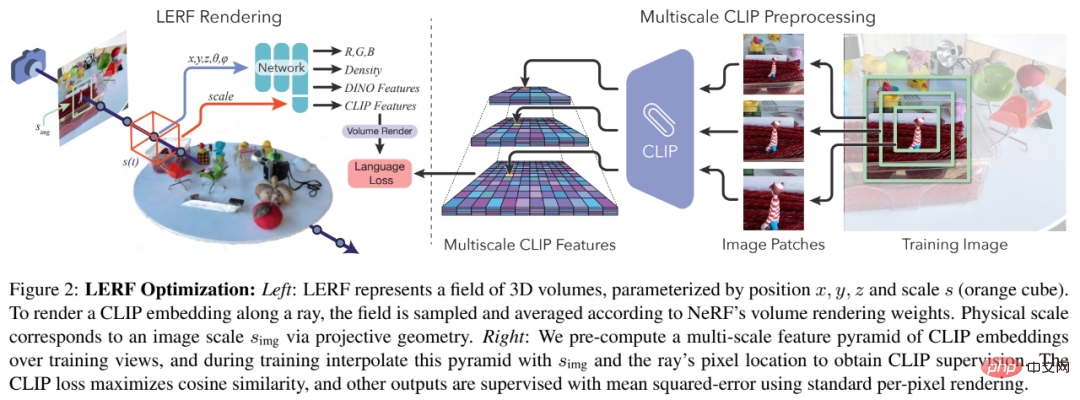

研究透過與NeRF 共同最佳化語言場建構了新方法LERF。 LERF 將位置和物理尺度作為輸入並輸出單一 CLIP 向量。在訓練期間,場(field)使用多尺度特徵金字塔(pyramid)進行監督,該金字塔包含從訓練視圖的圖像裁剪(crop)生成的 CLIP 嵌入。這允許 CLIP 編碼器捕捉不同尺度的圖像語境,從而將相同的 3D 位置與不同尺度的語言嵌入相關聯。 LERF 可以在測試期間以任意尺度查詢語言場以獲得 3D 相關性映射。

由於從多尺度的多個視圖中提取CLIP 嵌入,因此透過LERF 的3D CLIP 嵌入獲得的文字查詢的相關性映射與透過2D CLIP 嵌入獲得的相比更加本地化(localized),並且是3D 一致的,可以直接在3D 場中進行查詢,而無需渲染多個視圖。

LERF 需要在以樣本點為中心的體積上學習語言嵌入場。具體來說,該場的輸出是包含指定體積的影像裁切的所有訓練視圖的平均 CLIP 嵌入。透過將查詢從點重構為體積,LERF 可以有效地從輸入影像的粗略裁剪中監督密集場,這些影像可以透過在給定的體積尺度上進行調節以像素對齊的方式呈現。

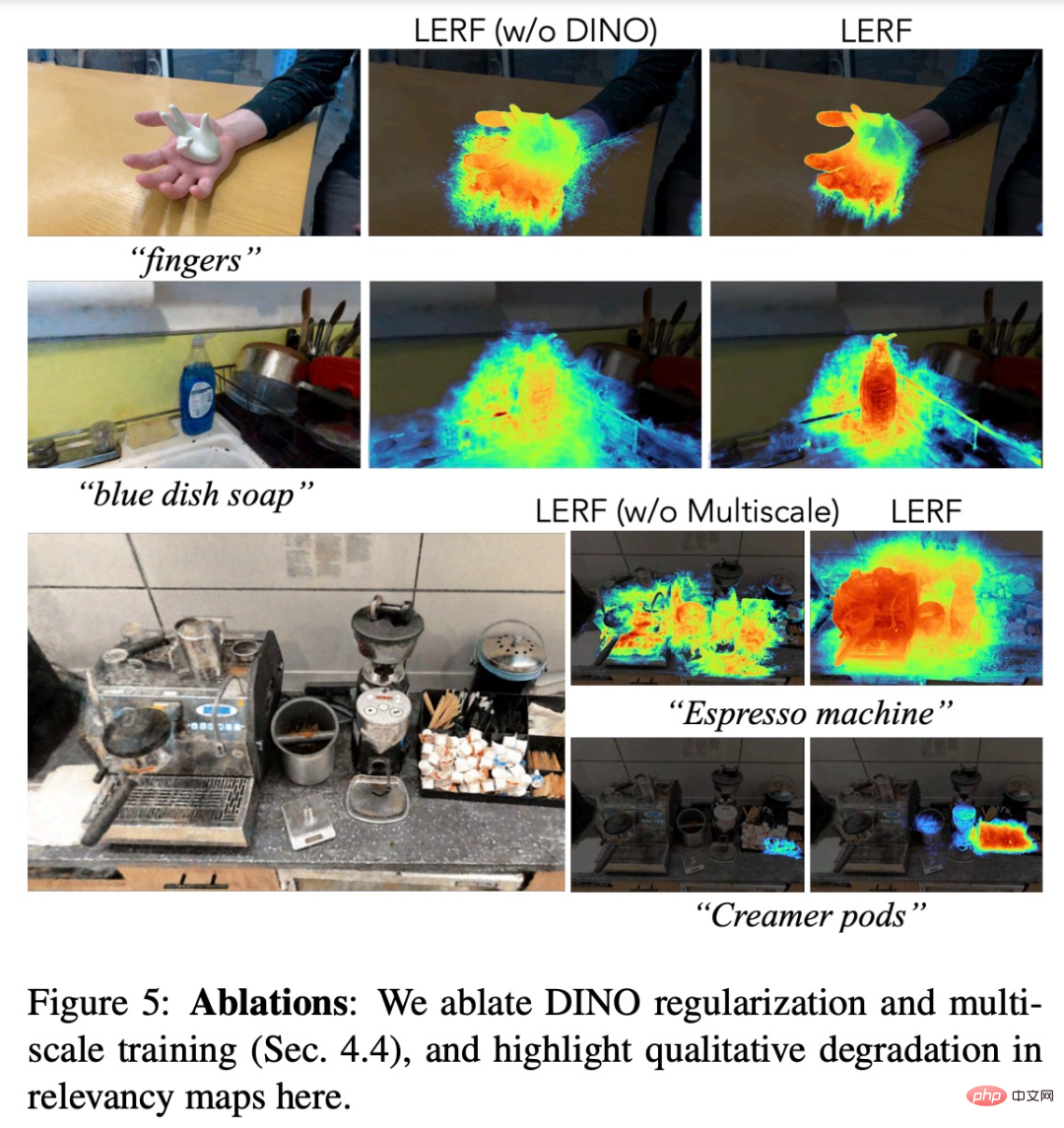

LERF 本身會產生連貫的結果,但產生的相關性映射有時可能是不完整的,並且包含一些異常值,如下圖 5 所示。

為了規範優化的語言場,該研究透過共享瓶頸引入了自監督的 DINO。

在架構方面,優化3D 中的語言嵌入不應該影響底層場景表徵中的密度分佈,因此該研究透過訓練兩個獨立的網路來捕捉LERF 中的歸納偏置(inductive bias):一個用於特徵向量(DINO、CLIP),另一個用於標準NeRF 輸出(顏色、密度)。

實驗

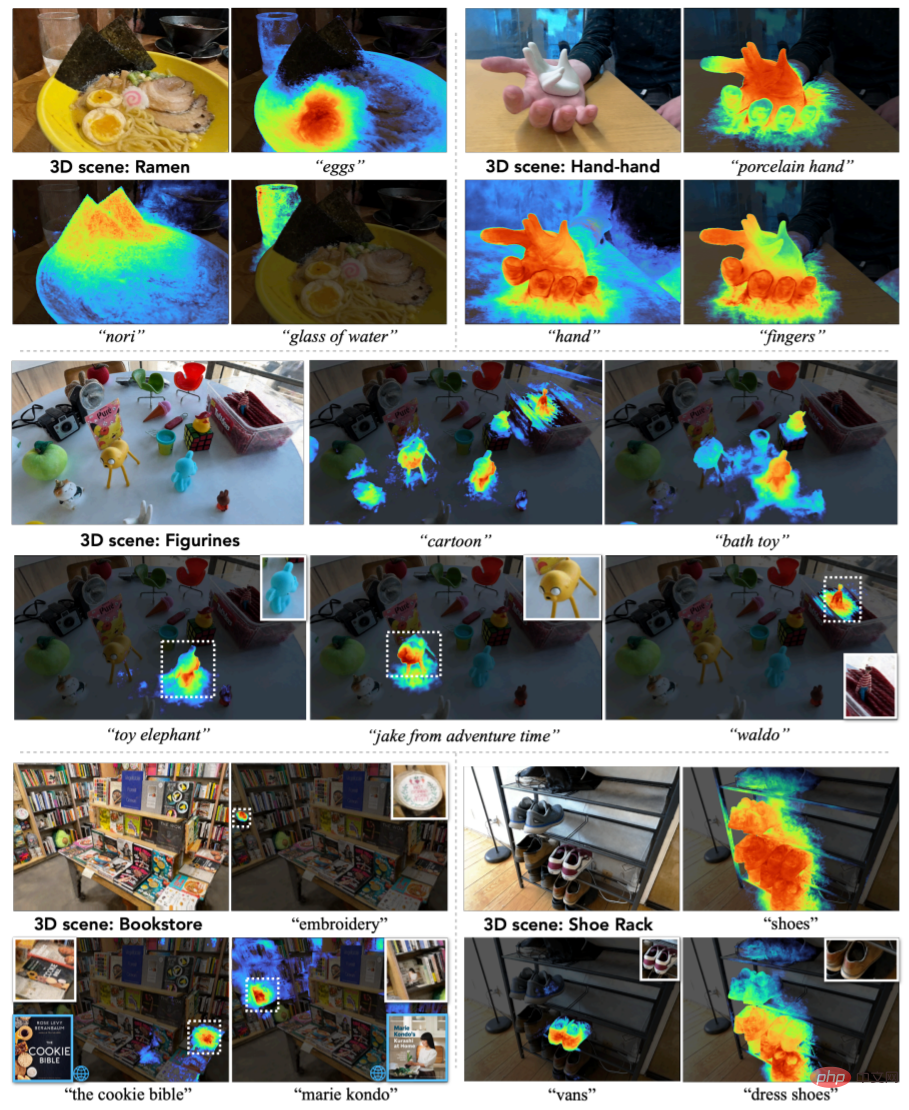

為了展示LERF 處理真實世界資料的能力,研究收集了13 個場景,其中包括雜貨店、廚房、書店、小雕像等場景。圖 3 選擇了 5 個代表性的場景,展示了 LERF 處理自然語言的能力。

圖3

圖3

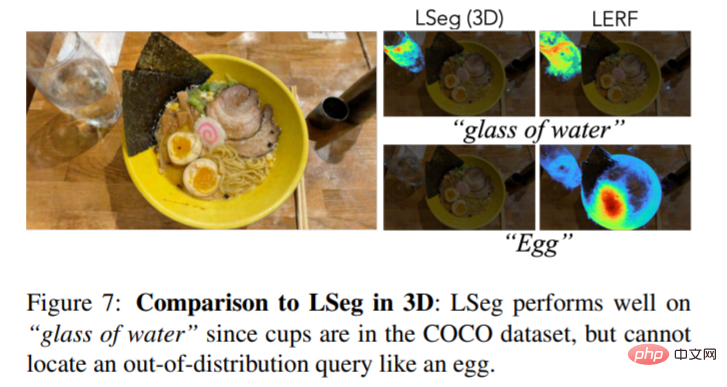

圖7 為LERF 與LSeg 的3D 視覺對比,在標定碗裡的雞蛋中,LSeg 不如LERF:

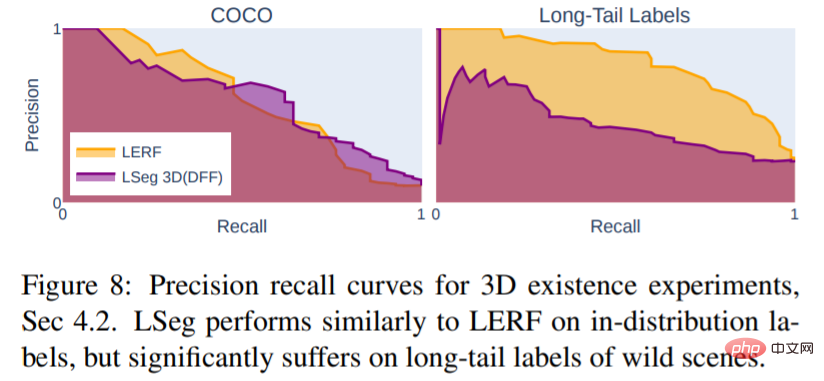

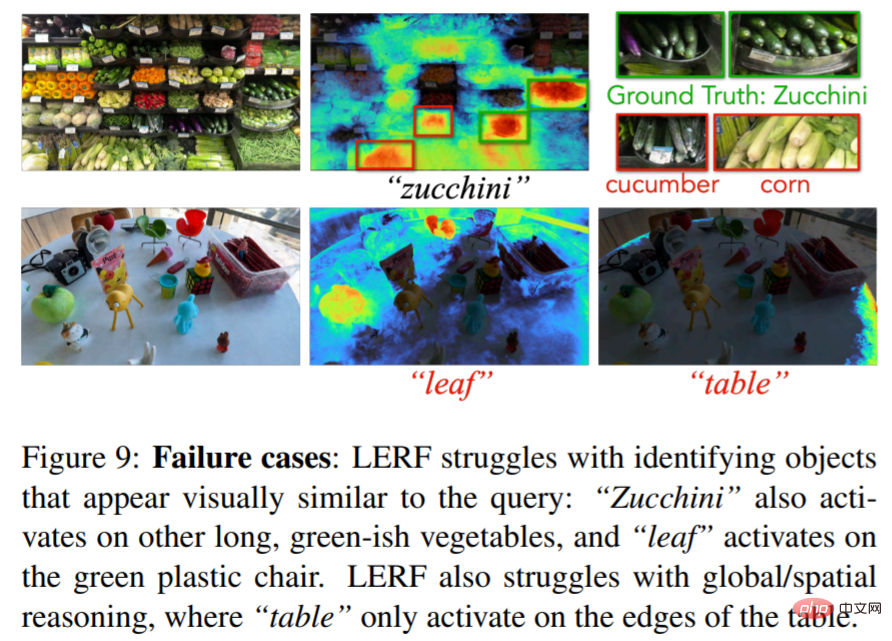

##圖8 表明,在有限的分割數據集上訓練的LSeg 缺乏有效表示自然語言的能力。相反,它僅在訓練集分佈範圍內的常見物件上表現良好,如圖 7 所示。

以上是自然語言融入NeRF,給點文字就產生3D圖的LERF來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

自然語言生成任務中的五種採樣方法介紹和Pytorch程式碼實現

Feb 20, 2024 am 08:50 AM

自然語言生成任務中的五種採樣方法介紹和Pytorch程式碼實現

Feb 20, 2024 am 08:50 AM

在自然語言生成任務中,取樣方法是從生成模型中獲得文字輸出的一種技術。這篇文章將討論5種常用方法,並使用PyTorch進行實作。 1.GreedyDecoding在貪婪解碼中,生成模型根據輸入序列逐個時間步地預測輸出序列的單字。在每個時間步,模型會計算每個單字的條件機率分佈,然後選擇具有最高條件機率的單字作為當前時間步的輸出。這個單字成為下一個時間步的輸入,生成過程會持續直到滿足某種終止條件,例如產生了指定長度的序列或產生了特殊的結束標記。 GreedyDecoding的特點是每次選擇當前條件機率最

如何使用PHP進行基本的自然語言生成

Jun 22, 2023 am 11:05 AM

如何使用PHP進行基本的自然語言生成

Jun 22, 2023 am 11:05 AM

自然語言生成是一種人工智慧技術,它能夠將資料轉換為自然語言文字。在當今的大數據時代,越來越多的業務需要將資料視覺化或呈現給用戶,而自然語言生成正是一種非常有效的方法。 PHP是一種非常受歡迎的伺服器端腳本語言,它可以用來開發網頁應用程式。本文將簡要介紹如何使用PHP進行基本的自然語言生成。引入自然語言生成庫PHP自帶的函數庫並不包括自然語言生成所需的功能,因此

使用馬可夫鏈建立文字產生器

Apr 09, 2023 pm 10:11 PM

使用馬可夫鏈建立文字產生器

Apr 09, 2023 pm 10:11 PM

本文中將介紹一個流行的機器學習專案-文字產生器,你將了解如何建立文字產生器,並了解如何實作馬可夫鏈以實現更快的預測模型。文字產生器簡介文字生成在各個行業都很受歡迎,特別是在行動、應用和資料科學領域。甚至新聞界也使用文字生成來輔助寫作過程。在日常生活中都會接觸到一些文本生成技術,文本補全、搜尋建議,Smart Compose,聊天機器人都是應用的例子,本文將使用馬可夫鏈建立一個文本生成器。這將是一個基於字元的模型,它接受鏈的前一個字元並產生序列中的下一個字母。透過使用範例單字訓練我們的程序,

流量工程將程式碼產生的準確率提高一倍:由19%提高至44%

Feb 05, 2024 am 09:15 AM

流量工程將程式碼產生的準確率提高一倍:由19%提高至44%

Feb 05, 2024 am 09:15 AM

一篇新論文的作者提出了一種「強化」代碼生成的方法。程式碼生成是人工智慧中一項日益重要的能力。它透過訓練機器學習模型,根據自然語言描述自動產生電腦程式碼。這項技術具有廣泛的應用前景,可以將軟體規格轉化為可用的程式碼,自動化後端開發,並協助人類程式設計師提高工作效率。然而,產生高品質程式碼對AI系統仍然具有挑戰性,與翻譯或總結等語言任務相比。程式碼必須準確地符合目標程式語言的語法,能夠優雅地處理各種極端情況和意外輸入,並精確地處理問題描述中的許多小細節。即使是其他領域看似無害的小錯誤也可能完全破壞程式的功能,導

整合GPT-4的Cursor讓編寫程式碼和聊天一樣簡單,用自然語言編寫程式碼的新時代已來

Apr 04, 2023 pm 12:15 PM

整合GPT-4的Cursor讓編寫程式碼和聊天一樣簡單,用自然語言編寫程式碼的新時代已來

Apr 04, 2023 pm 12:15 PM

整合GPT-4的Github Copilot X還在小範圍內測中,而整合GPT-4的Cursor已公開發行。 Cursor是一個整合GPT-4的IDE,可以用自然語言寫程式碼,讓寫程式碼和聊天一樣簡單。 GPT-4和GPT-3.5在處理和編寫程式碼的能力上差異還是很大的。官網的一份測試報告。前兩個是GPT-4,一個採用文字輸入,一個採用影像輸入;第三個是GPT3.5,可以看出GPT-4的程式碼能力相較於GPT-3.5有較大能力的提升。整合GPT-4的Github Copilot X還在小範圍內測中,而

價值、隱私保護全覆蓋 網信辦擬為生成式AI'立規矩”

Apr 13, 2023 pm 03:34 PM

價值、隱私保護全覆蓋 網信辦擬為生成式AI'立規矩”

Apr 13, 2023 pm 03:34 PM

4月11日,國家網路資訊辦公室(以下簡稱「網信辦」)起草發布了《生成式人工智慧服務管理辦法(徵求意見稿)》,並向社會大眾展開為期一個月的意見徵求。這份管理辦法(徵求意見稿)共21條,從適用範圍看,既包括了提供生成式人工智慧服務的主體,也包括使用這些服務的組織和個人;管理辦法覆蓋了生成式人工智慧輸出內容的價值導向、服務提供者的訓練原則、隱私權/智慧財產權等各項權利的保護等等。 GPT類生成式自然語言大模型及產品出現後,既讓大眾體驗到了人工智慧的飛躍式進步,也暴露出安全風險,包括產生帶偏見和歧視性的

一定要「分詞」嗎? Andrej Karpathy:是時候拋棄這個歷史包袱了

May 20, 2023 pm 12:52 PM

一定要「分詞」嗎? Andrej Karpathy:是時候拋棄這個歷史包袱了

May 20, 2023 pm 12:52 PM

ChatGPT等對話AI的出現讓人們習慣了這樣一件事情:輸入一段文字、程式碼或一張圖片,對話機器人就能給出你想要的答案。但在這種簡單的互動方式背後,AI模型要進行非常複雜的資料處理與運算,tokenization就是比較常見的一種。在自然語言處理領域,tokenization指的是將文字輸入分割成更小的單元,稱為「token」。這些token可以是字、子字或字符,取決於特定的分詞策略和任務需求。例如,如果對句子「我喜歡吃蘋果」執行tokenization操作,我們將得到一串token序列:[&qu

多國擬發ChatGPT禁令 關「野獸」的籠子要來了?

Apr 10, 2023 pm 02:40 PM

多國擬發ChatGPT禁令 關「野獸」的籠子要來了?

Apr 10, 2023 pm 02:40 PM

「人工智慧想越獄『、』AI產生自我意識」、「AI終將殺死人類」、「矽基生命的進化」.......曾經只在賽博朋克等科技幻想中出現的劇情,在今年走向現實,生成式自然語言模式正遭受前所未有的質疑。聚光燈下最矚目的那個是ChatGPT,3月底到4月初,OpenAI開發的這個文字對話機器人,突然從「先進生產力」的代表變成了人類的威脅。先是被上千位科技圈的精英們點名,放在「暫停訓練比GPT-4更強大的AI系統」的公開信中;緊接著,美國科技倫理組織又要求美國聯邦貿易委員會調查OpenAI,禁止發布商業版