真·重磅研究! 32篇論文硬碟點2022年度AI熱點

雖然世界仍在復甦,但研究並沒有放慢其狂熱的步伐,尤其是在人工智慧領域。

此外,今年人們對AI倫理、偏見、治理和透明度都有了新的重視。

人工智慧和我們對人腦的理解及其與人工智慧的連結正在不斷發展,在不久的將來,這些改善我們生活品質的應用將大放異彩。

知名部落客Louis Bouchard也在自己的部落格盤點了2022年32項(!)AI科技突破。

接下來讓我們一起看看,這些令人驚豔的研究有哪些吧!

文章網址:https://www.louisbouchard.ai/2022-ai-recap/

#LaMA:基於傅立葉卷積的分辨率穩健的大型掩碼修復

#你肯定經歷過這種情況:你和你的朋友拍了一張很棒的照片。結果,你發現有人在你身後,毀了你要發到朋友圈或小紅書的照片。但現在,這不再是問題。

基於傅立葉卷積的解析度穩健的大型遮罩修復方法,可以讓使用者輕鬆清除影像中不需要的內容。不論是人,還是垃圾桶都能輕鬆消失。

它就像是你口袋裡的專業ps設計師,只要輕輕一按,就能輕鬆清除。

雖然看似簡單,但影像修復是許多AI研究人員長期以來一直需要解決的問題。

論文連結:https://arxiv.org/abs/2109.07161

專案網址:https://github.com/saic-mdal/lama

#Colab Demo:https://colab.research .google.com/github/saic-mdal/lama/blob/master/colab/LaMa_inpainting.ipynb

##影片解說:https://youtu.be /Ia79AvGzveQ

短篇分析:https://www.louisbouchard.ai/lama/

#STIT:基於GAN的真實影片人臉編輯你肯定有過這樣的經歷:在看電影時,會發現電影中的演員看起來要比本人年輕得多。

《雙子殺手》中的威爾史密斯

之前,這需要專業人員花費數百甚至數千小時的工作,手動編輯這些演員出現的場景。但利用AI,你可以在幾分鐘內完成。

事實上,許多技術可以讓你增加笑容,讓你看起來更年輕或更老,所有這些都是使用基於人工智慧的演算法自動完成的。它在影片中被稱為基於AI的臉部操作(AI-based face manipulations),代表了2022年的最新技術水平。

論文連結:https://arxiv.org/abs/2201.08361

專案地址:https://github.com/rotemtzaban/STIT#

影片解說:https://youtu.be/mqItu9XoUgk

短篇分析:https://www.louisbouchard.ai/stitch-it-in-time/

#NeROIC:利用線上圖庫的神經渲染

##神經渲染可以透過物件、人物或場景的圖片,在空間中產生逼真的3D模型。

有了這項技術,你只需擁有某物體的幾張圖片,就可以請機器了解這些圖片中的物體,並模擬出它在空間中的樣子。

透過圖像來理解物體的物理形狀,這對人類來說很容易,因為我們了解真實的世界。但對於只能看到像素的機器來說,這是一個完全不同的挑戰。

產生的模型如何融入新場景?如果照片的光線條件和角度不同,產生的模型也會因此而變化,該怎麼辦?這些都是Snapchat和南加州大學在這項新研究中需要解決的問題。

論文連結:https://arxiv.org/abs/2201.02533

計畫網址: https://github.com/snap-research/NeROIC

#影片解說:https://youtu.be /88Pl9zD1Z78

#短篇分析:https://www.louisbouchard.ai/neroic/

#SpeechPainter:文本條件下的語音修復對於影像來說,基於機器學習的修復技術不僅可以移除其中的內容,還能根據背景資訊填滿影像的缺失部分。

對於視訊修復來說,其挑戰在於不僅要保持幀與幀之間的一致性,而且要避免產生錯誤的偽影。同時,當你成功地將一個人從影片中「踢出去」之後,還需要把他/她的聲音也一併刪除才行。

為此,Google的研究人員提出了一種全新的語音修復方法,可以修正影片中的語法、發音,甚至消除背景噪音。

論文連結:https://arxiv.org/abs/2202.07273

## 影片解說: https://youtu.be/zIIc4bRf5Hg

#短篇分析:https://www.louisbouchard.ai/speech-inpainting-with-ai/GFP-GAN:利用生成性臉部先驗,實現真實世界的盲臉修復

你是否有一些珍藏的舊照片,因為年代久遠而畫質模糊?別擔心,有了盲臉修復技術(Blind Face Restoration),你的回憶會被歷久彌新。這個全新且免費的AI模型可以在一瞬間修復你的大部分舊照片。即使修復前的照片畫質非常低,它也能很好地工作。這在之前通常是一個相當大的挑戰。

更酷的是,你可以用自己喜歡的方式來嘗試。他們已經開源了程式碼,創建了一個演示和線上應用程式供大家試用。相信這項技術一定會讓你大吃一驚!

論文連結:https://arxiv.org/abs/2101.04061

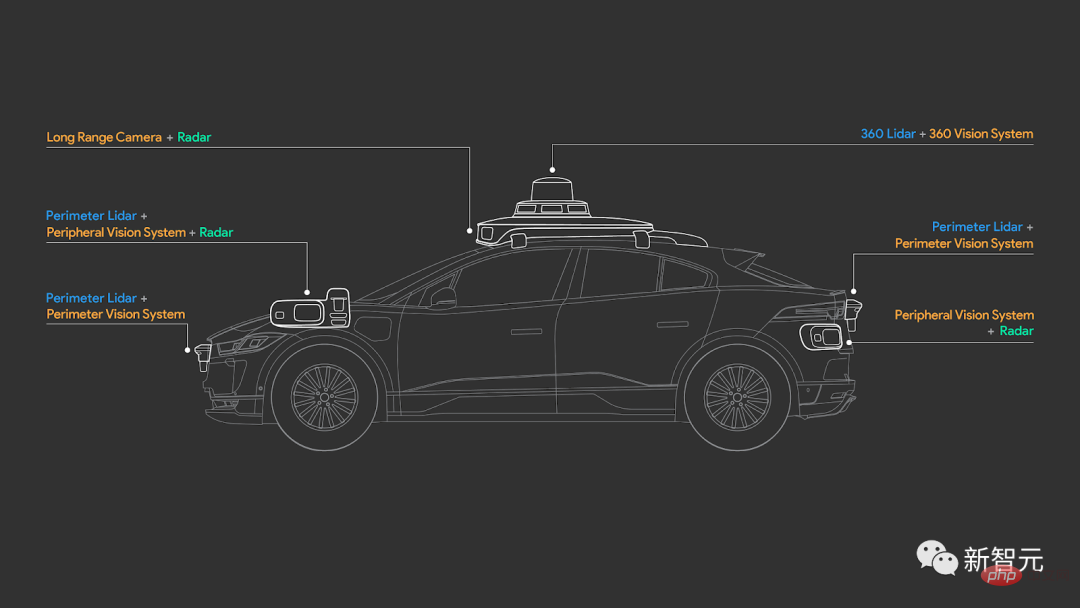

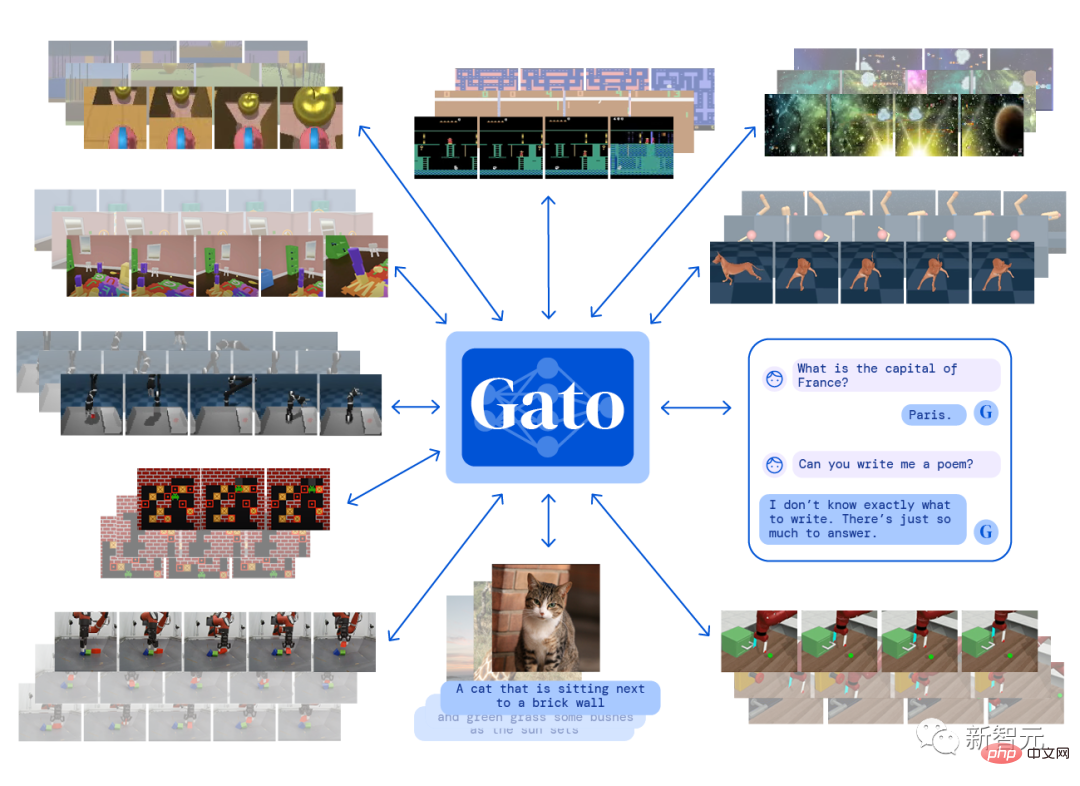

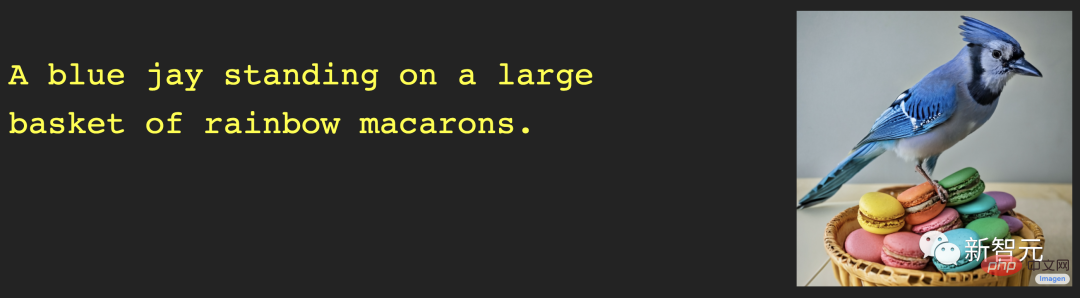

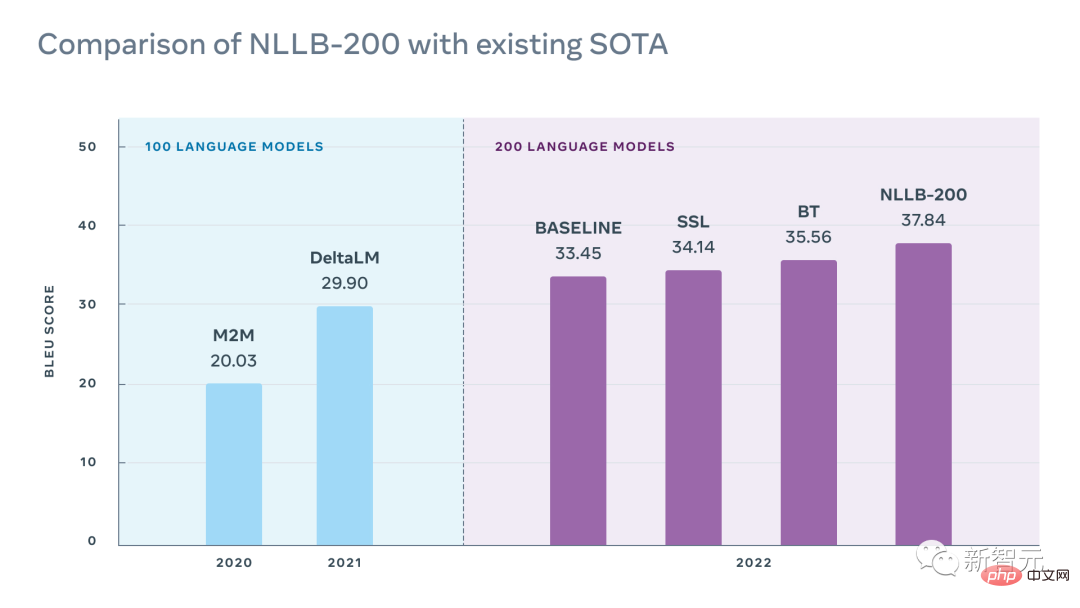

專案地址:https://github.com/TencentARC/GFPGAN# Colab Demo:https://colab.research.google.com/drive/1sVsoBd9AjckIXThgtZhGrHRfFI6UUYOo #線上應用:https //huggingface.co/spaces/akhaliq/GFPGAN #影片解說:https://youtu.be/nLDVtzcSeqM #短篇分析:https://www.louisbouchard.ai/gfp-gan/ 4D-Net:多模態對齊的學習 你可能聽過車企正在使用的LiDAR感光元件或其他奇怪的相機。但它們是如何運作的,它們如何觀察這個世界,以及它們與我們相比究竟看到了什麼不同? 論文連結:https://arxiv.org/abs/2109.01066 與特斯拉只使用攝影機來了解世界不同,大多數自動駕駛汽車廠商,例如Waymo,使用的是普通攝影機和3D LiDAR感測器。 它們不會像普通相機那樣產生影像,而是產生3D點雲,利用RGB感測訊息,測量物體之間的距離,計算它們投射到物體的脈衝激光的傳播時間。 儘管如此,我們如何有效地結合這些資訊並讓車輛理解它?車輛最終會看到什麼?自動駕駛是否夠安全? Waymo和Google的一篇新研究論文將會解答這些謎題。 影片解說:https://youtu.be/0nJMnw1Ldks 短篇分析:https: //www.louisbouchard.ai/waymo-lidar/ Instant NeRF:基於多解析度雜湊編碼的即時神經圖元 ##如何通過照片模擬世界的樣子? 使用AI模型,人們可以將拍攝的影像變成高品質的3D模型。這項具有挑戰性的任務,讓研究人員透過2D影像,創造物體或人在三維世界中的樣子。 透過基於哈希編碼的神經圖元(graphical primitives),英偉達實現5秒訓練NeRF,並獲得了更好的效果。在不到兩年的研究中,將NeRF的訓練速度提高了1000多倍。 論文連結:https://arxiv.org/abs/2201.05989 專案地址:https://github.com/NVlabs/instant-ngp 視頻解說:https://youtu.be/UHQZBQOVAIU 短篇分析:https://www.louisbouchard.ai/nvidia-photos-into-3d- scenes/ 去年,OpenAI發布了文字-圖像生成模型DALL·E。現在,升級版DALL·E 2又來了。 DALL·E 2不僅可以從文字產生逼真的圖像,其輸出的解析度是前者的四倍! 不過,效能方面的提升似乎不足以令OpenAI滿足,為此他們也讓DALL·E 2學會了一項新技能:影像修復。 也就是說,你可以用DALL·E 2編輯圖像,或添加任何想要的新元素,例如在背景中加上一隻紅鶴。 論文連結:https://arxiv.org/abs/2204.06125 影片解說:https://youtu.be/rdGVbPI42sA 短篇分析:https://www.louisbouchard.ai/openais -new-model-dall-e-2-is-amazing/ MyStyle:個人化生成先驗 Google和特拉維夫大學提出了一個非常強大的DeepFake技術。擁有了它,你幾乎無所不能。 只需給一個人拍上百張照片,就可以對其圖像進行編碼,並修復、編輯或創建任何想要的樣子。 這既令人驚訝又令人恐懼,尤其是當你看到產生的結果時。 論文連結:https://arxiv.org/abs/2203.17272 專案網址:https://mystyle-personalized-prior.github.io/ 影片解說:https://youtu. be/BNWAEvFfFvQ 短篇分析:https://www.louisbouchard.ai/mystyle/ #OPT:開放預訓練的Transformer語言模型 GPT-3如此強大的原因,在於其架構和大小。 它有1750億個參數,是人類大腦中神經元數量的兩倍!如此巨大的神經網路使模型幾乎學習了整個網路的內容,了解我們如何書寫、交換和理解文字。 就在人們驚嘆於GPT-3的強大功能時,Meta向開源社群邁出了一大步。他們發布了一個同樣強大的模型,並且,該模型已經完全開源了! 該模型不僅也有超過千億級別的參數,並且,與GPT-3相比,OPT-175B更加開放及便於訪問。 論文連結:https://arxiv.org/abs/2205.01068 專案網址:https://github.com/facebookresearch/metaseq 影片連結: https://youtu.be/Ejg0OunCi9U #短篇分析:https://www.louisbouchard.ai/opt-meta/ BlobGAN:空間離散的場景表徵 對於如何描述一個場景,Adobe研究團隊給了一個新的方法:BlobGAN。 BlobGAN使用「斑點」(blob)來描述場景中的物件。研究人員可以移動這些斑點,將它們變大、變小,甚至可以刪除,這對影像中斑點所代表的物體都會產生相同的效果。 正如作者在他們的結果中分享的那樣,你可以透過複製斑點,在資料集中創建新的圖像。 現在,BlobGAN的程式碼已經開源,有興趣的小夥伴,抓緊快上手試試吧! 論文連結:https://arxiv.org/abs/2205.02837 專案網址:https://github.com/dave-epstein/blobgan #Colab Demo:https://colab.research.google.com/drive /1clvh28Yds5CvKsYYENGLS3iIIrlZK4xO?usp=sharing#scrollTo=0QuVIyVplOKu #4影片解說:https://youtu #短篇分析:https://www.louisbouchard.ai/blobgan/ DeepMind建構了一個單一的「通用」智能體Gato。可以玩 Atari 遊戲、做字幕圖片、與人聊天、還能控制機械手臂! 更令人震驚的是,它只訓練一次並使用相同的權重,便能完成所有任務。 Gato是一個多模態智能體。這意味著它既可以為圖像創建標題,也能作為聊天機器人回答問題。 雖然GPT-3也能陪你聊天,但很明顯,Gato可以做到更多。畢竟,能聊天的AI常有,能陪玩遊戲的不常有。 論文連結:https://arxiv.org/abs/2205.06175 影片解說:https://youtu.be/xZKSWNv6Esc 短篇分析:https: //www.louisbouchard.ai/deepmind-gato/ ##如果你認為DALL ·E 2很優秀,那麼不妨看看這個來自Google Brain的新模型——Imagen——可以做些什麼。 DALL·E很神奇,但生成的影像往往缺乏真實感,這就是Google團隊研發的Imagen所要解決的問題。 根據比較文字到圖像模型的基準,Imagen在大型語言模型的文字嵌入對文字-圖像的合成方面成效顯著。生成的影像既天馬行空,又真實可信。 論文連結:https://arxiv.org/abs/2205.11487 專案網址:https://imagen.research.google/ 影片解說:https ://youtu.be/qhtYPhPWCsI #短篇分析:https://www.louisbouchard.ai/google-brain-imagen/ 一組小札的驚悚圖曾在Twitter上風靡一陣。這組San值狂掉的作品,出自DALL·E mini之手。 作為DALL·E家族的「青春版」,DALL·E mini是勝在免費開源。代碼已留,下一個被魔改的人物又會是誰呢? 計畫網址:https://github.com/borisdayma/dalle-mini ##線上體驗:https:// huggingface.co/spaces/dalle-mini/dalle-mini #影片解說:https://youtu.be/K3bZXXjW788 #短篇分析:https://www.louisbouchard.ai/dalle-mini/ Meta AI發表的這款NLLB-200模型,模型命名概念來自「不落下任何一種語言」(No Language Left Behind),在200多種語言上實現了任意互譯。 研究的亮點在於:研究者讓大多數低資源語言訓練提升多個數量級,同時實現了200 語言翻譯的SOTA結果。 論文連結:https://research.facebook.com/publications/no-language-left-behind/ 專案網址:https://github.com/facebookresearch/fairseq/tree/nllb # #線上體驗:https://nllb.metademolab.com/ #影片解說:https://youtu. be/2G4NeG17Eis 短篇分析:https://www.louisbouchard.ai/no-language-left-behind/ #Dual-Shutter光學振動感測系統 聲音也能被看見? 因此可實現樂器的分離、噪音的消除等各種需求。

論文連結:https://openaccess.thecvf.com/content/CVPR2022/papers/Sheinin_Dual-Shutter_Optical_Vibration_Sensing_CVPR_2022_paper.pdf #專案位址:https://imaging.cs.cmu.edu/vibration/ 影片解說:https://youtu.be/n1M8ZVspJcs 短篇分析:https://www.louisbouchard .ai/cvpr-2022-best-paper/Make-A-Scene:基於場景且有人類先驗的文字到圖像生成 雖然DALL·E可以根據文字提示產生隨機圖像,這確實很酷,但同時也限制了用戶對生成結果的控制。 而Meta的目標是推動創意表達,將這種文本到圖像的趨勢與先前的草圖到圖像模型相結合,從而產生“Make-A-Scene”:文本和草圖條件影像生成之間的奇妙融合。

論文連結:https://arxiv.org/abs/2203.13131 影片解說:https://youtu.be/K3bZXXjW788 短篇分析:https://www.louisbouchard. ai/make-a-scene/ BANMo:從任意影片中建立目標3D動畫模型 基於Meta的這項研究,你只需給定捕獲可變形對象的任意視頻,例如上傳幾個小貓小狗的視頻,BANMo便可通過將來自數千張圖像的2D線索整合到規範空間中,進而重建一個可編輯的動畫3D模型,且無需預定義形狀模板。 論文連結:https://arxiv.org/abs/2112.12761 專案網址:https://github.com/facebookresearch/banmo #影片解說: https://youtu.be/jDTy-liFoCQ #短篇分析:https://www.louisbouchard.ai/banmo/ #以潛在擴散模型進行高解析度影像合成 今年大火的影像生成模型DALL·E、Imagen以及強勢出圈的Stable Diffusion,這些強大的影像生成模型有什麼共同點?除了高運算成本、大量訓練時間之外,它們都基於相同的擴散機制。 擴散模型最近在大多數圖像任務中取得了SOTA結果,包括使用DALL·E的文字到圖像,還有許多其他與圖像生成相關的任務,如圖像修復、風格轉換或影像超解析度。 論文連結:https://arxiv.org/abs/2112.10752 專案網址:https://github.com/CompVis/latent-diffusion #影片解說:https://youtu.be /RGBNdD3Wn-g 短篇分析:https://www.louisbouchard.ai/latent-diffusion-models/ #PSG:基於場景的圖像生成模型 AI可以幫助你準確地識別圖像中的物體,但是理解物體與環境之間的關係則沒有那麼輕鬆。 為此,來自南洋理工對研究人員提出了一種基於全景分割的全場景圖生成(panoptic scene graph generation,即PSG)任務。 相較於傳統基於偵測框的場景圖生成,PSG任務要求全面地輸出影像中的所有關係(包括物件與物件間關係,物件與背景間關係,背景與背景間關係),並以準確的分割塊來定位物體。 論文連結:https://arxiv.org/abs/2207.11247 專案網址:https://psgdataset.org/ #線上應用程式:https://huggingface.co/spaces/ECCV2022/ PSG

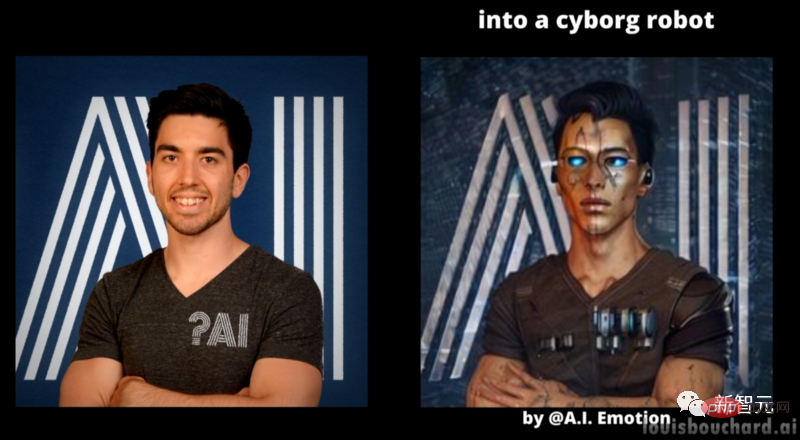

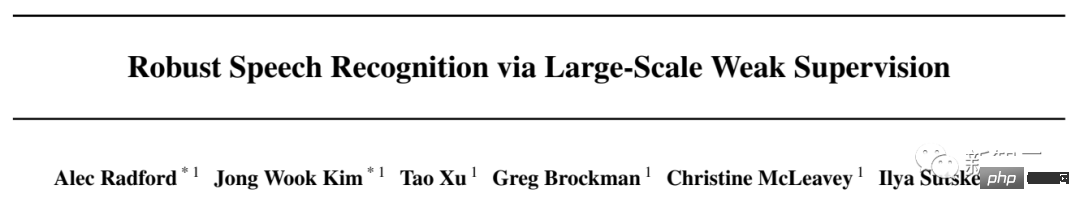

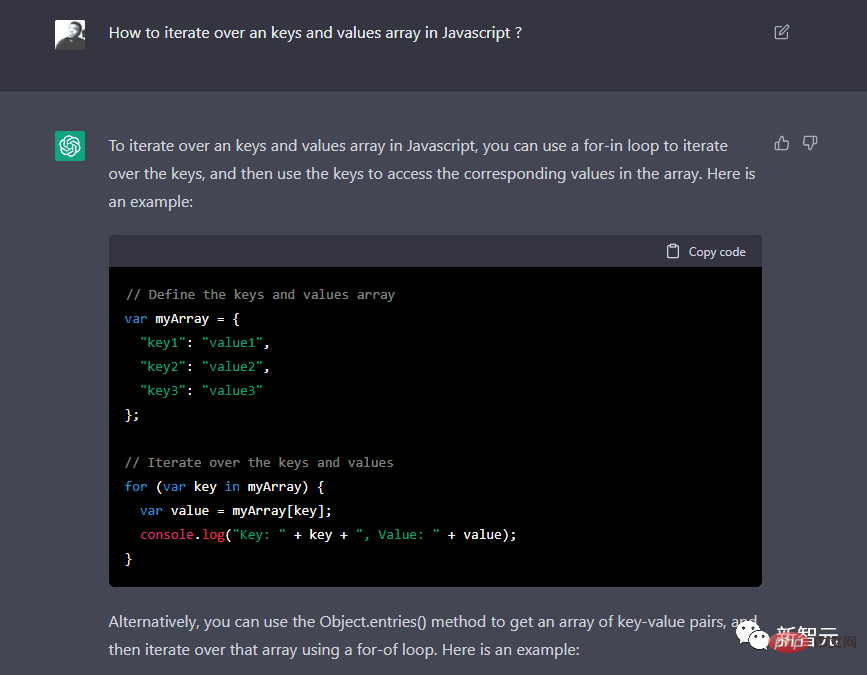

############################################# ########短篇分析:https://www.louisbouchard.ai/psg/############利用文字反轉實現文字到影像的個人化產生### 今年各大廠的影像生成模型可謂是八仙過海各顯神通,但是如何讓模型生成特定風格的影像作品呢? 來自特拉維夫大學的學者和英偉達合作推出了一個個人化圖像生成模型,可以DIY你想要得到的圖像。 論文連結:https://arxiv.org/abs/2208.01618 專案網址:https://textual-inversion.github.io/ 影片解說:https://youtu.be/f3oXa7_SYek #短篇分析:https://www.louisbouchard.ai/imageworthoneword/ #用於通用視訊識別的語言圖像預訓練模型 視覺文字模型的學習毫無疑問已經取得了巨大成功,然而如何將這種新的語言圖像預訓練方法擴展到視訊領域仍然是一個懸而未決的問題。 來自微軟和中科院的學者提出了一種簡單而有效的方法使預先訓練的語言圖像模型直接適應視頻識別,而不是從頭開始預訓練新模型。 論文連結:https://arxiv.org/abs/2208.02816 計畫網址: https://github.com/microsoft/VideoX/tree/master/X-CLIP #影片解說:https://youtu.be/seb4lmVPEe8 短篇分析:https://www.louisbouchard.ai/general-video-recognition/ Make- A-Video:一鍵文字生成影片模型 畫家在畫布上盡情作畫,如此清晰流暢的畫面,你能想到影片的每一幀都是AI生成的嗎? MetaAI推出的Make-A-Video,只需簡單輸入幾個文字,便可在幾秒內生成不同風格的視頻,說成“視頻版DALL·E”也不為過。 論文連結:https://arxiv.org/abs/2209.14792 影片解說:https://youtu.be/MWwESVyHWto 短篇分析:https: //www.louisbouchard.ai/make-a-video/ #Whisper:大規模弱監督語音辨識模型 你有沒有想過有一個翻譯軟體可以快速翻譯影片中的語音,甚至是那些你自己都聽不懂的語言? OpenAI開源的Whisper剛好就能做到這一點。 Whisper在超過68萬小時的多語種資料上訓練,能辨識吵雜背景下的多語種聲音並轉化為文字,此外還可勝任專業術語的翻譯。 論文連結:https://arxiv.org/abs/2212.04356 專案網址:https://github.com/openai/whisper 影片解說:https://youtu.be/uFOkMme19Zs ##短篇解析:https://www.louisbouchard.ai/whisper/ 文字能生成圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生圖像、視頻,還能產生影像有3D模型~ Google推出的DreamFusion透過使用預訓練的2D文字到影像擴散模型可一鍵產生3D模型,在數十億圖像文字對上訓練的擴散模型推動了文本到3D模型合成的最新突破。 論文連結:https://arxiv.org/abs/2209.14988 影片解說:https://youtu.be/epuU0VRIcjE 短篇解析:https: //www.louisbouchard.ai/dreamfusion/ 使用DALL·E等文字圖像生成模型,只要輸入一行文字就能得到想要的圖片,但AI產生的影像有時候就沒那麼完美。 來自Google、以色列理工學院、魏茨曼科學研究所的研究者介紹了一種基於擴散模型的真實影像編輯方法—Imagic,只用文字就能實現真實照片的PS。 例如,我們可以改變一個人的姿勢和構圖同時保留其原始特徵,或者我想讓一隻站立的狗坐下,讓一隻鳥展開翅膀。 論文連結:https://arxiv.org/abs/2210.09276 專案網址:https://imagic-editing.github.io/ #影片解說:https://youtu.be/ gbpPQ5kVJhM 短篇分析:https://www.louisbouchard.ai/imagic/ 比DALL·E和Stable Diffusion更強的圖像合成模型來了! 這就是英偉達的eDiffi,它可以更準確地產生更高品質的圖像,此外加入畫筆模具,可以為你的作品增加更多創意和靈活性。 論文連結:https://arxiv.org/abs/2211.01324 專案網址:https://deepimagination.cc/eDiff-I/ 影片解說:https://youtu.be/grwp-ht_ixo #短篇分析:https://www.louisbouchard.ai/ediffi/ 你有沒有想過,隨手拍一張照片然後就像打開一扇門一樣飛進圖片裡呢? 來自Google和康乃爾大學的學者將這一想像變成現實,這就是InfiniteNature-Zero,他可從單幅圖像中產生無限制的自然場景視圖。 論文連結:https://arxiv.org/abs/2207.11148 專案網址:https://infinite-nature.github.io/ 影片解說:https://youtu.be/FQzGhukV-l0 #短篇分析:https://www.louisbouchard.ai/infinitenature-zero Galactica:用於科學的大語言模型 Meta開發的Galactica是一種大型語言模型,其大小與GPT-3 相當,但它擅長的領域是科學知識。 該模型可編寫政府白皮書、新聞評論、維基百科頁面和程式碼,它還知道如何引用以及如何編寫方程式。這對人工智慧和科學來說是一件大事。 論文連結:https://arxiv.org/abs/2211.09085 影片解說:https://youtu.be/2GfxkCWWzLU 短篇分析:https: //www.louisbouchard.ai/galactica/ RAD-NeRF:基於音訊空間分解的即時人像合成模型 自從DeepFake和NeRF的出現,AI換臉似乎已經是司空見慣了,但有個問題,AI換的臉有時會因為對不上嘴型而露餡。 RAD-NeRF的出現可以解決這個問題,它可以對影片中所出現的說話者進行即時的人像合成,此外還支援自訂頭像。 論文連結:https://arxiv.org/abs/2211.12368 專案網址:https://me.kiui.moe/radnerf/ #影片解說:https://youtu.be/ JUqnLN6Q4B0 短篇分析:https://www.louisbouchard.ai/rad-nerf/ #ChatGPT:為對話優化的語言模型 2022年度AI的重磅作品怎麼能少了ChatGPT,這個已經火遍全網並已經被網友開發出寫小黃文、敲代碼等各種應用的萬能模型,如果你還不了解它,那就快來看看! #影片解說:https://youtu.be/AsFgn8vU-tQ 短篇分析:https://www.louisbouchard.ai/chatgpt/ #可直接用於生產使用的視訊人臉re-aging 雖然當下電腦視覺模型可以對人臉的年齡進行生成、風格遷移等,但這也只是看起來酷炫,在實際應用中卻幾乎零作用,現有的技術通常存在著面部特徵遺失、解析度低和在後續視訊畫面中結果不穩定的問題,往往需要人工二次編輯。 最近迪士尼發布了第一個可實用的、完全自動化的、可用於生產使用的視訊影像中re-age人臉的方法FRAN(Face Re-Aging Network) ,正式宣告電影中靠著化妝師改變演員年齡視覺效果的技術落幕。 #論文連結:https://dl.acm.org/doi/pdf/10.1145/3550454.3555520 #專案網址:https://studios.disneyresearch.com/2022/11/30/production-ready-face-re-aging-for-visual-effects/ #影片解說:https://youtu.be/WC03N0NFfwk 短篇分析:https://www.louisbouchard.ai/disney-re-age/自動駕駛汽車如何「眼觀六路」?

DALL·E Mini

以上是真·重磅研究! 32篇論文硬碟點2022年度AI熱點的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

Binance、OKX、gate.io等十大數字貨幣交易所完善系統、高效多元化交易和嚴密安全措施嚴重推崇。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球十大加密貨幣交易平台包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、KuCoin和Poloniex,均提供多種交易方式和強大的安全措施。

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠谱的数字货币交易平台推荐:1. OKX,2. Binance,3. Coinbase,4. Kraken,5. Huobi,6. KuCoin,7. Bitfinex,8. Gemini,9. Bitstamp,10. Poloniex,这些平台均以其安全性、用户体验和多样化的功能著称,适合不同层次的用户进行数字货币交易

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0通過創新架構和性能突破重新定義了加密資產管理。 1) 它解決了資產孤島、收益衰減和安全與便利悖論三大痛點。 2) 通過智能資產樞紐、動態風險管理和收益增強引擎,提升了跨鏈轉賬速度、平均收益率和安全事件響應速度。 3) 為用戶提供資產可視化、策略自動化和治理一體化,實現了用戶價值重構。 4) 通過生態協同和合規化創新,增強了平台的整體效能。 5) 未來將推出智能合約保險池、預測市場集成和AI驅動資產配置,繼續引領行業發展。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣的價格在20,000到30,000美元之間。 1. 比特幣自2009年以來價格波動劇烈,2017年達到近20,000美元,2021年達到近60,000美元。 2. 價格受市場需求、供應量、宏觀經濟環境等因素影響。 3. 通過交易所、移動應用和網站可獲取實時價格。 4. 比特幣價格波動性大,受市場情緒和外部因素驅動。 5. 與傳統金融市場有一定關係,受全球股市、美元強弱等影響。 6. 長期趨勢看漲,但需謹慎評估風險。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

2025年全球十大加密貨幣交易所包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、KuCoin、Bittrex和Poloniex,均以高交易量和安全性著稱。