NeurIPS 2022 會議正如火如荼地進行之中,各路專家學者圍繞著深度學習、電腦視覺、大規模機器學習、學習理論、優化、稀疏理論等眾多細分領域展開交流與探討。

會上,圖靈獎得主、深度學習先驅Geoffrey Hinton 被邀請發表演講,以表彰他十年前與其研究生Alex Krizhevsky 和Ilya Sutskever 共同撰寫的論文《ImageNet Classification with Deep Convolutional Neural Networks》,該論文因對該領域的「巨大影響」而獲得時間檢驗獎。這項工作發表於 2012 年,是卷積神經網路首次在 ImageNet 影像辨識競賽中表現人類水準的能力,它是啟動第三次人工智慧浪潮的關鍵事件。

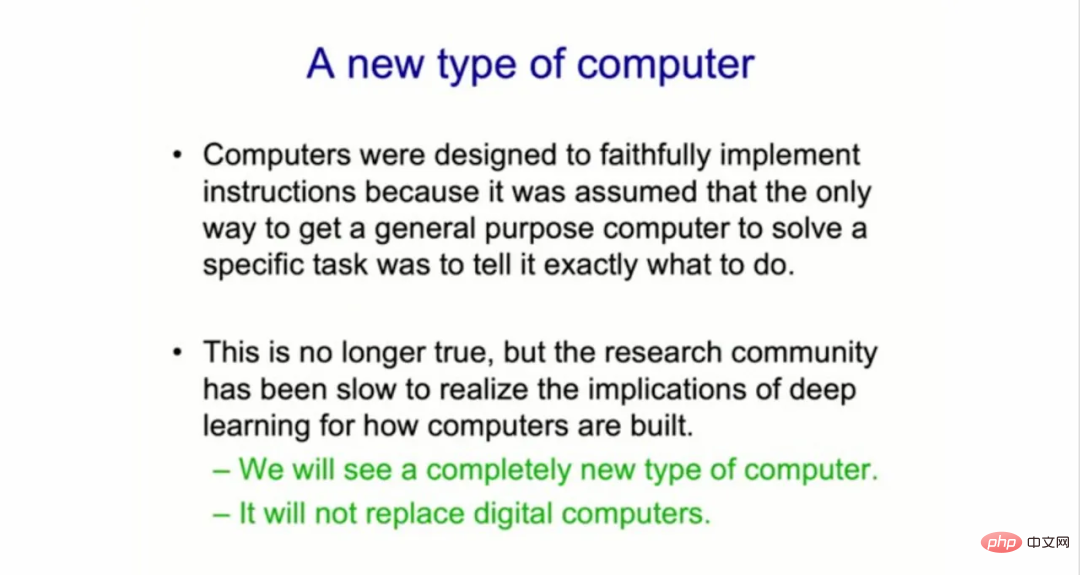

Hinton 演講的主題為《The Forward-Forward Algorithm for Training Deep Neural Networks》。在演講中,Geoffrey Hinton 表示,「機器學習研究社群在意識到深度學習對電腦建構方式的影響上一直表現緩慢。」他認為,人工智慧的機器學習形式將引發電腦系統的變革,這是一種將AI「放入你的烤麵包機」的新型軟硬結合。

他繼續說到,「我認為我們將看到一種完全不同的計算機,雖然幾年內無法實現。但我們有充分的理由來研究這種完全不同的計算機。”

迄今為止,所有的數字計算機都被構建為“不朽” (immortal),其中硬體設計非常可靠,以便相同的軟體可以在任何地方運行。 「我們可以在不同的實體硬體上運行相同的程序,知識是不朽的。」

Hinton 表示,這種設計要求意味著數位電腦已經錯過了「硬體的各種可變、隨機、不穩定、模擬和不可靠特性」,而這些特性可能對我們非常有用。

在Hinton 看來,未來的電腦系統將採取不同的方式:它們將是「神經形態的」,並且是普通的( mortal)。這意味著每台電腦都將是神經網路軟體與雜亂無章硬體的緊密結合,在具有類比而非數位元件的意義上,它可以包含不確定性因素並隨時間推移而發展。

Hinton 解釋到,「現在的替代方案是我們將放棄硬體與軟體的分離,但電腦科學家真的不喜歡這種做法。」

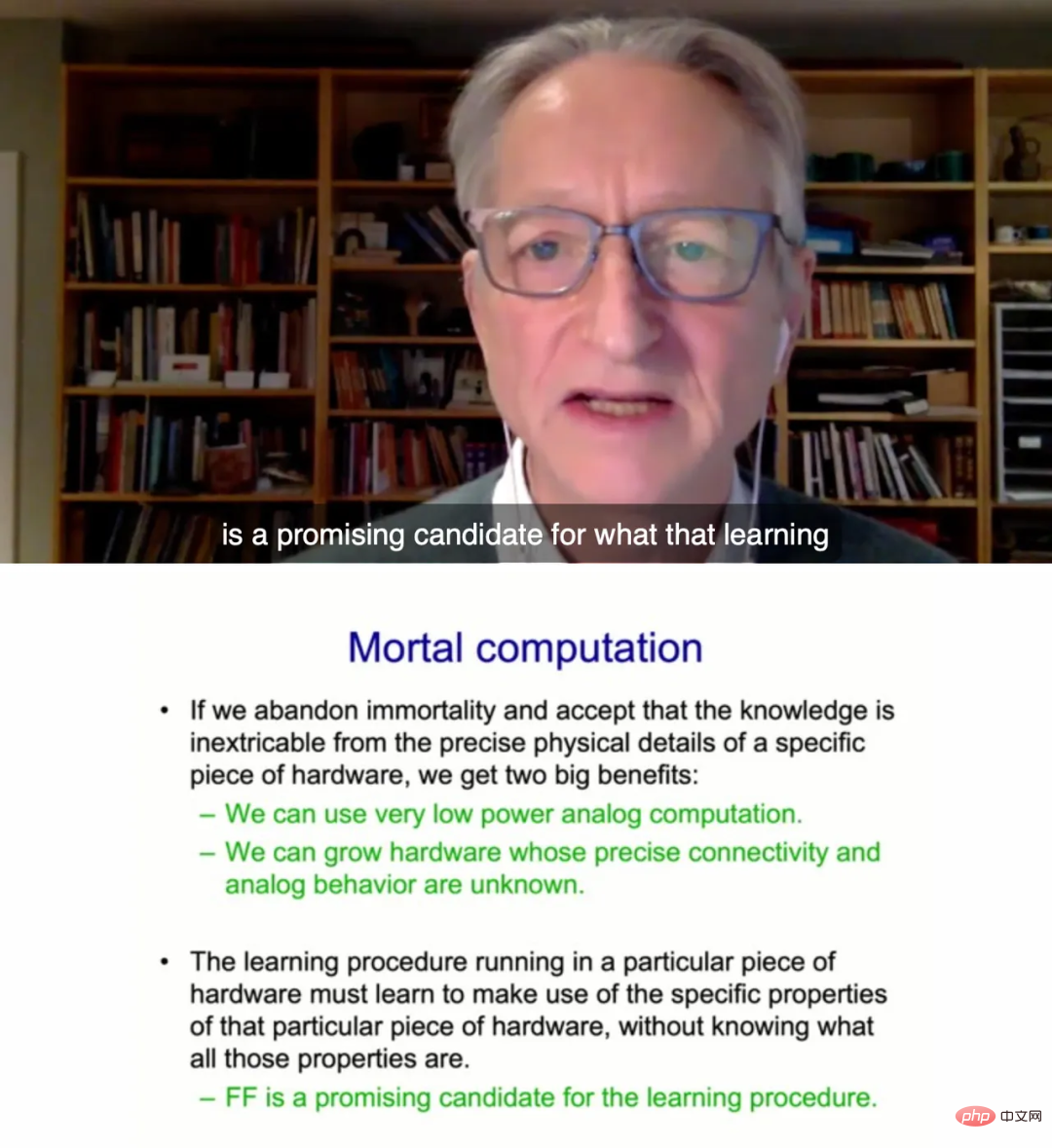

所謂的普通計算(mortal computation),就是系統學習到的知識和硬體是密不可分的。這些普通計算機可以「成長」,擺脫造價高昂的晶片製造廠。

Hinton 指出,如果我們這麼做了,就可以使用功耗極低的類比計算,還能使用憶阻器權重來進行兆次並行處理。這裡指的是一種基於非線性電路元件、數十年歷史的實驗晶片。此外我們也可以在不了解不同位元硬體的精確行為的精準品質時發展硬體。

但是,Hinton 也表示,新的普通計算機並不會取代傳統的數位計算機,「它不是掌控你的銀行帳戶的計算機,也不會確切知道你有多少錢。」

這種計算機用於放置(即處理)其他東西,例如它可以使用一美元將GPT-3 之類的東西「放入你的烤麵包機中」,這樣只需幾瓦的功率,就可以與自己的烤麵包機對話。

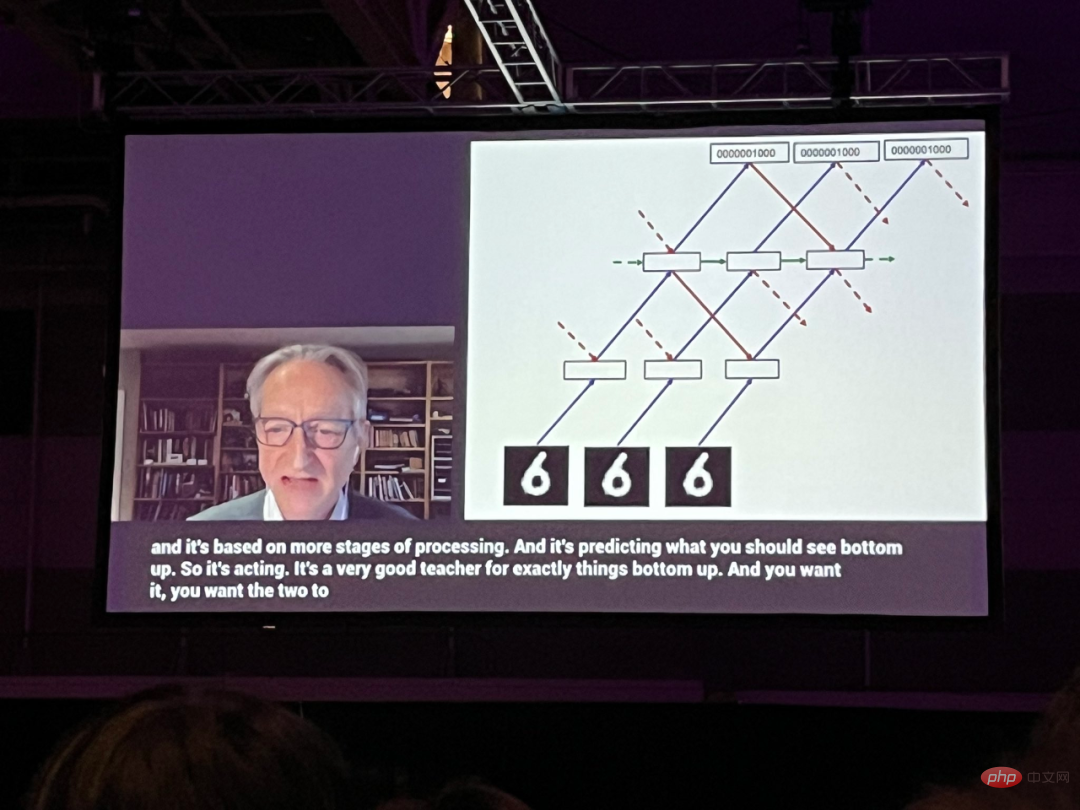

在這次演講中,Hinton 花了大部分時間談論一種新的神經網路方法,他稱之為Forward-Forward(FF)網絡,它取代了幾乎所有神經網路中使用的反向傳播技術。 Hinton 提出,透過去除反向傳播,前向網路可能更合理地接近現實生活中在大腦中發生的情況。

這篇論文草稿被張貼在多倫多大學的Hinton 首頁:

##論文連結:https://www.cs.toronto.edu/~hinton/FFA13.pdf

#Hinton 表示,FF 方法可能更適合普通的計算硬體。 「目前如果要實現這樣的事情,我們必須有一個將在專屬硬體中運行的學習程序,必須要學習利用該專屬硬體的具體屬性,而不知道所有這些屬性是什麼。但我認為前向演算法是一個有潛力的選項。」

他說,建造新的模擬電腦的一個障礙是,人們對在數百萬台設備上運行一個軟體的可靠性很重視。 「這些手機中的每一部都必須從一個嬰兒手機開始取代,而且它必須學習如何成為一部手機,」Hinton 說。 「而這是非常痛苦的。」

即使是最擅長相關技術的工程師,也會因為擔心不確定性,而遲遲不能放棄完美的、相同的不朽計算機的範式。

Hinton 說:「在對模擬計算感興趣的人中,仍有極少數人願意放棄不朽。這是因為對一致性、可預測性的依戀。但如果你希望模擬硬體每次都做同樣的事情,你遲早因為這些雜亂的東西遇到真正的問題。」

論文內容##在論文中, Hinton 介紹了一種新的神經網路學習程序,並透過實驗證明它在一些小問題上的效果足夠好。具體內容如下:反向傳播有什麼問題?

過去十年,深度學習的成功確立了在大量參數和大量資料的情況下執行隨機梯度下降的有效性。梯度通常是透過反向傳播來計算的,這導致人們對大腦是否實現了反向傳播或是否有其他方式來獲得調整連接權重所需的梯度產生了興趣。作為大腦皮質如何學習的模型,反向傳播仍然是不可信的,儘管人們做出了相當大的努力來讓它像真實的神經元一樣實施。目前沒有令人信服的證據表明大腦皮質明確地傳播誤差導數或儲存神經活動,以便在隨後的反向傳播中使用。從一個皮層區域到視覺通路中較早的區域的自上而下的連接並不像預期的那樣,即如果在視覺系統中使用反向傳播,就會出現自下而上的連接。相反,它們形成了循環,其中神經活動經過兩個區域的大約半打皮質層,然後回到它開始的地方。

透過時間的反向傳播作為學習序列的一種方式是特別不可靠的。為了處理感官輸入流而不頻繁超時,大腦需要透過感官處理的不同階段對感官資料進行 pipeline 處理,它需要一個能「在飛行中」學習的學習程序。 Pipeline 後期階段的表徵可能提供自上而下的信息,在後續的時間步中影響 pipeline 早期階段的表徵,但感知系統需要即時地進行推理和學習,而不需要停止執行反向傳播。

反向傳播的另一個嚴重限制是,它需要完全了解在前向傳遞中進行的計算,以便計算出正確的導數。如果我們在前向傳遞中插入一個黑盒子,那麼就不可能再進行反向傳播,除非我們學習了黑盒子的可微分模型。正如我們將看到的,黑盒子根本不會改變 FF 演算法的學習程序,因為不需要透過它進行反向傳播。

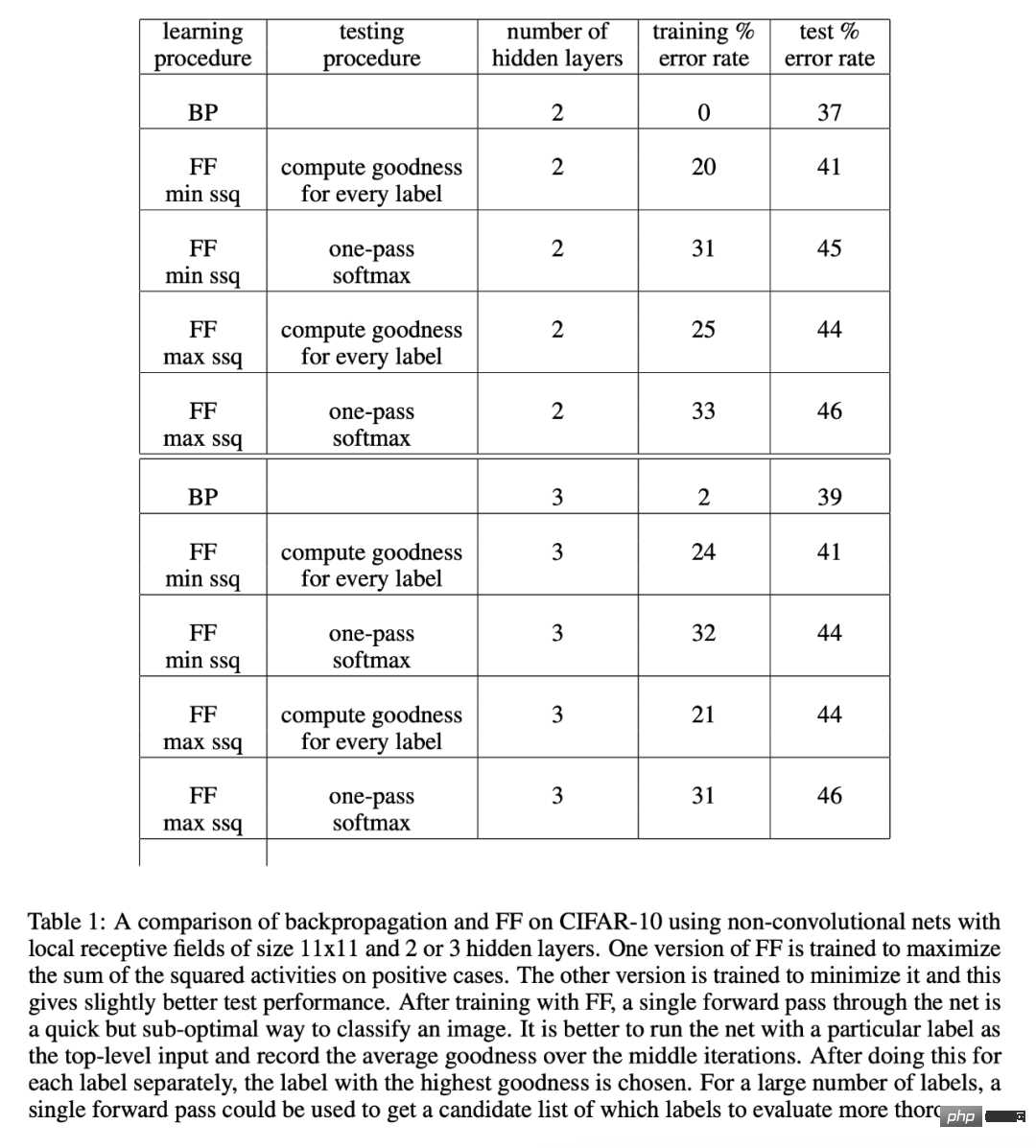

在沒有完美的前向傳遞模式的情況下,或許能求助於許多形式的強化學習之一。這個想法是對權重或神經活動進行隨機擾動,並將這些擾動與收益函數的變化聯繫起來。但強化學習程序存在高變異性:當許多其他變數同時被擾動時,很難看到擾動一個變數的效果。為了平均化所有其他擾動造成的噪音,學習率需要與被擾動的變數數量成反比,這意味著強化學習的規模很差,對於包含數百萬或數十億參數的大型網絡,無法與反向傳播競爭。 這篇論文的主要觀點是,含有未知非線性的神經網路不需要藉助於強化學習。 FF 演算法的速度與反向傳播相當,但它的優點是可以在正向計算的精確細節未知時使用。它的優點還在於可以在透過神經網路對順序資料進行流水作業時進行學習,而不需要儲存神經活動或停止傳播誤差導數。 整體來說,FF 演算法比反向傳播慢一些,而且在本文研究的幾個toy problem 上,它的歸納性也不太理想,所以在功率不在太受限的應用中,它不太可能取代反向傳播。對於在非常大的資料集上訓練的非常大的模型,這類探索將繼續使用反向傳播。 FF 演算法在兩個方面可能優於反向傳播,一是作為大腦皮質的學習模型,二是作為使用非常低功率的模擬硬體而不需要藉助於強化學習。 Forward-Forward 演算法是一種貪婪的多層學習程序,其靈感來自玻爾茲曼機和噪音對比估計。 想法是用兩個前向傳遞取代反向傳播的前向和後向傳遞#,這兩個前向傳遞又以完全相同的方式彼此運算,但在不同的數據上,目標也相反。其中,positive 傳遞在真實資料上運算,並調整權重以增加每個隱藏層的優點(goodness);negative 傳遞在 negative 資料上運算,並調整權重以減少每個隱藏層中的優點。 在論文中,Hinton 透過在 CIFAR-10 上的實驗展示了 FF 演算法的效能。 CIFAR-10 有 50000 幅訓練影像,這些影像為 32 x 32 像素大小,每個像素有三個色彩通道。因此,每張圖像有 3072 個維度。這些圖像的背景很複雜,變化很大,在如此有限的訓練資料下無法很好地建模。一般來說,有兩到三個隱藏層的全連結網路在用反向傳播法訓練時,除非隱藏層非常小,否則過擬合效果很差,所以幾乎所有的報告結果都是卷積網路。 由於FF 的目的是用於權重共享不可行的網絡,所以將它與反向傳播網絡進行了比較,後者使用局部感受野來限制權重的數量,而不過於限制隱藏單元的數量。其目的只是為了表明,在有大量隱藏單元的情況下,對於包含高度可變背景的圖像,FF 的性能與反向傳播相當。 表 1 顯示了用反向傳播和 FF 訓練網路的測試效能,這兩種方法都使用了權重衰減來減少過度擬合。 更多研究細節,可參考原文。 FF 演算法

以上是近萬人圍觀Hinton最新演講:前向-前向神經網路訓練演算法,論文已公開的詳細內容。更多資訊請關注PHP中文網其他相關文章!