自然語言生成 (NLG) 技術的最新進展顯著提高了大型語言模型生成文字的多樣性、控制力和品質。一個值得注意的例子是 OpenAI 的 ChatGPT,它在回答問題、撰寫電子郵件、論文和程式碼等任務中展示了卓越的效能。然而,這種新發現的高效生成文本的能力也引起了人們對檢測和防止大型語言模型在網路釣魚、虛假資訊 和學術造假等任務中濫用的擔憂。例如,由於擔心學生利用 ChatGPT 寫作業,紐約公立學校全面禁止了 ChatGPT 的使用,媒體也對大型語言模式產生的假新聞發出警告。這些對大型語言模式 濫用的擔憂嚴重阻礙了自然語言生成在媒體和教育等重要領域的應用。

最近關於是否可以正確檢測大型語言模型產生的文本以及如何檢測的討論越來越多,這篇文章對現有檢測方法進行了全面的技術介紹。

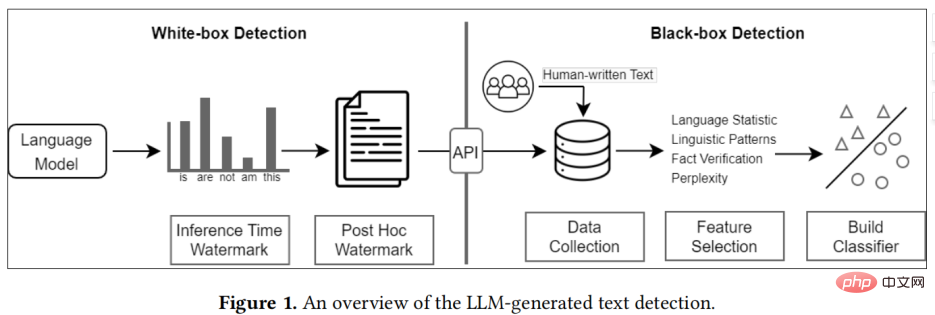

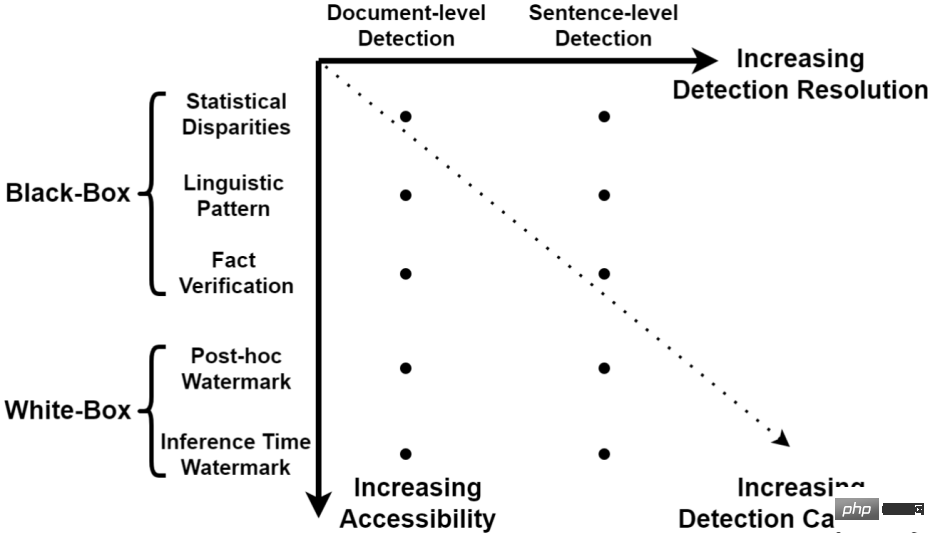

現有的方法大致可分為兩類:黑盒偵測與白盒偵測#。

大語言模型產生文字偵測概述

在實踐中,黑盒偵測器通常由第三方構建,例如 GPTZero,而白盒偵測器通常由大型語言模型開發人員建構。

大型語言模型產生的文字偵測分類學

黑盒偵測一般有三個步驟,分別是資料收集,特徵選擇和模型建立。

對於人類文本的收集,一種方法是招募專業人員進行資料收集,但是這種方法費時費力,不適於大型資料集的收集,更有效率的方法是利用現有的人類文字數據,例如從維基百科收集各種專家編輯的詞條,或是從媒體上收集數據,例如Reddit。

特徵的選取一般分為統計特徵,語言特徵和事實特徵。其中統計特徵一般是用來檢查大型語言模型生成文本是否在一些常用的文本統計指標上於人類文本不同,常用的有 TFIDF、齊夫定律等。語言特徵一般是找一些語言學特徵,例如詞性,依存分析,情緒分析等。最後,大型語言模型常常會產生一些反事實的言論,因此事實驗證也可以提供一些區分大型語言模型生成文本的資訊。

現有的分類模型一般分為傳統的機器學習模型,例如 SVM 等。最新的研究傾向於利用語言模型來做主幹, 例如 BERT,RoBERTa, 並且取得了更高的檢測表現。

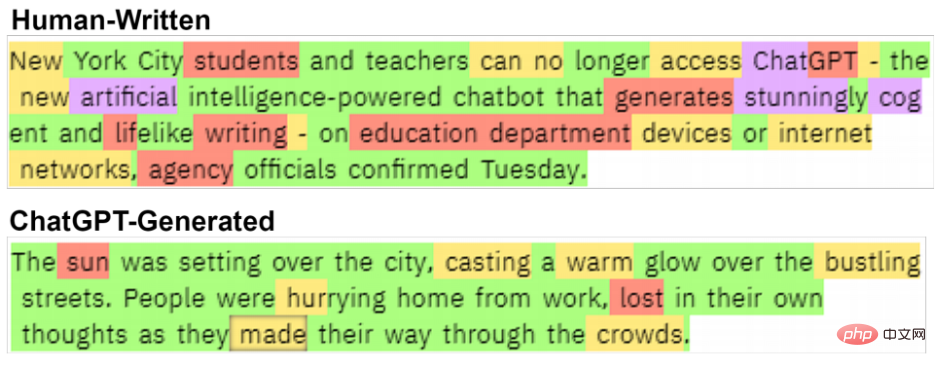

這兩個文字之間有明顯的差異。 human-written 文字來自 Chalkbeat New York。

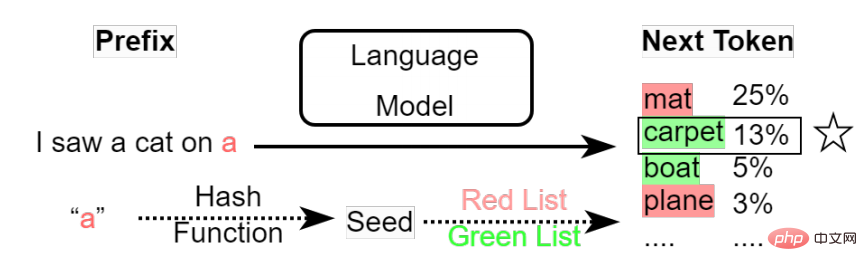

白盒偵測一般預設是大型語言模型開發人員提供的偵測。不同於黑盒檢測,白盒檢測對模型擁有完全訪問權力, 因此能透過改變模型的輸出來植入水印,以此達到檢測的目的。

目前的偵測方法可以分為 post-hoc 浮水印與inference time 浮水印:

#Inference time 水印

(1)對於黑盒模型,資料的收集是非常關鍵的一步,但是這個過程非常容易引入偏見(biases)。例如現有的資料集主要集中在問答,故事產生幾個任務,這就引入了主題的偏見。此外,大模型產生的文字經常會出現固定的風格或格式。這些偏見常常會被黑盒分類器作為分類的主要特徵而降低了檢測的穩健性。

隨著大型語言模型能力的提升,大型語言模型生成的文本和人類的差距會越來越小,導致黑盒模型的檢測準確性越來越低,因此白盒檢測是未來更有前景的檢測方式。

(2)#現有的偵測方法預設大型語言模型是由公司擁有,因而所有的使用者都是透過API 來獲得公司的大型語言模型服務,這種多對一的關係非常有利用偵測系統的部署。但是如果公司開源了大型語言模型,這將導致現有的檢測方法幾乎全部失效。

對於黑盒子偵測,因為使用者可以微調他們的模型,改變模型輸出的風格或格式,從而導致黑盒偵測無法找到通用的偵測特徵。

白盒偵測可能是一個解決辦法,公司在開源模型之前可以為模型中加入一個浮水印。但使用者同樣可以透過微調模型,改變模型 token 的取樣機制來移除浮水印。現在還沒有一種浮水印技術能夠抵禦用戶的這些潛在威脅。

以上是冒充人類作者,ChatGPT等濫用引擔憂,一文綜述AI生成文本檢測方法的詳細內容。更多資訊請關注PHP中文網其他相關文章!