多模態再次統一! Meta發布自監督演算法data2vec 2.0:訓練效率最高提升16倍!

近几年人工智能领域的突破大多由自监督学习推动,比如BERT中提出的MLM (Masked Language Model) ,通过将文本中的部分单词遮盖后重新预测,使得海量无标记文本数据也能用来训练模型,自此开启了大规模预训练模型的新时代。但自监督学习算法也有明显的局限性,通常只适用于单一模态(如图像、文本、语音等)的数据,并且需要大量的算力从海量数据中进行学习。相比之下,人类的学习效率要显著高于当前的AI模型,并且可以从不同类型的数据中进行学习。

2022年1月,Meta AI发布了自监督学习框架data2vec,将三个模态的数据(语音、视觉和文本)通过一个框架整合起来,大有一统多模态的趋势。最近Meta AI发布了data2cec 2.0版本,主要在性能方面对上一代进行了改进:在精度相同的情况下,训练速度相比其他算法最高提升了16倍!

论文链接:https://ai.facebook.com/research/publications/efficient-self-supervised-learning-with-contextualized-target-representations-for-vision-speech-and-language

代码链接:https://github.com/facebookresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

目前来说,大部分机器学习模型仍然是基于有监督学习的模式,需要有专门的标注人员对目标数据打标签,但对于某些任务来说(比如地球上的几千种人类语言),收集标注数据是不可行的。

相比之下,自监督学习不需要告诉模型正确和错误,而是让机器通过观察世界来学习图像、语音和文本的结构。相关的研究成果促进了语音(如,wave2vec 2.0)、计算机视觉(例如,掩码自编码器)和自然语言处理(例如,BERT)等领域的发展。

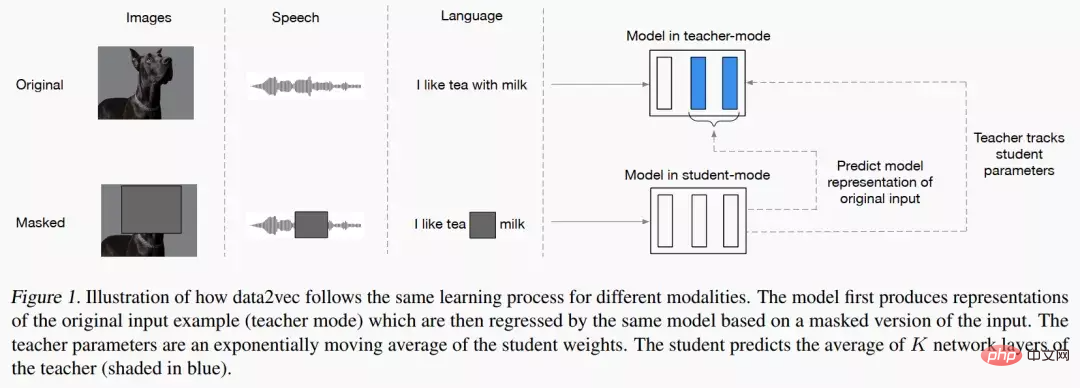

data2vec的主要思路就是先建立一个教师网络,首先计算来自图像、文本或语音的目标表征。然后对数据进行掩码遮盖掉部分输入,并用一个学生网络重复该过程预测教师模型得到的表征。

也就是說,學生模型只能在接受「不完整輸入資訊」的同時預測「完整輸入資料」的表示。為了確保兩個模型的一致性,二者的參數時共享的,但在訓練初期會讓Teacher模型的參數更新更快。 在實驗結果上,data2vec在語音、視覺、文字等任務上比較baseline模型表現提昇明顯。

data2vec 2.0

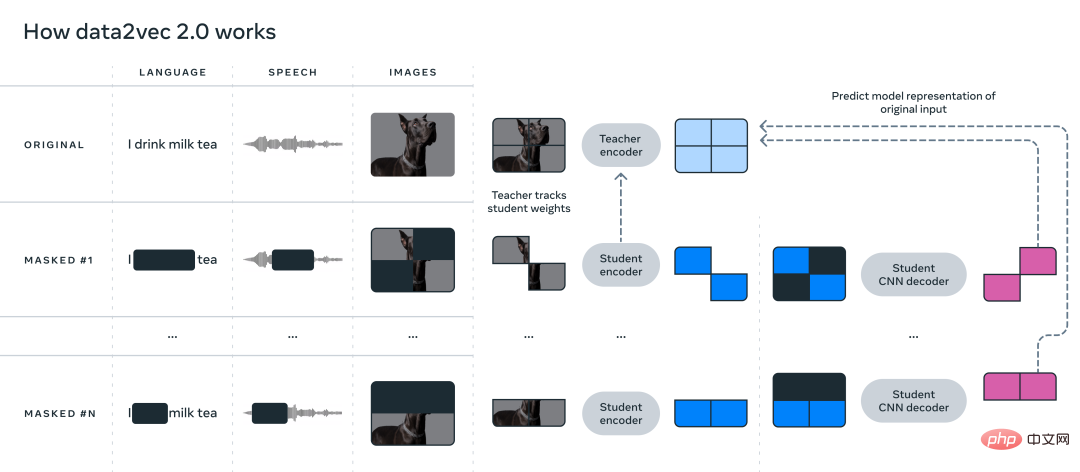

data2vec提出了一個通用的自監督學習框架統一了語音、視覺和語言三個模態資料的學習,而data2vec2.0主要解決的痛點就是建構自監督模型需要大量的GPU做算力支撐才能完成訓練。與最初的 data2vec 演算法類似,data2vec 2.0預測資料的上下文化的表徵(contextualized representations),或是神經網路的層次,而非預測圖像的像素、文本段中的單字或語音。

與常見的其他演算法不同,這些所謂的目標表徵是上下文化的,這意味著演算法需要將整個訓練範例考慮在內。

比如說,模型學習單字bank 的表徵是基於包含bank的整個句子,從而更容易推導出單字的正確意義,例如區分具體指涉「金融機構」還是「河邊的土地」。研究人員認為上下文化的目標會促進更豐富的學習任務,並使 data2vec 2.0比其他演算法學習得更快。

data2vec 2.0透過以下三種方式提高了原始data2vec 演算法的效率:

1、為特定訓練範例建立目標表徵,並將此表徵重複使用在遮罩版本上。在遮罩版本中,訓練範例中的不同部分會被隨機隱藏。隨後兩個版本學到的表徵都會輸入到學生模型中,為不同的掩碼版本預測相同的上下文化的目標表徵,從而有效地分攤了創建目標表徵所需的計算量。

2、類似掩碼自編碼器(masked autoencoder, MAE),學生模型中的編碼器網路並不起作用訓練範例中的空白部分(blanked out)。在影像實驗中,大約80%的部分都是空白,從而顯著節省了計算週期。

3、使用了一個更有效的解碼器模型,不再依賴Transformer網絡,而是依賴一個多層卷積網。

實驗部分

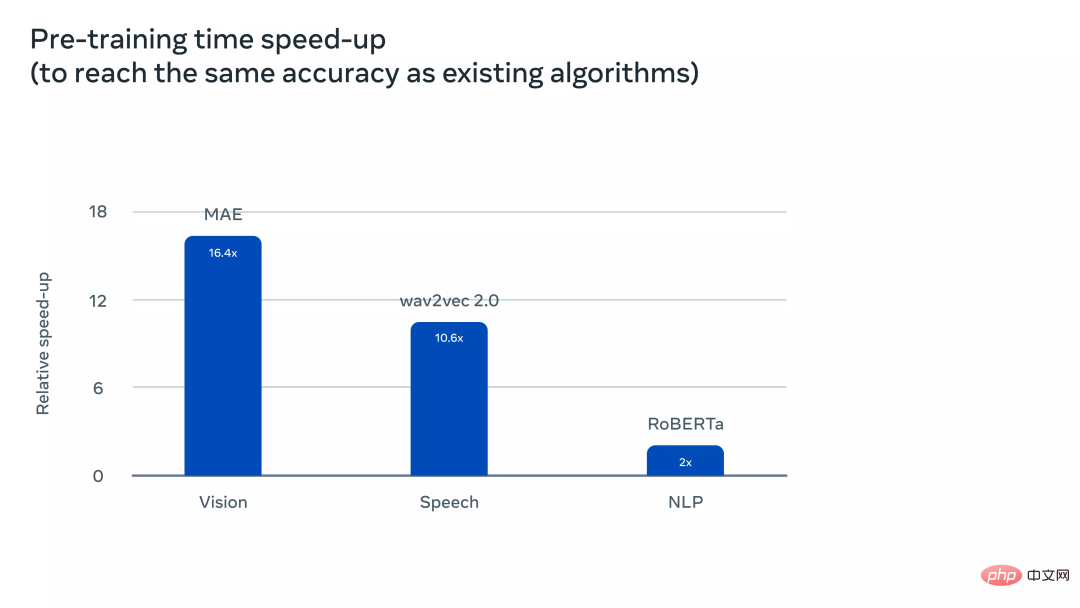

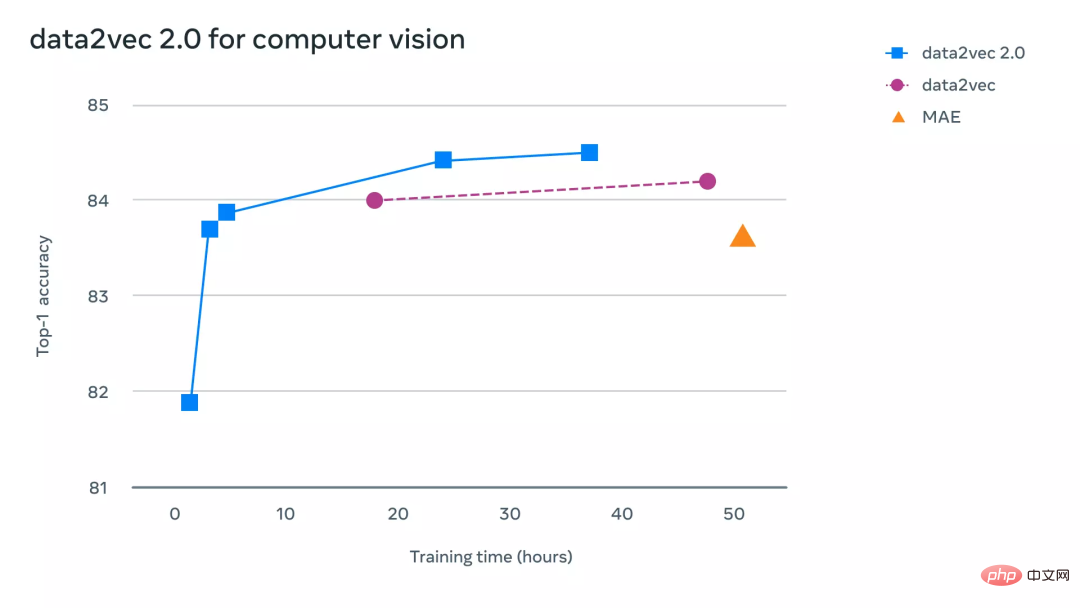

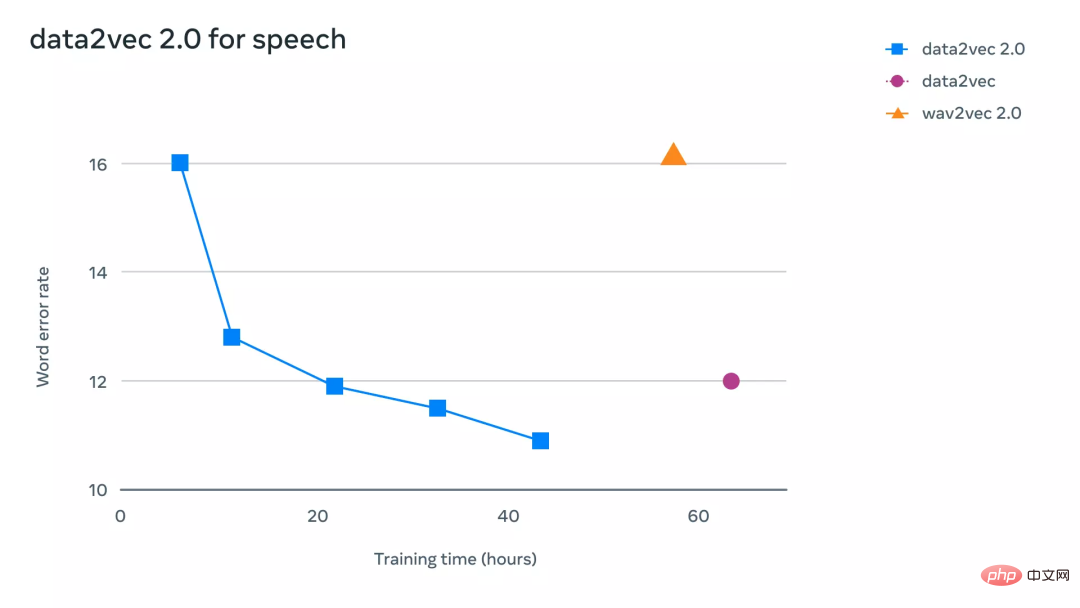

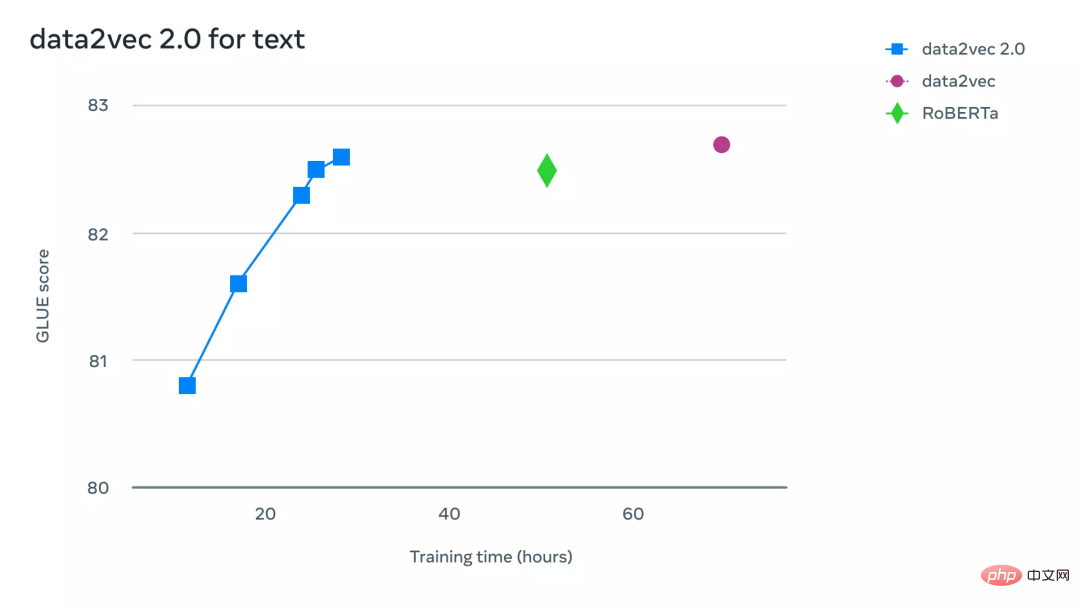

為了更直觀地理解data2vec 2.0 比data2vec 和其他同類演算法的效率要高多少,研究人員在電腦視覺、語音和文字任務相關的基準測試中進行了廣泛的實驗。實驗中主要考慮最終的精確度以及預訓練模型所需的時間,實驗環境都是在相同的硬體上(GPU 的型號、數量等)來測量演算法的運行速度。

在電腦視覺任務上,研究人員在標準ImageNet-1K 影像分類基準上評估了data2vec 2.0,模型透過該資料集可以學習圖像表徵。實驗結果顯示,data2vec 2.0可以等同於遮罩自編碼器(MAE)的準確性,但是速度要快16倍。

如果繼續給data2vec 2.0演算法更多的運行時間,它可以達到更高的精度,並且仍然會比MAE的速度快。

在語音任務上,研究人員在 LibriLanguage 語音辨識基準上進行了測試,它的準確性是 wave2vec 2.0的11倍以上。

對於自然語言處理任務,研究人員在通用語言理解評估(GLUE)基準上評估了data2vec 2.0,僅需一半的訓練時間即可達到與BERT 的重新實現RoBERTa 相同的精度。

以上是多模態再次統一! Meta發布自監督演算法data2vec 2.0:訓練效率最高提升16倍!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球十大加密貨幣交易平台包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、KuCoin和Poloniex,均提供多種交易方式和強大的安全措施。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0通過創新架構和性能突破重新定義了加密資產管理。 1) 它解決了資產孤島、收益衰減和安全與便利悖論三大痛點。 2) 通過智能資產樞紐、動態風險管理和收益增強引擎,提升了跨鏈轉賬速度、平均收益率和安全事件響應速度。 3) 為用戶提供資產可視化、策略自動化和治理一體化,實現了用戶價值重構。 4) 通過生態協同和合規化創新,增強了平台的整體效能。 5) 未來將推出智能合約保險池、預測市場集成和AI驅動資產配置,繼續引領行業發展。

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠谱的数字货币交易平台推荐:1. OKX,2. Binance,3. Coinbase,4. Kraken,5. Huobi,6. KuCoin,7. Bitfinex,8. Gemini,9. Bitstamp,10. Poloniex,这些平台均以其安全性、用户体验和多样化的功能著称,适合不同层次的用户进行数字货币交易

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣的價格在20,000到30,000美元之間。 1. 比特幣自2009年以來價格波動劇烈,2017年達到近20,000美元,2021年達到近60,000美元。 2. 價格受市場需求、供應量、宏觀經濟環境等因素影響。 3. 通過交易所、移動應用和網站可獲取實時價格。 4. 比特幣價格波動性大,受市場情緒和外部因素驅動。 5. 與傳統金融市場有一定關係,受全球股市、美元強弱等影響。 6. 長期趨勢看漲,但需謹慎評估風險。

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

Binance、OKX、gate.io等十大數字貨幣交易所完善系統、高效多元化交易和嚴密安全措施嚴重推崇。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

2025年全球十大加密貨幣交易所包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、KuCoin、Bittrex和Poloniex,均以高交易量和安全性著稱。