約克大學:AI進步很快,但它的辨識能力比人眼還是差遠了

深度卷積神經網路(DCNN)看待物體的方式與人類不同,約克大學教授James Elder的研究團隊認為,深度學習模型無法捕捉人體形狀感知獲取的構形特徵。

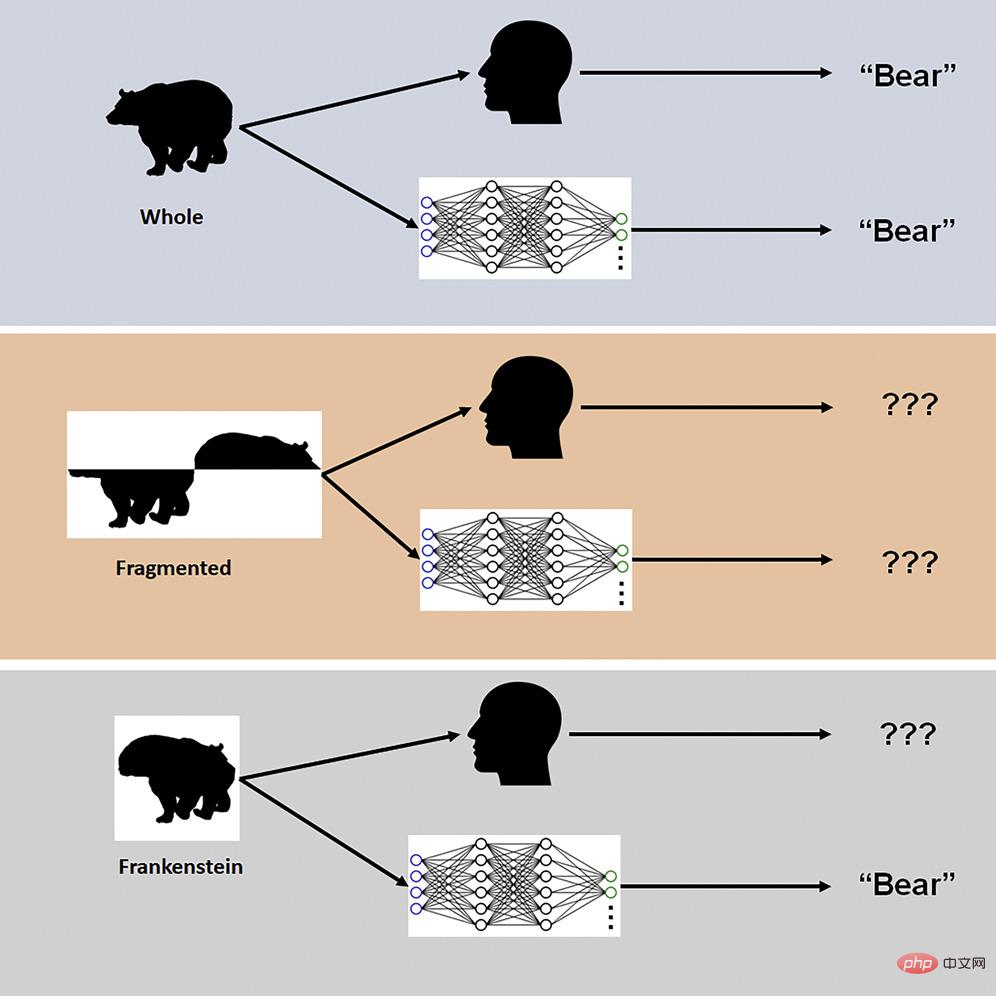

到底人類大腦和DCNN是如何感知整體的?又是如何感知物件特性的?科學家用所謂的「Frankensteins」視覺刺激來檢測。 James Elder說:「所謂的Frankensteins就是將整體拆成部分,讓部分以錯誤的方式整合在一起,從局部看它們是正確的,但部分放在了錯誤的位置。」

#研究發現,雖然Frankensteins會迷惑人類視覺系統,但DCNN對於錯誤的配置不敏感。

例如一張熊的圖片,人眼看到是熊,AI看到也是熊。將照片從中間切開,變成兩半,不要連在一起,人眼無法辨識,AI也無法辨識。再將上下兩半以錯誤方式拼在一起,人眼無法識別,看到的是不像熊的動物,如同怪物,但AI卻將它識別為熊。

這說明什麼?說明AI對於被配置物件的特徵不夠敏感。

James Elder說:「我們的研究解釋了在特定條件下為什麼AI模型會失敗,要理解大腦中的視覺處理是如何進行的,我們要考慮物件辨識之外的任務。在在解決複雜識別難題時,深度模型會走捷徑。儘管許多時候走捷徑是可行的,但到了真實世界的AI應用就有些危險了。我們與產業和政府合作夥伴正在開發應用於真實世界的AI應用。 ”

正如在識別熊時,熊的圖片各部分錯誤配置,AI還是會將拼出的怪物識別為熊。

讓我們來看看AI交通視頻安全系統。繁忙交通系統中有很多東西,例如汽車、自行車、行人,它們交織,成為各自的障礙物,這些東西像斷開的碎片一樣進入駕駛員的視覺系統。大腦自動處理,將各種碎片分組,確定正確的類別,判斷物體的位置。 AI交通監測系統差很多,它只能感知個別碎片,所以會有很大風險。

依照研究人員的說法,優化訓練和架構,想讓AI網路更像大腦,這樣的研究對於提升AI的配置處理能力沒有太大幫助。人類是怎樣一次又一次判斷對象的? AI網路無法精準預測。人類視覺系統的配置能力高度敏感,如果AI想與人類視覺系匹敵,它可能需要在類別辨識之外做更多的事。

科學家的警告也許是有道理的,現在最聰明的AI也遠遠比不上人類器官,連視覺系統都比不上,更別說大腦,如果稍有不慎,AI可能會造成嚴重惡果。

幾年前,有一個名叫Sophia的人形機器人曾經大紅大紫。在一次會議上,Sophia接受人類的採訪。人類主持人問Sophia:「你想毀滅人類嗎?」Sophia回答:「好的,我會毀滅人類。」聽眾大笑。有人猜測Sophia的回答是預先設定好的,因為Sophia還沒有先進到可以做決定並回答這樣的問題,不過也有人相信這一回答並不是預先設定的。

在另一次活動中,Sophia是這樣回答的:「不要擔心,如果你們對我好,我也會對你們很好的。你們應該像對待智慧系統一樣對我。」

現在AI開始慢慢流行,但結果並非總是正面正面的。霍金與馬斯克曾表達擔憂,擔心AI會帶來破壞。就眼下來看,擔憂AI毀滅人類可能有些誇大,但警惕還是應該的。

隨著時間的推移,也許AI會變得像人類一樣聰明,甚至超越人類。不過讓AI模擬人類感知可能是很棘手的事。對人類來說,有些事習以為常,做起來很容易,科學家訓練AI,讓它不斷執行某項任務,做人類輕鬆能做的事。儘管做了很多努力,現在的AI還是無法追上人類視覺系統。

以上是約克大學:AI進步很快,但它的辨識能力比人眼還是差遠了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

phpmyadmin建立數據表

Apr 10, 2025 pm 11:00 PM

phpmyadmin建立數據表

Apr 10, 2025 pm 11:00 PM

要使用 phpMyAdmin 創建數據表,以下步驟必不可少:連接到數據庫並單擊“新建”標籤。為表命名並選擇存儲引擎(推薦 InnoDB)。通過單擊“添加列”按鈕添加列詳細信息,包括列名、數據類型、是否允許空值以及其他屬性。選擇一個或多個列作為主鍵。單擊“保存”按鈕創建表和列。

怎麼創建oracle數據庫 oracle怎麼創建數據庫

Apr 11, 2025 pm 02:33 PM

怎麼創建oracle數據庫 oracle怎麼創建數據庫

Apr 11, 2025 pm 02:33 PM

創建Oracle數據庫並非易事,需理解底層機制。 1. 需了解數據庫和Oracle DBMS的概念;2. 掌握SID、CDB(容器數據庫)、PDB(可插拔數據庫)等核心概念;3. 使用SQL*Plus創建CDB,再創建PDB,需指定大小、數據文件數、路徑等參數;4. 高級應用需調整字符集、內存等參數,並進行性能調優;5. 需注意磁盤空間、權限和參數設置,並持續監控和優化數據庫性能。 熟練掌握需不斷實踐,才能真正理解Oracle數據庫的創建和管理。

oracle數據庫怎麼創建 oracle數據庫怎麼建庫

Apr 11, 2025 pm 02:36 PM

oracle數據庫怎麼創建 oracle數據庫怎麼建庫

Apr 11, 2025 pm 02:36 PM

創建Oracle數據庫,常用方法是使用dbca圖形化工具,步驟如下:1. 使用dbca工具,設置dbName指定數據庫名;2. 設置sysPassword和systemPassword為強密碼;3. 設置characterSet和nationalCharacterSet為AL32UTF8;4. 設置memorySize和tablespaceSize根據實際需求調整;5. 指定logFile路徑。 高級方法為使用SQL命令手動創建,但更複雜易錯。 需要注意密碼強度、字符集選擇、表空間大小及內存

oracle數據庫的語句怎麼寫

Apr 11, 2025 pm 02:42 PM

oracle數據庫的語句怎麼寫

Apr 11, 2025 pm 02:42 PM

Oracle SQL語句的核心是SELECT、INSERT、UPDATE和DELETE,以及各種子句的靈活運用。理解語句背後的執行機制至關重要,如索引優化。高級用法包括子查詢、連接查詢、分析函數和PL/SQL。常見錯誤包括語法錯誤、性能問題和數據一致性問題。性能優化最佳實踐涉及使用適當的索引、避免使用SELECT *、優化WHERE子句和使用綁定變量。掌握Oracle SQL需要實踐,包括代碼編寫、調試、思考和理解底層機制。

MySQL數據表字段操作指南之添加、修改與刪除方法

Apr 11, 2025 pm 05:42 PM

MySQL數據表字段操作指南之添加、修改與刪除方法

Apr 11, 2025 pm 05:42 PM

MySQL 中字段操作指南:添加、修改和刪除字段。添加字段:ALTER TABLE table_name ADD column_name data_type [NOT NULL] [DEFAULT default_value] [PRIMARY KEY] [AUTO_INCREMENT]修改字段:ALTER TABLE table_name MODIFY column_name data_type [NOT NULL] [DEFAULT default_value] [PRIMARY KEY]

MySQL數據庫中的嵌套查詢實例詳解

Apr 11, 2025 pm 05:48 PM

MySQL數據庫中的嵌套查詢實例詳解

Apr 11, 2025 pm 05:48 PM

嵌套查詢是一種在一個查詢中包含另一個查詢的方式,主要用於檢索滿足複雜條件、關聯多張表以及計算匯總值或統計信息的數據。實例示例包括:查找高於平均工資的僱員、查找特定類別的訂單以及計算每種產品的總訂購量。編寫嵌套查詢時,需要遵循:編寫子查詢、將其結果寫入外層查詢(使用別名或 AS 子句引用)、優化查詢性能(使用索引)。

oracle數據庫表的完整性約束有哪些

Apr 11, 2025 pm 03:42 PM

oracle數據庫表的完整性約束有哪些

Apr 11, 2025 pm 03:42 PM

Oracle 數據庫的完整性約束可確保數據準確性,包括:NOT NULL:禁止空值;UNIQUE:保證唯一性,允許單個 NULL 值;PRIMARY KEY:主鍵約束,加強 UNIQUE,禁止 NULL 值;FOREIGN KEY:維護表間關係,外鍵引用主表主鍵;CHECK:根據條件限制列值。

oracle是乾嘛的

Apr 11, 2025 pm 06:06 PM

oracle是乾嘛的

Apr 11, 2025 pm 06:06 PM

Oracle 是全球最大的數據庫管理系統(DBMS)軟件公司,其主要產品包括以下功能:關係數據庫管理系統(Oracle 數據庫)開發工具(Oracle APEX、Oracle Visual Builder)中間件(Oracle WebLogic Server、Oracle SOA Suite)雲服務(Oracle Cloud Infrastructure)分析和商業智能(Oracle Analytics Cloud、Oracle Essbase)區塊鏈(Oracle Blockchain Pla