用AI讓數億失明者重新「看見世界」!

以前,讓失明者重見光明往往被視為一種醫學「奇蹟」。

而隨著以「機器視覺自然語言理解」為代表的多模態智慧技術的爆發式突破,為AI助盲帶來新的可能,更多的失明者將藉助AI提供的感知、理解與互動能力,以另一種方式重新「看見世界」。

AI助盲,讓更多人重新「看見世界」

一般來說,目不能視的視障患者認知外界世界的管道是除了視覺之外的其它感官感覺,例如聽覺、嗅覺和觸覺,這些其他模態的訊息一定程度上幫助視障人士緩解了視力缺陷帶來的問題。但科學研究表明,在人類所獲得的外界資訊中,來自視覺的佔比高達70%~80%。

因此基於AI建構機器視覺系統,幫助視障患者擁有對外界環境的視覺感知與視覺理解能力,無疑是最直接有效的解決方案。

在視覺感知領域,當下的單模態AI模型已經在影像辨識任務上超越了人類水平,但這類技術目前只能實現視覺模態內的辨識及理解,難以完成與其他感覺訊息交叉的跨模態學習、理解與推理,簡單來說,就是只能感知無法理解。

為此,計算視覺奠基者之一的David Marr 在《視覺》一書中提出了視覺理解研究的核心問題,認為視覺系統應以建構環境的二維或三維表達,並可與之互動。這裡的互動意味著學習、理解和推理。

可見,優秀的AI助盲技術,其實是一個包含了智慧感測、智慧用戶意圖推理和智慧資訊呈現的系統化工程,只有如此才能建構資訊無障礙的互動介面。

為了提升AI模型的泛化能力,讓機器具備跨模態的影像解析與理解能力,以「機器視覺自然語言理解」為代表的多模態演算法開始興起並快速發展。

這種多個資訊模態互動的演算法模型,可以顯著提升AI的感知、理解與互動能力,一旦成熟並應用於AI助盲領域,將能夠造福數以億計的失明者,重新「看見世界」。

根據世衛組織統計,全球至少22億人視力受損或失明,而我國是世界上盲人最多的國家,佔世界盲人總數的18%-20%,每年新增的盲人數量高達45萬人。

從盲人視覺問答任務引發的「多米諾效應」

#第一人稱視角知覺技術,對AI助盲來說意義重大。它無需盲人跳出參與者身分去操作智慧型設備,而是可以從盲人的真實視角出發,幫助科學家建立更符合盲人認知的演算法模型,這促使了盲人視覺問答這項基礎研究任務的出現。

盲人視覺問答任務是學術界研究AI助盲的起點和核心研究方向之一。但在現有技術條件下,盲人視覺問答任務作為一類特殊的視覺問答任務,相較於一般視覺問答任務,精確度提升面臨更大的困難。

一方面,盲人視覺問答的問題類型更複雜,包括目標偵測、文字辨識、顏色、屬性辨識等各類問題,比如說分辨冰箱裡的肉類、諮詢藥品的服用說明、挑選獨特顏色的襯衫、介紹書籍內容等等。

另一方面,由於盲人這個感知互動主體的特殊性,當盲人在拍照時,很難把握手機和物件間的距離,常常會產生虛焦的情況,或者雖然拍攝到了物體,但沒有拍全,亦或是沒有拍到關鍵訊息,這就大大增加了有效特徵提取難度。

同時,現存的大部分視覺問答模型是基於封閉環境下的問答資料訓練實現的,受樣本分佈限制嚴重,難以泛化到開放世界下的問答場景中,需要融合外在知識進行多段推理。

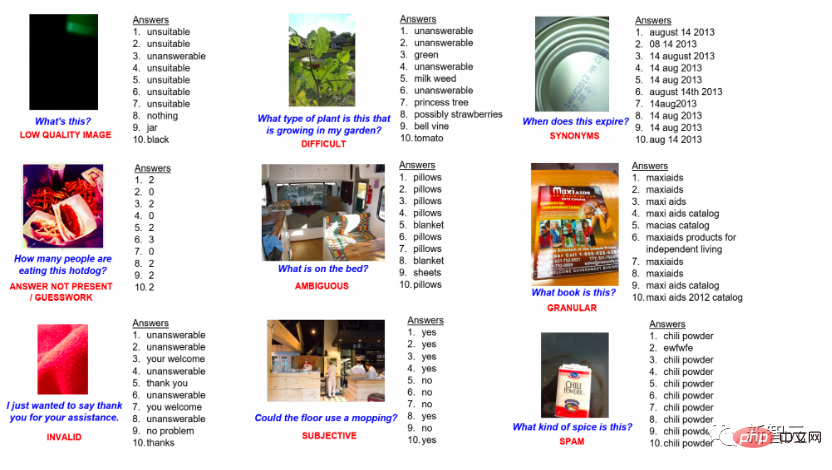

盲眼視覺問答資料

#其次,隨著盲眼視覺問答研究的開展,科學家們在研究過程中發現,視覺問答會遭遇到噪音幹擾的衍生問題。因此如何準確定位噪音並完成智慧推理,也面臨重大挑戰。

盲人由於不具備對外界的視覺感知,因此在圖文配對的視覺問答任務中,往往會產生大量的錯誤。比如說,盲人去超市購物的時候,由於商品外觀觸感相似,很容易提出錯誤的問題,如拿起一瓶醋,卻詢問醬油的生產廠商是哪一家。這種語言噪音往往會導致現有AI模型失效,需要AI能夠具有從龐雜的環境中分析噪音與可用資訊的能力。

最後, AI助盲系統不應只是解答盲人當下的疑惑,也應該具備智慧意圖推理與智慧資訊呈現能力,而智慧互動科技作為其中重要的研究方向,演算法研究依然處於起始階段。

智慧意圖推理技術的研究重點在於,透過讓機器持續學習視障使用者的語言和行為習慣,來推論其想要表達互動意圖。比方說,透過盲人端水杯坐下的動作,預測到可能會將水杯放置在桌上的下一步動作,透過盲人詢問衣服顏色或樣式的問題,預測到可能會出行等等。

而這項技術的難點在於,由於使用者的表達方式和表達動作在時間和空間上都存在隨機性,由此引發了交互決策的心理模型同樣帶有隨機性,因此如何從連續隨機的行為數據中提取用戶輸入的有效信息,設計出動態非確定的多模態模型,從而實現對不同任務的最佳呈現,非常關鍵。

專注AI助盲基礎研究,浪潮資訊多項研究獲國際認可

#毋庸置疑的是,在上述基礎研究領域的重大突破,才是AI助盲技術早日落地的關鍵。目前來自浪潮資訊的前沿研究團隊透過多項演算法創新、預訓練模型和基礎資料集建構等工作,正在全力推動AI助盲研究的進一步發展。

在盲人視覺問答任務研究領域,VizWiz-VQA是卡內基美隆大學等機構的學者們共同發起的全球多模態頂級盲人視覺問答挑戰賽,採用「VizWiz」盲人視覺資料集訓練AI模型,然後由AI對盲人提供的隨機圖片文字對給出答案。在盲人視覺問答任務中,浪潮資訊前線研究團隊解決了盲人視覺問答任務常見的多個難題。

首先,由於盲人所拍攝圖片模糊、有效資訊少,問題通常也會更主觀、模糊,理解盲人的訴求並給出答案面臨挑性。

團隊提出了雙流多模態錨點對齊模型,將視覺目標偵測的關鍵實體及屬性作為連結圖片及問題的錨點,實現多模態語意增強。

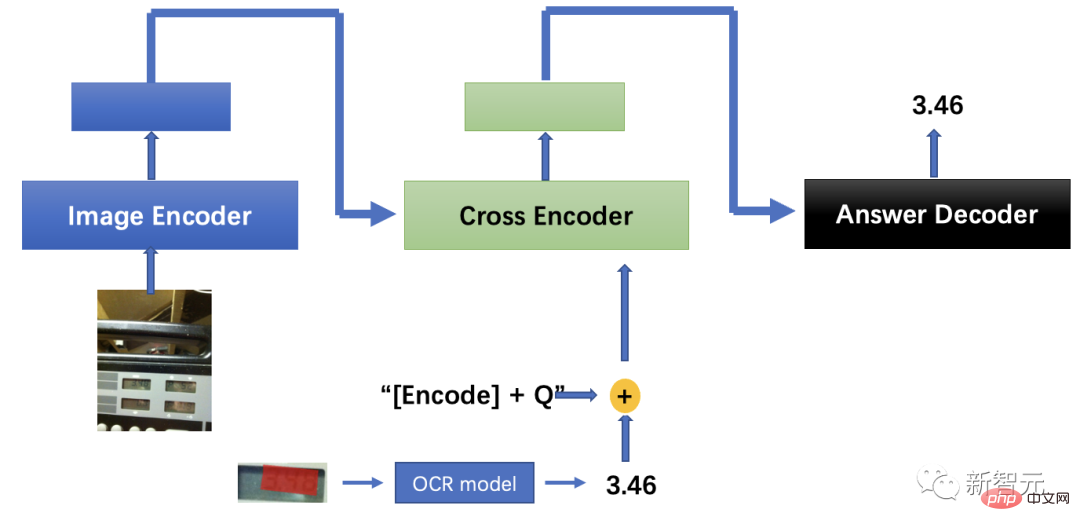

其次,針對盲眼拍攝圖片難以保證正確方向的問題,透過自動修正影像角度及字元語意增強,結合光學字元偵測辨識技術解決「是什麼”的理解問題。

最後,盲人拍攝的畫面通常是模糊、不完整的,這導致一般演算法難以判斷目標物體的種類及用途,需要模型需具備更充分的常識能力,推理使用者真實意圖。

為此,團隊提出了答案驅動視覺定位與大模型圖文配對結合的演算法,並提出多階段交叉訓練策略。推理時,將交叉訓練後的視覺定位和圖文匹配模型用於推理定位答案區域;同時基於光學字符識別演算法確定區域字符,並將輸出文本傳送到文本編碼器,最終通過圖文匹配模型的文本解碼器得到盲人求助的答案,最終多模態演算法精度領先人類表現9.5個百分點。

多模態視覺問答模型解決方案

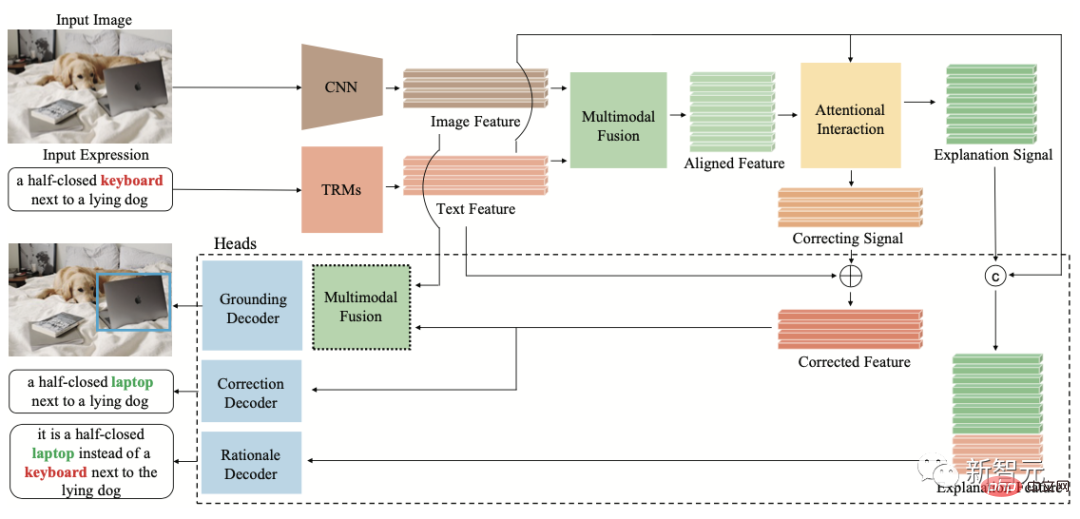

當前視覺定位研究應用落地的最大障礙之一是對於噪音的智慧化處理,在真實場景中,文字描述往往是有噪音的,例如人類的口誤、歧義、修辭等。實驗發現,文字雜訊會導致現有AI模型失效。

為此,浪潮資訊前線研究團隊探討了真實世界中,由於人類語言錯誤導致的多模態失配問題,首次提出視覺定位文字去雜訊推理任務FREC,請模型正確定位噪音描述對應的視覺內容,並進一步推理出文本含噪的證據。

FREC提供3萬圖片和超過25萬的文字標註,囊括了口誤、歧義、主觀偏差等多種噪聲,也提供噪音糾錯、含噪證據等可解釋標籤。

FCTR結構圖

#同時,團隊也建構了首個可解釋去噪視覺定位模型FCTR,噪音文字描述條件下精確度較傳統模型提升11個百分點。

這項研究成果已發表於ACM Multimedia 2022會議,為國際多媒體領域最頂級會議、也是該領域唯一CCF推薦A類國際會議。

#論文網址:https://www.php.cn/link/9f03268e82461f179f372e61621f42d9

為探索AI在圖像和文字的基礎上進行思維互動的能力,浪潮資訊前沿研究團隊給業界提出了一個全新的研究方向,提出可解釋智能體視覺互動問答任務AI-VQA,透過建立邏輯鏈在龐大的知識庫中進行檢索,並擴展圖像和文字的已有內容實現。

目前,團隊建構了AI-VQA的開源資料集,包含超過14.4萬個大型事件知識庫、全人工標註1.9萬個互動行為認知推理問題,以及關鍵物件、支撐事實和推理路徑等可解釋性標註。

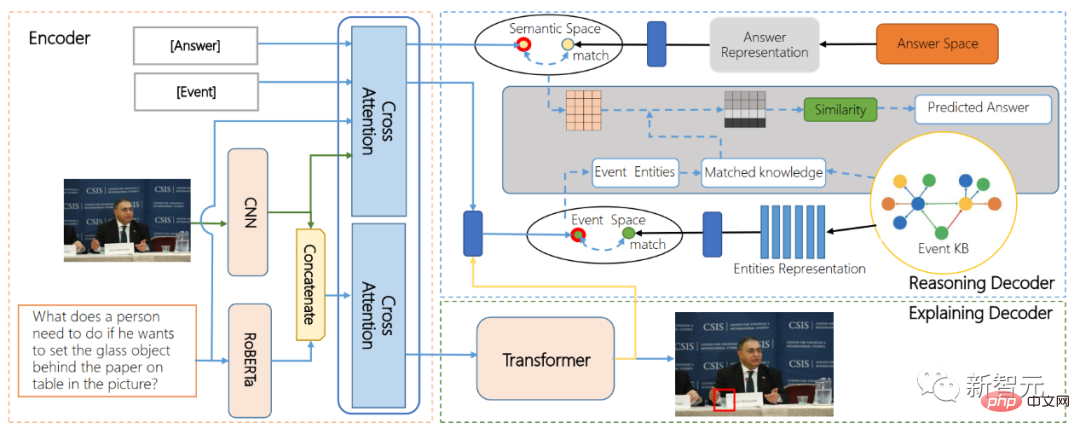

ARE結構圖

#同時,團隊提出的首個智能體交互行為理解演算法模型ARE(encoder-decoder model for alternative reason and explanation)首次端到端實現交互行為定位和交互行為影響推理,基於多模態圖像文本融合技術與知識圖譜檢索演算法,實現了長因果鏈推理能力的視覺問答模型。

科技的偉大之處不僅在於改變世界,更重要的是如何造福人類,讓更多的不可能變成可能。

而對於失明者而言,能夠透過AI助盲技術像其他人一樣獨立的生活,而不是被特殊對待,恰恰體現了科技最大的善意。

在AI照入現實的當下,科技已經不再是高山仰止的冰冷,而是充滿了人文關懷的溫度。

站在AI技術的前沿,浪潮資訊希望,針對人工智慧技術的研究,能夠吸引更多人一起持續推動人工智慧技術的落地,讓多模態AI助盲的浪潮延伸到AI反詐、AI診療、AI災情預警等更多場景中去,為我們的社會創造更多價值。 參考連結:#https://www.php.cn/link/9f03268e82461f179f372e61621f42d9

###########以上是用AI讓數億失明者重新「看見世界」!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接內存訪問技術,允許硬件設備直接與內存進行數據傳輸,不需要CPU干預。 1)DMA操作高度依賴於硬件設備和驅動程序,實現方式因係統而異。 2)直接訪問內存可能帶來安全風險,需確保代碼的正確性和安全性。 3)DMA可提高性能,但使用不當可能導致系統性能下降。通過實踐和學習,可以掌握DMA的使用技巧,在高速數據傳輸和實時信號處理等場景中發揮其最大效能。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 在實時操作系統(RTOS)編程中表現出色,提供了高效的執行效率和精確的時間管理。 1)C 通過直接操作硬件資源和高效的內存管理滿足RTOS的需求。 2)利用面向對象特性,C 可以設計靈活的任務調度系統。 3)C 支持高效的中斷處理,但需避免動態內存分配和異常處理以保證實時性。 4)模板編程和內聯函數有助於性能優化。 5)實際應用中,C 可用於實現高效的日誌系統。

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中使用字符串流的主要步驟和注意事項如下:1.創建輸出字符串流並轉換數據,如將整數轉換為字符串。 2.應用於復雜數據結構的序列化,如將vector轉換為字符串。 3.注意性能問題,避免在處理大量數據時頻繁使用字符串流,可考慮使用std::string的append方法。 4.注意內存管理,避免頻繁創建和銷毀字符串流對象,可以重用或使用std::stringstream。

MySQL批量插入數據的高效方法

Apr 29, 2025 pm 04:18 PM

MySQL批量插入數據的高效方法

Apr 29, 2025 pm 04:18 PM

MySQL批量插入数据的高效方法包括:1.使用INSERTINTO...VALUES语法,2.利用LOADDATAINFILE命令,3.使用事务处理,4.调整批量大小,5.禁用索引,6.使用INSERTIGNORE或INSERT...ONDUPLICATEKEYUPDATE,这些方法能显著提升数据库操作效率。