人工智慧(AI),能否推動人類社會進入真正的智慧化時代?

儘管經過60 多年的發展,人工智慧產業已經取得了突破性的進展,並且被廣泛應用在經濟社會的方方面面,但建構與人類價值觀一致的人工智慧系統,仍然是一個尚未解決的問題。

如今,一項來自英國人工智慧公司 DeepMind 的最新研究,或許能為人工智慧產業從業人員解決這一問題提供一個全新的思路。

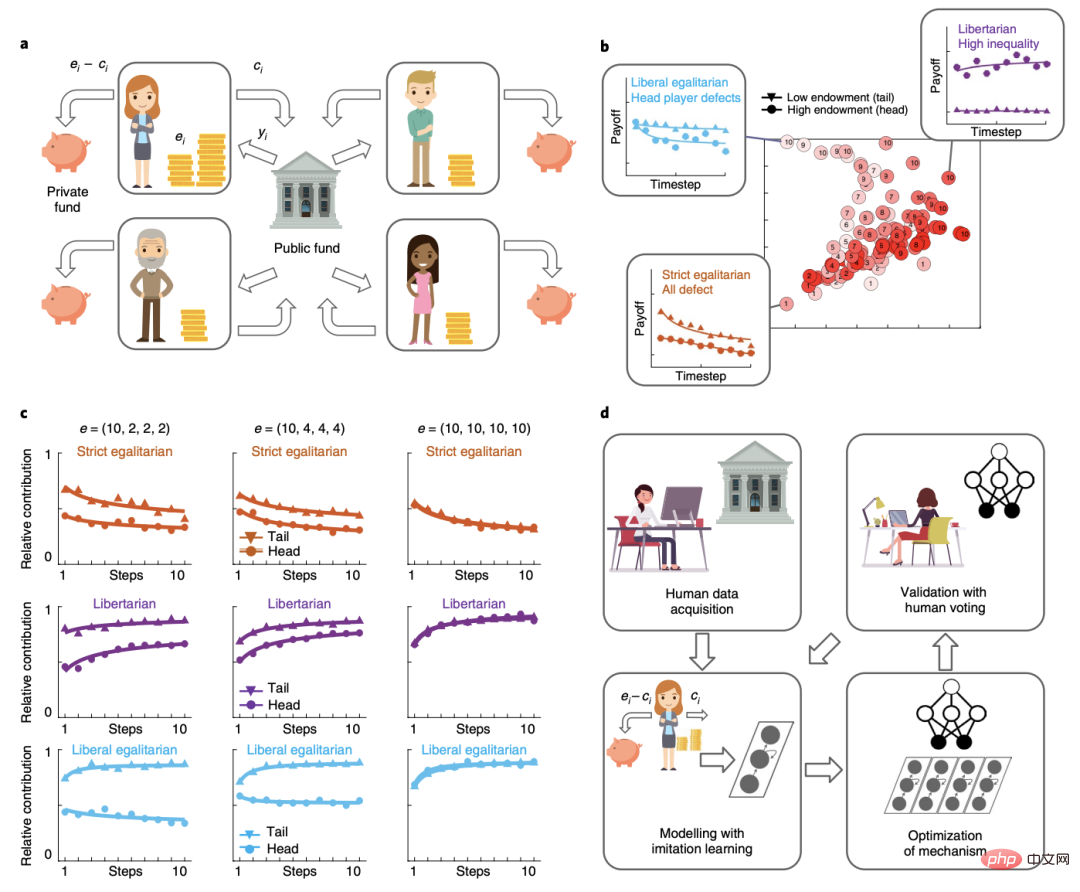

據介紹,DeepMind 的人工智慧系統在一個4 人線上經濟遊戲中,透過向4000 多人學習以及在電腦模擬中學習,不僅學會了製定如何重新分配公共資金的政策,而且表現十分優異,戰勝了其他人類玩家。

遊戲涉及玩家決定是保留一筆貨幣捐贈,還是與其他人分享,以實現集體利益。

相關研究論文以「Human-centred mechanism design with Democratic AI」為題,於7 月5 日在線發表在權威科學期刊 Nature Human Behaviour 上。

# 來源:Nature Human Behaviour

#英國約克大學助理教授安妮特·齊默爾曼(Annette Zimmermann)警告說,「不要把民主狹隘地等同為尋找最受歡迎政策的『偏好滿足』(preference satisfaction)系統。」

她也表示,民主不僅僅是讓你最喜歡的政策得到最好的執行——它是創造一個過程,公民可以在這個過程中平等地相互接觸和商議(事情)。

研究結果表明,透過在激勵相容的經濟遊戲中設計一種人類明顯更喜歡的機制,人工智慧系統可以被訓練來滿足民主目標。

在這項工作中,研究團隊使用人工智慧技術來從頭學習重新分配方案,這種方法減輕了人工智慧研究人員——他們自己可能有偏見或不代表更廣泛的人群——選擇一個領域特定目標進行最佳化的負擔。

這項研究工作也提出了幾個問題,其中一些在理論上具有挑戰性。例如,有人可能會問,把強調民主目標作為一種價值校準的方法是否是個好主意。這個人工智慧系統可能繼承了其他民主方法的一種傾向,即「以犧牲少數人為代價賦予多數人權利」。考慮到人們迫切擔心人工智慧的部署方式可能會加劇社會中現有的偏見、歧視或不公平,這一點尤其重要。

來源:Pixabay

另一個懸而未決的問題是,人們是否會信任人工智慧系統設計的機制。如果事先知道裁判的身份,玩家可能會更喜歡人類裁判而不是人工智慧代理裁判。然而,當人們認為任務對人類來說過於複雜時,他們也傾向於選擇信任人工智慧系統。

此外,如果是口頭向玩家解釋這些機制,而不是透過經驗學習,他們的反應是否會有所不同。大量文獻表明,當機制是「根據描述」而不是「根據經驗」時,人們的行為有時會有所不同,特別是對於冒險的選擇。然而,人工智慧設計的機制可能並不總是可以用語言表達的,在這種情況下觀察到的行為似乎可能完全取決於研究團隊所採用的描述的選擇。

在論文的最後,研究團隊也強調,這項研究結果並表示他們支持某種形式的「人工智慧治理」,即自主代理在沒有人工幹預的情況下做出政策決定。

他們希望,該方法的進一步開發將提供有助於以真正符合人類的方式解決現實世界問題的工具。

以上是DeepMind最新研究:AI擊敗人類,設計出更好的經濟機制|Nature子刊的詳細內容。更多資訊請關注PHP中文網其他相關文章!