揭秘數據競賽勝利秘訣:探析A100在200場比賽中的優勢

2022 年是 AI 領域發展的重要一年,在數據競賽領域也是如此,所有平台的總獎金超過了 500 萬美元。

近日,機器學習競賽分析平台 ML Contests 對 2022 年的資料競賽進行了大規模統計。新報告回顧了 2022 年發生的所有值得關注的事。以下是原文的編譯整理。

重點內容:

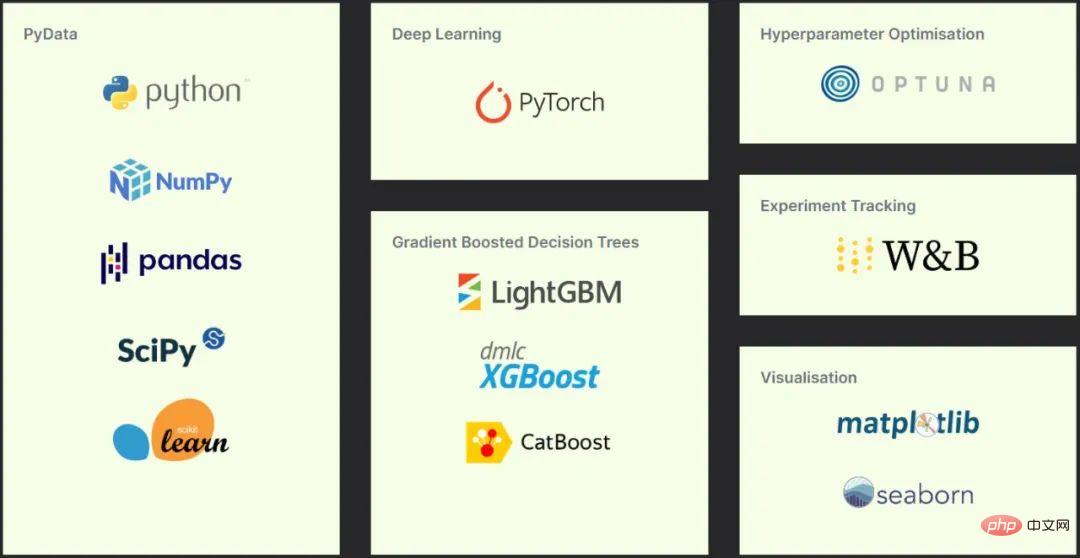

- 成功參賽者的工具選擇:Python、Pydata、Pytorch 和梯度提升的決策樹。

- 深度學習仍未取代梯度增強的決策樹,儘管在結識增強方法時,前者通常價值會有所提升。

- Transformer 繼續在 NLP 中占主導地位,並開始在電腦視覺中和卷積神經網路開始競爭。

- 當今資料競賽涵蓋了廣泛的研究領域,包括電腦視覺、NLP、資料分析、機器人、時間序列分析等。

- 大集合模型在獲勝方案中仍然很普遍,一些單模型解決方案也能贏。

- 有多個活躍的資料競賽平台存在。

- 資料競賽社群持續成長,在學界也是一樣。

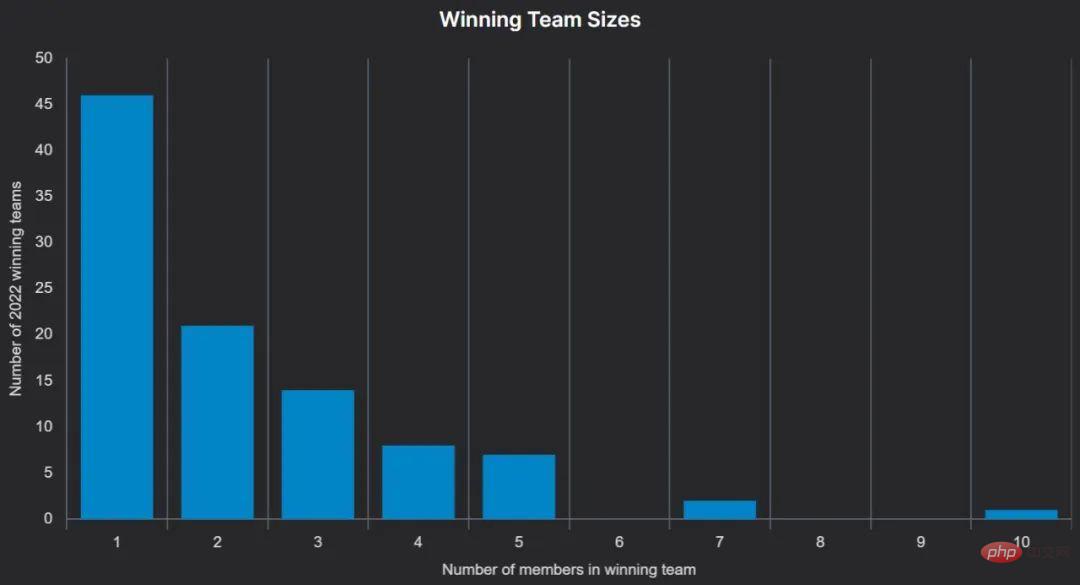

- 大約有 50%獲獎者是一人團隊,50%的獲獎者是首次獲獎。

- 有人使用了高階硬件,但像 Google Colab 這樣的免費資源也能贏得比賽。

比賽和趨勢

獎金數量最大的比賽是由美國復墾局贊助 Drivendata 的 Snow Cast Showdown 競賽。參與者可獲得 50 萬美元的獎金,旨在透過為西部的不同地區提供準確的雪水流量估算,以幫助改善供水管理。像往常一樣,Drivendata 詳細撰寫了比賽情況的文章並有詳細的解決方案報告,非常值得一讀。

2022 年最受歡迎的比賽是 Kaggle 的 American Express 預設預測競賽,旨在預測客戶是否會償還貸款。有超過 4000 支隊伍參賽,共 10 萬美元獎金分發至前四名的隊伍。今年第一次有首次參賽且單人隊伍獲得冠軍,其使用了神經網路和 LightGBM 模型的集合。

最大的獨立競賽是史丹佛大學的AI 審計挑戰,該挑戰為最佳的「模型、解決方案、資料集和工具」提供了7.1 萬美元的獎勵池,以尋求方法解決「非法歧視的AI 審核系統」的問題。

基於金融預測的三場比賽全部都在 Kaggle 上:分別是 JPX 的東京證券交易所預測,Ubiquant 的市場預測以及 G-Research 的加密預測。

在不同方向的對比中,電腦視覺佔比最高,NLP 位居第二,順序決策問題(強化學習)正在興起。 Kaggle 透過在 2020 年引入模擬競賽來回應這種流行的成長。 Aicrowd 也舉辦了許多強化學習類競賽。在 2022 年,其中有 25 場互動賽的比賽總額超過 30 萬美元。

在NeurIPS 2022 官方競賽Real Robot Challenge 中,參與者必須學會控制三指機器人,以將立方體移動到目標位置或將其定位在空間的特定點上,且要面對正確的方向。參與者的策略每週在實體機器人上運行,結果更新到排行榜上。獎勵為 5000 美元的獎品,以及在 NeurIPS 研討會上演講的學術榮譽。

平台

雖然人們都知道 Kaggle 和天池,但目前也有很多機器學習競賽平台組成了活躍的生態系統。

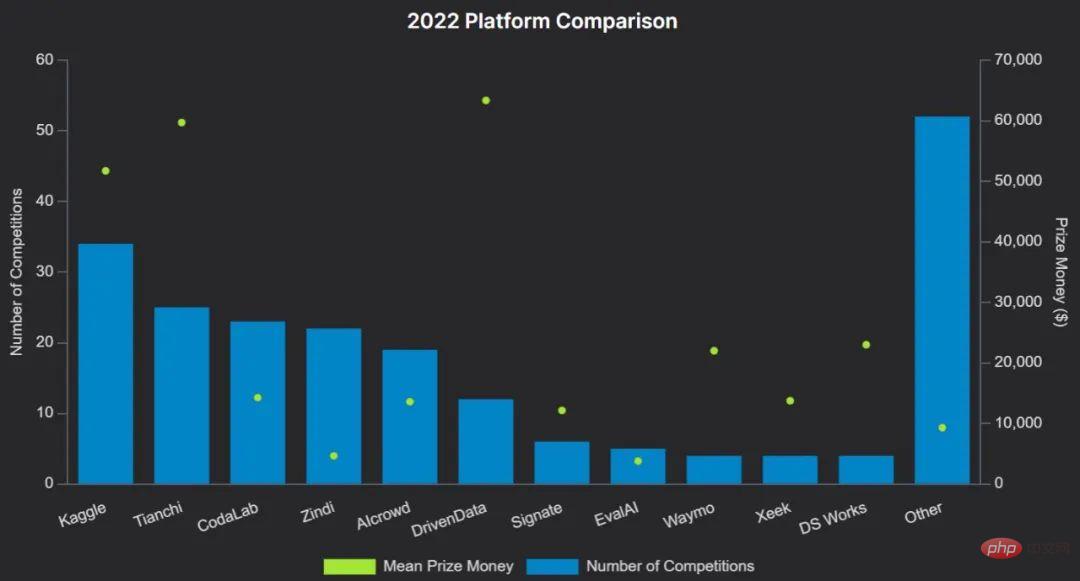

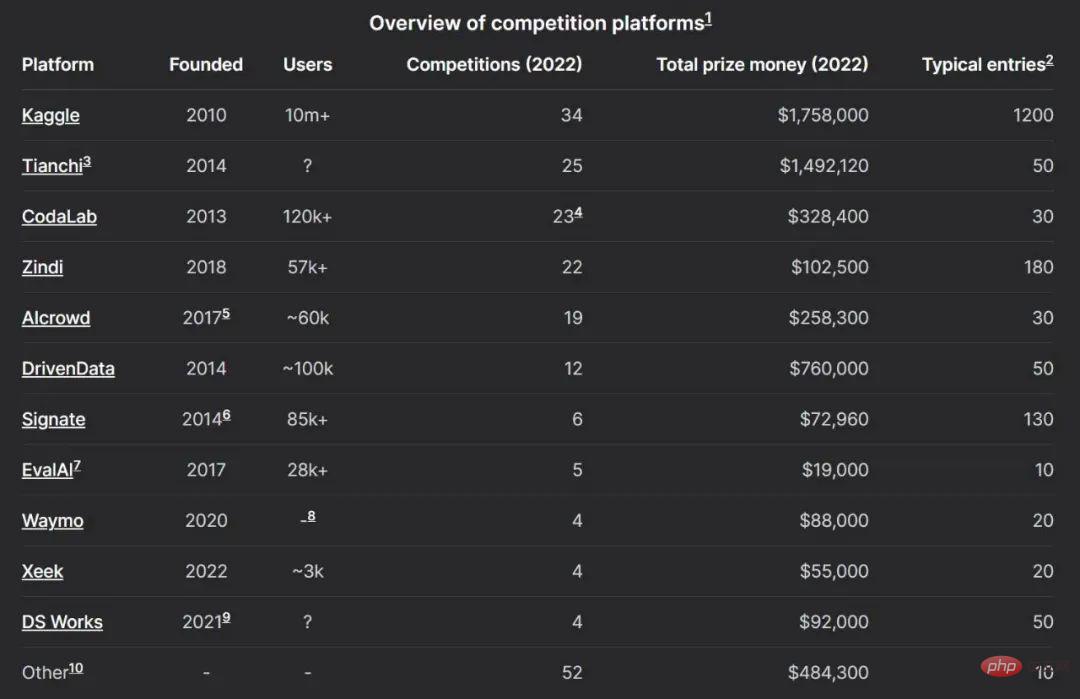

下圖為2022 平台比較:

舉一些範例:

- Kaggle 是最成熟的平台之一,它在 2017 年被Google收購,並擁有最大的社區,最近吸引了 1000 萬用戶。在 Kaggle 上進行帶獎金的比賽可能非常昂貴。除了舉辦比賽外,Kaggle 還允許用戶託管資料集,筆記和模型。

- Codalab 是一個開源競賽平台,由巴黎大學 - 薩克萊大學維護。任何人都可以註冊,主持或參加比賽。其提供免費的 CPU 資源可用於推理,比賽組織者可以用自己的硬體補充。

- Zindi 是一個較小的平台,具有非常活躍的社區,專注於將機構與非洲的資料科學家聯繫起來。 Drivendata 專注於具有社會影響力的競賽,並為 NASA 和其他組織開展了比賽。競賽總是在深入的研究報告後跟進。

- Aicrowd 最初是瑞士聯邦理工學院(EPFL)的研究項目,現在是前五名競賽平台之一。它舉辦了幾場 NeurIPS 官方比賽。

學術界

在大型平台上運行的比賽的大部分獎金都來自工業界,但是機器學習競賽顯然在學術界擁有更豐富的歷史,正如Isabelle Guyon 今年在NeurIPS 邀請演講中所討論的那樣。

NeurIPS 是全球最負盛名的學術機器學習會議之一,過去十年中最重要的機器學習論文經常會在大會上呈現,包括AlexNet,GAN,Transformer 和GPT-3。

NeurIPS 在 2014 年首次在機器學習(CIML)研討會方面舉辦了資料挑戰賽,自 2017 年以來一直有競賽環節。從那時起,競賽和總獎金不斷增長,在 2022 年 12 月達到了接近 40 萬美元。

其他機器學習會議也舉辦了比賽,包括 CVPR、ICPR、IJCAI、ICRA、ECCV、PCIC 和 AutoML。

獎金

大約一半的機器學習比賽有超過 1 萬美元的獎金池。毫無疑問,許多有趣的比賽獎金不多,本報告僅考慮那些有貨幣獎品或學術榮譽的部分。通常,與享有聲望的學術會議相關的數據比賽為獲獎者提供了旅行贈款,以便他們參加會議。

雖然平均而言,一些比賽平台確實傾向於擁有比其他平台更大的獎金池(見平台比較圖表),但許多平台在2022 年至少舉辦過一場獎池非常大的比賽—— 總獎金排名前十的比賽包括在DrivenData、Kaggle、CodaLab 和AIcrowd 上運行的。

奪冠方法

該調查透過問捲和觀察程式碼的方式分析獲勝演算法使用的技術。

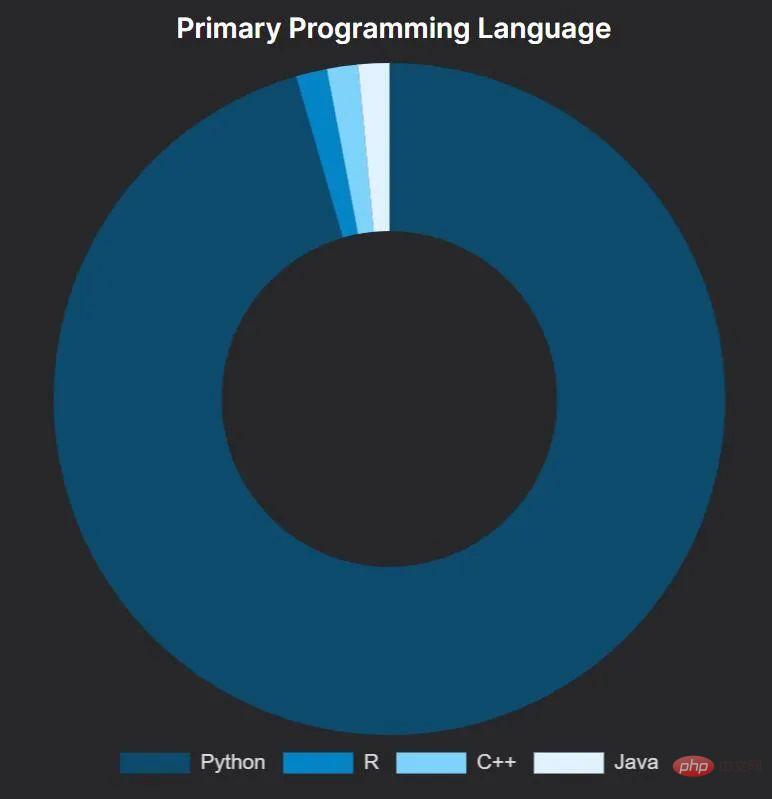

相當一致的是,Python 是競賽獲勝者的首選語言,這對人們來說可能不是個預料之外的結果。在使用 Python 的人中,大約一半主要使用 Jupyter Notebook,另一半則使用標準 Python 腳本。

一個主要使用R 語言的獲勝解決方案是:Amir Ghazi 贏得了Kaggle 上預測2022 年美國男子大學籃球錦標賽獲勝者的比賽。他透過使用 —— 顯然是逐字複製 ——2018 年同類競賽獲勝解決方案的代碼來做到這一點,該方法由 Kaggle Grandmaster Darius Barušauskas 撰寫。讓人難以想像的是,Darius 也參加了 2022 年的比賽,他使用新的方法,並獲得了第 593 名。

獲獎者使用的Python 套件

在觀察獲勝解決方案中使用的軟體包時,結果顯示所有使用Python 的獲獎者都在一定程度上使用了PyData 堆疊。

將最受歡迎的軟體包分為三類 —— 核心工具包、NLP 類別和電腦視覺類別。

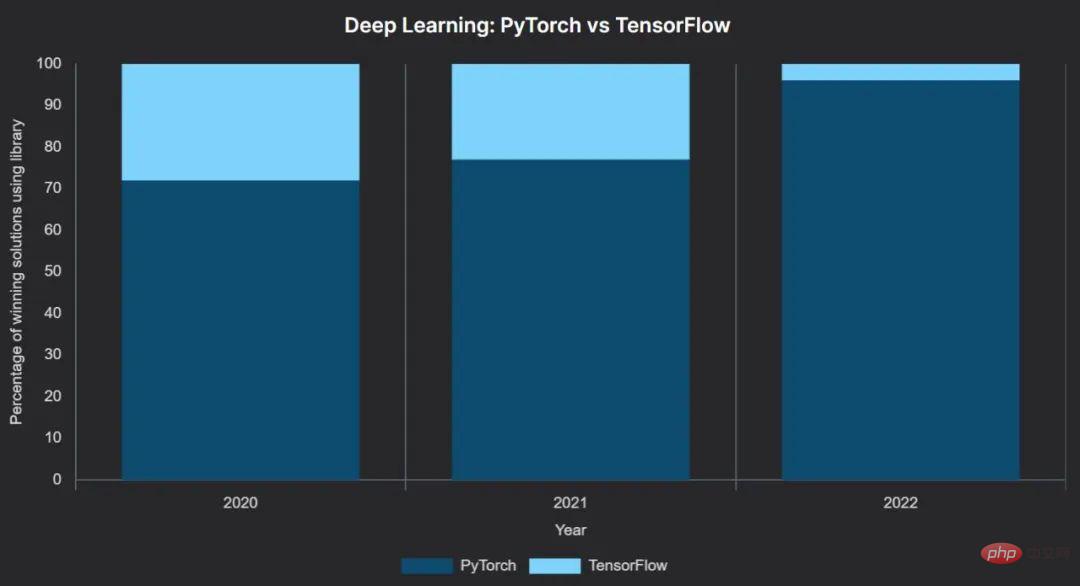

其中,深度學習框架PyTorch 的成長一直穩定,其從2021 年到2022 年的躍升非常明顯:PyTorch 從獲勝解決方案的77% 增加到了96%。

在 46 個使用深度學習的獲獎解決方案中,44 個使用 PyTorch 作為他們的主要框架,只有兩個使用 TensorFlow。更明顯的是,使用 TensorFlow 贏得的兩場比賽之一,Kaggle 的大堡礁競賽,提供額外的 5 萬美元獎金給使用 TensorFlow 的獲勝團隊。另一個使用 TensorFlow 獲勝的比賽使用了高級的 Keras API。

雖然有3 位獲勝者使用pytorch-lightning 和1 位使用fastai— 兩者都建立在PyTorch之上—— 但絕大多數人直接使用PyTorch。

現在或許可以說至少在資料競賽上,PyTorch 贏得了機器學習框架之爭。這與更廣泛的機器學習研究趨勢一致。

值得注意的是,我們沒有發現任何獲勝團隊使用其他神經網路庫的實例,例如JAX(由Google 構建,由DeepMind 使用)、PaddlePaddle(由百度開發)或MindSpore(華為開發)。

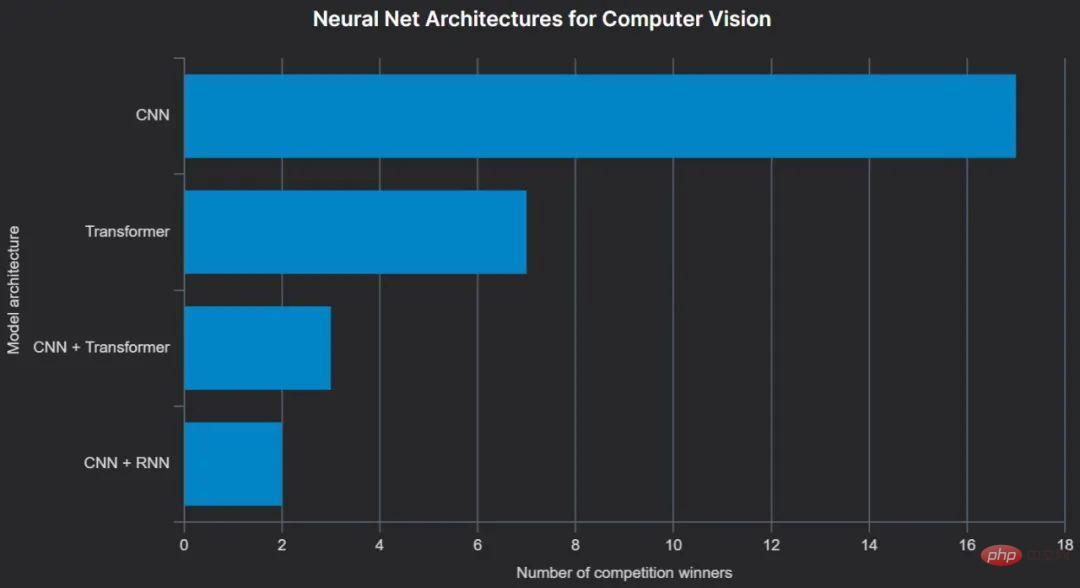

電腦視覺

工具有一統江湖的趨勢,技術卻不是。在 CVPR 2022 上,ConvNext 架構被介紹為「2020 年代的 ConvNet」,並證明其性能優於最近的基於 Transformer 的模型。它被用於至少兩個贏得比賽的電腦視覺解決方案,而 CNN 總體上仍是迄今為止電腦視覺競賽獲獎者中最喜歡的神經網路架構。

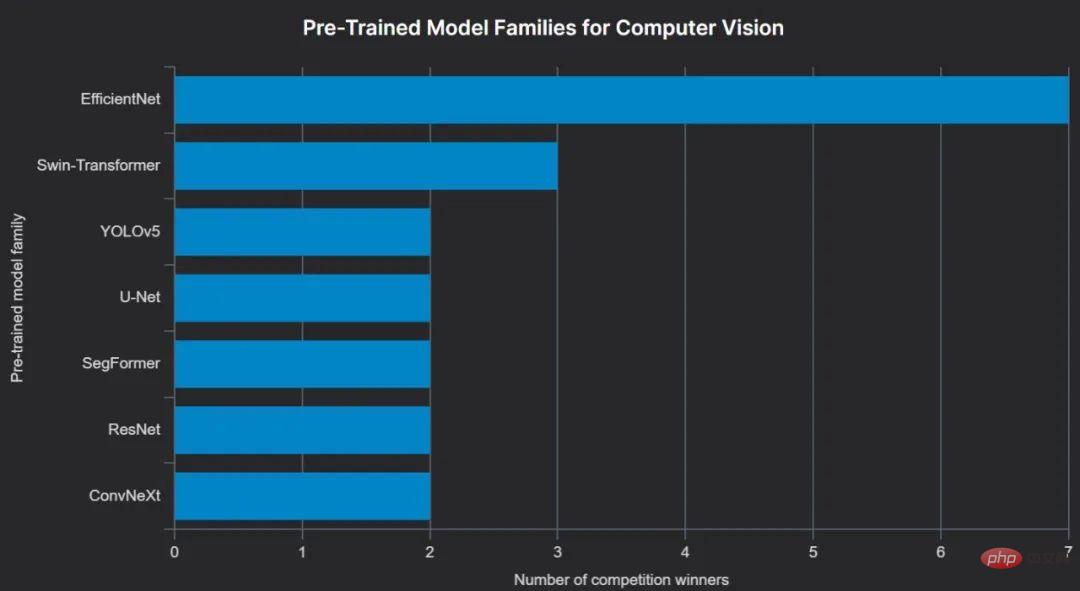

電腦視覺與語言建模非常相似的地方在於使用預訓練模型:在公共資料集(例如ImageNet )上訓練的易於理解的架構。最受歡迎的儲存庫是 Hugging Face Hub,可透過 timm 訪問,這使得加載數十種不同電腦視覺模型的預訓練版本變得極為方便。

使用預訓練模型的優勢是顯而易見的:真實世界的圖像和人類生成的文本都有一些共同的特徵,使用預訓練模型可以帶來常識的知識,類似於使用了更大、更通用的訓練資料集。

通常,預先訓練好的模型會根據特定任務的資料(例如比賽組織者提供的資料)進行微調 —— 進一步訓練,但並非總是如此。 Image Matching Challenge 的獲勝者使用了預訓練模型,完全沒有任何微調——「由於本次比賽中訓練和測試資料的品質(不同),我們沒有使用提供的訓練進行fine-tuning,因為我們認為它會不太有效。」這個決定得到了回報。

到目前為止,2022 年獲獎者中最受歡迎的預訓練電腦視覺模型類型是 EfficientNet,顧名思義,它的優勢在於比許多其他模型佔用資源更少。

自然語言處理

#自2017 年問世以來,基於Transformer 的模型一直主導著自然語言處理(NLP)領域。 Transformer 是 BERT 和 GPT 中的“T”,也是 ChatGPT 中的核心。

因此,自然語言處理競賽中所有獲勝的解決方案都是基於 Transformer 的模型為核心也就不足為奇了。它們都是在 PyTorch 中實現的,這並不奇怪。他們都使用了預訓練模型,使用 Hugging Face 的 Transformers 庫加載,幾乎所有模型都使用了 Microsoft Research 的 DeBERTa 模型版本 —— 通常是 deberta-v3-large。

它們其中的許多都需要大量的運算資源。例如,Google AI4Code 獲勝者運行 A100(80GB)大約 10 天,以訓練單個 deberta-v3-large 用於他們的最終解決方案。這種方法是個例外(使用單一主模型和固定的訓練 / 評估分割)— 所有其他解決方案都大量使用整合模型,幾乎都使用各種形式的 k-fold 交叉驗證。例如,Jigsaw Toxic Comments 比賽的獲勝者使用了 15 個模型輸出的加權平均值。

基於 Transformer 的整合有時會與 LSTM 或 LightGBM 結合使用,也有至少兩個偽標籤實例被有效地用於獲勝的解決方案。

XGBoost 曾經是 Kaggle 的代名詞。然而,LightGBM 顯然是2022 年獲獎者最喜歡的GBDT 庫—— 獲獎者在他們的解決方案報告或問卷中提到LightGBM 的次數與CatBoost 和XGBoost 的總和相同,CatBoost 位居第二,XGBoost 出人意料地排名第三。

運算與硬體

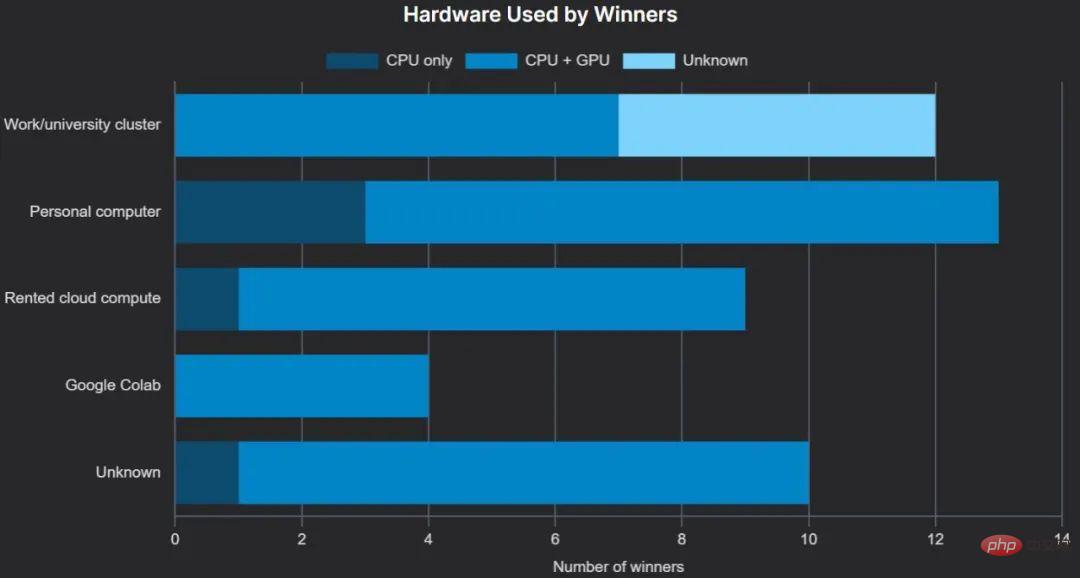

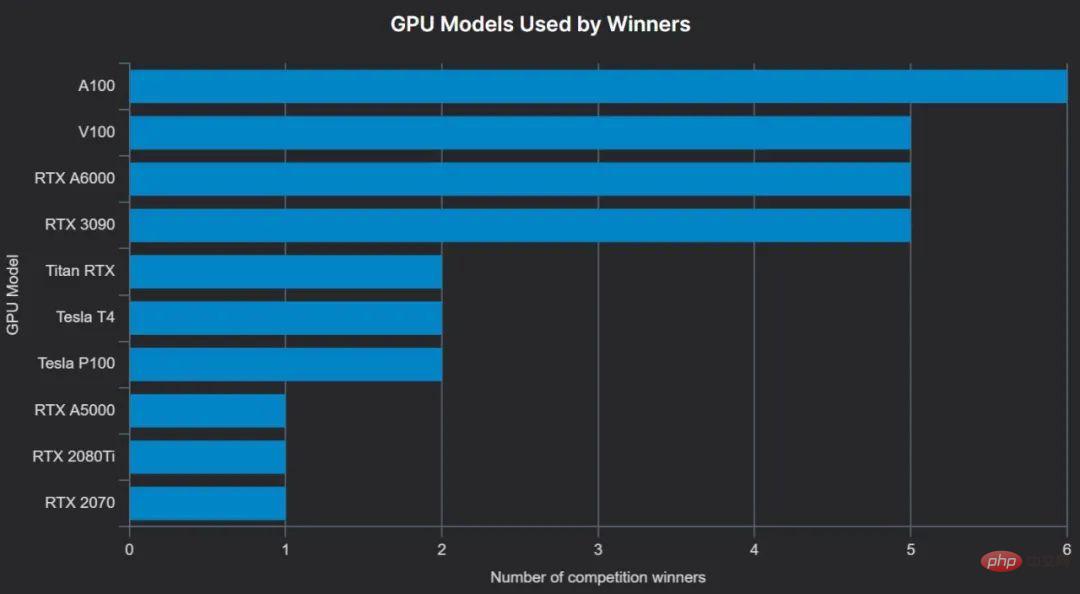

#如大致預期的,大多數獲勝者都使用GPU 進行訓練— — 這可以大大提高梯度提升樹的訓練性能,並且實際上是深度神經網路所必需的。相當多的獲獎者可以訪問其雇主或大學提供的集群,通常包括 GPU。

有點令人驚訝的是,我們沒有發現任何使用 Google 的張量處理單元 TPU 來訓練獲勝模型的實例。我們也沒有看到任何關於蘋果 M 系列晶片上訓練的獲勝模型,蘋果晶片自 2022 年 5 月以來一直得到 PyTorch 的支援。

Google的雲端筆記本解決方案Colab 很受歡迎,有一位獲勝者使用免費套餐,一位使用Pro 套餐,另一位使用Pro (我們無法確定第四位獲勝者使用Colab 所使用的套餐)。

本地個人硬體比雲端硬體更受歡迎,儘管九名獲獎者提到了他們用於訓練的 GPU,但沒有具體說明他們使用的是本地 GPU 還是雲端 GPU。

最受歡迎的GPU 是最新的高階AI 加速卡NVIDIA A100(這裡將A100 40GB 和A100 80GB 放在一起,因為獲勝者並不總是區分兩者),而且通常使用多塊A100—— 例如,Zindi 的Turtle Recall 競賽的獲勝者使用8 塊A100(40GB)GPU,另外兩個獲勝者使用4 塊A100。

團隊組成

許多比賽允許每個團隊最多5 名參賽者,團隊可以由個人或較小的團隊在成績提交截止日期前的某個deadline 前「合併」在一起組成。

一些比賽允許更大的團隊,例如,Waymo 的開放資料挑戰允許每個團隊最多 10 個人。

#結論

#這是對 2022 年機器學習競賽的大致觀察。希望你可以從中找到一些有用資訊。

2023 年有許多令人興奮的新比賽,我們期待在這些比賽結束時發布更多見解。

以上是揭秘數據競賽勝利秘訣:探析A100在200場比賽中的優勢的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

DDREASE是一種用於從檔案或區塊裝置(如硬碟、SSD、RAM磁碟、CD、DVD和USB儲存裝置)復原資料的工具。它將資料從一個區塊設備複製到另一個區塊設備,留下損壞的資料區塊,只移動好的資料區塊。 ddreasue是一種強大的恢復工具,完全自動化,因為它在恢復操作期間不需要任何干擾。此外,由於有了ddasue地圖文件,它可以隨時停止和恢復。 DDREASE的其他主要功能如下:它不會覆寫恢復的數據,但會在迭代恢復的情況下填補空白。但是,如果指示工具明確執行此操作,則可以將其截斷。將資料從多個檔案或區塊還原到單

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如果您需要了解如何在Excel中使用具有多個條件的篩選功能,以下教學將引導您完成對應步驟,確保您可以有效地篩選資料和排序資料。 Excel的篩選功能是非常強大的,能夠幫助您從大量資料中提取所需的資訊。這個功能可以根據您設定的條件,過濾資料並只顯示符合條件的部分,讓資料的管理變得更有效率。透過使用篩選功能,您可以快速找到目標數據,節省了尋找和整理數據的時間。這個功能不僅可以應用在簡單的資料清單上,還可以根據多個條件進行篩選,幫助您更精準地定位所需資訊。總的來說,Excel的篩選功能是一個非常實用的

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

在iPhone上面臨滯後,緩慢的行動數據連線?通常,手機上蜂窩互聯網的強度取決於幾個因素,例如區域、蜂窩網絡類型、漫遊類型等。您可以採取一些措施來獲得更快、更可靠的蜂窩網路連線。修復1–強制重啟iPhone有時,強制重啟設備只會重置許多內容,包括蜂窩網路連線。步驟1–只需按一次音量調高鍵並放開即可。接下來,按降低音量鍵並再次釋放它。步驟2–過程的下一部分是按住右側的按鈕。讓iPhone完成重啟。啟用蜂窩數據並檢查網路速度。再次檢查修復2–更改資料模式雖然5G提供了更好的網路速度,但在訊號較弱

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂煉大模型,一網路的資料不夠用,根本不夠用。訓練模型搞得跟《飢餓遊戲》似的,全球AI研究者,都在苦惱怎麼才能餵飽這群資料大胃王。尤其在多模態任務中,這問題尤其突出。一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把「模型生成數據自己餵自己」變成了現實。而且還是理解側和生成側雙管齊下,兩側都能產生高品質、多模態的新數據,對模型本身進行數據反哺。模型是啥?中關村論壇上剛露面的多模態大模型Awaker1.0。團隊是誰?智子引擎。由人大高瓴人工智慧學院博士生高一鑷創立,高

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理