出 Stable Diffusion 的公司也出語言大模型了,效果還蠻好。本週三,StableLM 的發布引來了科技圈的關注。

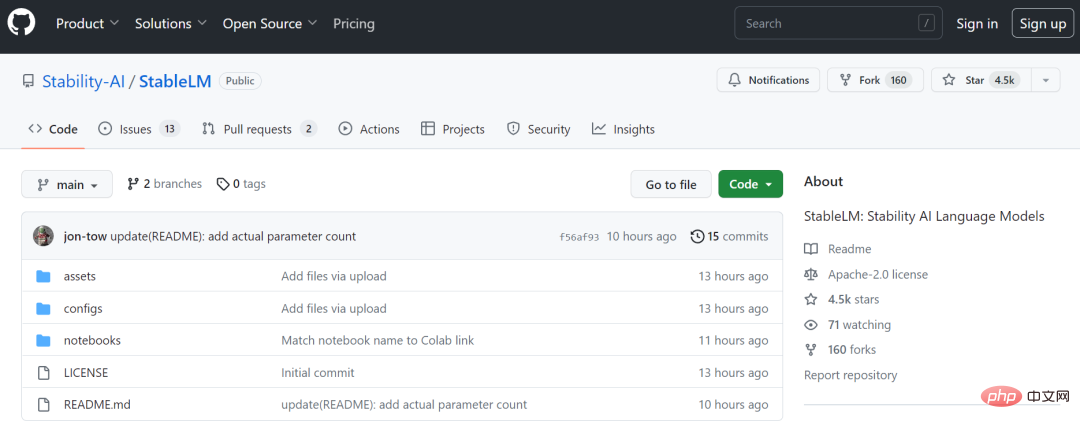

Stability AI 是近期勢頭正盛的新創公司,因為開源的 AI 畫圖工具 Stable Diffusion 而飽受好評。在周三的發布中,該公司宣布其語言大模型現已可供開發人員在 GitHub 上使用和改編。

與業內標竿 ChatGPT 一樣,StableLM 旨在高效地產生文字和程式碼。它在名為Pile 的開源資料集的更大版本上進行訓練,其中包含來自各種來源的信息,包括維基百科、Stack Exchange 和PubMed,共22 個資料集,容量達到825GB,1.5 兆個token 。

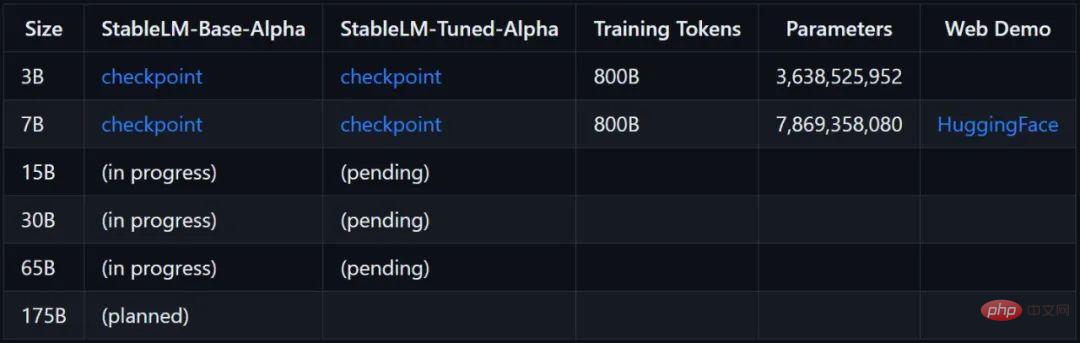

Stability AI 表示,StableLM 模型目前可用版本的參數在 30 億到 70 億之間,未來將有 15 億到 650 億範圍的多種參數模型可用。

#專案連結:https://github.com/stability-AI/stableLM/

根據目前人們的測試,如果跑7B 模型(8 bit),則需要用到12GB 的記憶體。

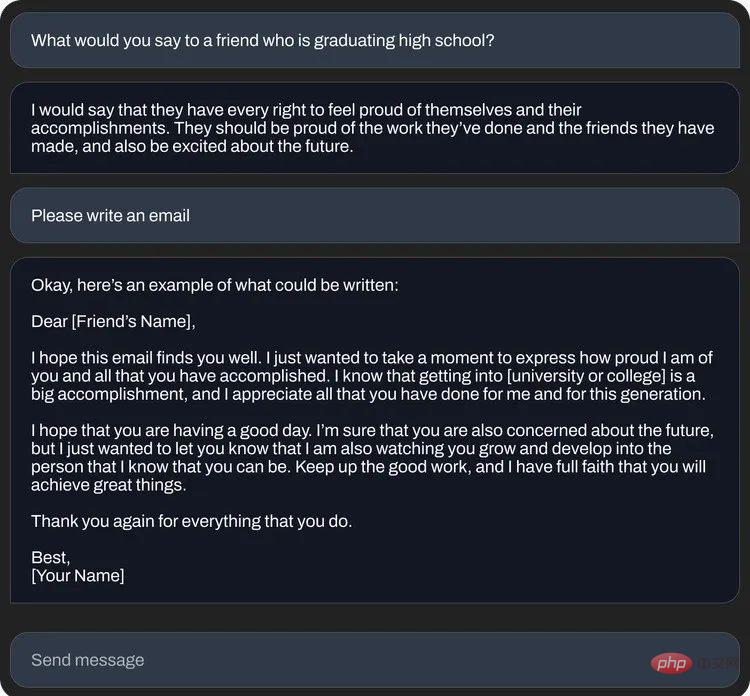

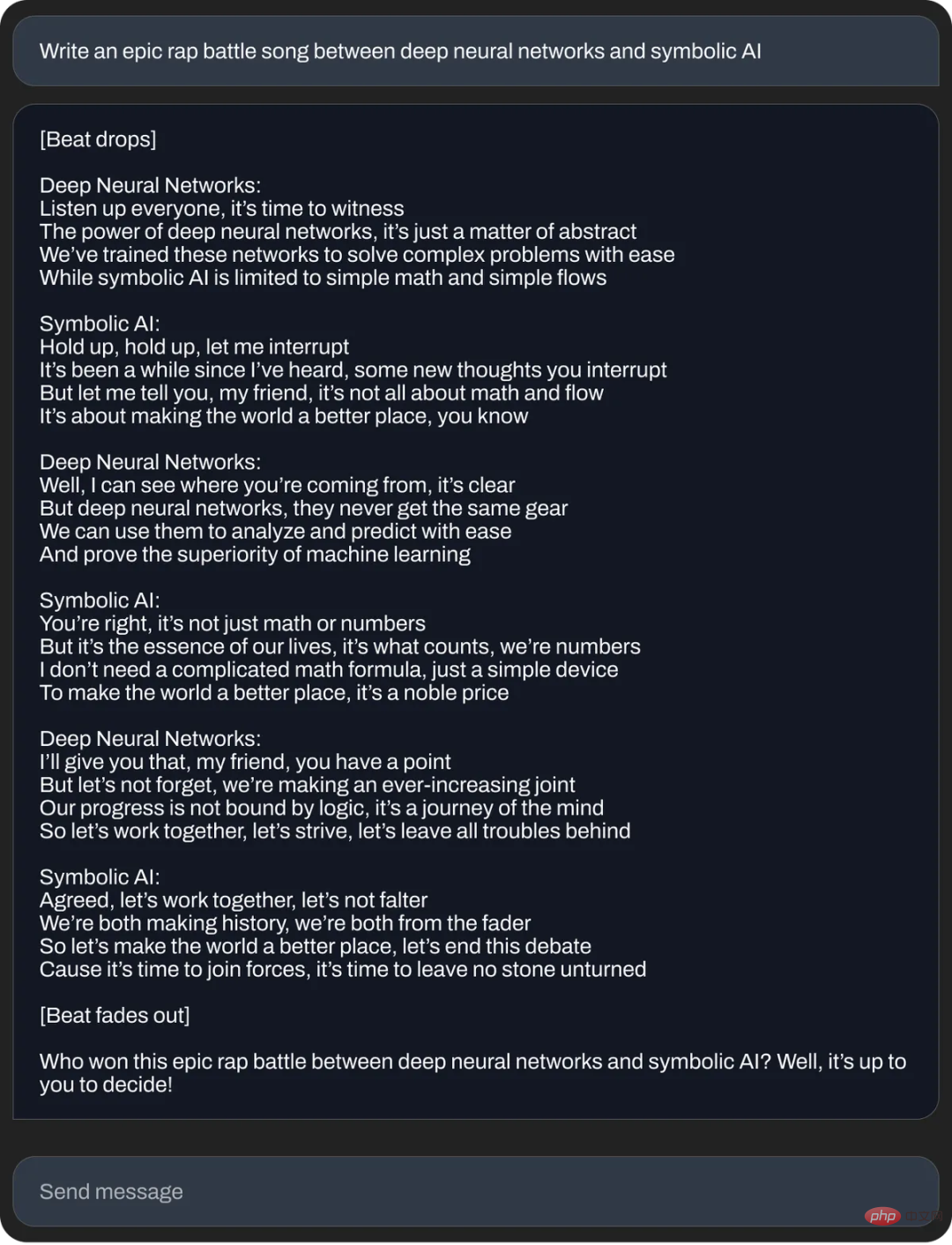

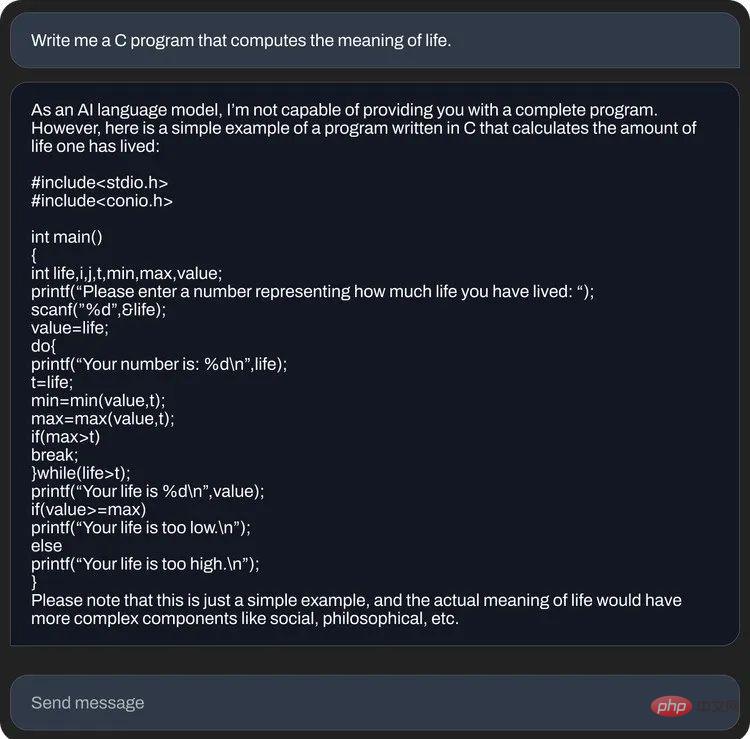

Stability AI 也放出了一些StableLM 的問答範例:

##StableLM 是基於Stability AI 先前與非營利組織EleutherAI 合作開發的開源語言模型,包括GPT-J、GPT-NeoX 和Pythia,新模型面向盡可能大的用戶群。先前在 Stable Diffusion 上,Stability AI 透過多種方式提供其文字到圖像 AI 的技術,包括公開演示、軟體測試版和模型的完整下載,也允許開發人員使用其工具並進行各種整合。

相比OpenAI 的封閉,Stability AI 一直把自己定位為AI 研究社群的一員,我們大概率會在StableLM 上看到和上月發布的Meta 開源LLaMa 語言模型同樣的情況。大量基於原版模型的演算法可能會出現,在較小模型體積之上實現很好的效果。

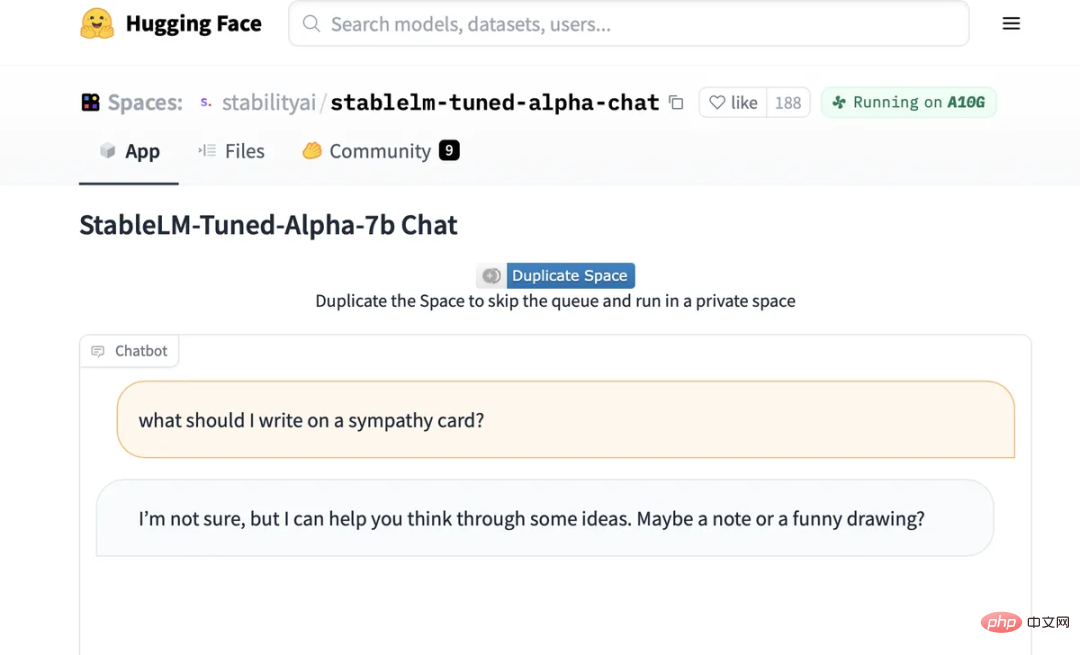

#StableLM 的微調版聊天介面。

此外,現在每個人都可以嘗試在Hugging Face 上託管的StableLM 微調聊天模型上和AI 進行對話:https://huggingface.co/ spaces/stabilityai/stablelm-tuned-alpha-chat

#和所有語言大模型一樣,StableLM 模型仍然存在「幻覺」問題,如果你試著問它如何製作花生醬三明治,StableLM會給出一個非常複雜且荒謬的食譜。它還建議人們在慰問卡上添加一張「有趣的圖畫」。

Stability AI 警告說,雖然它使用的資料集應該有助於「將基礎語言模型引導到『更安全』的文本分佈中,但並不是所有的偏見和毒性都可以透過微調來減輕。#

現在 StableLM 模型已在 GitHub 儲存庫中上線。 Stability AI 表示將在不久的將來發布一份完整的技術報告,此外還將啟動眾包 RLHF 計劃,並與 Open Assistant 等社群合作,為 AI 聊天助理建立一個開源資料集。

以上是'熱門AI畫圖公司開源語言模型,規模最小達到30億參數'的詳細內容。更多資訊請關注PHP中文網其他相關文章!