發布中文段落排序基準資料集:依據30萬真實查詢、200萬網路段落。

段落排序是資訊檢索領域中十分重要且具有挑戰性的議題,受到了學術界和工業界的廣泛關注。段落排序模型的有效性能夠提高搜尋引擎使用者的滿意度並且對問答系統、閱讀理解等資訊檢索相關應用有所助益。在這一背景下,例如 MS-MARCO,DuReader_retrieval 等一些基準資料集被建構用於支援段落排序的相關研究工作。然而常用的資料集大部分都關注英文場景,對於中文場景,已有的資料集在資料規模、細粒度的使用者標註和假負例問題的解決上有其限制。在這一背景下,我們基於真實搜尋日誌,建立了一個全新的中文段落排序基準資料集:T2Ranking。

T2Ranking由超過30 萬的真實查詢和200 萬的網路段落構成,並且包含了由專業標註人員提供的4 級細粒度相關性標註。目前數據和一些 baseline 模型已經公佈在 Github,相關研究工作已作為 Resource 論文被 SIGIR 2023 錄用。

- #論文資訊:Xiaohui Xie, Qian Dong, Bingning Wang, Feiyang Lv , Ting Yao, Weinan Gan, Zhijing Wu, Xiangsheng Li, Haitao Li, Yiqun Liu, and Jin Ma. T2Ranking: A large-scale Chinese Benchmark . SIGIR 2023.

- 論文網址:https://arxiv.org/abs/2304.03679

- Github 網址:https://github.com/THUIR/T2Ranking

背景與相關工作

段落排序任務的目標是基於給定的查詢詞,從一個大規模段落集合中召回並排序候選段落,依照相關性從高到低的順序得到段落清單。段落排序一般由段落回想和段落重新排序兩個階段組成。

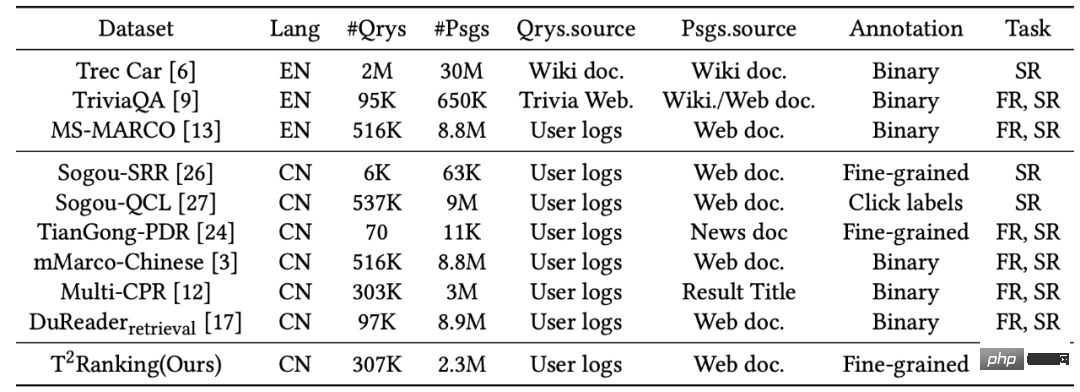

為了支援段落排序任務,多個資料集合被建構用於訓練和測試段落排序演算法。廣泛使用的資料集大多聚焦於英文場景,例如最常用的有 MS-MARCO 資料集,該資料集包含了 50 多萬個查詢詞和 800 多萬個段落,其中,每一個查詢詞都具有問題屬性。對於每一個查詢詞,MS-MARCO 資料發布團隊招募了標註人員提供了標準答案,根據給定段落是否包含人工提供的標準答案判斷這個段落是否與查詢詞相關。

在中文場景中,也有一些資料集被建構用來支援段落排序任務。例如mMarco-Chinese 是MS-MARCO 資料集的中文翻譯版本,DuReader_retrieval 資料集採用了和MS-MARCO 相同的範式生成段落標籤,即從人工提供的標準答案中來給定查詢詞- 段落對的相關性評分。 Multi-CPR 模型包含了來自三個不同領域(電子商務、娛樂影片和醫藥)的段落檢索資料。基於搜狗搜尋的日誌數據,Sogou-SRR,Sogou-QCL 和 Tiangong-PDR 等數據集也相繼被提出。

圖1:段落排序任務中常用資料集的統計資訊

#雖然已有資料集推進了段落排序應用的發展,我們也需要關注幾個限制:

1)這些資料集不是大規模的或相關性標籤不是人工標註的,特別是在中文場景下。 Sogou-SRR 和 Tiangong-PDR 僅包含了少量的查詢資料。雖然 mMarco-Chinese 和 Sogou-QCL 規模較大,但前者基於機器翻譯,後者採用的相關性標籤為使用者的點擊資料。最近,Multi-CPR 和 DuReader_retrieval 兩個規模相對較大的資料集被相繼建構和發布。

2)已有数据集缺乏细粒度的相关性标注信息。大部分数据集采用了二值相关性标注(粗粒度),即相关或者不相关。已有工作表明细粒度的相关性标注信息有助于挖掘不同实体之间的关系和构建更加精准的排序算法。然后已有数据集不提供或者仅提供少量的多级细粒度标注。例如 Sogou-SRR 或者 Tiangong-PDR 仅提供不超过 10 万个的细粒度标注。

3)假负例问题影响了评价的准确性。已有数据集受到了假负例问题的影响,即有大量相关文档被标记为不相关文档。这一问题是由于大规模数据中人工标注数量过少引起的,会显著影响评价的准确性。例如在 Multi-CPR 中,对于每一个查询词只有一个段落会被标记为相关,而其他都会被标记为不相关。DuReader_retrieval 尝试让标注者人工检查并且重新标注靠前的段落集合来缓解假负例问题。

为了能够更好地支持段落排序模型进行高质量的训练和评测,我们构建并且发布了一个新的中文段落检索基准数据集 - T2Ranking。

数据集构建流程

数据集的构建流程包括查询词采样,文档召回,段落提取和细粒度相关性标注。同时我们也设计了多个方法用于提升数据集质量,包括采用基于模型的段落切分方法和基于聚类的段落去重方法保证了段落的语义完整性和多样性,采用基于主动学习的标注方法提升标注的效率和质量等。

1)整体流程

- 查询词采样:我们从搜狗搜索引擎的搜索日志中采样了真实用户提交的查询词,经过去重和归一化处理后得到了初始查询词集合。接着,我们使用意图分析算法去除了色情查询,非疑问查询,资源申请类查询和可能包含用户信息的查询,保证最终查询数据集合仅包含高质量、具有问题属性的查询。

- 文档召回:基于采样得到的查询词,我们从搜狗、百度和谷歌等多个主流搜索引擎召回了文档候选集合,充分综合了这些搜索引擎在索引和排序文档方面的能力。因为这些搜索引擎能够覆盖互联网数据的不同部分并且能够返回多样化的文档结果,因此能够提高文档候选集合的完整性,并且在一定程度上缓解假负例问题。

- 段落提取:段落提取步骤涉及到段落分割和去重。不同于采用启发式方法在文档中分割段落(例如常规地通过换行符确定段落的开始和结束),我们训练了段落语义模型来进行段落分割,尽可能地保证每个段落的语义完整性。此外,我们还引入了一种基于聚类的技术来提高标注的效率并且保证了标注段落的多样性,这个技术能够有效地移除高度相似的段落。

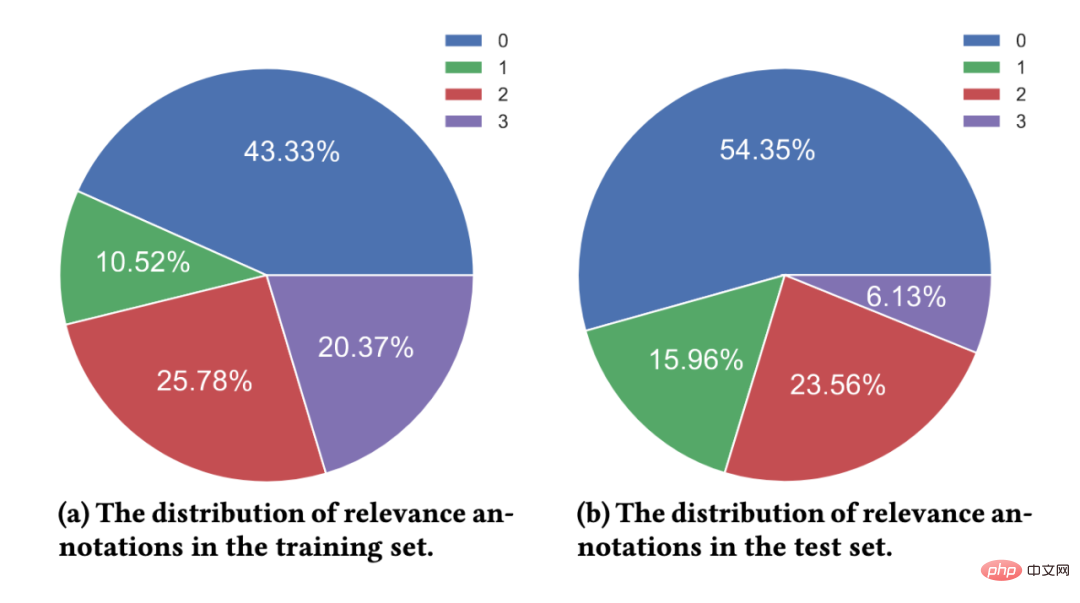

- 细粒度相关性标注:所聘请的标注人员均为搜索相关标注任务的专家,并且长期从事标注工作。对于每一个查询词 - 段落对,至少 3 名标注人员会提供标注。如果 3 名标注人员的标注结果均不一致,我们会引入额外的标注者进行标注,如果 4 名标注者的结果均不一致,我们倾向于认为这个查询词 - 段落对太过于模糊,质量较低且不太能够确定所需要的信息,从而将该查询词 - 段落对排除在数据集外。我们通过多数投票的方式来确定最终的相关性标签。我们采用的 4 级相关性标注指南与 TREC 基准一致。

- 级别 0:查询词与段落内容之间完全不相关

- 级别 1:段落内容与查询词相关,但不符合查询词的信息需求

- 级别 2:段落内容与查询词相关,能够部分满足查询词的信息需求

- 级别 3:段落内容能够完全满足查询词的信息需求,并且包含了准确答案。

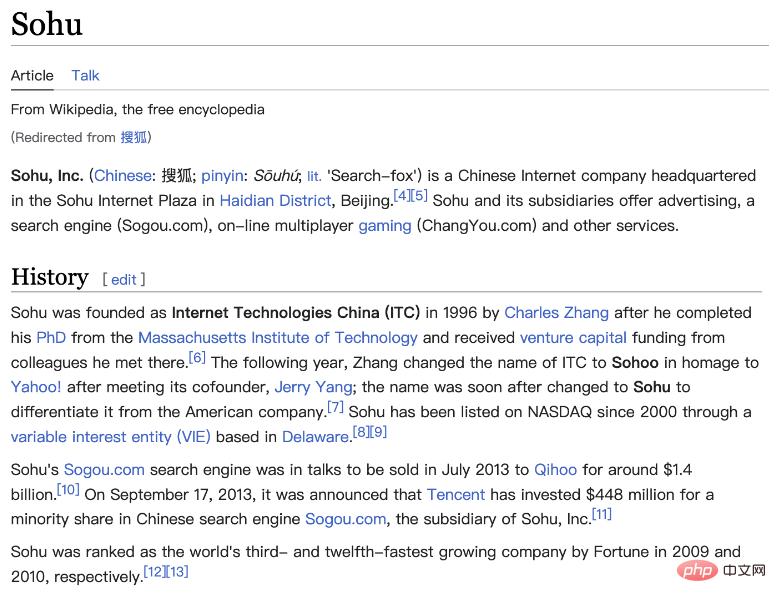

圖 2:維基百科頁面範例。所展示的文檔包含了清晰定義的段落。

2)基於模型的段落分割方法

在現有資料集中,段落通常是根據自然段落(換行符)或透過固定長度的滑動視窗從文件中分割得到的。然而,這兩種方法可能都會導致段落的語義不完整或因為段落過長而導致段落包含了多個不同的主題。在這項工作中,我們採用了基於模型的段落分割方法,具體而言,我們使用搜狗百科、百度百科和中文維基百科作為訓練數據,因為這部分文檔的結構是比較清晰的,並且自然段落也都得到了較好的定義。我們訓練了一個分割模型來判斷一個給定的單字是否需要作為分割點。我們利用了序列標註任務的思想,將每一個自然段的最後一個單字作為正例來訓練模型。

3)基於聚類的段落去重方法

#對高度相似的段落進行標註是冗餘和無意義的,對於段落排序模型而言,高度相似的段落內容帶來的資訊增益有限,因此我們設計了一個基於聚類的段落去重方法來提高標註的效率。具體而言,我們採用了一個層次化聚類演算法 Ward 對相似文件進行無監督聚類。在同一個類別中的段落被認為是高度相似的,我們從每一個類別中採樣一個段落進行相關性標註。需要注意的是,我們只在訓練集中進行這個操作,對於測試集,我們會對所有提取的段落進行完整標註,減少假負例的影響。

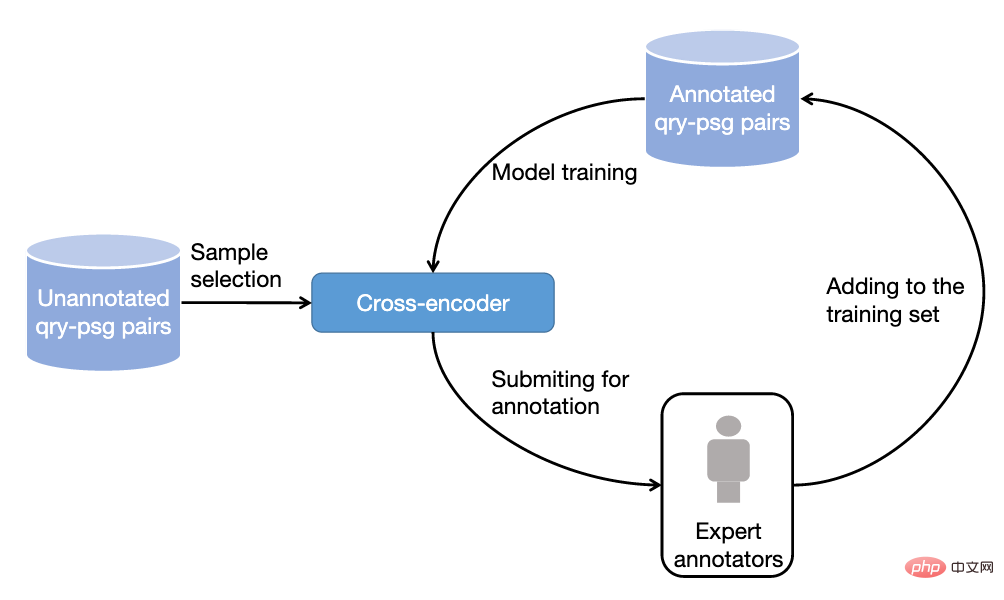

圖3:基於主動學習的取樣標註流程

4)基於主動學習的資料取樣標註方法

在實務中,我們觀察到並不是所有的訓練樣本都能夠進一步提升排序模型的效能。對於模型能夠準確預測的訓練樣本,對於後續模型的訓練效益有限。因此,我們借鑒了主動學習的想法,讓模型能夠選擇更有資訊量的訓練樣本進行進一步的標註。具體而言,我們先基於已有的訓練數據,訓練了一個以交叉編碼器為框架的查詢詞- 段落重排序模型,接著我們用這個模型對其他數據進行預測,去除過高置信分數(信息量低)和過低置信分數(雜訊資料)的段落,對保留的段落進行進一步標註,並迭代此流程。

資料集統計資料

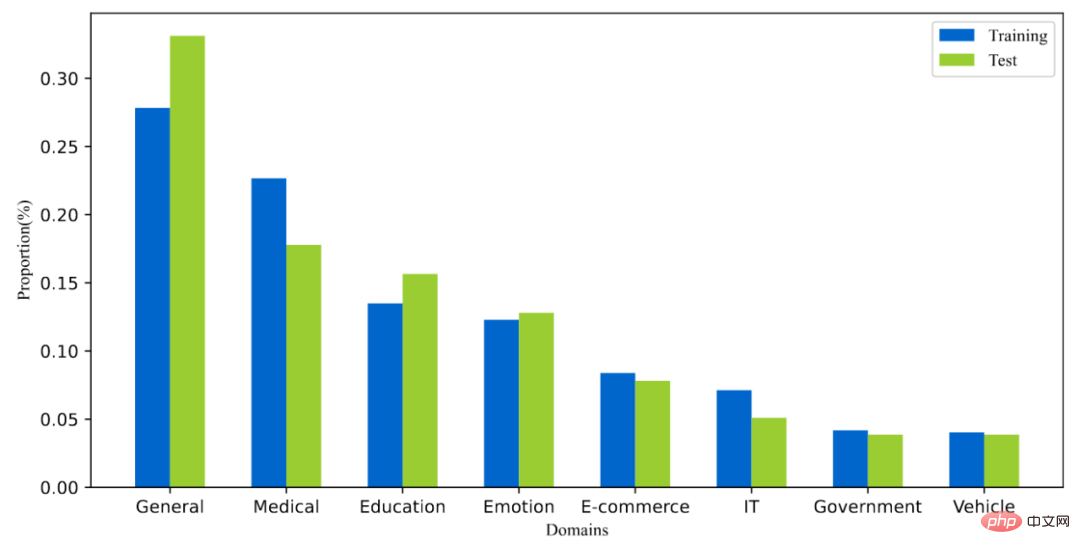

T2Ranking 由超過 30 萬的真實查詢和 200 萬的網路段落構成。其中,訓練集包含約 25 萬個查詢詞,測試集包含約 5 萬個查詢詞。查詢詞長度最長為 40 個字符,平均長度在 11 個字符左右。同時,資料集中的查詢詞涵蓋了多個領域,包括醫藥、教育、電商等,我們也計算了查詢詞的多樣性分數(ILS),與已有資料集相比,我們的查詢多樣性更高。採樣的 230 多萬個段落來自 175 萬個文檔,平均每個文檔被分割為了 1.3 個段落。在訓練集中,平均每個查詢詞有 6.25 個段落被人工標註,而在測試集中,平均每個查詢詞有 15.75 個段落被人工標註。

圖4:資料集中查詢詞的領域分佈情況

圖5:相關性標註分佈情況

常用模型的實驗結果

我們在所得到的資料集上,測試了一些常用的段落排序模型的性能,我們同時評測了已有方法在段落召回和段落重排序兩個階段上的效能。

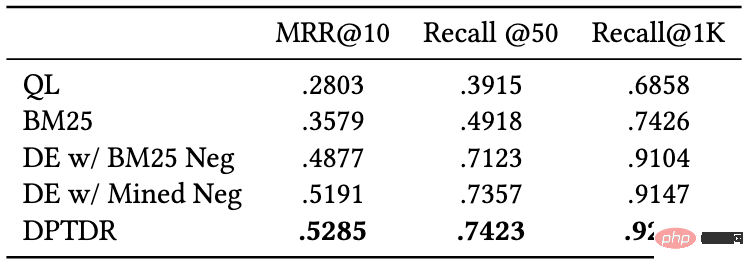

1)段落回想實驗

#已有的段落回想模型可以大致分為稀疏回想模型和稠密召回模型。

- 稀疏召回模型著重精確匹配訊號來設計相關性評分函數,例如 BM25 就是最具代表性的基準模型。

- 稠密召回模型則採用深度神經網路來學習低維度的稠密向量用於表徵查詢詞和段落。

我們測試了以下召回模型的表現:

- #QL(query likelihood):QL 是具有代表性的統計語言模型,根據段落產生給定查詢詞的機率來評估相關性。

- BM25:常用的稀疏召回基準模型。

- DE w/ BM25 Neg:即DPR 模型,雙塔編碼器結構(Dual-Encoder),該模型是第一個利用預訓練語言模型作為骨幹框架的段落召回模型。

- DE w/Mined Neg:雙塔編碼器結構(Dual-Encoder),透過從全量語料中召回難負例來增強 DPR 模型的效能。

- DPTDR:第一個採用提示微調(prompt tunning)的段落回想模型。

在這些模型中,QL 和 BM25 是稀疏召回模型,其他模型為稠密召回模型。我們採用MRR,Recall 等常用指標來評估這些模型的效能,實驗結果如下表所示:

圖6:段落召回模型在測試集上的表現

從實驗結果可以看出,相較於傳統的稀疏排序模型,稠密檢索模型取得了更好的表現。同時引入了難負例對於模型性能的提升也是有幫助的。值得一提的是,這些實驗模型在我們資料集上的召回表現比在其他資料集上的表現差,例如BM25 在我們的資料集上的Recall@50 是0.492,而在MS-Marco 和Dureader_retrieval上是0.601 和0.700。這可能是由於我們有更多的段落被進行了人工標註,在測試集中,平均每個查詢詞下我們有4.74 個相關文檔,這使得召回任務更加具有挑戰性且一定程度上降低了假負例的問題。這也說明了 T2Ranking 是一個具有挑戰的基準資料集,對未來的召回模型而言有較大的提升空間。

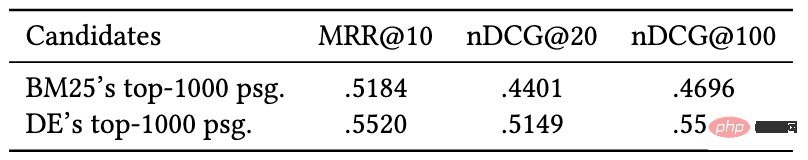

2)段落重新排序實驗

#相比於段落回想階段,重新排序階段需要考慮的段落規模較小,因此大多數方法傾向於使用交互編碼器(Cross-Encoder)作為模型框架,在本工作中,我們測試了交互編碼器模型在段落重排序任務上的性能,我們採用MRR 和nDCG作為評估指標,實驗效果如下:

#圖7:交互編碼器在段落重新排序任務上的表現

實驗結果表明,在雙塔編碼器(Dual-Encoder)召回的段落基礎上進行重排效果比在BM25 召回的段落基礎上重排能夠取得更好的效果,這與已有工作的實驗結論一致。與召回實驗類似,重排序模型在我們資料集上的表現比在其他資料集上的表現差,這可能是由於我們資料集採用了細粒度標註且具有更高的查詢詞多樣性造成,也進一步說明了我們的資料集是具有挑戰性的,並且能夠更精確地反映模型效能。

資料集發布團隊介紹

該資料集由清華大學電腦系資訊檢索課題組(THUIR)和騰訊公司QQ 瀏覽器搜尋技術中心團隊共同發布,得到了清華大學天工智能計算研究院的支持。 THUIR 主題小組聚焦搜尋與推薦方法研究,在使用者行為建模和可解釋學習方法等方面取得了典型成果,主題組成果實獲得了包括WSDM2022 最佳論文獎、SIGIR2020 最佳論文提名獎和CIKM2018 最佳論文獎在內的多項學術獎勵,並獲得了2020 年中文資訊學會「錢偉長中文資訊處理科學技術獎」 一等獎。 QQ 瀏覽器搜尋技術中心團隊是騰訊PCG 資訊平台與服務線負責搜尋技術研發的團隊,依托騰訊內容生態,透過使用者研究驅動產品創新,提供使用者圖文、資訊、小說、長短影片、服務等多方位的資訊需求滿足。

以上是發布中文段落排序基準資料集:依據30萬真實查詢、200萬網路段落。的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

DDREASE是一種用於從檔案或區塊裝置(如硬碟、SSD、RAM磁碟、CD、DVD和USB儲存裝置)復原資料的工具。它將資料從一個區塊設備複製到另一個區塊設備,留下損壞的資料區塊,只移動好的資料區塊。 ddreasue是一種強大的恢復工具,完全自動化,因為它在恢復操作期間不需要任何干擾。此外,由於有了ddasue地圖文件,它可以隨時停止和恢復。 DDREASE的其他主要功能如下:它不會覆寫恢復的數據,但會在迭代恢復的情況下填補空白。但是,如果指示工具明確執行此操作,則可以將其截斷。將資料從多個檔案或區塊還原到單

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如果您需要了解如何在Excel中使用具有多個條件的篩選功能,以下教學將引導您完成對應步驟,確保您可以有效地篩選資料和排序資料。 Excel的篩選功能是非常強大的,能夠幫助您從大量資料中提取所需的資訊。這個功能可以根據您設定的條件,過濾資料並只顯示符合條件的部分,讓資料的管理變得更有效率。透過使用篩選功能,您可以快速找到目標數據,節省了尋找和整理數據的時間。這個功能不僅可以應用在簡單的資料清單上,還可以根據多個條件進行篩選,幫助您更精準地定位所需資訊。總的來說,Excel的篩選功能是一個非常實用的

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

在iPhone上面臨滯後,緩慢的行動數據連線?通常,手機上蜂窩互聯網的強度取決於幾個因素,例如區域、蜂窩網絡類型、漫遊類型等。您可以採取一些措施來獲得更快、更可靠的蜂窩網路連線。修復1–強制重啟iPhone有時,強制重啟設備只會重置許多內容,包括蜂窩網路連線。步驟1–只需按一次音量調高鍵並放開即可。接下來,按降低音量鍵並再次釋放它。步驟2–過程的下一部分是按住右側的按鈕。讓iPhone完成重啟。啟用蜂窩數據並檢查網路速度。再次檢查修復2–更改資料模式雖然5G提供了更好的網路速度,但在訊號較弱

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂煉大模型,一網路的資料不夠用,根本不夠用。訓練模型搞得跟《飢餓遊戲》似的,全球AI研究者,都在苦惱怎麼才能餵飽這群資料大胃王。尤其在多模態任務中,這問題尤其突出。一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把「模型生成數據自己餵自己」變成了現實。而且還是理解側和生成側雙管齊下,兩側都能產生高品質、多模態的新數據,對模型本身進行數據反哺。模型是啥?中關村論壇上剛露面的多模態大模型Awaker1.0。團隊是誰?智子引擎。由人大高瓴人工智慧學院博士生高一鑷創立,高