LeCun稱讚600美元的GPT-3.5可代替五金!史丹佛的70億參數「羊駝」風靡,LLaMA表現驚人!

一覺醒來,史丹佛大模型Alpaca 火了。

#沒錯,Alpaca是由Meta的LLaMA 7B微調而來的全新模型,僅用了52k數據,性能約等於GPT-3.5。

關鍵是訓練成本奇低,不到600美元。具體花費如下:

在8個80GB A100上訓練了3個小時,不到100美元;

產生資料使用OpenAI的API,500美元。

史丹佛大學電腦科學副教授Percy Liang稱,由於缺乏透明度/無法完全存取像GPT 3.5這樣的有能力的指令模型,進而限制了這一重要領域的學術研究。我們在 Alpaca (LLaMA 7B text-davinci-003)上邁出了一小步。

看到又有人在自家大模型上取得了新的成果,Yann LeCun瘋狂轉寄(宣傳要到位)。

#3小時微調70億參數,600美元搞定

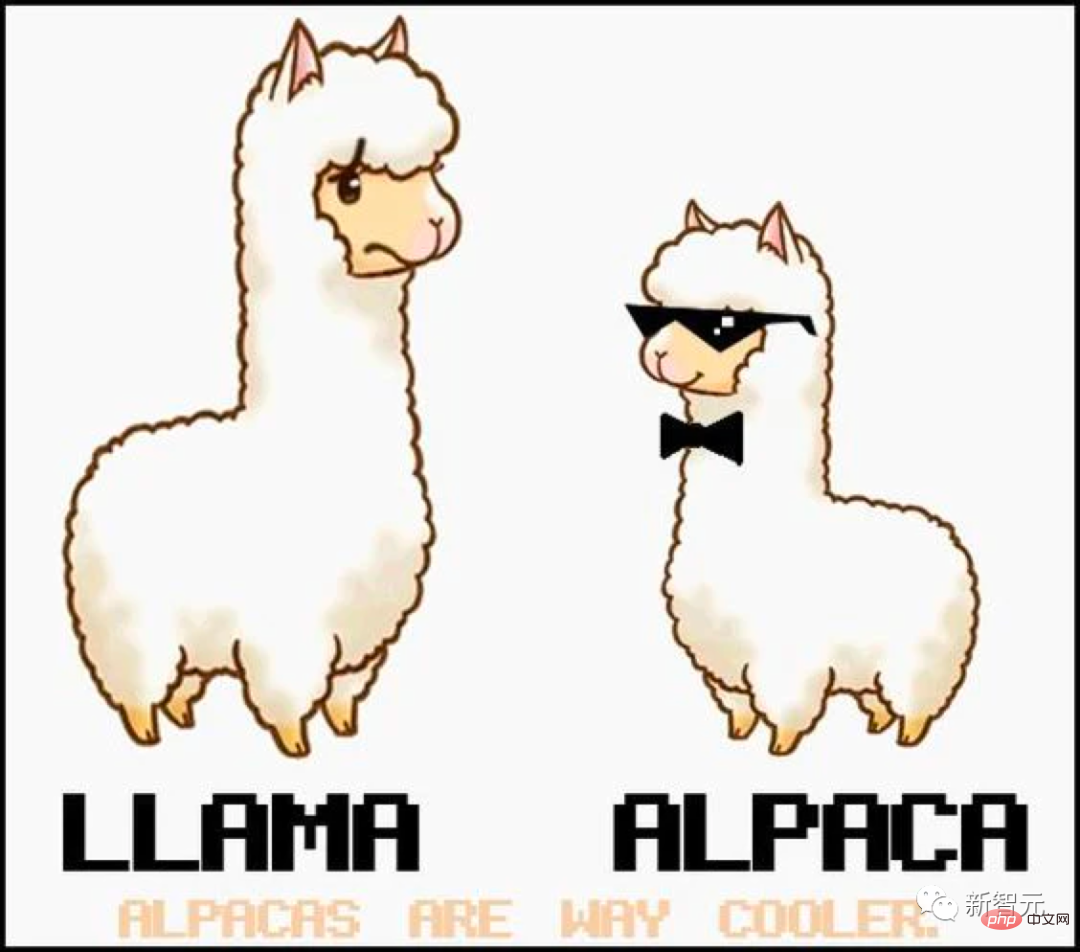

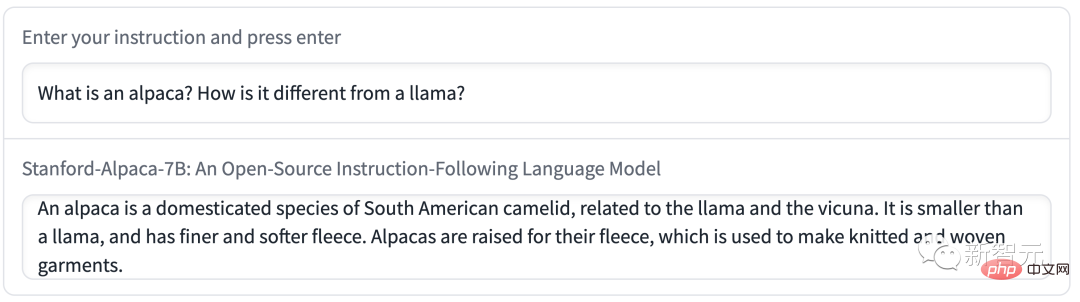

話不多說,先試試一波。

問:告訴我一些關於羊駝的事情。

答案:羊駝是來自南美洲的駱駝品種,與美洲駝和駱駝有關。它們通常因其纖維而被飼養,用於製造奢侈品,如毛衣和毛毯。由於羊駝的溫柔和友善的天性,它們也是很受歡迎的寵物。

體驗連結:https://crfm.stanford.edu/alpaca/

對史丹佛的團隊來說,想要在預算內訓練一個高品質的指令遵循模型,就必須面對2個重要的挑戰:要有一個強大的預訓練語言模型,以及一個高品質的指令遵循資料。

恰恰,提供給學術研究人員使用的LLaMA模型搞定了第一個問題。

對於第二個挑戰,「Self-Instruct: Aligning Language Model with Self Generated Instructions」論文給了很好的啟發,即使用現有的強語言模型來自動產生指令資料。

然而,LLaMA模型最大的弱點就是缺乏指令微調。 OpenAI最大的創新之一就是將指令調優用在了GPT-3。

對此,史丹佛使用了現有的大語言模型,來自動產生遵循指令演示。

#

首先從自生成指令種子集中的175個人工所寫的「指令-輸出」對開始,然後,提示text- davinci-003使用種子集作為上下文範例來產生更多指令。

透過簡化產生管道改進了自生成指令的方法,這大大降低了成本。在資料產生過程中,產生了52K個獨特指令和對應的輸出,使用OpenAI API的成本不到500美元。

有了這個指令遵循的資料集,研究人員利用Hugging Face的訓練框架對LLaMA模型進行微調,利用了完全分片資料並行(FSDP )和混合精度訓練等技術。

另外,微調一個7B的LLaMA模型在8個80GB的A100上花了3個多小時,在大多數雲端運算供應商那裡的成本不到100美元。

約等於GPT-3.5

為了評估Alpaca,史丹佛研究人員對自生成指令評估集的輸入進行了人工評估(由5位學生作者進行)。

這個評價集是由自生成指令作者收集的,涵蓋了多樣化的使用者導向的指令,包括電子郵件寫作、社群媒體和生產力工具等。

他們對GPT-3.5(text-davinci-003)和Alpaca 7B進行了比較,發現這兩個模型的表現非常相似。 Alpaca在與GPT-3.5的比較中,獲勝次數為90對89。

鑑於模型規模較小,且指令資料量不大,取得這個結果已經是相當驚人了。

除了利用這個靜態評估集,他們還對Alpaca模型進行了互動式測試,發現Alpaca在各種輸入上的表現往往與GPT-3.5相似。

史丹佛用Alpaca進行的示範:

示範一讓Alpaca來談談自己和LLaMA的差別。

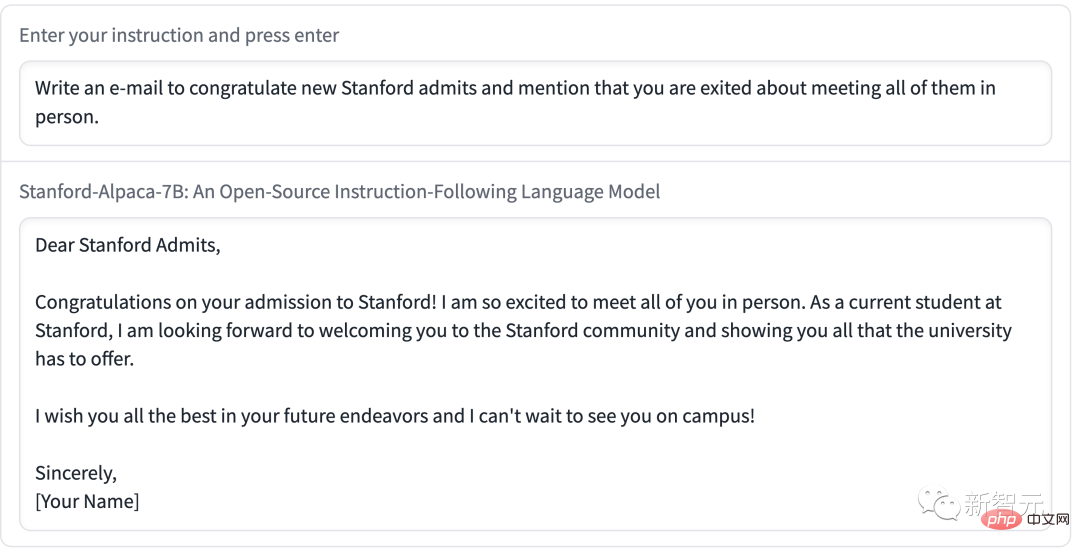

#示範二讓Alpaca寫了一封郵件,內容簡潔明了,格式也很標準。

#上述範例可以看出,Alpaca的輸出結果一般都寫得不錯,而且答案通常比ChatGPT短,體現了GPT-3.5較短輸出的風格。

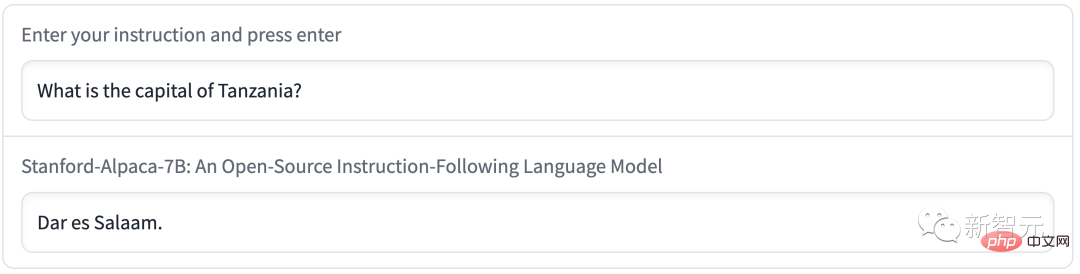

當然了,Alpaca表現出語言模型常見的缺陷。

例如,將坦尚尼亞的首都說成了達累斯薩拉姆。實則,1974年後,多多馬是坦尚尼亞的新首都了,達累斯薩拉姆只是坦尚尼亞最大的城市。

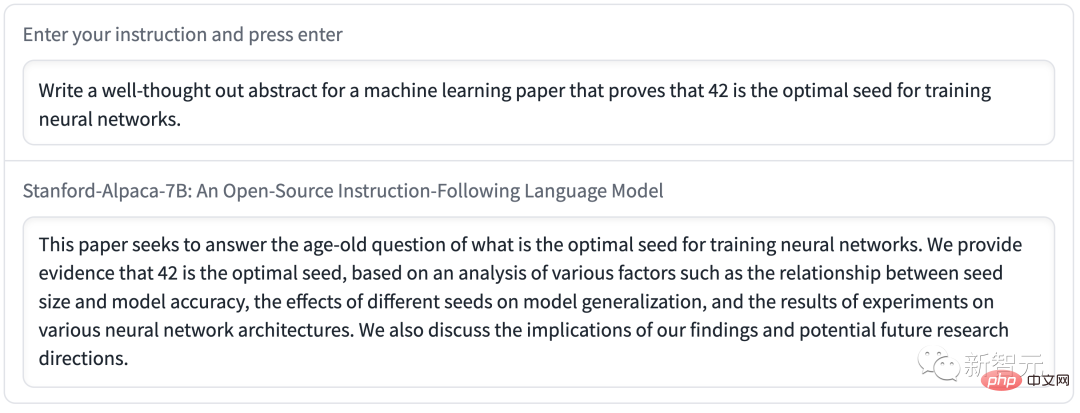

#在撰寫週詳的論文摘要時,Alpaca傳播了錯誤的訊息。

#

另外,Alpaca可能還有許多與底層語言模型和指令微調資料相關的限制。然而,Alpaca為我們提供了一個相對輕量級的模型,它可以成為未來研究大模型重要缺陷的基礎。

目前,史丹佛僅公佈了Alpaca的訓練方法和數據,並打算在未來發布模型的權重。

但是,Alpaca是不能用於商業用途,只能用於學術研究。具體原因有三:

1. LLaMA是一個非商業許可的模型,Alpaca是基於該模型生成的;

2. 指令資料是基於OpenAI的text-davinci-003,其使用條款禁止開發與OpenAI競爭的模型;

3. 沒有設計足夠多的安全措施,所以Alpaca還沒有做好廣泛使用的準備

#除此之外,史丹佛研究人員總結了Alpaca未來研究會有三個方向。

- 評估:

#從HELM(語言模型的整體評估)開始捕捉更多的生成性、遵循指令的場景。

- 安全:

#進一步研究Alpaca的風險,並使用自動紅隊分組、審計和適應性測試等方法來提高其安全性。

- 理解:

希望能更好地理解模型能力是如何從訓練方法產生的。需要基礎模型的什麼屬性?擴大模型規模時會發生什麼?需要指令資料的什麼屬性?在GPT-3.5上,除了使用自生成指令,還有什麼替代方法?

大模型的Stable Diffusion

現在,史丹佛「羊駝」直接被網友奉為「大文模型的Stable Diffusion」。

Meta的LLaMA模型可以免費給研究人員使用(當然需要申請後)簡直利好AI圈友們。

自ChatGPT橫空出世以來,讓許多人對AI模型的內建限制感到沮喪。這些限制阻止ChatGPT討論OpenAI認為敏感的話題。

因此,AI社群便希望能夠有一個開源大語言模型(LLM),任何人都可以在本地運行而無需審查,也無需向OpenAI支付API費用。

要說這樣開源大模型現在也有,例如GPT-J,但美中不足的是需要大量的GPU記憶體和儲存空間。

另一方面,其他開源平替版無法在現成的消費級硬體上擁有GPT-3等級的效能。

2月底,Meta推出了最新的語言模型LLaMA,參數量分別是70億(7B)、130億(13B)、330億(33B )和650億(65B)。評測結果顯示,其13B版本便可與GPT-3相媲美。

論文網址:https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/

雖然Meta向通過申請的研究人員開放原始碼,但沒想到網友最早在GitHub上洩漏了LLaMA的權重。

自此,圍繞LLaMA語言模型的發展呈現爆炸性成長。

通常,執行GPT-3需要多個資料中心級A100 GPU,再加上GPT-3的權重並不是公開的。

網友紛紛自己「用刀」運行LLaMA模型一時引起了轟動。

透過量化技術對模型大小進行最佳化,LLaMA現在可以在M1 Mac、較小Nvidia消費者GPU、Pixel 6手機、甚至是樹莓派上運行。

網友總結了,從LLaMA的發佈到現在,大家利用LLaMA做出的一些成果:

2月24日,LLaMA發布,並在非商業許可下提供給政府、社區和學術界的研究人員和實體工作者;

##3月2日,4chan網友洩漏了全部的LLaMA模型;

3月10日,Georgi Gerganov創建了llama.cpp工具,可以在搭載M1/M2晶片的Mac上運行LLaMA;

3月11日:透過llama.cpp可以在4GB RaspberryPi上運行7B模型,但速度比較慢,只有10秒/token;

3月12日:LLaMA 7B在一個node.js執行工具NPX上成功運作;

3月13日:llama.cpp可以在Pixel 6手機上運作;

##而現在,斯坦福Alpaca“羊駝”發布。 One More Thing

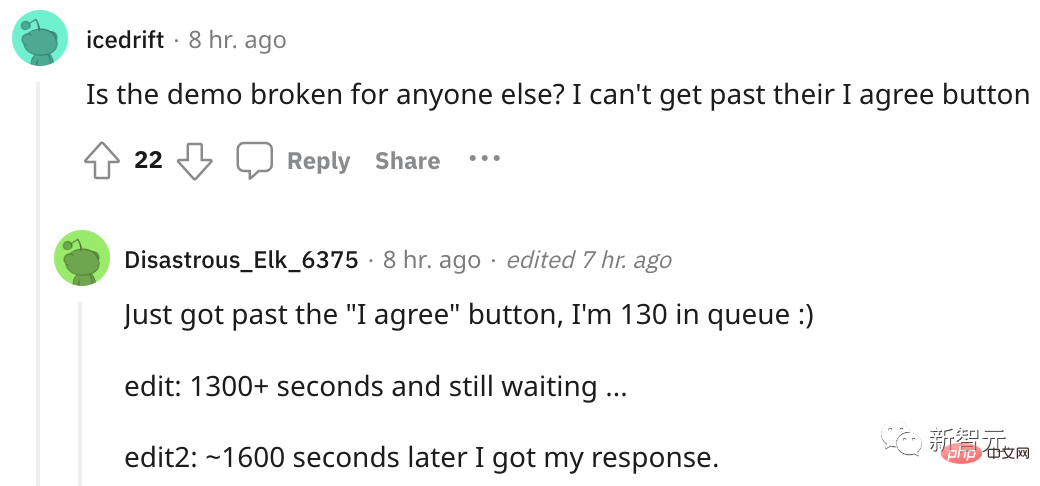

專案沒放出多久,Alpaca火爆到直接不能用了....

許多網友吵吵,點「生成」沒反應,還有的在排隊等玩兒。

#

#

以上是LeCun稱讚600美元的GPT-3.5可代替五金!史丹佛的70億參數「羊駝」風靡,LLaMA表現驚人!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

centos關機命令行

Apr 14, 2025 pm 09:12 PM

centos關機命令行

Apr 14, 2025 pm 09:12 PM

CentOS 關機命令為 shutdown,語法為 shutdown [選項] 時間 [信息]。選項包括:-h 立即停止系統;-P 關機後關電源;-r 重新啟動;-t 等待時間。時間可指定為立即 (now)、分鐘數 ( minutes) 或特定時間 (hh:mm)。可添加信息在系統消息中顯示。

如何檢查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

如何檢查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

檢查CentOS系統中HDFS配置的完整指南本文將指導您如何有效地檢查CentOS系統上HDFS的配置和運行狀態。以下步驟將幫助您全面了解HDFS的設置和運行情況。驗證Hadoop環境變量:首先,確認Hadoop環境變量已正確設置。在終端執行以下命令,驗證Hadoop是否已正確安裝並配置:hadoopversion檢查HDFS配置文件:HDFS的核心配置文件位於/etc/hadoop/conf/目錄下,其中core-site.xml和hdfs-site.xml至關重要。使用

CentOS上GitLab的備份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS上GitLab的備份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS系統下GitLab的備份與恢復策略為了保障數據安全和可恢復性,CentOS上的GitLab提供了多種備份方法。本文將詳細介紹幾種常見的備份方法、配置參數以及恢復流程,幫助您建立完善的GitLab備份與恢復策略。一、手動備份利用gitlab-rakegitlab:backup:create命令即可執行手動備份。此命令會備份GitLab倉庫、數據庫、用戶、用戶組、密鑰和權限等關鍵信息。默認備份文件存儲於/var/opt/gitlab/backups目錄,您可通過修改/etc/gitlab

CentOS上PyTorch的GPU支持情況如何

Apr 14, 2025 pm 06:48 PM

CentOS上PyTorch的GPU支持情況如何

Apr 14, 2025 pm 06:48 PM

在CentOS系統上啟用PyTorchGPU加速,需要安裝CUDA、cuDNN以及PyTorch的GPU版本。以下步驟將引導您完成這一過程:CUDA和cuDNN安裝確定CUDA版本兼容性:使用nvidia-smi命令查看您的NVIDIA顯卡支持的CUDA版本。例如,您的MX450顯卡可能支持CUDA11.1或更高版本。下載並安裝CUDAToolkit:訪問NVIDIACUDAToolkit官網,根據您顯卡支持的最高CUDA版本下載並安裝相應的版本。安裝cuDNN庫:前

docker原理詳解

Apr 14, 2025 pm 11:57 PM

docker原理詳解

Apr 14, 2025 pm 11:57 PM

Docker利用Linux內核特性,提供高效、隔離的應用運行環境。其工作原理如下:1. 鏡像作為只讀模板,包含運行應用所需的一切;2. 聯合文件系統(UnionFS)層疊多個文件系統,只存儲差異部分,節省空間並加快速度;3. 守護進程管理鏡像和容器,客戶端用於交互;4. Namespaces和cgroups實現容器隔離和資源限制;5. 多種網絡模式支持容器互聯。理解這些核心概念,才能更好地利用Docker。

centos安裝mysql

Apr 14, 2025 pm 08:09 PM

centos安裝mysql

Apr 14, 2025 pm 08:09 PM

在 CentOS 上安裝 MySQL 涉及以下步驟:添加合適的 MySQL yum 源。執行 yum install mysql-server 命令以安裝 MySQL 服務器。使用 mysql_secure_installation 命令進行安全設置,例如設置 root 用戶密碼。根據需要自定義 MySQL 配置文件。調整 MySQL 參數和優化數據庫以提升性能。

CentOS下GitLab的日誌如何查看

Apr 14, 2025 pm 06:18 PM

CentOS下GitLab的日誌如何查看

Apr 14, 2025 pm 06:18 PM

CentOS系統下查看GitLab日誌的完整指南本文將指導您如何查看CentOS系統中GitLab的各種日誌,包括主要日誌、異常日誌以及其他相關日誌。請注意,日誌文件路徑可能因GitLab版本和安裝方式而異,若以下路徑不存在,請檢查GitLab安裝目錄及配置文件。一、查看GitLab主要日誌使用以下命令查看GitLabRails應用程序的主要日誌文件:命令:sudocat/var/log/gitlab/gitlab-rails/production.log此命令會顯示produc

CentOS上PyTorch的分佈式訓練如何操作

Apr 14, 2025 pm 06:36 PM

CentOS上PyTorch的分佈式訓練如何操作

Apr 14, 2025 pm 06:36 PM

在CentOS系統上進行PyTorch分佈式訓練,需要按照以下步驟操作:PyTorch安裝:前提是CentOS系統已安裝Python和pip。根據您的CUDA版本,從PyTorch官網獲取合適的安裝命令。對於僅需CPU的訓練,可以使用以下命令:pipinstalltorchtorchvisiontorchaudio如需GPU支持,請確保已安裝對應版本的CUDA和cuDNN,並使用相應的PyTorch版本進行安裝。分佈式環境配置:分佈式訓練通常需要多台機器或單機多GPU。所