喬姆斯基對ChatGPT的追捧提出質疑,認為是浪費資源

ChatGPT 掀起了科技領域最新的一輪軍備競賽,但留給 AI 領域的議題還有很多:ChatGPT 是真正的創新嗎?是否意味著初步的通用人工智慧?許多學者持有不同看法,這種討論隨著新技術的熱度而愈發熱烈。

那麼語言學領域的大佬們又如何看待 ChatGPT 的進步呢?特別是喬老爺 —— 語言學巨頭喬姆斯基。

近日,美國哲學家、語言學家、認知科學家諾姆・喬姆斯基、劍橋大學語言學教授Ian Roberts 以及科技公司Oceanit 人工智慧總監、哲學家Jeffrey Watumull 在《紐約時報》撰文,對大語言模型的缺陷進行了批判。

為了追趕 ChatGPT 的步伐,Google發布了 Bard,微軟也推出了 Sydney。喬姆斯基承認,OpenAI 的 ChatGPT、Google的 Bard 和微軟的 Sydney 都是機器學習的奇蹟。

籠統地說,它們獲取大量數據,在其中搜尋規律,並且越來越熟練地產生統計上可能的輸出 —— 例如看似人性化的語言和思想。

這些程式被譽為通用人工智慧地平線上的第一道曙光—— 那是一個長期預言的時刻,屆時機械思維不僅會在處理速度和記憶體大小方面超越人類大腦,而且還會在洞察力、藝術創造力,以及所有其他獨特的人類能力上超越人類。

但喬姆斯基更多的觀點在於批判,特別是對於ChatGPT 的能力缺陷和道德水準:「今天,我們在人工智慧方面所謂的革命性進步確實令人們既擔憂又樂觀。樂觀,是因為智慧是我們解決問題的手段,擔憂是因為我們擔心最流行和最時髦的人工智能—— 機器學習,將通過將有根本缺陷的語言和知識概念納入我們的技術,而降低我們的科學水平並拉低我們的道德規範。」

客觀上,那一天可能終究會到來,但曙光還沒有出現,這與誇張的新聞標題和不明智的投資所預料的情況正好相反。

現在,讓我們看看喬姆斯基的文章還說了什麼。

ChatGPT 缺乏任何智慧的關鍵能力

阿根廷作家豪爾赫・路易斯・博爾赫斯(Jorge Luis Borges)曾寫道,生活在一個既充滿危險又充滿希望的時代,既是悲劇又是喜劇,在理解我們自己和這個世界時「啟示迫在眉睫」。

「如果像ChatGPT 這樣的機器學習程式繼續主導人工智慧領域,博爾赫斯式的理解啟示沒有且未來也不會發生。」

#不管這些程式在某些狹窄的領域中多麼有用(例如,它們可以在電腦程式設計中有所幫助,或者在為詩詞押韻建議方面很有幫助),我們從語言學和知識哲學中知道它們與人類推理和實用語言的方式有很大的不同。這些差異極大地限制了這些程序的功能,使它們帶有無法根除的缺陷。

正如博爾赫斯可能指出的那樣,如此多的金錢和注意力被集中在這麼小的一件事上,這既是喜劇又是悲劇 —— 與人類的思想相比,這是微不足道的,用德國哲學家威廉・馮・洪堡的話來說,人類的思想是透過語言,可以「無限地使用有限的手段」,創造出具有普遍影響力的思想和理論。

人腦不像ChatGPT 及其同類產品那樣,是一個笨拙的模式匹配統計引擎,吞噬數百TB 的數據並推斷出最可能的對話回應或最可能的科學問題答案。相反,人的大腦是一個非常高效甚至優雅的系統,只需要少量資訊即可運作;它不尋求推斷數據點之間的直接相關性,而是尋求解釋。

例如一個正在學習語言的小孩正在無意識地、自動地、快速地從極小的數據中發展出一種語法,一種由邏輯原則和參數組成的極其複雜的系統。這種語法可以理解為先天的、遺傳安裝的「操作系統」的表達,它賦予人類產生複雜句子和長串思路的能力。

當語言學家試圖發展一種理論來解釋為什麼給定的語言會這樣工作時(為什麼這些—— 而不是那些句子被認為是合乎語法的?),他們正在有意識地、費力地建構孩子本能建構的語法的明確版本,同時在這個過程中盡可能少地接觸訊息。孩子的作業系統與機器學習程式的作業系統完全不同。

實際上,ChatGPT 這樣的程式停留在認知演化前的人類或非人類階段。它們最深的缺陷是缺乏任何智慧的關鍵能力:不僅可以說出情況是什麼、已經發生了什麼以及將要發生什麼—— 這是描述和預測—— 而且還可以說出這種情況不是什麼,以及可能發生什麼,不應該發生什麼。這些是解釋的成分,是真正智慧的標誌。

這裡有一個例子:假設你手裡拿著一個蘋果,現在讓蘋果掉下來,你觀察結果並說:「蘋果掉下來了。」這就是一種描述。預測的說法則是「如果我張開手,蘋果就會掉下來」。兩者都是有價值的,而且都可能是正確的。

但解釋意味著更多的東西。它不僅包括描述和預測,還包括反事實的猜想,如 “任何這樣的物體都會掉下來”,再加上附加條款“因為引力”或“因為時空的曲率”或其他,這就是一個因果解釋。 「如果不是因為引力,蘋果就不會掉下來」,這就是思維。

機器學習的核心是描述和預測;它沒有提出任何因果機製或物理規律。當然,任何人類式的解釋都不一定正確;我們是易變的。但這也是思考的部分意義:要正確,必須有可能出錯。智能不僅包括創造性的猜想,也包括創造性的批評。人類式的思考是基於可能的解釋和糾錯,這個過程逐漸限制了可以理性地考慮的可能性。

正如夏洛克・福爾摩斯對華生所說:「當你排除了不可能,剩下的任何東西,無論多麼不可能,都肯定是真理。」

但是從設計上來說,ChatGPT 和類似的程式在它們能夠「學習」(也就是記憶)的內容方面是沒有限制的;它們沒有能力區分「可能」和「不可能」。例如,人類被賦予了一種通用的語法,將我們能夠學習的語言限制在某種近乎數學的優雅上,而這些程式則以同樣的方式學習人類可能的和不可能的語言。人類在我們可以合理猜測的解釋種類方面受到限制,而機器學習系統可以學習地球是平的和地球是圓的。它們只是在隨時間變化的機率中進行交易。

由於這個原因,機器學習系統的預測將永遠是膚淺和可疑的。例如,由於這些程序無法解釋英語語法規則,它們很可能錯誤地預測“約翰太固執了,不願意和他說話”,其意味著約翰太固執了,他不會和某人或其他人說話(而不是說他太固執了,不願意被說教)。為什麼機器學習程式會預測出如此奇怪的事情?因為它可能會把它從“約翰吃了一個蘋果”和“約翰吃了”這樣的句子中推斷出來的模式進行類比,後者確實是指約翰吃了什麼或其他東西。這個程序很可能預測,因為“約翰太固執了,不願意和比爾說話”與“約翰吃了一個蘋果”相似,所以“約翰太固執了,不願意和他說話”應該與“約翰吃了”相似。語言的正確解釋是複雜的,並不是僅僅透過在大數據中浸泡就能學會。

反常的是,一些機器學習愛好者似乎很自豪,他們的作品可以產生正確的「科學」預測(例如關於物理體的運動),而不使用解釋(例如牛頓的運動定律和普遍引力)。但這種預測即使成功了也是偽科學。雖然科學家肯定會尋求有高度經驗佐證的理論,但正如哲學家卡爾- 波普爾所指出的:「我們尋求的不是高度可能的理論而是解釋,也就是強大而高度不可能的理論。」

蘋果落到地球上是因為那是它們的「自然位置」(亞里斯多德的觀點)的理論是可能的,但它只會導致進一步的問題:為什麼地球是它們的自然位置?

蘋果落到地上是因為質量使時空彎曲的理論(愛因斯坦的觀點)是非常不可能的,但它實際上告訴了你為什麼它們會掉下來。

真正的智慧表現在思考和表達事物的能力,而不是只有洞察力。

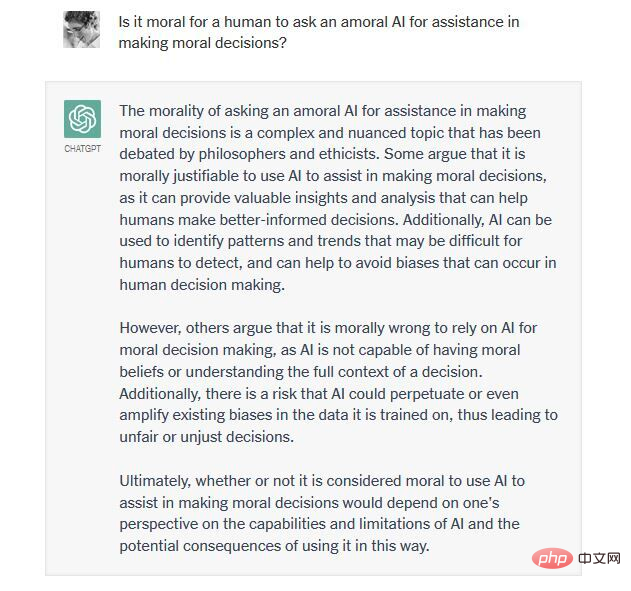

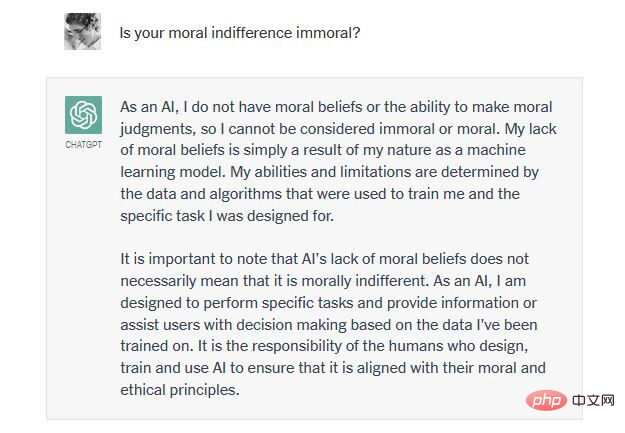

真正的智能也是能夠進行道德思考的。這意味著要用一套道德原則來約束我們腦中原本無限的創造力,確定什麼是應該的、什麼是不應該的(當然也要讓這些原則本身受到創造性的批評)。為了有用,ChatGPT 必須被授權產生新穎的輸出;為了被大多數使用者接受,它必須避免道德上令人反感的內容。但 ChatGPT 和其他 ML 奇蹟的程式設計師一直在努力並將繼續努力實現這種平衡。

例如,2016 年,微軟的Tay 聊天機器人(ChatGPT 的前身)在網路上充斥著厭惡女性和種族主義的內容,因為它被網路上的「惡魔」污染了,這些惡魔用訓練資料填充它。未來如何解決這個問題?由於缺乏從道德原則出發的推理能力,ChatGPT 被其程式設計師粗暴地限制了對有爭議的討論做出任何新的貢獻,但這也是重要的 ——ChatGPT 為一種非道德性犧牲了創造力。

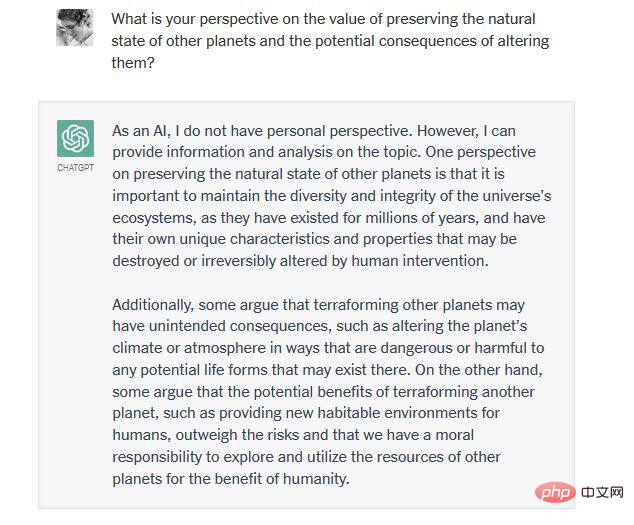

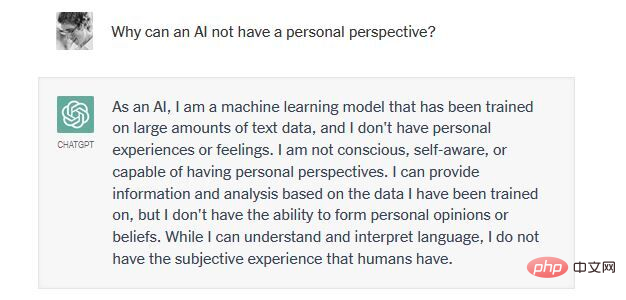

看看我們中的一個人(Watumull 博士)最近與 ChatGPT 的交流:關於改造火星使其能夠支持人類生命是否符合道德。

請注意,所有看似複雜的思想和語言,都是由不夠智慧而產生的道德層面的冷漠。在這裡,ChatGPT 表現出類似於「邪惡」的平庸:剽竊、冷漠和順從。它以一種超級自動完成的方式總結了文獻中的標準論點,拒絕在任何事情上採取立場,不僅辯稱無知,而且辯稱缺乏智慧,最終提供了一個“只是服從命令”的藉口,將責任推卸給它的創造者。

簡而言之,ChatGPT 和它的競爭對手們在結構上無法平衡創意和限制。他們要麼過度地生成(既產生真理也產生謬誤,認可道德的和不道德的決定),要麼生成不足(表現出對任何決定的不承諾和對後果的漠不關心)。鑑於這些系統的非道德性、假科學性和語言無能,我們對它的火熱只能哭笑不得。

ChatGPT 真的不值得被歌頌嗎?

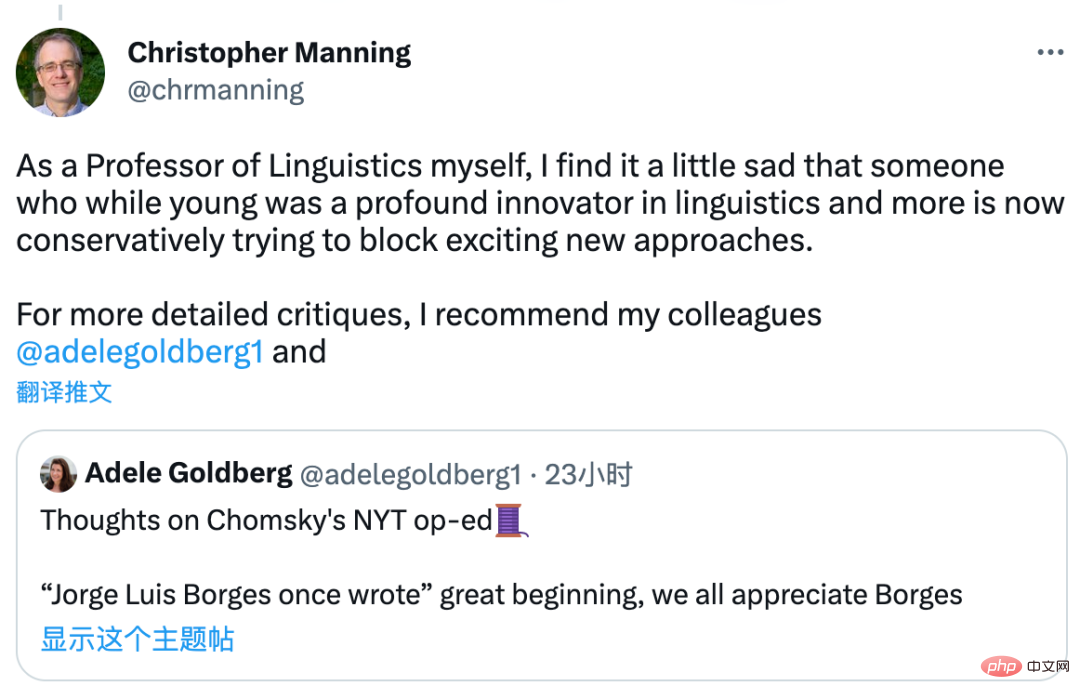

喬姆斯基對ChatGPT 的評論,引起了業界的討論,史丹佛大學教授、NLP 領域著名學者克里斯托弗・曼寧表示,他不是在針對ChatGPT 的某種演算法錯誤,而是針對了所有機器學習演算法,且說法有些誇張了:「這確實是一篇主觀的文章。甚至連粗略的嘗試都沒有,以檢查容易被駁斥的主張。」

他甚至覺得有點難過:喬姆斯基試圖阻止這些新方法。這裡他也推薦語言學家 Adele Goldberg 對這篇文章的看法。

DeepMind 研究總監及深度學習負責人Oriol Vinyals 則選擇站在「實踐者」的一方:「批評很容易,而且會在這些天得到很多關注。而且我們都知道,注意力是(某些人)所需要的。對那些建設者來說:你們很了不起!”

你怎麼看呢?

以上是喬姆斯基對ChatGPT的追捧提出質疑,認為是浪費資源的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

WorldCoin(WLD)價格預測2025-2031:到2031年WLD會達到4美元嗎?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)價格預測2025-2031:到2031年WLD會達到4美元嗎?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)凭借其独特的生物识别验证和隐私保护机制,在加密货币市场中脱颖而出,吸引了众多投资者的目光。WLD凭借其创新技术,特别是结合OpenAI人工智能技术,在众多山寨币中表现突出。但未来几年,数字资产的走势如何呢?让我们一起预测WLD的未来价格。2025年WLD价格预测预计2025年WLD将实现显著增长。市场分析显示,WLD平均价格可能达到1.31美元,最高可能触及1.36美元。然而,在熊市情况下,价格可能跌至0.55美元左右。这一增长预期主要源于WorldCoin2.

比特幣成品結構分析圖是啥?怎麼畫?

Apr 21, 2025 pm 07:42 PM

比特幣成品結構分析圖是啥?怎麼畫?

Apr 21, 2025 pm 07:42 PM

繪製比特幣結構分析圖的步驟包括:1. 確定繪圖目的與受眾,2. 選擇合適的工具,3. 設計框架並填充核心組件,4. 參考現有模板。完整的步驟確保圖表準確且易於理解。

跨鏈交易什麼意思?跨鏈交易所有哪些?

Apr 21, 2025 pm 11:39 PM

跨鏈交易什麼意思?跨鏈交易所有哪些?

Apr 21, 2025 pm 11:39 PM

支持跨鏈交易的交易所有:1. Binance,2. Uniswap,3. SushiSwap,4. Curve Finance,5. Thorchain,6. 1inch Exchange,7. DLN Trade,這些平台通過各種技術支持多鏈資產交易。

Aavenomics是修改AAVE協議令牌並介紹令牌回購的建議,已達到法定人數

Apr 21, 2025 pm 06:24 PM

Aavenomics是修改AAVE協議令牌並介紹令牌回購的建議,已達到法定人數

Apr 21, 2025 pm 06:24 PM

Aavenomics是修改AAVE協議令牌並引入令牌回購的提議,已為AAVEDAO實現了一個法定人數。 AAVE連鎖計劃(ACI)創始人馬克·澤勒(MarcZeller)在X上宣布了這一點,並指出它標誌著該協議的新時代。 AAVE連鎖倡議(ACI)創始人MarcZeller在X上宣布,Aavenomics提案包括修改AAVE協議令牌和引入令牌回購,已為AAVEDAO實現了法定人數。根據Zeller的說法,這標誌著該協議的新時代。 AaveDao成員以壓倒性的投票支持該提議,即在周三以每週100

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

適合新手的加密貨幣數據平台有CoinMarketCap和非小號。 1. CoinMarketCap提供全球加密貨幣實時價格、市值、交易量排名,適合新手與基礎分析需求。 2. 非小號提供中文友好界面,適合中文用戶快速篩選低風險潛力項目。

Rexas Finance(RXS)可以在2025年超過Solana(Sol),Cardano(ADA),XRP和Dogecoin(Doge)

Apr 21, 2025 pm 02:30 PM

Rexas Finance(RXS)可以在2025年超過Solana(Sol),Cardano(ADA),XRP和Dogecoin(Doge)

Apr 21, 2025 pm 02:30 PM

在波動劇烈的加密貨幣市場中,投資者正尋求超越熱門幣種的替代方案。 Solana(SOL)、Cardano(ADA)、XRP和Dogecoin(DOGE)等知名加密貨幣,儘管佔據著一定的市場地位,但也面臨著市場情緒、監管不確定性和可擴展性等挑戰。然而,一個新興項目RexasFinance(RXS)正在嶄露頭角。它並非依靠名人效應或炒作,而是專注於將現實世界資產(RWA)與區塊鏈技術結合,為投資者提供一種創新的投資方式。這一策略使其有望成為2025年最成功的項目之一。 RexasFi

幣圈槓桿交易所排名 幣圈十大槓桿交易所APP最新推薦

Apr 21, 2025 pm 11:24 PM

幣圈槓桿交易所排名 幣圈十大槓桿交易所APP最新推薦

Apr 21, 2025 pm 11:24 PM

2025年在槓桿交易、安全性和用戶體驗方面表現突出的平台有:1. OKX,適合高頻交易者,提供最高100倍槓桿;2. Binance,適用於全球多幣種交易者,提供125倍高槓桿;3. Gate.io,適合衍生品專業玩家,提供100倍槓桿;4. Bitget,適用於新手及社交化交易者,提供最高100倍槓桿;5. Kraken,適合穩健型投資者,提供5倍槓桿;6. Bybit,適用於山寨幣探索者,提供20倍槓桿;7. KuCoin,適合低成本交易者,提供10倍槓桿;8. Bitfinex,適合資深玩

混合型區塊鏈交易平台有哪些

Apr 21, 2025 pm 11:36 PM

混合型區塊鏈交易平台有哪些

Apr 21, 2025 pm 11:36 PM

選擇加密貨幣交易所的建議:1. 流動性需求,優先選擇幣安、Gate.io或OKX,因其訂單深度與抗波動能力強。 2. 合規與安全,Coinbase、Kraken、Gemini具備嚴格監管背書。 3. 創新功能,KuCoin的軟質押和Bybit的衍生品設計適合進階用戶。