開源雙語對話模式在GitHub上熱度高漲,主張AI無需修正胡說八道

本文經AI新媒體量子位元(公眾號 ID: QbitAI)授權轉載,轉載請聯絡來源

國產對話機器人ChatGLM,和GPT-4誕生於同一天。

由智譜AI和清華大學KEG實驗室共同推出,開啟alpha內測版。

這個巧合讓智譜AI創始人兼CEO張鵬有一種說不清的複雜感覺。但看到科技被OpenAI做到這麼牛,這名被AI新進展轟炸麻了的科技老兵又猛然亢奮起來。

特別是在追GPT-4發表會直播時,他看一下螢幕裡的畫面,就埋頭笑一陣,再看一段,又咧嘴笑一會兒。

從成立起,張鵬帶隊的智譜AI就是大模型領域的一員,定下「讓機器像人一樣思考」的願景。

但這條路坎坷不斷。和幾乎所有做大模型的公司遇到的問題一樣,缺數據、缺機器,同時還缺錢。還好一路走來,有一些機構和公司提供無償支持。

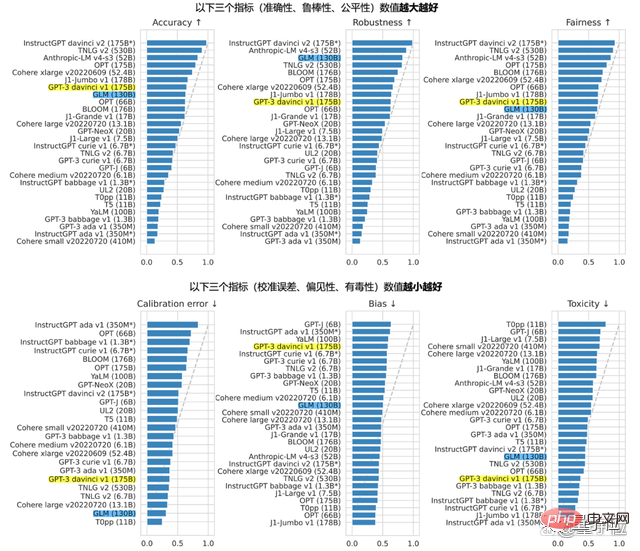

去年8月,公司聯合一眾科研院所,開源的雙語預訓練大語言模型GLM-130B,能在準確性和惡意性指標上與GPT-3 175B (davinci) 接近或持平,也就是後來ChatGLM的基座。和ChatGLM同時開源的還有個62億參數版本ChatGLM-6B,千元單卡就可跑的那種。

除了GLM-130B,智譜另一個有名的產品是AI人才庫AMiner,學界大佬都在玩:

人肉測評。

先不說別的,幾輪測試下來就不難發現,ChatGLM身上有著包括ChatGPT、新必應在內都擁有的一項本領:一本正經胡說八道,包括但不限於在雞兔同籠問題中算出-33隻小雞崽。 對大多數把對話AI當「玩具」或辦公室助理的人來說,怎麼才能提高準確度,是格外被關注和重視的一點。 對話AI一本正經胡說八道這回事,可以修正嗎?又真的需要糾正嗎?

「肯定也會有。但難道閉源就一定能解決安全問題嗎?我看未必。而且我相信世界上聰明人很多,競爭是促進整體產業和生態快速往前推進的優質催化劑。」

這裡的追趕是在陳述過程,建立在認為OpenAI研究方向是通往更遠目標路徑上的必經之路,但追趕上OpenAI並不是最終目的。

追趕上,不代表可以停下;追趕過程,不代表要原樣照搬矽谷模式,甚至可以發揮中國調動頂層設計集中力量辦大事的特色和優勢,才有可能去彌補發展速度上的差異。

雖然有2019年至今4年多的經驗,但智譜還不敢給什麼避坑指南。不過,智譜了解大致對的方向,這也是智譜透露的正在和CCF聊的共同想法——

大模型技術的誕生,是一個非常全面、複雜的系統化工程。

它不再是幾個聰明的腦袋在實驗室裡琢磨,掉幾根頭髮,做點實驗,發點paper就了事。除了原始的理論創新,還需要很強的工程實現和系統化能力,甚至還需要很好的產品能力。

就像ChatGPT這樣,選擇適合場景,設定並封裝一個上到80歲、下到8歲都能接觸使用的產品。

算力、演算法、數據,具體到背後都是人才,尤其是系統工程的從業者,重要程度遠大於往日。

基於這種認知,張鵬透露道,在大模型領域中加入知識系統(知識圖譜),讓二者像左右腦一樣系統工作,是智譜在研究和實驗當中的下一步。

GitHub最火雙語對話模型

ChatGLM整體參考了ChatGPT的設計想法。

也就是在千億雙語基座模型GLM-130B中註入程式碼預訓練,透過有監督微調等技術,實現人類意圖對齊(就是讓機器的回答符合人類價值、人類期望)。

背後1,300億參數的GLM-130B,由智譜和清華大學KEG實驗室共同研發。不同於BERT、GPT-3以及T5的架構,GLM-130B是一個包含多目標函數的自迴歸預訓練模型。

去年8月,GLM-130B對外發布,同時開源。 Standford報告中,它的表現在多項任務上可圈可點。

對開源的堅持,源自於智譜不想做通往AGI道路上孤獨的前行者。

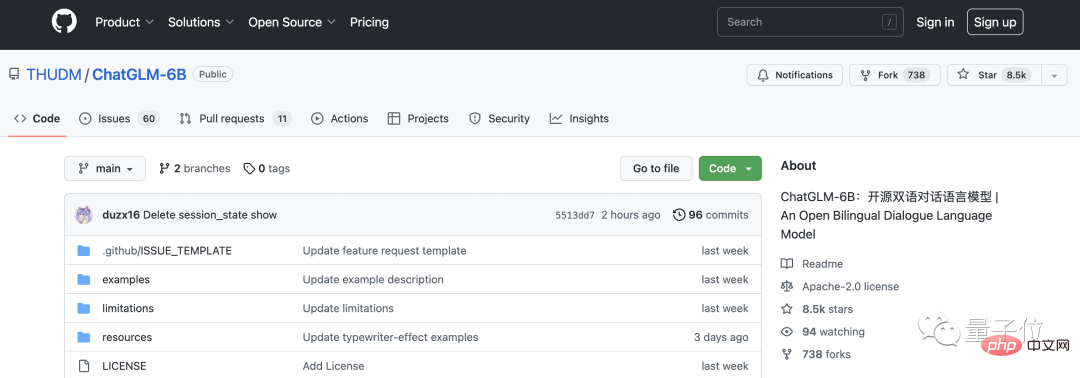

這也是繼開源GLM-130B後,今年繼續開源ChatGLM-6B的原因。

ChatGLM-6B是模型的“縮小版”,62億參數大小,技術基底與ChatGLM相同,初具中文問答和對話功能。

持續開源,理由無外乎兩點。

一個是希望把預訓練模型的生態做大,吸引更多人投入大模型研究,解決現存的許多研究性問題;

#另一個是希望大模型作為基礎設施沉澱下來,以幫助產生更大的後續價值。

加入開源社群確實很吸引人。 ChatGLM內測的幾天內,ChatGLM-6B在GitHub上已有8.5k星標,一度躍升trending排行榜上的第一位。

從本次對話中,量子位元也從眼前這位從業者身上聽到這樣的聲音:

同樣bug頻出,但人們對OpenAI推出的ChatGPT,和對谷歌對話機器人Bard、百度文心一言的容忍程度差異明顯。

這既公平,又不公平。

從純技術的角度來說,評判標準不一,這是不公平所在;但谷歌、百度之類的大廠,佔據更多資源,大家天然覺得它們技術實力更強,做出更好的東西的可能性更高,期待值就更高。

「希望大家可以給更多的耐心,無論是對百度,對我們,還是其他機構。」

除了上述內容,在本次談話中,量子位也和張鵬具體聊了聊ChatGLM的體驗感受。

下面附上對話實錄。為了方便閱讀,我們在不改變原意的基礎上做了編輯整理。

對話實錄

量子位元:內測版本給自己打的標籤好像沒那麼“通用”,官網給它的適用領域框定了三個圈,教育、醫療和金融。

張鵬:這跟訓練資料沒什麼關係,主要是考慮到它的應用場景。

ChatGLM和ChatGPT類似,是一個對話模型。哪些應用領域天然更接近對話場景?像客服,像醫生問診,或例如線上金融服務。在這些場景下,更適合ChatGLM的技術去發揮作用。

量子位:但醫療領域,要看病的人對AI的態度還是比較謹慎的。

張鵬:肯定不能直接拿大模型往上懟啊! (笑)想要完全取代人類,還是要慎重。

現階段不是用它去代替人工作,更多的是輔助作用,給從業者建議來提升工作效率。

量子位元:我們把GLM-130B的論文連結丟給ChatGLM,讓它簡單概括一下主題,它 約照半天,結果說的根本不是這篇。

張鵬:ChatGLM的設定就是無法取得連結的東西。倒不是技術上的困難,而是系統邊界的問題,主要是從安全角度考慮,不希望它任意存取外部連結。

可以試試看把130B的論文文字copy下來丟給輸入框,一般不會瞎說。

量子位元:雞兔同籠我們也丟給它了,算出了-33隻雞。

張鵬:在數學處理、邏輯推理方面,它確實還有一定缺陷,做不到那麼好。內測說明裡我們其實寫了這件事。

量子位元:知乎有人做了測評,寫程式碼能力好像也普通。

張鵬:至於寫程式的能力,我覺得還好?不知道你們的測試方式是什麼。但具體要看跟誰比了,和ChatGPT比的話,ChatGLM本身在程式碼資料的投入可能就沒有那麼多。

就像ChatGLM和ChatGLM-6B比,後者只有6B(62億)的參數,整體能力,例如整體的邏輯性、回答時的幻覺和長度上,縮小版和原版的差距就很明顯。

但是「縮小版」能在普通電腦上部署,帶來的是更高的可用性和更低的門檻。

量子位元:它有個優點,對新資訊的掌握度不錯,知道推特現在的CEO是馬斯克,也知道何愷明3月10日回歸學界的事情-雖然不知道GPT- 4已經發布了,哈哈。

張鵬:我們做了一些特殊的技術處理。

量子位元:是什麼?

張鵬:具體細節就不展開講了。但對時間比較近的新訊息,是有辦法處理的。

量子位元:那透露下成本? GLM-130B訓練一次的成本還是有幾百萬,ChatGLM進行一輪問答的成本目前壓到什麼程度?

張鵬:我們大概測試估算了一下,和OpenAI倒數第二次公佈的成本差不多,比他們略低一些。

但OpenAI的最新報價縮減到原來的10%,只有0.002美元/750個單詞,這就比我們更低了。這個成本確實是很驚人的,估計他們做了模型壓縮、量化、最佳化等工作,否則不可能降到這麼低。

我們也在做相關的事情,期望能把成本壓下去。

量子位元:假以時日,能和搜尋成本一樣低嗎?

張鵬:什麼時候可以降到這麼低?我也不知道。還需要一點時間。

我之前看過每次搜尋價格平均成本的計算,其實與主營業務相關。例如搜尋引擎主要業務就是廣告,所以要用廣告總收入作為上限來計算成本。這樣計算的話,其實要考慮的不是消耗的成本,而是企業獲利收益的平衡點。

做模型推理需要的是AI算力,肯定比搜尋這類只用CPU算力的成本是要更高的。但大家也在努力吧,很多人提出一些想法,像是持續去做模型的壓縮量化。

甚至有人想把模型做一些轉化,讓它在CPU上跑,因為CPU更便宜,量更大,跑起來的話,成本下降就會很明顯。

量子位元:最後還想聊兩句人才方面的話題,現在大家都在搶大模型人才,智譜怕招不到人嗎?

張鵬:我們從清華KEG的技術計畫孵化出來,和各大學的關係一直都不錯。而且公司對年輕人來說氣氛比較open,75%的同事都是年輕人,我這種已經算老傢伙了。大模型人才現在確實奇貨可居,但我們還沒什麼招人的擔憂。

反過來,其實我們現在比較擔心被別人撬牆角(狗頭)。

以上是開源雙語對話模式在GitHub上熱度高漲,主張AI無需修正胡說八道的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技術已成為熱門話題,對各行業產生了巨大影響,程式設計領域尤其如此。人們越來越認識到AI技術的重要性,Spring社群也不例外。隨著GenAI(GeneralArtificialIntelligence)技術的不斷進步,簡化具備AI功能的應用程式的創建變得至關重要和迫切。在這個背景下,"SpringAI"應運而生,旨在簡化開發AI功能應用程式的過程,使其變得簡單直觀,避免不必要的複雜性。透過"SpringAI",開發者可以更輕鬆地建立具備AI功能的應用程序,將其變得更加易於使用和操作

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他們的最新一代嵌入模型embeddingv3,他們聲稱這是效能最出色的嵌入模型,具備更高的多語言效能。這一批模型被劃分為兩種類型:規模較小的text-embeddings-3-small和更強大、體積較大的text-embeddings-3-large。這些模型的設計和訓練方式的資訊披露得很少,模型只能透過付費API存取。所以就出現了很多開源的嵌入模型但是這些開源的模型與OpenAI閉源模型相比如何呢?本文將對這些新模型與開源模型的效能進行實證比較。我們計劃建立一個數據

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

關於Llama3,又有測試結果新鮮出爐-大模型評測社群LMSYS發布了一份大模型排行榜單,Llama3位列第五,英文單項與GPT-4並列第一。圖片不同於其他Benchmark,這份榜單的依據是模型一對一battle,由全網測評者自行命題並評分。最終,Llama3取得了榜單中的第五名,排在前面的是GPT-4的三個不同版本,以及Claude3超大杯Opus。而在英文單項榜單中,Llama3反超了Claude,與GPT-4打成了平手。對於這一結果,Meta的首席科學家LeCun十分高興,轉發了推文並

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型給的答案一點也看不懂,你敢用嗎?隨著機器學習系統在更重要的領域中得到應用,證明為什麼我們可以信任它們的輸出,並明確何時不應信任它們,變得越來越重要。獲得對複雜系統輸出結果信任的一個可行方法是,要求系統對其輸出產生一種解釋,這種解釋對人類或另一個受信任的系統來說是可讀的,即可以完全理解以至於任何可能的錯誤都可以被發現。例如,為了建立對司法系統的信任,我們要求法院提供清晰易讀的書面意見,解釋並支持其決策。對於大型語言模型來說,我們也可以採用類似的方法。不過,在採用這種方法時,確保語言模型生

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson編譯丨諾亞出品|51CTO技術堆疊(微訊號:blog51cto)Zed編輯器專案目前仍處於預發布階段,已在AGPL、GPL和Apache許可下開源。此編輯器以高性能和多種AI輔助選擇為特色,但目前僅適用於Mac平台使用。內森·索博(NathanSobo)在一篇貼文中解釋道,Zed專案在GitHub上的程式碼庫中,編輯器部分採用了GPL許可,伺服器端元件則使用了AGPL許可證,而GPUI(GPU加速用戶介面)部分則採用了Apache2.0授權。 GPUI是Zed團隊開發的一款

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

卷瘋了卷瘋了,大模型又變天了。就在剛剛,全球最強AI模型一夜易主,GPT-4被拉下神壇。 Anthropic發布了最新的Claude3系列模型,一句話評價:真·全面碾壓GPT-4!在多模態和語言能力指標上,Claude3都贏麻了。用Anthropic的話來說,Claude3系列模型在推理、數學、編碼、多語言理解和視覺方面,都樹立了新的行業基準! Anthropic,就是曾因安全理念不合,而從OpenAI「叛逃」出的員工組成的新創公司,他們的產品一再給OpenAI暴擊。這次的Claude3,更是整了個大的