世界超大AI晶片打破單設備訓練大模型記錄 ,Cerebras要「殺死」GPU

本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。

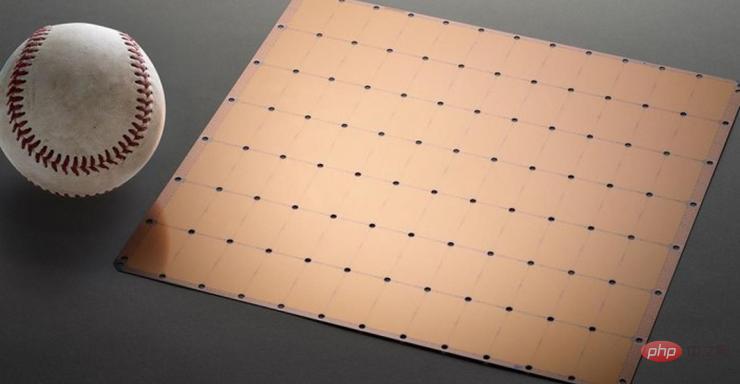

以創造世界上最大加速器晶片CS-2 Wafer Scale Engine聞名的公司Cerebras昨日宣布他們已經在利用「巨芯」進行人工智慧訓練上走出了重要的一步。該公司訓練出了單晶片上全世界最大的NLP(自然語言處理)AI模型。

此模型具有20億個參數,並基於CS-2晶片進行訓練。這塊全世界最大的加速器晶片採用7nm製程工藝,由一整塊方形的晶圓蝕刻而成。它的大小數百倍於主流晶片,具有15KW的功率。它整合了2.6兆個7nm晶體管,封裝了850,000個核心和40GB記憶體。

圖1 CS-2 Wafer Scale Engine晶片

單晶片訓練AI大模型新紀錄

NLP模型的開發是人工智慧中的一個重要領域。利用NLP模型,人工智慧可以「理解」文字意義,並進行相應的動作。 OpenAI的DALL.E模型就是一個典型的NLP模型。這個模型可以將使用者的輸入的文字資訊轉換為圖片輸出。

例如當使用者輸入「酪梨形狀的扶手椅」後,AI就會自動產生若干與這句話對應的影像。

圖:AI接收訊息後產生的「酪梨形狀扶手椅」圖片

不止於此,該模型還能夠使AI理解物種、幾何、歷史時代等複雜的知識。

但要實現這一切並不容易,NLP模型的傳統開發具有極高的算力成本和技術門檻。

實際上,如果只討論數字,Cerebras開發的這一模型20億的參數量在同行的襯托下,顯得有些平平無奇。

前面提到的DALL.E模型具有120億個參數,而目前最大的模型是DeepMind於去年底推出的Gopher,具有2800億個參數。

但除去驚人的數字外,Cerebras開發的NLP還有一個巨大的突破:它降低了NLP模型的開發難度。

「巨芯」如何打敗GPU?

依照傳統流程,開發NLP模型需要開發者將巨大的NLP模型切分若干個功能部分,並將他們的工作負載分散到數百個圖形處理單元上。

數以千計的圖形處理單元對廠商來說意味著巨大的成本。

技術上的困難也同樣使廠商們痛苦不堪。

切分模型是一個客製化的問題,每個神經網路、每個GPU的規格、以及將他們連接(或互聯)在一起的網路都是獨一無二的,並且不能跨系統移植。

廠商必須在第一次訓練前將這些因素統統考慮清楚。

這項工作極為複雜,有時甚至需要幾個月的時間才能完成。

Cerebras表示這是NLP模型訓練中「最痛苦的方面之一」。只有極少數公司擁有開發NLP所必要的資源和專業知識。對於人工智慧產業中的其他公司而言,NLP的訓練則太昂貴、太耗時且無法使用。

但如果單一晶片就能夠支援20億個參數的模型,就意味著不需要使用海量的GPU分散訓練模型的工作量。這可以為廠商節省數千個GPU的訓練成本和相關的硬體、擴展要求。同時這也使廠商不必經歷切分模型並將其工作負載分配給數千個GPU的痛苦。

Cerebras也並非只執拗於數字,評價一個模型的好壞,參數的數量並不是唯一標準。

比起希望誕生於“巨芯”上的模型“努力”,Cerebras更希望的是模型“聰明”。

之所以Cerebras能夠在參數量上取得爆炸性成長,是因為利用了權重流技術。這項技術可以將計算和記憶體的佔用量解耦,並允許將記憶體擴展到足以儲存AI工作負載中增加的任何數量的參數。

由於這項突破,設定模型的時間從幾個月減少到了幾分鐘。並且開發者在GPT-J和GPT-Neo等型號之間「只需幾次按鍵」即可完成切換。這讓NLP的開發變得更簡單。

這使得NLP領域出現了新的變化。

正如Intersect360 Research 首席研究官Dan Olds 對Cerebras取得成就的評價:「Cerebras 能夠以具有成本效益、易於訪問的方式將大型語言模型帶給大眾,這為人工智能開闢了一個激動人心的新時代。

以上是世界超大AI晶片打破單設備訓練大模型記錄 ,Cerebras要「殺死」GPU的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

Laravel的地理空間:互動圖和大量數據的優化

Apr 08, 2025 pm 12:24 PM

Laravel的地理空間:互動圖和大量數據的優化

Apr 08, 2025 pm 12:24 PM

利用地理空間技術高效處理700萬條記錄並創建交互式地圖本文探討如何使用Laravel和MySQL高效處理超過700萬條記錄,並將其轉換為可交互的地圖可視化。初始挑戰項目需求:利用MySQL數據庫中700萬條記錄,提取有價值的見解。許多人首先考慮編程語言,卻忽略了數據庫本身:它能否滿足需求?是否需要數據遷移或結構調整? MySQL能否承受如此大的數據負載?初步分析:需要確定關鍵過濾器和屬性。經過分析,發現僅少數屬性與解決方案相關。我們驗證了過濾器的可行性,並設置了一些限制來優化搜索。地圖搜索基於城

如何設置Vue Axios的超時時間

Apr 07, 2025 pm 10:03 PM

如何設置Vue Axios的超時時間

Apr 07, 2025 pm 10:03 PM

為了設置 Vue Axios 的超時時間,我們可以創建 Axios 實例並指定超時選項:在全局設置中:Vue.prototype.$axios = axios.create({ timeout: 5000 });在單個請求中:this.$axios.get('/api/users', { timeout: 10000 })。

mysql 無法啟動怎麼解決

Apr 08, 2025 pm 02:21 PM

mysql 無法啟動怎麼解決

Apr 08, 2025 pm 02:21 PM

MySQL啟動失敗的原因有多種,可以通過檢查錯誤日誌進行診斷。常見原因包括端口衝突(檢查端口占用情況並修改配置)、權限問題(檢查服務運行用戶權限)、配置文件錯誤(檢查參數設置)、數據目錄損壞(恢復數據或重建表空間)、InnoDB表空間問題(檢查ibdata1文件)、插件加載失敗(檢查錯誤日誌)。解決問題時應根據錯誤日誌進行分析,找到問題的根源,並養成定期備份數據的習慣,以預防和解決問題。

mysql安裝後怎麼使用

Apr 08, 2025 am 11:48 AM

mysql安裝後怎麼使用

Apr 08, 2025 am 11:48 AM

文章介紹了MySQL數據庫的上手操作。首先,需安裝MySQL客戶端,如MySQLWorkbench或命令行客戶端。 1.使用mysql-uroot-p命令連接服務器,並使用root賬戶密碼登錄;2.使用CREATEDATABASE創建數據庫,USE選擇數據庫;3.使用CREATETABLE創建表,定義字段及數據類型;4.使用INSERTINTO插入數據,SELECT查詢數據,UPDATE更新數據,DELETE刪除數據。熟練掌握這些步驟,並學習處理常見問題和優化數據庫性能,才能高效使用MySQL。

偏遠的高級後端工程師(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

偏遠的高級後端工程師(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

遠程高級後端工程師職位空缺公司:Circle地點:遠程辦公職位類型:全職薪資:$130,000-$140,000美元職位描述參與Circle移動應用和公共API相關功能的研究和開發,涵蓋整個軟件開發生命週期。主要職責獨立完成基於RubyonRails的開發工作,並與React/Redux/Relay前端團隊協作。為Web應用構建核心功能和改進,並在整個功能設計過程中與設計師和領導層緊密合作。推動積極的開發流程,並確定迭代速度的優先級。要求6年以上複雜Web應用後端

mysql 能返回 json 嗎

Apr 08, 2025 pm 03:09 PM

mysql 能返回 json 嗎

Apr 08, 2025 pm 03:09 PM

MySQL 可返回 JSON 數據。 JSON_EXTRACT 函數可提取字段值。對於復雜查詢,可考慮使用 WHERE 子句過濾 JSON 數據,但需注意其性能影響。 MySQL 對 JSON 的支持在不斷增強,建議關注最新版本及功能。

了解 ACID 屬性:可靠數據庫的支柱

Apr 08, 2025 pm 06:33 PM

了解 ACID 屬性:可靠數據庫的支柱

Apr 08, 2025 pm 06:33 PM

數據庫ACID屬性詳解ACID屬性是確保數據庫事務可靠性和一致性的一組規則。它們規定了數據庫系統處理事務的方式,即使在系統崩潰、電源中斷或多用戶並發訪問的情況下,也能保證數據的完整性和準確性。 ACID屬性概述原子性(Atomicity):事務被視為一個不可分割的單元。任何部分失敗,整個事務回滾,數據庫不保留任何更改。例如,銀行轉賬,如果從一個賬戶扣款但未向另一個賬戶加款,則整個操作撤銷。 begintransaction;updateaccountssetbalance=balance-100wh

mysql 主鍵可以為 null

Apr 08, 2025 pm 03:03 PM

mysql 主鍵可以為 null

Apr 08, 2025 pm 03:03 PM

MySQL 主鍵不可以為空,因為主鍵是唯一標識數據庫中每一行的關鍵屬性,如果主鍵可以為空,則無法唯一標識記錄,將會導致數據混亂。使用自增整型列或 UUID 作為主鍵時,應考慮效率和空間佔用等因素,選擇合適的方案。