生成式語意分割新範式GMMSeg,可同時處理閉集與開集識別

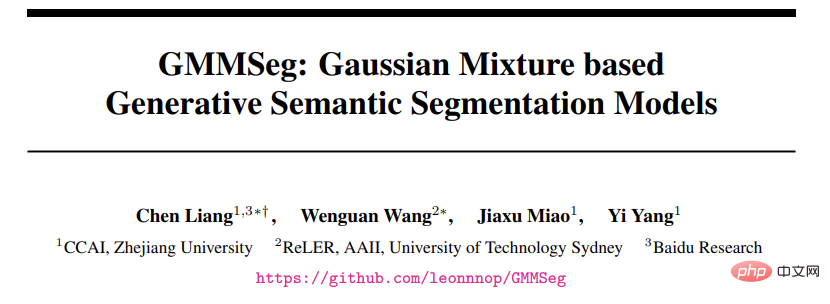

目前主流語意分割演算法本質上是基於softmax 分類器的判別式分類模型,直接對p (class|pixel feature) 進行建模,而完全忽略了潛在的像素資料分佈,即p ( class|pixel feature)。這限制了模型的表達能力以及在 OOD (out-of-distribution) 資料上的泛化性。

在最近的一項研究中,來自浙江大學、雪梨科技大學、百度研究院的研究者提出了一種全新的語意分割範式—— 基於高斯混合模型(GMM)的生成式語意分割模型GMMSeg。

- 論文連結:https://arxiv.org/abs/2210.02025

- #程式碼連結:https://github.com/leonnnop/GMMSeg

GMMSeg 對像素與類別的聯合分佈進行建模,透過EM 演算法在像素特徵空間學習高斯混合分類器(GMM Classifier),以產生式範式對每個類別的像素特徵分佈進行精細捕捉。同時,GMMSeg 採用判別式損失來端到端的最佳化深度特徵提取器。這使得 GMMSeg 同時具備判別式與生成式模式的優點。

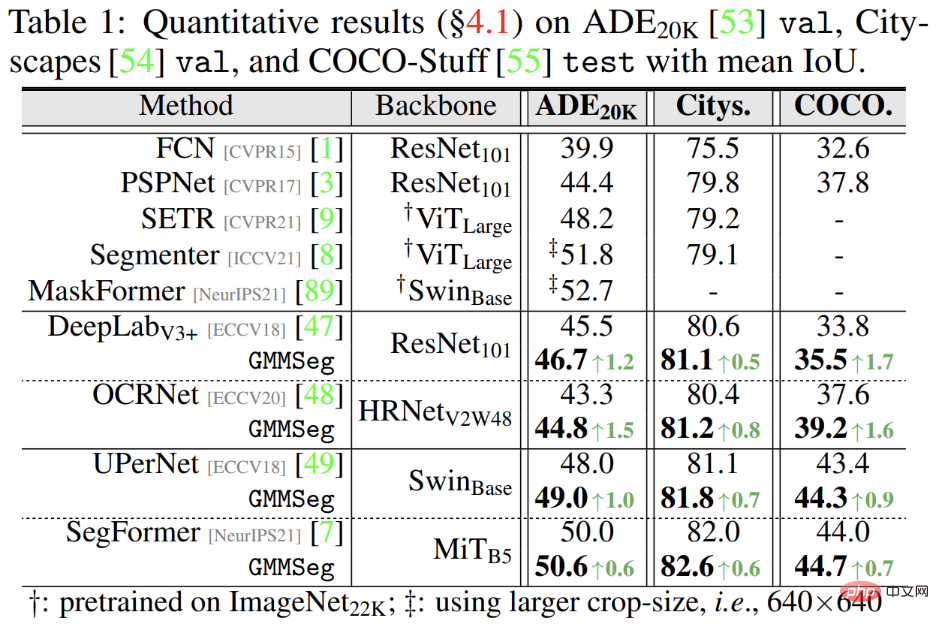

實驗結果表明,GMMSeg 在多種分割網路架構(segmentation architecture) 及骨幹網路(backbone network) 上都獲得了效能提升;同時,無需任何後處理或微調, GMMSeg 可以直接被應用到異常分割(anomaly segmentation) 任務。

迄今為止,這是第一次有語意分割方法能夠使用單一的模型實例,在閉集(closed-set) 及開放世界(open-world) 條件下同時取得進階效能。這也是生成式分類器第一次在大規模視覺任務中展現優勢。

判別式v.s. 生成式分類器

#在深入探討現有分割範式以及所提方法之前,這裡簡略引入判別式以及生成式分類器的概念。

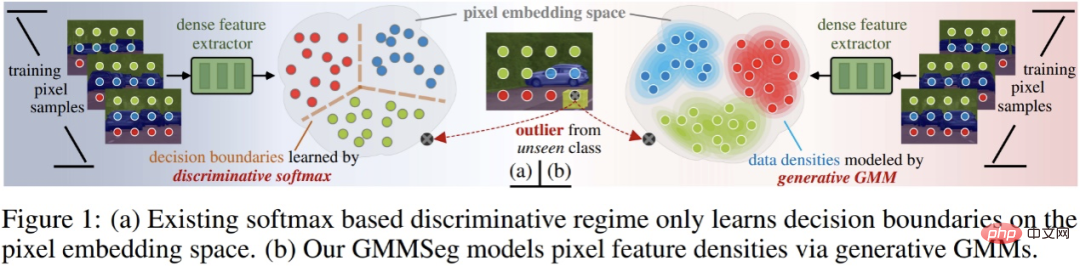

假設有資料集合D,其包含成對的樣本- 標籤對(x, y);分類器的最終目標是預測樣本分類機率p ( y|x)。分類方法可以分為兩類:判別式分類器以及生成式分類器。

- 判別式分類器:直接建模條件機率p (y|x);其僅僅學習分類的最優決策邊界,而完全不考慮樣本本身的分佈,也因此無法反映樣本的特性。

- 生成式分類器:首先建模聯合機率分佈p (x, y),而後透過貝葉斯定理推導出分類條件機率;其明確地對資料本身的分佈進行建模,往往針對每一個類別都會建立對應的模型。相較於判別式分類器,其充分考慮了樣本的特徵資訊。

主流語意分割範式:判別式Softmax 分類器

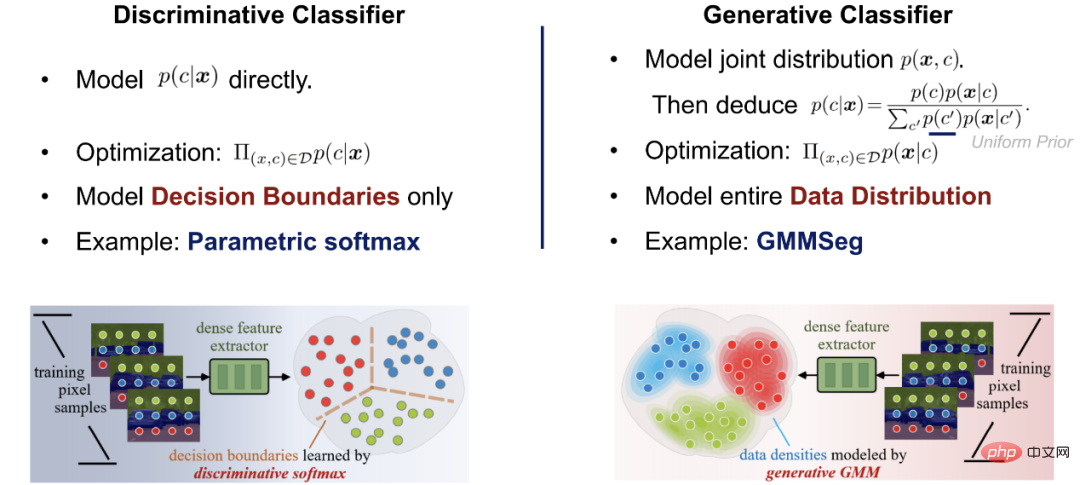

目前主流的逐像素分割模型大多使用深度網路會抽取像素特徵,而後使用softmax 分類器進行像素特徵分類。其網路架構由兩部分組成:

第一部分為像素特徵提取器,其典型架構為編碼器- 解碼器對,透過將RGB 空間的像素輸入映射到D - 維度的高維空間來獲取像素特徵。

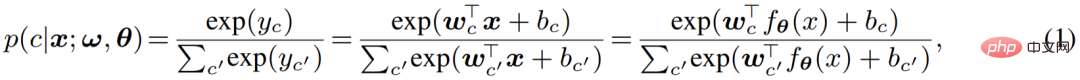

第二部分為像素分類器,即主流的softmax 分類器;其將輸入的像素特徵編碼為C - 類實數輸出(logits),而後利用softmax 函數對輸出(logits)歸一化並賦予機率意義,即利用logits 計算像素分類的後驗機率:

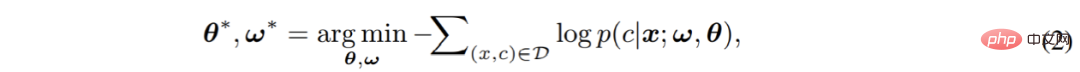

最終,由兩個部分構成的完整模型將透過cross-entropy 損失進行端到端的最佳化:

##在此過程中,模型忽略了像素本身的分佈,而直接對像素分類預測的條件機率p (c|x) 進行估計。由此可見,主流的 softmax 分類器本質為判別式分類器。

判別式分類器結構簡單,並因其最佳化目標直接針對於縮小判別誤差,往往能夠取得優異的判別效能。然而同時,其有一些尚未引起已有工作重視的致命缺點,極大的影響了softmax 分類器的分類性能及泛化性:

- 首先,其僅僅對決策邊界進行建模;完全忽略了像素特徵的分佈,也因而無法對每一個類別的具體特性進行建模與利用;削弱了其泛化性以及表達能力。

- 其次,其使用單一的參數對(w,b) 建模一個類別;換言之,softmax 分類器依賴於單模分佈(unimodality) 假設;這種極強且過於簡化的假設在實際應用往往不能成立,這導致其只能夠取得次優的性能。

- 最後,softmax 分類器的輸出無法準確反映真實的機率意義;其最終的預測只能作為與其他類別進行比較時的參考。這也正是大量主流分割模式較難偵測出 OOD 輸入的根本原因。

針對這些問題,作者認為應該對目前主流的判別式範式進行重新思考,並在本文中給出了對應的方案:生成式語義分割模型— —GMMSeg。

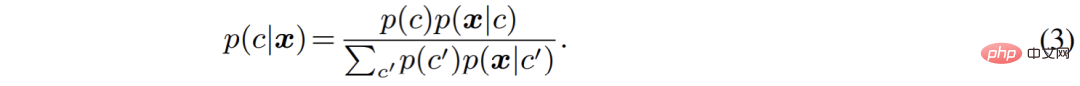

產生式語意分割模型:GMMSeg作者從生成式模型的角度重新整理了語意分割過程。相較於直接建模分類機率p (c|x),生成式分類器對聯合分佈p (x, c) 進行建模,而後使用貝葉斯定理推導出分類機率:

其中,出於泛化性考慮,類別先驗p (c) 往往被設定為uniform 分佈,而如何對像素特徵的類別條件分佈p (x|c) 進行建模,就成為了目前的首要問題。

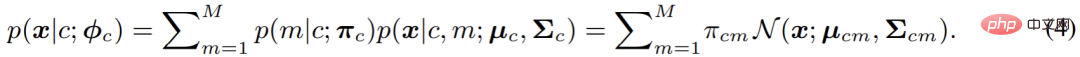

在本文中,即GMMSeg 中,採用高斯混合模型對p (x|c) 進行建模,其形式如下:

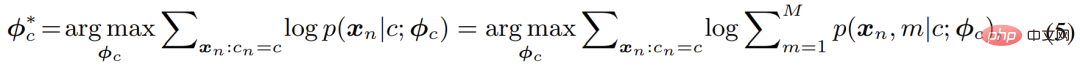

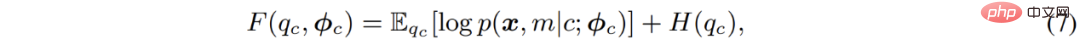

在分模型(component) 數目不受限的情況下,高斯混合模型理論上能夠擬合任意的分佈,因而十分優雅且強大;同時,其混合模型的本質也使得建模多模分佈(multimodality),即建模類內變化,變得可行。基於此,本文採用極大似然估計來最佳化模型的參數:

#其經典的解法為EM 演算法,即透過交替執行E-M - 兩步驟逐步最佳化F - 函數:#

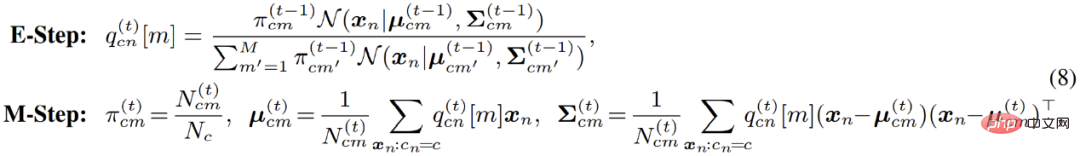

具體到高斯混合模型的最佳化;EM 演算法實際上在 E - 步驟中,對資料點屬於每一個分模型的機率進行了重新估計。換言之,其相當於在 E - 步中對像素點進行了軟聚類 (soft clustering);而後,在 M - 步,即可利用聚類結果,再次更新模型參數。

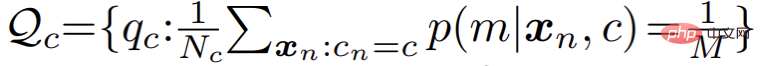

然而在實際應用中,作者發現標準的 EM 演算法收斂緩慢,且最終結果較差。作者懷疑是由於 EM 演算法對參數最佳化初始值過於敏感,導致其難以收斂到更優的局部極值點。受到近期一系列基於最優傳輸理論(optimal transport) 的聚類演算法的啟發,作者對混合分模型分佈額外引入了一個uniform 先驗:

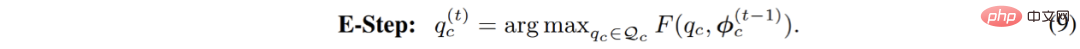

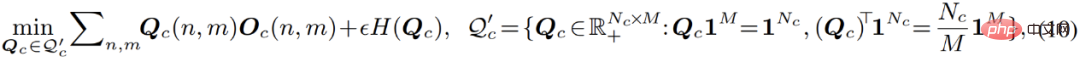

對應的,參數最佳化過程中的E - 步驟被轉換為約束最佳化問題,如下:

##這個過程可以被直觀的理解成,對聚類過程引入了一個均分的限制:在聚類過程中,資料點能夠被一定程度上均勻的分配給每一個分模型。引入此約束之後,此最佳化過程就等價於下式列出的最優傳輸問題:

#此式可以利用Sinkhorn-Knopp算法快速求解。而整個改進後的最佳化過程被命名為 Sinkhorn EM,其被一些理論工作證明,具有與標準 EM 演算法相同的全局最優解,且更不容易陷入局部最優解。

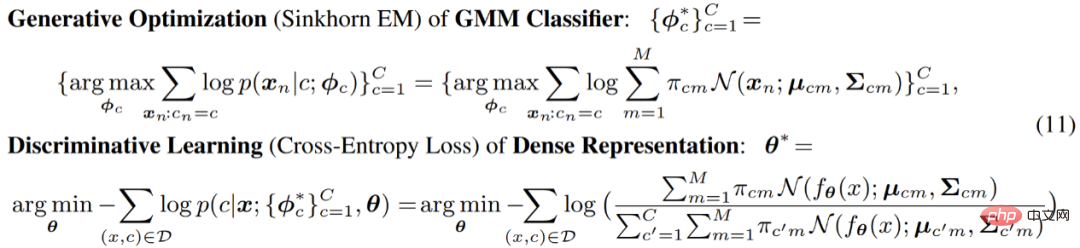

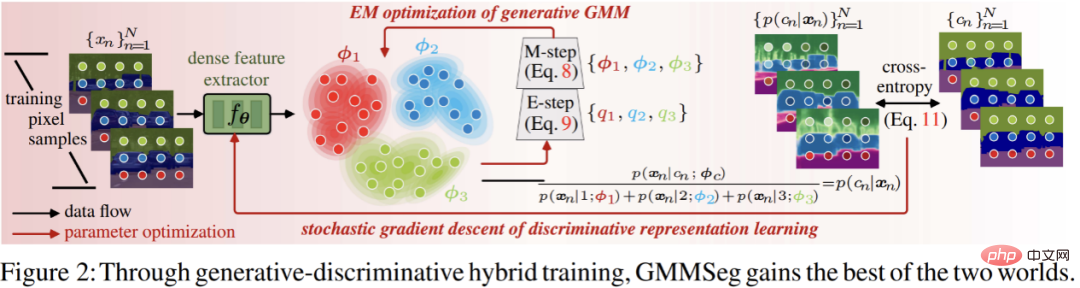

線上混合(Online Hybrid) 優化之後,在完整的優化過程中,文章中使用了一種在線混合(online hybrid) 的優化模式:透過生成式Sinkhorn EM,在逐漸更新的特徵空間中,不斷對高斯混合分類器進行最佳化;而對於完整框架中另一個部分,即像素特徵提取器部分,則基於生成式分類器的預測結果,使用判別式cross-entropy 損失進行最佳化。兩個部分交替優化,互相對齊,使得整個模型緊密耦合,並且能夠進行端到端的訓練:

在此過程中,特徵提取部分只透過梯度反向傳播優化;而生成式分類器部分,則只透過SinkhornEM 進行最佳化。正是這種交替式最佳化的設計,使得整個模型能夠緊湊的融合在一起,並同時繼承來自判別式以及生成式模型的優勢。

最終,GMMSeg 受益於其生成式分類的架構以及線上混合的訓練策略,展示出了判別式softmax 分類器所不具有的優勢:

- 其一,受惠於其通用的架構,GMMSeg 與大部分主流分割模型相容,即與使用softmax 進行分類的模型相容:只需要替換判別式softmax 分類器,即可無痛增強現有模型的效能。

- 其二,由於hybrid 訓練模式的應用,GMMSeg 合併了生成式以及判別式分類器的優點,且一定程度上解決了softmax 無法建模類別內變化的問題;使得其判別性能大為提升。

- 其三,GMMSeg 明確建模了像素特徵的分佈,即p (x|c);GMMSeg 能夠直接給出樣本屬於各個類別的機率,這使得其能夠自然的處理未曾見過的OOD 資料。

實驗結果

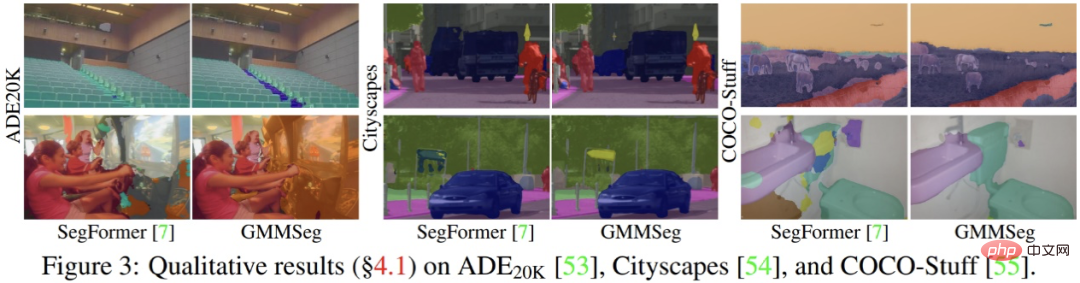

實驗結果表明,不論是基於CNN 架構或基於Transformer 架構,在廣泛使用的語義分割資料集(ADE20K, Cityscapes , COCO-Stuff) 上,GMMSeg 都能夠取得穩定且明顯的效能提升。

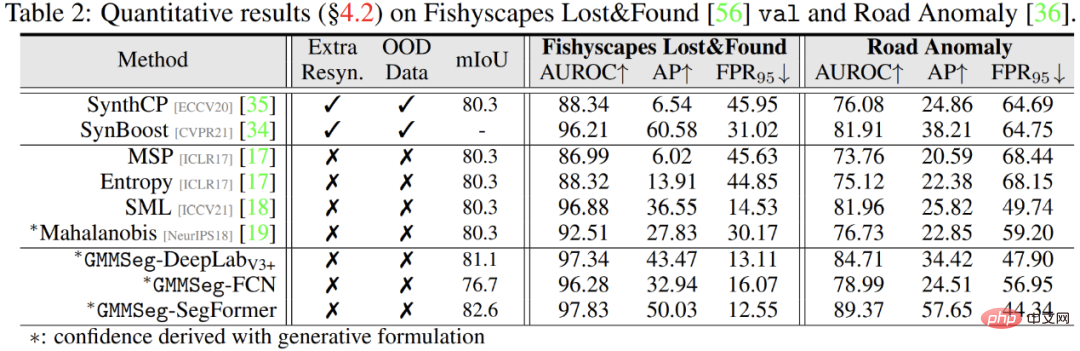

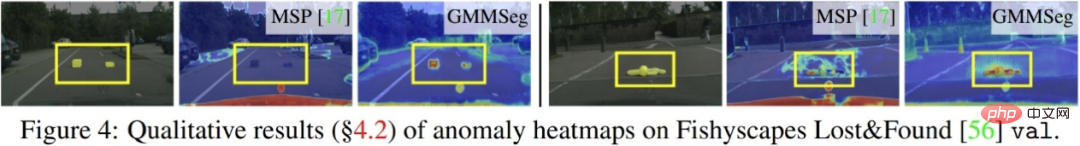

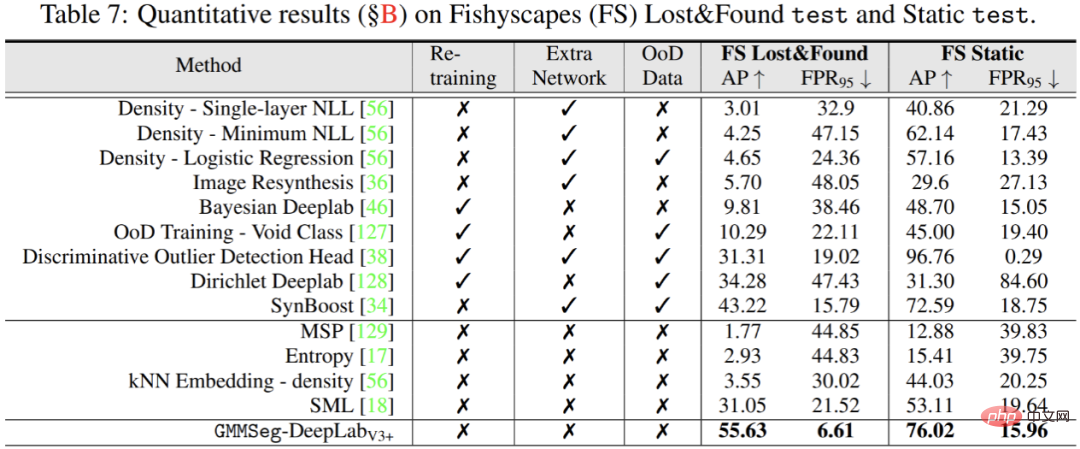

除此之外,在例外分割任務中,無需對在閉集任務,即常規語意分割任務中訓練完畢的模型做任何的修改,GMMSeg 即可在所有一般評量指標上,超越其他需要特殊後處理的方法。

以上是生成式語意分割新範式GMMSeg,可同時處理閉集與開集識別的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI,的確正在改變數學。最近,一直十分關注這個議題的陶哲軒,轉發了最近一期的《美國數學學會通報》(BulletinoftheAmericanMathematicalSociety)。圍繞著「機器會改變數學嗎?」這個話題,許多數學家發表了自己的觀點,全程火花四射,內容硬核,精彩紛呈。作者陣容強大,包括菲爾茲獎得主AkshayVenkatesh、華裔數學家鄭樂雋、紐大電腦科學家ErnestDavis等多位業界知名學者。 AI的世界已經發生了天翻地覆的變化,要知道,其中許多文章是在一年前提交的,而在這一

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

時間序列預測 NLP大模型新作:為時序預測自動產生隱式Prompt

Mar 18, 2024 am 09:20 AM

時間序列預測 NLP大模型新作:為時序預測自動產生隱式Prompt

Mar 18, 2024 am 09:20 AM

今天我想分享一個最新的研究工作,這項研究來自康乃狄克大學,提出了一種將時間序列資料與自然語言處理(NLP)大模型在隱空間上對齊的方法,以提高時間序列預測的效果。此方法的關鍵在於利用隱空間提示(prompt)來增強時間序列預測的準確性。論文標題:S2IP-LLM:SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting下載網址:https://arxiv.org/pdf/2403.05798v1.pdf1、問題背景大模型

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

目標偵測在自動駕駛系統當中是一個比較成熟的問題,其中行人偵測是最早得以部署演算法之一。在多數論文當中已經進行了非常全面的研究。然而,利用魚眼相機進行環視的距離感知相對來說研究較少。由於徑向畸變大,標準的邊界框表示在魚眼相機當中很難實施。為了緩解上述描述,我們探索了擴展邊界框、橢圓、通用多邊形設計為極座標/角度表示,並定義一個實例分割mIOU度量來分析這些表示。所提出的具有多邊形形狀的模型fisheyeDetNet優於其他模型,並同時在用於自動駕駛的Valeo魚眼相機資料集上實現了49.5%的mAP

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺