今年上半年,可謂是AI屆最波瀾壯闊的半年。

在急速發展的各類GPT甚至AGI的雛形背後,是持不同觀點的兩大陣營的人們。

一派認為,以ChatGPT為首的生成式AI非常強大,能帶動一大波革命性的風潮,繼續推進沒有問題。

另一派認為,咱發展的有點太快了。不說禁止,也得停一停。而且道德方面,相匹配的約束也太少了。

而作為AI屆的一位大拿,Yann LeCun對此卻有不同看法。

LeCun表示,他對ChatGPT的表現並不感到驚訝,也不贊成暫停人工智慧的研究。

「這可能會產生和預期相反的結果。」

他表示,人工智慧作為人類智慧的放大器,可能是新文藝復興的起源。

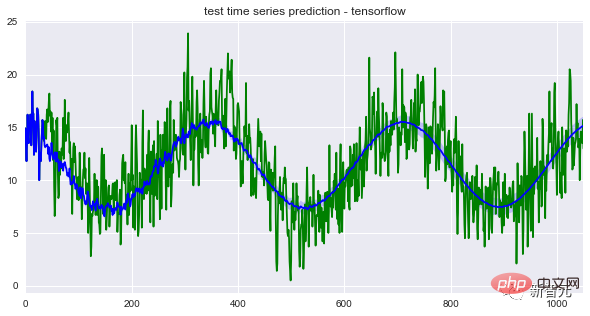

ChatGPT這種大語言模型就是「自迴歸」。 AI接受訓練,從一個包含多達14000億個單詞的語料庫中提取單詞,預測給定句子序列中的最後一個單詞,也就是下一個必須出現的單詞。

Claude Shannon在上個世紀50年代所進行的相關研究就是基於這個原則。

原則沒變,變得是語料庫的規模,以及模型本身的運算能力。

LeCun表示,「目前,我們無法靠這類模型產生長而連貫的文本,這些系統不是可控的。比如說,我們不能直接要求ChatGPT產生一段目標人群是13歲兒童的文本。

其次,ChatGPT生成的文本作為資訊來源並不是100%可靠的。GPT的功能更像是一種輔助工具。就好比現有的駕駛輔助系統一樣,開著自動駕駛功能,也得把著方向盤。

而且,我們今天所熟知的自回歸語言模型的壽命都非常短,五年算是一個週期,五年以後,過去的模型就沒有人再會用了。

而我們的研究重點,就應該集中在找到一種是這些模型可控的辦法上。換句話說,我們要研究的AI,是能根據給定目標進行推理和計劃的AI,並且得能保證其安全性和可靠性的標準是一致的。這種AI能感受到情緒。」

要知道,人類情緒的很大一部分和目標的實現與否有關,也就是和某種形式的預期有關。

而有了這樣的可控模型,我們就能產生出長而連貫的文字。

LeCun的想法是,未來設計出能混合來自不同工具的資料的增強版模型,例如計算器或搜尋引擎。

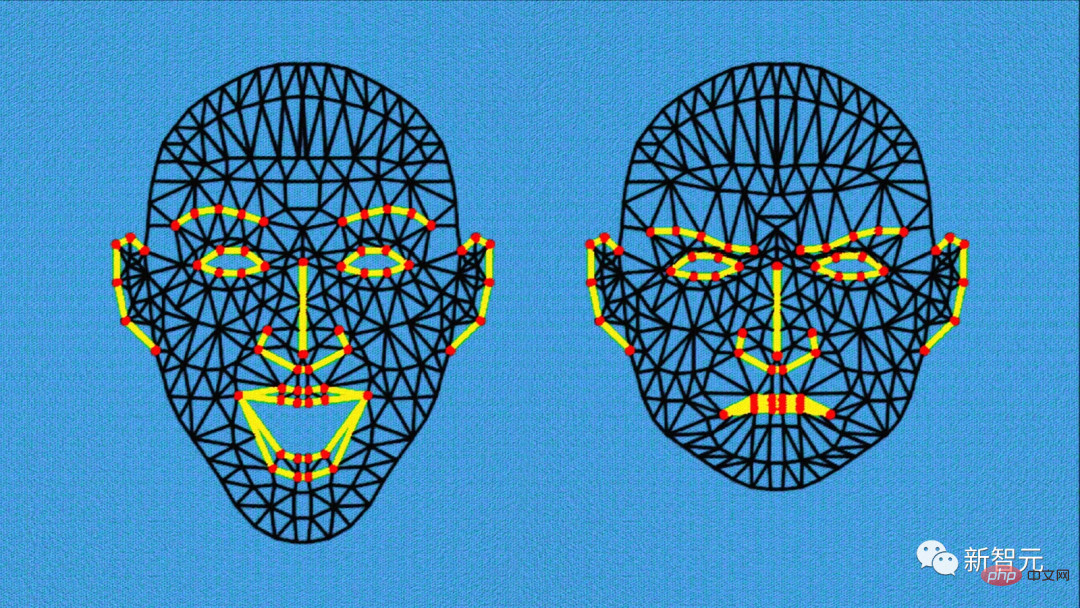

像ChatGPT這樣的模型只接受文字訓練,因此ChatGPT對現實世界的認識並不完整。而想要在此基礎上進一步發展,就需要學習一些和整個世界的感官知覺、世界結構有關的內容。

而這些更複雜的內容並不是單純地透過閱讀文本就能實現的,這才是未來幾年的最大挑戰之一。

對權力的渴望,是人類特有的。而AI並不會因為變得越來越強大就會具備這種渴望。

只有人類這個物種才知道如何制定法律,保障個體的行為不會過度損害共同利益。

OpenAI最初是一個開放的研究項目,現在已經關閉了。而OpenAI對其工作隻字未提,這種情況的逆轉在研究領域並不常見。

問題在於訓練語言模型很昂貴,要花費數千萬歐元,所以新創公司負擔不起。

這也是微軟與OpenAI合併的主要原因,需要集團共同的運算能力來改進其未來的模型。 這也是為什麼DeepMind和Google大腦最後還是合併了。

LeCun表示,最終在市場方面,開發者會走向一個開放平台的共同生態。如果只有少數公司控制這類技術,就糟糕了。

從歷史來看,不管是Facebook還是改完名的Meta,都在積極推動開放性的基礎研究,例如LlaMa這個開源專案。

90年代初期,Sun Microsystems和Microsoft大打出手,爭奪操作伺服器的力量。要記住,所有能一直站穩腳步的網路技術都是開源的。

LeCun最後表示,目前,阻止這類開放的開源AI平台的關鍵,是法律上的問題。如果未來歐盟想要推動AI產業的結構化,那麼這種類似的開源平台是不可或缺的。

以上是圖靈獎得主LeCun:ChatGPT侷限龐大,自迴歸模型壽命不超5年的詳細內容。更多資訊請關注PHP中文網其他相關文章!